基于Transformer增強卷積的膝關節磁共振影像年齡預測

朱昊哲 鄧小冬 廖培希 杜文超 陳懷歆 劉洪 陳虎 鄧振華 楊紅雨

摘要:年齡預測是臨床醫學中的一個重要課題和非常活躍的研究領域.最近,由于傳統影像學檢查中電離輻射的缺點,越來越多的研究使用磁共振影像進行年齡預測.本文基于膝關節MRI數據集,提出了一種新的端到端網絡,結合卷積神經網絡和Masked-Transformer網絡互補地來提取局部特征和全局依賴,并使用一個特征聚合模塊來聚合不同局部膝關節MRI切片的特征.通過整合卷積神經網絡的特征圖和視覺Transformer分支的特征編碼,特征提取模塊可以互補地提取局部和全局信息,更好地提取與年齡相關的特征.同時,該網絡使用由圖注意力網絡組成的特征聚合模塊,用于在特征級別集成不同MRI切片的局部特征,實現多切片局部特征之間的交互.大量實驗表明,該方法可以在膝關節MRI年齡估計任務中達到最先進的性能.具體而言,本文方法在MRI數據集上進行了測試,該測試集包括44個年齡在12.0~25.9歲之間的膝關節MRI樣本,其中五折交叉驗證的最佳結果是年齡平均絕對誤差為1.57±1.34歲.

關鍵詞:深度學習; 膝關節年齡預測; 核磁共振影像; 計算機輔助診斷

中圖分類號:??TP389.1? ?文獻標識碼:A? DOI:10.19907/j.0490-6756.2023.052001

收稿日期: ?2022-11-30

基金項目: ??四川省衛生健康委員會科研課題(19PJ007); 成都市衛生健康委員會科研課題(2022053);四川省自然科學基金(2022NSFSC1286); 成都市重點研發支撐計劃項目(2021YF0501788SN)

作者簡介: ??朱昊哲(2000-), 男, 湖北武漢人, 碩士研究生, 主要研究方向為醫學圖像處理. E-mail: zzzhz@stu.scu.edu.cn

通訊作者: ?陳虎. E-mail: huchen@scu.edu.cn

Transformer enhanced convolution based knee age estimation on MRIs

ZHU Hao-Zhe ?1 , DENG Xiao-Dong ?2 , LIAO Pei-Xi ?3 , DU Wen-Chao ?1 , CHEN Huai-Xin ?4 ,

LIU Hong ?1,4 , CHEN Hu ?1 , DENG Zhen-Hua ?2 , YANG Hong-Yu ?1,4

(1. College of Computer Science, Sichuan University, Chengdu 610065, China; ??2. West China School of Basic Medical Sciences and Forensic Medicine, Sichuan University, Chengdu 610041, China;

3. The Sixth Peoples Hospital of Chengdu, Chengdu 610051, China;

4. Department of National Key Laboratory of Fundamental Science on ?Synthetic Vision, Sichuan University, Chengdu 610065, China)

Age estimation is regarded as a crucial topic and a very active research field in clinical medicine. Recently, due to the drawback of ionizing radiation from the traditional imageological examination, growing more and more studies have focused on using magnetic resonance imaging (MRI) for bone age prediction. This paper proposes a novel end-to-end network based on the knee MRI dataset, which combines the convolution neural network (CNN) and Masked-Transformer network to extract complementary features, and uses a feature aggregation module to aggregate features of different local knee MRI slices. By integrating the feature maps of CNN and the patch embeddings of visual transformer branches, the feature extraction module can complementarily acquire local and global information to better extract age-related features. A feature aggregation module composed of the graph attention network is proposed in our work to integrate the local features of different MRI slices at the feature level to achieve the interaction between multiple slice features. Extensive experiments demonstrate that our method can achieve state-of-the-art performance in the knee MRI age estimation task. Specifically, our method is tested on a dataset including 44 knee MRI samples aging from 12.0 to 25.9 years, and the best result of five-fold cross-validation is a mean absolute error of 1.57 ± 1.34 years in age regression.

Deep learning; Knee age estimation; Magnetic resonance imaging; Computeraided diagnosis

1 引 言

年齡預測在臨床醫學和放射學中是一個重要的研究領域 ?[1-2] ,可用于診斷內分泌疾病、判斷青少年發育時間點以及規劃骨科手術干預時間點 ?[3-4] .現有的人工年齡預測的方法,諸如Greulich and Pyle(GP) ?[5] 和Tanner Whitehouse 2(TW2) ?[6] 等方法對于手腕部醫學圖像中骨骼生長板骨化狀況進行分級對照,從而預測出樣本的年齡.參考GP和TW2方法,許多研究 ?[7-14] 總結了人工對于膝關節X光圖像或MRI圖像進行年齡預測的方法,從股骨遠端、脛骨近端和腓骨近端三個部位 ?[15] 獲取年齡相關信息.然而,傳統的膝關節年齡預測方法需要專業放射科醫生手動完成,這可能導致主觀誤差和低準確性.因此,需要開發基于深度學習技術的自動化算法來提高年齡預測的效率和準確性.

最近的研究 ?[16-18] 利用卷積神經網絡對膝關節MRI進行年齡預測.這些方法將每個MRI樣本看作多層面的二維圖像,并使用共享參數的卷積神經網絡和全連接層提取具有年齡相關性的特征信息,以預測每個切片的年齡并加權得到最終的年齡預測結果.盡管卷積神經網絡在該任務中表現良好,但仍難以獲取所有MRI切片的全局相關信息,在該項年齡預測任務中存在局限性.

自注意力模型近年來在計算機視覺領域得到廣泛應用,尤其在圖像識別、圖像分割和目標檢測等任務中表現突出.視覺Transformer模塊通過捕獲圖像的全局依賴,在處理全局信息方面具有優勢,這與卷積神經網絡在處理局部細節方面的優勢相互補充.

基于卷積網絡和Transformer結構的優勢和特點,本文提出了ResMAE網絡結構.該網絡由Masked-Transformer模塊增強的卷積神經網絡基本塊組成,用于從每個膝關節MRI樣本的圖像切片中提取與年齡相關的特征.在提取到圖像特征之后,應用一個由圖注意力網絡結構組成的特征聚合模塊實現各MRI切片特征的聚合,以輸入到全連接層和Softmax層中得到預測的年齡結果.本文的貢獻主要包括:(1) 本文提出了一種新的端到端網絡,用于處理膝關節MRI年齡預測任務,該網絡顯著提高了其在膝關節MRI的年齡預測任務的性能效果,并實現了臨床應用的可行性;(2) 本文提出了一種Masked-Transformer增強的卷積特征提取網絡結構.實驗證明該網絡在膝關節MRI年齡預測任務中比全卷積結構和全視覺Transformer結構具有更好的結果;(3) 本文在局部MRI切片特征級別上使用了圖注意力網絡 ?[19] 作為特征聚合模塊.實驗表明,相比原始的基于每個切片預測結果的機器學習聚合方法,該方法表現更佳;(4) 通過詳細的實驗結果證明,本文方法在可解釋性、時間效率和性能方面均優于人工膝關節MRI年齡預測方法和現有深度學習方法.

2 膝關節核磁共振相關研究

2.1 膝關節年齡預測

近期的研究 ?[16-18] 采用深度學習技術對膝關節MRI圖像進行年齡估計.這些方法將每個MRI切片看作一張二維圖像,使用二維卷積神經網絡和全連接層提取與年齡相關的特征信息,并使用機器學習方法預測每個切片的年齡并加權平均得到最終的年齡結果.然而,卷積神經網絡雖然能夠有效地提取局部特征,但在捕獲所有MRI切片的全局依賴信息方面存在困難.同時,由于未考慮到不同切片之間的關系,直接將不同切片的年齡結果反饋到另一個機器學習回歸函數中進行最終的年齡估計也不可靠.

具體而言,Dallora等人 ?[16] 使用GoogLeNet ?[20] 和全連接層進行膝關節MRI切片圖像的特征提取和年齡回歸預測.Prove等人 ?[17] 引入U-Net結構 ?[21] 從膝關節MRI切片圖像中分割出骨骼部分,用U-Net編碼器提取骨骼掩膜圖像中的特征,并將每個切片的年齡預測結果輸入到隨機森林回歸函數中得到最終年齡結果.Mauer等人 ?[18] 使用AgeNet2D從局部膝關節MRI切片提取特征,并應用極端隨機樹回歸器對每個切片的預測結果進行加權,以在其私人數據集中獲得最佳預測結果.然而, 這些方法都采用兩階段方法,即使用二維卷積神經結構提取每個MRI圖像切片的特征,并將每個切片的預測結果直接加權以獲得最終年齡.

相比之下,本文提出了一種新的方法,使用視覺Transformer結構對膝關節MRI數據進行特征提取,以提高年齡預測的準確性.與現有解決方案相比,本文方法從全局角度提取更多與年齡相關的特征,并使用由圖注意力網絡結構組成的特征聚合模塊在特征層面實現各切片特征的聚合,從而更好地考慮了不同局部切片之間的相關性.此外,本文的方法以端到端的方式實現,實現起來更加方便,并在后續實驗中證明了其在預測性能上的優越性.

2.2 卷積神經網絡

卷積神經網絡在計算機視覺任務中表現驚人,其在膝關節MRI年齡預測任務中也不例外.ResNet ?[22] 作為一個具有里程碑意義的深度卷積神經網絡模型.過去,研究人員一直認為神經網絡的深度對卷積神經網絡的性能和擬合能力至關重要,因此一直通過增加層數來改進神經網絡模型.但是He等人 ?[22] 證明,當網絡深度增加到一定程度時,網絡的擬合能力可能會下降.因此,ResNet使用跳躍連接來解決過擬合問題并加速訓練.由于ResNet在特征提取方面的出色能力,本文選擇ResNet作為該任務的主干網絡.考慮到本文的訓練數據集相對較小且圖像分辨率相對較低,因此選擇參數較少的ResNet34網絡結構作為主干網絡,以緩解過度擬合現象.

2.3 Transformer模塊

Transformer ?[23] 模塊一直被廣泛應用于NLP任務中.最近ViT ?[24] 的出現證明了在視覺任務中使用Transformer結構的可行性,并展示了其在全局特征提取方面的優勢.視覺Transformer網絡通過將每個圖像分割成帶有位置編碼信息的特征來構建一系列特征編碼,并使用串聯的Transformer模塊提取參數化向量作為全局視覺表示.然而,全Transformer網絡結構可能會忽略圖像的局部特征細節,并且在數據量不足的情況下訓練時的泛化性能較差.為了應對這些問題,近期許多工作著力于使用Transformer結構來增強卷積主干網絡,提高網絡的整體性能.

具體而言,Dai等人 ?[25] 提出了CoAtNet網絡結構,以結合卷積神經網絡和Transformer模塊的優點.他們發現,深度卷積結構和自注意力機制可以自然地統一結合,并在淺層中更有效地垂直堆疊卷積和自注意力層.Conformer ?[26] 使用并行混合的卷積神經網絡結構和Transformer塊,以利用卷積運算和自注意力機制來增強網絡的泛化能力.

與現有工作不同,本文考慮到更好地提取所有MRI切片的全局特征和局部切片特征,在ResMAE的ResNet基本塊的基礎上,加入了類似于MAE ?[27] 的編碼器結構的Masked-Transformer結構,以將具有年齡相關性的全局信息融入切片圖像特征提取中.同時,Masked-Transformer結構隨機地對一些圖像區域進行遮蔽操作,以此減輕Transformer結構產生的過擬合現象.后續部分將詳細介紹本文所提出的ResMAE模塊,并通過綜合實驗證明,ResMAE中的特征提取模塊顯著提高了膝關節MRI年齡預測任務的精度,在預測時間和精度方面都能滿足臨床應用需要.

3 方 法

本節將介紹用于膝關節MRI年齡估計任務的特征提取網絡和特征聚合模塊.整體網絡結構如圖1所示,網絡的輸入為12張二維切片圖像,經過初始的3個卷積網絡塊得到淺層特征,接著輸入到4個級聯的基本塊進行特征提取并得到每張圖像的高級語義特征向量.最后,本文通過特征聚合模塊(Feature Aggregation Module,FAM)將各切片的特征向量進行聚合,得到年齡相關性最強的切片特征,并使用全連接層和Softmax層輸出預測年齡.

基于圖1中的網絡結構,我們來解釋本文如何結合卷積神經網絡和Transformer模塊的優點來進行特征提取.同時,本文還介紹了如何使用Masked-Transformer模塊以減輕過擬合現象,并展示了如何應用特征聚合模塊對提取到的切片特征在特征層面進行聚合.

3.1 基于Transformer模塊的特征提取網絡

本節詳細介紹了用于膝關節MRI切片特征提取的網絡結構,如圖2所示.與ResNet ?[22] 結構相似,本文的特征提取網絡針對膝關節年齡預測任務進行了修改.首先,為了避免圖像細節的丟失,本文在網絡的初始部分應用3個3×3的卷積塊進行初始特征提取過程,將初始輸入圖像轉換為具有初級語義特征的特征圖.基本塊的整體卷積結構與ResNet34結構類似,每個卷積塊的卷積核大小為3×3,padding為1,并在其后跟隨有一個BatchNorm層和ReLU激活層.

此外,如圖2右上部分所示,本文在ResNet基本塊的第二個卷積塊后添加了一個Masked-Transformer模塊,以更好地融合Transformer模塊的全局依賴,實現更好的特征提取過程.Masked-Transformer 模塊的結構如圖2的下半部分所示,為了更好地表示網絡的計算過程,這里假設上一個基本塊或者卷積塊的輸出特征圖為 ?f ??c ∈ Euclid Math TwoRA@

B×N×C×h×w ?(其中 B、N、C、h、w 分別代表訓練的批次大小、MRI樣本的切片數量、特征圖的通道數量、特征圖高和特征圖寬).本文先使用平均池化操作減小特征圖的尺寸大小將特征圖壓縮為 ?f ???c ′ ∈ Euclid Math TwoRA@

B×E× h ′× w ′ ?(其中 E=N×C , ?h ′、 w ′ 分別為壓縮后的特征圖大小).然后使用一個類似于MAE ?[27] 編碼器的結構來對特征圖的部分區域進行采樣,同時對未采樣區域進行遮蔽操作,此時可以得到隨機采樣后的特征圖 ?f ??m ∈ Euclid Math TwoRA@

B×E× h ′× w ′ ?(其中本文設置的遮蔽率為 ?M ??r ?, ?M ??r ?的大小在0~1之間,即對特征圖僅保留 1- M ??r ?比例的部分信息,其余 ?M ??r ?比例部分進行零填充操作).同時,由于經過Transformer模塊計算之后的特征編碼需要還原到原始的特征圖尺度大小,本文也使用了掩碼標記的結構以通過一種可學習向量的形式來替代上一步中的被遮蔽部分.與文獻[27]中類似,ResMAE給所有特征編碼加上了位置編碼信息以便還原為原特征圖的維度大小.同時,為了將二維的特征圖轉化為Transformer模塊輸入的一維序列格式,本文按照ViT ?[24] 的步驟,將特征圖 ?f ??m ∈ Euclid Math TwoRA@

B×E× h ′× w ′ ?轉化為 ?f ??e ∈ Euclid Math TwoRA@

B×P×E ?(其中P表示Transformer模塊的特征通道數, P= h ′× w ′× M ??r ?).隨后使用兩個級聯的Transformer模塊來提取輸入的特征序列 ?f ??e ?,Transformer模塊的格式按照標準的ViT ?[24] 結構進行設置.如圖2所示,ResMAE在基本塊之后要實現原始卷積特征圖和Transformer模塊輸出特征編碼的拼接,為此本文使用前面提到的位置編碼信息和掩碼標記將Transformer模塊的輸出還原到輸入的特征圖大小,還原后的特征圖為 ?f ???t ′ ∈ Euclid Math TwoRA@

B×E× h ′× w ′ ?,并且使用最近鄰插值算法使特征圖的維度大小調整為 ?f ??t ∈ Euclid Math TwoRA@

B×N×C×h×w ?.最后將卷積輸出與Transformer模塊的輸出進行拼接即可得到基本塊的輸出結果.

可以通過后續實驗部分證明,通過將帶有隨機遮蔽采樣的Transformer模塊嵌入到原始卷積塊之中,不僅可以為卷積結構提取的局部特征添加全局表示能力,而且通過一種隨機掩蔽的方式減輕Transformer模塊帶來的過擬合現象,增強特征提取網絡的魯棒性.

3.2 基于圖注意力網絡的特征聚合模塊

考慮到不同MRI切片之間的原始順序,本文從特征層面考慮不同切片特征之間的特征聚合,以消除不同切片之間年齡相關信息的差異性,獲得年齡相關性更強的高級語義特征.對于特征聚合模塊,本文使用圖注意力網絡 ?[19] 作為聚合局部切片特征向量的基本塊.具體而言,假設特征提取網絡得到的切片特征向量為 ?F ??l ∈ Euclid Math TwoRA@

B×N×D ?(其中 D 為特征向量的維度大小).在特征提取網絡中,每個切片特征被視為圖中的一個結點,每個切片結點 ?V ??i ∈ ?V ??1 , V ??2 ,…, V ??N ??的特征維度為 1×D .考慮到磁共振影像中的每個相鄰二維圖像切片可能包含更多相似的年齡相關信息,本文讓相鄰的各圖像節點之間相互連接,來實現信息的交互.

圖注意力網絡的輸入為相鄰結點之間的結點特征和邊的集合.在一系列的圖注意力加權操作之后,可以將切片特征向量進行聚合并進行加權平均為最終的輸出特征 ?F ??o ∈ Euclid Math TwoRA@

B×D ?.最后,經過聚合的局部切片特征輸入到全連接層和Softmax層中加權得到預測年齡 A∈ Euclid Math TwoRA@

B ?.通過使用圖注意力網絡作為局部切片特征的特征聚合模塊,本文的ResMAE網絡結構可以更好地在不同切片圖像上集成切片特征,并在局部圖像域和全局圖像域提取年齡相關性更強的特征.

3.3 損失函數設計

對于年齡估計任務而言,主要有兩種方法來計算損失函數:基于分類的方法和基于回歸的方法.為了增強網絡的預測能力,Rothe等人 ?[28] 提出了一種將年齡回歸作為一個深度分類問題,然后使用Softmax層細化期望值的方法,這樣可以顯著提高年齡預測網絡的性能.同時,Pan等人 ?[29] 提出了對于年齡分布進行估計的平均損失函數,主要擬合減小預測的年齡分布均值與真實年齡分布均值的差異,在此基礎上提高年齡分布的預測精度.基于上述兩種方法,本文中使用Softmax損失函數和基于年齡分布估計均值的損失函數來預測年齡,讓預測標簽更接近于真實標簽值.本文的損失函數使用細節如下.

首先,這里假設 X 為圖1中最后的全連接層輸出的特征向量, ?S ??i ∈{1,2,…,T} 表示整個數據集的標簽年齡組.其中特征向量 X 的維度為 B×T (其中 B 為訓練批次大小、 T 為特征向量的向量維度).將特征向量 X 輸入到Softmax層中即可得到每個年齡標簽 ?S ??i ?的概率分布 P (其中 P 具有與特征向量 X 相同的維度大小).因此,這里可以使用如下式得到概率分布的表示:

P ???b,i = ?e ????X ???b,i ??∑ ??T ??t=1 ?e ????X ???b,t ????(1)

其中, ?P ??b,i ?表示樣本 b 在所有年齡組 ?S ??i ?上的預測概率.因此,每個樣本在網絡輸出的最終預測年齡可以用以上 ?P ??b,i ?和 ?S ??i ?的加權平均和來表示.最終的預測年齡 ?A ??b ?可以由如下公式計算得到:

A ???b =∑ ?T ??i=1 ??P ???b,i * S ???i ??(2)

均值損失致力于減少網絡估計的年齡分布均值與真實的年齡分布標簽之間的誤差.同時,均值損失和Softmax損失函數被嵌入到神經網絡的預測部分,以平衡年齡預測的最終損失函數.因此,本文所用的整體損失函數如下式.

L=λ L ???mean ?+ L ???softmax ???(3)

其中, λ 是用來平衡均值損失以及Softmax損失的超參數.均值損失按照前文的敘述可以由式(4)計算得到:

L ??mean = 1 2B ∑ ?B ??b=1 ????A ???b - Y ???b ????2 =

1 2B ∑ ?B ??b=1 ???∑ ?T ??i=1 ??P ???b,i * S ???i - Y ???b ????2 ??(4)

其中, ?Y ??b ?為每個樣本的真實年齡.同時Softmax損失可以由式(5)計算得到:

L ??softmax = 1 B ∑ ?B ??b=1 ?- log ?P ???b, Y ???b ???(5)

所以,綜合上述的公式~式(5)可以得到最終的損失計算函數:

L=λ L ??mean + L ??softmax =

λ 1 2B ∑ ?B ??b=1 ???∑ ?T ??i=1 ??P ???b,i * S ???i - Y ???b ????2 +

1 B ∑ ?B ??b=1 ?- log ?P ???b, Y ???b ???(6)

4 實驗與分析

4.1 膝關節MRI標注數據集

由于膝關節MRI年齡預測任務沒有公開數據集,本文實驗采用的數據為四川大學華西基礎醫學與法學院提供的膝關節MRI年齡預測數據集.數據集由259例年齡位于12.0~25.9歲之間的中國漢族男性受試者膝關節MRI數據組成,其中每個3D MRI樣本可以映射為15~22張二維圖像切片.每個MRI樣本與該樣本的真實年齡標簽一一對應,作為本論文網絡的主要數據集和標簽.膝關節磁共振圖像如圖3所示. 本文在實驗中將數據集的259例膝關節圖像樣本按照4∶1的比例進行劃分,其中訓練集樣本數量為205例,測試集樣本數量為44例,每個樣本經處理后包含12張二維圖像切片.

由于磁共振掃描設備中的磁場強度變化,磁共振圖像通常顯示出不均勻的結果,即在磁共振圖像中,由于磁場強度的差異,圖像的一部分在視覺上可能顯得更亮或者更暗,這可能會降低后續圖像處理算法的性能.因此,本文按照先前工作的思路 ?[17,18] ,首先對MRI數據進行N4ITK偏置場矯正 ?[30] 處理,以消除磁共振設備本身對于實驗結果的影響.其次,由于原始的3D MRI數據分辨率為512×512×15~512×512×22,不同樣本的二維切片數量不盡相同,為了方便后期的處理以及用作神經網絡的輸入,本文在華西醫院專家的幫助下對于不同切片數量的膝關節圖像進行選取并且統一插值縮放到128×128×12的尺度大小.并且,由于前人的工作 ?[17,18] 已經證明了在膝關節磁共振影像中首先通過分割任務提取出骨骼部分區域來進行年齡預測的有效性,所以本文按照U-Net ?[21] 的實驗設置,同樣地對原始數據中的骨骼部分進行分割提取.本實驗中的數據采集和處理步驟如圖4所示.

4.2 實驗設置

本文在Windows 10系統中使用Pytorch框架進行實驗,其中GPU為Nvidia GeForce RTX 2080 8 GB GPU,內存為32 GB.由于顯存容量的限制,數據輸入的批次大小設置為2.同時,本文對于所有的Dropout層的概率設置為0.2,默認情況下本文使用Adam優化器來訓練網絡,Adam優化器的權重衰減設置為0.0005,初始學習率為 0.000 05 ,總訓練周期為80次,并且每30個訓練周期將學習率下降0.3倍.在后續實驗中,平均絕對誤差(Mean Absolute Error,MAE)、標準差(Standard Deviation,SD)和95%置信區間(Confidence Interval,CI)用于評估本文提出的方法和經典模型.另外,本文在數據集上使用五折交叉驗證來報告不同模型在數據集上的預測性能.

4.3 實驗結果分析

本文提出的模型利用Transformer模塊在提取全局依賴性特征和卷積神經網絡在提取局部細節特征的優勢,結合Masked-Transformer結構來緩解Transformer模塊提取全局特征時的過擬合現象.為了驗證本文使用的網絡模型的有效性,本文將ResMAE模型與最近在膝關節年齡預測相關論文的方法、計算機視覺領域中廣泛使用的先進深度卷積網絡和基于Transformer模塊的網絡結構進行對比.

表1列舉了在本文數據集上使用不同模型的預測性能,以及按年齡區間段進行劃分的預測結果的平均絕對誤差(除了AgeNet2D ?[18] 按照原論文設置為兩階段的實現方式以外,其余模型在提取到每個局部切片的特征之后都使用了本文提出的特征聚合模塊進行特征層面的聚合).從表1結果可以看出,在融合了本文所提出的特征聚合模塊之后,具有相對較少訓練參數的神經網絡結構可以取得較好的性能.即對于卷積神經網絡SKNet ?[31] 、ResNeXt ?[32] 和基于卷積和Transformer結合的方法CoAtNet ?[25] 和Conformer ?[26] ,這些網絡的性能低于GoogLeNet ?[20] 、ResNet34 ?[22] 和ResNet50 ?[22] 等.同時,本文提出的端到端網絡結構比具有兩級結構的AgeNet2D ?[18] 具有更好的預測結果,這在很大程度上取決于ResMAE中的Masked-Transformer結構以及提取局部切片特征之后所采用的特征聚合模塊.由于本數據集樣本數量相對較少,全Transformer結構訓練難以獲得足夠的訓練樣本,所以對于類似ViT ?[24] 的全Transformer結構并沒有比全卷積神經網絡結構獲得更好的結果.此外,由于ResNet ??[22] 的跳躍連接結構在特征通道加權中發揮了出色的作用,其在該任務中取得了較好的實驗結果.本文提出的ResMAE結構使用ResNet34和Masked-Transformer模塊作為特征提取的基本塊,以一種全局和局部相結合的方式進一步提高特征的全面性,并且在表1的所有網絡結構中取得了最好的性能.

如前文所述,與全卷積網絡結構和全視覺Transformer結構相比,本文為了提升整體網絡結構的特征提取能力,融合視覺Transformer在提取全局特征方面的優勢以及卷積網絡結構適用于局部特征細節的特點,在ResNet基本塊中插入了Masked-Transformer模塊.通過實驗結果可以看出,卷積和Transformer結構結合的混合式結構明顯優于單體網絡結構,能夠實現更好的年齡預測結果.并且本文中通過使用Masked-Transformer結構,能夠進一步平衡Transformer和卷積網絡在特征提取過程中的作用,有效避免過擬合現象,實現在膝關節年齡預測任務中的最佳實驗結果.

此外,本文使用圖5顯示了表1中最佳網絡模型ResMAE在五折交叉實驗中的預測膝蓋年齡與實際年齡的散點圖.可以看出,在12~16歲之間,由于樣本的膝關節骨骼生長板即骨骺區域并未完全融合,年齡特征相對來說比較明顯,因此網絡能夠較為準確地預測出測試樣本的年齡.以往的醫學研究表明,男性的膝關節骨骺生長板區域完全愈合發生在16~19歲之間,并隨個體的不同存在差異,因此在16歲以上的樣本中通過膝關節MRI來判斷個體年齡具有較大誤差.同時由于膝關節MRI數據集中的部分受試樣本中可能存在發育異常現象,即存在較大的個體差異可能性,在預測結果中16~22歲年齡區間內的少部分樣本可能存在預測值偏大,22歲以上年齡區間內的少部分樣本存在預測值偏小的現象.

同時,本文為了驗證ResMAE網絡模型在使用Masked-Transformer模塊和特征聚合模塊上的效果,以及在Masked-Transformer模塊中使用不同大小的遮蔽率 ?M ??r ?對于模型預測效果的影響,進行了以下消融實驗.

首先,如前文所述,本文采用Transformer模塊來增強卷積神經網絡的特征提取,以此來獲得互補性的年齡相關性特征,并且應用Masked-Transformer結構的隨機遮蔽策略減輕Transformer模塊的過擬合現象.由于Masked-Transformer模塊中不同遮蔽率 ?M ??r ?大小會對模型的性能以及預測效果產生影響,本文在不同遮蔽率大小設置下進行實驗.如表2所示,在ResMAE中采用不同大小的遮蔽率會對結果產生不同的影響,在遮蔽率過小的時候由于Transformer模塊對于全局圖像的過擬合可能會導致網絡的整體性能下降,同時當遮蔽率過大的時候會減弱Transformer模塊對全局依賴的感知能力.當遮蔽率 ?M ??r ?設置為0.2時,ResMAE取得最佳的實驗結果,因此在本文所提及的剩余實驗中也將 ?M ??r ?設置為0.2.

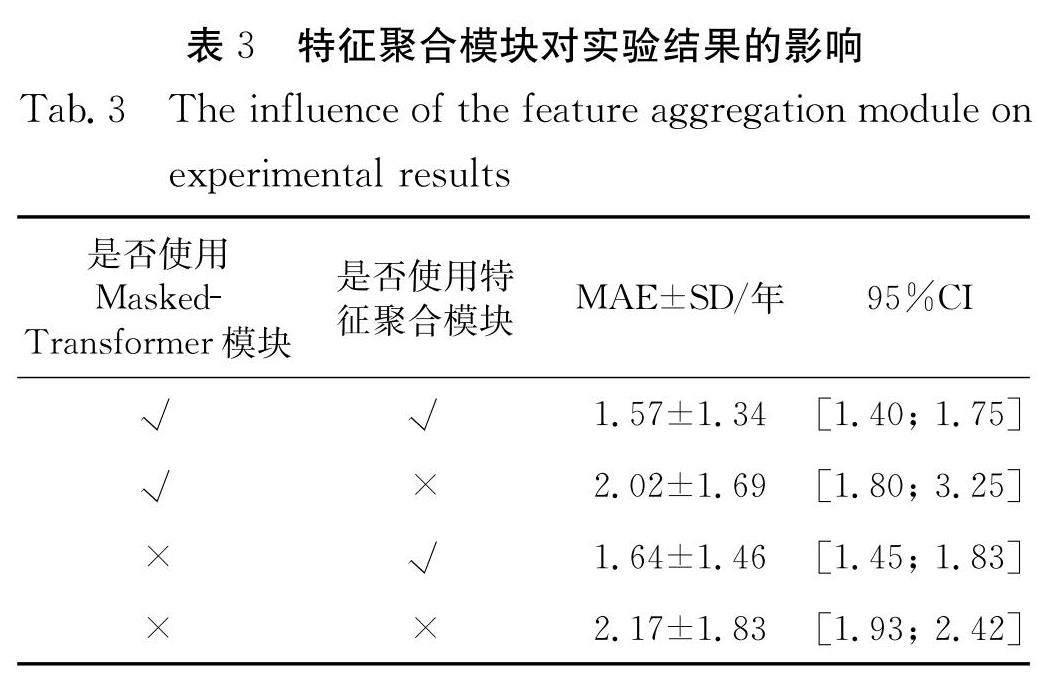

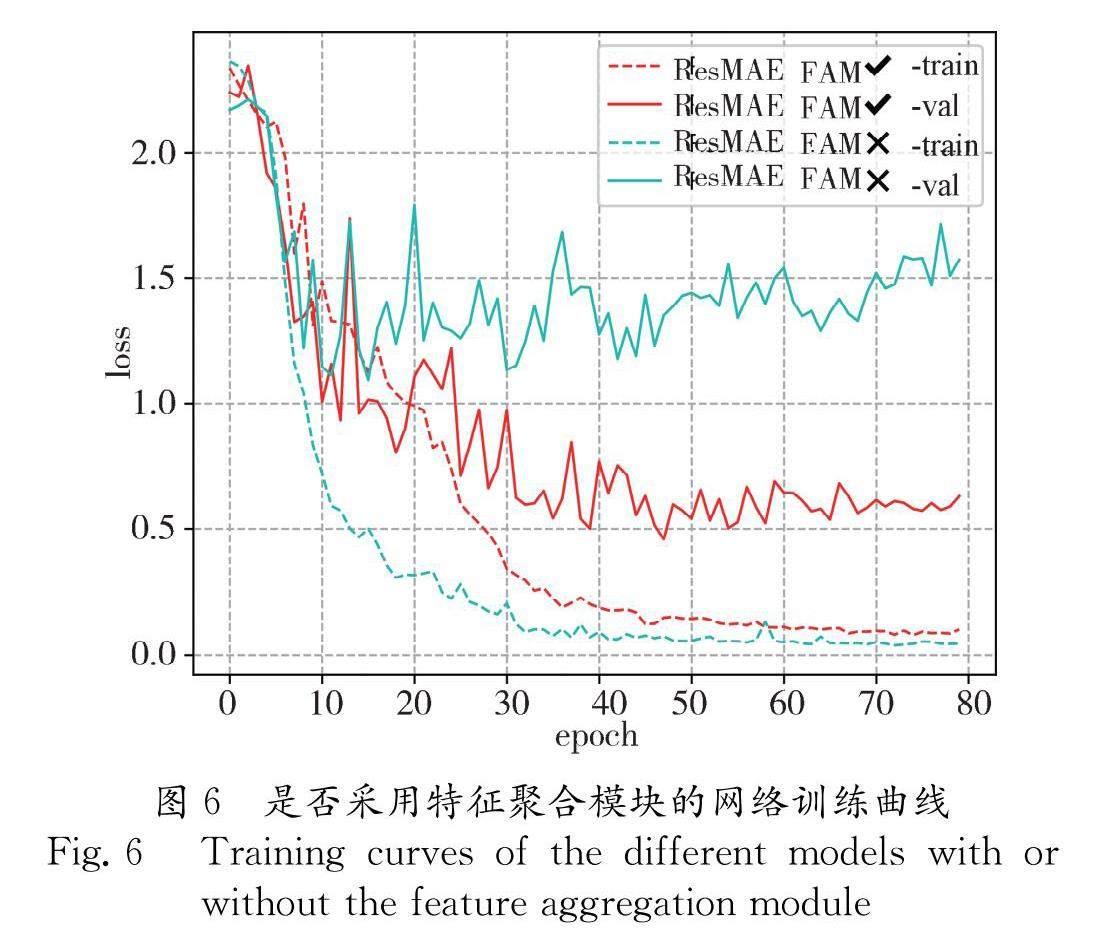

其次,在前一章中提到,特征提取模塊生成所有MRI切片的12個局部特征向量,為了更好地聚合局部切片特征向量,本文使用兩層圖注意力模塊在特征層面上對于局部特征向量進行聚合.為了進一步說明特征聚合模塊的作用以及Transformer模塊對于特征提取的影響,本文對于網絡是否使用特征聚合模塊以及是否用到Masked-Transformer模塊進行了實驗,實驗結果如表3所示.無論網絡是否使用到了Masked-Transformer模塊,與原始的網絡相比,使用了特征聚合模塊的網絡結構可以顯著提升預測效果,預測精度提升大約為0.5年左右.在使用Masked-Transformer增強卷積結構時,由于Transformer模塊在提取全局特征的優勢以及隨機遮蔽策略能夠緩解過擬合現象的特點,使用Masked-Transformer策略對于整體網絡性能提升也能起到較大作用.同時,本文還評估了特征聚合模塊對于網絡收斂速度的貢獻,網絡模型運行的訓練曲線如圖6所示,可以觀察到,在網絡中使用特征聚合模塊可以顯著減少網絡訓練過程中的過擬合現象來加速網絡的擬合速度,并在年齡預測任務中產生更好的性能.通過以上實驗證明,本文通過使用Masked-Transformer模塊實現更全面的特征提取過程,并應用特征聚合模塊將不同切片特征在特征層面實現融合,極大程度上提高了網絡的年齡預測表征能力并減輕過擬合現象.

最后,為了比較臨床醫生和已訓練網絡在本文數據集上的預測表現,本文在表4中展示了專家放射科醫師、醫師助理以及本文的ResMAE網絡的預測結果.從表4中可以看出,膝關節年齡估計需要經過長時間的觀察統計才能手動做出準確的決定,并且由于缺乏專業培訓和相關經驗,醫師助理很難取得良好的預測結果.甚至即使對于該領域的專家而言,在時間和準確性方面也無法超過本文的ResMAE網絡.可以看出,本文的工作可以大大減少膝關節MRI年齡預測任務中的時間消耗和平均絕對誤差,這可以在很大程度上幫助臨床醫生和放射科醫生精確預測年齡.因此,ResMAE可用于幫助專業臨床醫生進行膝關節年齡預測的任務,同時即使是非專業人員,在本文已訓練模型的幫助下,其預測個體年齡的能力也能得到顯著提高.

5 結 論

年齡估計被認為是臨床醫學中的一個重要課題.本文提出了一種新的端到端網絡結構ResMAE,該網絡使用Masked-Transformer模塊來增強卷積特征提取過程,并使用了一個由圖注意力網絡組成的特征聚合模塊來集成不同局部MRI切片圖像的特征以用于膝關節MRI年齡預測任務.具體而言,本文在每個基本塊的卷積塊之后插入Masked-Transformer模塊,以提取所有局部切片特征圖的全局特征,這在實驗中可以證明有助于更準確的年齡預測結果.此外,本文引入了一種基于圖注意力網絡的特征聚合模塊,以將不同MRI切片的特征向量聚合為年齡相關性最強的特征,該結構在特征提取階段發揮了巨大的作用.盡管本文中的總數據集較小,但ResMAE網絡結構在此基礎上也取得了很好的結果,這也展現了其應用在更大的數據集上能產生更好效果的前景.此外,本文方法在很大程度上提高了膝關節MRI年齡估計任務中的預測精度,并縮短了推理時間,這對臨床醫生或放射科醫生的工作有很大幫助.最后,希望本文提出的在卷積神經網絡中插入Masked-Transformer模塊以增強特征提取的想法和在特征層面使用特征聚合模塊的策略能夠對相似醫學圖像回歸或分類任務起到幫助作用.

參考文獻:

[1] ??Creo ?A L, Schwenk W F. Bone age: a handy tool for pediatric providers [J]. Pediatrics, 2017, 140.

[2] ?Schmeling A, Dettmeyer R, Rudolf E, ?et al . Forensic age estimation: methods, certainty, and the law [J]. ?Dtsch Arztebl Int, 2016, 113: 44.

[3] ?Martin D D, Wit J M, Hochberg Z, ?et al . The use of bone age in clinical practice-part1 [J]. Horm Res Paediatr, 2011, 76: 1.

[4] ?Martin D D, Wit J M, Hochberg Z, ?et al . The use of bone age in clinical practice-part2 [J]. Horm Res Paediatr, 2011, 76: 10.

[5] ?Garn S M. Radiographic atlas of skeletal development of the hand and wrist [J]. Am J Hum Genet, 1959, 11: 282.

[6] ?Poznanski ?A K. Assessment of skeletal maturity and prediction of adult height (TW2 method)[J]. Am J Hum Genet, 1977, 131: 1041.

[7] ?Craig J G, Cody D D, Van Holsbeeck M. The distal femoral and proximal tibial growth plates: MR imaging, three-dimensional modeling and estimation of area and volume[J]. Skeletal radiology, 2004, 33: 337.

[8] ?Dedouit F, Auriol J, Rousseau H, ?et al . Age assessment by magnetic resonance imaging of the knee: a preliminary study[J]. Forensic Sci Int, 2012, 217: 232.

[9] ?Cameriere R, Cingolani M, Giuliodori A, ?et al . Radiographic analysis of epiphyseal fusion at knee joint to assess likelihood of having attained 18 years of age [J]. Int J Legal Med, 2012, 126: 889.

[10] ?Faisant M, Rerolle C, Faber C, ?et al . Is the persistence of an epiphyseal scar of the knee a reliable marker of biological age?[J]. Int J Legal Med, 2015, 129: 603.

[11] OConnor J E, Coyle J, Bogue C, ?et al . Age prediction formulae from radiographic assessment of skeletal maturation at the knee in an Irish population [J]. Forensic Sci Int, 2014, 234: 188.

[12] Saint-Martin P, Rérolle C, Pucheux J, ?et al . Contribution of distal femur MRI to the determination of the 18-year limit in forensic age estimation [J]. Int J Legal Med, 2015, 129: 619.

[13] Krmer J A, Schmidt S, Jürgens K U, ?et al . Forensic age estimation in living individuals using 3.0 T MRI of the distal femur[J]. Int J Legal Med, 2014, 128: 509.

[14] Fan F, Zhang K, Peng Z, ?et al . Forensic age estimation of living persons from the knee: comparison of MRI with radiographs [J]. Forensic Sci Int, 2016, 268: 145.

[15] O'Connor J E, Bogue C, Spence L D, ?et al . A method to establish the relationship between chronological age and stage of union from radiographic assessment of epiphyseal fusion at the knee: an Irish population study [J]. J ANAT, 2008, 212: 198.

[16] Dallora A L, Berglund J S, Brogren M, ?et al . Age assessment of youth and young adults using magnetic resonance imaging of the knee: a deep learning approach [J]. JMI, 2019, 7: 16291.

[17] Prve P L, Jopp-van Well E, Stanczus B, ?et al . Automated segmentation of the knee for age assessment in 3D MR images using convolutional neural networks [J]. Int J Legal Med, 2019, 133: 1191.

[18] Mauer M A, Well E J, Herrmann J, ?et al . Automated age estimation of young individuals based on 3D knee MRI using deep learning [J]. Int J Legal Med, 2021, 135: 649.

[19] Veli kovi ?P, Cucurull G, Casanova A, ?et al . Graph attention networks [EB/OL]. (2018-02-04) [2022-12-15]. https://arxiv.org/pdf/1710.10903.pdf.

[20] Szegedy C, Liu W, Jia Y, ?et al . Going deeper with convolutions [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015: 1.

[21] Ronneberger O, Fischer P, Brox T. U-net: Convolutional networks for biomedical image segmentation[C]//International Conference on Medical Image Computing and Computer-assisted Intervention. Munich: Springer, 2015: 234.

[22] He K, Zhang X, Ren S, ?et al . Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016: 770.

[23] Vaswani A, Shazeer N, Parmar N, ?et al . Attention is all you need [C]//Advances in Neural Information Processing Systems. Long Beach: MIT Press, 2017: 5998.

[24] Dosovitskiy A, Beyer L, Kolesnikov A, ?et al . An image is worth 16×16 words: Transformers for image recognition at scale [EB/OL].[2022-12-15]. https://arxiv.org/pdf/2010.11929.pdf.

[25] Dai Z, Liu H, Le Q V, ?et al . Coatnet: Marrying convolution and attention for all data sizes [C]//Advances in Neural Information Processing Systems. Virtual: MIT Press, 2021: 3965.

[26] Peng Z, Huang W, Gu S, ?et al . Conformer: Local features coupling global representations for visual recognition [C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021: 357.

[27] He K, Chen X, Xie S, ?et al . Masked autoencoders are scalable vision learners [C]//Proceedings of the IEEE/CVF ?Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022.

[28] Rothe R, Timofte R, Van Gool L. Dex: deep expectation of apparent age from a single image [C]//Proceedings of the IEEE International Conference on Computer Vision Workshops. Santiago: IEEE, 2015: 252.

[29] Pan H, Han H, Shan S, ?et al . Mean-variance loss for deep age estimation from a face [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 5285.

[30] Tustison ?N J, Avants B B, Cook P A, ?et al . N4ITK: improved N3 bias correction [J]. IEEE T Med Imaging, 2010, 29: 1310.

[31] Li X, Wang W, Hu X, ?et al . Selective kernel networks [C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019: 510.

[32] Xie S, Girshick R, Dollár P, ?et al . Aggregated residual transformations for deep neural networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017: 5987.