基于COSNet的偽裝目標分割

蔣昕昊, 蔡偉, 張志利, 姜波, 楊志勇, 王鑫

(火箭軍工程大學 導彈工程學院, 陜西 西安 710025)

0 引言

在自然界,部分生物為了提升生存能力,可以對自身外形特征進行自適應偽裝,或者根據適者生存的原則保留與棲息地環境更融合的外形特征,從而避免被攻擊者捕食以及更好地埋伏獵物[1]。前者如變色龍,身體表皮顏色可以隨外界環境做出變化[2],后者如白蛾與黑蛾的適者生存實例。

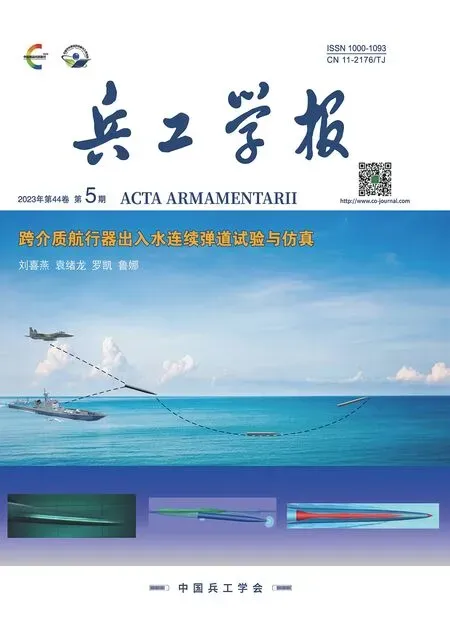

近年來,隨著科學技術的進步,仿生動物偽裝技術在高科技戰爭中得到了廣泛應用,如不斷推陳出新的軍用迷彩服和偽裝網[3],根據戰場環境的差異針對性設計出的荒漠迷彩、叢林迷彩等具有高偽裝性能的偽裝裝備。狙擊手可以利用偽裝技術躲避敵方搜索,特種車輛、裝甲車可以利用偽裝技術騙過敵方可見光偵察。圖1所示士兵和坦克憑借迷彩服、迷彩涂層以及地物遮擋等因素,近乎完美地達到了與背景融為一體的效果。

圖1 軍用偽裝目標示例Fig.1 Example of military camouflaged object

但是,現階段的可見光COS研究寥寥無幾。在軍事領域中,往往會通過借助紅外、高光譜、偏振等其他技術識別偽裝目標[4-6],雖然在一定程度上緩解了可見光識別偽裝目標的局限性,卻忽略了可見光波段下如何精準分割偽裝目標這一科學問題的研究。可見光波段的偽裝目標精確分割仍是需要解決的技術難題。因此,必須提出一種可提高可見光波段偽裝目標分割(COS)準確率的算法。

針對現實需求,本文提出了一種基于人類視覺系統的COS網絡—COSNet的可見光波段COS算法。首先,根據場景多樣、類別多樣、目標偽裝效果多樣的數據集構建原則,構建出數據集MiCOD。然后針對性地構建出COSNet網絡模型,模型由特征提取模塊、聚焦放大模塊和多尺度特征圖融合模塊3部分組成。其中,針對偽裝目標與背景融合度高的特點設計的聚焦放大模塊為模型關鍵模塊,通過模擬人類視覺系統以提高分割精度。包含兩個關鍵串行模塊,即關鍵點聚焦模塊和感受野放大模塊。關鍵點聚焦模塊通過模擬人類注意力高度集中的觀察過程降低虛警率,而感受野放大模塊用以增大觀測感受野以提升分割精度。最后為COS設計了更加適用的關鍵點區域加權感知損失,通過權重給予偽裝目標更高的關注度。

本文的主要貢獻如下:

1)構建了以模擬真實戰場環境為基礎,具有多樣性場景和目標的MiCOD,通過大量實驗證明可為COS的研究提供有效的數據支撐。

2)基于人類視覺系統提出了一種可見光波段COSNet,針對性設計了關鍵點聚焦模塊和感受野放大模塊的串行結構,提出了關鍵點區域加權感知損失以提升分割效果。

3)所提出的COSNet網絡在自建數據集上和通用數據集上均有最好的表現性能,各項指標均優于已公開的優秀算法。

1 相關工作

本節主要對與本文相關的可見光COS算法和語義分割算法進行梳理。

1)可見光COS算法。2020年可以作為基于深度學習的可見光偽裝目標識別的研究元年,有許多學者對此開展了研究。周靜等[7]提出了基于光流場分割的偽裝色運動目標傳統檢測算法。Fan等提出了比較完備的通用偽裝目標數據集COD10K,并提出了相應的COS網絡SINet,推動了偽裝目標識別的快速發展[8],但該數據集未收錄軍用偽裝目標。2021年,Mei等模擬動物捕食過程,提出了基于分心挖掘的COS網絡PFNet[9],但該算法由粗到細的定位聚焦比較耗時。總結來看,現有的COS模型在設計原理和網絡結構上都比較復雜。

2)基于深度學習的圖像分割算法。近年來,通過逐像素進行圖像分類的語義分割技術作為圖像理解的高級任務,得到了廣泛的研究[10-12]。大量基于深度學習的語義分割工作相繼被提出[13-16]。目前主要可以分為基于全卷積網絡(FCN)[17]、卷積神經網絡(CNN)[18]、循環神經網絡(RNN)[19]和對抗神經網絡(GAN)[20]4種。與此同時,還衍生出基于深度學習的顯著目標分割和醫學圖像分割等應用。

2 MiCOD數據集的構建

2.1 數據集構建的必要性

數據集的質量直接決定了網絡模型訓練的優劣,在極大程度上影響著模型的落地應用。而偽裝目標數據集的制作十分困難,因為偽裝目標和背景有較高的“融合度”,相似性極強,難以區分目標和背景的分界線。當前使用量最多的通用偽裝目標數據集主要有2個:1)CAMO數據集包含8個種類的 1 250張偽裝圖像[21];2)COD10K通用偽裝目標數據集,具有78子類的10 000張圖像,該數據集標注十分精細,具有相當大的挑戰性[8]。

軍用偽裝目標由于價值極高,難以獲取公開的圖像和數據,制備難度極大,并且在真實的戰場環境中偽裝目標并不是時時刻刻出現的,大量不含偽裝目標的自然場景是對網絡模型的極大挑戰。使用通用偽裝目標數據集難以保證適用于軍用偽裝目標的分割,因此收集構建完備的軍用偽裝數據集具有極高的軍事意義[22]。

2.2 數據集構建原則和方法

軍用偽裝數據集的構建需要滿足以下原則:

1)軍用偽裝目標類別多樣;

2)采集場景多樣;

3)環境條件多樣。

遵循以上條件構建的多樣性軍用偽裝目標數據集,既能滿足圖像分割的基本條件,又可以防止數據量少帶來的過擬合現象,還能提升網絡模型的分割魯棒性。

需要注意的是,在現實環境中偽裝目標并不總是存在于所有圖像中。因此在數據集中添加了大量的真實場景不含偽裝目標實例的圖像,以更加符合真實的戰場環境,減小虛警率。

綜上所述,軍用偽裝數據集使用可見光攝像機實地采集、網絡搜集典型軍用偽裝目標數據相結合的方式進行構建。

2.3 數據集處理

首先對采集到的所有數據按照構建原則進行二次篩選,保留拍攝效果好、應用價值高的影像資料,剔除無用數據。編程實現視頻取幀,生成連續的圖像數據。

其次通過數據增廣緩解樣本數量少、分布不均衡的情況。為保證增廣后的數據滿足實際環境,內容自然,采用隨機增廣策略,按照隨機概率對數據進行平移、水平/垂直翻轉、旋轉、縮放、裁剪、剪切、對比度處理、色彩抖動處理等操作。對比度和色彩變化等操作通過Pytorch函數實現。圖像變換公式為

(1)

式中:xorg和yorg表示變換前的圖像坐標;xpro和ypro表示變換后的圖像坐標;H表示變換矩陣,包括但不限于表1內的變換矩陣。表1中,Hshift為平移矩陣,dx和dy為橫縱坐標移動的距離常數,Hrotation為旋轉矩陣,θ為順時針旋轉角,Hhorizon為水平翻轉矩陣,Hvertical為垂直翻轉矩陣,Hscale為縮放矩陣,sx和sy為水平縮放因子和垂直縮放因子,Hshear為錯切矩陣,shx和shy為水平錯切角和垂直錯切角。此外,數據增廣還可采用組合增廣(多矩陣相乘)的方式。

表1 變換矩陣

而后通過標注工具Labelme對數據集進行像素級分割標注,獲取數據集中所有的分割真值圖(GT),用于模型的分割訓練和測試結構的精確驗證。

2.4 數據集概述

通過2.3節的數據集處理步驟,最終構建出所需的MiCOD,數據集的概況如表2所示,共4 000張。數據集處理后按照一一對應命名放置,每一類的示例圖如圖2所示。

圖2 數據集示例(左為RGB圖像,右為真值圖)Fig.2 Example of dataset (RGB images on the left, GT maps on the right)

表2 數據集概況

3 COSNet目標分割模型

Hall等[23]通過實驗證明,識別圖像中的偽裝目標與注意力集中程度和觀測時間呈正比。這是因為當人觀測一幅圖像時,往往會首先關注圖像中的顯著區域,但當集中注意力避免分心時,便可以聚焦搜索到圖像中的可疑區域,進而以此為中心,逐步增大觀測面積直至確定目標。

圖3 COSNet目標分割模型網絡結構聚焦放大模塊真值圖Fig.3 Network structure of COSNet object segmentation model

(2)

下面分別對3個組成部分和損失函數的設計思路和具體實現進行詳細論述。

3.1 特征提取模塊

3.2 聚焦放大模塊

3.2.1 關鍵點聚焦模塊KPFM

圖4 關鍵點聚焦模塊結構圖Fig.4 Diagram of KPFM structure

(3)

(4)

(5)

3.2.2 感受野放大模塊RFAM

圖5 感受野放大模塊結構圖Fig.5 Diagram of RFAM structure

3.3 多尺度特征圖融合模塊

(6)

算法1多尺度特征圖融合模塊。

# 1.首輪融合操作

# 2.次輪融合操作

# 3.末輪生成操作

3.4 關鍵點區域加權感知損失函數

在大量的目標分割算法中,二元交叉熵(BCE)函數和交并比(IOU)損失最為常見[25]。然而BCE損失和IOU損失平均處理每個像素點的方式不能適用于偽裝目標檢測。在圖像中,偽裝物體相比于其他物體(尤其是顯著性物體),由于其難以分辨的特性,需要更加關注。

結合設計的聚焦放大模塊,本文提出一種關鍵點區域加權感知損失Lkawa,在BCE損失和IOU損失的基礎上,加入關鍵點區域感知權重,聯合得到Lkawa損失函數:

Lkawa=Lwbce(P,GT)+Lwiou(P,GT)

(7)

(8)

(9)

式中:P為預測圖;GT為真值圖;Lbce(P,GT)為原始BCE損失函數;wij為關鍵點區域感知權重,

(10)

2)范圍越大越需要更大的計算量,意味著訓練速度越慢,因此應使用保證有效的最小值;

3) 應避免出現權重等于1/2的情況,故選取奇數。

總結以上3點,本文選取17×17大小的區域范圍。從式(10)中可以看出,無論偽裝目標在該區域的占比如何,關鍵點區域感知權重均能給予偽裝目標較高的關注度,從而使得模型訓練朝著有利于分割偽裝目標的方向進行。

4 實驗結果與分析

4.1 實驗平臺配置

實驗訓練測試階段使用的硬件平臺配置為:顯卡為NVIDIA Quadro GV100,顯存為32 GB,使用Pytorch深度學習開發框架。CPU為Inter Xeon Silver 4210,操作系統為Windows 10操作系統。訓練時使用Adam優化器進行網絡優化,圖片輸入大小設置為352×352,學習率設置為0.000 1。

4.2 數據集設置

采用3種設置方式對網絡和訓練方式進行綜合性評估:

1)遵循通用偽裝目標數據集的設置方式,假設每幅圖像均含有偽裝目標。即只在包含偽裝目標的圖像上進行訓練和測試。將2 700張含有偽裝目標的圖像采用6∶2∶2的比例劃分為訓練集、驗證集和測試集。此種訓練方式更能證明網絡的分割準確性的高低。

2)模擬真實的戰場環境,即偽裝目標并不總是在視場中出現,即在所有圖像上進行訓練和測試。將4 000張圖像采用6∶2∶2的比例劃分為訓練集、驗證集和測試集。此種訓練方式更能證明網絡的分割虛警率的高低。

3)為證明COSNet算法的泛化性,使用公開的通用偽裝目標數據集進行綜合性評估。通用偽裝目標數據集選取CAMO[21]以及COD10K數據集[8],CAMO有1 250張圖像,COD10K有5 066張偽裝圖像,一共組合為6 316張圖像,按照6∶2∶2的比例劃分為訓練集、驗證集和測試集。

4.3 評價指標

目前適用于COS的指標很多,各項指標關注點均不同,選取了8種常用的評價指標。平均絕對誤差(MAE)計算的是預測圖和真值對應位置之間的像素差異的絕對值之和[26];結構度量Sm是一種結構相似性評價指標,著重評估預測圖的結構信息[27];自適應E-MeasureadpEm可以評估像素級相似效果,也可以獲取圖像級統計信息[28];自適應F-MeasureadpFm是一種綜合的關于預測圖精確度和召回率的評估方法[29];平均dice系數Dicmean用以計算分割準確的面積占GT圖像中真實面積的百分比[30];平均交并比IOUmean計算的是分割預測圖和GT圖之間的交集與并集的面積比;平均靈敏度Senmean可以衡量實際為正樣本的結果有多少被預測為了正樣本,靈敏度越高則漏檢率越低;平均特異度Spemean可以衡量實際為負樣本的結果有多少被預測為了負樣本,特異度越高,虛警率就越低。

4.4 對比算法

為了證明本文COSNet算法的有效性,選取8個經典算法以及最新算法進行比較。其中包括醫學圖像分割算法UNet++[31]、PraNet[32]、UACANet-L[33],顯著性目標分割算法BASNet[34]、SCRN[35]、F3Net[25]和COS算法SINet-V1[8]、PFNet[9]。

為了公平地比較算法的分割性能,所有算法均采用4.1節提出的實驗配置平臺和實驗參數設置,輸入尺寸均設置為352×352。此外,評價指標的計算均采用同一套代碼。評測代碼、測試圖片及評測結果將公布在:https:∥github.com/jiangxinhao2020/COD-eval。

4.5 對比實驗結果分析

4.5.1 對比結果1(每幅圖片均含有偽裝目標)

表3為本文COSNet算法與其他8種算法在MiCOD數據集上的實驗對比結果。由于每張圖像上均有偽裝目標,對于各種優秀網絡的挑戰性不強,主要體現了網絡本身的特征提取能力和分割精準度。由表3可以看出,COSNet算法在7項指標上達到最優,綜合分割能力最好,尤其是平均靈敏度Senmean較最新算法UACANet-L提升了6%,這意味著COSNet算法具有最低的漏檢率。由于每張圖像均有偽裝目標,故每種模型的平均特異度Spemean值均比較高,而COSNet算法仍高出1%,即說明COSNet算法同時具有最低的虛警率。漏檢率和虛警率的平衡在實際應用中尤為重要,代表了網絡模型的穩定性。

表3 在自建MiCOD數據集上的對比實驗結果1(每幅圖片均含有偽裝目標)

注:□表示醫學圖像分割算法,◇表示顯著性目標分割算法,?表示COS算法。

4.5.2 對比結果2(模擬真實環境,每幅圖片不總是含有偽裝目標)

表4為模擬真實環境,數據集4 000張圖片全部參與訓練測試時的實驗結果。從表4中可以看出,相較于設置方式1的評價結果,僅有Sm和adpEm整體有所提升,這是因為Sm評估的是預測圖和真值圖之間的結構相似性,adpEm的評價計算中則涉及全局統計平均值,大量不含偽裝目標的圖像使得這兩項指標平均下來得分較高。而其他評價指標下降較大,表明模擬真實環境的MiCOD數據集對于目標分割網絡模型十分具有挑戰性。但在本文實驗中,COSNet算法在8項指標上均優于其他算法,其中,平均交并比IOUmean提升最為明顯,較最新算法UACANet-L大幅提升了7.5%,實現了性能的顯著增強,證明了本文提出的COSNet算法在MiCOD數據集上的有效性和精準性。

表4 在自建MiCOD數據集上的對比實驗結果2(每幅圖片不總是含有偽裝目標)

表5為本節在自建MiCOD數據集對比實驗的可視化對比結果。由表5可以看出,COSNet算法能夠更加精準地分割出偽裝目標。關鍵點聚焦模塊通過模擬人類視覺注意力機制,可以獲取通道上和空間上更為重要的信息,從而可以精準分割出偽裝目標的細節區域(如圖像5坦克頂部的細節區域)。感受野放大模塊通過放大感受野和融合多尺度特征可以較好地識別出隱藏在復雜背景中的小目標和細長目標(如圖像1中士兵手持的武器)。關鍵點區域加權感知損失函數的引入使得網絡模型更加關注偽裝目標關鍵點附近區域,從而減少分割虛警率(如最后一列不含偽裝目標的背景圖)。

表5 在自建MiCOD數據集上的可視化對比結果

4.5.3 對比結果3(通用偽裝目標數據集)

COSNet算法與其他8種算法在通用偽裝目標數據集上的實驗結果對比如表6所示。由表6可以看出,通用偽裝目標數據集類別比較復雜,但COSNet算法仍能在7項指標上優于其他算法,其中提升最明顯的是adpFm,比UACANet-L算法提升了2.3%,僅有adpEm指標與UACANet-L算法持平。綜合分析來看,COSNet在通用COS數據集上的泛化性能良好,證明了COSNet算法在COS這一任務上的優勢。

表6 在通用偽裝目標數據集上的對比實驗結果

表7為通用偽裝目標數據集全部對比實驗的可視化結果。由表7可以看出,COSNet算法可以較好地排除其他干擾,精準定位偽裝目標關鍵點,且能夠清晰地識別出目標輪廓。依賴于關鍵點聚焦模塊,模型可以精準分割出如圖像1中昆蟲觸須等細節區域,感受野放大模塊則使得模型可以適用于各個尺度的偽裝目標,如圖像4中的小目標也能較好地分割出來。關鍵點區域加權感知損失函數則通過權重的變化使得網絡模型能夠處理如圖像3偽裝目標被部分遮擋的情況。

4.6 模塊消融實驗結果分析

為驗證針對性設計的兩個仿生模塊(即關鍵點聚焦模塊KPFM和感受野放大模塊RFAM)的有效性,在數據集第1種設置方式(即每幅圖片均含偽裝目標)的條件下進行了消融實驗。

表8全面展示了COSNet算法的消融實驗結果(√表示使用該模塊)。從表8中可以發現,分別單獨添加兩個模塊后,對模型性能均有不同程度的提高。其中,單獨添加關鍵點聚焦模塊KPFM,對各項指標雖提高不明顯,但該模塊的效果主要體現在對辨別特征圖的重要程度上(見定性分析);而單獨添加感受野放大模塊RFAM后,使得adpEm達到最優,這是因為RFAM的感受野放大機制起了作用,提升了像素級相似效果,通過多尺度特征提取,實現了全局圖像級統計信息的高效利用。最終的融合圖則達到了性能上的綜合最優效果。

表8 在自建MiCOD數據集上的消融實驗結果

將關鍵點聚焦模塊KPFM和感受野放大模塊RFAM輸出的特征圖進行可視化,并與最終融合后的特征圖進行對比,結果如表9所示。KPFM輸出的特征圖證明了該模塊更加關注偽裝目標的關鍵點,即目標中心區域,確保模型能夠找到正確的偽裝目標,從而降低復雜環境下目標分割的虛警率;而RFAM模塊在找到關鍵點的基礎上,通過增大觀測感受野,從全局出發尋找偽裝目標,從而保留更多偽裝目標的重要信息,可以有效解決多尺度目標分割的難題。融合后的輸出偽裝特征圖結合了兩個模塊的特點,實現了仿生人類視覺系統探測目標的過程,可以以偽裝目標中心為關鍵點,通過放大感受野,精準尋找關鍵點附近偽裝目標的重要信息,以提高分割的準確性,使得分割的漏檢率和虛警率實現較好的平衡。

表9 在自建MiCOD數據集上的消融實驗可視化對比結果

5 結論

為了實現更加精準的COS,本文從數據集和網絡模型兩方面入手開展研究。首先依據現實需求和真實戰場環境,構建了軍用偽裝目標數據集MiCOD,共4 000張圖片,均為像素級標注。然后通過仿生人類視覺系統構建了COS網絡—COSNet,針對性設計了串行的關鍵點聚焦模塊和感受野放大模塊,且提出了更加適用的關鍵點區域加權感知損失函數。

在自建的MiCOD數據集和通用偽裝目標數據集上進行了充分的對比實驗,證明了COSNet在COS方面的綜合性性能優勢,8項指標均達到最優效果,且通過消融實驗證明了COSNet關鍵模塊的作用原理和仿生效果。

使用模擬真實戰場環境的數據集時,COSNet平均靈敏度Senmean為0.622,平均特異度Spemean為0.670,表明自建的MiCOD數據集具有一定的挑戰性,各項指標仍有很大的提高空間,可為后續COS的研究提供較好的數據支持。