復雜場景下自適應特征融合的圖像運動目標跟蹤算法研究

朱冰 劉琦 余瑞星

摘要:? ? ? 針對目標跟蹤所面臨的尺度變化、 快速運動導致的跟蹤漂移或失敗問題, 提出一種復雜場景下自適應特征融合的圖像運動目標跟蹤算法。 本文分別設計了目標分類和目標估計模塊, 并將其有效結合。 在目標分類模塊, 設計了一種自適應特征融合機制。 該機制融合了多層深度特征以實現有效的在線跟蹤。 此外, 設計的聯合更新策略通過優化投影矩陣層和相關層, 在處理運動模糊、 嚴重目標形變時具有更強的魯棒性。 在目標估計模塊, 引入IoU(Intersection over Union)最大化的理念, 預測目標和估計邊界框之間的IoU分數, 在跟蹤過程中, 通過使用梯度上升最大化IoU分數來估計目標狀態, 獲得更加精確的邊界框。 實驗結果表明,? 本文所提出的算法具有更出色的跟蹤性能, 其在OTB100, UAV123及LaSOT數據集上的SAUC分別為70.1%, 47.6%和51.6%, 優于其他相關算法。

關鍵詞:? ? ?目標跟蹤; 深度學習;? 目標分類; 目標估計; 特征融合中圖分類號:? ? ? TJ760; V249

文獻標識碼:? ? A文章編號:? ? ?1673-5048(2023)02-0125-06

DOI: 10.12132/ISSN.1673-5048.2022.0094

0引言

目標跟蹤[1]是許多應用領域不可缺少的一部分, 屬于計算機視覺的基本分支。 到目前為止, 許多跟蹤挑戰, 例如尺度變化、 快速運動、 形變、 遮擋、 平面旋轉和背景雜波[2]等, 仍然有待解決。 一般跟蹤問題可分為分類任務和估計任務。 在目標分類任務中, 通過將圖像區域劃分為前景和背景來提供目標在圖像中的粗略位置。 而目標估計任務是估計目標狀態, 通常用一個邊界框來表示。

近年來, 深度神經網絡[3]一直是跟蹤研究中的重點, 已經有大量研究使用深度特征完成目標跟蹤, 該類跟蹤器[4]在準確性方面具有優勢, 但其魯棒性卻低于其他跟蹤器。 這是由于在深度神經網絡設計中, 現有算法幾乎沒有設計單獨的網絡模塊來完成目標的狀態估計[5]。 事實上, 目前最先進的跟蹤器[6]仍然是依靠分類進行多尺度搜索來估計目標, 這種算法難以處理因跟蹤目標發生尺度變化導致的跟蹤結果不準確甚至跟蹤失敗的問題。 為此, 本文將跟蹤中的目標估計模塊和目標分類模塊相結合。 在目標分類模塊中, 為了提供一種更好的特征表示, 充分利用多層深度特征所提供的不同信息, 提出一種自適應特征融合策略, 實現目標的粗定位, 并設計一種更新策略, 在外觀明顯變化期間對目標實現精確跟蹤。 在目標估計模塊中, 通過邊界框來預測目標的狀態, 利用IoU-Net[7]方法中IoU最大化思想來進行調整以得到精確的目標邊界框。 實驗結果表明, 與現有算法相比, 本文所提出的算法在保持魯棒性的同時, 能更加精確地估計目標狀態, 具有良好的性能。

1復雜場景下自適應特征融合的運動目標跟蹤算法

1.1目標估計模塊

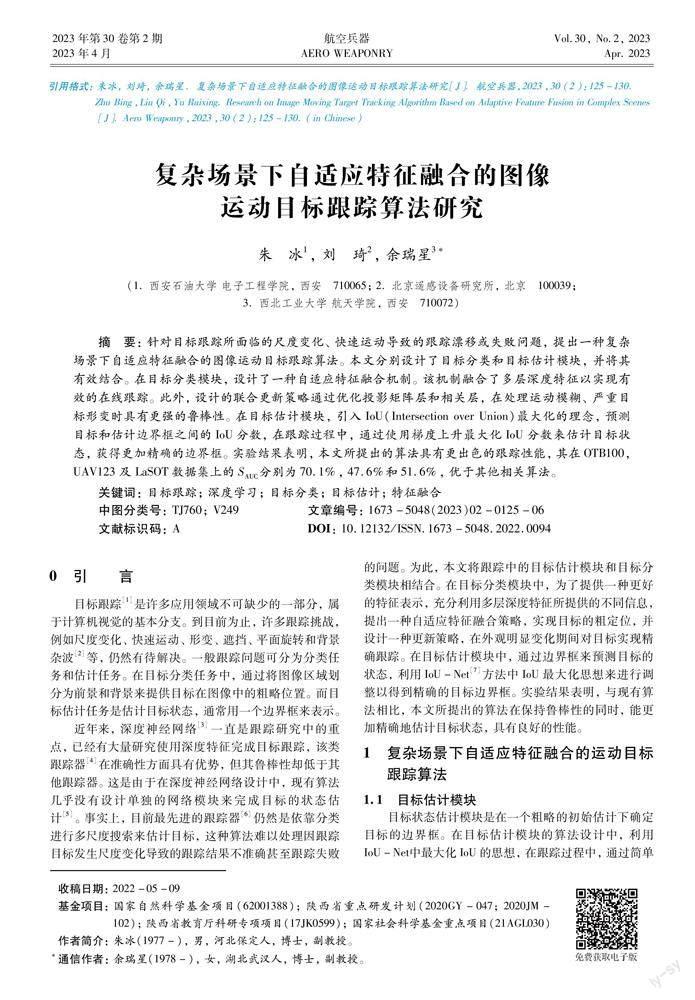

目標狀態估計模塊是在一個粗略的初始估計下確定目標的邊界框。 在目標估計模塊的算法設計中,? 利用IoU-Net中最大化IoU的思想, 在跟蹤過程中, 通過簡單地最大化每一幀中預測的IoU來調整所得的目標邊界框, 該模塊網絡架構如圖1所示。

從網絡架構圖可以看出, 目標估計模塊由兩個分支組成: 參考分支和測試分支。 在參考分支中, 參考圖像的特征和目標的初始邊界框標注作為輸入, 經過骨干網絡ResNet-50[8]提取其Block 3的特征, 并將其送到卷積層[9], 然后根據輸入的參考圖像指定區域對特征圖進行PrRoI(Precise Region of Interest) pooling[10]操作, 得到兩個大小一致的局部特征圖。 參考分支的輸出是一個系數向量y(xr, b), 向量的大小是1×1×Dy, 而且向量內部的元素都是大于0的數。 由圖1可見, 參考分支的網絡結構主要由卷積層、 PrRoI pooling和全連接層組成[11]。

1.2目標分類模塊

1.3自適應特征融合策略

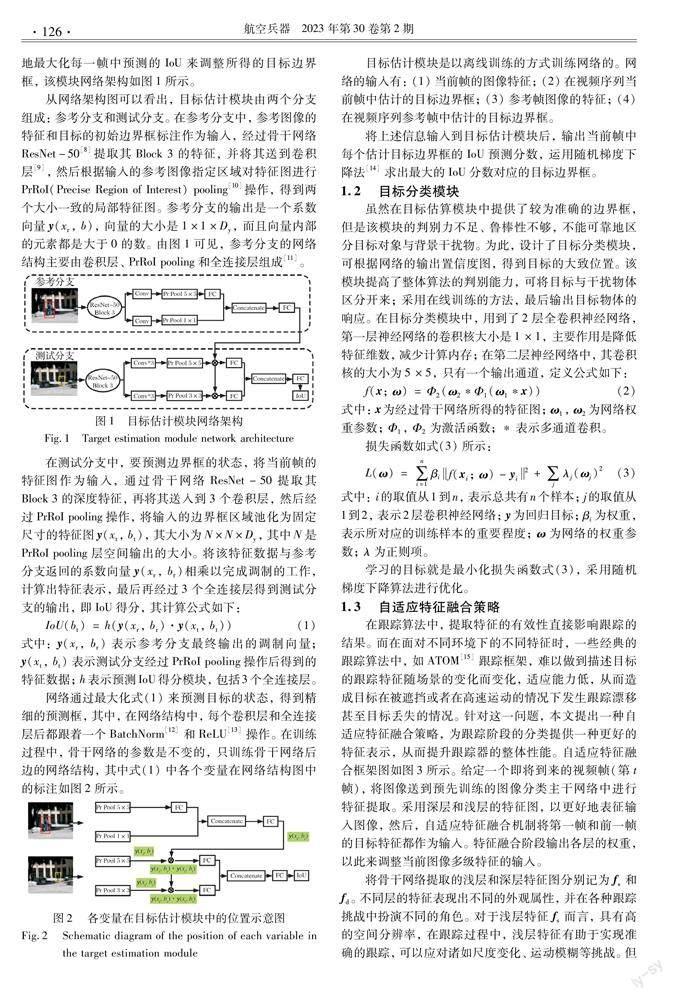

在跟蹤算法中, 提取特征的有效性直接影響跟蹤的結果。 而在面對不同環境下的不同特征時, 一些經典的跟蹤算法中, 如ATOM[15]跟蹤框架, 難以做到描述目標的跟蹤特征隨場景的變化而變化, 適應能力低, 從而造成目標在被遮擋或者在高速運動的情況下發生跟蹤漂移甚至目標丟失的情況。 針對這一問題, 本文提出一種自適應特征融合策略, 為跟蹤階段的分類提供一種更好的特征表示, 從而提升跟蹤器的整體性能。 自適應特征融合框架圖如圖3所示。 給定一個即將到來的視頻幀(第t幀), 將圖像送到預先訓練的圖像分類主干網絡中進行特征提取。 采用深層和淺層的特征圖, 以更好地表征輸入圖像, 然后, 自適應特征融合機制將第一幀和前一幀的目標特征都作為輸入。 特征融合階段輸出各層的權重, 以此來調整當前圖像多級特征的輸入。

將骨干網絡提取的淺層和深層特征圖分別記為fs和fd。 不同層的特征表現出不同的外觀屬性, 并在各種跟蹤挑戰中扮演不同的角色。 對于淺層特征fs而言, 具有高的空間分辨率, 在跟蹤過程中, 淺層特征有助于實現準確的跟蹤, 可以應對諸如尺度變化、 運動模糊等挑戰。 但是, 在諸如平面外旋轉或變形的情況下, 淺層特征的貢獻就相對較小。 相比之下, 深層特征fd包含了更多的語義信息, 能夠解決淺層特征無法解決的問題。 另一方面, 多層特征提供了多尺度信息, 這對于目標的分類至關重要。 因此, 將淺層特征fs和深層特征fd在通道維度上連接起來, 形成更豐富、 更完整的特征表示。 值得注意的是, 淺層特征fs和深層特征fd的空間分辨率不同, 直接連接不便于后面的關聯操作。 因此, 需要將淺層特征fs和深層特征fd的大小調整為相同的空間維度。 總之, 將淺層特征和深層特征相融合, 通過整合利用淺層和深層優勢的外觀信息, 可以獲得更強大的分類特征表示。

1.4更新策略

自適應特征融合機制通過融合淺層特征和深層特征, 成功地抑制了冗余和誤導性信息。 為了進一步消除高維融合特征的數據冗余, 采用投影矩陣層通過1×1卷積層進行降維。 該操作降低了計算成本, 并且增加了分類模塊中相關濾波的魯棒性。

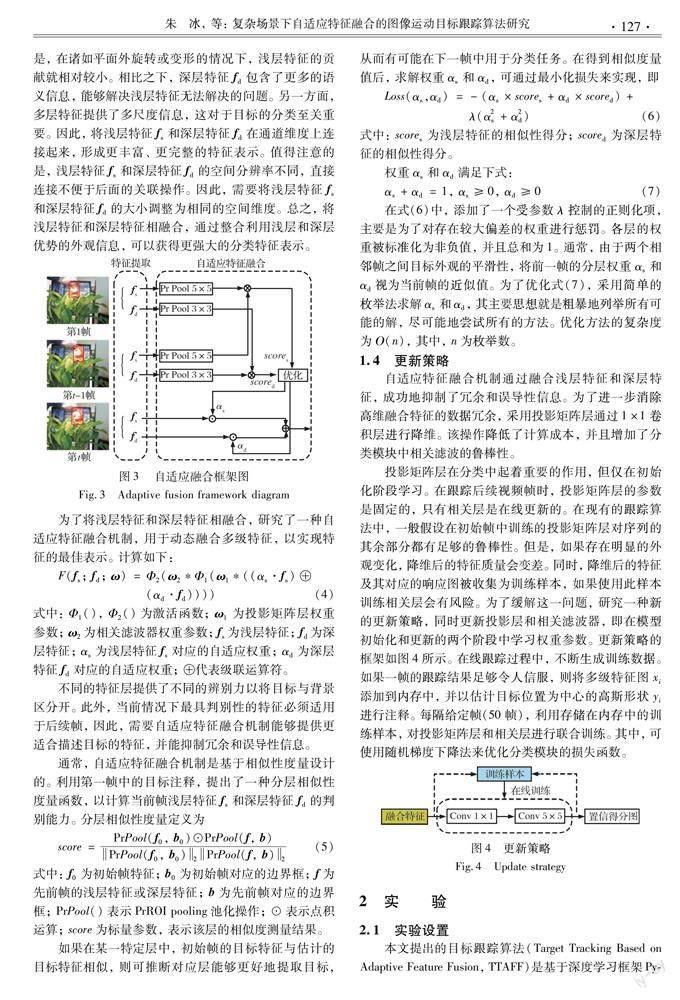

投影矩陣層在分類中起著重要的作用, 但僅在初始化階段學習。 在跟蹤后續視頻幀時, 投影矩陣層的參數是固定的, 只有相關層是在線更新的。 在現有的跟蹤算法中, 一般假設在初始幀中訓練的投影矩陣層對序列的其余部分都有足夠的魯棒性。 但是, 如果存在明顯的外觀變化, 降維后的特征質量會變差。 同時, 降維后的特征及其對應的響應圖被收集為訓練樣本, 如果使用此樣本訓練相關層會有風險。 為了緩解這一問題, 研究一種新的更新策略, 同時更新投影層和相關濾波器, 即在模型初始化和更新的兩個階段中學習權重參數。 更新策略的框架如圖4所示。 在線跟蹤過程中, 不斷生成訓練數據。 如果一幀的跟蹤結果足夠令人信服, 則將多級特征圖xi添加到內存中, 并以估計目標位置為中心的高斯形狀yi進行注釋。 每隔給定幀(50幀), 利用存儲在內存中的訓練樣本,? 對投影矩陣層和相關層進行聯合訓練。? 其中, 可使用隨機梯度下降法來優化分類模塊的損失函數。

2實驗

2.1實驗設置

本文提出的目標跟蹤算法(Target Tracking Based on Adaptive Feature Fusion, TTAFF)是基于深度學習框架PyTorch在python中實現的。? 使用在ImageNet上經過預訓練的ResNet-50作為本文跟蹤算法的骨干網絡。 目標估計模塊采用離線訓練, 離線訓練數據集為LaSOT數據集。 目標估計模塊包括參考分支和測試分支, 對數據集進行采樣并添加擾動, 分別生成參考分支數據集圖像和測試分支數據集圖像。 使用均方差損失函數, 訓練50個周期, 每批包含64個樣本對, 采用隨機梯度下降法來最小化損失函數, 訓練網絡模型; 目標分類模塊采用在線訓練。 為了充分驗證所提出的目標跟蹤算法的有效性, 將該算法與其他現有的目標跟蹤算法在OTB100[16], UAV123[17], LaSOT[18]數據集上作比較, 并進行性能評價。

2.2特征融合權重自適應過程

圖5顯示了在跟蹤過程中特征權重的自適應過程。 其中(a)~(d)為person 7序列, (e)~(h)為car 4序列。

一般情況下, 本文算法能夠很好地平衡淺層特征權重αs和深層特征權重αd。 從圖5可以看出, 當面臨運動模糊(如圖5(b))、 尺度變化(如圖5(d)), 以及區分目標和類間干擾物(如圖5(f)和(h))等挑戰時, 由于淺層特征可以提供詳細的空間信息, 因此淺層特征的貢獻較多, 淺層特征權重αs增大。 當目標出現變形(如圖5(c))和遮擋(如圖5(g))等挑戰時, 相應的深層特征權重αd的值增大。 以上實驗結果證明, 自適應融合策略可以適應目標跟蹤中的各種挑戰, 實現更好的跟蹤效果。

2.3不同算法對比實驗

2.4消融實驗

本文采用消融實驗在OTB100數據集上評估所提方法中每部分的影響。 該數據集包含了種類繁多的視頻, 這些視頻在許多方面都具有挑戰性, 比如變形、 遮擋和干擾等。

2.4.1目標估計模塊的影響

將目標狀態估計模塊與僅使用分類模型的多尺度搜索方法進行比較, 結果如表3所示,表中COP0.5為重疊精度, 其值越大跟蹤成功率越高。 在SAUC中, 本文方法明顯優于多尺度方法, 并使邊界框預測的百分比增加了20%左右, 得到較高精度的邊界框。

2.4.2目標分類模塊影響

將目標分類模塊從跟蹤框架中排除, 以調查其影響。 表3中無分類模塊表示僅使用目標估計模塊來跟蹤, 使用了較大的搜索區域, 所得方法的SAUC達到37.1%, 比本文所提出的方法少了近30%。

2.4.3自適應特征融合策略影響

在OTB100數據集上進行消融研究, 結果見表4。 由表4可以得到如下的結論: 首先, 與使用一層特征相比, 利用多層特征可以獲得更好的性能。 其次, 利用所提出的自適應特征融合機制, 跟蹤效果優于多層特征直接級聯。 其中, 與利用第3層特征相比, 直接級聯第2層和第3層特征的精度得分為83.9%。 當采用自適應融合特征后, 跟蹤效果提高了0.6%, 達到84.5%。 需要注意的是, 當直接級聯第2層和第4層的特征時, 精度得分會下降, 這歸因于第4層的特征經過調整大小后包含了冗余和誤導性信息。 然而, 與僅使用第2層特征和第2層與第4層的直接級聯版本相比, 自適應融合版本分別提高了0.5%和2.8%。 實驗結果進一步驗證了所提出的自適應特征融合機制的有效性。

由表4可以看到, 第3層特征和第4層特征直接級聯后性能大幅下降, 達到67.4%。 這表明, 在特征融合過程中, 低層次的判別細節信息和高層次的語義信息是互補的。? 在第3層和第4層特征融合上應用自適應特征融合機制, 精度分數提高了3.8%。 對第2層、 第3層和第4層的特征進行整合后, 在直接級聯和自適應的特征融合版本中, 跟蹤精度分別達到81.6%和81.9%。

2.4.4更新策略影響

如表4所示, 投影矩陣層和相關層同時更新的策略提高了跟蹤性能。? 分別利用單層特征和多層特征作為輸入來評估其有效性。 更新策略以第2層和第3層的特征作為輸入, 性能分別提高了1.1%和1.3%。 此外, 本文所提出的策略在使用融合特征時也是有效的。 當投影矩陣和相關層的輸入融合第2層和第3層的特征時, 精度分數提高了約0.7%。

3結論

本文提出復雜場景下運動目標的跟蹤算法, 通過在目標分類模塊中設計一種自適應特征融合策略, 以提供更好的特征表示, 并提出一種更新策略, 使得在目標外觀發生明顯變化時, 仍能實現精確的跟蹤, 最終將目標跟蹤問題中的目標分類模塊和目標估計模塊相結合, 使目標發生尺度變化、 快速運動等時, 算法魯棒性更強, 達到改進目的。

參考文獻:

[1] 陳旭, 孟朝暉. 基于深度學習的目標視頻跟蹤算法綜述[J]. 計算機系統應用, 2019, 28(1): 1-9.Chen Xu, Meng Zhaohui. Survey on Video Object Tracking Algorithms Based on Deep Learning[J]. Computer Systems & Applications, 2019, 28(1): 1-9.(in Chinese)

[2] Villeneuve E, Harwin W, Holderbaum W, et al. Signal Quality and Compactness of a Dual-Accelerometer System for Gyro-Free Human Motion Analysis[J]. IEEE Sensors Journal, 2016, 16(16): 6261-6269.

[3] Danelljan M, Bhat G, Khan F S, et al. ECO: Efficient Convolution Operators for Tracking[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2017.

[4] Qi Y K, Zhang S P, Qin L, et al. Hedged Deep Tracking[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2016.

[5] 盧湖川, 李佩霞, 王棟. 目標跟蹤算法綜述[J]. 模式識別與人工智能, 2018, 31(1): 61-76.Lu Huchuan, Li Peixia, Wang Dong. Visual Object Tracking: A Survey[J]. Pattern Recognition and Artificial Intelligence, 2018, 31(1): 61-76.(in Chinese)

[6] Han B, Sim J, Adam H. BranchOut: Regularization for Online Ensemble Tracking with Convolutional Neural Networks[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2017.

[7] Jiang B R, Luo R X, Mao J Y, et al. Acquisition of Localization Confidence for Accurate Object Detection[C]∥Computer Vision-ECCV, 2018.

[8] He K M, Zhang X Y, Ren S Q, et al. Deep Residual Learning for Image Recognition[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2016.

[9] 閔召陽, 趙文杰. 基于深度學習的目標抗干擾跟蹤算法[J]. 紅外技術, 2018, 40(2): 176-182.Min Zhaoyang, Zhao Wenjie. Target Anti-Jamming Tracking Algorithm Based on Depth Learning[J]. Infrared Technology, 2018, 40(2): 176-182.(in Chinese)

[10] Lin M, Chen Q, Yan S C. Network in Network[C]∥International Conference on Learning Representations (ICLR), 2014.

[11] Hinton G E, Srivastava N. Krizhevsky A, et al. Improving Neural Networks by Preventing Co-Adaptation of Feature Detectors[C]∥International Conference on Machine Learning (ICML), 2012.

[12] Galoogahi H K, Fagg A, Lucey S. Learning Background-Aware Correlation Filters for Visual Tracking[C]∥IEEE International Conference on Computer Vision (ICCV), 2017: 1144-1152.

[13] Nair V, Hinton G E. Rectified Linear Units Improve Restricted Boltzmann Machines[C]∥International Conference on Machine Learning (ICML), 2010.

[14] Qian N. On the Momentum Term in Gradient Descent Learning Algorithms[J]. Neural Networks, 1999, 12(1): 145-151.

[15] Danelljan M, Bhat G, Khan F S, et al. ATOM: Accurate Tracking by Overlap Maximization[C]∥IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019.

[16] Wu Y, Lim J, Yang M H. Object Tracking Benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[17] Mueller M, Smith N, Ghanem B. A Benchmark and Simulator for UAV Tracking[C]∥Computer Vision-ECCV, 2016.

[18] Fan H, Lin L T, Yang F, et al. LaSOT: A High-Quality Benchmark for Large-Scale Single Object Tracking[C]∥IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019.

[19] Danelljan M, Robinson A, Shahbaz Khan F, et al. Beyond Correlation Filters: Learning Continuous Convolution Operators for Vi-sual Tracking[C]∥Computer Vision-ECCV, 2016.

[20] Nam H, Han B. Learning Multi-Domain Convolutional Neural Networks for Visual Tracking[C]∥IEEE Conference on Compu-ter Vision and Pattern Recognition, 2016.

[21] Bhat G, Danelljan M, van Gool L, et al. Learning Discriminative Model Prediction for Tracking[C]∥IEEE/CVF International Conference on Computer Vision (ICCV), 2019

[22] Bertinetto L, Valmadre J, Golodetz S, et al. Staple: Complementary Learners for Real-Time Tracking[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2016.

[23] Bertinetto L, Valmadre J, Henriques J F, et al. Fully-Convolutional Siamese Networks for Object Tracking[C]∥Computer Vision-ECCV, 2016.

[24] Galoogahi H K, Fagg A, Lucey S. Learning Background-Aware Correlation Filters for Visual Tracking[C]∥IEEE International Conference on Computer Vision (ICCV), 2017.

[25] Li F, Tian C, Zuo W M, et al. Learning Spatial-Temporal Regularized Correlation Filters for Visual Tracking[C]∥IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2018.

[26] Danelljan M, Hger G, Khan F S, et al. Learning Spatially Regularized Correlation Filters for Visual Tracking[C]∥IEEE International Conference on Computer Vision (ICCV), 2015.

[27] Li B, Wu W, Wang Q, et al. SiamRPN++: Evolution of Siamese Visual Tracking with Very Deep Networks[C]∥IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019.

[28] Zhao S C, Xu T Y, Wu X J, et al. Adaptive Feature Fusion for Visual Object Tracking[J]. Pattern Recognition, 2021, 111: 107679.

[29] Song Y B, Ma C, Wu X H, et al. VITAL: VIsual Tracking via Adversarial Learning[C]∥IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2018.

[30] Choi J, Chang H J, Fischer T, et al. Context-Aware Deep Feature Compression for High-Speed Visual Tracking[C]∥IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2018.

Research on Image Moving Target Tracking Algorithm Based on

Adaptive Feature Fusion in Complex Scenes

Zhu Bing Liu QiYu Ruixing

(1. School of Electronic Engineering, Xian Shiyou University, Xian 710065, China;

2. Beijing Institute of Remote Sensing Equipment, Beijing 100039, China;

3. School of Astronautics, Northwestern Polytechnical University, Xian 710072, China)

Abstract: Aiming at the problems of tracking drift or failure in target tracking for the scale change and fast motion, a image moving target tracking algorithm based on adaptive feature fusion in complex scenes is proposed. In this paper, the target classification module and target estimation module is designed respectively and combined effectively. In the target classification module, an adaptive feature fusion mechanism is designed, and it integrates multi-layer depth features so as to achieve effective online tracking. Moreover, the designed joint update strategy is more robust in dealing with motion blur and severe target deformation by optimizing the projection matrix layer and the correlation la-yer. In the target estimation module, the concept of IoU(Intersection over Union) maximization is introduced to predict the IoU score between bounding boxes and the estimation target. During the tracking process, the target state is estimated by using gradient ascent to maximize the IoU score to obtain a more accurate bounding box. Experimental results show that the proposed algorithm has excellent performance, with SAUC of 70.1%, 47.6%, 51.6% on OTB100, UAV123 and LaSOT datasets, which is superior to other related algorithms.

Key words: target tracking; deep learning;? target classification; target estimation; feature fusion