攔截機(jī)動(dòng)目標(biāo)的信賴域策略優(yōu)化制導(dǎo)算法

陳文雪,高長(zhǎng)生,荊武興

哈爾濱工業(yè)大學(xué) 航天學(xué)院,哈爾濱 150001

針對(duì)高速性、機(jī)動(dòng)性的臨近空間目標(biāo)攔截制導(dǎo)問(wèn)題是目前單枚彈道導(dǎo)彈防御中的一個(gè)研究熱點(diǎn)及難點(diǎn)問(wèn)題。近些年來(lái),隨著航天領(lǐng)域制導(dǎo)技術(shù)的發(fā)展,古典導(dǎo)引律、現(xiàn)代導(dǎo)引律均得到了快速發(fā)展。古典制導(dǎo)控制方法中,比例導(dǎo)引與其各種改進(jìn)方法因其結(jié)構(gòu)簡(jiǎn)單、易于實(shí)現(xiàn)及有效性得到了廣泛應(yīng)用[1-2]。文獻(xiàn)[3]運(yùn)用比例導(dǎo)引律(Proportional Navigation,PN)研究理想導(dǎo)彈在不同初始條件下對(duì)目標(biāo)的攔截問(wèn)題,文獻(xiàn)[4]基于純比例導(dǎo)引律(Pure Proportional Navigation,PPN)研究針對(duì)有界分段連續(xù)時(shí)變機(jī)動(dòng)目標(biāo)的捕獲能力,在PPN 的基礎(chǔ)上文獻(xiàn)[5]考慮攔截碰撞角約束提出一種基于純比例導(dǎo)引律的攔截碰撞角約束(Pure Proportional Navigation Intercept Angle Constraint Guidance,PPNIACG)制導(dǎo)算法。文獻(xiàn)[6]研究擴(kuò)展真比例導(dǎo)引律(Ture Pro‐portional Navigation,TPN),并將其應(yīng)用于具有較小航向誤差的簡(jiǎn)單攔截場(chǎng)景。文獻(xiàn)[7]在比例導(dǎo)引律的基礎(chǔ)上提出一種改進(jìn)比例導(dǎo)引律,提高了針對(duì)大氣層外高機(jī)動(dòng)目標(biāo)的命中精度。由上述研究可知,雖然比例導(dǎo)引及其變結(jié)構(gòu)形式在制導(dǎo)律設(shè)計(jì)中得到了廣泛應(yīng)用,但其缺陷也在應(yīng)用過(guò)程中逐漸凸顯,當(dāng)攔截機(jī)動(dòng)能力較大的目標(biāo)時(shí),其攔截效果并不理想,甚至造成脫靶。

針對(duì)傳統(tǒng)制導(dǎo)律存在的缺陷,隨著經(jīng)典控制理論的發(fā)展,將經(jīng)典控制理論與制導(dǎo)方法相結(jié)合的現(xiàn)代制導(dǎo)理論逐漸得到發(fā)展。文獻(xiàn)[8]考慮導(dǎo)彈三維制導(dǎo)問(wèn)題中的耦合作用,提出了一種將有限時(shí)間控制和非線性干擾觀測(cè)器相結(jié)合的復(fù)合制導(dǎo)控制方法,文獻(xiàn)[9]運(yùn)用神經(jīng)網(wǎng)絡(luò)對(duì)目標(biāo)加速度進(jìn)行預(yù)測(cè),提出一種最優(yōu)滑模制導(dǎo)律,并設(shè)計(jì)自適應(yīng)開(kāi)關(guān)項(xiàng)來(lái)處理執(zhí)行器飽和誤差及預(yù)測(cè)誤差。文獻(xiàn)[10]基于彈目相對(duì)視線方向與視線法向設(shè)計(jì)終端滑模雙層協(xié)同制導(dǎo)律,并針對(duì)提出的制導(dǎo)律設(shè)計(jì)新的自適應(yīng)律,用以加快滑模面的收斂速度。文獻(xiàn)[11]以具有理想動(dòng)態(tài)時(shí)滯的自動(dòng)駕駛儀為前提,提出了滑模制導(dǎo)律,并將其推廣到自動(dòng)駕駛儀具有動(dòng)態(tài)延遲的情況。文獻(xiàn)[12]考慮攻擊角約束、自動(dòng)駕駛儀動(dòng)態(tài)特性,設(shè)計(jì)一種固定時(shí)間收斂的新型非奇異終端滑模制導(dǎo)律,并設(shè)計(jì)固定時(shí)間收斂的滑模干擾器用于估計(jì)目標(biāo)機(jī)動(dòng)等干擾。文獻(xiàn)[13]提出了一種基于最小控制力和末端位置、速度約束的最優(yōu)策略,并將其與滑模控制相結(jié)合,得到魯棒最優(yōu)制導(dǎo)律,最后將此種方法推廣至攔截任意時(shí)變機(jī)動(dòng)目標(biāo)。文獻(xiàn)[14]提出一種針對(duì)機(jī)動(dòng)目標(biāo),帶有終端虛擬視線角約束、終端視線角約束的最優(yōu)制導(dǎo)律,旨在以一定的末端攻擊角度攔截目標(biāo)。文獻(xiàn)[15]提出了一種具有權(quán)重函數(shù)的最優(yōu)制導(dǎo)律,使得導(dǎo)彈在全程制導(dǎo)過(guò)程中不需對(duì)制導(dǎo)律進(jìn)行重新設(shè)計(jì)。文獻(xiàn)[16]基于模型靜態(tài)規(guī)劃算法提出了一種考慮初制導(dǎo)與中制導(dǎo)的聯(lián)合規(guī)劃制導(dǎo)算法,用于解決多階段、最優(yōu)攔截制導(dǎo)問(wèn)題。除此之外,一些新型制導(dǎo)方法也被廣泛應(yīng)用,文獻(xiàn)[17]提出一種基于新型幾何方法的攔截制導(dǎo)律,文獻(xiàn)[18]基于經(jīng)典微分幾何曲線理論與Lyapunov 理論,提出一種新型的魯棒幾何方法制導(dǎo)律。文獻(xiàn)[19]中針對(duì)高速機(jī)動(dòng)目標(biāo),提出一種基于混合策略博弈理論的新型自適應(yīng)加權(quán)微分博弈制導(dǎo)律,其權(quán)重依據(jù)目標(biāo)加速度的估計(jì)誤差進(jìn)行設(shè)計(jì)。文獻(xiàn)[20]針對(duì)非線性動(dòng)態(tài)控制系統(tǒng)在給定時(shí)刻的閉環(huán)制導(dǎo)問(wèn)題,提出了一種模糊組合制導(dǎo)律,文獻(xiàn)[21]中基于PN 方法提出了一種模糊控制方法,通過(guò)模糊邏輯控制器改變等效導(dǎo)航常數(shù)值,以達(dá)到導(dǎo)彈最好性能。文獻(xiàn)[22]基于監(jiān)督學(xué)習(xí),運(yùn)用具有比例導(dǎo)引律的導(dǎo)彈系統(tǒng)生成大量數(shù)據(jù)訓(xùn)練深度神經(jīng)網(wǎng)絡(luò)得到制導(dǎo)策略。盡管目前諸多算法在攔截非機(jī)動(dòng)目標(biāo)與機(jī)動(dòng)目標(biāo)時(shí)均具有明顯效果,但算法中仍有諸多角度、時(shí)間等約束,并且需明確目標(biāo)運(yùn)動(dòng)信息。

在經(jīng)典制導(dǎo)律與現(xiàn)代制導(dǎo)律存在缺陷的基礎(chǔ)上,隨著人工智能的快速發(fā)展,機(jī)器學(xué)習(xí)被廣泛應(yīng)用于解決決策問(wèn)題。強(qiáng)化學(xué)習(xí)(Reinforce‐ment Learning,RL)作為機(jī)器學(xué)習(xí)中的一個(gè)重要分支,被引入到制導(dǎo)律設(shè)計(jì)中,此算法能夠?qū)⒂^察到的狀態(tài)直接映射到動(dòng)作。在與環(huán)境進(jìn)行交互的過(guò)程中,通過(guò)不斷學(xué)習(xí)、試錯(cuò)的方式采取動(dòng)作信息來(lái)影響系統(tǒng)的狀態(tài),從而最大化所獲得的獎(jiǎng)勵(lì),即隨著時(shí)間的推移能夠不斷進(jìn)行學(xué)習(xí)尋找最優(yōu)策略的過(guò)程[23]。將強(qiáng)化學(xué)習(xí)方法與制導(dǎo)、導(dǎo)航與控制領(lǐng)域相結(jié)合,能夠克服基于模型的傳統(tǒng)方法需要系統(tǒng)模型和完整地環(huán)境信息的局限性問(wèn)題[23-24]。在強(qiáng)化學(xué)習(xí)中通常選用策略函數(shù)、價(jià)值函數(shù)等不同的優(yōu)化目標(biāo)以及不同的函數(shù)逼近器來(lái)近似策略、價(jià)值函數(shù)或者他們的組合[25]。

文獻(xiàn)[26]基于Q 學(xué)習(xí)方法設(shè)計(jì)零控脫靶制導(dǎo)律,并在垂直平面上驗(yàn)證算法的有效性。文獻(xiàn)[27]設(shè)計(jì)了一種基于微分對(duì)策方法的神經(jīng)網(wǎng)絡(luò)制導(dǎo)律,面向二維平面內(nèi)的追逃問(wèn)題進(jìn)行研究。傳統(tǒng)的強(qiáng)化學(xué)習(xí)算法往往采用離散的狀態(tài)與動(dòng)作空間,所以“狀態(tài)-值”函數(shù)可以用狀態(tài)的查找表表示。但在實(shí)際復(fù)雜任務(wù)中往往需要較大的狀態(tài)空間及連續(xù)的動(dòng)作空間[28]。為避免狀態(tài)、動(dòng)作空間過(guò)大而造成的維數(shù)“災(zāi)難”問(wèn)題,通常使用由神經(jīng)網(wǎng)絡(luò)構(gòu)成的函數(shù)逼近器或“動(dòng)作-評(píng)價(jià)”智能體結(jié)構(gòu)搭配實(shí)現(xiàn)具有連續(xù)狀態(tài)、動(dòng)作的強(qiáng)化學(xué)習(xí)算法[24]。文獻(xiàn)[29]中將卷積神經(jīng)網(wǎng)絡(luò)引入到強(qiáng)化學(xué)習(xí)算法中,提出了深度Q 學(xué)習(xí)算法,并提出了深度強(qiáng)化學(xué)習(xí)(Deep Reinforcement Learn‐ing,DRL)相關(guān)概念。深度強(qiáng)化學(xué)習(xí)算法結(jié)合了強(qiáng)化學(xué)習(xí)中的決策能力與深度學(xué)習(xí)(Deep Learn‐ing,DL)的特征提取能力。文獻(xiàn)[30]應(yīng)用動(dòng)作-評(píng)價(jià)(Actor-Critic,AC)深度強(qiáng)化學(xué)習(xí)算法研究其在導(dǎo)彈突防問(wèn)題中的實(shí)用性。文獻(xiàn)[31]考慮數(shù)據(jù)運(yùn)用效率,基于模型預(yù)測(cè)路徑積分控制方法設(shè)計(jì)基于模型的深度強(qiáng)化學(xué)習(xí)制導(dǎo)律,文獻(xiàn)[32]將元學(xué)習(xí)與近端策略優(yōu)化(Proximal Policy Opti‐mization,PPO)算法相結(jié)合對(duì)制導(dǎo)律進(jìn)行設(shè)計(jì),且所設(shè)計(jì)的制導(dǎo)律不需目標(biāo)與攔截器的距離估計(jì)。文獻(xiàn)[33]基于深度確定性策略梯度(Deep Deterministic Policy Gradient,DDPG)算法設(shè)計(jì)多智能體深度確定性策略梯度(Multi-Agent Deep Deterministic Policy Gradient,MADDPG)算法解決不同情況下多智能體的防御和攻擊問(wèn)題,文獻(xiàn)[34]運(yùn)用DDPG 算法學(xué)習(xí)行動(dòng)策略,將所觀察到的狀態(tài)映射到制導(dǎo)指令中。文獻(xiàn)[35]中針對(duì)彈道導(dǎo)彈終端攔截問(wèn)題,設(shè)計(jì)基于雙延遲深度確定性策略梯度(Twin Delayed Deep De‐terministic Policy Gradient,TD3)算法的制導(dǎo)策略。在上述研究中,強(qiáng)化學(xué)習(xí)算法的學(xué)習(xí)、訓(xùn)練效率仍然是目前研究的難點(diǎn)問(wèn)題,本文結(jié)合神經(jīng)網(wǎng)絡(luò)函數(shù)逼近器與“動(dòng)作-評(píng)價(jià)”智能體結(jié)構(gòu)的優(yōu)勢(shì),運(yùn)用深度強(qiáng)化學(xué)習(xí)中的信賴域策略優(yōu)化(Trust Region Policy Optimization,TRPO)算法對(duì)攔截制導(dǎo)問(wèn)題進(jìn)行研究,對(duì)訓(xùn)練數(shù)據(jù)進(jìn)行充分運(yùn)用,提高訓(xùn)練效率。

本文研究深度強(qiáng)化學(xué)習(xí)算法在導(dǎo)彈攔截制導(dǎo)問(wèn)題中的應(yīng)用,首先建立攔截彈與目標(biāo)間的相對(duì)運(yùn)動(dòng)模型,將其作為深度強(qiáng)化學(xué)習(xí)智能體的訓(xùn)練環(huán)境。其次設(shè)計(jì)基于TRPO 算法的制導(dǎo)算法,其輸入為狀態(tài),并將狀態(tài)直接映射為動(dòng)作即加速度制導(dǎo)指令,通過(guò)對(duì)交戰(zhàn)訓(xùn)練場(chǎng)景、狀態(tài)空間、動(dòng)作空間和獎(jiǎng)勵(lì)函數(shù)進(jìn)行設(shè)計(jì),以完成對(duì)制導(dǎo)算法的訓(xùn)練。其中獎(jiǎng)勵(lì)函數(shù)的設(shè)計(jì)對(duì)強(qiáng)化學(xué)習(xí)算法的訓(xùn)練尤為關(guān)鍵,好的獎(jiǎng)勵(lì)函數(shù)能夠加速訓(xùn)練過(guò)程的收斂,壞的獎(jiǎng)勵(lì)函數(shù)會(huì)導(dǎo)致收斂時(shí)間加長(zhǎng)甚至無(wú)法收斂。因此,獎(jiǎng)勵(lì)函數(shù)設(shè)計(jì)結(jié)合狀態(tài)空間中相對(duì)距離、相對(duì)視線角、相對(duì)視線角速度以及能量消耗等因素,能夠充分反映攔截彈與目標(biāo)的系統(tǒng)狀態(tài)。最終設(shè)置不同初始條件完成對(duì)環(huán)境的訓(xùn)練,主要包含2 種:①特定初始條件下對(duì)智能體進(jìn)行訓(xùn)練;②隨機(jī)初始條件下對(duì)智能體進(jìn)行訓(xùn)練。

訓(xùn)練完成后,通過(guò)仿真驗(yàn)證所設(shè)計(jì)制導(dǎo)算法的有效性,主要對(duì)不同初始狀態(tài)的學(xué)習(xí)場(chǎng)景和未學(xué)習(xí)場(chǎng)景進(jìn)行測(cè)試,測(cè)試結(jié)果顯示所設(shè)計(jì)的制導(dǎo)算法具有一定魯棒性、泛化能力。

1 深度強(qiáng)化學(xué)習(xí)及TRPO 算法

深度強(qiáng)化學(xué)習(xí)(Deep Reinforcement Learn‐ing,DRL)將強(qiáng)化學(xué)習(xí)與深度學(xué)習(xí)進(jìn)行結(jié)合,運(yùn)用深度神經(jīng)網(wǎng)絡(luò)作為函數(shù)逼近器。TRPO 算法位于同策略(On-policy)與異策略(Off-policy)強(qiáng)化學(xué)習(xí)方法的交界處。雖在算法設(shè)計(jì)過(guò)程中使用新、舊2 種策略網(wǎng)絡(luò),并運(yùn)用舊策略(Oldpolicy)進(jìn)行重要性采樣,但真正的異策略算法可以用任意策略網(wǎng)絡(luò)生成的數(shù)據(jù)更新目標(biāo)策略網(wǎng)絡(luò),而TRPO 算法新、舊策略比例受到一定約束,并且舊策略權(quán)重由新策略軟更新得來(lái),此方法保證新策略應(yīng)用舊策略采樣所得到的數(shù)據(jù)更新參數(shù)時(shí)更加有效。

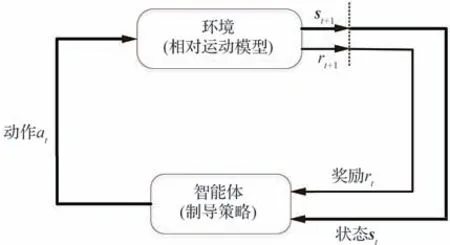

在強(qiáng)化學(xué)習(xí)中,智能體與環(huán)境進(jìn)行不斷的交互,在交互過(guò)程中試圖通過(guò)不斷試錯(cuò)的方式調(diào)整、優(yōu)化策略來(lái)解決系統(tǒng)所存在的問(wèn)題。在學(xué)習(xí)過(guò)程中,智能體(Agent)產(chǎn)生動(dòng)作at∈A,傳送到環(huán)境(Environment)對(duì)狀態(tài)st+1∈S及獎(jiǎng)勵(lì)rt+1(st,at)∈R進(jìn)行更新,并收集返回到智能體進(jìn)行經(jīng)驗(yàn)收集、分析后優(yōu)化策略π(a|s),通過(guò)最大化收集到的獎(jiǎng)勵(lì)rt+1(st,at)∈R找到一個(gè)最優(yōu)策略π?(a|s)[36]。其中涉及到馬爾可夫決策過(guò)程、策略梯度、優(yōu)勢(shì)函數(shù)等方法。

1.1 馬爾可夫決策過(guò)程

馬爾可夫決策過(guò)程(Markov Decision Pro‐cess,MDP)本質(zhì)為一個(gè)隨機(jī)過(guò)程,表示序列決策建模的理論框架,通過(guò)此框架強(qiáng)化學(xué)習(xí)中環(huán)境與智能體的交互過(guò)程以概率論的形式表現(xiàn)出來(lái)。馬爾可夫決策過(guò)程被定義為M=

在MDP 中,智能體在時(shí)間序列t時(shí)觀察到環(huán)境狀態(tài)st∈S,并依據(jù)狀態(tài)st采取一個(gè)動(dòng)作at∈A積分得到t+1 時(shí)刻狀態(tài)st+1∈S。同時(shí),為評(píng)估狀態(tài)轉(zhuǎn)換的好壞程度,智能體得到即時(shí)獎(jiǎng)勵(lì)rt+1(st,at)∈R,γ表示未來(lái)獎(jiǎng)勵(lì)的折扣因子,P表示狀態(tài)轉(zhuǎn)移概率。交互過(guò)程如圖1 所示。

圖1 “智能體-環(huán)境”交互Fig.1 “Agent-environment” interaction

圖1 中“環(huán)境”代指所建立的攔截彈-目標(biāo)相對(duì)運(yùn)動(dòng)模型,“智能體”代指基于信賴域策略優(yōu)化算法的制導(dǎo)策略。

MDP 與智能體共同給出了一組序列:

式(1)所示的序列中主要包括2 種狀態(tài)轉(zhuǎn)換:一是狀態(tài)到動(dòng)作的轉(zhuǎn)換由智能體的策略π(a|s)決定;另一種是由環(huán)境決定的動(dòng)作到狀態(tài)的轉(zhuǎn)換。

智能體在狀態(tài)st時(shí)的動(dòng)作選擇被建模為策略π(at|st)的映射,將環(huán)境的狀態(tài)值st映射到一個(gè)動(dòng)作集合的概率分布或者概率密度函數(shù):

在強(qiáng)化學(xué)習(xí)中,累積獎(jiǎng)勵(lì)被定義為與時(shí)間序列相關(guān)的表達(dá)式:

“狀態(tài)-值”函數(shù)定義為當(dāng)我們采取了某一策略π(a|s)后,累計(jì)回報(bào)在狀態(tài)st時(shí)的期望值:

在馬爾可夫決策過(guò)程中,擁有各種各樣的策略π(a|s),策略優(yōu)化過(guò)程為得到一個(gè)最優(yōu)策略π?(a|s),需獲得最大化的折扣獎(jiǎng)勵(lì):

式中:γ∈(0,1]為獎(jiǎng)勵(lì)函數(shù)折扣因子,對(duì)未來(lái)獎(jiǎng)勵(lì)進(jìn)行考慮加權(quán),當(dāng)γ→0 時(shí),更加注重目前的獎(jiǎng)勵(lì);當(dāng)γ→1 時(shí),會(huì)更優(yōu)先考慮未來(lái)的獎(jiǎng)勵(lì)。

1.2 策略梯度

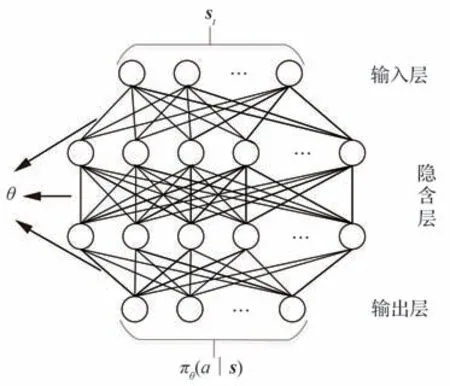

策略梯度算法的基本思想是通過(guò)學(xué)習(xí)策略π(a|s)對(duì)性能函數(shù)J(π)=Vπ(s)進(jìn)行最大化。針對(duì)復(fù)雜的目標(biāo)與攔截彈的交戰(zhàn)環(huán)境,其連續(xù)動(dòng)作空間及狀態(tài)空間較為龐大,為更好地近似策略函數(shù)π(a|s),其策略網(wǎng)絡(luò)由帶有權(quán)重θ的深度神經(jīng)網(wǎng)絡(luò)構(gòu)成,其策略函數(shù)參數(shù)化可以近似表示為πθ(a|s)。神經(jīng)網(wǎng)絡(luò)與強(qiáng)化學(xué)習(xí)結(jié)合為深度強(qiáng)化學(xué)習(xí)算法。神經(jīng)網(wǎng)絡(luò)是依據(jù)一系列層組成的輸入輸出系統(tǒng),每一層均包含有限個(gè)神經(jīng)元。策略網(wǎng)絡(luò)內(nèi)部結(jié)構(gòu)如圖2 所示,評(píng)價(jià)網(wǎng)絡(luò)內(nèi)部結(jié)構(gòu)與策略網(wǎng)絡(luò)內(nèi)部結(jié)構(gòu)相似。

圖2 策略(動(dòng)作)神經(jīng)網(wǎng)絡(luò)內(nèi)部結(jié)構(gòu)Fig.2 Policy(action)neural network interior structure

在神經(jīng)網(wǎng)絡(luò)中對(duì)權(quán)重參數(shù)進(jìn)行更新以最大化性能目標(biāo)函數(shù)J(πθ):

策略梯度算法主要依據(jù)隨機(jī)梯度上升法對(duì)權(quán)重參數(shù)θ進(jìn)行更新:

式中:α表示策略網(wǎng)絡(luò)的學(xué)習(xí)率,決定了梯度更新的步長(zhǎng)。

由策略梯度定理得知,估計(jì)策略函數(shù)的梯度表示為

式中:b(st)表示基準(zhǔn)函數(shù)。

將式(8)改寫(xiě)為策略梯度的損失函數(shù)[37]:

利用式(9)損失函數(shù)進(jìn)行參數(shù)優(yōu)化將會(huì)導(dǎo)致參數(shù)空間中出現(xiàn)多種相似的軌跡,且所提出的?θ J(θ)前面的每一次更新都會(huì)對(duì)后續(xù)更新產(chǎn)生影響,并最終影響訓(xùn)練效果。為解決上述缺陷,采用信賴域策略優(yōu)化(TRPO)算法設(shè)計(jì)制導(dǎo)策略。

1.3 優(yōu)勢(shì)函數(shù)

本節(jié)中,基于“狀態(tài)-值”函數(shù)式(4)引入“狀態(tài)-動(dòng)作-值”函數(shù),并通過(guò)兩者定義優(yōu)勢(shì)函數(shù)。

“狀態(tài)-動(dòng)作-值”函數(shù)表示當(dāng)狀態(tài)st與動(dòng)作at均確定時(shí)長(zhǎng)期期望獎(jiǎng)勵(lì):

“狀態(tài)-值”函數(shù)與“狀態(tài)-動(dòng)作-值”函數(shù)均表示為長(zhǎng)期期望獎(jiǎng)勵(lì),當(dāng)對(duì)所有動(dòng)作的“狀態(tài)-動(dòng)作-值”函數(shù)求期望便可以得到“狀態(tài)-值”函數(shù)表達(dá)式,具體表示為[23]

基于“狀態(tài)-值”函數(shù)式(4)與“狀態(tài)-動(dòng)作-值”函數(shù)式(10),可得到優(yōu)勢(shì)函數(shù)表達(dá)式:

1.4 信賴域策略優(yōu)化算法

在信賴域策略優(yōu)化(TRPO)算法中,通過(guò)設(shè)置Kullback-Leibler(KL)散度值來(lái)約束新、舊策略比例,使梯度步驟更新后的新策略與舊策略間差別減小,但同時(shí)TRPO 方法又采取了較大的更新步長(zhǎng)來(lái)更新策略參數(shù),目的為提高算法的性能。其中散度為新舊策略概率分布間的量度。

在信賴域策略優(yōu)化函數(shù)中,為最大化目標(biāo)狀態(tài)的期望回報(bào),引入一個(gè)新的函數(shù)定義η(π),將期望折扣獎(jiǎng)勵(lì)式(4)進(jìn)一步表示為

基于式(12)與式(13),策略πθ的預(yù)期回報(bào)為

針對(duì)式(16)等號(hào)右端第2 項(xiàng),所有動(dòng)作的選擇均是由舊策略進(jìn)行采樣,因此當(dāng)狀態(tài)st時(shí),運(yùn)用文獻(xiàn)[39]所介紹的重要性采樣及式(15)對(duì)其進(jìn)行改進(jìn):

為保證式(20)更好地逼近、替代預(yù)期回報(bào)式(14),應(yīng)限制策略更新幅度,因此為避免局限性,信賴域策略優(yōu)化算法引入KL 散度衡量新策略與舊策略概率分布間差異,其被定義為所有狀態(tài)中最大動(dòng)作分布的總變差散度DTV,表示為

若直接對(duì)上述目標(biāo)函數(shù)進(jìn)行優(yōu)化,由式(23)可得,懲罰系數(shù)ε較大,導(dǎo)致KL 散度較小,最終導(dǎo)致在策略優(yōu)化過(guò)程中,對(duì)策略更新幅度較小,即式(23)中懲罰系數(shù)ε在一定程度上限制步長(zhǎng),為增大步長(zhǎng)將懲罰系數(shù)變?yōu)榧s束項(xiàng):

式中:δ定義為約束因子。

在策略優(yōu)化的過(guò)程中,需對(duì)式(24)所示的目標(biāo)函數(shù)最大化以得到下一步參數(shù)θ。為進(jìn)一步優(yōu)化目標(biāo)函數(shù),將約束項(xiàng)KL 散度用其期望代替,且權(quán)重為舊策略穩(wěn)定狀態(tài)分布表示為

最終目標(biāo)函數(shù)為

目標(biāo)函數(shù)優(yōu)化過(guò)程中,依據(jù)式(13)和式(20)可得知舊策略下的期望折扣獎(jiǎng)勵(lì)與新策略參數(shù)πθ是相互獨(dú)立的,因此依據(jù)式(23)針對(duì)目標(biāo)函數(shù)的優(yōu)化可進(jìn)一步簡(jiǎn)化為

本文中信賴域策略優(yōu)化算法是依據(jù)“動(dòng)作-評(píng)價(jià)”網(wǎng)絡(luò)架構(gòu)進(jìn)行設(shè)計(jì)的,在訓(xùn)練過(guò)程中評(píng)價(jià)網(wǎng)絡(luò)針對(duì)策略網(wǎng)絡(luò)產(chǎn)生的策略進(jìn)行評(píng)估,并運(yùn)用TD-error 設(shè)計(jì)評(píng)價(jià)網(wǎng)絡(luò)目標(biāo)函數(shù):

因此依據(jù)策略網(wǎng)絡(luò)目標(biāo)函數(shù)式(27)與評(píng)價(jià)網(wǎng)絡(luò)目標(biāo)函數(shù)式(28)運(yùn)用優(yōu)化器與梯度上升方法對(duì)網(wǎng)絡(luò)參數(shù)進(jìn)行更新:

式中:k和k+1 分別表示當(dāng)前訓(xùn)練集與下一訓(xùn)練集;α和β分別為策略網(wǎng)絡(luò)與評(píng)價(jià)網(wǎng)絡(luò)的學(xué)習(xí)率;并設(shè)計(jì)Ke限制每次更新頻率,提高訓(xùn)練效率。舊策略網(wǎng)絡(luò)的參數(shù)則由新策略網(wǎng)絡(luò)參數(shù)軟更新得到。

2 基于深度強(qiáng)化學(xué)習(xí)的制導(dǎo)問(wèn)題描述

本文主要考慮攔截彈與目標(biāo)相對(duì)運(yùn)動(dòng)模型,暫時(shí)不考慮攔截彈、目標(biāo)繞質(zhì)心轉(zhuǎn)動(dòng)的姿態(tài)運(yùn)動(dòng),并將其應(yīng)用于深度強(qiáng)化學(xué)習(xí)制導(dǎo)策略設(shè)計(jì)中。首先提出以下3 個(gè)假設(shè)[35,41]:

假設(shè)1將地球視為均值的球體,對(duì)末制導(dǎo)進(jìn)行設(shè)計(jì),因時(shí)間較短,忽略掉地球自身的旋轉(zhuǎn)角速度。

假設(shè)2將攔截彈視為理想剛體狀態(tài),不考慮攔截彈所存在的可能性彈性形變,并將攔截彈與目標(biāo)視為常值速度的質(zhì)點(diǎn)運(yùn)動(dòng)。

假設(shè)3將攔截彈系統(tǒng)狀態(tài)視為理想制導(dǎo)狀態(tài),暫不考慮執(zhí)行結(jié)構(gòu)的動(dòng)態(tài)特性。

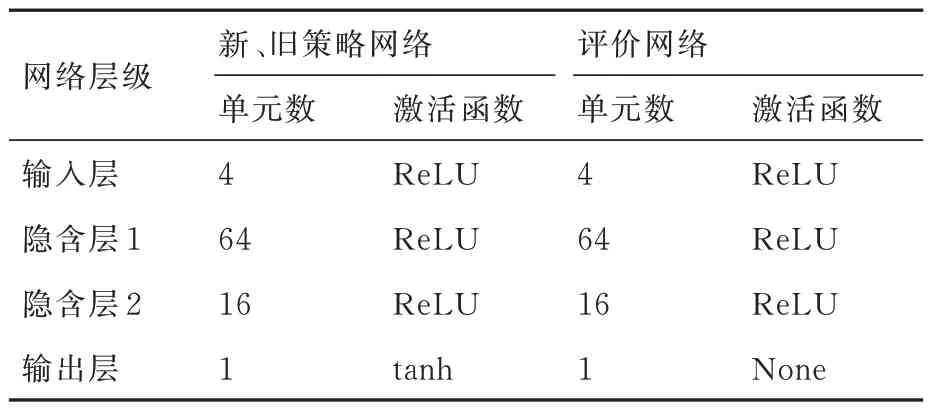

2.1 交戰(zhàn)環(huán)境

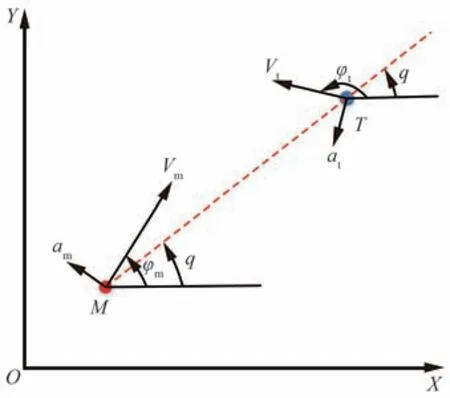

使用一個(gè)簡(jiǎn)潔的攔截彈與目標(biāo)相對(duì)運(yùn)動(dòng)場(chǎng)景,并且主要針對(duì)攔截彈與目標(biāo)二維垂直平面內(nèi)的制導(dǎo)問(wèn)題進(jìn)行研究,但研究結(jié)論可以推廣到三維空間。兩者縱向平面內(nèi)相對(duì)運(yùn)動(dòng)場(chǎng)景如圖3所示。

圖3 攔截彈-目標(biāo)相對(duì)運(yùn)動(dòng)環(huán)境Fig.3 Interceptor-target relative motion environment

圖中:M和T分別表示攔截彈與目標(biāo)質(zhì)點(diǎn)。在雙方交戰(zhàn)過(guò)程中,當(dāng)目標(biāo)飛行器T進(jìn)入到探測(cè)范圍后,發(fā)射攔截彈M運(yùn)用所設(shè)計(jì)的制導(dǎo)策略攔截目標(biāo)T,同時(shí)目標(biāo)T采取相應(yīng)的策略進(jìn)行規(guī)避,直至攔截成功或失敗。坐標(biāo)系OXY為慣性坐標(biāo)系;q表示彈目相對(duì)視線角;瞬時(shí)相對(duì)距離表示為R;Vm和Vt分別為攔截彈與目標(biāo)的運(yùn)動(dòng)速度;φm和φt為攔截彈與目標(biāo)之間的彈道傾角;am和at分別表示攔截彈與目標(biāo)垂直于速度方向的法向加速度。

根據(jù)圖3 交戰(zhàn)場(chǎng)景,我們給出攔截彈與目標(biāo)在二維平面內(nèi)運(yùn)動(dòng)學(xué)模型:

描述攔截彈與目標(biāo)相對(duì)運(yùn)動(dòng)的方程為

攔截彈與目標(biāo)垂直于速度方向的加速度與速度間的關(guān)系可表示為

直接應(yīng)用攔截彈與目標(biāo)相對(duì)運(yùn)動(dòng)方程作為深度強(qiáng)化學(xué)習(xí)環(huán)境,以便于更加直觀的計(jì)算、觀測(cè)系統(tǒng)各狀態(tài)變量。

2.2 制導(dǎo)算法設(shè)計(jì)

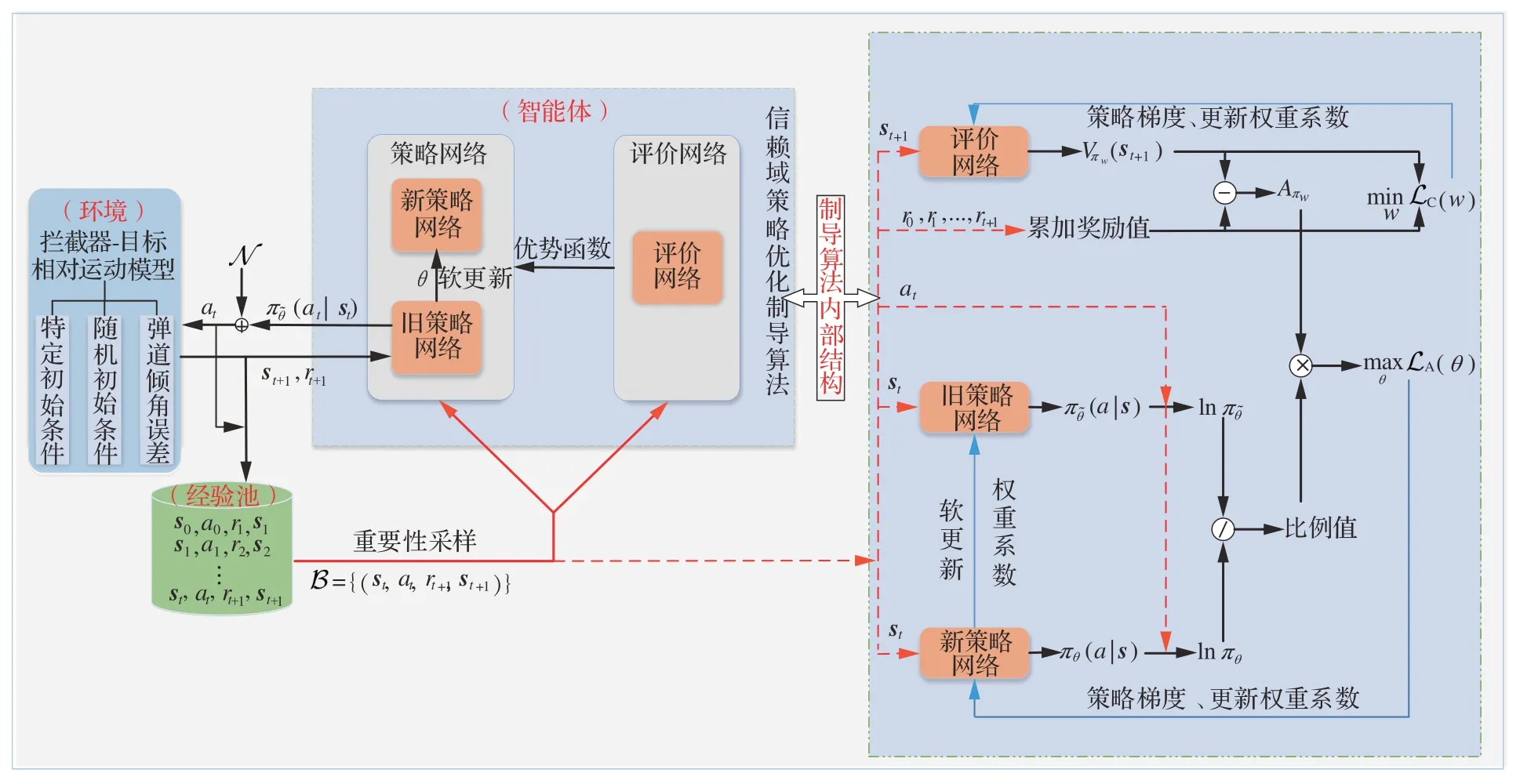

在本節(jié)中,提出一種基于信賴域策略優(yōu)化(TRPO)算法的制導(dǎo)算法設(shè)計(jì)方法,在智能體訓(xùn)練過(guò)程中將狀態(tài)直接映射到攔截彈的制導(dǎo)指令,并通過(guò)不斷地學(xué)習(xí)得到最優(yōu)策略。本文所設(shè)計(jì)制導(dǎo)算法具體結(jié)構(gòu)如圖4 所示,詳細(xì)描述制導(dǎo)算法的內(nèi)部結(jié)構(gòu)。為順利訓(xùn)練TRPO 制導(dǎo)算法,對(duì)制導(dǎo)算法中作戰(zhàn)訓(xùn)練場(chǎng)景、狀態(tài)空間、動(dòng)作空間、獎(jiǎng)勵(lì)函數(shù)及網(wǎng)絡(luò)結(jié)構(gòu)五方面進(jìn)行詳細(xì)設(shè)計(jì)。

圖4 信賴域策略優(yōu)化制導(dǎo)算法全結(jié)構(gòu)Fig.4 Trust region policy optimization guidance algorithm full structure

2.2.1 訓(xùn)練場(chǎng)景

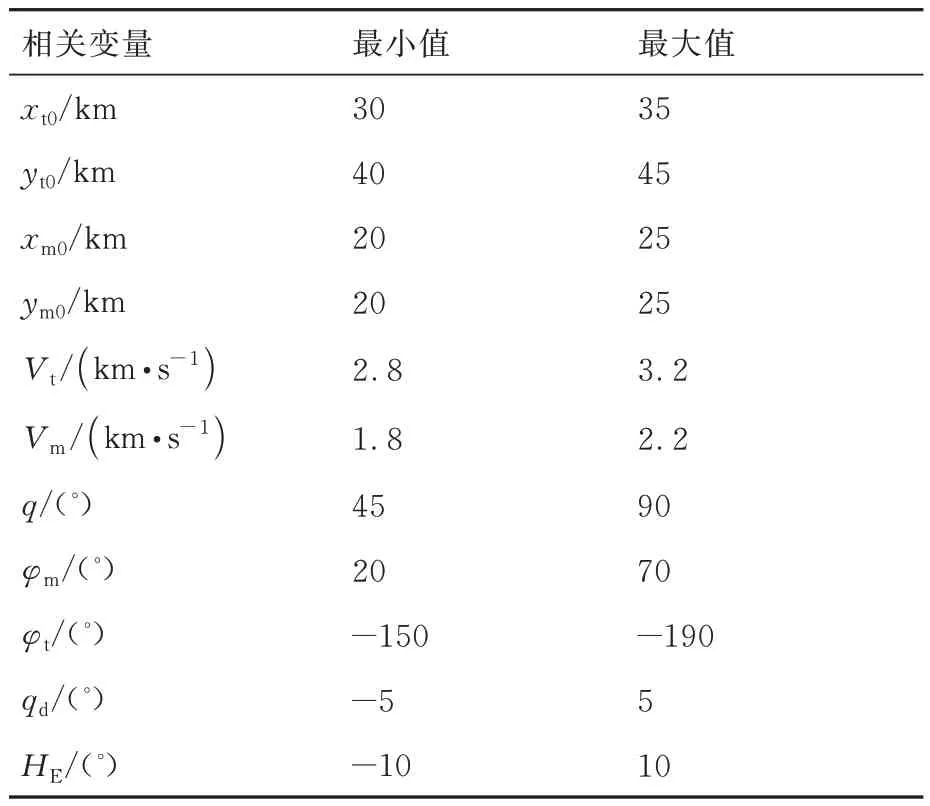

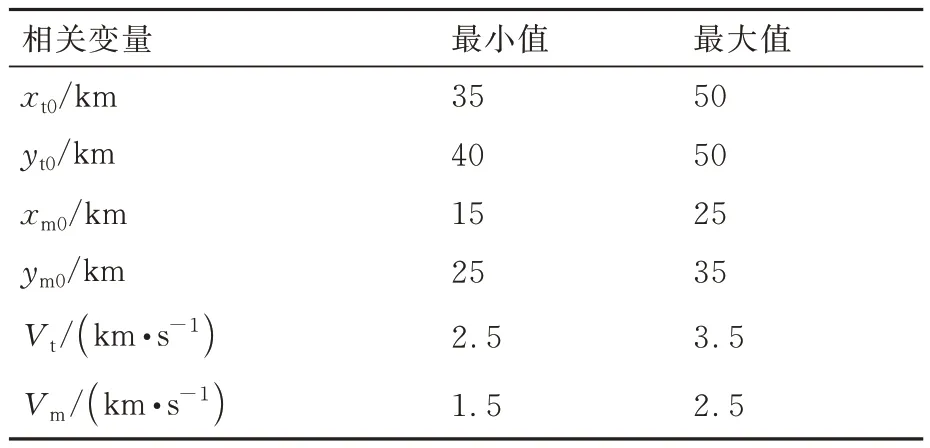

本文所研究的深度強(qiáng)化學(xué)習(xí)制導(dǎo)算法訓(xùn)練場(chǎng)景是基于所建立的攔截彈與目標(biāo)在二維垂直平面內(nèi)的相對(duì)運(yùn)動(dòng)模型構(gòu)建的,其在訓(xùn)練過(guò)程中與智能體直接進(jìn)行交互,為更好地對(duì)模型進(jìn)行訓(xùn)練,獲得最優(yōu)策略。為降低訓(xùn)練算法的隨機(jī)性,設(shè)定隨機(jī)初始條件范圍,其初始條件設(shè)置包括攔截彈與目標(biāo)的初始位置、速度等,相應(yīng)初始相對(duì)視線角及初始彈道傾角由初始條件推導(dǎo)可得,訓(xùn)練交戰(zhàn)環(huán)境如圖5 所示。圖5 中φmmax、φmmin、φtmax和φtmin分別表示攔截彈與目標(biāo)彈道傾角最大值與最小值;qmax和qmin分別表示相對(duì)視線角的最大值與最小值;ximax、ximin、yimax和yimin(i=m,t)分別表示攔截彈和目標(biāo)的初始位置邊界。設(shè)置環(huán)境各參數(shù)在訓(xùn)練過(guò)程中的約束條件如表1所示。

表1 訓(xùn)練場(chǎng)景參數(shù)邊界Table 1 Training scenario parameters constraints

圖5 訓(xùn)練交戰(zhàn)場(chǎng)景Fig.5 Training engagement scenario

在攔截彈與目標(biāo)位置、速度通過(guò)隨機(jī)初始化確定后,兩者初始相對(duì)距離與初始相對(duì)視線角可表示為

式中:(xm0,ym0)與(xt0,yt0)分別表示為攔截彈與目標(biāo)的初始位置;qd表示初始視線角誤差,初始化時(shí)對(duì)其在設(shè)定范圍內(nèi)進(jìn)行隨機(jī)初始化。

在相對(duì)視線角基礎(chǔ)上,目標(biāo)初始彈道傾角可表示為

式中:HE表示攔截彈與目標(biāo)的初始彈道傾角誤差,當(dāng)HE=0 時(shí)表示目標(biāo)速度指向攔截彈方向,但訓(xùn)練過(guò)程中每一訓(xùn)練集開(kāi)始時(shí)均在表1 所設(shè)定的范圍內(nèi)對(duì)HE進(jìn)行隨機(jī)初始化,即HE并不為0,目標(biāo)速度并不直接指向攔截彈,更加符合實(shí)際任務(wù)需求。

攔截彈初始彈道傾角表示為

式中:q0表示為攔截彈與目標(biāo)間的初始相對(duì)視線角,由式(34)確定;等號(hào)右端第2 項(xiàng)考慮目標(biāo)速度垂直于初始視線角的分量對(duì)攔截彈初始彈道傾角的影響;等號(hào)右端第3 項(xiàng)與目標(biāo)初始彈道傾角計(jì)算同理,當(dāng)HE=0 時(shí)攔截彈速度指向目標(biāo),但同樣在每一訓(xùn)練集中進(jìn)行隨機(jī)初始化,使HE≠0。

當(dāng)式(35)與式(36)中初始彈道傾角誤差HE均為0 時(shí),目標(biāo)與攔截彈滿足不機(jī)動(dòng)情況下的碰撞三角形如圖5 所示。但實(shí)際訓(xùn)練過(guò)程中,在每一訓(xùn)練集開(kāi)始對(duì)兩式中的初始彈道傾角誤差HE分別進(jìn)行隨機(jī)初始化,且兩者取值并不一致,使目標(biāo)與攔截彈速度均不指向?qū)Ψ剑淤N合實(shí)際需求。

訓(xùn)練過(guò)程中,目標(biāo)飛行器采用方波機(jī)動(dòng):

式中:nt表示目標(biāo)最大機(jī)動(dòng)過(guò)載;g表示重力加速度;ωf表示方波機(jī)動(dòng)頻率;Δt表示為機(jī)動(dòng)持續(xù)時(shí)間;Rtm表示目標(biāo)開(kāi)始機(jī)動(dòng)時(shí)攔截彈與目標(biāo)的臨界距離;ΔT為機(jī)動(dòng)所持續(xù)的最大時(shí)間。

2.2.2 狀態(tài)空間

為了更好地訓(xùn)練所設(shè)計(jì)的TRPO 制導(dǎo)算法,在構(gòu)造狀態(tài)空間時(shí),既要考慮到攔截彈與目標(biāo)交戰(zhàn)系統(tǒng)變量的多樣性,又要考慮智能體能夠更好提取狀態(tài)變量的關(guān)鍵信息,運(yùn)用神經(jīng)網(wǎng)絡(luò)進(jìn)行非線性擬合。因此狀態(tài)變量的選擇應(yīng)盡可能反應(yīng)系統(tǒng)重要信息,并盡可能簡(jiǎn)潔,以減小智能體所需要搜索的狀態(tài)空間,加快智能體的訓(xùn)練速度。基于式(32)所示的攔截彈與目標(biāo)二維交戰(zhàn)運(yùn)動(dòng)方程,將環(huán)境狀態(tài)空間設(shè)為

選定攔截彈與目標(biāo)相對(duì)距離、相對(duì)視線角、相對(duì)距離變化率和相對(duì)視線角速度4 個(gè)元素作為環(huán)境狀態(tài)量,其能夠充分反應(yīng)攔截彈與目標(biāo)相對(duì)位置信息,且相對(duì)視線角應(yīng)盡可能變化小,以盡可能的滿足平行接近。

2.2.3 動(dòng)作空間

深度強(qiáng)化學(xué)習(xí)中,根據(jù)特定任務(wù)需要,動(dòng)作空間需設(shè)計(jì)為離散動(dòng)作空間或連續(xù)動(dòng)作空間。設(shè)計(jì)的TRPO 制導(dǎo)算法作為生成制導(dǎo)指令的策略,依據(jù)攔截任務(wù)需要采用連續(xù)動(dòng)作空間進(jìn)行描述。制導(dǎo)指令由相關(guān)狀態(tài)變量進(jìn)行直接映射:

式中:ft(?)表示非線性函數(shù),由神經(jīng)網(wǎng)絡(luò)擬合而成。

制導(dǎo)指令設(shè)置在最大過(guò)載范圍內(nèi):

式中:nm表示為攔截彈最大的法向過(guò)載。

2.2.4 獎(jiǎng)勵(lì)函數(shù)

獎(jiǎng)勵(lì)函數(shù)作為T(mén)RPO 制導(dǎo)算法中最重要的一部分,合適的獎(jiǎng)勵(lì)函數(shù)能夠更好地輔助訓(xùn)練智能體。在攔截彈與目標(biāo)相對(duì)運(yùn)動(dòng)過(guò)程中,系統(tǒng)需要針對(duì)每一步返回一個(gè)即時(shí)獎(jiǎng)勵(lì)到智能體,更直觀地反映系統(tǒng)狀態(tài)好壞。設(shè)計(jì)的制導(dǎo)算法需要使攔截彈能夠不斷地接近目標(biāo)最終成功攔截。獎(jiǎng)勵(lì)函數(shù)的具體形式為

式中:rp表示為攔截彈與目標(biāo)相互接近過(guò)程中獎(jiǎng)勵(lì)函數(shù),即為過(guò)程獎(jiǎng)勵(lì)函數(shù);re表示攔截彈是否成功攔截目標(biāo)的終端獎(jiǎng)勵(lì),若成功攔截則給出一個(gè)正獎(jiǎng)勵(lì)。

rp和re的具體形式可表示為

式中:過(guò)程獎(jiǎng)勵(lì)函數(shù)等號(hào)右端第1 項(xiàng)為攔截彈與目標(biāo)相對(duì)距離的直觀獎(jiǎng)勵(lì),當(dāng)攔截彈不斷接近目標(biāo)時(shí)則給出正獎(jiǎng)勵(lì),距離越近獎(jiǎng)勵(lì)值越高,kr表示相對(duì)距離權(quán)重系數(shù);等號(hào)右端第2 項(xiàng)對(duì)攔截彈能量消耗進(jìn)行考慮,使攔截彈在攔截目標(biāo)的同時(shí)盡量保證較少的能量消耗,ka表示能耗權(quán)重系數(shù);等號(hào)右端第3 項(xiàng)與第4 項(xiàng)均與相對(duì)視線角有關(guān),使攔截彈在不斷接近目標(biāo)的同時(shí)保證相對(duì)視線角的變化量與變化率盡可能小,以保證攔截彈盡可能以平行接近的方式攔截目標(biāo),ks1和ks2表示相對(duì)視線角及視線角變化率權(quán)重系數(shù);re表示終端攔截成功時(shí)直接加入一個(gè)正值獎(jiǎng)勵(lì)a1,用于區(qū)別普通過(guò)程獎(jiǎng)勵(lì),使本文所設(shè)計(jì)的制導(dǎo)算法在訓(xùn)練過(guò)程中朝此方向優(yōu)化;Rm表示攔截成功時(shí)最小脫靶量。

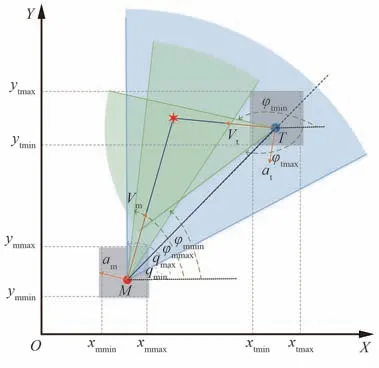

2.2.5 網(wǎng)絡(luò)結(jié)構(gòu)

信賴域策略優(yōu)化(TRPO)算法屬于強(qiáng)化學(xué)習(xí)中“動(dòng)作-評(píng)價(jià)”算法,其中包括策略(動(dòng)作)與評(píng)價(jià)2 種網(wǎng)絡(luò)結(jié)構(gòu)。2 種網(wǎng)絡(luò)均由4 層全連接神經(jīng)網(wǎng)絡(luò)構(gòu)成,其中包含一個(gè)輸入層,2 個(gè)隱含層與一個(gè)輸出層,其網(wǎng)絡(luò)結(jié)構(gòu)均如圖2 所示。4 層全連接神經(jīng)網(wǎng)絡(luò)中每層具體單元數(shù)、激活函數(shù)如表2 所示。

表2 策略與評(píng)價(jià)網(wǎng)絡(luò)結(jié)構(gòu)Table 2 Policy and critic network structure

策略網(wǎng)絡(luò)與評(píng)價(jià)網(wǎng)絡(luò)中輸入層、隱含層的激活函數(shù)均為ReLU 函數(shù),此種激活函數(shù)比其他非線性激活函數(shù)具有更快的處理速度,并在一定程度上緩解梯度消失的問(wèn)題,其具體表達(dá)形式為

動(dòng)作網(wǎng)絡(luò)為將動(dòng)作范圍限制在[?1,1]內(nèi),其輸出層激活函數(shù)為tanh 函數(shù),既能夠防止制導(dǎo)機(jī)構(gòu)飽和,又便于對(duì)制導(dǎo)指令按照最大過(guò)載nm進(jìn)行精確縮放,其具體表達(dá)式為

式中:z表示激活函數(shù)的輸入變量。

2.2.6 訓(xùn)練流程

針對(duì)2.2.1~2.2.5 節(jié)所建立的攔截彈與目標(biāo)相對(duì)運(yùn)動(dòng)交戰(zhàn)環(huán)境與基于信賴域策略優(yōu)化算法的制導(dǎo)算法進(jìn)行交互訓(xùn)練。在介紹具體流程前首先進(jìn)行變量初始化:一是相關(guān)超參數(shù)初始化包括折扣系數(shù)γ,約束因子δ,更新頻率Ke,經(jīng)驗(yàn)池大小|D|,最小批量大小|B|,訓(xùn)練集數(shù)nepisodes,每集訓(xùn)練最大步長(zhǎng)nsteps,策略網(wǎng)絡(luò)學(xué)習(xí)率α及評(píng)價(jià)網(wǎng)絡(luò)學(xué)習(xí)率β;二是交戰(zhàn)環(huán)境參數(shù)邊界初始化包括攔截彈與目標(biāo)初始位置(xm0,ym0)、(xt0,yt0),初始速度Vt、Vm,初始彈道傾角誤差HE,初始視線角誤差qd,初始彈道傾角φt0、φm0,初始視線角q0等。后續(xù)具體訓(xùn)練流程如算法1 所示。

3 仿真校驗(yàn)

3.1 訓(xùn)練超參數(shù)

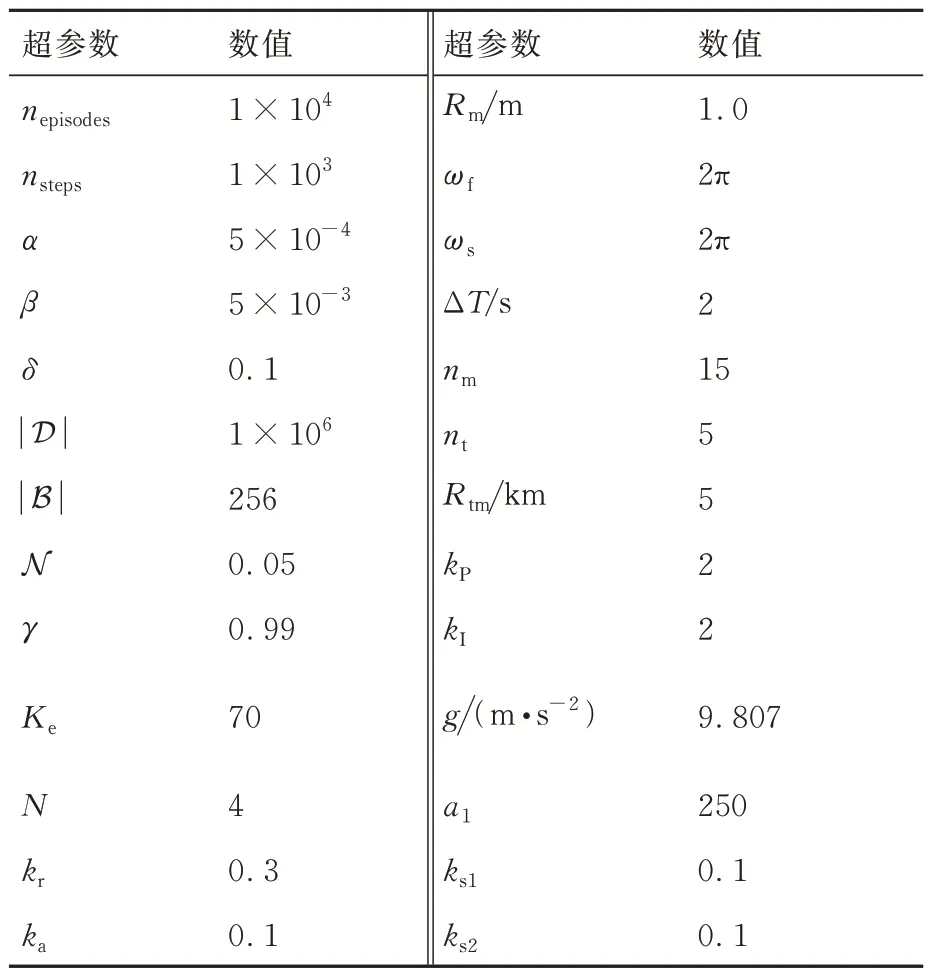

深度強(qiáng)化學(xué)習(xí)中各超參數(shù)的取值對(duì)訓(xùn)練效果有明顯的影響,實(shí)際訓(xùn)練過(guò)程中針對(duì)不同環(huán)境、不同任務(wù)需求,其調(diào)參過(guò)程、最終參數(shù)取值并不唯一。針對(duì)2.2 節(jié)給出的攔截彈與目標(biāo)的正面接觸場(chǎng)景及所設(shè)計(jì)的狀態(tài)空間、動(dòng)作空間、網(wǎng)絡(luò)結(jié)構(gòu)及獎(jiǎng)勵(lì)函數(shù)等,通過(guò)多次調(diào)參試錯(cuò),給出訓(xùn)練中最佳效果的超參數(shù)值,如表3 所示。

表3 訓(xùn)練超參數(shù)設(shè)計(jì)Table 3 Training hyper-parameters design

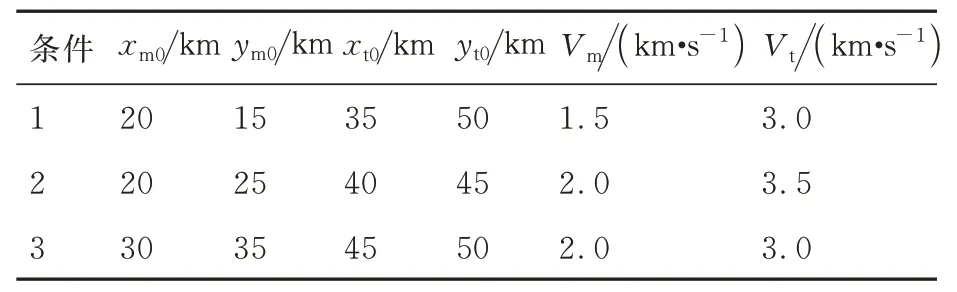

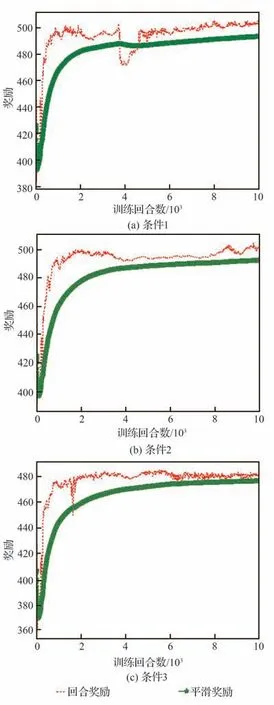

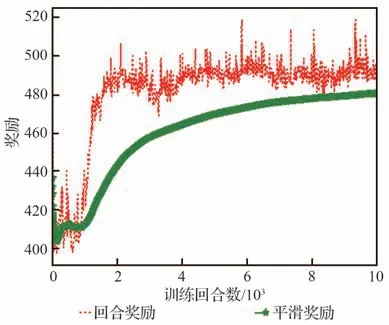

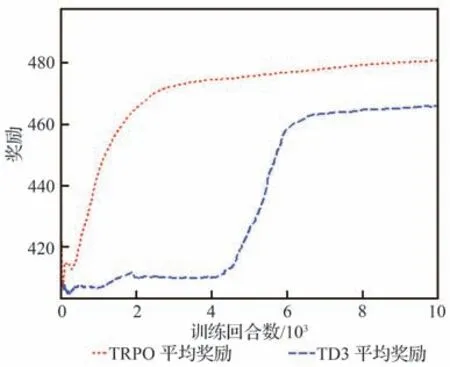

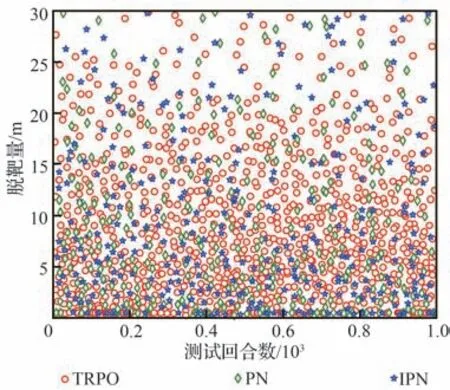

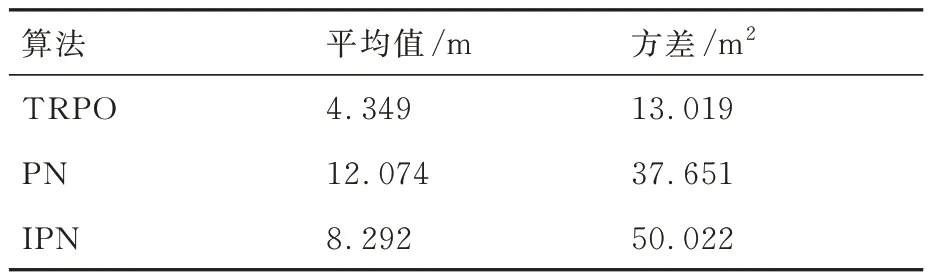

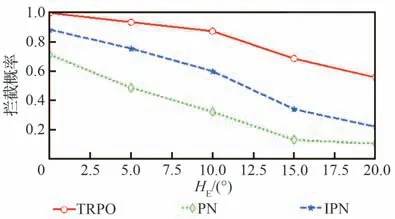

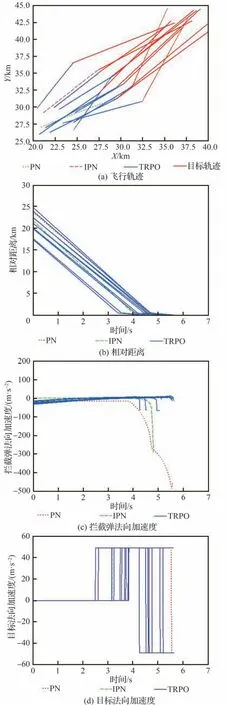

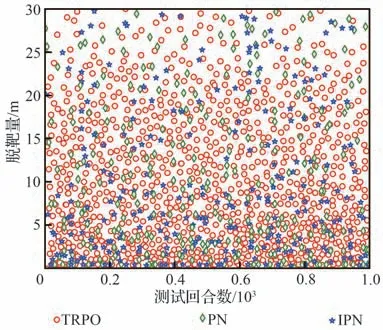

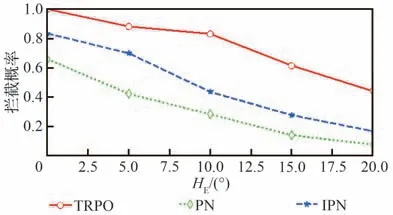

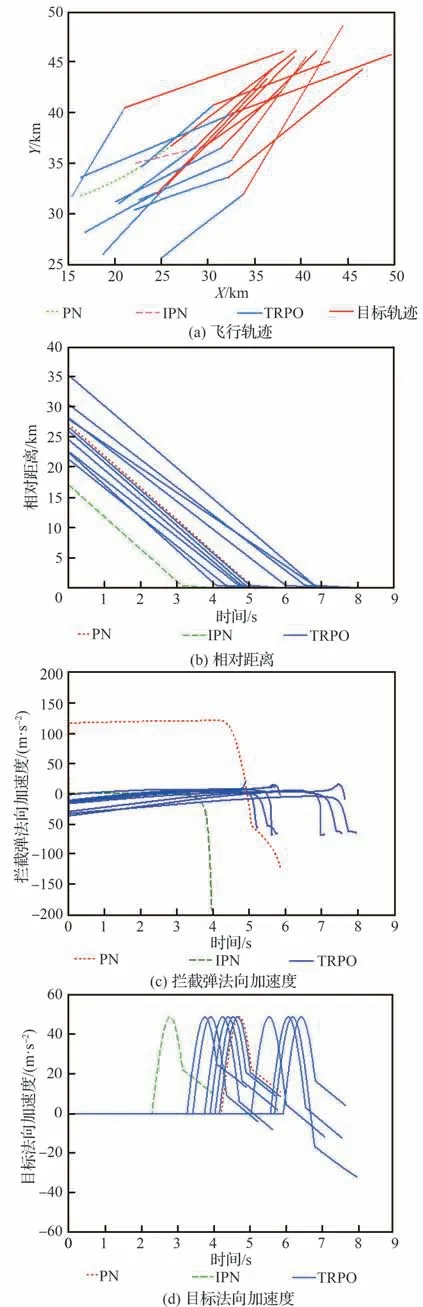

表3 中訓(xùn)練集數(shù)nepisodes與每集最大訓(xùn)練步長(zhǎng)nsteps取值依據(jù)彈目相對(duì)距離、兩者速度大小,保證每集最大訓(xùn)練步長(zhǎng)內(nèi)能夠成功攔截,且多次訓(xùn)練中保證算法能夠在訓(xùn)練集數(shù)內(nèi)收斂。策略網(wǎng)絡(luò)與評(píng)價(jià)網(wǎng)絡(luò)學(xué)習(xí)率α和β依據(jù)訓(xùn)練經(jīng)驗(yàn)評(píng)價(jià)網(wǎng)絡(luò)學(xué)習(xí)率設(shè)計(jì)比策略網(wǎng)絡(luò)高一數(shù)量級(jí)。依據(jù)攔截任務(wù)中數(shù)據(jù)量經(jīng)驗(yàn)池大小|D|一般選為1×106~5×106,最小批量數(shù)據(jù)|B|通常選為128~512,約束因子δ一般設(shè)為0.1~0.3,更新頻率Ke取值限制網(wǎng)絡(luò)參數(shù)更新頻率,通常選為60 ~90,獎(jiǎng)勵(lì)折扣系數(shù)γ通常選為0.99~0.999,合適的參數(shù)能夠在訓(xùn)練過(guò)程中使訓(xùn)練更加高效的同時(shí),盡量減小計(jì)算量。過(guò)程獎(jiǎng)勵(lì)函數(shù)中彈目相對(duì)距離系數(shù)kr,能耗系數(shù)ka,相對(duì)視線角及視線角速度系數(shù)ks1和ks2為使獎(jiǎng)勵(lì)不會(huì)過(guò)大導(dǎo)致計(jì)算量增加,又能夠在彈目相對(duì)運(yùn)動(dòng)中給出明顯的正負(fù)獎(jiǎng)勵(lì),取值范圍選定為0.1~1,且在本文算法設(shè)計(jì)中更加注重相對(duì)距離因素,故彈目相對(duì)距離權(quán)重系數(shù)取值相對(duì)較大。脫靶量Rm表示彈目距離 訓(xùn)練、測(cè)試仿真驗(yàn)證均依托于Python 3.8 和PyTorch 1.10.2 框架,計(jì)算機(jī)硬件信息為 i5-10400F CPU @ 2.90GHz,32G DDR3,1T SSD,NVIDIA GeForce GTX 1650。 在訓(xùn)練過(guò)程中,最大訓(xùn)練集被設(shè)定為1×104,每一集中最大訓(xùn)練步長(zhǎng)為1 000。在每一訓(xùn)練集開(kāi)始首先對(duì)攔截彈-目標(biāo)相對(duì)運(yùn)動(dòng)環(huán)境進(jìn)行特定或隨機(jī)初始化,得到初始化觀測(cè)狀態(tài)s0,而后智能體依據(jù)此狀態(tài)得到相對(duì)應(yīng)的動(dòng)作a0,環(huán)境得到動(dòng)作指示后,依據(jù)動(dòng)作運(yùn)用四階龍格庫(kù)塔積分得到下一步狀態(tài)st+1,起始積分步長(zhǎng)選定為0.01,當(dāng)相對(duì)距離R<500 m 時(shí)積分步長(zhǎng)選為0.001,并獲得獎(jiǎng)勵(lì)值rt+1,而后將狀態(tài)輸入到智能體,循環(huán)此過(guò)程,直到攔截目標(biāo)或步長(zhǎng)達(dá)到最大值后進(jìn)入下一訓(xùn)練集。最終直到獲得最佳的制導(dǎo)策略。同時(shí)將一系列狀態(tài)、動(dòng)作、獎(jiǎng)勵(lì)等值存入經(jīng)驗(yàn)池,每5 次循環(huán)對(duì)智能體進(jìn)行一次訓(xùn)練并運(yùn)用優(yōu)化器、梯度算法更新網(wǎng)絡(luò)參數(shù),每次更新中依據(jù)參數(shù)δ與Ke對(duì)網(wǎng)絡(luò)參數(shù)更新幅度及頻率進(jìn)行控制,且在動(dòng)作選擇時(shí)加入隨機(jī)噪聲N 用以估計(jì)執(zhí)行結(jié)構(gòu)等引起的誤差。 訓(xùn)練過(guò)程中,為保證所設(shè)計(jì)制導(dǎo)算法具有應(yīng)對(duì)多種初始情況的能力,主要針對(duì)2 種場(chǎng)景進(jìn)行訓(xùn)練:一種為特定初始條件下攔截彈-目標(biāo)相對(duì)運(yùn)動(dòng)環(huán)境,對(duì)攔截彈與目標(biāo)初始位置、初始速度進(jìn)行設(shè)定,并列舉3 種具有代表性初始特征點(diǎn)如表4 所示,相應(yīng)的學(xué)習(xí)曲線如圖6 所示;另一種是隨機(jī)初始條件下攔截彈-目標(biāo)相對(duì)運(yùn)動(dòng)環(huán)境,使攔截彈與目標(biāo)初始位置、初始速度每集訓(xùn)練時(shí)在表1 設(shè)定范圍內(nèi)進(jìn)行隨機(jī)選擇,其學(xué)習(xí)曲線如圖7 所示。 表4 訓(xùn)練初始條件Table 4 Training initial condition 圖6 特定初始條件下學(xué)習(xí)過(guò)程Fig.6 Learning process with fixed initial conditions 圖7 隨機(jī)初始條件下學(xué)習(xí)過(guò)程Fig.7 Learning process with random initial conditions 學(xué)習(xí)曲線圖6(a)可看出條件1 時(shí),在1 000 訓(xùn)練集內(nèi)獎(jiǎng)勵(lì)得到有效提升,并在4 000 集左右有明顯波動(dòng),5 000 集后訓(xùn)練曲線能夠基本保持穩(wěn)定,獎(jiǎng)勵(lì)值最終在500 左右波動(dòng)。圖6(b)可看出條件2 學(xué)習(xí)曲線在1 000 集內(nèi)得到提升,且最終能夠基本穩(wěn)定在490~500 之間。由圖6(c)可以看出條件3 學(xué)習(xí)曲線在訓(xùn)練集2 000 以內(nèi)提升、波動(dòng),最終獎(jiǎng)勵(lì)值在5 000 集后能夠穩(wěn)定在480 左右。由3 組特定條件下學(xué)習(xí)曲線可得出,雖然因?yàn)槌跏紬l件的差異,獎(jiǎng)勵(lì)曲線最終穩(wěn)定值不同,但均有較好的學(xué)習(xí)效果,證明所設(shè)計(jì)的制導(dǎo)策略針對(duì)不同初始條件,具有一定的魯棒性。 根據(jù)圖7 隨機(jī)初始條件下的學(xué)習(xí)曲線可看出,獎(jiǎng)勵(lì)在2 000 集以內(nèi)得到快速的提升,且在2 000 集后維持在480~500 間波動(dòng),由學(xué)習(xí)曲線可得知在隨機(jī)初始條件下雖比特定初始條件下波動(dòng)明顯,但仍然能夠得到理想的訓(xùn)練效果,且隨機(jī)初始條件的訓(xùn)練更加符合現(xiàn)實(shí)任務(wù)需要。經(jīng)上述訓(xùn)練曲線分析表明所設(shè)計(jì)的TRPO 制導(dǎo)算法針對(duì)不同特定初始條件、隨機(jī)初始條件的訓(xùn)練場(chǎng)景均具有一定的穩(wěn)定性,能夠及時(shí)收斂。 為進(jìn)一步對(duì)TRPO 制導(dǎo)算法訓(xùn)練效率提升效果進(jìn)行驗(yàn)證,運(yùn)用本文所設(shè)計(jì)的TRPO 制導(dǎo)算法與文獻(xiàn)[35]提出的雙延遲深度確定性策略梯度(TD3)制導(dǎo)算法對(duì)隨機(jī)條件下攔截彈與目標(biāo)相對(duì)運(yùn)動(dòng)環(huán)境進(jìn)行訓(xùn)練,圖8 顯示訓(xùn)練過(guò)程中平均獎(jiǎng)勵(lì)對(duì)比曲線。由圖8 中可得知TRPO 制導(dǎo)算法在2 000 集以內(nèi)得到收斂,而TD3 方法在4 000~6 000 集間進(jìn)行收斂。表明本文提出的TRPO 制導(dǎo)算法比TD3 制導(dǎo)算法收斂更快速,且最終平穩(wěn)獎(jiǎng)勵(lì)值更高,由此驗(yàn)證TRPO 制導(dǎo)算法對(duì)訓(xùn)練數(shù)據(jù)利用率更高,提高了訓(xùn)練效率。 圖8 獎(jiǎng)勵(lì)函數(shù)對(duì)比曲線Fig.8 Reward function comparison curves 為驗(yàn)證3.2 節(jié)訓(xùn)練的TRPO 制導(dǎo)算法的有效性、魯棒性及在不同初始條件下攔截不同機(jī)動(dòng)模式目標(biāo)的泛化性,對(duì)所設(shè)計(jì)的TRPO 制導(dǎo)算法進(jìn)行2 種場(chǎng)景下的測(cè)試驗(yàn)證:一是在學(xué)習(xí)場(chǎng)景下進(jìn)行測(cè)試;二是在未知場(chǎng)景下進(jìn)行測(cè)試。測(cè)試過(guò)程中考慮攔截彈在臨近空間環(huán)境的復(fù)雜性,易受到風(fēng)場(chǎng)等干擾,在測(cè)試中對(duì)彈道傾角φm加入5%實(shí)時(shí)誤差,驗(yàn)證本文所設(shè)計(jì)的深度強(qiáng)化學(xué)習(xí)算法在攔截目標(biāo)時(shí)具有應(yīng)對(duì)干擾的能力。并將測(cè)試結(jié)果與傳統(tǒng)的比例導(dǎo)引律(PN)及改進(jìn)比例導(dǎo)引律(IPN)結(jié)果相比較,驗(yàn)證算法的高效性。 PN 和IPN 具體形式為[42] 3.3.1 學(xué)習(xí)場(chǎng)景下測(cè)試 本節(jié)基于上文建立的攔截彈-目標(biāo)交戰(zhàn)環(huán)境,運(yùn)用隨機(jī)初始條件下訓(xùn)練的制導(dǎo)算法,并與隨機(jī)初始條件下訓(xùn)練過(guò)程采用相同的參數(shù),具體取值如表3 所示,同時(shí)目標(biāo)進(jìn)行方波機(jī)動(dòng)如式(37)所示。在學(xué)習(xí)場(chǎng)景下采用蒙特卡洛打靶法進(jìn)行1 000 次打靶仿真對(duì)所設(shè)計(jì)的制導(dǎo)算法進(jìn)行測(cè)試,并將結(jié)果與PN、IPN 仿真結(jié)果相比較,驗(yàn)證算法的優(yōu)越性,脫靶量散點(diǎn)分布如圖9 所示。 圖9 學(xué)習(xí)場(chǎng)景下脫靶量分布Fig.9 Miss distances distribution in learned scenarios 由圖9 可得知在15 m 處脫靶量分布逐漸密集,且越靠近0 m 分布越密集。統(tǒng)計(jì)不同導(dǎo)引律脫靶量平均值及方差特性如表5 所示。由表5 中數(shù)據(jù)可得知與傳統(tǒng)的PN、IPN 相比,所提出的深度強(qiáng)化學(xué)習(xí)制導(dǎo)算法脫靶量具有明顯的減小,平均值基本能夠維持在4.5 m 以內(nèi),由方差值大小可得出TRPO 制導(dǎo)算法相較于PN、IPN 脫靶量波動(dòng)更小,攔截效果更加平穩(wěn),驗(yàn)證提出的深度強(qiáng)化學(xué)習(xí)制導(dǎo)算法具有一定的優(yōu)越性。 表5 脫靶量統(tǒng)計(jì)Table 5 Statistics of miss distances 為進(jìn)一步測(cè)試提出的深度強(qiáng)化學(xué)習(xí)制導(dǎo)算法在不同初始彈道傾角誤差下的性能,針對(duì)不同初始彈道傾角誤差分別進(jìn)行1 000 次蒙特卡洛仿真實(shí)驗(yàn),并分別記錄不同彈道傾角誤差下的攔截概率,其性能對(duì)比如圖10 所示。由圖10 可得知,TRPO 制導(dǎo)算法在不同彈道傾角誤差下性能均優(yōu)于傳統(tǒng)PN、IPN 制導(dǎo)律,且隨著初始彈道傾角誤差的增大,優(yōu)勢(shì)更為明顯,表明所設(shè)計(jì)的制導(dǎo)算法對(duì)中末交班條件要求更低,初始彈道傾角誤差容錯(cuò)率更高,能夠一定程度上對(duì)攔截彈中制導(dǎo)誤差進(jìn)行修正。另一方面在測(cè)試過(guò)程中所設(shè)計(jì)的彈道傾角基礎(chǔ)上增加5%實(shí)時(shí)誤差,用于模擬外部環(huán)境干擾,攔截結(jié)果表明所設(shè)計(jì)的深度強(qiáng)化學(xué)習(xí)制導(dǎo)算法具有應(yīng)對(duì)外部干擾的能力。 圖10 學(xué)習(xí)場(chǎng)景下攔截性能對(duì)比Fig.10 Comparison of interception probability in learned scenarios 攔截過(guò)程中,為更加直觀的展現(xiàn)所設(shè)計(jì)的TRPO 制導(dǎo)算法針對(duì)不同位置、速度來(lái)襲目標(biāo)的攔截效果,選取學(xué)習(xí)場(chǎng)景下10 組攔截彈與目標(biāo)運(yùn)動(dòng)狀態(tài)與1 組傳統(tǒng)PN、IPN 攔截過(guò)程進(jìn)行記錄繪圖,攔截測(cè)試中攔截彈與目標(biāo)運(yùn)動(dòng)軌跡、相對(duì)運(yùn)動(dòng)距離、攔截彈法向加速度及目標(biāo)法向加速度如圖11 所示,由圖11(a)可更加直觀的得到不同初始條件下的攔截效果,運(yùn)用本文提出的TRPO 算法能夠?qū)Σ煌跏嘉恢谩⑺俣鹊哪繕?biāo)進(jìn)行有效攔截。由圖11(b)可得出攔截彈與目標(biāo)相對(duì)距離呈線性減小,當(dāng)目標(biāo)與攔截彈相對(duì)距離減小到一定程度時(shí),本文設(shè)定為500 m,為了更加精確對(duì)目標(biāo)進(jìn)行攔截,積分步長(zhǎng)減小,相對(duì)距離縮減變緩。由圖11(c)攔截彈法向加速度曲線可得出TRPO 制導(dǎo)算法與傳統(tǒng)PN、IPN 算法相比,法向加速度后期變化更為平緩。在接近目標(biāo)時(shí),攔截彈法向加速度增加是由于目標(biāo)進(jìn)行機(jī)動(dòng)導(dǎo)致,與圖11(d)中目標(biāo)法向加速度變化曲線相對(duì)應(yīng),且由圖可得知目標(biāo)進(jìn)行方波機(jī)動(dòng)。但兩者法向加速度均在所設(shè)計(jì)的加速度范圍內(nèi),滿足攔截要求。而由圖11(c)可得知傳統(tǒng)PN、IPN 算法的法向加速度不在所設(shè)定的范圍內(nèi),易造成執(zhí)行機(jī)構(gòu)的飽和。 圖11 學(xué)習(xí)場(chǎng)景下測(cè)試結(jié)果Fig.11 Test results in learned scenarios 3.3.2 未知場(chǎng)景下測(cè)試 為驗(yàn)證所設(shè)計(jì)的深度強(qiáng)化學(xué)習(xí)制導(dǎo)算法針對(duì)未知環(huán)境的適應(yīng)能力,本小節(jié)中運(yùn)用隨機(jī)初始條件下訓(xùn)練的模型對(duì)未知場(chǎng)景進(jìn)行測(cè)試,且在攔截測(cè)試過(guò)程中采用與隨機(jī)初始條件下訓(xùn)練過(guò)程相同的超參數(shù),具體取值如表3 所示,仿真仍然采用1 000 次蒙特卡洛打靶實(shí)驗(yàn)。其初始條件改變主要包括目標(biāo)的機(jī)動(dòng)方式、目標(biāo)與攔截彈初始位置、速度變化等。其初始位置與速度主要針對(duì)超出隨機(jī)初始條件范圍的部分進(jìn)行測(cè)試,具體位置、速度范圍如表6 所示,其他訓(xùn)練場(chǎng)景參數(shù)邊界值如表1 所示。目標(biāo)機(jī)動(dòng)方式選為正弦機(jī)動(dòng),進(jìn)一步驗(yàn)證制導(dǎo)算法的泛化性。 表6 未知場(chǎng)景參數(shù)邊界Table 6 Unlearned scenario parameters constraints 正弦機(jī)動(dòng)具體形式表示為 式中:ωs表示正弦機(jī)動(dòng)頻率。 在正弦機(jī)動(dòng)模式下,測(cè)試過(guò)程中脫靶量分布與傳統(tǒng)PN 和IPN 算法對(duì)比如圖12 所示,由圖可知TRPO 制導(dǎo)算法脫靶量在20 m 以內(nèi)分布逐漸密集,表明TRPO 制導(dǎo)算法對(duì)不同位置、速度及機(jī)動(dòng)模式的來(lái)襲目標(biāo)均具有較好的攔截效果。 圖12 未知場(chǎng)景下脫靶量分布Fig.12 Miss distances distribution in unlearned scenarios 不同初始彈道傾角誤差下的性能對(duì)比如圖13 所示,由圖得知TRPO 制導(dǎo)算法相較于傳統(tǒng)制導(dǎo)律在不同初始彈道傾角誤差時(shí)均具有更高的攔截概率,但在初始彈道傾角誤差較大時(shí),其攔截效果提升有輕微減小,后續(xù)研究中可對(duì)未知場(chǎng)景初始彈道傾角誤差較大的情況進(jìn)行改進(jìn)。 圖13 未知場(chǎng)景下攔截概率對(duì)比Fig.13 Comparison of interception probability in unlearned scenarios 為進(jìn)一步直觀的展現(xiàn)本文所設(shè)計(jì)的TRPO制導(dǎo)算法針對(duì)目標(biāo)速度、位置超過(guò)訓(xùn)練過(guò)程中所設(shè)定范圍、且機(jī)動(dòng)模式改變時(shí)的攔截效果,同時(shí)記錄不同制導(dǎo)算法在攔截過(guò)程中制導(dǎo)參數(shù)的變化情況,在未知場(chǎng)景下選取10 組TRPO 制導(dǎo)算法與傳統(tǒng)PN 和IPN 算法攔截過(guò)程進(jìn)行對(duì)比。詳細(xì)攔截過(guò)程、彈目相對(duì)距離變化曲線及攔截彈、目標(biāo)法向加速度如圖14 所示。由圖14(a)可知,當(dāng)攔截彈與目標(biāo)位置、速度位于所設(shè)定范圍以外時(shí),TRPO 制導(dǎo)算法仍具有很好的攔截效果,更加說(shuō)明TRPO 制導(dǎo)算法的泛化性,可應(yīng)用于多種攔截場(chǎng)景。由圖14(c)可得知傳統(tǒng)PN、IPN 制導(dǎo)律與所設(shè)計(jì)的TRPO 制導(dǎo)算法相比,法向加速度變化劇烈,且不在所規(guī)定范圍內(nèi),容易造成執(zhí)行機(jī)構(gòu)飽和,消耗更多的能量。由圖14(d)目標(biāo)法向加速度變化曲線可看出目標(biāo)在攔截過(guò)程后半程進(jìn)行正弦機(jī)動(dòng)。 圖14 未知場(chǎng)景下測(cè)試結(jié)果Fig.14 Test results in unlearned scenarios 依據(jù)上述學(xué)習(xí)場(chǎng)景和未知場(chǎng)景下的測(cè)試仿真分析可得知,運(yùn)用所設(shè)計(jì)的TRPO 制導(dǎo)算法針對(duì)不同位置、速度及不同機(jī)動(dòng)模式的目標(biāo)均具有較好的攔截效果,證實(shí)TRPO 制導(dǎo)算法具有泛化性,并具有一定的魯棒性及應(yīng)對(duì)外部干擾的能力,且相較于2 種傳統(tǒng)制導(dǎo)律性能優(yōu)勢(shì)明顯。在攔截過(guò)程中,深度強(qiáng)化學(xué)習(xí)制導(dǎo)算法運(yùn)用神經(jīng)網(wǎng)絡(luò)對(duì)4 種狀態(tài)變量進(jìn)行擬合得到指令加速度,其計(jì)算量較小,經(jīng)過(guò)在不同配置計(jì)算機(jī)上進(jìn)行訓(xùn)練測(cè)試,均具有較快的收斂速度,且單次攔截測(cè)試均保持在1 s 內(nèi),表明所設(shè)計(jì)的TRPO 制導(dǎo)算法可應(yīng)用于多種配置計(jì)算機(jī)。 提出了一種攔截臨近空間高超聲速飛行器的信賴域策略優(yōu)化(TRPO)制導(dǎo)算法。建立了攔截彈與目標(biāo)相對(duì)運(yùn)動(dòng)交戰(zhàn)模型,并與制導(dǎo)算法共同構(gòu)建馬爾可夫決策框架,依據(jù)實(shí)際任務(wù)需求設(shè)計(jì)狀態(tài)空間、動(dòng)作空間和深度強(qiáng)化學(xué)習(xí)制導(dǎo)算法中的網(wǎng)絡(luò)結(jié)構(gòu)以及結(jié)合相對(duì)距離、相對(duì)視線角及能量消耗等因素的獎(jiǎng)勵(lì)函數(shù),并在算法訓(xùn)練過(guò)程中針對(duì)狀態(tài)空間、獎(jiǎng)勵(lì)運(yùn)用歸一化方法加快學(xué)習(xí)速度。最終在學(xué)習(xí)場(chǎng)景和未知場(chǎng)景下運(yùn)用蒙特卡洛打靶法對(duì)制導(dǎo)算法進(jìn)行仿真驗(yàn)證,仿真結(jié)果表明:本文所提出的深度強(qiáng)化學(xué)習(xí)制導(dǎo)算法相較于傳統(tǒng)比例導(dǎo)引律(PN)及改進(jìn)比例導(dǎo)引律(IPN)具有更好地?cái)r截效果,更小的脫靶量,更穩(wěn)定的性能,在多種場(chǎng)景下具有一定的魯棒性、抗干擾性及泛化性,并可適應(yīng)于多種不同配置計(jì)算機(jī)。3.2 訓(xùn)練過(guò)程

3.3 測(cè)試過(guò)程

4 結(jié)論