基于圖像的地鐵車站施工人員不安全行為識別研究

祝銘悅 牛梓儒 萬勇 朱仁遲 張丹 郭海林

關鍵詞:安全管理工程其他學科;地鐵車站施工;不安全行為;動作識別;模型優化

中圖分類號:X947 文獻標識碼:A DOI: 10.7535/hbgykj.2023yx01004

隨著中國城市建設的快速發展,地面交通壓力越來越大。為緩解城市交通壓力,地鐵項目相繼開工,在建設過程中出現大量安全事故。近15年來,發生在施工階段的地鐵安全事故占比約為60%[1],其中,人的不安全行為導致的安全事故占總數的70%~98%[2]。由于在地鐵車站施工中,人員的不安全行為復雜多樣,傳統的人盯人安全監管已不能滿足現場管理需求;同時監控攝像頭已廣泛應用于施工現場,為圖像識別提供了良好的硬件基礎[3]。因此,有必要開展地鐵車站施工人員不安全行為的圖像識別研究,為實時監管施工人員的不安全行為提供科學依據。

圖像識別作為計算機視覺中的一個分支,近幾年有了長足的進步和發展。目前,圖像識別在人們的日常生活中十分常見[4],如高鐵站身份核對、指紋打卡、人臉支付等,應用領域也十分廣泛。尤其在建筑行業,人體姿態識別技術受到研究者們的青睞。楊梟[5]利用Open Pose算法提取人體關鍵點信息,建立二維的人體骨骼模型,提出多特征融合的CamShift跟蹤算法來完成叉車人員安全檢測任務。元黎明[6]首先將建筑工人不安全行為分為4大類,運用AI智能框架Eazy DL設計不安全行為檢測系統識別動作。于言滔[7]通過將不安全行為的檢測轉化為對前置動作的識別,構建的人體模型用關節參數角度表示不安全前置動作,建立實時采集模塊識別工人依靠、高處傾倒和攀爬3類動作。謝逸等[8]從人身檢測、入侵檢測以及協同作業檢測3個方面對人員不安全行為進行監測,同時提出了較為系統的檢測框架。地鐵施工中,王凱迪[9]構建基于YOLO 的小目標檢測網絡,能較好地對地鐵施工人員以及安全帽進行識別。綜上,目前人體動作識別研究十分廣泛,研究成果較為豐富,但仍然存在對地鐵車站施工人員的行為識別研究較少、復雜環境下識別模型復雜與識別率不高等問題。

因此,為解決地鐵車站施工人員不安全行為的實時監管等現實問題[10],本文擬在對地鐵車站施工人員不安全行為分類的基礎上,基于現場圖像研究人員越界行為的檢測方法,并構建施工人員行為數據庫,利用機器學習和深度學習算法對施工人員動作進行識別,為實現地鐵車站施工安全智能管理提供支持。

1 地鐵車站施工不安全行為分析

1.1 施工人員不安全行為定義

狹義的行為安全領域研究表示,不安全行為包括施工人員作業時的某種行為、行為引發事故的趨勢與選擇此行為的原因3個因素[11-13]。由此可知,地鐵施工人員的不安全行為是指在地鐵施工過程中施工人員產生的已經導致事故發生或可能會造成安全事故的人為差錯,包括導致傷害事故發生的不安全動作以及規定實施而沒有執行的安全行為。

1.2 施工人員不安全行為分類

在地鐵施工過程中,現場人員必須遵守國家標準規范、規章制度及各類安全管理條例[14],例如《安全生產法》《建筑安裝安全操作規程》、地鐵施工相關規范以及公司制定的地鐵工程施工安全管理制度等。根據法律法規、參考文獻以及地鐵車站施工實地調研,本文將地鐵車站施工人員的不安全行為從識別角度分為4類:不安全位置類、不安全動作類[15]、未正確使用個人勞動防護用品和其他。

本文主要針對地鐵車站施工現場人員處于不安全位置和做出不安全動作進行識別。

2 檢測基本算法

2.1 基于MobileNet V1的SSD目標檢測算法

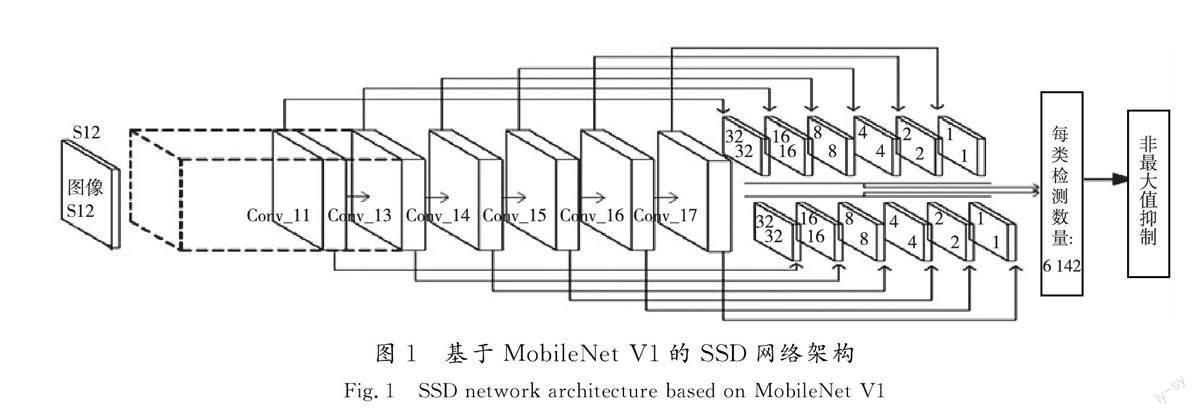

本文采用基于MobileNet V1 的SSD(shotmultibox detector)算法,全連接層、最大池化層和Softmax 等最后幾層被省略[16],同時具有MobileNet V1算法延遲低和SSD算法的高精度檢測特點。基于MobileNet V1的SSD架構模式如圖1所示。

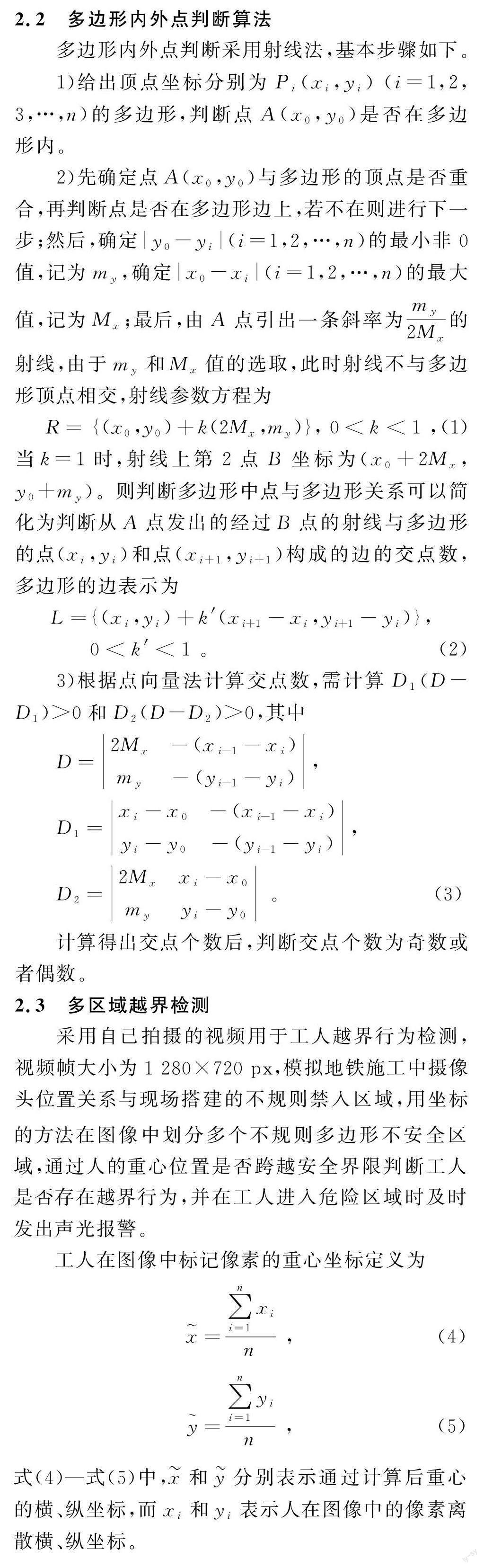

越界檢測效果如圖2所示,圖中藍色區域為標定的不安全區域,當人員進入畫面時顯示目標的ID,從0開始,并用白色矩形框標注,通過計算矩形框內人體像素重心坐標,利用射線法判斷重心越過不安全區域邊界時發出警告,區域邊界顯示為紅色,輸入視頻測試時幀率達到30 f/s,檢測識別效果較好。

3 基于骨骼序列的施工人員不安全行為識別數據集的構建

3.1 實驗設計

在實驗室環境下模擬施工人員在施工現場經常出現的8種行為,并對其進行識別,包括現場安全行為和不安全行為,包括堆放、行走、蹲坐、揮手、攀爬斜坡、依靠、跌倒和下樓打電話。本文采用雙攝像頭進行視頻錄制,攝像頭通過USB與電腦直接連接,通過軟件保存實驗視頻數據,攝像頭幀率為30 f/s,圖像大小為1 280×720 px,攝像頭高度設為1.4 m,分別采集人體正面和側面2個方向的數據。為保證能夠完整拍攝到人體動作,在攝像頭畫面中規定動作區域并用紅線表示。

實驗人數為20,所有被試者均為非專業施工人員,實驗分為預采集階段和正式采集階段,預采集階段人數為1,實驗編號為0,正式采集階段共19人,實驗編號為1~19。施工現場男多女少,因此本文實驗被試者中男性15名,女性5名。

每個動作從開始到結束采集時間設定為15 s,每個動作采集6次,實驗前被試者休息5~10 min,隨后引導被試者站立在畫線區,確保能夠捕捉到整個身體,開始捕捉。每種動作采集6 次后休息2 min,避免疲勞實驗,8 種動作采集完畢后實驗結束。

3.2 數據采集與處理

實驗中每個動作采集了120個視頻數據,總共采集視頻數據1 920個。采集到的視頻每隔20 f提取一張圖片轉換成圖片數據,剔除掉部分不符合要求的圖片。然后對每張圖片使用Open Pose模型估計圖像中人體骨骼點的空間位置信息和置信度,并將骨骼點信息保存到csv文件中。

對于本文所采集的動作,移除了頭部和腳掌的關節數據,同時刪除置信度較低(低于0.3)的信息。數據預處理之后,手動設計和提取可能對區分動作類型有用的顯著特征。為區分不同動作并消除不同圖像大小的影響,降低數據維度,提高模型的訓練速度和準確性,本文將骨骼點位置信息轉換為10個關節角度,使用的Open Pose算法獲取人體骨骼中鼻子、脖子等25個關節點編號。

4 模型構建與結果分析

4.1 KNN 模型參數優化與識別結果分析

在本文建立的模擬施工人員行為數據集上,用KNN 算法作為分類器,相關超參數設置為“n_neighbors”表示取臨近點的數量k,通過不同k 值的測試,“n_ neighbors”設置為25。權重參數“weights”設置為“distance”,表示權重為距離的倒數,距離近的對分類判決影響大。“algorithm”設置為“kd_tree”,表示通過構造KD 樹來實現鄰近樣本的搜索。距離參數“p”設置為2,表示距離的度量方法使用的是歐氏距離。

KNN模型評估參數如表1所示,輸出混淆矩陣如圖3所示。使用KNN 算法得到的總體準確率為93.45%,所有動作的精確率均高于83.00%,平均精確率為93.28%;召回率均高于73.00%,平均召回率為93.50%;F1 值均高于80.00%,其平均值為93.20%。其中“下樓打電話”動作的F1 值僅80.60%,識別效果最差;該算法對“行走”“蹲坐”“堆放”和“依靠”4個動作識別效果較好,F1 值均大于95.00%。由輸出混淆矩陣可知,對于“下樓打電話”動作有17.00%的概率被錯誤識別為“攀爬斜坡”,有3.00%的概率被錯誤識別為“揮手”,有3.00%的概率被錯誤識別為“蹲坐”,錯誤率最高,其他動作的錯誤識別率均在3.00%以下。

4.2 MLP模型構建與識別結果分析

編寫程序使用基于TensorFlow 平臺的Keras深度學習框架構建MLP模型,考慮到函數式模型和序貫模型的特點,本文編寫的MLP模型使用序貫模型(Sequential)。構建的最終模型由5個全連接層組成,模型前4個全連接層均使用ReLU 激活函數,最后一層用Softmax作為激活函數。為防止模型過擬合,全連接層中權重矩陣用Keras.regularizers.l2正則化方法,正則化參數λ 設置為0.01。

MLP模型評估參數如表2所示,輸出混淆矩陣如圖4所示。使用MLP模型得到的總體準確率為93.94%。除“下樓打電話”動作的精確率較低為76.05%,其余動作準確率均高于92.00%,平均精確率為94.22%;所有動作的召回率均高于85.00%,平均召回率為93.85%;F1值均高于81.00%,其平均值為94.73%。其中“下樓打電話”動作的F1值為81.86%,“揮手”和“行走”動作的F1值均高于98.00%,識別效果較好。

4.3 LSTM模型構建與識別結果分析

基于TensorFlow 的Keras庫構建模型,分類模型添加了3個LSTM 層和1個Dense層,激活函數設置為Softmax,損失函數使用categorical_crossentropy(交叉熵函數),采用Adam 算法作為優化器,超參數中學習率α 設置為0.000 1。

LSTM 模型評估參數如表3所示,輸出混淆矩陣如圖5所示。LSTM 模型得到的總體準確率為93.68%。所有動作準確率均高于83.00%,平均精確率為93.57%;除“跌倒”動作召回率只有74.84%,其余動作的召回率均高于94.00%,平均召回率為93.72%;F1 值均高于80.00%,其平均值為93.53%,“跌倒”動作的F1值最低,為80.26%。

綜上,KNN,MLP 與LSTM 模型的總體準確率分別為93.45%,93.94%和93.68%;F1的平均值分別為93.20%,94.73%和93.53%。

5 結語

為解決人工監測地鐵車站施工人員不安全行為不夠理想的問題,本文提出了新型不安全行為分類方法和優化的MLP識別模型,主要研究結論如下。

1)通過刺激-反應行為模式和勒維特行為模型,并依據現場調研從圖像的角度將地鐵車站施工人員不安全行為分為4類。

2)為解決施工人員的定位和追蹤問題,通過實驗確定不安全行為特征,結合傳統的射線法和越界警報,對MobileNet V1的SSD算法進行了優化,判斷了施工人員是否出現在不安全區域,實驗結果驗證了該方法的有效性和可行性。

3)依據地鐵車站施工現場情況以及分析車站施工安全事故選取了8種動作進行識別,在自建數據集中,傳統機器學習算法KNN 總體準確率達到93.45%,平均召回率達到了93.50%;優化后的MLP和LSTM 兩種神經網絡模型總體準確率分別為93.94%和93.68%,平均召回率達到了93.85%和93.72%;相對傳統KNN 算法,MLP 和LSTM模型的總體準確率分別提高了0.49%和0.23%。而MLP模型的識別準確率和F1 值最高,對不安全行為的識別錯誤率最低,可選擇MLP模型作為地鐵車站施工人員不安全行為的識別模型,為構建地鐵施工安全智能識別系統提供模型基礎。

論文實現了基于圖像的多區域條件下的施工人員不安全行為的識別,但是目前所提出的模型在人員行為預測等方面還有待研究,后續可加入人員行為預測功能,以進一步提高識別系統的安全性和人機交互性。