基于語義概念的圖像情感分析

楊瀚森, 樊養余, 呂國云, 劉詩雅, 郭哲

(1.西北工業大學 電子信息學院, 陜西 西安 710072; 2.虛擬現實內容制作中心, 北京 101318)

隨著互聯網技術的快速發展和應用,越來越多的人在社交媒體上表達意見,分享情感和日常生活。大量的文字、視覺內容在不同用戶之間傳播。相比于文字,視覺內容包含更多的抽象信息,針對圖像的分析引起了研究者的密切關注。當下,圖像情感分析在輿情監控、意見挖掘[1]方面發揮了重要作用。此外,該領域開發出的技術存在很多潛在的應用,比如,推薦[2]、娛樂[3]、行為評估等。

圖像情感分析的目的是預測圖像的情感類別,或獲得與查詢圖像具有相同情感的圖像。與基于內容的圖像分析任務相比,情感的主觀性與抽象性使得圖像特征和情感之間存在“語義鴻溝”。早期,研究者利用或設計不同的底層特征以學習它們與人類情感之間的映射。Olkiewicz等[4]使用邊緣、顏色、紋理直方圖等人工特征的組合進行情感圖像檢索。Zhang等[5]提取圖像的顏色、形狀、紋理特征,利用多核學習進行情感圖像分類與檢索。受到心理學及藝術理論的啟發,Zhao等[6]基于藝術方面的理論,提取圖像平衡、梯度、運動等特征,并結合底層以及高層特征,進行了圖像到情感的多圖學習。隨著卷積神經網絡在物體檢測、圖像分割、圖像識別等領域的成功應用,深度卷積神經網絡也逐步被引入圖像情感分析領域[7-8]。近年來,研究人員在卷積神經網絡的基礎上,提出了各種基于情感的圖像檢索方法。Yang等[9]利用情感之間的層級關系,提出一種具有層級結構的三元組損失函數,實現了情感圖像的檢索與分類。Yao等[10]在Yang[9]提出的損失函數的基礎上,用自適應間隔代替三元組中的固定間隔,增強了檢索與分類性能。Yao等[11]利用情感層級關系,設計了一種帶有層級結構的N-Pair Loss損失函數,對情感圖像進行檢索和分類,并且在此基礎上提出一種自適應的難分負樣本生成方法[12],進一步提升了模型性能。

目前,圖像情感分析領域的方法都是建立圖像特征和情感之間的直接映射關系。然而,圖像情感分析包含了人們感知過程的主觀性和抽象性,直接的映射關系往往難以準確建立。

除計算機視覺領域,圖像對情感的影響也得到了心理學家的關注。心理學研究[13]表明,人類感知情感的過程分為3步:刺激(stimuli,S)、機理(organism,O),反應(response,R),即S-O-R模型。然而現有的圖像情感分析方法可以看作是直接建立S-O-R中S和R的關系,而包含人的感知知識以及經驗的機理(O)步驟被忽略了。此外,用獨熱(one-hot)離散向量來表示情感標記,外部的知識無法融入模型的訓練過程。所以,通常的圖像情感分析方法會受到模糊性和主觀性的影響,而人的情感認知卻較少受到影響。

受到情感認知過程的啟發,本研究嘗試在圖像到情感的學習過程中加入類似于人們認知的中間特征。

一類圖像情感概念為本研究提供了思路。這些概念通過名為DeepSentibank[14]的圖像概念檢測器得到。給定一張圖片,DeepSentibank能夠輸出多個跟情感有關的語義概念,比如“beautiful flower”或“smiling girl”等。這些概念能夠很好地描述圖像內容,同時具有明顯的情感傾向性,因此可以很好地作為圖像和情感之間的中間語義。

綜合以上事實,本研究提出了一種新的圖像情感分析方法,利用情感概念作為中間語義來連接圖像與情感之間的關系,旨在克服圖像情感分析中的模糊性和主觀性問題。首先,本研究建立了一個情感專屬知識圖譜來描述概念和情感之間的關系。然后將知識圖譜中的節點嵌入到一個共同的語義空間中。模型的訓練采用端到端的視覺-語義嵌入方式,將圖像特征投影至語義空間與情感進行匹配。同時,情感圖像在語義上具有較大的差異性,本研究還提出了一個多級可變間隔損失函數,從而有效地學習圖像特征和情感之間的關系。在該損失函數中,間隔大小可以根據相應的概念相似度進行自動調節。實驗表明,本文提出的方法具有較好的分類及檢索性能,模型輸出特征具有較高的可區分性。

1 方 法

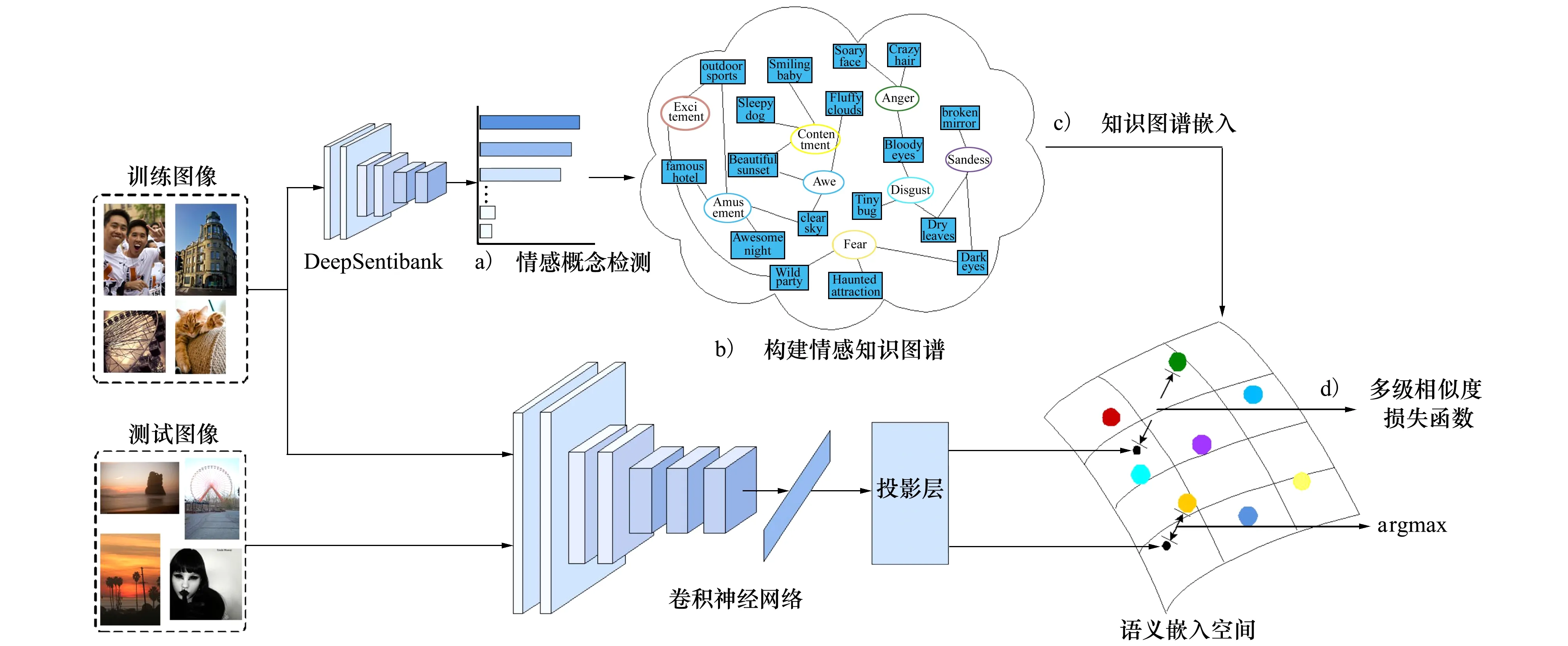

圖1展示了本研究所提出方法的框架:①訓練圖像經過DeepSentibank檢測器得到一系列情感概念;②利用情感概念以及情感構建知識圖譜;③用圖嵌入方法將知識圖譜嵌入語義空間;④利用卷積神經網絡提取圖像特征,將圖像特征投影至語義空間,通過多級相似度損失函數優化圖像特征和情感特征之間的相似度。測試時,計算圖像投影特征與不同情感向量之間的相似度,將相似度最大的情感作為預測結果。

圖1 系統框架圖

1.1 DeepSentibank簡介

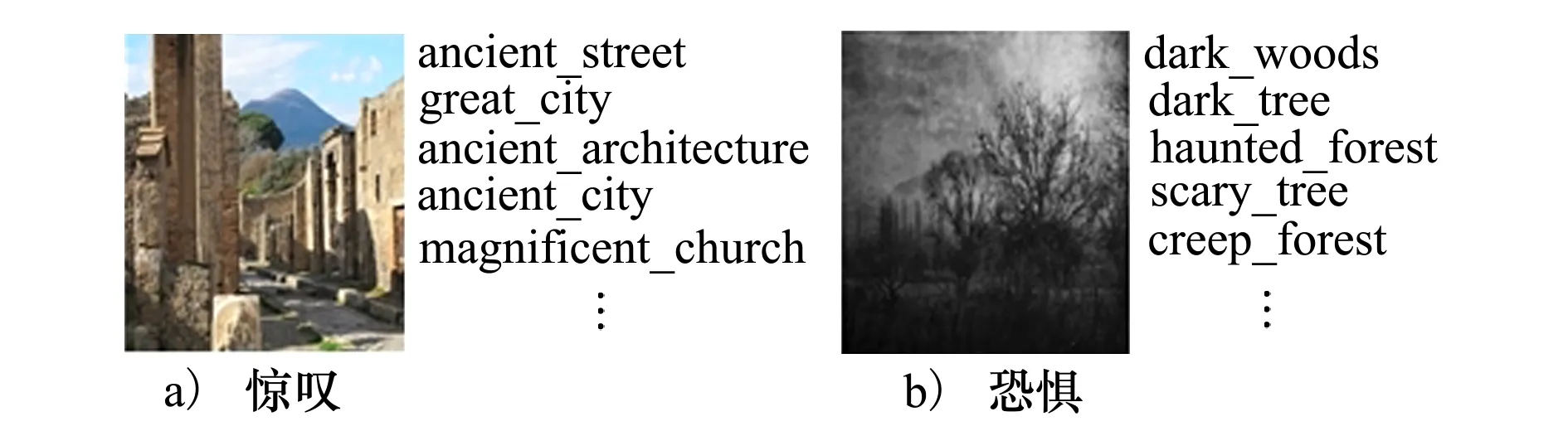

本研究中的情感語義概念通過視覺概念檢測器DeepSentibank得到。基于在ImageNet數據集上預訓練的深度模型,Chen等[14]在VSO[15]數據集上對深度模型進行微調。VSO是一個通過基于情感詞語檢索和標記分析建立的情感本體數據集,該數據集包含3 000個情感概念標記和100多萬張圖像。DeepSentibank的最后一個全連接層有2 089個神經元,每個神經元對應一個情感概念。輸入一張圖片,DeepSentibank能夠輸出2 089個概念的概率分布。圖2給出了情感概念的示例。當人們看到圖2a)所示的圖片時,不禁對歷史遺跡發出贊嘆。所以,驚嘆是與這張圖片最匹配的情感響應。當人們看到圖2b)這樣的場景時,相比較于其他情感,恐懼可能是最為接近人們反應的情感。很明顯,除了圖像的視覺信息,人們經驗當中的先驗知識會在很大程度上影響情感認知。

圖2 情感概念示例

1.2 問題描述

(1)

θ是視覺語義嵌入模型中需要學習的參數。

1.3 圖像表示

預訓練的深度神經網絡模型可以作為良好的圖像表示。在ResNet50[16]的基礎上建立視覺語義嵌入模型,并在訓練集上對其進行微調。為了消除ResNet50最后一個全連接層與圖嵌入空間中節點維數的差異,用另一個全連接層替換ResNet50本身的最后一個全連接層。基于其他深度模型的性能將會在之后進行討論。

1.4 知識圖譜構建與表示

為了將外部知識融入到模型的訓練過程中,首先建立一個情感專屬的知識圖譜。在該知識圖譜中,情感和概念之間的相互關系得以描述。知識圖譜作為一種實體的組織方式,能夠將數據以圖的形式保存和表示,并且保留各實體之間的結構化信息。

一個圖可以表示為G=(V,E),V表示節點,E表示邊。節點之間的關系通過邊來表示。在本研究構建的情感專屬知識圖譜中,有C個情感類別和S個概念,所以一共有C+S個節點。邊e=(VM,VP)∈E表示情感節點(VM)和概念節點(VP)之間的連接權重,邊e=(VP,VP)∈E表示2個概念節點之間的連接權重。首先用檢測器對訓練集中的每個圖片進行檢測。因為檢測概率較低的概念不能夠正確反映圖像中的內容,所以對每張圖像保留前k個檢測概念。于是,可以通過統計概念和情感之間的共現次數,以及概念和概念之間的共現次數,并且進行歸一化,得到兩類邊的權值。如圖2a)所示,ancient street和驚嘆以及ancient city分別共現一次。任意2個情感節點之間沒有關聯。

在構建知識圖譜后,利用Node2vec[17]將圖譜中的所有實體以及圖關系嵌入到一個低維的語義空間中,Node2vec是一種基于Skip-gram的圖嵌入方法,采用一種有偏的隨機游走采樣方式,通過參數設置來控制搜索策略,從而有效地平衡了學習過程中的同質性和同構性。并且這種游走方式可以挖掘出結構相似性等序列本身沒有的信息。同質性和同構性較強的節點在該語義空間中距離較近,而相似度較低的語義節點距離則較遠。

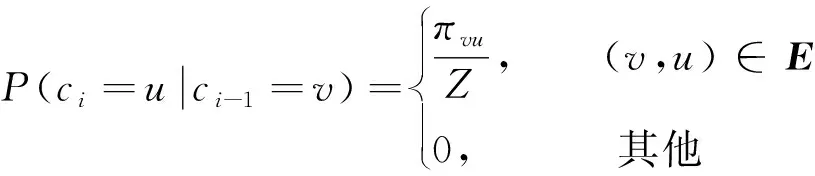

給定當前節點v,訪問下一個節點u的概率為

(2)

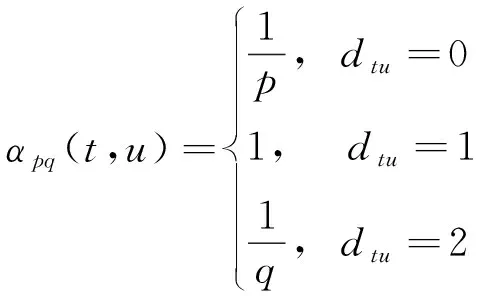

式中:ci表示游走中的第i個節點;Z是歸一化常數;πvu是節點v和節點u之間的未歸一化轉移概率。為平衡同質性和同構性,Node2vec引入2個超參數p和q來控制隨機游走產生的方式,并且定義未歸一化轉移概率為:πvu=αpq(t,x)wvu,wuv為節點u和節點v之間邊的權重,其中

(3)

式中:dtu為節點t和u之間的最短路徑距離。

經過以上轉移概率的預處理,以及有偏置的隨機游走和異步隨機梯度下降優化,Node2vec可以學習得到節點的向量表示。

1.5 模型訓練

在構建了知識圖譜以及完成圖嵌入后,通過多級損失函數來訓練視覺-語義嵌入模型。

圖像特征由深度神經網絡ResNet50的倒數第2層表示,情感標記通過Node2vec表示。全連接層T∈Rd×e將圖像特征投影至語義空間,使得其維數與情感語義節點維數相同,其中d為圖像特征維數,e為情感語義特征維數。

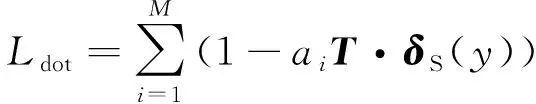

在視覺語義嵌入的研究中,點積相似度是最常用的衡量2個向量相似度的指標。為了在語義空間中將視覺特征與情感相匹配,通常的做法是將負點積相似度[18]作為損失函數來優化模型,其形式為

(4)

式中:ai表示第i個訓練圖片的特征;δS(y)表示與ai相應的情感標記特征。

然而,只對2個向量之間的差異進行懲罰,這樣的約束力較弱。因此設計一個三元組損失函數,實現視覺-情感相似度約束,在減小圖像特征和情感之間差異的同時,使得圖像特征遠離其他不同類別的情感向量。損失函數為

(5)

式中:D(·,·)表示2個向量之間的負點積相似度;[·]+=max(0,·)。δD(y)表示與xi不同的情感向量。m1為固定間隔。

進一步,為了優化視覺向量之間的分布,使用另一個三元組損失函數進行視覺相似度約束

(6)

式中:pi表示與xi類別相同的正示例特征;ni表示與xi類別不同的負示例特征。然而,情感圖像的類內差異可能會很大,同時,類間差異會很小。在通常的三元組損失函數中,間隔對于任何樣本對都是固定的,忽略了上述差異性,故而不能很好地適用于圖像情感問題。因此,利用情感概念設計了一種自適應可變間隔,記為m2=Bvi·Bni。Bvi表示圖像xi對應的檢測概率最高的概念,Bni表示圖像ni對應的檢測概率最高的概念。

最終的損失函數記為:

L=λL1+(1-λ)L2

(7)

式中:0<λ<1為L1和L2之間的平衡參數,將在第3節進行討論。

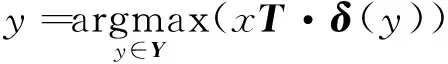

給定一張測試圖片x,通過計算投影視覺向量和每一個情感向量之間的相似度,并通過最鄰近搜索法,預測測試圖片所屬的情感類別

(8)

2 實驗設置

2.1 數據集

本文基于2個情感圖像數據集構建情感知識圖譜,并且評估所提出方法的性能。

You等[19]在Flickr和Instagram上檢索Mikel[20]所提出的8種情感對應的詞語(即:興奮、娛樂、滿足、驚嘆、憤怒、厭惡、悲傷、恐懼),建立了大規模的情感圖像數據集(Flickr&Instagram,即FI)。通過檢索,得到了超過300萬張帶有弱標記的圖片,其中的90 000張圖片由Amazon Mechanical Turk (AMT)進行進一步標注。為了得到更為可靠的圖片標記,5名具有資質的志愿者對每張圖片檢索時使用的情感進行確認,給出“是”或“否”的選擇。最終,23 308張得到了3個以上“是”的圖片得以保留。FI數據集提供了每張圖片的下載鏈接,由于一些鏈接失效,最終下載了22 097張圖片(其中,娛樂4 770張,滿足5 196張,興奮2 753張,驚嘆2 917張,厭惡1 643張,恐懼957張,悲傷2 672張,憤怒1 189張)。Peng等[21]基于Ekman[22]所提出的的6種情感(驚奇、喜悅、厭惡、恐懼、悲傷、憤怒)及其近義詞,在Flickr上進行圖像檢索,得到1 980張圖片(每類情感330張)。Peng等[21]雇傭AMT的工作人員為每張圖片的情感進行投票,通過計數,生成了分布式標記。本研究中,僅使用圖片的原始類別標記。

2.2 圖像檢索評價指標

給定一張待檢索圖片,檢索目標是返回與該圖片情感相同的圖片。

在本研究中,參考文獻[23]中的指標進行檢索,使用測試集中的圖片作為被檢索圖片,返回結果來自于訓練集。2張圖片的情感相似性通過點積相似度來衡量。最鄰近率(nearest neighbor rate,NN)定義為第一個返回的檢索圖像與被檢索圖像屬于同一類的比例,用RNN表示。

第一層級(first tier,FT)和第二層級(second tier,ST)表示前τ個和前2τ個檢索結果的召回率FFT和FST。

式中,nτ和n2τ分別表示前τ個和前2τ個檢索結果中正確的數量。

PmA為平均檢索準確率在多個類別下的均值

(11)

式中,PA(j)為第j類的平均精度。

折扣累計增益(discounted cumulative gain,DCG)是根據位置先后順序,對累計增益(cumulative gain,CG)的加權,用GDC表示。

平均歸一化修正檢索秩(average normalized modified retrieval rank,ANMRR)是一種基于正確圖片在檢索結果中的排序位置的度量指標,其定義為[24]:

(12)

式中:RMR(modified retrieval rank,MRR)為修正檢索秩;K為常數;q為查詢圖像編號;ng(q)代表與查詢圖像類別相同的被檢索圖像集大小;RANMR數值越小,代表性能越好。所有檢索指標的數值范圍都在0和1之間。

2.3 實驗細節

本研究中,圖片的尺寸均調整為224×224像素。圖像的視覺特征從ResNet50提取,同時也研究基于其他常用深度神經網絡模型時的性能。深度模型的初始參數采用在ImageNet[25]上預訓練的參數,并通過本研究提出的方法進行微調。

經過大量觀察和研究,DeepSentibank的檢測結果中,前5個響應概率最高的情感概念能夠較好地描述圖像內容。因此,每張圖片都對應5個情感概念。2個情感圖像數據集均隨機分為80%訓練,5%驗證,15%測試。模型的優化采取隨機梯度下降方法,mini-batch的大小為64,學習率設置為0.001。三元組的選取采用半困難(semi-hard)采樣策略。固定間隔m1設置為0.1。Node2vec節點表示向量為128維。

3 實驗結果與分析

3.1 消融試驗

3.1.1 知識圖譜構建方法

知識圖譜的構建對于準確反映其中節點之間的關系起到重要作用,本小節討論不同的知識圖譜構建方法對分類和檢索性能的影響。

本研究構建的知識圖譜中存在2種節點:情感節點及概念節點。首先,邊的權重通過節點之間的共現頻次進行歸一化來計算。這種方法對應表1中的方法Ⅰ。

表1 不同知識圖譜構建方法對檢索與分類性能的影響

然而,FI數據集中不同類別的圖片數量存在較大差別,擁有較多樣本的類別中,情感與一些概念的關系會得到加強,同時減弱其他類別和相應概念之間的權重。為抑制這種不平衡效應,對FI數據集中情感和概念之間邊的權重乘以平衡系數NM/Ni,Ni(i=1,2,…,8)表示FI數據集中第i類圖像的數量,NM是所有類別中最大的圖片數量(對應表1中方法Ⅱ)。此外,在加入平衡系數的基礎上,為減少概念檢測噪聲的影響,將權重值小于0.05的邊置為0(對應表1中方法Ⅲ)。在該步驟中,僅使用L1對模型進行優化。最終, 基于FI數據集構建的知識圖譜有2 065個節點、10 812個邊,基于Emotion6數據集構建的知識圖譜有2 018個節點和6 045個邊。表1中的實驗結果表明,相比于方法Ⅰ,方法Ⅱ和Ⅲ均使檢索和分類性能得到了提升,并且方法Ⅲ的作用最為明顯。構建良好的知識圖譜可以更準確地反映其中實體之間的關系,在視覺向量投影至語義空間后,會更接近所屬情感以及相應概念的空間位置。同時,對負點積相似度損失函數(Ldot)的性能進行了評估。實驗結果表明,使用Ldot時的性能次于使用L1損失函數時的性能,這證明了L1對視覺向量和情感向量之間施加的約束更為有效。

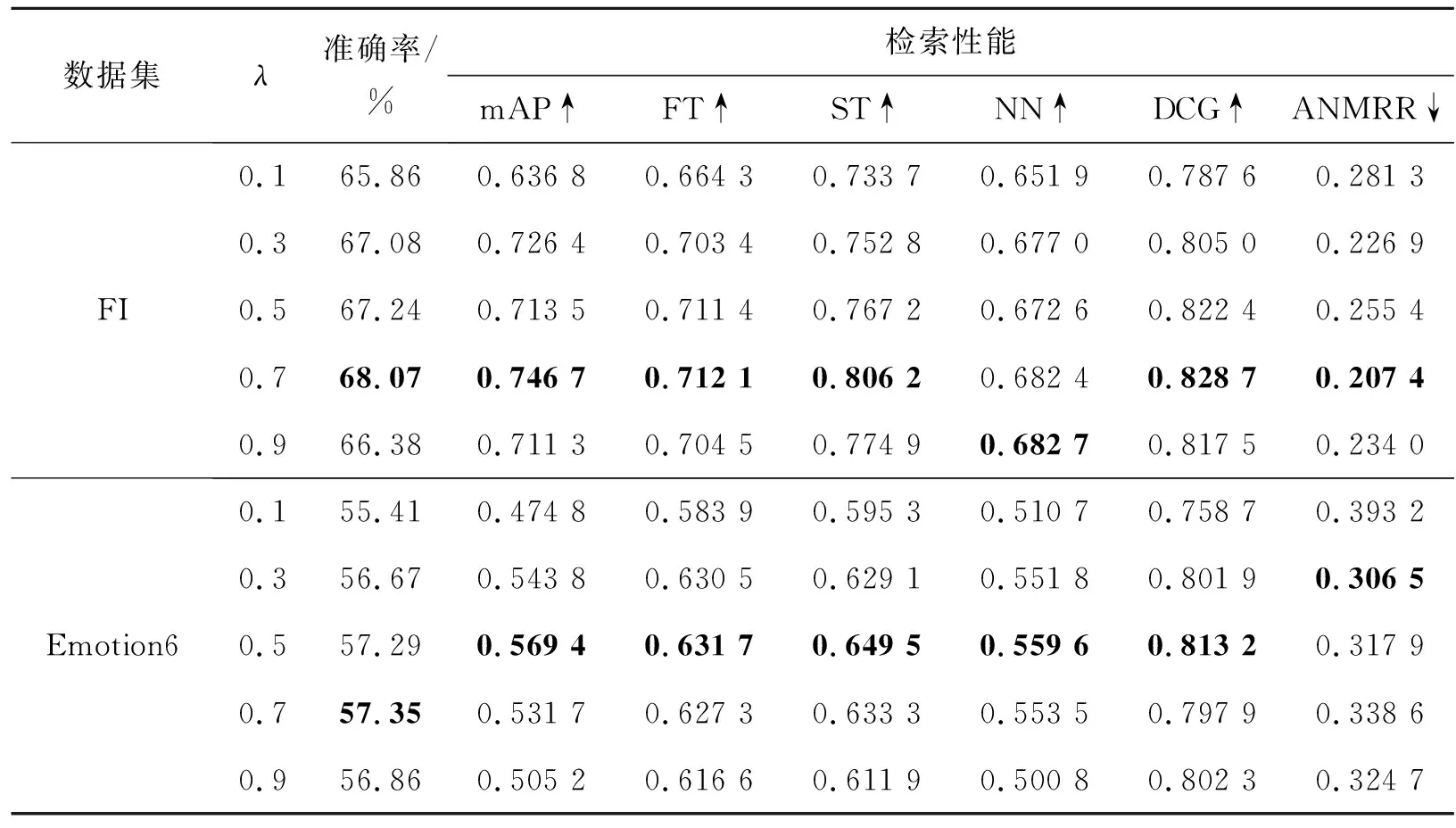

3.1.2 超參數分析

本節研究不同的λ值對模型性能的影響。在損失函數L中,λ平衡L1和L2的關系,λ的值越大,L1的貢獻越大。因為三元組中的視覺投影特征向量依賴于投影層,為使2個損失函數同時發揮作用,λ的值設為0.1~0.9。如表2所示,當λ在0.5~0.7之間時,2個數據集上大部分的指標都達到了最優,并且檢索和分類的性能表現出了相同的變化趨勢。這說明視覺相似度約束與視覺-情感相似度約束之間可以起到互補作用。但是因為L1和L2對于檢索和分類2個任務的貢獻程度存在差異,在個別情況下,使檢索和分類性能達到最優的λ的值不完全一致。同時,過小的λ值,會降低整體損失函數的性能。

表2 不同的λ值下的檢索和分類性能

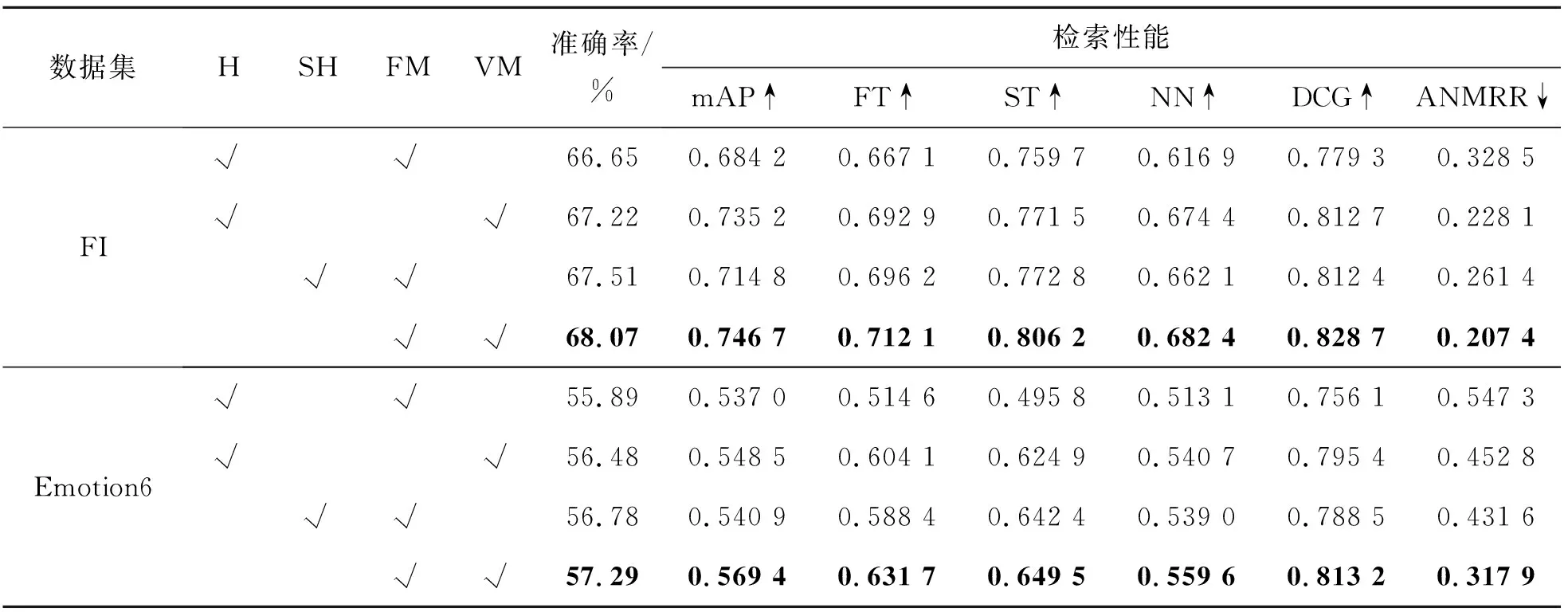

3.1.3 采樣策略和間隔的影響

采樣策略對于三元組的使用有重要影響,本節探討不同采樣策略對性能的影響。首先采用Schroff等[26]提出的半困難采樣(semi-hard sampling)策略,其中負樣本與錨點之間的距離大于正樣本與錨點之間的距離,由于間隔的存在,損失函數此時并不為零。作為對比,同時也使用困難采樣(hard-sampling)策略進行評估。此時,負樣本和錨點之間的距離小于正樣本與錨點之間的距離。研究表明,半困難采樣策略相比較其他方式能夠使模型收斂得更快,不容易陷入局部極小值。同時,為了驗證可變間隔的作用,將L2中的可變間隔設置為0.1進行對比。實驗結果如表3所示,表中“H”、“SH”、“FM”、“VM”分別表示困難采樣策略、半困難采樣策略、固定間隔、自適應可變間隔。從表3可以看出,半困難采樣策略的分類和檢索性能均有所提升。同時,使用自適應間隔時,實驗結果優于使用固定間隔。因為自適應間隔考慮到了不同正負樣本的差異性,能夠對難以區分的樣本對施加更大的懲罰,從而更加有效地進行優化,而固定間隔忽略了不同樣本的差異。

表3 采樣策略和間隔對性能的影響

3.2 與相關研究的對比

為驗證本文提出方法的有效性,在表4中與當前性能較好的優秀方法進行比較。基于情感標記的層級關系,Yang等[9]將普通的的三元組損失函數擴展為一個具有層級結構的三原組損失函數。該損失函數包含兩部分:第一部分使得情感相同的圖片之間的距離小于不同情感類別而又屬于相同情感極性的圖片;第二部分則使得相同情感極性的圖片之間的距離小于不同情感極性之間圖片的距離。Yao等[10]在Yang[9]提出方法的基礎上,提出了可變間隔以替換固定間隔。該方法通過softmax層計算樣本在不同類別上的置信概率,然后對在其他類別上置信度較高的樣本給予更大的懲罰。此外,Yao等[11]基于情感標記的層級關系,提出了一種改進的N-pair損失函數,并基于困難程度自適應地選取負樣本[12]。

從表4中的檢索結果可以看出,本文提出的方法超過了當前多種優秀算法。文獻[9-12]的方法利用情感標記層級結構對標記空間進行約束,得到了相對普通三元組較為細致的標記空間。然而這種約束僅能增強不同情感極性之間的可區分性,卻難以區分相同情感極性的差異。在情感概念的幫助下,本文提出的方法構建了一個高度結構化的標記空間,無論是類間關系還是類內關系,都通過知識圖譜得到了學習。另一方面,L1中三元組中的錨點屬于標記層級,位置是固定的,更有助于圖像向量的聚類。因此,本文方法在圖像檢索指標上超過了現有方法,在圖像分類上同樣表現良好。

表4中也展示了基于其他常用深度模型,AlexNet[27]和VGGNet[28]的實驗結果。從結果可以看出,由于先進的深度模型可以更好表示圖像中的語義信息,因此分類和檢索性能得到了提升。

最后,本文提出的模型經過訓練,包含相同概念的圖像在投影后,在語義空間中會較為接近。而分類和檢索任務都需要通過語義空間中的比較來實現,因此,作為互逆問題,檢索與分類性能在大部分實驗中保持了一致性。為了更直觀地展示模型對圖像的區分能力,在圖3中給出了基于t-SNE[29]的模型輸出向量的可視化結果。每一點代表一個測試圖片的視覺特征(共3 316個點),不同顏色代表不同的情感類別。如圖3所示,可視化圖按照從左到右的順序,可區分度程度依次增加,經過多級損失函數優化的模型,輸出向量聚類性更好。可視化結果直觀地說明了本文方法無論對于相同極性的情感還是不同極性的情感的圖像,模型的輸出特征均具有較高程度的可區分性。

圖3 模型輸出特征可視化

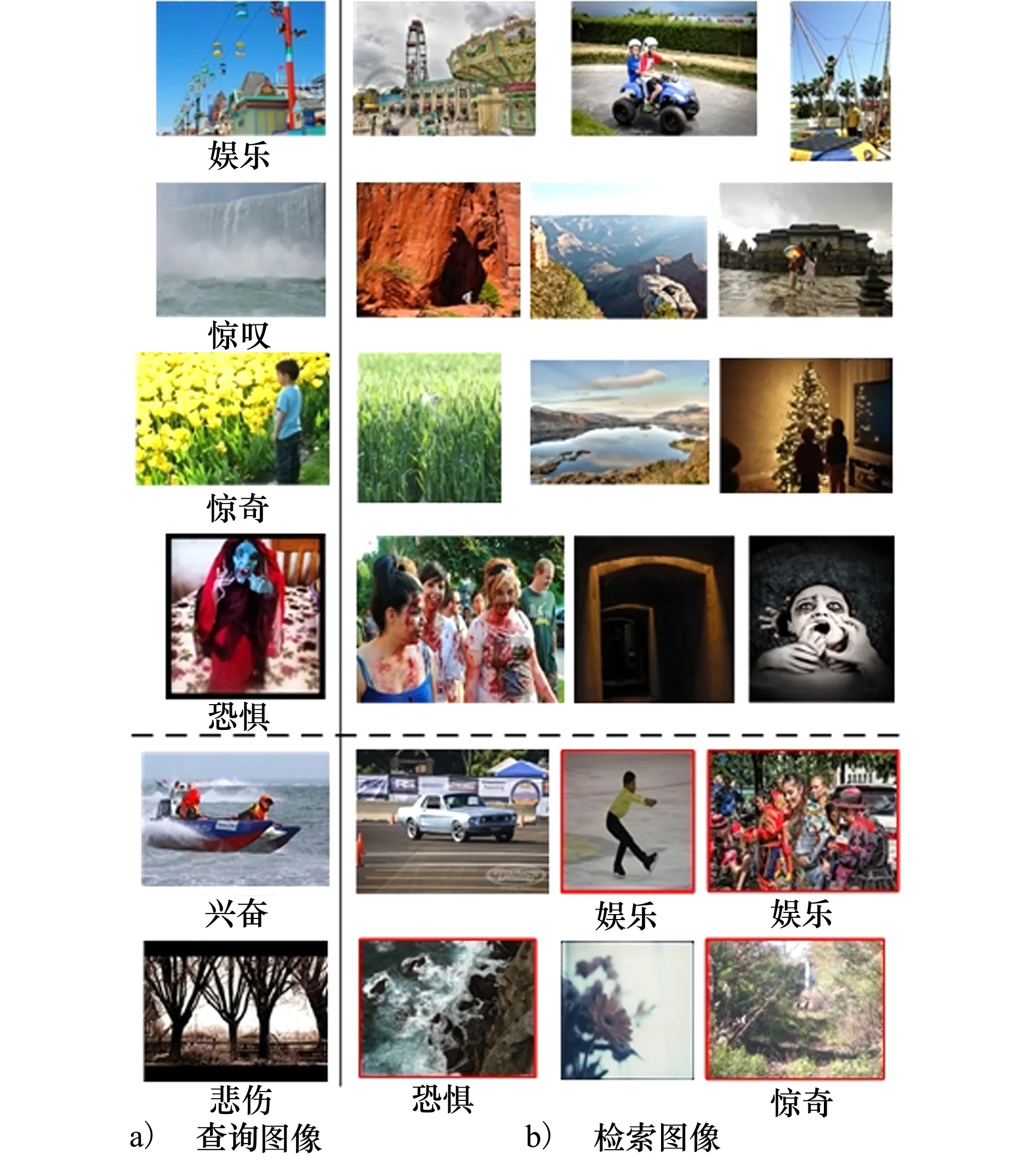

圖4中給出了一些檢索結果的示例。對于被檢索圖像,所提出方法可以明顯地得到類別相同的檢索結果。并且具有一定的語義相關性。圖中的最后2行展示了一些錯誤的檢索示例,比如,代表娛樂的圖片被識別為興奮。由于情感的模糊性,一些場景可能會引發人的多種情感,這時,單一的情感可能不足以充分代表圖像的情感。

圖4 基于本研究提出方法的圖像檢索示例

4 結 論

受到心理學中情感感知機理的啟發,本研究提出利用情感概念作為媒介來解決圖像情感分析中的主觀性和模糊性問題。首先利用知識圖譜建立情感和概念之間的聯系,通過圖表示方法,將知識圖譜中的節點嵌入到低維的語義空間中。采用視覺語義嵌入的框架,在語義空間中對圖像表示和情感進行匹配,從而學習圖像特征和情感之間的關系。此此,提出了一種多級損失函數,從標記層面以及示例層面同時對模型進行優化。通過在多個檢索指標以及分類指標上進行評估,本文方法表現良好,在不同的網絡結構下具有魯棒性。本研究使用的圖片均來自于社交媒體,因此具有具象內容,可以通過語義概念描述。然而,一些藝術作品比如抽象畫同樣可以引發人的情感,卻不包含明顯的物體或場景。因此,對于這類圖片,本研究中使用的概念檢測器不再適用。下一步的研究工作是使得模型能夠分析抽象圖片。