基于混合機制的深度神經網絡壓縮算法

趙旭劍,李杭霖

(西南科技大學 計算機科學與技術學院,四川 綿陽 621010)

0 引言

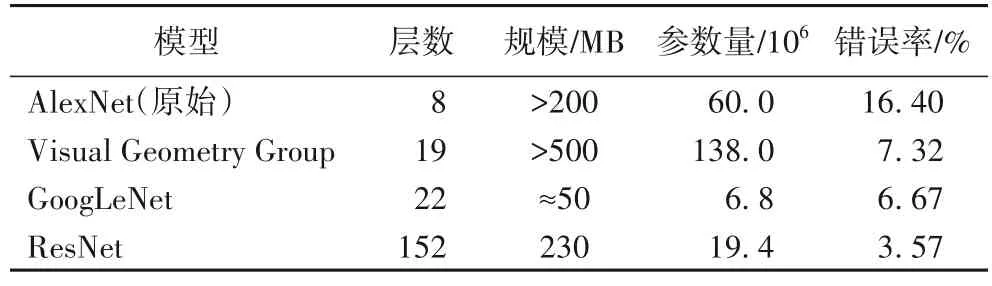

隨著深度神經網絡(Deep Neural Network,DNN)的快速發展和應用,對于深度神經網絡的壓縮需求也愈發強烈。如表1 所示,神經網絡的計算復雜度隨模型復雜度增加而增加,這為DNN 在有限資源設備的部署移植帶來了困難與挑戰。傳統的DNN 中通常含有龐大的參數,這些參數一定程度上代表著模型復雜度,決定模型占有的空間大小,這些參數往往存在冗余[1]。因此,如何減少冗余信息并對深度神經網絡模型進行壓縮的研究具有重要理論意義。

表1 經典神經網絡對比Tab.1 Comparison of classical neural networks

本文針對深度神經網絡因模型存儲空間和計算量大而難移植至嵌入式或移動設備的問題,通過深入分析已有深度神經網絡壓縮算法在占用內存、運行速度及壓縮效果等方面的實驗性能,以mini-ImageNet 數據集為基礎,融合知識蒸餾、結構設計、網絡剪枝和參數量化的壓縮機制,基于AlexNet 建立深度神經網絡壓縮模型,提出一種基于混合機制的深度神經網絡優化壓縮算法。

本文的主要工作如下:

1)系統分析了深度神經網絡壓縮算法影響要素,提出了一個基于AlexNet 的影響要素分析研究框架。

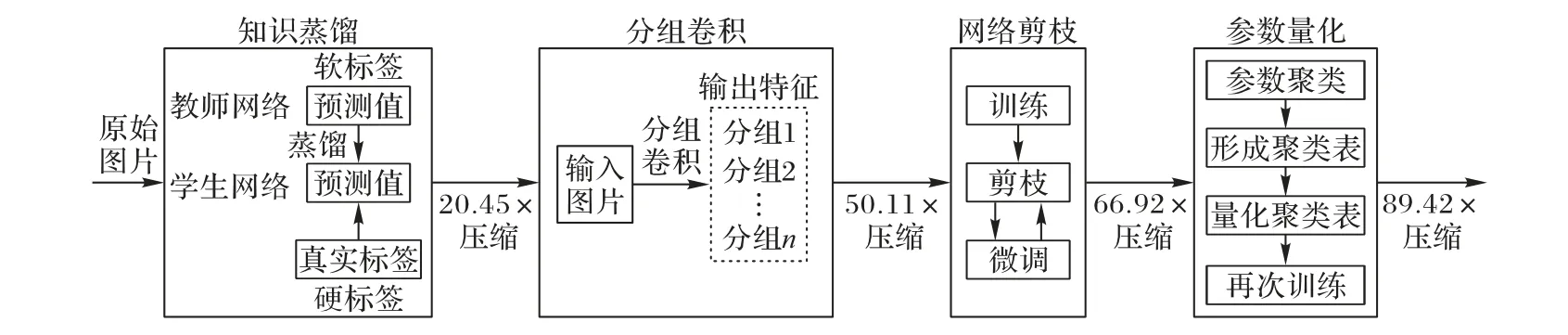

2)提出了一種基于混合機制的深度神經網絡壓縮優化算法。采用知識蒸餾的思路設計學生網絡和教師網絡兩個神經網絡作知識遷移,使學生網絡從教師網絡中學習“知識”,再通過對學生網絡進行結構設計和網絡剪枝的操作來縮小學生網絡的體量大小,并通過參數量化進一步縮小學生網絡體積達到網絡壓縮的效果。

1 相關工作

隨著深度學習的快速發展,對DNN 的計算量需求也越來越大,這無疑加速了對DNN 壓縮算法的研究,于是網絡剪枝、知識蒸餾、參數量化、結構設計等壓縮算法相繼出現。

網絡剪枝[2]是為壓縮深度神經網絡而提出的刪除權重張量中冗余參數的算法。早在20 世紀90 年代,LeCun 等[3]就提出了網絡剪枝的概念,主要步驟包括預訓練、剪枝和微調。網絡剪枝的壓縮算法有多種實現方法,Wang 等[4]提出從零開始剪枝(prune from scratch)的方法并在CIFAR10 和ImageNet 數據集上進行驗證,該方法在進行網絡剪枝前隨機初始化權重以獲得多樣化的剪枝結構,甚至能夠獲得性能更優的模型;Dong 等[5]提出將神經網絡結構搜索直接應用于具有彈性通道和層尺寸的網絡,通過最小化剪枝后網絡的損失來減少通道數;Chen 等[6]提出為每個卷積層引入一個顯著性剪枝模塊(Saliency-and-Pruning Module,SPM),SPM 需要先學習并預測顯著性分數,然后將其應用剪枝到每個通道,這種自適應網絡剪枝方法能夠降低卷積神經網絡(Convolutional Neural Network,CNN)的計算量;Wen 等[7]對剪枝權重與神經元的選擇作對比分析,在準確率不受影響的條件下,得出結果為:對權重剪枝會導致剩余神經元接受不同數量的輸入,利用不同GPU 進行加速的效果均不理想,稀疏剪枝實際上是令神經網絡中的矩陣更稀疏,通過不同方法使某些神經元失活,但實際上內存的占用并未減少。

Hinton 等[8]首次提出知識蒸餾的概念,通過引入與教師網絡相關的軟目標來促進學生網絡訓練,達到知識遷移的目的,使學生網絡能學習來自教師網絡的隱藏信息。由于深度神經網絡的網絡層數較多,且每層含有較多網絡參數,Romero 等[9]提出使用回歸模塊來配準部分學生網絡和部分教師網絡的輸出特征,并對輸出特征進行相應處理,將網絡處理的重點放在特征層以更高效地進行知識蒸餾,知識蒸餾往往需要先預訓練教師模型,再通過蒸餾將知識傳遞給學生模型,該訓練過程會帶來運行速度的減慢。

參數量化的實現方法很多,它的中心思想是令多個參數共享取值。Vanhoucke 等[10]和Hwang 等[11]通過fixed-point 降低參數精度,令取值相近的參數共享一個數值。Chen 等[12]提出利用哈希桶的方式壓縮神經網絡,將神經網絡的權值隨機劃分到多個哈希桶,其中同一哈希桶內共享同一參數以實現神經網絡的壓縮。之后,他們在此基礎上又提出一種新網絡FreshNets(Frequency-sensitive hashed Nets)[13],將網絡卷積核變換到頻率域并在頻率域進行隨機哈希,對重要性低的高頻部分使用更低的哈希位數表示,以實現更高壓縮。Gong等[14]通過K-means 聚類算法對參數進行聚類操作,每簇參數共享中心值以達到壓縮神經網絡的目的。

調整神經網絡架構可以只需要比較少的參數達到壓縮神經網絡的目的,該類方法統稱為結構設計。深度可分離卷積是其中一個至關重要的理論,基于此衍生出各式各樣的網絡。Iandola 等[15]提出一種小網絡SqueezeNet,在達到AlexNet精度的情況下,只需要AlexNet 中50%的參數。Howard 等[16]提出基于移動端和嵌入式視覺應用的MobileNets 模型,使用深度可分離卷積構建輕量級DNN,結果表明MobileNets 在ImageNet 分類問題上有極佳的性能。Zhang 等[17]為了避免分組卷積帶來副作用,設計允許更多通道數的ShuffleNet,使用通道打亂操作來幫助信息在不同的通道間流動,利于編碼更多信息。

總而言之,現有的經典神經網絡壓縮算法在內存占用、運行速度及壓縮效果的實驗性能上各有優劣。針對以上問題,本文首先系統分析DNN 壓縮算法的影響要素,并提出一種基于混合機制的深度神經網絡優化算法提升壓縮效率,為深度神經網絡在有限資源環境下的移動部署提供可行的解決方案。

2 深度神經網絡壓縮算法的影響要素

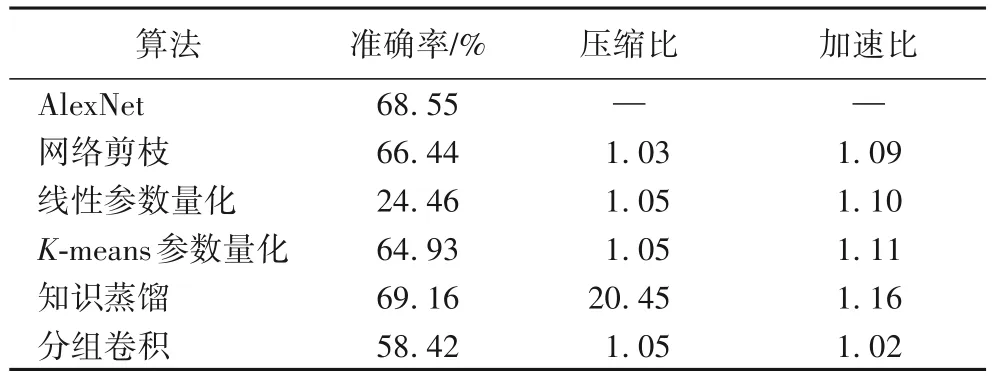

本文基于AlexNet,在mini-ImageNet 數據集上,綜合考慮壓縮算法的結構屬性和功能屬性,對網絡剪枝、線性參數量化、基于K-means 的聚類參數量化、知識蒸餾以及分組卷積五種神經網絡壓縮算法進行性能評測,并從準確率、壓縮比和加速比三個指標進行分析。對比結果如表2 所示。

表2 不同壓縮算法對AlexNet的壓縮結果對比Tab.2 Compression results of different compression algorithms on AlexNet

在進行網絡剪枝操作時,首先訓練未剪枝的神經網絡,設置刪減閾值為0.5,通過fine-tune 將剪枝后的模型重新在訓練集上訓練,以減少網絡剪枝帶來的損失。若剪枝后網絡的準確率變化在5%以內,則結束剪枝操作;反之繼續剪枝。經過網絡剪枝壓縮的神經網絡壓縮比為1.03,準確率小幅下降,運行速度和壓縮程度得到了小幅優化。

線性參數量化和K-means 參數量化都將卷積層參數壓縮至4 b,雖然壓縮比與加速比相差不大,但線性參數量化會導致準確率過低。因此,本文的混合機制在進行組合時選擇K-means 參數量化算法。

知識蒸餾的學生網絡構造相對簡單,主要由3 個卷積層和1 個全連接層構成。從表3 可以看出,經過知識蒸餾后,網絡的準確率相較于原始AlexNet 提高了0.61 個百分點,壓縮比達到了20.45,加速比也較其他經典算法表現更出色。同時,可以看出,通過分組卷積調整神經網絡結構后,網絡的壓縮比和加速比也有小幅提升。

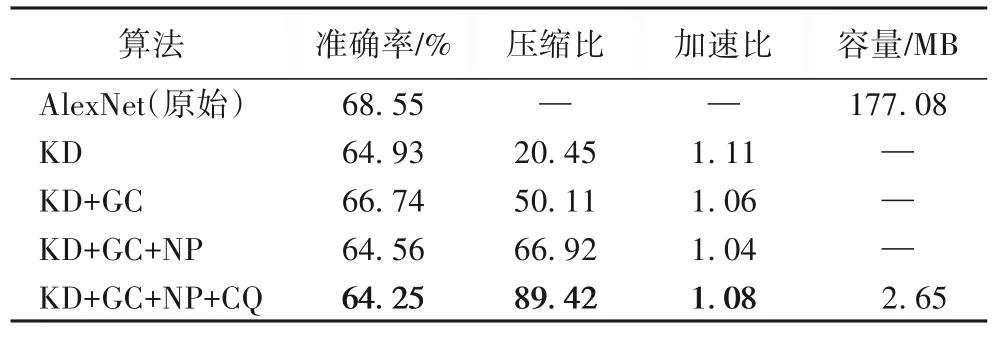

表3 壓縮算法實驗結果Tab.3 Experimental results of compression algorithms

知識蒸餾通過模型轉換將知識遷移到緊湊的模型上,顯著提升了壓縮性能,說明模型全局(結構)層面的優化對算法具有積極影響。同時,從局部(參數)的角度來看:網絡剪枝與分組卷積分別采用參數去繁與參數簡化的方法實現末端(參數)的功能優化,提高了算法壓縮性能;而參數量化則令多個參數共享數值,使用K-means 參數量化能優化模型的運行速度和空間占用。因此,本文設計了一種融合壓縮算法結構與功能特征,自全局向局部優化的神經網絡壓縮機制。

3 基于混合機制的DNN壓縮優化算法

3.1 優化算法模型構建

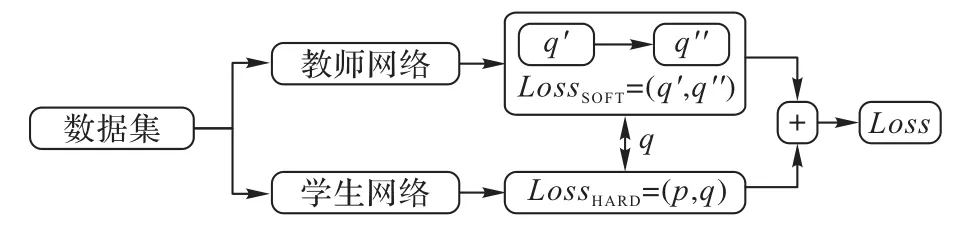

本文采用知識蒸餾設計一個體量較小的學生網絡和基于AlexNet 的教師網絡作知識遷移,使學生網絡從教師網絡中學習教師網絡學到的“知識”,再通過結構設計、網絡剪枝縮小學生網絡的體量大小,并通過參數量化進一步縮小學生網絡。本文算法主要的模型結構如圖1 所示。

圖1 本文算法的模型結構Fig.1 Model structure of the proposed algorithm

3.2 教師網絡和學生網絡的構建

本文首先基于知識蒸餾壓縮算法建立教師網絡和學生網絡兩個神經網絡,其中教師網絡結構與AlexNet 結構一致,學生網絡為3 層卷積層與1 層全連接層簡單組合而成的網絡。利用這兩個網絡進行知識遷移,其中教師網絡為“知識”輸出者,學生網絡為“知識”接受者,將學生網絡的訓練結果與正確標簽比對,用式(1)求得cross-entropy 并最小化它的值:

其中:H(A,B)是神經網絡A和神經網絡B的交叉熵;xi是樣本標簽;PA(xi)是神經網絡A判斷結果為樣本xi的概率;PB(xi)是神經網絡B判斷結果為樣本xi的概率。

知識蒸餾過程可以大致劃分為兩個階段,如圖2 所示:第一階段是訓練相對復雜或由多個模型集成的教師網絡;第二階段是訓練學生網絡,它是參數量較小、結構相對簡單的模型。損失函數用式(2)表示,主要由教師網絡訓練結果經蒸餾后與學生網絡訓練結果的損失LossSOFT(q,q″)和學生網絡訓練結果與標簽的損失LossHARD(p,q)組合而成。

圖2 知識蒸餾流程Fig.2 Process of knowledge distillation

其中:p為樣本標簽;q為學生網絡訓練結果;q″為教師網絡經蒸餾后的訓練結果。

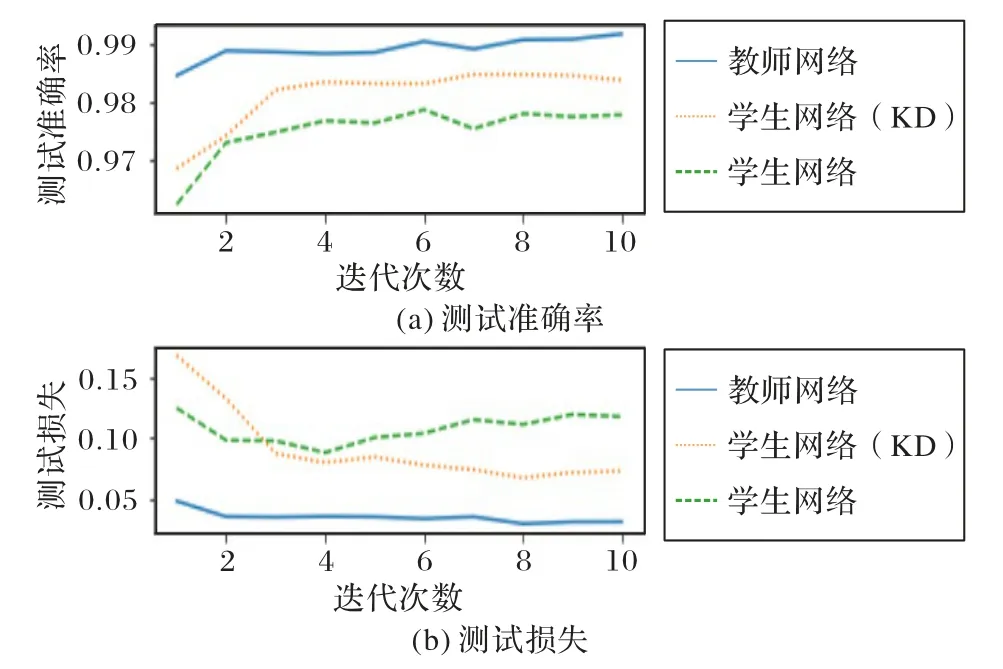

學生網絡和教師網絡對于任何輸入都能獲得輸出,輸出經過Softmax 映射后同樣能輸出對應類別的概率值。與普通Softmax 層不同,知識蒸餾的Softmax 層用式(3)表示,需要添加溫度參數,避免輸出變為one-hot 形式而損失教師網絡所攜帶的隱藏信息。其中:yi為輸出結果;xi為第i個輸入;xj為遍歷所有輸入;T為溫度參數。經過知識蒸餾的神經網絡效果對比如圖3 所示,雖然經過知識蒸餾(Knowledge Distillation,KD)的學生網絡(KD)仍不如教師網絡,但在測試集上的損失和準確率都優于未經過知識蒸餾的學生網絡。

圖3 經過知識蒸餾的神經網絡的結果對比Fig.3 Comparison of results of neural networks after knowledge distillation

3.3 學生網絡的結構設計

完成知識蒸餾后,學生網絡已經學習到教師網絡所學過的“知識”,其中還包含帶有隱藏信息的“暗知識”。此時對學生網絡進行結構設計,使它只需要比較少的參數,就能夠進一步壓縮深度神經網絡的空間大小。

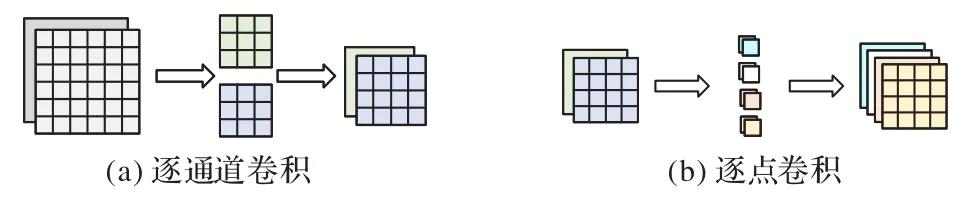

利用深度可分離卷積對卷積神經網絡進行結構設計,該方法一般分為逐通道卷積和逐點卷積兩個步驟,如圖4 所示。其中逐通道卷積過程是將卷積核設為平面,設置卷積核數量與輸入通道數相等;逐點卷積過程則是將不同卷積核處理的數據連接起來。處理上一步的輸出特征圖,將新卷積核大小設置為1 × 1 的通道數以得到新輸出。此方法能明顯減少參數量。設輸入通道數為I,輸出通道數為O,卷積核大小為K×K,此時參數量減少至這樣做之所以能減少參數數量,是相當于在逐通道卷積的過程中共享了參數。

圖4 深度可分離卷積Fig.4 Depthwise separable convolution

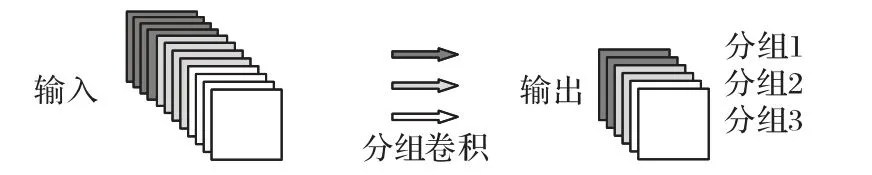

由于后續還需對學生網絡進行網絡剪枝,而對卷積層使用深度可分離卷積的方式會對剪枝結果產生較大影響,所以本文采用原理類似的分組卷積予以替換。分組卷積原理如圖5 所示,分組卷積輸出特征圖的每個通道只與輸入特征圖的部分通道有關,這部分通道即為組。設輸入通道數為I,輸出通道數為O,卷積核大小為K×K,分為N組,則每一組的輸出通道數為,只需要將各分組的計算結果按照通道連接即可,用此方法的參數量為,一定程度上減少了卷積所需參數量。

圖5 分組卷積Fig.5 Group convolution

3.4 學生網絡的網絡剪枝

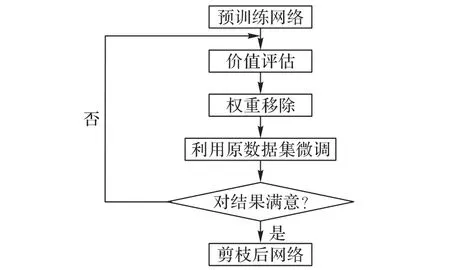

對學生網絡進行網絡剪枝操作能進一步縮小學生網絡的大小,網絡剪枝本質是移除深度神經網絡中的冗余參數。本文主要以權重為剪枝單元實現非結構化剪枝,對學生網絡的網絡剪枝流程如圖6 所示。

圖6 網絡剪枝流程Fig.6 Flow of network pruning

首先訓練未剪枝的學生網絡;其次利用式(4)和式(5)計算L1、L2的取值,移除取值在設定閾值以外的權重;再利用原數據集對剪枝后的學生網絡進行訓練微調,以減少剪枝所帶來的損失;最后判斷剪枝后的網絡準確率變化是否在5%范圍內浮動,若是則結束算法,否則進行二次剪枝。

其中:yi為第i個樣本標簽;為第i個輸出數據;m為樣本數。

3.5 學生網絡的參數量化

完成知識蒸餾、結構設計、網絡剪枝后,對學生網絡進行參數量化操作進一步壓縮DNN。參數量化有許多不同實現方式:如利用K-means 等算法對神經網絡的權重進行類別分簇;也可以將出現頻率高的簇用低比特代替,將頻率出現低的用高比特代替,如此能減少存儲空間,如Huffman encoding算法。

本文主要實現線性量化和基于K-means 的非線性量化兩種參數量化方法。線性量化計算便捷,如式(6)所示,設A和W都是類型為float32 的浮點數,將A和W分別量化為int8類型的AQ和WQ后進行計算,能顯著提高運算速率,但量化后的AQ和WQ在一定程度上存在損失,a,b,c,d為常數。

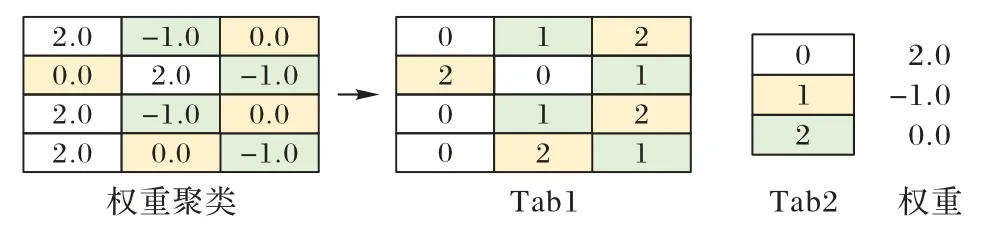

基于K-means 的非線性參數量化過程如圖7 所示,對學生網絡中的權重進行K-means 聚類操作,將同一類別下的權重賦值為該類別的均值,分簇后只需要一個存儲類別的Tab1 和一個存儲類別與權重映射關系的Tab2 即可表示權重,能夠有效地減小所需存儲空間。

圖7 基于K-means的參數量化設計Fig.7 Parameter quantization design based on K-means

4 實驗與結果分析

4.1 實驗數據集

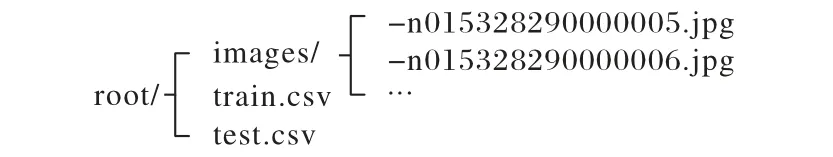

實驗采用mini-ImageNet 數據集(https://lyy.mpi-inf.mpg.de/mtl/download/Lmzjm9tX.html)。mini-ImageNet 數據集在元學習和小樣本學習領域應用廣泛,是ImageNet 數據集的子集。

ImageNet 數據集是一個非常龐大的數據庫,主要用于對視覺識別的研究。ImageNet 數據集為超過1 400 萬張圖像標記注釋,并給100 萬張以上的圖像提供了邊框,ImageNet 數據集中包含“氣球”“輪胎”等20 000 多個類別數據,且每個類別均有不少于500 張圖像。訓練如此龐大的數據集需要消耗大量計算資源,因此,2016 年GoogLe DeepMind 團隊在ImageNet 的基礎上提取出了它的子集mini-ImageNet。

DeepMind 團隊首次將mini-ImageNet 數據集用于小樣本學習研究,mini-ImageNet 數據集自此成為了元學習和小樣本領域的基準數據集。mini-ImageNet 數據集內共包含100 個類別,共60 000 張圖片,其中每類有600 個樣本,每張圖片的規格大小為84×84,圖片均為RGB 三通道彩色圖片。相較于CIFAR10 數據集,雖然mini-ImageNet 數據集更加復雜,但更適合進行原型設計和實驗研究。mini-ImageNet 的容量大小為2.86 GB,數據架構如圖8 所示,其中images 里為所有的圖片樣本,train.csv、test.csv 文件內均含兩列數據,第1 列為文件名,第2 列為標簽。

圖8 mini-ImageNet的數據架構Fig.8 Data architecture of mini-ImageNet

4.2 數據預處理

首先對數據集進行劃分。如果按照給定的訓練集和測試集進行劃分,即將100 個類別數據按照類別劃分給三個數據集,這并不契合本文的實驗需求,因此,首先將所有照片提取出來,通過train.csv 和test.csv 將照片保存到對應標簽的文件夾下,即將100 類數據保存到100 個文件夾中,文件夾名為類別名。將數據按照6∶2∶2 的比例劃分為訓練集、驗證集和測試集,三個數據集內均有100 個類別,數據集中每個類別的樣本數為劃分好的6∶2∶2。數據示例如圖9 所示。

圖9 數據示例Fig.9 Examples of data

對mini-ImageNet 數據集中的每個樣本進行預處理。與MNIST 手寫數據集不同,mini-ImageNet 是從原始ImageNet 數據集中選擇的一小部分子集,每個子集包含來自不同類別的圖像,這些圖像可能具有不同的尺寸和寬高比。在使用mini-ImageNet 進行訓練和評估時,通常會將所有圖像調整為相同的大小,以便于輸入到模型中。由于本文主要基于AlexNet 設計算法實驗,故統一將圖片隨機裁剪到224×224 的像素大小,并進行隨機水平翻轉以達到數據增強的效果,減少過度擬合并提高模型的泛化能力。

4.3 評測標準

實驗過程的壓縮比Cr和加速比Sr主要效仿失真率而來,利用式(7)和式(8)進行計算。準確率Ar則利用式(9)計算。

其中:M為原模型,M'為經壓縮后的模型;λ為原模型占用存儲大小,λ?為經壓縮后模型占用存儲大小;γ為運行原模型耗時,γ?為運行經壓縮后模型耗時;α為所有預測正確的樣本數,α?為總樣本數量。

4.4 實驗設計

為了更充分地比較和分析本文算法與已有方法的實驗性能,本文的實驗設計分為兩個步驟:AlexNet 訓練與壓縮算法性能評測,以實現Benchmark 性能分析。具體過程如下。

1)AlexNet 訓練。將mini-ImageNet 數據集按照6∶2∶2 劃分為訓練集、測試集和驗證集進行實驗,通過驗證集調整選擇在訓練集得到的最優的結果并應用于測試集,須在訓練前對圖片統一進行裁剪。經迭代訓練得到本文實驗的Benchmark 算法。

2)壓縮算法性能評測。基于AlexNet 對不同深度神經網絡壓縮算法及組合算法進行算法性能評測。本文主要考慮了網絡剪枝、線性參數量化、基于K-means 的聚類參數量化、知識蒸餾以及分組卷積5 種神經網絡壓縮算法的組合方法進行實驗。

4.5 實驗比較與分析

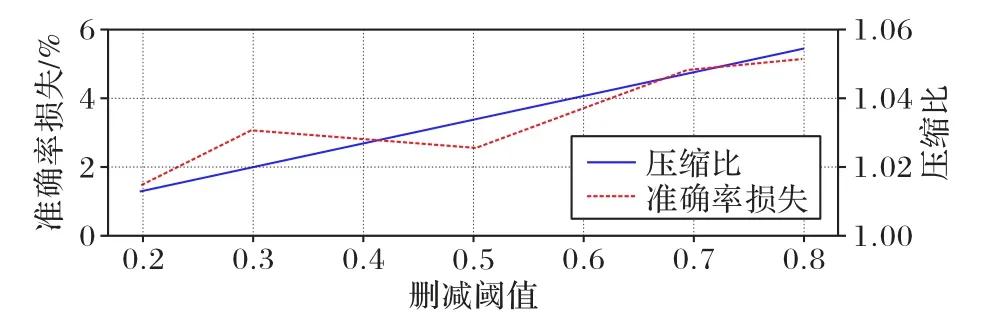

基于以上分析設計,本文基于AlexNet 在mini-ImageNet數據集上進行了實驗比較與分析。實驗結果如表3 所示,其中:GC(Group Convolution)代表分組卷積,NP(Network Pruning)代表網絡剪枝,CQ(Clustering Quantization)代表聚類量化,LQ(Linear Quantization)代表線性量化,KD 代表知識蒸餾。實驗結果表明,本文算法(KD+GC+NP+CQ)在壓縮后的準確率只降低了6.3%的情況下,壓縮后AlexNet 的容量減小了98.5%,壓縮性能較優。在準確率損失不嚴重的情況下,壓縮比隨著組合壓縮算法復雜度上升而增大,其中知識蒸餾顯著壓縮了神經網絡模型,且對加速比的提升有較大優化,分組卷積和網絡剪枝的加入很大程度上縮小了模型存儲空間,最后對模型進行基于K-means 的聚類參數量化操作,進一步壓縮加速模型。圖10 展示了AlexNet 在進行網絡剪枝時,在不同刪減閾值下的準確率損失與壓縮比變化趨勢。

圖10 不同刪減閾值情況下的實驗結果比較Fig.10 Comparison of experimental results under different deletion thresholds

分析可知,隨著刪減閾值不斷增大,壓縮比和準確率損失總體呈上升趨勢,當刪減閾值為0.5 時出現一個轉折點,此時是最佳刪減閾值。從理論上而言,在進行網絡剪枝時,所刪減的網絡連接會隨著刪減閾值的增大而變多,從而使參數的稀疏矩陣中為零的值隨之增多,達到減小存儲空間的效果。AlexNet 的存儲占用隨著刪減閾值的增加而減小,與理論相同。在經過最佳閾值點0.5 后,AlexNet 在(0.5,0.7]的閾值區間內準確率損失增長速率顯著,說明此時神經網絡中重要程度高的連接比較多,而重要程度低的連接比較少。

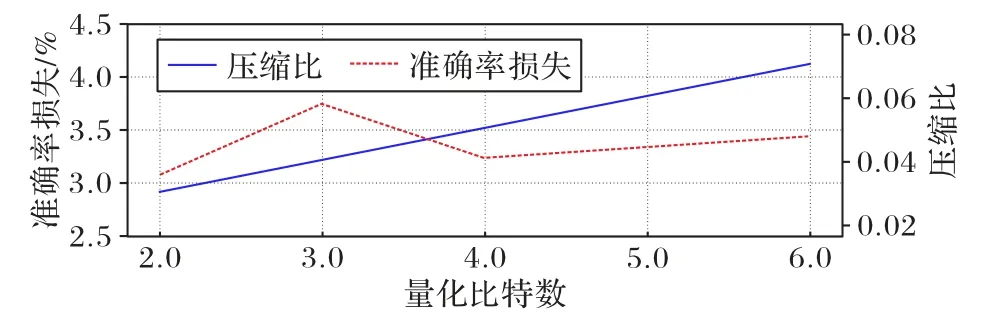

圖11 展示了AlexNet 量化為不同比特條件下的準確率損失與壓縮比變化趨勢。因為在進行K-means 聚類之前是利用隨機中心點初始化的,本文選取3 次實驗結果的平均值進行分析以避免實驗偶然性。

圖11 不同量化比特數情況下的實驗結果比較Fig.11 Comparison of experimental results under different quantization bit numbers

分析可知,模型的準確率損失首先隨著量化比特數增加而上升,在4 b 時出現明顯轉折點,隨后呈現緩慢上升趨勢。當量化模型參數為4 b(聚類簇數為16)時準確率損失最小。理論上,在執行參數量化對神經網絡進行壓縮時,量化比特數越大,占用的存儲空間也越少。如圖11 所示,AlexNet 的壓縮比隨著量化比特數上升而穩步上升,與理論結論一致。

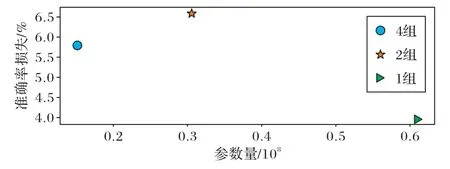

圖12 展示了AlexNet 在不同分組條件下的準確率損失情況。對AlexNet 使用1、2、4 組不同數量分組進行訓練,分析可知,當劃分分組數量為2 時,雖然在一定程度上減少了模型參數,但準確率損失比較嚴重;當劃分分組為4 時,能更大程度壓縮模型的同時減小準確率損失,也就是保證準確率并減小模型參數存儲空間。理論上而言,分組卷積能帶來的模型效果要優于標準的卷積網絡,因為分組卷積類似于正則所帶來的效果,能夠減少訓練參數的同時增加相鄰層之間對角相關性,避免過擬合的現象發生。分析可知,AlexNet 的準確率隨分組的數目呈現先減小再增加的趨勢,故劃分組別為4 能帶來更好的壓縮效果。

圖12 不同分組情況下的準確率損失對比Fig.12 Comparison of accuracy loss under different grouping conditions

5 結語

本文針對深度神經網絡因模型存儲和計算量大而難移植至嵌入式或移動設備的問題,系統分析了深度神經網絡壓縮算法影響要素,提出了一個基于AlexNet 的影響要素分析研究框架;在此基礎上,提出了一種融合知識蒸餾、結構設計、網絡剪枝和參數量化的混合機制的深度神經網絡優化壓縮算法。實驗結果表明,在準確率降低了6.3%的條件下,存儲量壓縮比達到了89.42,加速比達到了1.08,為深度神經網絡在移動設備等有限資源條件下的移動和部署提供了更大的可能性。