融合卷積神經網絡的遙感圖像全色銳化

路琨婷,費蓉蓉,張選德

(陜西科技大學 電子信息與人工智能學院,西安 710021)

0 引言

近年來,遙感圖像被廣泛應用于科學研究、精準農業、礦產探測、國土普查、城市規劃、地震預報、軍事防御等領域[1]。然而,由于物理設備的限制,直接從衛星遙感器獲取到的圖像僅僅有兩種:低空間分辨率多光譜(Low-Resolution Multi-Spectral,LRMS)圖像和高空間分辨率(High-Resolution,HR)全色(PANchromatic,PAN)圖像。前者分辨率較低但擁有豐富的光譜信息,后者分辨率較高但含有的光譜信息較少。

全色銳化通常利用較高空間分辨率的PAN 圖像對較低空間分辨率的多光譜(Multi-Spectral,MS)圖像進行銳化,從而獲得高空間分辨率多光譜(High-Resolution Multi-Spectral,HRMS)圖像。解決全色銳化問題的方法分為傳統方法和基于深度學習的方法兩大類。傳統方法包括成分替換(Component Substitution,CS)、多分辨率分析(Multi-Resolution Analysis,MRA)以及基于模型的方法。

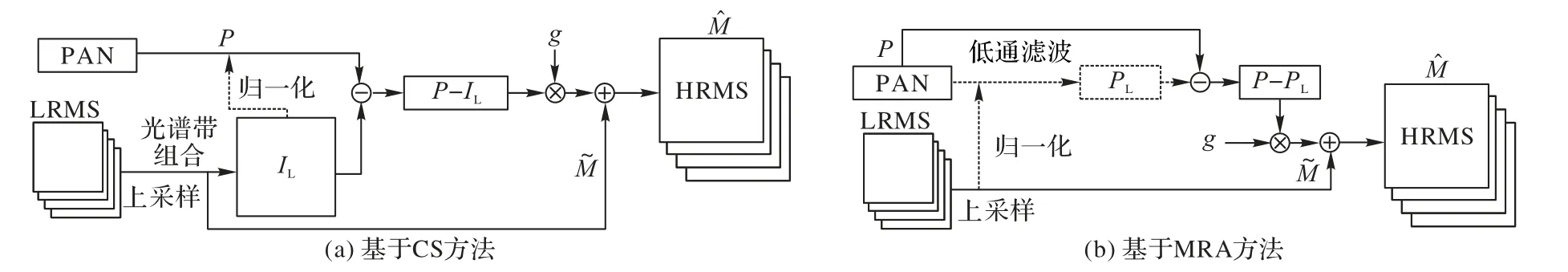

CS 方法首先對LRMS 圖像上采樣后作適當的域變換,使表示頻譜和空間的信息完全分離并用不同的分量表達;然后利用擁有更多空間信息的PAN 圖像替換分離的空間分量;最后使用上述變換的逆變換將替換后的圖像變換回原域得到HRMS 圖像。CS 方法使用的變換包括亮度-色度-飽和度(Intensity-Hue-Saturation,IHS)變換[2]、主成分分析(Principal Component Analysis,PCA)變換、Gram-Schmid(tGS)變換[3]等,能展現清晰的空間結構,但存在一定的光譜失真。

MRA 方法假定可以通過PAN 圖像的高頻空間分量補充LRMS 圖像的空間細節:利用低通濾波器獲取PAN 圖像的高頻信息,然后將它注入MS 圖像中得到HRMS 圖像。常見的MRA 方法有抽取小波變換(Decimated Wavelet Transform,DWT)、非抽取小波變換(UnDecimated Wavelet Transform,UDWT)以及拉普拉斯金字塔(Laplacian Pyramid,LP)[4]等。MRA 方法最大限度地保留了LRMS 圖像的光譜信息,但由于濾波的使用導致HRMS 圖像會出現一定的空間失真。

隨著稀疏表示算法和貝葉斯(Bayesian)框架的快速發展,基于模型的方法已被廣泛應用于各種圖形圖像處理任務并取得顯著效果。基于模型的方法將全色銳化看作圖像重建的過程,利用各種先驗信息建立統計模型。常見的基于模型的方法有壓縮感知(Compressed Sensing)、貝葉斯、變分優化(Variational Optimization)等。這類方法的光譜和空間細節失真相對較低,但對先驗信息的要求較高。

近幾年,基于深度學習的全色銳化方法產生的HRMS 圖像性能明顯優于傳統方法。Masi 等[5]首先將卷積神經網絡(Convolutional Neural Network,CNN)應用于全色銳化并提出PNN(CNN based Pansharpening);Wei 等[6]引入殘差學習提出一個具有11 個可學習層的深度殘差網絡(Residual Network,ResNet),在全色銳化問題中充分利用深度學習模型的高度非線性性質;Yang 等[7]提出的PanNet 由10 個堆疊的殘差塊組成,旨在解決全色銳化的兩個基本問題,即光譜信息和空間信息保存;Yuan 等[8]設計的多尺度多深度的CNN(Multi-Scale and multi-Depth CNN,MSDCNN)模型擁有兩個不同的可學習層數分支,性能優異;Fu 等[9]使用分組的多尺度擴張網絡(Deep Multiscale Detail Network,DMDNet)擴大感受野,多尺度結構能夠融合不同尺度的空間信息以進一步提升融合效果;Zhang 等[10]建立圖像間的非線性梯度變換關系來約束空間結構,使網絡對融合結果圖像中含有的空間結構具有更強的合理性解釋。除上述監督學習框架外,無監督學習框架也發展迅速:Wang 等[11]提出多尺度密集生成器網絡來提取特征,采用兩個鑒別器分別保護光譜和空間信息;Zhou等[12]設計雙流生成器從MS 圖像和PAN 圖像中提取模態特定特征來提升性能。

傳統的CS 和MRA 方法易于解釋但效果在光譜保真和空間細節信息增強兩方面各有側重,得到的HRMS 圖像質量各有利弊。此外,CS 和MRA 方法的一個很大的局限性是使用的線性注入模型通常不考慮用于全色銳化傳感器的相對光譜響應。目前大多數全色銳化網絡雖然能實現較好的融合效果,但缺乏如傳統CS 和MRA 方法對模型和算法的直觀解釋,對原圖像的開發利用不足,特征信息提取不夠充分,對特征圖的各個通道平等看待造成了光譜和空間信息的部分損失,在一定程度上阻礙了融合性能。

為解決上述問題,本文結合傳統方法與深度學習方法構建融合效果良好的全色銳化方法CMRNet,以提高融合圖像的光譜和空間分辨率。本文的主要工作如下:

1)聚合CS 和MRA 的思想,并結合CNN 實現非線性,克服傳統方法線性注入模型的局限性,改善深度學習全色銳化方法的性能。

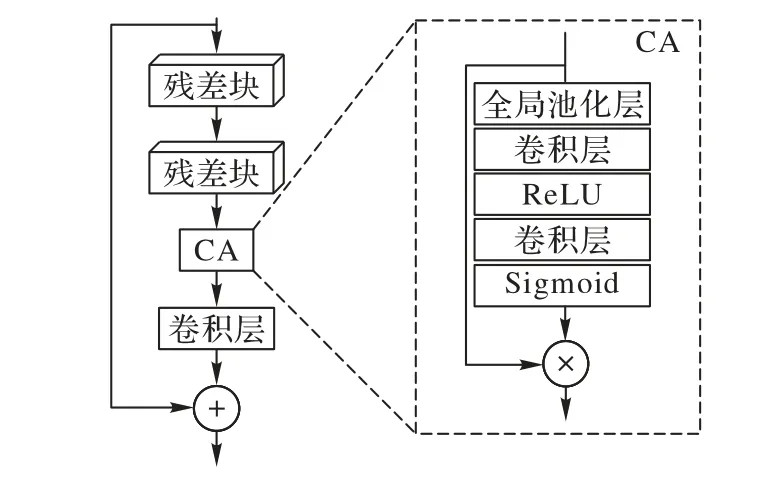

2)設計殘差通道(Residual Channel,RC)塊以充分提取光譜和空間信息,實現多尺度特征信息的融合提取,并引入通道注意力(Channel Attention,CA)[13]學習通道間的依賴關系使網絡更關注重要的特征信息。

1 相關工作

1.1 基于CS的全色銳化方法

CS 方法基于PAN 圖像對單一分量進行簡單替換,這些強度分量通常通過MS 圖像光譜帶的線性組合獲得。首先通過PAN 圖像與強度分量的差值提取PAN 圖像的高空間結構信息,再通過適當的注入方案將提取的高空間結構信息注入MS 圖像。Tu 等[14]證明基于CS 的方法可推廣到一種新的形式化,隨后Dou 等[15]進一步擴展,提出了通用的CS 方法融合框架,現已被廣泛使用。基于一般形式化的CS 方法的流程如圖1(a)所示,數學表達式如下:

圖1 傳統的全色銳化方法流程Fig.1 Flowcharts of traditional pansharpening methods

其中:M表示LRMS 圖像表示融合圖像(即HRMS 圖像)表示LRMS 圖像上采樣后的圖像;IL表示要替換的強度分量;P表示PAN 圖像,通常PAN 圖像與IL分量進行歸一化(如直方圖匹配)以減少光譜失真;g表示注入權重。

1.2 基于MRA的全色銳化方法

Tu 等[14]也對基于一般形式化的MRA 方法進行擴展,算法流程如圖1(b)所示,大多數基于MRA 方法的數學表達式如下:

其中,PL表示PAN 圖像的低通版本。與CS 方法提取空間細節的方式不同,MRA 方法通過PAN 圖像與它的低通版本的差值獲得空間結構信息。

1.3 基于深度學習的全色銳化方法PanNet

基于深度學習的PanNet 方法[7]第一次應用了ResNet,網絡模型分為空間保護和光譜保護兩部分。對于空間保護,PanNet 在高通域訓練圖像以保存細節邊緣信息;對于光譜保護,將上采樣的MS 圖像直接添加到網絡輸出以更好地保存光譜信息。網絡損失函數為:

其中:N表示訓練數據的總數;fw(·)表示ResNet 模型;G表示高通信息;↑表示上采樣操作。

2 本文方法

傳統的基于CS 和MRA 的全色銳化方法在理論解釋方面的研究相對成熟,從理論分析以及實驗實施均有發展成熟的各種常用方法;基于CS 的方法具有豐富的空間細節信息;基于MRA 的方法生成的融合圖像具有較強的光譜保真度。CS 和MRA 方法的一個很大的局限性是通常假設使用線性注入模型,而不考慮用于全色銳化傳感器的相對光譜響應。

結合MRA 方法對具有優越表現的PanNet 方法進行深入分析:在PanNet 方法中,網絡輸入包含PAN 圖像和MS 圖像的高通信息,最后將上采樣的MS 圖像添加到網絡輸出獲得HRMS 圖像;在MRA 方法中,PAN 圖像與低通PAN 圖像之間的差值獲得的同樣是PAN 圖像的高通信息,將PAN 圖像的高通信息注入到MS 圖像即可獲得融合圖像。因此,PanNet方法可以看作是一種實現MRA 方法非線性的深度學習方法。

本文將遵循CS 和MRA 方法的一般形式化,使用CNN 實現CS 和MRA 方法的非線性,提高全色銳化方法性能。

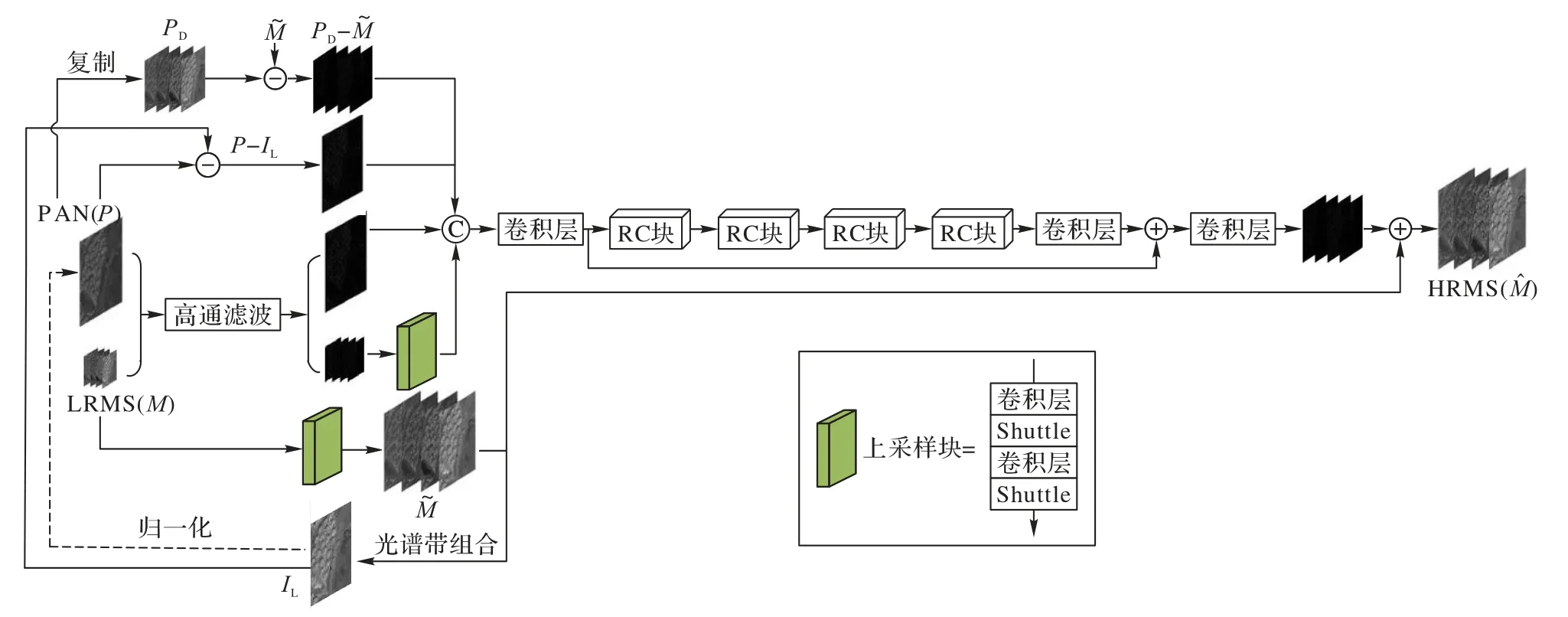

2.1 網絡結構

本文將結合傳統與深度學習的全色銳化方法稱作CMRNet,從而構建HRMS 圖像的空間細節信息和光譜信息。受超分辨領域殘差通道注意力網絡(Residual Channel Attention Network,RCAN)[16]的啟發,CMRNet 的網絡框架采用長連接和短連接的方式,有助于傳輸豐富的低頻信息,使網絡學習到更有效的信息。網絡主體結構由四個RC 塊堆疊組成:RC 塊保證在網絡訓練時,輸入信息可通過所有參數層充分傳播,并且能很好地提取空間和光譜信息。每個RC 塊由兩個殘差塊、通道注意力(CA)塊、卷積、跳躍連接組成,RC 塊采用跳躍連接將提取的特征信息跨層傳播,實現多尺度特征信息的融合提取。此外,由于遙感圖像的通道數較多且一般的網絡結構無法充分利用通道間的相互依賴關系,導致獲得的特征質量在通道方向參差不齊或冗余,這將限制網絡學習的能力。因此,本文在RC 塊中引入CA,使網絡根據通道間的依賴關系為不同的通道分配不同的權重,進一步提高網絡表達能力。

RC 塊的主要結構如圖2 所示,具體實現如下:1)輸入信息經過兩個殘差塊進行特征提取;2)通過CA 塊讓網絡去注意多通道中對重建更有用的信息;3)使用一次卷積實現當前RC 塊與前一個RC 塊的通道數對齊,便于后續跳躍連接的實現;4)通過跳躍連接實現多尺度特征信息的融合提取。

圖2 RC塊結構Fig.2 Structure of RC block

CMRNet 的網絡結構如圖3 所示。首先,CMRNet 關注高通域的高頻細節,通過高通濾波器獲得PAN 圖像和LRMS 圖像的高通信息,使用上采樣塊將LRMS 圖像的高通信息上采樣到PAN 圖像的分辨率;接著,使用上采樣塊將LRMS 圖像上采樣到PAN 圖像的分辨率,并進行光譜帶的線性組合得到要替換的強度分量,從而通過PAN 圖像與強度分量間的差值進一步獲得高空間結構信息;然后將PAN 圖像的高通信息、上采樣到PAN 圖像大小后LRMS 圖像的高通信息、高空間結構信息、PAN 圖像與MS 圖像間的差值級聯后輸入網絡進行訓練;最后,為更好地保存光譜信息,直接添加上采樣的MS 圖像到網絡的輸出使光譜信息直接傳播到融合圖像,最大限度地減小HRMS 圖像與LRMS 圖像之間的光譜信息差異,保持光譜質量以獲得高質量的HRMS 圖像。本文網絡能充分利用原圖像包含的豐富空間信息和光譜信息,經過高通濾波后的圖像可以更好地顯示其空間信息,利用較高的空間結構信息以及PAN 圖像與MS 圖像的差異可減少光譜和空間細節的損失。

圖3 CMRNet方法的網絡結構Fig.3 Network structure of CMRNet method

對結合CS 和MRA 的全色銳化方法CMRNet 進行抽象描述,該方法中PAN 圖像的高通信息可類比于MRA 方法中的P-PL,高空間結構信息可類比于CS 方法中的P-IL,最后添加到網絡輸出的上采樣的MS 圖像也可類比于CS 和MRA方法中的。綜上所述,本文方法將傳統方法與深度方法相結合,不僅實現CS 和MRA 方法的非線性,而且能更好地保存光譜和空間信息。

2.2 損失函數

現有的基于深度學習的全色銳化方法采用圖像域的監督方式,由于L2 損失函數能夠懲罰較大的異常值,因此選用L2 損失對網絡估計的HRMS 圖像與真實標簽數據的相似性進行約束,損失函數定義如下:

其中:PD表示復制到MS 圖像分辨率的PAN 圖像;f(?)表示本文網絡。

3 實驗與結果分析

3.1 實驗設置

實驗采用QuickBird 和GF1 衛星傳感器收集的圖像分別進行模型的訓練和測試。對于QuickBird 傳感器,PAN 圖像和LRMS 圖像的空間分辨率分別為0.6 m 和2.4 m;對于GF1傳感器,PAN 圖像和LRMS 圖像的空間分辨率分別為2 m 和8 m。由于實際應用中遙感圖像不存在真實標簽數據,即網絡訓練中沒有目標圖像,因此需要構建訓練數據集。本文根據Wald 協議[17]進行設計,將原始MS 圖像和PAN 圖像以采樣率4 進行下采樣,構建的訓練數據集包括下采樣后的LRMS、PAN 以及原始的MS 圖像。降尺度評估以下采樣后的圖像作為網絡輸入,以原始MS 圖像作為參考圖像即真實標簽數據。全尺度評估則直接將原始的衛星圖像輸入網絡。QuickBird和GF1 衛星數據集中的PAN 和LRMS 圖像對數分別為11 904和8 960,圖像大小分別為128×128 和32×32,將它們隨機分成90%和10%用于訓練和測試。

為充分驗證CMRNet 的性能,與較先進的方法進行實驗對比,選用的方法如下:基于CS 方法的IHS[2]和GS[3],基于MRA 方法的Wavelet[4]、廣義拉普拉斯金字塔(Modulation Transfer Function based Generalized Laplacian Pyramid,MTFGLP)[18],基于深度學習方法的DMDNet[9]、MSDCNN[8]、深度CNN 的遙感圖像融合(Remote Sensing Image Fusion with deep CNN,RSIFNN)[19]與PanNet[7]。

本文的實驗環境如下:PyTorch 1.13 深度學習框架,并在GeForce RTX 3090Ti 上訓練。網絡訓練中使用Adam 優化器優化網絡,批處理大小為32,初始學習率為0.001 并且每20個epoch 乘以0.5。

3.2 評價指標

實驗采用的評價指標包括:峰值信噪比(Peak Signal-to-Noise Ratio,PSNR)、結構相似性(Structural SIMilarity,SSIM)、相關系數(Correlation Coefficient,CC)、光譜角度映射(Spectral Angle Mapper,SAM)、相對無量綱全局誤差(Erreur Relative Globale Adimensionnelle de Synthese,ERGAS)、質量指標(Quality-index,Q4)、無參考質量指標(Quality with No Reference,QNR)和它的兩個分量Dλ和DS。這幾種指標中,PSNR、SSIM、CC、Q4、QNR 指標越高表明融合效果越好;SAM、ERGAS、Dλ、DS指標越低表明融合效果越好。指標具體說明如下所示。

CC 能衡量兩個圖像的相似度:

其中:x表示第x個像素;X表示像素數;表示融合圖像;M表示參考圖像;μ*表示圖像的均值。

SAM 衡量兩個圖像像素點矢量間的角度的絕對值,可反映圖像的光譜失真程度:

其中,u和v是融合圖像和參考圖像的像素向量。

ERGAS 是一個全局質量指標,能全面反映融合圖像的質量:

其中:h和l分別表示PAN 圖像和MS 圖像的空間分辨率;B是圖像的波段數;IRMSE(b)是融合圖像和參考圖像b波段的均方根誤差;μ(b)是b波段的均值。

Q4是一個通用圖像質量評價指標:

QNR 在沒有任何參考圖像的情況下衡量融合圖像的全局質量,由Dλ和DS組成,分別反映光譜失真程度和空間失真程度:

其中:P表示PAN 圖像,P↓表示下采樣后的PAN 圖像。

3.3 實驗與結果分析

3.3.1 降尺度評估

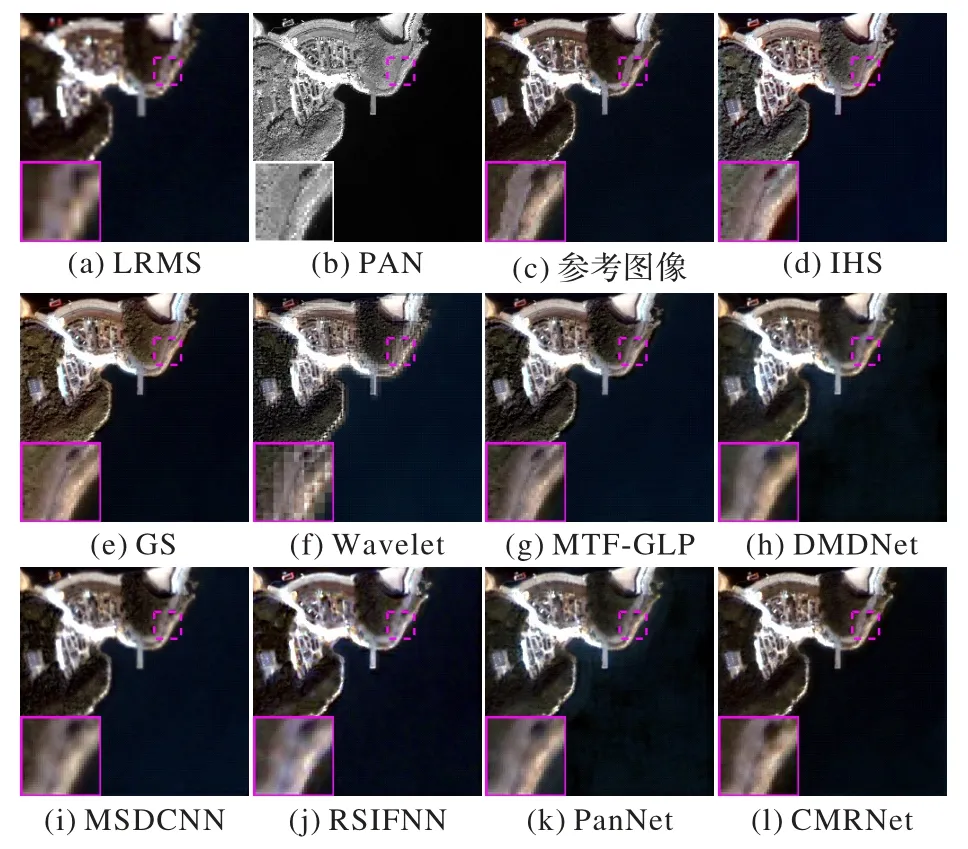

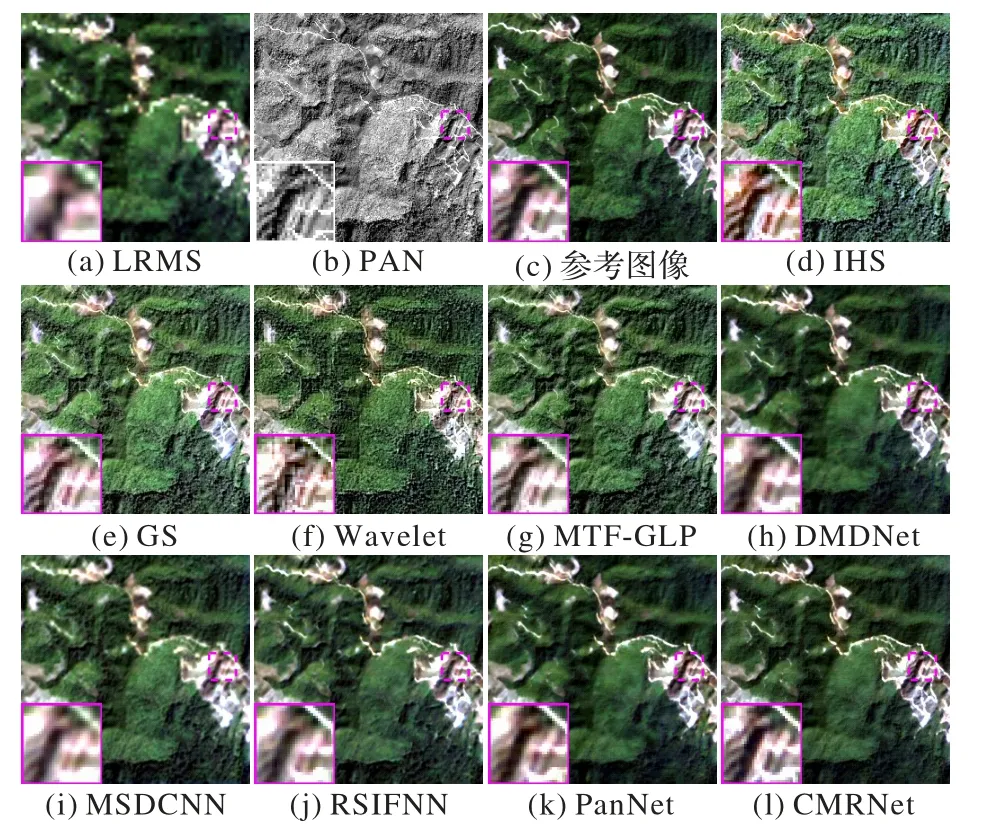

不同方法在降尺度QuickBird 數據集上對海邊港口圖像的銳化結果如圖4 所示。與參考圖像相比,只有PanNet、DMDNet 和CMRNet 能夠很好地保存光譜信息,而其他方法均具有明顯的光譜失真。為進一步進行可靠的對比,選取局部區域放大。比較3 種方法的局部放大圖像,可以看出CMRNet 的光譜信息與參考圖像最相似,邊界也更清晰。在這些具有光譜失真的方法中,IHS、GS 和RSIFNN 方法的整體失真較為嚴重,光譜信息與參考圖像差異較大,圖像整體顏色較淡;MTF-GLP 方法和MSDCNN 方法部分光譜信息損失且邊界較模糊;Wavelet 方法的銳化效果質量較差,空間細節信息較少且存在偽影和鋸齒。與這些方法相比,本文的CMRNet 方法可以更好地保存光譜信息和紋理細節。

圖4 降尺度QuickBird衛星圖像的銳化結果Fig.4 Sharpening results at reduced-resolution on QuickBird dataset

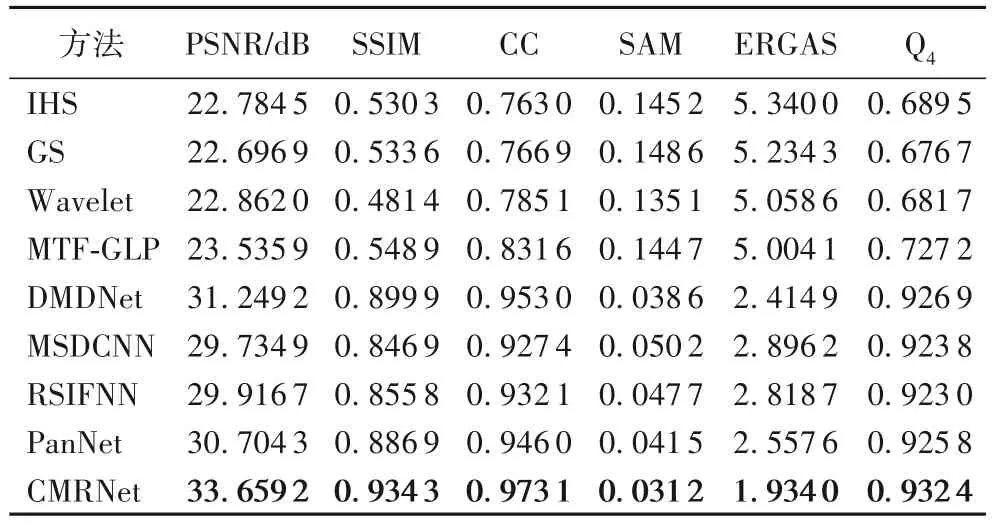

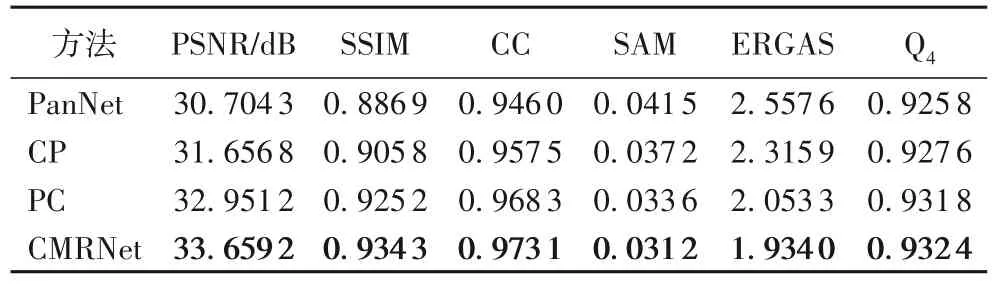

不同方法在QuickBird 數據集上測試的統計平均結果如表1 所示,最優結果加粗表示。從表1 可以看出,與幾種常用的全色銳化方法相比,CMRNet 方法在PSNR、SSIM、CC、SAM、ERGAS 和Q4這6 種指標上都取得最好的效果。相較于PanNet 方法,CMRNet 的PSNR 提高了5.48%。因此,在QuickBird 衛星圖像上,本文方法在定性和定量上的表現較好,融合圖像在光譜分布和空間結構上均與參考圖像最一致。

表1 不同方法在降尺度QuickBird數據集上的結果對比Tab.1 Comparison of results of different methods on reduced-resolution QuickBird dataset

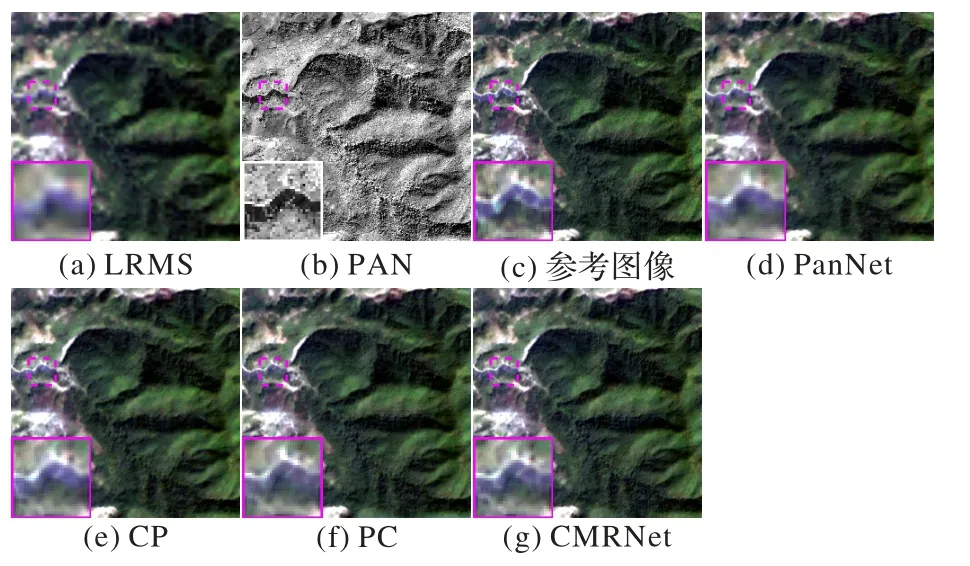

不同方法在GF1 數據集上對森林圖像的銳化結果如圖5所示。可以看出,傳統的IHS、GS、Wavelet 和MTF-GLP 方法的光譜失真較為嚴重,銳化結果缺乏綠色光譜信息;MSDCNN 方法保留空間信息的能力較弱,圖像較模糊;比較局部放大區域的河流,可以看出RSIFNN 方法在邊界上有輕微的空間信息損失,PanNet、DMDNet 和CMRNet 方法的銳化效果較好,但本文的CMRNet 方法在保存光譜和空間信息方面略優于PanNet 和DMDNet 方法,并且在光譜和空間上最接近參考圖像。

圖5 降尺度GF1衛星圖像的銳化結果Fig.5 Sharpening results at reduced-resolution on GF1 dataset

不同方法在降尺度GF1 數據集上測試的統計平均結果如表2 所示。從表2 可以看出,與幾種常用的全色銳化方法相比,本文的CMRNet 方法在所有指標上都取得了最優;相較于PanNet,CMRNet 的PSNR 提高了9.62%。實驗結果表明,本文方法的銳化效果優于其他方法,銳化結果不僅具有更準確的光譜分布,而且包含合理的局部紋理細節。綜上,在GF1 衛星圖像上,本文方法在定性和定量評價上均取得較好的效果。

表2 不同方法在降尺度GF1數據集上的結果對比Tab.2 Comparison of results of different methods on reduced-resolution GF1 dataset

3.3.2 全尺度評估

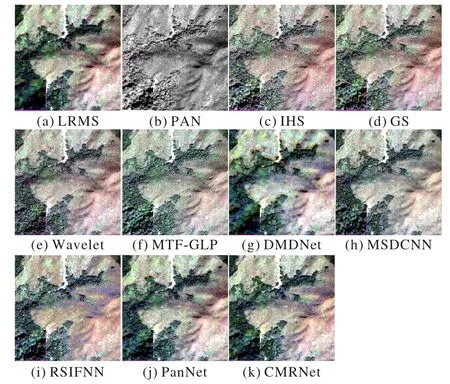

不同方法在QuickBird 數據集上的銳化結果如圖6 所示。

圖6 全尺度QuickBird衛星圖像的銳化結果Fig.6 Sharpening results at full-resolution on QuickBird dataset

可以看出,除PanNet 和本文的CMRNet 方法外,其他方法生成的圖像均有不同程度的紅色光譜信息失真。與PanNet 方法相比,CMRNet 方法包含的綠色光譜信息稍多,顏色上與LRMS 圖像最相似,主觀感知方面優于其他方法。

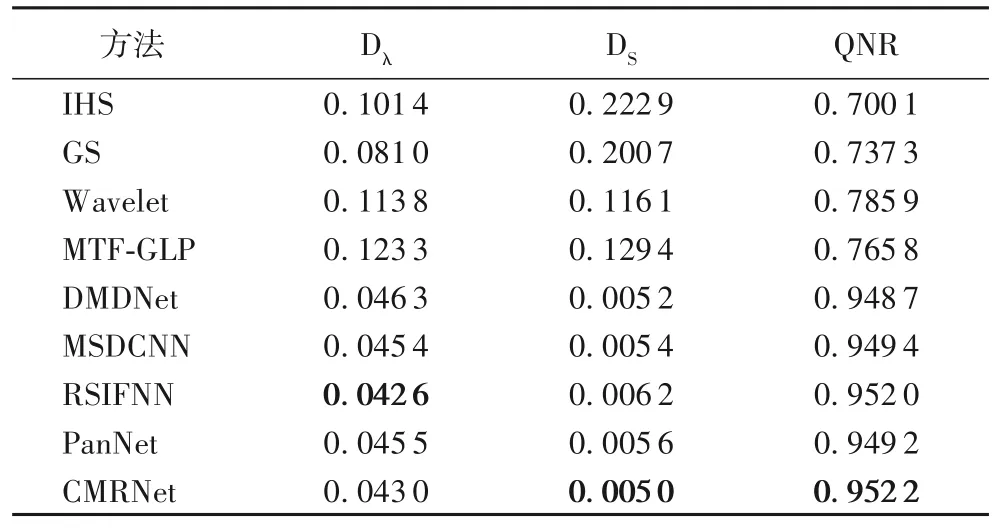

不同方法在QuickBird 數據集上測試的統計平均結果如表3 所示。從表3 可以看出,與其他全色銳化方法相比,CMRNet 在DS和QNR 指標上取得了最優,Dλ指標也跟最優的RSIFNN 接近。總體來看,本文方法仍然在對比方法中表現最優,在全尺度實驗中取得了良好的效果,充分驗證了本文方法對全色銳化任務的積極作用。

表3 不同方法在全尺度QuickBird數據集上的結果對比Tab.3 Comparison of results of different methods on full-resolution QuickBird dataset

3.4 消融實驗

為驗證CMRNet 中CS 方法和MRA 方法相結合的思想及網絡結構的有效性,在GF1 數據集上進行消融實驗。

1)將CMRNet 與PanNet 與以下方法對比:使用本文的損失函數和PanNet 的網絡結構進行訓練的方法(簡稱CP);使用PanNet 的損失函數和本文的網絡結構進行訓練的方法(簡稱PC)。銳化效果如圖7 所示。從局部放大區域可看出,CP、PC、CMRNet 的銳化效果都優于PanNet 方法,其中CMRNet 方法在光譜信息和空間細節方面與參考圖像最接近,實現了較好的銳化效果。4 種方法的評價指標如表4 所示。在所有指標上,CP 均優于PanNet,驗證了本文損失函數的有效性;PC 優于PanNet,驗證了本文網絡結構的有效性。而CMRNet 結合這兩者進一步提升了融合效果。

表4 不同損失函數與網絡結構組合的消融實驗結果對比Tab.4 Comparison of ablation experiment results of different loss functions and network structure combinations

圖7 消融實驗的銳化結果及其對比圖像Fig.7 Sharpening results of ablation experiments and their comparison images

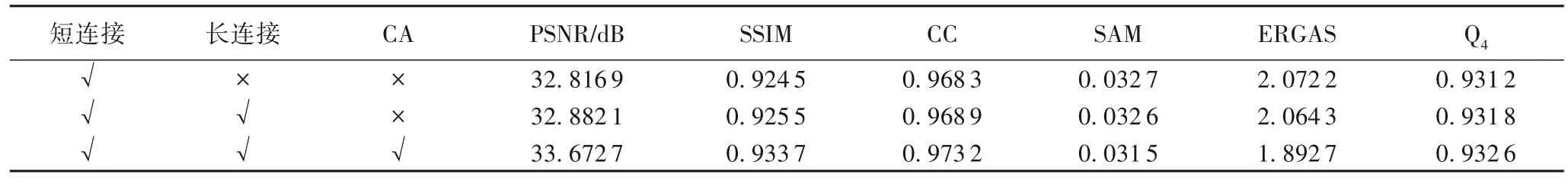

2)對CMRNet 中的長連接、RC 塊中的短連接和CA 的有效性進行消融實驗,評價指標如表5 所示。從表5 可以看出,三者均對性能提升起著積極作用。

表5 不同模塊的消融實驗結果對比Tab.5 Comparison of ablation experimental results of different modules

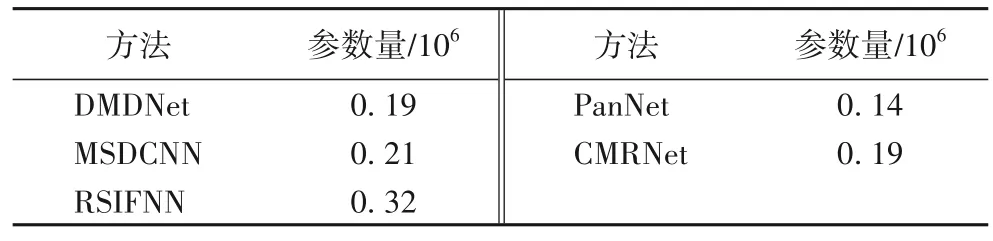

3.5 網絡性能評估

本節對比了本文方法與DMDNet、MSDCNN、RSIFNN、PanNet 的參數量。所有的全色銳化方法均使用PyTorch 框架實現,各方法的參數量如表6 所示。可以看出,本文的CMRNet 方法具有較低的參數量。因此,CMRNet 方法不僅相對輕量化,并且能夠實現較好的全色銳化效果。

表6 不同方法的參數量Tab.6 Parameters of different methods

4 結語

本文關注傳統方法CS 和MRA 的思想,并將它們與CNN相結合,巧妙聚合這兩種思想并實現非線性以克服線性注入模型的局限性,從而提升全色銳化方法的性能。考慮到遙感圖像的通道數較多但大多網絡結構忽略通道間的依賴關系使網絡學習能力受到限制,引入通道注意力給每個通道分配不同的權重,讓網絡關注重要的特征并抑制不重要的特征,進一步提高性能。實驗結果表明,與基于深度學習的方法相比,本文的CMRNet 方法不僅參數量較小,而且進一步提高了融合圖像的光譜和空間分辨率(定量結果顯示所有指標均有顯著提升);此外,消融實驗結果驗證了本文思想和網絡結構均對性能提升起著積極作用。綜上所述,本文方法能較好地保存空間和光譜信息,具有廣泛的研究與應用前景。未來將會對圖像約束作進一步研究,以達到更好的效果。