基于Transformer的自動駕駛交互感知軌跡預測

景榮榮, 吳蘭, 張坤鵬

(1.河南工業大學電氣工程學院, 鄭州 450001; 2.河南工業大學機電工程學院, 鄭州 450001; 3.清華大學自動化系, 北京 100084)

在可預見的未來,自動駕駛車輛將成為智能交通的重要組成部分,能夠極大地改善人們的出行環境,具有十分重要的研究價值[1-2]。自動駕駛車輛在行駛過程中,需要及時、準確地預測周圍交通參與者(如汽車、公共汽車、卡車、自行車、行人等)的軌跡,從而提前合理地規劃自身的行駛路徑,避免發生碰撞。因此,能否準確地預測周邊其他交通參與者的運動軌跡是衡量自動駕駛技術安全性和可靠性的重要指標。在現實交通環境中,準確預測車輛的軌跡是十分困難的。因為車輛的軌跡不僅受到道路結構、交通信號、交通規則等先驗知識的約束,還會不可避免地受到交通場景中其他交通參與者的影響。目前,中外研究者針對自動駕駛汽車的軌跡預測方法大致可以分為兩類:傳統預測方法和基于深度學習的預測方法。

傳統的方法可以分為3類:物理方法、駕駛意圖方法和交互感知方法[3]。物理方法將車輛視為受物理定律支配的動態實體,通常假設其速度或加速度恒定,然后通過動態模型[4]或運動學模型[5]預測車輛軌跡。駕駛意圖方法假定車輛的運動對應于一系列的駕駛動作(如變道、保道、轉彎、超車等),并獨立于其他車輛執行。它們通常依靠兩種策略來預測軌跡,即原始軌跡聚類和意圖估計。前者通過基于集群的方法將未來的軌跡與先前觀察到的軌跡相匹配[6]。后者則是先估計駕駛員的駕駛意圖,然后相應地預測軌跡[7]。交互感知方法考慮了周圍交通參與者對車輛運動的影響。因此,與基于物理和基于駕駛意圖方法的模型相比,交互感知模型更加有效[8]。盡管傳統方法在一些交通場景中展現出令人滿意的性能,但由于建模能力有限,難以適用于復雜場景。

近年來,由于可以對大規模、復雜數據進行有效的建模,深度學習技術被廣泛應用于各個領域[9-12],其優異的性能也在軌跡預測中得到了驗證[13-16]。深度學習模型的性能取決于輸入數據的類型和它的表征方法。基于深度學習,遞歸神經網絡(recurrent neural networks,RNN)被用來預測城市交叉口的司機駕駛意圖和未來軌跡[17]。一些研究也提出基于長短時間記憶(long short-term memory,LSTM)的軌跡預測方法[18],根據交通參與者的坐標、速度、大小和方向來預測其軌跡。這些方法將軌跡預測建模為序列生成任務,在預測軌跡的過程中僅考慮了目標交通參與者自身的運動,沒有考慮與相鄰交通參與者的交互。盡管目標交通參與者的歷史軌跡能夠為預測其未來軌跡提供不可或缺的運動信息,但由于忽略了周圍其他交通參與者的影響,上述方法預測出的軌跡往往難以滿足實際需要。為了軌跡預測過程中有效地考慮交通參與者之間的交互,學者們試圖將目標交通參與者和周圍交通參與者的歷史軌跡同時作為預測模型的輸入。例如,Alahi等[19]提出利用全連接的池化層對目標交通參與者及其周圍一定數量的參與者的信息進行提取,進而提高預測準確度。Zhang等[20]提出使用卷積社會池化層來學習一定范圍內交通參與者之間的交互信息。這些模型在進行軌跡預測的過程中只考慮了固定數量的交通參與者之間的交互。由于現實場景中交通參與者的數量是動態變化的,因此上述模型無法對交通環境的動態性進行有效地建模。

近來,一些研究嘗試將交通場景構建為交通圖來解決上述問題。交通圖的節點和邊分別表示交通參與者及其交互關系。例如,Diehl等[21]利用圖神經網絡(graph neural networks,GNN)對交通圖進行運算,進而預測交通圖中交通參與者的軌跡。Li等[22]提出了一個基于圖卷積網絡(graph convolutional networks,GCN)和門控遞歸單元(gated recurrent units,GRU)的交互感知模型。該模型通過GCN對交通圖進行學習來捕捉交通參與者之間的交互,最終使用GRU來同時對多個交通參與者進行軌跡預測。然而,由于不能區分周圍交通參與者的影響程度,這些基于圖的方法并不能有效地捕捉交通圖中最關鍵的交互。此外,這些方法也未能考慮周圍道路基礎設施(如道路幾何和交通信號)對交通參與者運動軌跡的影響。

考慮到道路基礎設施的對軌跡預測的影響,學者們探索在具有詳細道路信息的柵格化鳥瞰圖上勾畫交通參與者的歷史軌跡[23-24]。Djuric等[23]將交通參與者和周圍環境信息編碼到鳥瞰圖中作為卷積神經網絡(convolutional neural network,CNN)的輸入,并利用池化層提取有用特征。然而,使用池化層往往會遺漏交通場景中有價值的信息。Liu等[24]通過堆疊多個Transformer網絡,提出mmTransformer模型用于預測交通參與者的軌跡。在該模型中,歷史軌跡和道路信息被輸入到不同的Transformer單元。通過定制的特征提取器,它可以分層次地整合不同的環境信息。雖然這種結構可以有效地提取目標的歷史軌跡和周圍環境的特征,但這種分層結構增加了模型的計算復雜性,需要更多的推理時間。

為了解決上述問題,現提出一種基于改進Transformer的交互感知軌跡預測方法,用于對自動駕駛車輛周圍交通參與者的運動趨勢進行估計并輸出相應預測軌跡。將軌跡預測對象建模為交通智能體,構建了軌跡預測Transformer(trajectory prediction transformer,TPT)模型。首先將包含交通智能體的歷史運動軌跡和周圍交通環境信息的道路信息圖作為TPT模型的輸入。然后,利用改進的Transformer對交通環境進行建模,并捕捉交通智能體與交通環境之間的交互信息,預測其未來運動軌跡。在注意力機制的幫助下,TPT模型可以捕捉最值得注意的交互信息,以提高模型的預測性能和可解釋性。最后使用Lyft數據集[25]進行數值實驗,驗證TPT模型的有效性。

1 模型建立

1.1 問題構建

軌跡預測可以被表述為這樣一個問題,即基于交通智能體的歷史軌跡和來自周圍交通參與者和道路基礎設施的時空交互來估計交通智能體的未來位置。具體來說,讓V表示交通場景中觀察到的交通智能體的過去特征。公式為

V=[v1,v2,…,vt,…,vT]

(1)

式(1)中:t=1,2,…,T,為時間節點;vt=(xt,yt,ot);xt和yt為交通智能體在t時刻的位置坐標;ot為其他屬性(如車輛的長、寬、高、車頭朝向等)。

圖1 Lyft數據集可視化

(2)

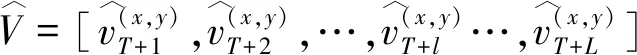

1.2 軌跡預測Transformer模型

圖2 TPT模型結構

(3)

(4)

1.3 Nested Transformer

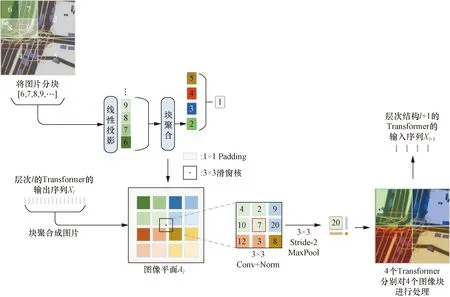

圖3所示為3層架構的Nested Transformer。可以看出,Nested Transformer的第i層的嵌套將整張圖像分成(2i)2個小塊,i=1,2,…,Tl,Tl為總層數。Nested Transformer利用不同的層次結構對道路信息圖和可達網絡進行特征提取。在圖3中,道路信息圖I和可達網格G作為模型的輸入,隨后被分割成(H×W)/(S×S)個圖像補丁。每個大小為S×S的圖像補丁被線性投影到向量空間中的一個嵌入。然后,所有的嵌入都被劃分為塊,作為Transformer的輸入x。該過程可以表示為

Padding、Conv、Norm和 Stride-2 MaxPool即填充、卷積、歸一化和步長為2的最大池化操作

x=Block[PatchEmbed(I,G)]

(5)

(6)

x′=LN(x)

(7)

y=x+MSA(x′,x′,x′)

(8)

x″=y+FFN[LN(y)]

(9)

式中:y為單個圖像塊x經過Transformer處理所提取的特征。

由于所有塊在同一個層次結構中共享參數,Nested Transformer可以對所有塊并行運算MSA,增加了運算效率。在TPT中,Nested Transformer利用MSA捕捉交通智能體周圍值得注意的不同類型的交通參與者,并提取它們的交互信息。

與其他Vit不同的是,Nested Transformer采用層間塊聚合實現相鄰圖像塊之間的信息耦合和通信。在塊聚合步驟中,通過卷積和池化等簡單的空間操作實現全局信息的通信和融合。

Aggregate(y,i)=Block×

{Conv×Norm×MaxPooli[Unblock(y)]}

(10)

式(10)中:Aggregate為塊聚合操作;Unblock為圖像塊合并操作。

圖3的下半部分是Nested Transformer塊聚合操作的具體過程,結合式(10)可以看到,首先層次結構l的輸出Xl經過Unblock操作以填滿圖像平面Al,隨后對降采樣特征映射應用空間操作,最后使用Block操作將特征映射回Xl+1,用于層次l+1。可以看到,經過塊聚合后,每一層的圖像塊總數減少為最初的1/4,直到在頂層減少到1。在圖像平面上執行的Conv、Norm和MaxPool操作允許上層的不同圖像塊之間進行通信。采用分層嵌套結構,僅利用局部注意力,Nested Transformer就能具備較高的計算效率和較好的收斂性,從而縮短了軌跡預測模型的推理時間。

2 實驗與分析

2.1 數據集來源

為了對所提方法進行評價,使用Lyft自動駕駛數據集。該數據集是迄今為止最大的自動駕駛運動預測數據集,擁有1 118 h的數據。這是由20輛自動駕駛汽車組成的車隊在4個月的時間里收集的,這些汽車在加州帕洛阿爾托的郊區路線上行駛了超過2.6萬km。它由17萬個場景組成,每個場景持續25 s,包含自動駕駛汽車附近車輛、自行車、行人的精確位置、大小和移動時間。該數據集包含該地區詳細的高清語義地圖,包含15 242個標記元素,包括道路規則、車道幾何形狀和其他交通元素。為了進一步幫助預測,該數據集還提供了該地區的高分辨率航空地圖,覆蓋了74 km2。此外,交通場景中紅綠燈的變化也包含在Lyft的數據集中。

Lyft數據集的每條軌跡被分割成8 s的序列,其中前3 s作為歷史觀測軌跡,其余5 s作為真實軌跡,預測交通智能體未來5 s的軌跡。Lyft的訓練數據集包含超過13.4萬個場景,用于訓練提出的TPT模型。為了確定最佳超參數,隨機選擇訓練數據集的10%作為驗證數據集。TPT模型的性能通過驗證數據集進行驗證,該數據集包含1 100個場景。

2.2 評價指標

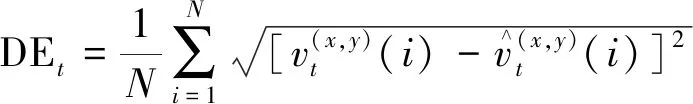

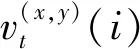

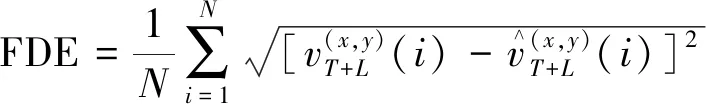

評價指標采用平均位移誤差(average displacement error,ADE)和最終位移誤差(final displacement error,FDE)。其中DEt為t時刻真實軌跡坐標與預測軌跡坐標之間的歐氏距離,計算公式為

(11)

所有預測步長的真實坐標與預測坐標之間的平均歐氏距離ADE為

(12)

預測時間步T+L的真實坐標與預測坐標之間的平均歐氏距離FDE為

(13)

2.3 模型比較

引入幾種現有的軌跡預測方法,并與所提出的TPT模型進行比較,驗證模型的有效性。

(1)Constant Velocity(CV):CV模型認為交通智能體的狀態不隨時間的變化而變化,沒有考慮來自其他交通智能體的影響。

(2)LSTM:利用基于LSTM的編碼器-解碼器結構,該模型利用交通智能體的歷史軌跡,預測未來軌跡。該模型在預測過程中考慮了交通智能體的狀態在時間維度中的演進,未能考慮來自其他交通參與者的影響因素。

(3)Conv-LSTM:Conv-LSTM模型利用卷積神經網絡從交通圖像中提取歷史軌跡特征,然后利用LSTM進行軌跡預測。

(4)Conv-attn-LSTM:在Conv-LSTM的基礎上,Conv-attn-LSTM引入注意力機制來捕獲交通場景中值得注意的交互。

(5)Conv-attn-GRU:將Conv-attn-GRU模型中的LSTM塊替換為GRU塊。

(6)TPT-ORIG:TPT-ORIG模型使用原始的Transformer從交通圖像中提取特征,其輸入和輸出和TPT模型相同。

如表1所示,以ADE和FDE為評價指標,與現有方法相比,TPT取得了最準確的預測結果。由于缺乏考慮交通狀態的時間相關性和交通場景中不同交互作用,CV模型的預測結果最差。與CV模型相比,LSTM模型考慮了交通智能體的交通狀態隨時間變化的特性,獲得了更準確的軌跡預測結果。與LSTM模型相比,Conv-LSTM模型考慮了周圍環境和其他交通參與者的影響,取得了更好的預測表現。Conv-attn-LSTM模型利用注意力機制捕獲交通場景中值得注意的交互作用,提高了軌跡預測準確度。Conv-attn-GRU模型的性能略優于Conv-attn-LSTM模型。相較于Conv-attn-LSTM模型,兩種基于Transformer的模型(即TPT-ORIG和TPT)取得了更好的預測結果。與TPT-ORIG相比,TPT模型的預測準確度得到了較大的提升。這表明相較于原始的Transformer,Nested Transformer的分層嵌套結構具有更好的性能,使得TPT不僅可以有效地捕獲車輛與車輛之間的交互,還可以有效捕獲車輛與基礎設施之間的交互,從而提高其預測準確度。

表1 模型預測結果對比

此外,推理時間是衡量軌跡預測模型能否成功應用于實際工業場景的重要指標。表1中還展示了7個模型的推理時間。以預測1 000個交通智能體的未來軌跡為例,CV模型所花費的時間為0.85 s,是所有模型中最短的。這是因為CV作為傳統的預測模型在預測過程中認為交通智能體的運動狀態不隨時間變化,并且不考慮其他因素的影響,所需的計算量遠低于深度學習模型。TPT模型只花費1.78 s,遠少于其他深度學習模型。這表明在Nested Transformer的幫助下,TPT模型具有更好的計算效率,可以顯著減少推理時間。

2.4 模型分析

2.4.1 實驗1:預測結果可視化

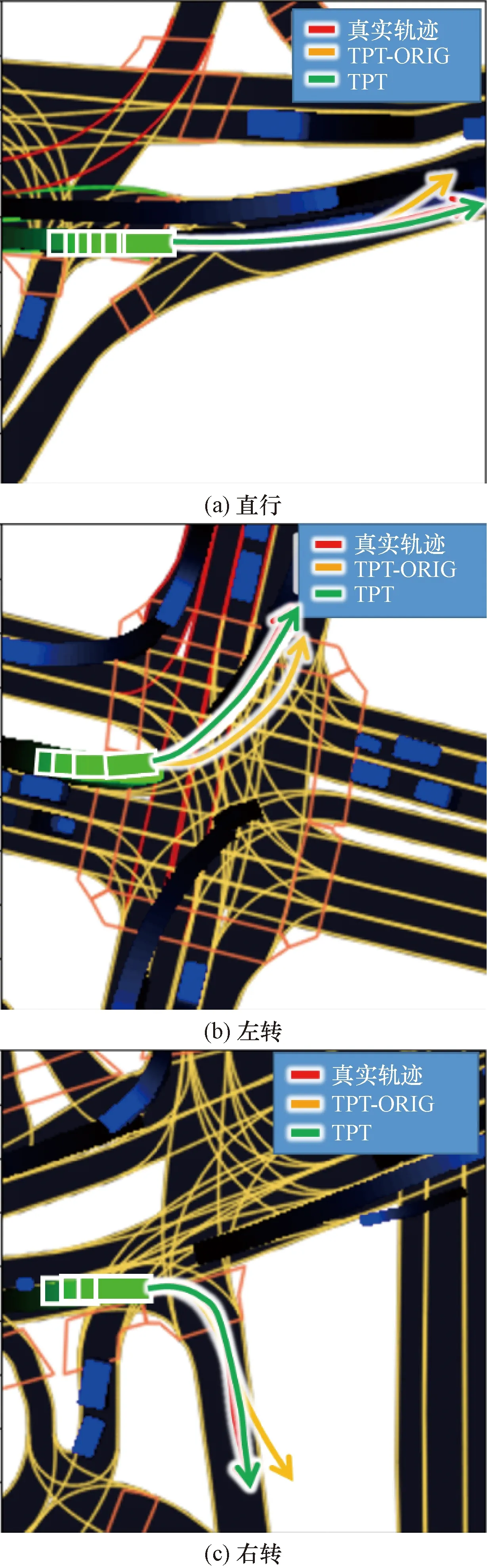

圖4顯示了TPT和TPT-ORIG在3種不同駕駛場景下對單個交通智能體的預測結果。在預測場景中,交通場景中的一個交通智能體被視為目標交通智能體,將道路信息圖I、可達網格G和歷史軌跡R作為模型輸入對其未來軌跡進行預測。然后,利用l5kit軟件包提供的坐標變換功能,將預測的軌跡繪制成圖。可以看出,TPT可以準確地預測交通智能體在各種駕駛情況下的未來軌跡。相比于TPT-ORIG模型,基于改進的Nested Transformer的TPT模型能夠更準確地預測交通智能體的軌跡,表明了Nested Transformer相較于原始Transformer的優勢。圖5為TPT多車交通場景的預測結果可視化,該交通場景中的每個交通智能體被視為目標交通智能體。可以發現,TPT模型能夠準確地預測該交通場景中每個交通智能體的未來軌跡。

紅色曲線代表真實軌跡;黃色曲線代表TPT-ORIG預測的軌跡;綠色曲線代表TPT預測的軌跡

圖5 多車交通場景的預測結果可視化

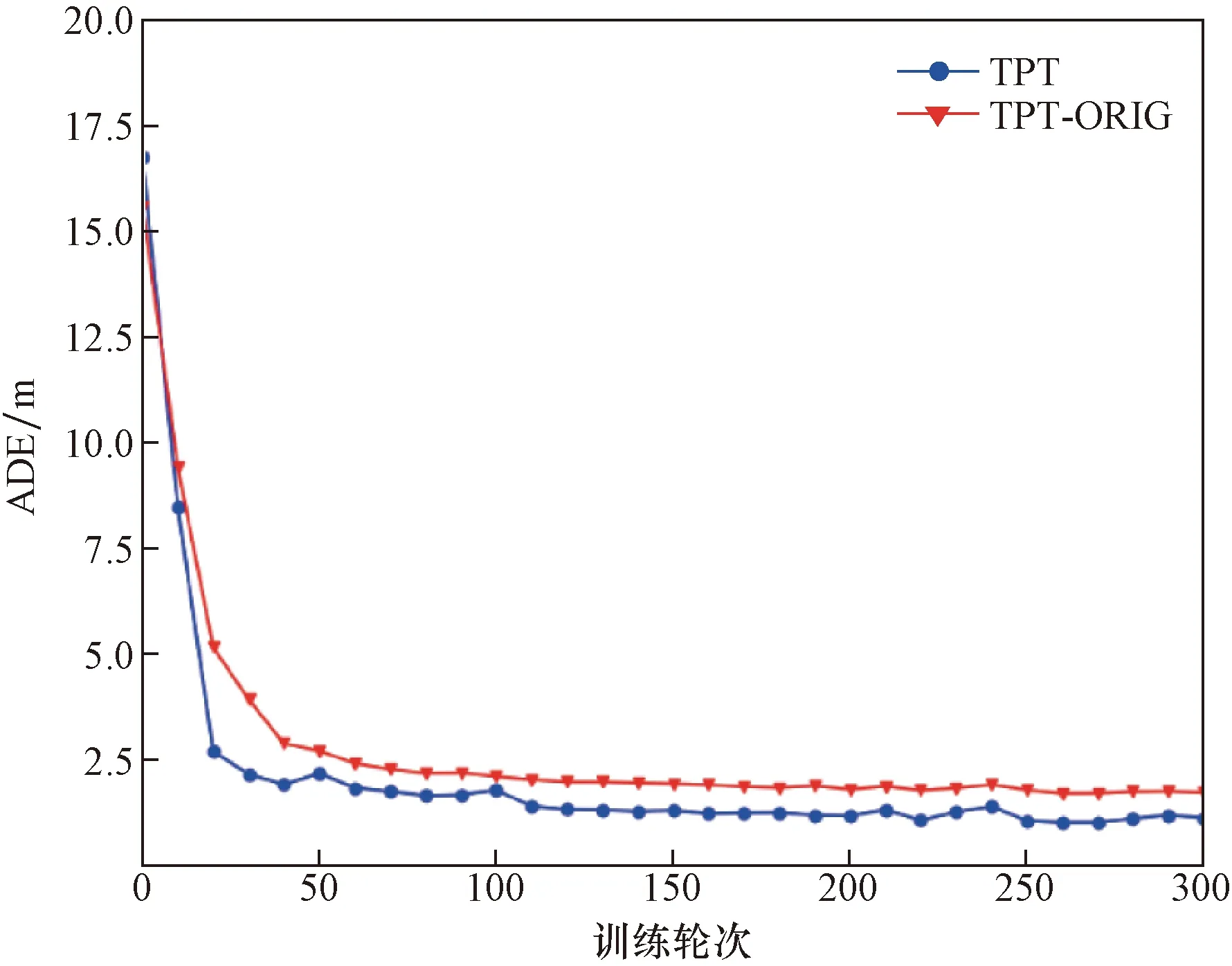

圖6為TPT在原始Transformer和Nested Transformer下的訓練過程。可以看出,相比于使用原始的Transformer,使用Nested Transformer的TPT模型具有更好的收斂性能和更高的預測精度。這表明相較于原始的Transformer,Nested Transformer的分層嵌套結構使其具有較高的計算效率和較好的收斂性,可以幫助TPT模型在更短的時間內更準確地預測交通智能體的未來軌跡。

圖6 基于原始Transformer和Nested Transformer的TPT訓練過程

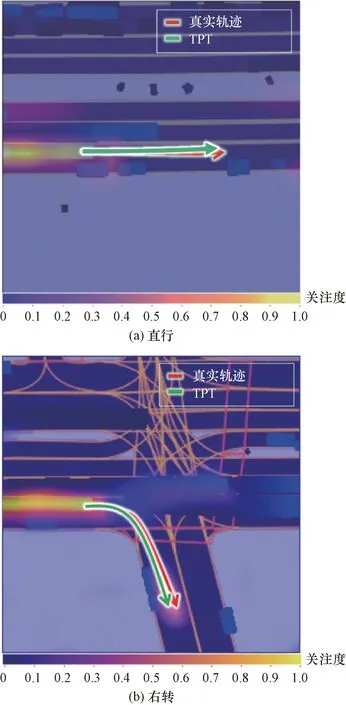

2.4.2 實驗2:TPT的注意力圖

利用注意力機制捕捉交通智能體周圍值得關注的交互是TPT模型主要的優點。圖7是TPT在預測交通智能體直行和右轉時未來軌跡的注意力圖,不同的顏色深度表示不同的關注度。從圖7可以看到,無論是直行還是右轉,TPT模型在預測未來軌跡的時候,都會給與交通智能體的歷史軌跡極大的關注,同時也會關注周圍移動的交通參與者。不同的是,在右轉的情況下,TPT會給與周圍移動的交通參與者更多的關注。這也符合現實情況,在現實交通場景中,人類駕駛員在判斷周圍車輛走向時,會關注該車輛的歷史軌跡。在直行時無需過多的關注周圍的車輛,而在進行轉向時,則要對周圍移動的車輛給予足夠的關注,然后對車輛進行及時的調整以避免碰撞。實驗表明,在注意力機制的幫助下,TPT可以在不同駕駛情況下有效地捕捉交通智能體周圍最值得注意的交互,并準確地預測其未來軌跡。

圖7 TPT的注意力圖

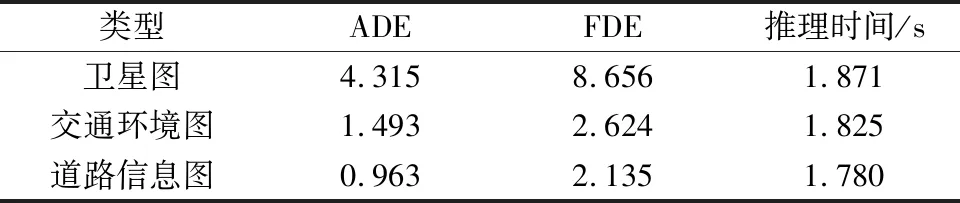

2.4.3 實驗3:交通圖像類型

Lyft的數據集以不同的形式提供地圖,包括衛星圖和道路信息圖。還可以將衛星圖和道路信息圖整合起來,從而得到交通環境圖。表2顯示了使用道路信息圖的TPT模型獲得了預測性能。當TPT模型使用衛星圖作為輸入時,它的性能比使用交通環境圖和道路信息圖時差。這可以解釋為,衛星圖只包含道路信息,沒有交通信號。道路信息圖包含道路幾何形狀和交通信號等信息,并排除了不必要的信息,使其成為最佳選擇。

表2 使用不同類型交通圖像的TPT性能比較

2.4.4 實驗4:交通信號

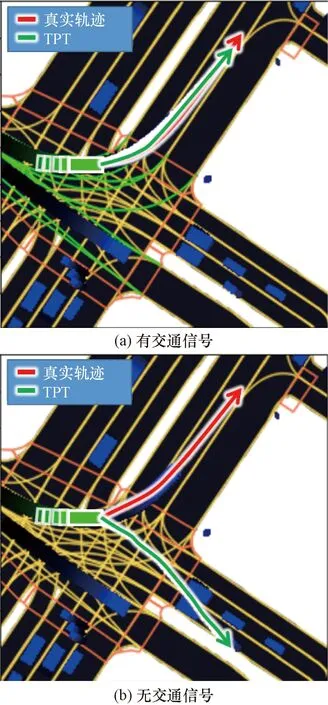

在Lyft數據集中,車道邊緣顏色代表交通信號,當交通信號發生變化時,車道邊緣顏色也會發生變化。紅色的車道邊表示此時該車道為紅燈,綠色的車道邊表示此時該車道為綠燈,黃色的車道邊代表黃燈。圖8展示了交通信號對TPT性能的影響。在圖8(a)中,當前車道顯示綠燈表示可以行駛時,TPT模型可以提供合理的預測結果。在沒有交通信號信息的情況下,圖8(b)中TPT對軌跡的預測具有較大的隨機性,導致預測結果不夠準確。這是因為在注意力機制的幫助下,TPT可以有效地關注到交通智能體周圍包括交通信號在內的值得注意的交互(實驗2中已經進行了論證)。因此,TPT也可以有效地將交通信號對軌跡預測的影響納入考慮中。

圖8 有無交通信號的預測結果

2.4.5 實驗5:突然出現的交通參與者

本次實驗旨在檢驗模型對交通場景中突然出現的交通智能體的預測能力。事實上,這對于軌跡預測模型在實際中的應用是非常重要的。在一個十字路口內,分別使用1 s和2 s的歷史軌跡來預測交通智能體的5 s未來軌跡。預測結果如圖9所示。可以發現,即使只有1 s的歷史軌跡,交通智能體的未來軌跡也是可以被預測的。如圖9(b)所示,在有2 s歷史軌跡的情況下,TPT模型的預測結果更加準確。

圖9 對突然出現的交通參與者的預測結果

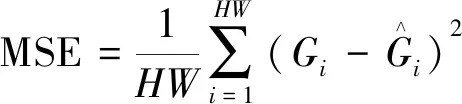

2.4.6 實驗6:可達網格

為了提高模型的預測性能,將可達網格作為模型的先驗知識,然后計算網格損失。網格損失迫使模型關注車道覆蓋的交通區域。3種不同情景下的預測結果如圖10所示。可以發現,可達網格的引入顯著提高了預測準確度。

圖10 在有無可達網格的情況下TPT預測結果的可視化

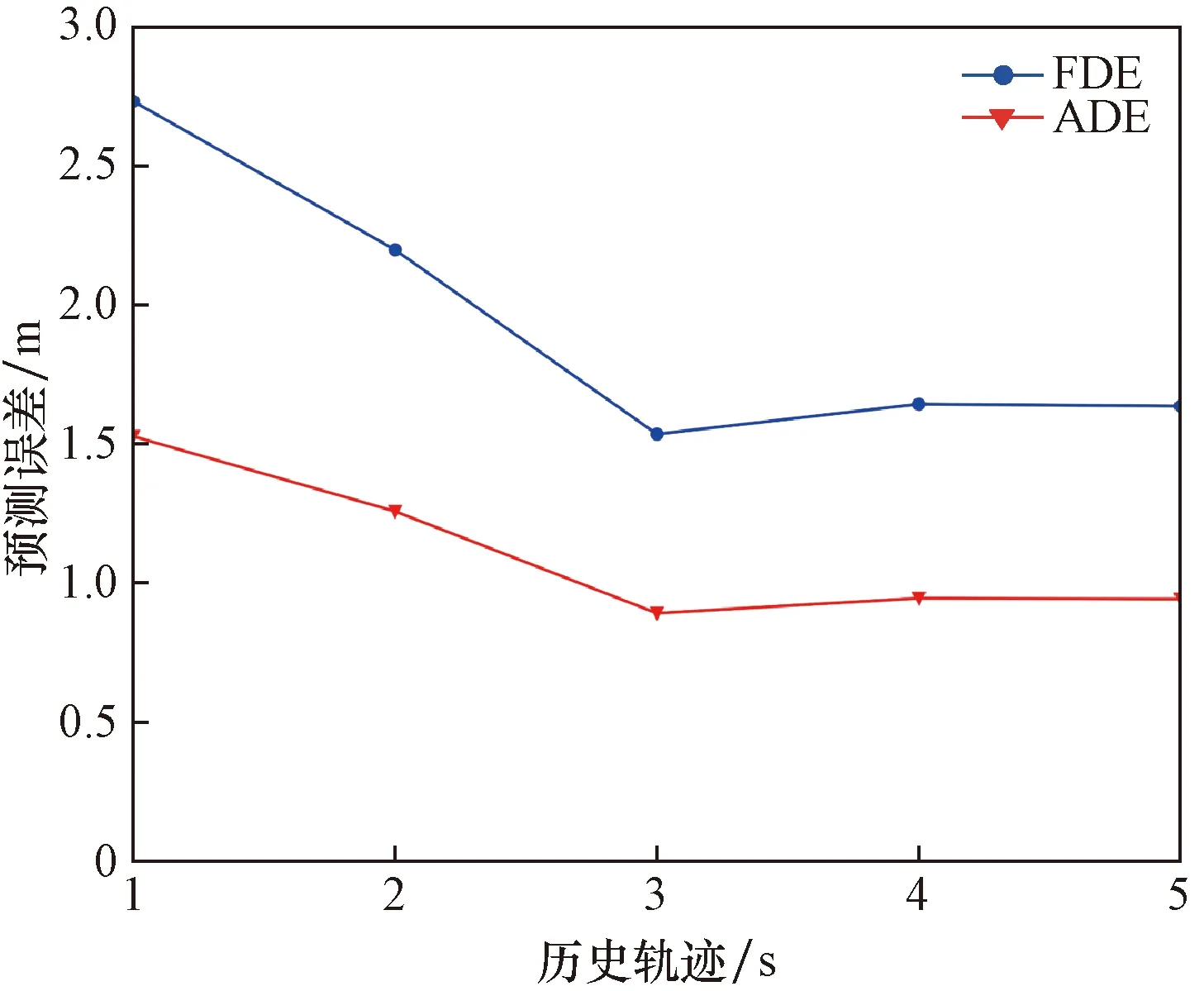

2.4.7 實驗7:歷史觀測軌跡

為了驗證歷史觀測軌跡長度對預測精度的影響,通過使用不同長度的歷史觀測軌跡來進行預測。實驗結果由圖11可知,當輸入為3 s的歷史觀測軌跡時,模型的預測精度最高。隨著歷史觀測軌跡長度的增加,模型的預測精度隨之下降。因此可以知道,在一定范圍內增加歷史觀測軌跡長度可以相應提高模型的預測精度,而超過這個范圍則對提高模型的預測精度沒有幫助。同時也可以知道,預測交通智能體的未來軌跡只與一定時間長度的歷史觀測軌跡有關。

圖11 TPT在不同長度歷史軌跡下的預測結果

3 結論

在考慮道路幾何信息和交通參與者之間的交互信息的情況下,提出了TPT模型來實現自動駕駛車輛的軌跡預測。將包含歷史軌跡和周圍環境信息的多通道圖作為輸入,利用改進的Nested Transformer對交通環境進行建模,有效地考慮了車輛之間的交互以及車輛與基礎設施之間的交互。在公開的自動駕駛數據集Lyft上的實驗結果表明,與現有方法相比,TPT在所需推理時間更短的情況下獲得了更好的預測結果。得出以下結論。

(1)將交通智能體的歷史運動軌跡和周圍交通環境信息整合到多通道圖中作為輸入,利用改進的Nested Transformer有效地建模來自環境的時空交互,從而準確地預測交通智能體的未來軌跡。

(2)利用注意力機制,TPT模型可以捕獲周圍環境中最值得注意的交互作用,從而提高了性能,改善了模型的解釋性。

(3)將道路信息圖處理后得到的可達網格圖作為先驗知識輸入到模型中,引導TPT模型學習道路信息圖中的可行駛道路區域,提升了TPT的預測精度。

(4)在未來的工作中,探索將TPT模型擴展到同時對多個交通智能體進行軌跡預測,進一步提升預測的效率。此外,TPT模型僅對交通智能體進行了單模態軌跡預測。考慮到軌跡預測的多模態性,將對TPT模型進行改進,使其能夠為交通智能體提供多條可能的預測軌跡。