基于知識圖譜使用多特征語義融合的文檔對匹配

陳毅波,張祖平,黃鑫,向行,何智強

(1. 國網湖南省電力有限公司,湖南 長沙,410004;2. 中南大學 計算機學院,湖南 長沙,410083)

識別文檔對的關系是一項自然語言理解任務,也是文檔查重和文檔搜索工作必不可少的步驟。人工區分文檔需要花費大量的人力資源成本,而早期文檔識別方法主要基于術語相似度和規則。傳統的基于術語如TF-IDF 向量、BM25、LDA 的匹配方法通過無監督指標評估文檔對之間的語義信息[1-4],在查詢文檔、檢索和搜索信息方面該方法取得了較大的成功,而基于規則的模型的穩定性取決于構建的知識結構。此外,基于機器學習的文檔識別方法主要思想是將文檔分成多個類別,然后進行分類以進行檢索,在新聞報道、文獻查重等領域也取得了很好的識別效果[5]。

目前,文檔表示方法主要包括詞袋(BOW)[6]、詞頻逆文檔頻率(TF-IDF)[1]、隱含狄利克雷分布(LDA)[3]等向量,但是這些表示方法無法捕獲語義信息,通常無法獲得良好的性能。為了更好地捕捉語義關系,研究人員提出了圖形文檔表示[4],現有的大多數圖形文檔表示主要有詞、文本、概念和混合圖4 類[4]。在單詞圖中,文本中的單詞作為頂點,通過句法分析、共現[4]等方法構建邊;在文本圖中,句子、段落或文檔都被視為頂點,詞共現、位置[7]、文本相似性被用來構建邊。

近年來,研究人員提出多種用于文本匹配的深度神經網絡模型[8-9],可以通過遞歸或卷積神經網絡來捕捉自然語言中的語義依賴(尤其是順序依賴)關系,其中,WAN 等[8]提出了一種多語言通用的BiLSTM-CRF 模型,利用詞嵌入作為特征來識別命名實體;羅凌等[9]使用了CNN 與CRF 相結合在中文電子病歷上做命名實體識別研究;趙宏等[10]所提出的BiLSTM-CNNs模型在中文評論數據集上實現了92.64%的F1 值;SHEN 等[11]提出了一種基于命名實體識別的方法運用在深度主動學習上,幫助深度主動學習在醫學和影像領域也取得了很大的成果[12],與深度學習方法相比,它只需要少量的訓練數據即可獲得相同的效果。然而,這些神經網絡模型沒有充分利用長文本文檔固有的結構特征。BERT預訓練模型[13]可以用于長文本匹配,但是模型復雜度高,難以滿足實際應用中的速度要求。

然而,現有的涉及句子對匹配的深度模型主要用于釋義識別、文檔中的答案選擇、實體或較長文檔中句子之間復雜的交互[8]等文檔匹配,但它并沒有被充分研究。其中,長文檔間的語義匹配在很大程度上是一個未開發的領域,盡管有很多用于句子匹配的數據集[9],但沒有用于匹配長文檔的公共標簽數據集。

為了對長文檔的語義匹配進行評估,本文首先構建了2個帶標簽的數據集,一個是已標注項目可研文檔對(來自不同項目)是否屬于同一個項目,另一個是已標注文檔對是否屬于同一個主題,將DBPEDIA 等知識庫[14]中的專業術語鏈接到實際中的文檔匹配,通過捕獲文檔中的專業術語以構建概念圖。在此基礎上,提出了一種后端匹配算法,以概念圖的形式表示和匹配長文檔,基于構建的概念圖(concept graph,CG)和圖神經網絡(graph convolution network,GCN)來匹配一對文檔,其思想是對于兩個文檔中出現的每個概念頂點,首先獲得一個局部匹配,然后采用GCN 將局部匹配向量聚合為最終匹配結果,該結果基于圖的整體視圖通過一系列文本編碼方案(包括神經編碼和基于術語的編碼)生成。最后,對于關鍵字識別,提出了一種基于概念的多特征語義融合模型(multifeature semantic fusion model,MFSFM),引入上下文多特征嵌入(contextual multi-feature embedding,CMFE)結構來優化文本表示。

1 模型構建

1.1 概念圖

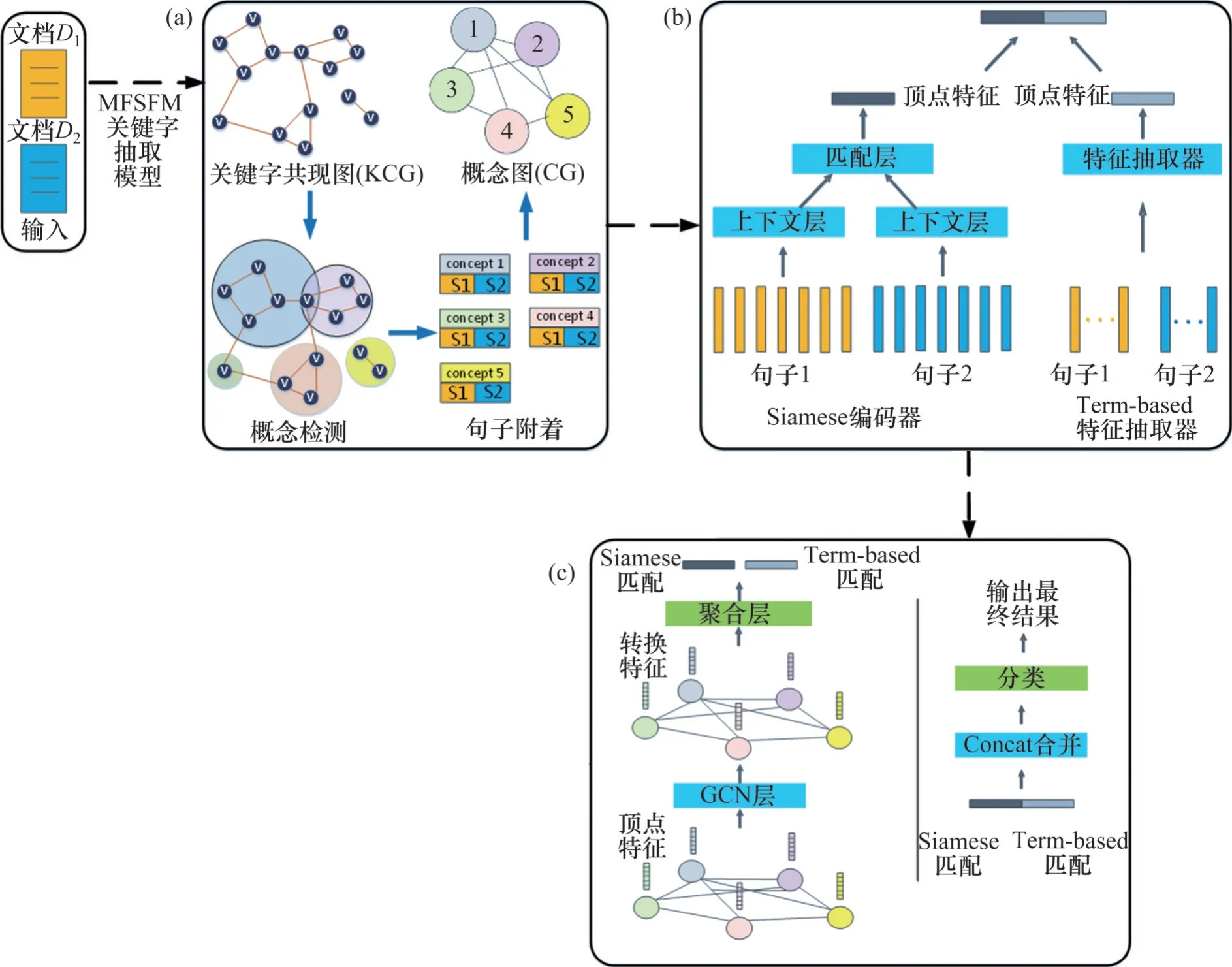

本文采用概念圖將文檔表示為無向擴展圖。將文本轉化為概念圖的示意圖如圖1所示。

圖1 將文本轉化為概念圖的示意圖Fig. 1 Schematic diagram of converting texts into a concept graph

首先,將文檔分解為句子的子集,每個句子與其產生的概念進行對齊。比如在文檔D中,概念圖GD是一個關鍵字或一組高度相關的關鍵字[4]。在概念圖中,先將關鍵字分組為概念,然后將每個句子附加到其最相關的概念頂點[4]。例如,在圖1 中,句子1 和句子2 主要討論“變壓器”和“電氣設備”的關系,因此被附加在概念(變壓器、電氣設備)之后。總的來說,本文基于知識圖譜使用一個包含關鍵字信息的概念圖來正確地表示原始文檔。每個概念圖都有一個句子的子集和它們之間的拓撲關系。從文檔對構建概念圖并通過GCN對其進行分類的方法概覽如圖2所示,它詮釋了概念的發現、概念與句子的對齊方式和文檔概念圖的構造過程。拆分文檔以及合并概念圖的步驟如下。

圖2 從文檔對構建概念圖并通過GCN對其進行分類的方法概覽Fig. 2 Overview of the method of constructing CG from document pairs and classifying them through GCN

步驟1) 構建關鍵字共現圖。給定一個文檔,應用命名實體識別方法提取命名實體和關鍵字,并且基于找到的關鍵字集構建一個關鍵字共現圖(keyword co-occurrence graph,KCG),其中每個關鍵字代表一個頂點。如果2個關鍵字同時出現在同一個句子中,則構建一條邊將它們連接起來。為了進一步改進模型,還可以通過共同實體分析和同義詞分析來組合具有相同含義的鍵。

步驟2) 概念檢測。KCG 的架構揭示了關鍵字之間的交互關系。當2 個關鍵字的集含高度相關時,就可以在KCG中構建一個密集連接的子圖[4]。此外,使用社區檢測算法可以將KCG 劃分為一組社區,其中每個社區包含某個概念的關鍵字集合。由于每個關鍵字可能出現在多個概念中,且不同文檔中的概念數量差異很大,本文使用一種基于介數中心性得分的算法[15]檢測KCG 中的關鍵字社區,而且每個關鍵字都可直接作為一個概念來使用,因此,概念檢測的優點是減少了頂點的數量,增加了匹配速度。

步驟3) 句子附著。通過捕獲文檔關鍵字來發現概念后,按概念對句子進行分組,然后計算句子和概念之間的余弦相似度,并且使用TF-IDF 向量表示[1]。不包含概念匹配的句子將被附加到虛擬頂點。虛擬頂點不包含任何關鍵字。

步驟4) 構建邊。通過在概念之間放置邊來體現概念之間的關系,對于每個頂點,將其句子集表示為與其相連的一系列句子,并使用TF-IDF 相似度計算兩者之間的邊權重。雖然可以使用其他方式來確定邊的權重,但是通過TF-IDF 構造邊更好,這樣生成的概念圖的連接更緊密。

1.2 文檔對匹配

對于給定的2個文檔DA和DB,首先匹配DA和DB中與每個概念相關的句子集;然后,分別采用Siamese 編碼器和Term-based 特征抽取器匹配該文檔對[4]得到局部匹配結果并通過多個圖卷積層將局部匹配結果聚合成最終結果。為了克服以往算法的缺點以及在較長的文本中捕獲更多的語義交互,本文從圖形角度來表示文檔。

圖2 所示為基于MFSFM 的文檔對匹配模型的整體架構,包括4個步驟:1) 通過單個合并的概念圖表達文檔對;2) 研究每個概念頂點的多視圖匹配特征;3) 進行結構化轉換,通過GCN 獲得局部匹配特征;4) 對局部匹配特征進行分組得到最終結果。以上4個步驟以端到端的方式進行訓練。

對于給定分組后的概念圖GAB,所提出的模型首先為每個概念v(v∈GAB)學習一個固定長度的匹配向量,以表示文檔DA和DB的句子集CA(v)和CB(v)之間的TF-IDF 語義相似度。這意味著將兩個文檔匹配轉換為每個頂點的句子集對匹配。進一步地,基于術語的技術和神經網絡生成局部匹配來聚合匹配向量。Siamese 網絡編碼器[15]被應用于每個頂點v,將{CA(v),CB(v)}的詞嵌入轉換為固定大小的隱藏特征向量mAB(v)。

首先,采用Siamese 編碼器將CA(v)和CB(v)分別編碼成上下文向量tA(v)和tB(v)。采用包含1個或多個BiLSTM 或CNN 層的神經網絡來學習CA(v)和CB(v)中的上下文信息。然后,通過后續聚合層[4]來計算頂點v的mAB(v)。分別計算上下文向量tA(v)和tB(v)的逐元素乘法以及逐元素絕對差,并拼接成mAB(v),即

其中:“?”表示Hadamard積[2]。

在采用Term-based 特征抽取器匹配文檔時,綜合4種計算指標(TF-IDF余弦相似度、TF余弦相似度、BM25 余弦相似度和1-gram 的Jaccard 相似度)來計算CA(v)和CB(v)之間基于術語的相似度,作為v的另一個匹配向量m′AB(v)。

一般而言,圖G=(V,E)被認為是GCN 的輸入,其中,V和E分別為頂點和邊的集合,第i個頂點vi∈V,第i和j個頂點連成的邊eij=(vi,vj) ∈E。另外,GCN 輸入中包含頂點特征矩陣其中,fi是頂點vi的特征向量。那么,文檔對DA和DB的概念圖GAB包含了GCN 中每個頂點的連通匹配向量,因此,fi可以表示為

本文所設計的GCN 層如圖2(c)所示。概念圖GAB的加權鄰接矩陣為A?RN×N,矩陣A中的元素Aij為頂點i和j的TF-IDF相似度。以為元素構建對角矩陣,其中,為概念圖GAB的度矩陣,為A的鄰接矩陣。GCN 的輸入層為H(0)=X,原始頂點特征被包含在H(0)中。記H(l)?RN×Ml為第l層的隱藏表示矩陣,每個GCN 層將運用以下圖卷積濾波器來學習隱藏表示:

在概念圖GAB上,一階局部譜濾波器的近似利用了圖卷積規則[16]。在遞歸過程中,首先提取頂點之間的交互模式[4],然后根據獲得的最后一層所有頂點的隱藏向量的平均值,在GCN 層合并該平均值為一個固定長度的向量,最后,使用諸如MLP的分類器來計算基于mAB(v)的最終匹配分數。

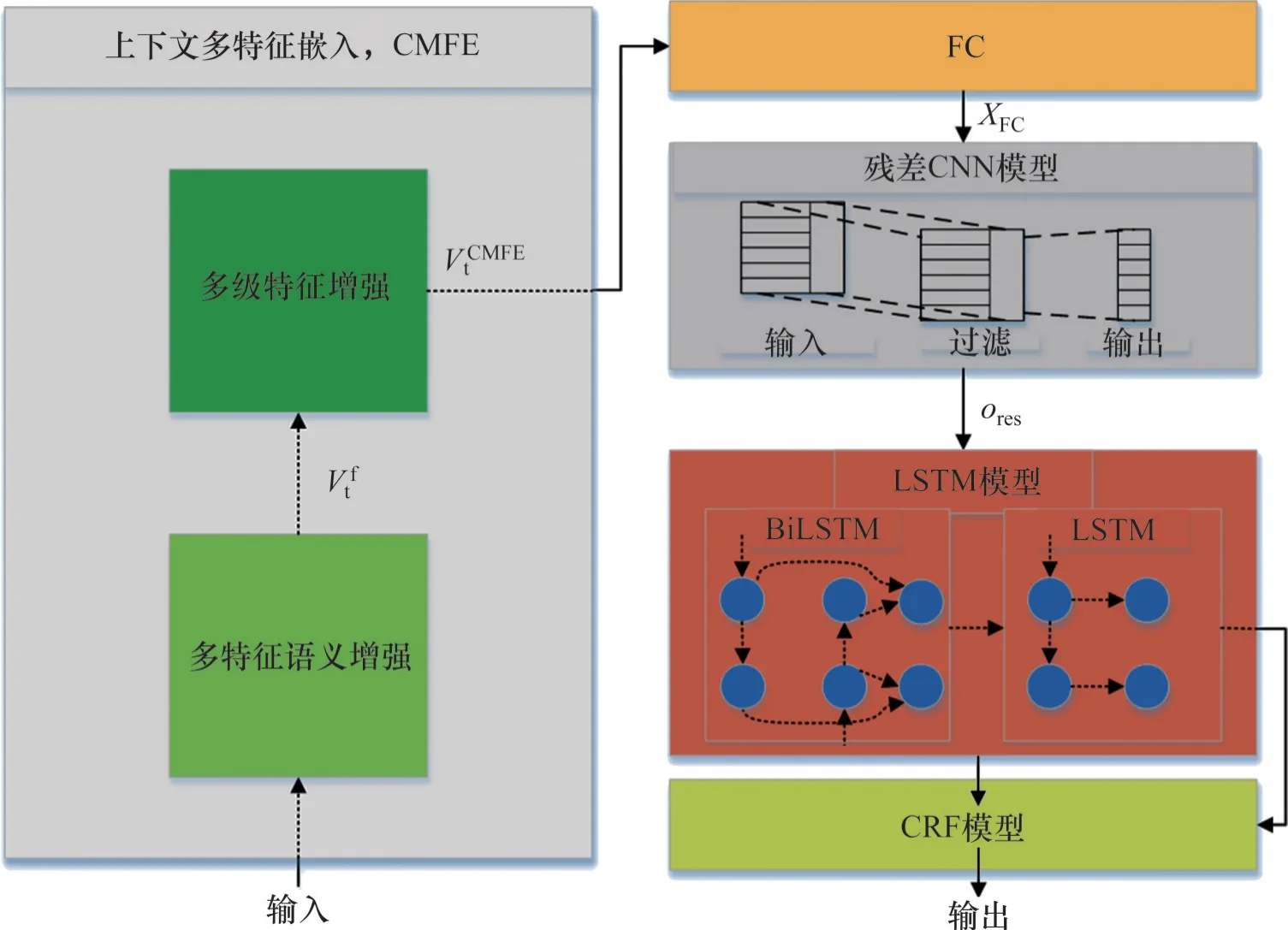

1.3 MFSFM模型

本文提出了MFSFM模型來改進文檔的關鍵字表示,MFSFM 的架構如圖3 所示。首先,設計了一個基于上下文的多特征語義融合(contextual multi-feature embedding,CMFE)結構來編碼上下文獲取的表達語義信息的詞向量;其次,考慮到關鍵字實體邊界的不確定性,構造了一個多卷積核混合殘差CNN 模塊來獲得局部注意力和實體邊界信息;第三,采用一個由BiLSTM和單向LSTM組成的LSTM模塊來增強時序信息學習;最后,采用CRF模塊來識別關鍵字實體。

圖3 多特征語義融合(MFSFM)架構示意圖Fig. 3 Schematic diagram of multi-feature semantic fusion (MFSFM) architecture

利用Word2Vec 技術編碼文檔作為MFSFM 的輸入。Word2Vec 可以將每個單詞表示為一個低維向量,以便壓縮數據規模,加快編碼速度,使模型更容易學習。此外,所構建的文檔數據集不僅具有字符(詞)特征,還具有詞性特征和相對位置特征,本文提出CMFE 方法來學習這兩種特征。CMFE 方法主要包括多特征語義增強(multi-feature semantic enhancement)和多級特征增強(multi-level feature enhancement)兩個過程,其示意圖如圖3所示。

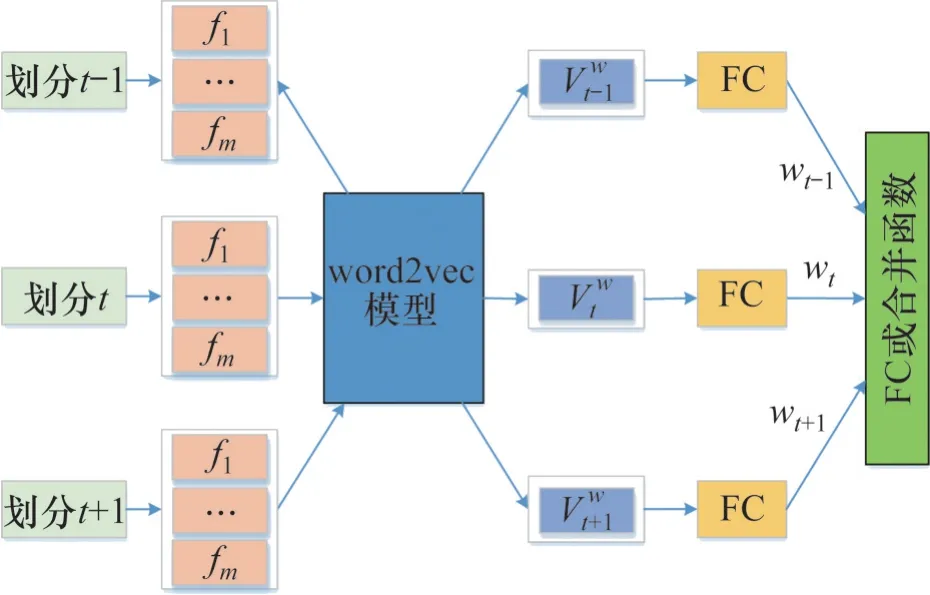

多特征語義增強過程示意圖如圖4所示,其步驟如下。

圖4 多特征語義增強(以n=3為例)示意圖Fig. 4 Schematic diagram of multi-feature semantic enhancement (taking n=3 as an example)

1) 使用Word2Vec 技術得到數據集中每個特征的詞向量矩陣Wfi,i=1,2,…,m(m代表特征個數)。

2) 將每個劃分中的特征輸入到矩陣Wfi,i=1,2,…,m,并得到對應的特征向量。由于每個劃分中的特征可以被訓練以反映不同特征的語義信息,因此,使用全連接(full connected,FC)層進行加權求和得到加權詞向量(沒有偏置向量)。

令當前時隙t的每個特征向量為Vt,i(i=1,2,…,m),FC 層每個特征向量權重為wt,i,i=1,2,…,m,與當前時隙t有關的加權詞向量Vtw可以由下式計算:

式中:“⊙”為逐元素乘法運算符號。

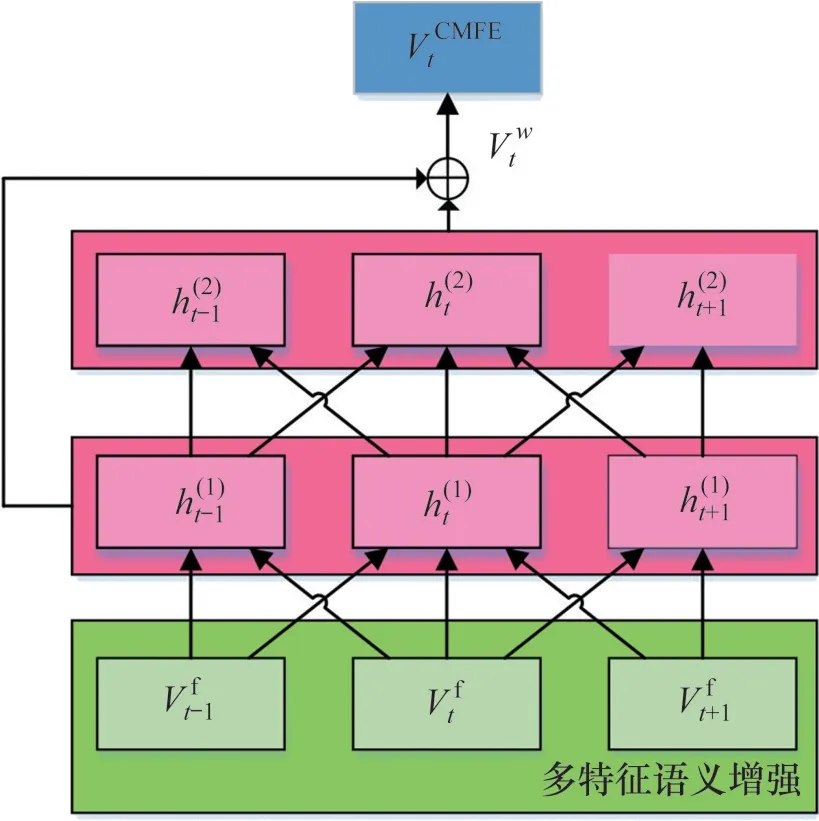

3) 采用窗口數n表征上下文的語義信息的相關度,使用FC層(無偏差向量)將n個分區加權詞向量拼接起來。記最大分割數為T,當前時隙為t,則窗口數為n時,FC 層的權重為wt+k,0 因此,當使用FC 層獲取詞向量時,多特征語義增強向量Vtf為 當使用拼接操作獲取詞向量時,多特征語義增強向量Vtf為 式中:“Σ⊕”為累積串聯運算。 考慮到多特征語義增強只提取淺層特征,本文并沒有捕捉數據劃分之間的深層特征。為了用詞向量矩陣來表達數據的語義信息,本文利用CNN 網絡中的卷積操作通過擴大感受野來獲得數據劃分的相關信息。因此,多級特征增強使用了兩層CNN 網絡(使用一維卷積)將兩層特征向量與多特征語義增強向量進行拼接得到CMFE 向量,如圖5所示。 圖5 多級特征增強(以n=3為例)示意圖Fig. 5 Schematic diagram of multi-level feature enhancement (taking n=3 as an example) CMFE方法的輸出向量VtCMFE定義為: 其中:“⊕”為拼接操作,h(t1)和h(t2)分別為一維卷積輸出的1級和2級特征向量。 CMFE方法可以得到每個劃分數據的詞向量表示,利用多特征強化語義信息和簡單的CNN 網絡強化層次信息,使得后續的學習過程更容易。 為了評估所提出的MFSFM方法的有效性,將MFSFM方法應用于項目申報中的項目查重,并與現有的模型進行對比,其中,基于DNN 模型包括ARC-I[17]、 ARC-II[17]、 DSSM[18]、 DUET[19]和Matchpyramid[20]模型;基于術語的相似性模型包括BM25[2]、LDA[3]和SimNet,以及基于大規模預訓練語言模型BERT[13]。 為了更好地匹配長文本,在所提出的方法中,任何短文本信息(如短標題、圖表標注、停用詞等)都被遺棄,但保留關鍵文檔信息的短文本(例如文章標題)。 對于匹配長文檔任務,沒有公共數據集可供使用。為此,本文構建了中文可行性研究同項目數據集(Chinese feasibility study same project data set,CNSR)和中文可行性研究同主題數據集(Chinese feasibility study same subject data set,CNSI)2 個數據集,包含從中國湖南國網電力有限公司收集的約500份長篇可行性報告文件,涵蓋公司各個領域的多個主題。這些數據集均由相關領域專家進行輔助標記。其中,CNSR 數據集包含4 678 對帶標記的可行性研究報告,標記了每對文檔是否為同一領域的項目;CNSI數據集包含2 464對帶標記的可行性研究報告,標記了每對文檔是否屬為同一主題。數據集中所有文檔的平均單詞數為9 034 個,最大值為32 461 個。在CNSR 和CNSI 數據集中,使用樣本的70%作為訓練集,15%作為驗證集,剩下的15%作為測試集。表1所示為CNSR 和CNSI 數據集的詳細分類。在這些數據集中,只標注了可行性研究報告的主要研究項目,同時需要保證不同的分割不涵蓋重復數據,避免數據泄露。本文選擇包含相似項目(關鍵字)的項目文檔對,并排除TF-IDF 相似度低于某個閾值的樣本,不會隨機生成兩個數據集中的負樣本。 表1 CNSR和CNSI數據集的詳細分類Table 1 CNSR ans CNSI evaluation dataset detailed classification 采用二分類的準確率以及F1-measure 值評估模型的文檔對匹配性能。對于每種評估方法,進行20個epoch的訓練,然后選擇測試集的最優值作為最終結果。 采用文獻[10]中提出的BiLSTM-CRF模型作為關鍵字實體識別模型,并將本文所提出的CMFE與CBOW和Skip-gram進行比較。其中,CBOW和Skip-gram 算法的參數設置如下:上下文窗口數n不同之處為5,負樣本數為10,詞向量大小為128。CMFE 的參數設置與CBOW 和Skip-gram 算法的設置相同,其中,一組64 維詞向量用于多特征語義增強,窗口數n=3;另一組64 維詞向量用于多級特征增強,卷積核大小為3。使用Stanford CoreNLP進行分詞(中文文本)和命名實體識別,對于帶有社區檢測的概念交互圖構建,將最小社區大小(概念頂點中包含的關鍵字數量)設置為2,最大社區大小設置為6。 本文的神經網絡模型包括詞嵌入層、Siamese編碼器、圖卷積層和分類層。在Siamese 編碼器中,依次使用1維卷積和64維全連接層、ReLU和Max Pooling 操作對概念圖進行編碼表示。在圖卷積層中,使用3 層GCN[16]對CNSS 數據集和CNSE數據集進行文檔匹配,當頂點編碼器有4 維特征時,GCN 層的輸出大小設置為32;當頂點編碼器是Siamese 編碼器時,將GCN 層的輸出大小設置為128。在最后的分類層中,有一個輸出大小為32的線性層和一個ReLU層。使用tensorflow 2.0來實現基于MFSFM 的匹配算法。在神經網絡模型中,采用正則化項L2對所有可訓練變量使用權重衰減,正則化參數λ設置為2×10-6。網絡損失率設置為0.005。使用最大梯度范數為5.0 的梯度裁剪,ADAM 作為優化器,其中,第一動量梯度下降因子β1=0.85,第二動量梯度下降因子β2=0.99,除零誤差ε=1×10-8。在前1 500 步中,網絡學習率呈指數衰減,衰減幅度設為0~0.001,然后在其余步驟中保持恒定的學習率,最大訓練epoch 數設置為20。 不同識別方法在2個數據集上的識別性能如表2所示。從表2可以看出,在關鍵字實體識別方面,CMFE 模型的準確率和召回率明顯比其他方法的高。 表2 不同識別方法的識別性能對比Table 2 Comparison of performance for different textual representations CMFE通過數據集中的多個特征進行多特征語義增強,再通過CNN網絡進行多層次的特征增強。所提出的MFSFM在兩個數據集上都實現了最佳識別性能,并且明顯優于其他方法的識別性能。這是因為兩個文檔在知識圖譜化后是沿著對應的語義單元對齊的,從而便于概念比較,而且所提出的MFSFM 對實體上下文周圍的語義信息進行編碼,并通過圖卷積來聚合它們。因此,基于MFSFM的匹配算法通過圖形化文檔的方式解決文檔匹配問題,適用于處理長文本。 不同方法在CNSR 和CNSI 數據集上的準確率和F1值比較如表3所示。從表3可見:本文所提出的模型在CNSR 和CNSI 數據集上的分類精度分別提高了13.67%和15.83%。 表3 不同方法在CNSR和CNSI數據集上的準確率和F1值比較Table 3 Comparison of accuracy and F1 value of different methods on CNSR and CNSI datasets CG-Siam 模型和MatchPyramid 模型具有相同的詞向量,均使用神經網絡(NN)對文本進行編碼,但CG-Siam模型以逐頂點分解的方式比較了CG上的文檔對,對比可知:CG-Siam模型的匹配性能優于MatchPyramid 模型的匹配性能。同樣,將本文CG-Sim模型與SimNet模型進行比較,兩者都應用基于術語的相似性,可見,本文的方法的匹配性能大大優于SimNet 算法。這是因為圖形分解可以顯著提高長文本的匹配性能,而SimNet 模型的主要是為了匹配序列而發明的,無法在項目文檔對中獲得有意義的語義信息。當上下文太長時,匹配文檔對很難獲得較好的上下文表示。對于專注于交互的NN模型,單詞之間的大多數交互對于兩個長文檔來說是沒有意義的。 分別對比CG-Siam-GCN 和CG-Siam 模型、CG-Sim-GCN和CG-Sim模型可知:通過合并GCN層,2個數據集的匹配性能均顯著提高。GCN通過整合每個頂點及其相鄰頂點來更新隱藏向量,將局部匹配特征聚合成最終結果。 分別對比CGc-Siam-GCN 和CG-Siam-GCN 模型、CGc-Sim-GCN 和CG-Sim-GCN 模型可知:社區檢測技術會帶來短暫的性能降低,這是因為直接使用關鍵字的概念頂點可以提供更多錨點來比較文檔對。一致的關鍵字可以通過社區檢測高度分組在一起,CG的平均大小可以從35個頂點減少到16 個,基于MFSFM 的匹配算法的總訓練時間可以減少53.6%。因此,可以選擇使用社區檢測來降低準確性以提高算法速度。 CG-Sim&Siam-GCN模型的匹配性能明顯優于CG-Sim 模型的匹配性能,這證明了連接多視圖匹配向量可以捕獲更多的文檔關鍵信息,提高匹配度。從表3可見:全局特征越多的算法總是表現不佳。這是因為這些文檔對的相似性和/或BERT 編碼的全局特征相對于本文所提出的概念圖,缺乏對文檔核心語義的理解。提高匹配性能的主要因素是圖的分解和卷積,模型在全局語義關系中綜合了局部比較信息,而多余的全局特征會干擾模型的訓練。 在實驗中,沒有BERT 的最大模型是CGSim&Siam-GCN-Simg,它只包含大約54 000 個參數,而BERT 中有130~340×106個參數。此外,本文在模型中對不同參數的敏感性進行了測試,可以發現含2~3 個GCN 層的模型的匹配性能最好,增加更多的GCN 層不能提高模型的匹配性能,但如果不含GCN 或只有1 層GCN,模型匹配性能最差。另外,GCN層中隱藏層向量大小在32~256之間具有最佳性能,并且更大的尺寸不會提高性能。當構建CG 時,需要為可選的社區檢測步驟選擇社區的大小,如果最大尺寸為8~10,最小尺寸為2~3,性能會更差。這表明所提出的基于MFSFM的匹配算法是穩定的,即對參數并不是很敏感。總而言之,本文所提出的基于概念圖的模型優于其他算法。 根據實際復雜度的定義,社區檢測的時間復雜度為O(q3),構建關鍵字圖的時間復雜度為O(rp+q2),句子附著和計算權重的操作時間復雜度為O(rp+p2),其中,r表示2 個文檔數據集中句子的數量,p表示句子中單詞的數量,q表示句子中關鍵字的數量。由于本文構建的文檔中關鍵字數量q很小,因此,整體時間復雜度很小,模型的收斂速度快。 1) 針對文檔的關鍵字提取,提出了多特征語義融合模型MFSFM 來捕獲關鍵字。與基于RNN的序列建模相比,MFSFM通過多特征語義增強組件更關注實體的上下文語義信息。 2) 提出一種后端匹配算法,通過構建關鍵字共現圖,并應用社區檢測算法檢測概念以概念圖的形式來表示文檔,并利用圖卷積神經網絡進行文檔對匹配。 3) 本文所提出的模型在CNSR 和CHSI 數據集上的分類精度分別提高了13.67%和15.83%,同時可以實現快速收斂,而且本文所提出的后端匹配算法可以很容易地實現,并應用于其他文檔數據集。

2 模型驗證與分析

2.1 數據集

2.2 實驗參數設置

2.3 結果與分析

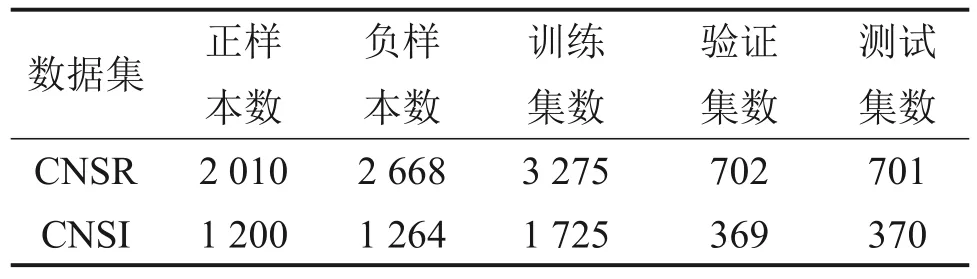

4 結論