一種遙操作場景下的混合現實視覺增強交互系統

施樂洋,李曉玲,王龍,陳漳沂,鄭帥

(1. 西安交通大學機械工程學院,710049,西安; 2. 西安交通大學電子與信息學部,710049,西安)

隨著自動化控制、自然人機交互、信息通信等技術的快速發展,面向遙操作環境的高度智能化與自主化的機器人系統在高風險任務中發揮著越來越重要的作用[1]。同時,遙操作技術也被廣泛應用于排雷排爆[2]、搜索救援[3]、高空作業[4]、水下探索[5]和太空探索[6-7]等極端復雜環境中。在這些應用領域里,機器人往往要代替人們進入危險環境,因此需要重點研究的是該如何賦予機器人以近似人類的感官系統和認知能力,從而能夠直觀地在操作員端再現遠端場景[8]。

研究表明,在人類的5種感官系統中,視覺的神經元數量以及信息傳輸率要遠高于其他感覺模式[9]。從某些程度上來講,人類大腦的一半以上直接或間接地用于處理視覺影像,視覺信息的處理又支配著來自其他模態信息的處理,由此可見視覺信息的正確反饋對于人類的重要性[10]。然而,目前大多數遙操作系統都是通過2D顯示器提供視覺模態的反饋,在這種方式的遙操作過程中,存在著大量的用戶操作失誤以及設備自身的人機交互問題[11]。

混合現實技術是一種將視覺作為最重要的輸入通道之一的交互技術,多年以來,混合現實中的人機交互研究一直在探索更加自然和高效的交互方式[12-13],旨在通過其立體、多維的場景輸入[14]改善傳統系統中的人機矛盾。目前,混合現實技術已經開始應用于遠程醫療手術[15]、太空艙外作業[16]以及排雷排爆等較為特殊的使用場景。在這些應用場景中,用戶均可以借助空間信息和直觀的交互技術(如手勢),來實現交互數據可視化或多模式遙操作,并可以實時獲取真實操作狀態信息,幫助自身保持高度的情景意識。因此,混合現實技術在提升操作系統的人機交互與協作效率方面具有巨大潛力。針對遙操作機器人這一場景,Su等提出了一種基于混合現實視覺和觸覺反饋方法的焊接方案[17],并用于遙控機器人焊接。該方案由機器人工作區域進行混合現實視覺反饋,同時通過混合觸覺約束,引導操作員的手部沿混合現實標注導向移動,并將焊接操作限制在無碰撞區域內。這種允許用戶進行沉浸式交互的設計方案,具有以用戶為中心、將觀察視角和態勢感知相結合的特點,可以使操作系統快速理解人類指令,豐富了人機協作的應用場景及范圍[18-19]。除此以外,華南理工大學的研究團隊利用Leap Motion體感控制器對操作者的手部動作進行檢測[20],并將其轉化為機器人的控制指令,通過混合現實技術對機器人的作業場景進行實時的視覺反饋,以確保操作的安全性和效率,提高了人機交互體驗[21]。Livatino等基于混合現實技術設計了一種組織信息呈現方法和一套視覺輔助工具,通過在用戶界面中使用混合現實和視覺輔助工具,向用戶呈現傳感器數據,以促進遠程操作控制面板中數據的視覺通信,不僅提高了操作員態勢感知能力,還加快了決策速度[22]。

上述研究現狀表明,混合現實技術在遙操作交互領域具有很大的應用價值,但現有研究往往單獨著眼于改進系統的某一個方向,如視覺反饋、交互反饋等;在進行系統整體設計時,仍沒有脫離傳統系統的設計思路;在進行交互任務時,由于各部分的混合現實程度不一,使用效率并沒有得到較大的提升;而且,混合現實場景下的臨場感往往比較低,交互性能不高。因此,本文基于以上研究內容與技術背景,面向遙操作應用場景,利用混合現實技術在人體視覺認知以及人機協作方面的優勢,設計了一種視覺增強交互系統架構,以滿足遙操作過程中操作員的交互需求;然后,采用攝像機到HoloLens(一種混合現實顯示設備)的端到端視頻傳輸方法,實現了遠程視景的實時呈現;通過研究混合現實場景下遙操作主端的交互流程與技術實現,建立了基于循環坐標下降逆運動學法的機械臂虛擬交互模型,通過虛實融合技術為遙操作機器人提供了一種可視化效果較好的交互控制方案,解決了目前主從式遙操作系統缺乏臨場感、交互性能差的問題,對系統的安全性、穩定性起到了很大的促進作用。

1 混合現實視覺增強交互系統設計

1.1 混合現實遙操作交互需求分析

當前的遙操作系統,尤其是排雷機器人系統(本文主要探討這一背景),操作員通常是通過顯示屏或傳統屏幕(如移動設備、平板電腦或筆記本電腦等)觀看機器人端攝像頭返回的實時視頻流。在這種情況下,操作員只能看到二維的圖像信息,明顯缺乏臨場感知[23]。另外,傳統的排雷系統中使用的搖桿、手柄、鍵鼠等遙控設備限制了交互的空間,通常情況下,遠端機器人的控制操作與視覺反饋兩個模塊呈現相互獨立的態勢。在實際作業與交互過程中,操作員不僅要實時關注機器人端攝像頭畫面,還需要實時獲取機器人的運動姿態并進行遠程操作,即操作員必須在視覺反饋區域和控制區域之間不斷進行切換,這樣不僅會導致注意力分散,而且是不自然和低效的[24-25]。基于上述問題,本文重點研究了如何利用混合現實技術提供一種新型的沉浸式視覺反饋與交互系統,以解決現有系統視點跳躍、交互區域不統一的問題。

從遙操作作業存在的問題和實際需求出發,可以總結出本系統的功能需求如下。

(1)遠程視景實時呈現:用戶的首要需求是通過實時視頻流信息來感知遠端環境,因此該系統的主要功能就是采集與傳輸實時畫面,且實時地呈現在用戶面前。

(2)人機自然交互:在人機交互過程中,遠程機械臂的交互控制需要納入混合現實交互場景中,以實現視線交互區域與遙控操作交互區域相統一。

(3)虛實融合:在遙工作場景中,將混合現實全息對象和真實的環境元素結合在一起,從而增強交互場景的視覺體驗。

非功能需求主要針對軟、硬件環境與應用場景,具體包括如下內容。

(1)系統開發平臺:Windows平臺,不需要大量的存儲空間,系統盡量小巧。

(2)用戶需求:用戶需具備基本的計算機作業經驗與能力,且在不熟悉計算機操作和混合現實系統的條件下,能做到快速學習并很好地適應。

(3)環境條件:應當盡量避免強光,以適用于設備采集到合適亮度的視頻為準。混合現實顯示設備也同樣不適用于強光環境。

總體來說,通過混合現實技術改變傳統的第三人稱視角觀察的多視頻流傳輸,有助于理解操作的上下文。此外,交互系統能為用戶提供直觀、立體的混合現實機械臂交互控制方式,使其更加身臨其境并得到自然的交互體驗。

1.2 視覺增強交互系統總體架構

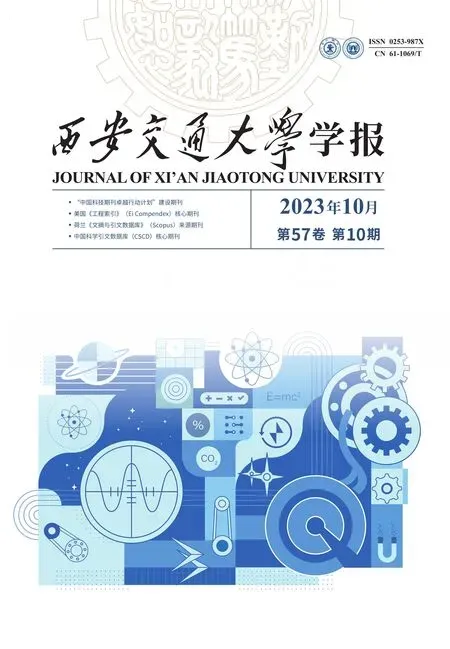

綜合以上需求分析,本文提出了一種新的視覺增強交互系統框架,采用“視頻視角”的混合現實顯示方案,將機器人端返回的視頻信息視為真實世界,將混合現實場景中的全息對象用于遠程機器人控制,并在數字化視頻流上完成混合現實的工作。該方法將視覺反饋區域與控制區域集成一體,最終呈現出一套完整的基于混合現實的閉環遙操作交互系統。此系統從三維顯示和自然交互的角度出發,在為操作員提供實時、準確、有效的作業場景信息的同時,實現了立體直觀的交互控制指令反饋。所設計的系統結構框架如圖1所示,主要分為主動端的操作員站和從動端的機器人作業站,二者通過無線自組網設備實現遠程通信。

圖1 遙操作視覺增強交互系統框架Fig.1 Teleoperation vision enhancement system frame

主動端為操作員、頭戴式顯示器、本地計算機等組成的操作員站。在本地計算機上建立一個混合現實場景,該場景包括立體視覺顯示和人機交互界面,可以直接給操作員提供立體可視化的遠端場景和交互界面,操作員通過頭戴式顯示器,在安全環境中實時、準確地觀察機器人姿態并完成交互控制任務。從動端為遙操作機器人、圖像采集設備、云臺等組成的機器人作業站。主動端和從動端通過自組網設備進行通信,自組網設備內嵌有視頻流傳輸協議,能夠把攝像頭采集到的圖像發送回主動端,在作業任務時提供輔助參考給操作員。交互系統按功能可分為真實層、虛擬層和交互層,其中也包括了作業場景采集系統、終端虛實顯示系統、跟蹤注冊模塊、虛實融合模塊等,其工作步驟如下。

步驟1真實層的作業場景采集系統首先讀取攝像機采集到的實時流協議(RTSP)視頻流,再對其進行編解碼,從而獲得實時圖像信息。

步驟2通過計算機終端的虛實顯示系統,完成虛擬圖像渲染與柵格化,生成虛擬層的虛擬信息。

步驟3跟蹤注冊模塊完成對攝像機視野和視角的跟蹤,生成相關的位置、坐標等信息,同時將虛擬層的數字信息與真實環境相匹配,實現虛擬層與真實層的融合。

步驟4將整合后的信息輸出至頭戴式顯示器,為操作人員提供視覺反饋和機器人控制界面,然后操作員與虛擬模型進行交互,完成遙操作任務并發出控制指令。

2 關鍵交互技術研究

2.1 遠程視景實時呈現

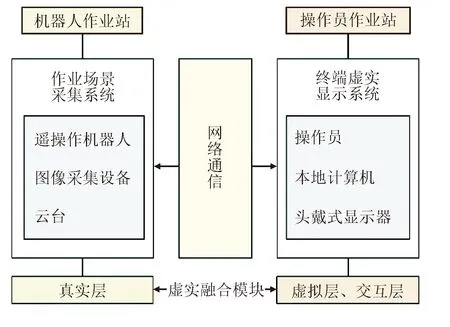

混合現實交互系統首先需要實現的一個功能就是通過攝像機捕捉或記錄近端任務環境,與此同時,遠程用戶在混合現實頭盔(HMD)上獲得近乎實時的視頻流。攝像機-HoloLens端到端視頻傳輸實現方法如圖2所示,首先設置流媒體通道,用于發布視頻輸出、編碼視頻和發布視頻流,然后在全息應用程序中將這個視頻流通道部署至HoloLens。

圖2 攝像機-HoloLens端到端視頻傳輸實現方法Fig.2 End-to-end video delivery implementation methods

圖像傳輸的流程如圖3所示,可通過自定義服務器端和遠程客戶端傳輸與接收的數據類型,提高網絡通信過程中的穩定性。

圖3 圖像傳輸流程Fig.3 Image transfer flowchart

采用2個網絡協議(IP)攝像頭采集遠端場景,分別獲取遠端整體抓取場景的全景圖像以及手部抓取的特寫圖像。在圖像數據的無線傳輸過程中,圖像幀率為30 Hz,分辨率為1 920×1 080像素。另外,為了減小數據傳輸量,在獲取實時圖像后將數據壓縮為JPEG格式,并根據自定義的傳輸類型進行打包發送。服務器端程序流程如圖4所示,遠程客戶端負責接收圖像數據,并將其解包、解碼后在混合現實場景中實時顯示。

圖4 服務器端程序設計流程Fig.4 Server-side programming

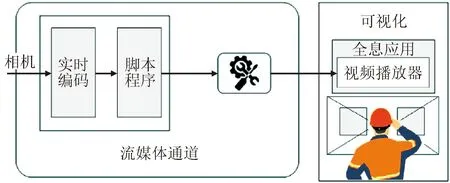

本文基于Unity3D軟件實現實時視頻播放功能,但由于其原生視頻播放器僅支持本地視頻文件的播放,因此為了將外部世界的IP攝像頭輸入到開發環境中,使用Universal Media Player 插件搭建了一個可以播放RTSP實時視頻流的場景,用腳本控制RTSP視頻流的播放,設計并開發了相應的程序接口與軟件界面,如圖5所示。

圖5 Unity3D軟件中的場景架構Fig.5 Scene architecture in Unity3D

該場景包括2個并列排布的2D畫布(canvas),分別用于渲染顯示主視角相機(CAM1)和手部視角相機(CAM2)的實時視頻流,并通過背景面板有效地避免強光環境中的光線干擾。隨后設置畫布的層次結構,掛載相應的腳本文件,直接調用RTSP視頻流,將畫面渲染到對應的畫布上,實現實時視頻流的接收與播放。運行該場景程序時,會在本地計算機打開一個提供網絡攝像頭畫面的新窗口,以輸出視頻編碼器正在接收圖像數據的狀態信息。在混合現實顯示器中,為了生成高質量且穩定的混合現實場景,通過無線串流在Unity3D軟件中實現HoloLens與PC電腦在同一局域網內的無線連接,從而在HoloLens中同步Unity中的輸出結果,如圖6所示。針對此類二維信息的注冊,只需確定其相對于真實空間的坐標信息,就能較好地實現信息疊加。在這個過程中,PC計算機作為后臺服務器進行數據處理,HoloLens作為客戶端向用戶提供操作環境。

圖6 Unity3D軟件中的視頻流顯示Fig.6 Video stream display in Unity3D

2.2 Unity場景下的機械臂自適應控制

本文所提出的混合現實交互系統面向遙操作作業環境,需要根據真實環境的物理數據創建遙操作平臺虛擬交互模型,從而實現對遙操作機器人作業場景中各要素的構建與實際控制。以遙操作機械臂為例,由于需要通過對機械臂模型各關節角度的實時接收發控制遠端的真實機械臂,因此首先構建機械臂模型,具體流程如圖7所示。首先利用SolidWorks軟件對機械臂進行幾何重建,確定各零部件之間的裝配關系與旋轉中心,然后考慮到形狀、材質、紋理等因素的影響,利用計算機圖形學及相關渲染算法進行模型著色,以提高混合現實三維立體顯示的質量。

圖7 機械臂虛擬模型構建流程Fig.7 Robotic arm virtual model building process

由于Unity3D軟件所支持的模型文件為FBX格式,所以必須先將SolidWorks軟件生成的模型導入3DsMAX軟件進行轉化,再將轉化后的文件導入Unity3D軟件,建立對應模型的材質球以刻畫模型的細節特征,從而提高混合現實視覺質量。此外,通過降低虛擬模型的真實性,保證了系統的實時性需求,即在進行建模與實時渲染時,對模型的精確度和繪制速度進行了權衡,既能使畫質得到保證又不會給用戶帶來任何視覺觀感上的不適。模型生成后需要貼上紋理,使其更具有真實感。三維模型貼圖的核心是建立紋理貼圖與模型表面的映射關系,其實現過程如圖8所示。首先計算紋理在三維模型空間坐標系中的空間位置,確定紋理空間點(u,v)與模型空間坐標的映射關系,然后依據該映射關系,實現三維模型的著色。

圖8 紋理映射過程示意圖Fig.8 Texture mapping process

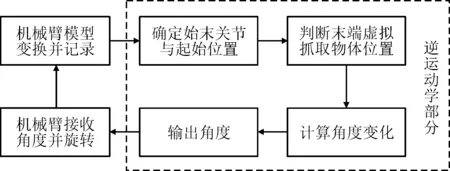

在場景實現過程中,模型建立后需要對機械臂模型進行控制與交互方法的設計。由于采用機械臂仿真Unity鉸鏈關節后進行角度輸出的傳統方案存在無法精確控制角度的問題,以及當項目套用混合現實工具包(MRTK)組件在混合現實場景下運行時,本文所使用的機械臂需要進行6軸的關節計算,給系統運行造成了較大的負載,常常會出現系統崩潰、模型顯示邏輯混亂的情況,因此,本文提出采用循環坐標下降逆運動學(cyclic coordinate descent inverse kinematics,CCDIK)方法實現混合現實場景下機械臂的交互。實現機械臂交互控制的框架如圖9 所示。

圖9 基于末端抓取物的機械臂交互控制框架 Fig.9 Robotic arm interactive control frame based on end-grabbing objects

本文基于Unity2020.3.41f1c1版本,利用CCDIK算法在混合現實場景中實現Unity機械臂的自適應交互。CCDIK算法是一種較為快速的逆運動學求解算法,在實時性要求較高的環境中運用比較廣泛,且由于這種算法的計算量比較小,對系統的負載影響也較小,因此適合在混合現實設備算力較弱的情況下使用。該算法的具體過程為:首先在Unity中創建一個機械臂模型,包括機械臂的各個關節和連接器,并設置好每個關節的轉動范圍和初始角度;然后,搭建CCDIK腳本來構建機械臂的逆運動學模型,該腳本可以根據機械臂的目標位置和姿態,計算出每個關節需要旋轉的角度,從而實現機械臂末端的精確定位;最后,將CCDIK腳本掛載到機械臂模型上,設置目標位置和姿態,并進行運動控制。本文通過編寫腳本來控制機械臂的運動,使用手部位姿來操作目標抓取物體,通過在更新進程中進行不間斷的坐標判斷,向腳本不斷輸出目標位置,實現連續、實時的機械臂姿態變換。隨后,進一步對機械臂模型進行優化和改進,添加了碰撞檢測以提高模型的精度和穩定性。

2.3 三維注冊與融合流程

混合現實系統的重要部分是將虛擬的全息對象與真實環境融合起來。本文所設計的混合現實場景中的全息對象包括兩大類,如圖10所示,一類是2D對象如字體、圖片、UI等,用于向用戶展示當前環境的動態信息及相關屬性;另一類是3D對象,主要是指三維全息對象如機械臂、抓取物、小車等虛擬模型,用于遠程機器人系統的交互控制,以增強用戶的沉浸感體驗。

圖10 混合現實場景中的虛擬信息Fig.10 Virtual information in a mixed reality scenario

采用基于自然特征點的無標識三維注冊方法,對這些全息對象進行空間三維注冊,利用Vuforia SDK工具包和Unity3D軟件開發對應的Unity腳本,實現對全息對象空間位置和姿態的實時定義。該三維注冊系統由4個部分組成,分別是三維目標預設、圖像實時處理、三維注冊以及圖像輸出。實現的基本流程如圖11所示。

圖11 三維注冊與融合流程Fig.11 3D registration and fusion flowchart

通過選取多張標記圖像建立目標樣本數據庫,并將數據庫導入到Unity項目中,可實現增強現實標記的調用。通過綁定模型與目標物圖像,根據Unity3D軟件中空間參考坐標系與真實空間坐標系的關系,設定目標物與虛擬模型的相對位置關系,可實現虛實融合與顯示。采用HoloLens設備進行虛實融合的過程如圖12所示。由圖可見,該三維注冊方法能將全息對象和現實所觀察到的遙操作場景相融合,使全息影像在相機識別到目標對象時,可以按照預先設置的相對關系在混合現實場景中顯示,增強了全息圖像的真實感,極大地改善了物理環境與虛擬環境的虛實融合效果。基于此方法,系統提供了可以進行機器人操作的全向感知平臺,允許操作員在作業過程中與虛擬機器人系統進行交互,并能從各個方向觀察虛擬機器人與虛擬抓取場景,有助于操作員直接感受遠端環境并進行遙操作控制,以獲得更好的真實感和沉浸感。

3 交互系統構建

3.1 交互界面可視化

在Unity3D軟件中進行系統交互界面的構建,作為遙操作視覺增強交互系統的重要組成部分,主要包括利用遠程攝像機在混合現實場景中獲取傳輸的實時視頻流,以及拖動三維可視化后的虛擬機械臂進行控制兩部分內容,因此可將虛擬交互空間進行劃分,并根據相應的交互功能進行布局。如圖13所示,左、右兩側展示了遙操作實時視頻流畫面,分別用于顯示遙操作端的手部實景和遙操作端的全局實景。AR識別平臺位于視野正前方,用于實時追蹤并定位虛擬機械臂控制的交互平臺。用戶通過觀察立體傳輸的視頻流信息,變換機械臂的虛擬模型位姿以進行遠端機械臂的同步控制。交互模式選擇模塊集合了性能分析器、手勢交互方式選擇、AR平臺關閉與顯示、場景切換等功能按鍵,分別響應于對應的特征。該界面用戶最終通過HoloLens設備進行顯示,輔助遙操作系統實現了自然人機交互與沉浸式作業。

圖13 混合現實系統界面Fig.13 Hybrid reality system interface

交互系統中使用的界面標定方式為環境鎖定,但為了適應不同應用場景以及用戶的個性化需求,在實際應用過程中也提供了基于頭部追隨技術的界面標定方式供操作員選擇,此方式能有效地避免由于用戶移動造成的畫面消失或頻繁的手動定位。

3.2 系統通信實現

本系統網絡通信由兩套獨立的子系統實現,分別為相機端-主機端視頻流的通信實現以及主動端-從動端交互指令的通信實現。通過不同的數據傳輸協議,從而實現主從端各子系統之間的信息、控制數據流轉。

本系統通過傳輸控制協議(transmission control protocol,TCP)通信實現主從端點云數據流的傳輸,其方法為在從端的Linux主機上搭建服務端,在主端的Unity程序中搭建客戶端并編寫對應的腳本文件。TCP是一種面向連接的、可靠的、基于字節流的傳輸層通信協議,其通過建立穩定連接、按順序傳輸數據包以及提供錯誤檢測和重傳機制,確保了數據的完整性和可靠性。該協議在本系統的具體應用如圖14所示 。

圖14 場景傳輸TCP通信流程Fig.14 Scenario transmission TCP communication process

基于Unity的自適應機械臂實現交互控制后,需要進一步搭建局域網傳輸機械臂的遠程控制指令,具體的通信流程設計如圖15所示。由于模型機械臂與真實機械臂的初始位姿不一定同步,因此在系統開啟之前需要先進行初始化同步以保證兩者的位姿相同,再通過用戶數據報協議(UDP)通信使Unity工程與遠端機器人進行遠程數據交換并發送位置指令。

圖15 混合現實機械臂控制通信流程Fig.15 Mixed reality robotic arm control communication process

為了控制機械臂的運動,需要獲取機械臂關節角度的變化信息。這些信息可以從Unity工程中提取,在進行位姿同步后,機械臂模型接收末端位姿的坐標并進行實時的姿態變換計算,隨后將變換后的角度信息通過UDP通信傳輸給遠端機器人。

在該Unity通信進程中,每一幀即1/12 s都會產生一次角度數據,因此在短時間內產生了大量的、重復的角度數據,并被機械臂服務器端全部接收,這對機械臂的角度處理造成了較大的干擾,頻繁出現單次姿態變換中移動卡頓的問題。基于此問題,本文通過物體抓取操作的監聽進行數據傳輸優化,由于系統構建中采用MRTK的交互腳本實現了對虛擬抓取物的交互操作,因此使用 MRTK 的可交互組件進行物體抓取操作時,可以通過監聽手勢交互終止事件(manipulation ended)來實現每次抓取結束后輸出一次角度信息的功能。實現的最終效果為在每次抓取操作結束后,才將旋轉信息發送到服務器,并輸出角度信息,極大地優化了機械臂的交互控制效果。

4 系統驗證

4.1 遙操作場景下傳輸延時實驗

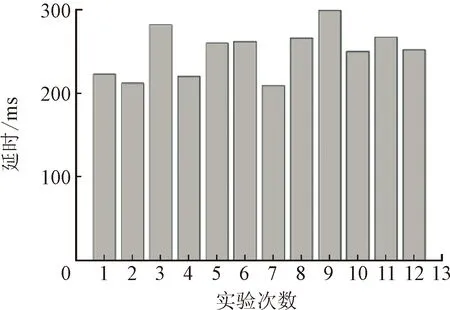

在混合現實視覺增強交互系統的實際應用中,遙操作主從端的傳輸延時是衡量系統整體性能的一個關鍵指標。一般情況下,系統延遲響應約為70~110 ms,一旦超過300 ms,就會直接影響到操作者的作業效率。設Δt1是相機從新的位置采集圖像并返回顯示器所造成的延遲,主要受由網絡傳輸性能的影響,并隨著傳輸圖像尺寸的增大而增大,Δt2是在HMD上渲染獲取的圖像所造成的延遲,因此系統總延遲Δt為Δt1與Δt2之和。實驗設定視頻以1 920×1 080 像素高清分辨率進行傳輸,使用MJPG編碼,幀率為30 Hz,傳輸圖像尺寸為640×480像素,服務器和客戶端在同一局域網中。設置主從端距離為15 m,在攝像機前執行固定動作直到該動作在交互系統中復現后,計算執行動作與復現動作之間的時間差即系統延時。

實驗得到的結果如圖16所示,統計結果表明,圖像傳輸過程中的延時保持在210 ms到300 ms之間,平均值為260 ms,方差為29 ms,能夠滿足實時性要求。

圖16 主從端距離為15 m時圖像傳輸延時實驗結果Fig.16 Experimental results of image transmission delay when the master-slave distance is 15 m

4.2 人機交互功能測試

對本文所設計的遙操作交互系統進行人機交互功能測試,測試結果主要用于評估系統的手勢識別與交互性能。實驗隨機招募14名被試者(10名男性,4名女性),年齡范圍為21~26歲(平均為23.79歲,標準差為1.42),均無VR、AR使用經驗。被試者進行基礎學習與訓練后,執行手勢30次/命令。手勢由5個命令組成,分別為選擇虛擬對象、調整對象位置、調整對象尺寸、機械臂姿態變換和多通道選擇交互,要求被試者完成混合現實環境下的關于系統相關模塊的基本交互任務。實驗記錄下檢測到的手勢數,并將統計結果列于表1。

表1 人機交互功能測試任務及結果統計

由表1可見,該系統對手勢命令的檢測準確率較高,交互時間隨著交互任務的復雜度增加。實驗過程中幀率總體波動范圍為55~75 Hz,最大差值保持在10 Hz以內。

綜上所述,所設計的混合現實視覺增強交互系統,能夠滿足基本的人機交互功能需求,并且具有良好的運行性能與流暢性。同時,通過與實驗搭建的利用二維顯示器進行場景傳輸的傳統遙操作系統相比,在進行完整的遙操作抓取任務中,同樣完成選擇對象、機械臂變換以及抓取對象這3組動作,傳統二維系統完成任務所需的平均時間為11.73 s,準確度為0.87,而本文所設計的遙操作交互系統在任務平均完成時間上減少了17.3%,準確度提高了7%。

5 結 論

本文針對遙操作機器人系統在高風險任務中近端交互臨場感差、操作者難以獲得真實體驗感的問題,提出了一種適用于遙操作場景的混合現實視覺增強交互系統,并對該交互系統的交互性能進行分析和實驗驗證,探討了混合現實交互技術的應用對于遙操作機器人系統人機交互性能的影響,得到以下主要結論。

(1)以人機交互通道為研究對象,從多通道信息的整合入手,研究了Unity3D平臺下視頻流的采集與流式無線傳輸方法,完成了在硬件平臺上的搭載并進行了傳輸測試,有效地完成了遠程場景還原的系統需求。

(2)基于機械臂的逆運動學構建了混合現實場景下的機械臂控制腳本,設計了一種立體可視化的遙操作控制流程,最大程度地保障了用戶以自然的方式與控制對象交互,降低了學習成本。

(3)基于視覺感知以及可視化交互理論構建系統交互界面,提出了二維信息與三維模型相結合的混合式系統信息構建方法。該方法將視覺反饋區域與控制區域集成一體,改善了遙操作機器人系統的復雜度和穩定性。

本文所提出的混合現實視覺增強方法遙操作交互系統,有效地解決了遠端作業場景的同步再現問題,提高了操作員的作業效率和準確率,對于軍事領域中的排雷排爆等遙操作作業具有一定的應用價值。