改進(jìn)的輕量級(jí)YOLOv4輸電線路鳥巢檢測(cè)方法

武明虎 雷常鼎 劉聰

[收稿日期]2022-0211

[第一作者]武明虎(1975-),男,湖北巴東人,湖北工業(yè)大學(xué)教授,研究方向?yàn)樾盘?hào)與信息處理

[文章編號(hào)]1003-4684(2023)02-0011-06

[摘要]基于深度學(xué)習(xí)的輸電線路缺陷檢測(cè)方法往往需要昂貴的硬件支持來(lái)實(shí)現(xiàn)實(shí)時(shí)和高精度的技術(shù)指標(biāo)要求,難以大規(guī)模推廣和普及。針對(duì)這一問題,提出一種改進(jìn)的輕量級(jí)YOLOv4神經(jīng)網(wǎng)絡(luò)模型方法。具體的,為提高檢測(cè)精度,在特征提取網(wǎng)絡(luò)中增加了輕量級(jí)注意力機(jī)制;為提高檢測(cè)速度,選用輕量級(jí)Mobilenet-v3網(wǎng)絡(luò)作為YOLOv4的骨干網(wǎng),同時(shí)采用了深度可分離卷積代替了傳統(tǒng)YOLOv4模型中的多尺度特征金字塔結(jié)構(gòu)普通卷積。實(shí)驗(yàn)結(jié)果表明,改進(jìn)的輕量級(jí)YOLOv4模型能有效檢測(cè)出輸電線路中的鳥巢,平均檢測(cè)精度(AP)值達(dá)到97.56%,相較于YOLOv4模型提高了1.80%,檢測(cè)速度達(dá)到Y(jié)OLOv3的45.8倍,是YOLOv4的56.6倍,具有較強(qiáng)的實(shí)際應(yīng)用價(jià)值。

[關(guān)鍵詞]深度學(xué)習(xí); 缺陷檢測(cè); YOLOv4; 注意力機(jī)制

[中圖分類號(hào)]TP391.4? [文獻(xiàn)標(biāo)識(shí)碼]A

高壓輸電線路多處于深山、林區(qū)、曠野等環(huán)境保護(hù)良好、水源豐富、鳥類活動(dòng)頻繁的區(qū)域,鳥類經(jīng)常會(huì)在輸電線路的桿塔或絕緣子上方筑巢而形成鳥害,嚴(yán)重威脅輸電線路的安全運(yùn)行,定期清除高壓輸電線路的鳥巢非常重要。高壓輸電線路地域復(fù)雜,人工檢測(cè)非常不便, 隨著電網(wǎng)建設(shè)的擴(kuò)大,新型的無(wú)人機(jī)巡檢方式逐步取代人工巡檢。

目前輸電線路缺陷檢測(cè)方法包括傳統(tǒng)的圖像處理和基于深度學(xué)習(xí)兩類方法,傳統(tǒng)的圖像處理方法[1-3]缺乏魯棒性、僅能識(shí)別和定位一種部件。隨著深度學(xué)習(xí)運(yùn)用在線路檢測(cè)中,基于深度學(xué)習(xí)輸電線路檢測(cè)領(lǐng)域也取得了一系列成果[4-10],然而目前基于深度學(xué)習(xí)的輸電線路缺陷檢測(cè)模型的參數(shù)量和計(jì)算量比較大,檢測(cè)速度較慢。

針對(duì)上述問題,本文提出一種改進(jìn)的輕量級(jí)卷積神經(jīng)網(wǎng)絡(luò)YOLOv4模型。針對(duì)YOLOv4在自建輸電線路鳥巢數(shù)據(jù)集中檢測(cè)硬件要求高和參數(shù)量過大的問題。在YOLOv4的基礎(chǔ)上,將主干特征網(wǎng)絡(luò)由CSPDarknet-53替換成Google的輕量級(jí)MobileNetv3網(wǎng)絡(luò),大大降低網(wǎng)絡(luò)參數(shù)量,減少模型計(jì)算量,使其可以無(wú)需昂貴的硬件用于輸電線路鳥巢實(shí)時(shí)檢測(cè)和通過遠(yuǎn)程控制無(wú)人機(jī)捕獲的實(shí)時(shí)視頻進(jìn)行實(shí)時(shí)檢測(cè)和本地化。其次在加強(qiáng)特征提取網(wǎng)絡(luò)PANet中增加最新的輕量級(jí)Coordinate Attention注意模塊,數(shù)據(jù)集實(shí)驗(yàn)結(jié)果顯示,改進(jìn)后的輕量級(jí)YOLOv4算法模型更小,檢測(cè)速度也有很大提升。

1??? 改進(jìn)YOLOv4目標(biāo)檢測(cè)算法

改進(jìn)YOLOv4模型融合了輕量級(jí)網(wǎng)絡(luò)和雙重注意力機(jī)制,其總體結(jié)構(gòu)如圖1所示,引入MobileNetv3輕量級(jí)網(wǎng)絡(luò)模型,用它替換YOLOv4模型的主干網(wǎng)絡(luò)CSPDarknet53,可在不損失精度的前提下,有效減少模型參數(shù)量,提高模型檢測(cè)速度。針對(duì)輸電線路鳥巢目標(biāo)被遮擋、多小目標(biāo)的特點(diǎn),在YOLOv4特征融合網(wǎng)絡(luò)的最后三個(gè)分支中引入CA模塊,以提高模型的檢測(cè)精度。相較于通道注意力通過將輸入進(jìn)行二維全局池化轉(zhuǎn)化為單個(gè)特征向量,CA模塊利用兩個(gè)一維全局池化操作將沿垂直和水平方向的輸入特征分別聚合為兩個(gè)單獨(dú)的方向感知特征圖。然后將這兩個(gè)方向感知特征圖編碼為兩個(gè)注意力圖,這樣做的優(yōu)點(diǎn)是每個(gè)注意力圖都可以沿著一個(gè)空間方向捕獲長(zhǎng)程依賴,沿著另一個(gè)空間方向保留精確的位置信息。兩個(gè)注意力圖接著被乘到輸入特征圖上來(lái)增強(qiáng)特征圖的表示能力。相比輕量級(jí)網(wǎng)絡(luò)上的注意力方法,CA存在以下優(yōu)勢(shì):首先,它不僅能捕獲跨通道的信息,還能捕獲方向感知和位置感知的信息,這種注意力能幫助模型更加精準(zhǔn)地定位和識(shí)別感興趣的目標(biāo),通過集成CA模塊,賦予特征圖區(qū)分空間方向的能力,使模型更加關(guān)注包含重要信息的目標(biāo)區(qū)域,抑制不相關(guān)信息,提高目標(biāo)檢測(cè)的整體精度。

1.1??? 輕量級(jí)骨干特征提取網(wǎng)絡(luò)

圖2中,卷積層由卷積層、批處理歸一化層和H-swish激活函數(shù)組成。MobileNetv3將普通卷積替換成深度可分離卷積,大大減少了參數(shù),在不降低檢測(cè)精度的同時(shí)減少了計(jì)算量,實(shí)現(xiàn)了速度與精度的完美結(jié)合。在訓(xùn)練過程中,圖像被拉伸和縮放到416×416,然后發(fā)送到卷積神經(jīng)網(wǎng)絡(luò)。經(jīng)過5次3/2卷積(卷積核大小為3×3,步長(zhǎng)為2),縮減為13×13,并選擇52×52、26×26、13×13三個(gè)尺度輸出feature map。

1.2??? 基于MobileNetv3的yolov4網(wǎng)絡(luò)結(jié)構(gòu)改進(jìn)

MobileNet網(wǎng)絡(luò)可分為MobileNet-v1[11]、MobileNet-v2[12]和MobileNet-v3[13]三種類型。MobileNet-v3分為大版本和小版本。在ImageNet分類任務(wù)中,大版本比小版本的準(zhǔn)確率高1.4%。但是大版本的檢測(cè)速度與小版本相比降低了10%。為保證實(shí)時(shí)檢測(cè)和本地化需求,使用小版的MobileNet-v3取代CSPDarkNet53作為改進(jìn)YOLOv4的骨干特征提取網(wǎng)絡(luò)。

MobileNet-v3在瓶頸層增加了擠壓激勵(lì)結(jié)構(gòu),將膨脹層通道修改為1/4,在不增加計(jì)算時(shí)間的情況下提高檢測(cè)精度。在MobileNet-v2中,平均池之前的1×1卷積層提高特征圖的維數(shù)。然而,在MobileNet-v3中,特征圖首先使用平均池化將其縮減為1×1。然后增加特征圖的維數(shù),將計(jì)算量減少49倍,提高了特征圖的計(jì)算速度。圖1顯示了將MobileNetv3與YOLOv4融合的輕量級(jí)網(wǎng)絡(luò)結(jié)構(gòu)。為進(jìn)一步降低網(wǎng)絡(luò)的參數(shù),將加強(qiáng)特征提取網(wǎng)絡(luò)PANet中的普通3×3卷積替換成深度可分離卷積。

1.3??? 特征融合網(wǎng)絡(luò)

在MobileNet-v3特征提取網(wǎng)絡(luò)后,使用特征融合網(wǎng)絡(luò)PANet和SPP對(duì)提取的特征進(jìn)行融合,以提高模型的檢測(cè)能力。SPP模塊的作用是使卷積神經(jīng)網(wǎng)絡(luò)的輸入不受固定大小的限制,在不降低網(wǎng)絡(luò)運(yùn)行速度的同時(shí),可以增加接受域,有效分離重要的上下文特征。SPP模塊位于特征提取網(wǎng)絡(luò) MobileNetv3之后。SPP網(wǎng)絡(luò)使用四種不同的最大池化比例來(lái)處理輸入特征圖。池化的核心大小為1×1、5×5、9×9、13×13,而1×1相當(dāng)于不經(jīng)過處理,對(duì)四個(gè)feature map進(jìn)行concat操作。最大池化采用填充操作,移動(dòng)步長(zhǎng)為1,池化層后feature map的大小不變。

在SPP之后,使用PANet進(jìn)行參數(shù)的聚合。與YOLOv3的特征金字塔結(jié)構(gòu)不同的是,PANet在自頂向下的特征金字塔之后增加了自底向上的路徑增強(qiáng)結(jié)構(gòu),該結(jié)構(gòu)包含兩個(gè)PAN結(jié)構(gòu)。并對(duì)PAN結(jié)構(gòu)進(jìn)行了改性。原PAN結(jié)構(gòu)采用了一種快捷連接方式將下采樣特征圖與深度特征圖融合,輸出特征圖的通道數(shù)量保持不變。修改后的PAN使用concat操作連接兩個(gè)輸入特征映射,并合并兩個(gè)特征映射的通道號(hào)。自上而下的特征金字塔結(jié)構(gòu)傳達(dá)強(qiáng)烈的語(yǔ)義特征,自下而上的路徑增強(qiáng)結(jié)構(gòu)充分利用淺層特征傳達(dá)強(qiáng)烈的定位特征。PANet可以充分利用淺層特征,并針對(duì)不同的檢測(cè)器水平,對(duì)不同的主干層進(jìn)行特征融合,進(jìn)一步提高特征提取能力,提高檢測(cè)器性能。

2??? 基于 Coordinate Attention 的yolov4網(wǎng)絡(luò)結(jié)構(gòu)改進(jìn)

Coordinate Attention [14]塊可以看作是一個(gè)計(jì)算單元。CA模塊通過精確的位置信息對(duì)通道關(guān)系和長(zhǎng)程依賴性進(jìn)行編碼,具體操作分為Coordinate信息嵌入和Coordinate Attention生成2個(gè)步驟。其模塊結(jié)構(gòu)見圖3。

2.1??? Coordinate信息嵌入

為了促使注意力模塊能夠捕捉具有精確位置信息的遠(yuǎn)程空間交互,本文按照公式(1)全局池化分解為公式(2)和公式(3)的兩個(gè)一維特征編碼操作:

zc=1H×W∑Hi=1∑Wj=1xc(i,j)(1)

其中zc是與第c個(gè)通道相關(guān)聯(lián)的輸出,H和W為圖像的高度和寬度,xc(i,j)表示高度為i 寬度為j的c通道輸入,式(1)相當(dāng)于將H×W×C 的輸入轉(zhuǎn)換成1×1×C的輸出。式(2)和式(3)分別使用一個(gè)尺寸為(H,1)和(1,W)的池化核分別沿著水平坐標(biāo)方向和垂直坐標(biāo)方向?qū)γ總€(gè)通道進(jìn)行編碼。

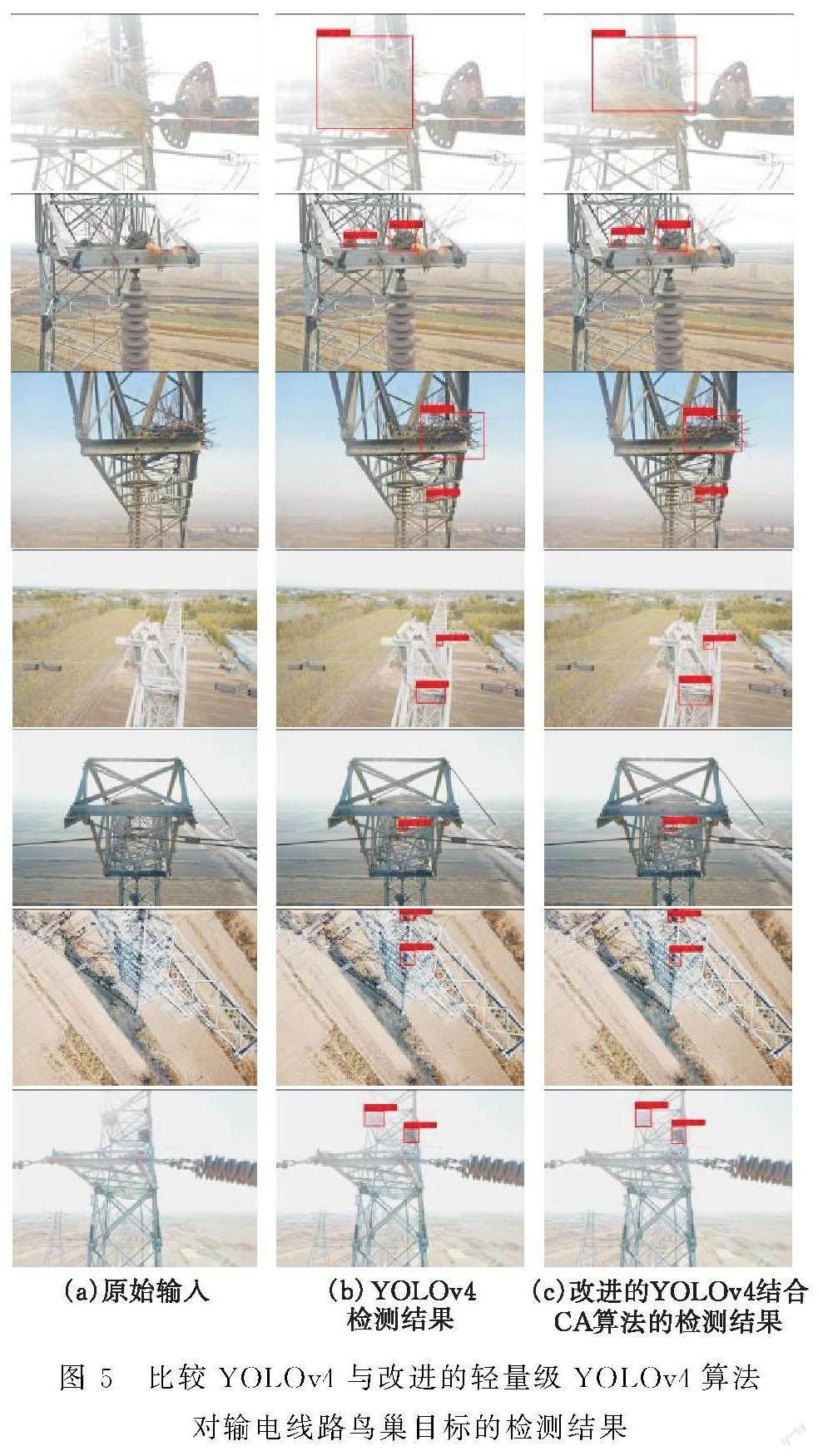

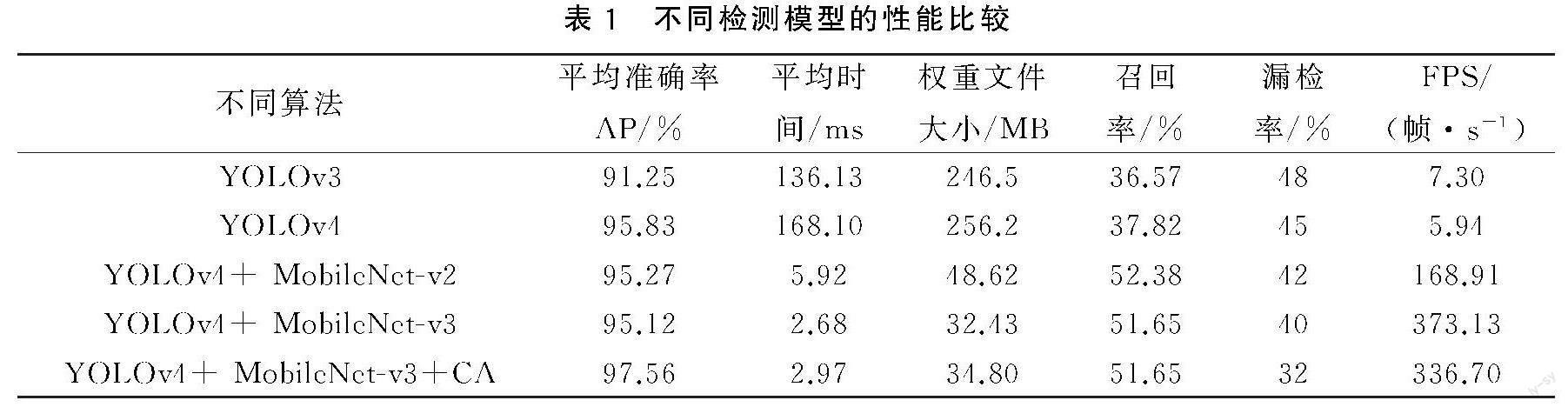

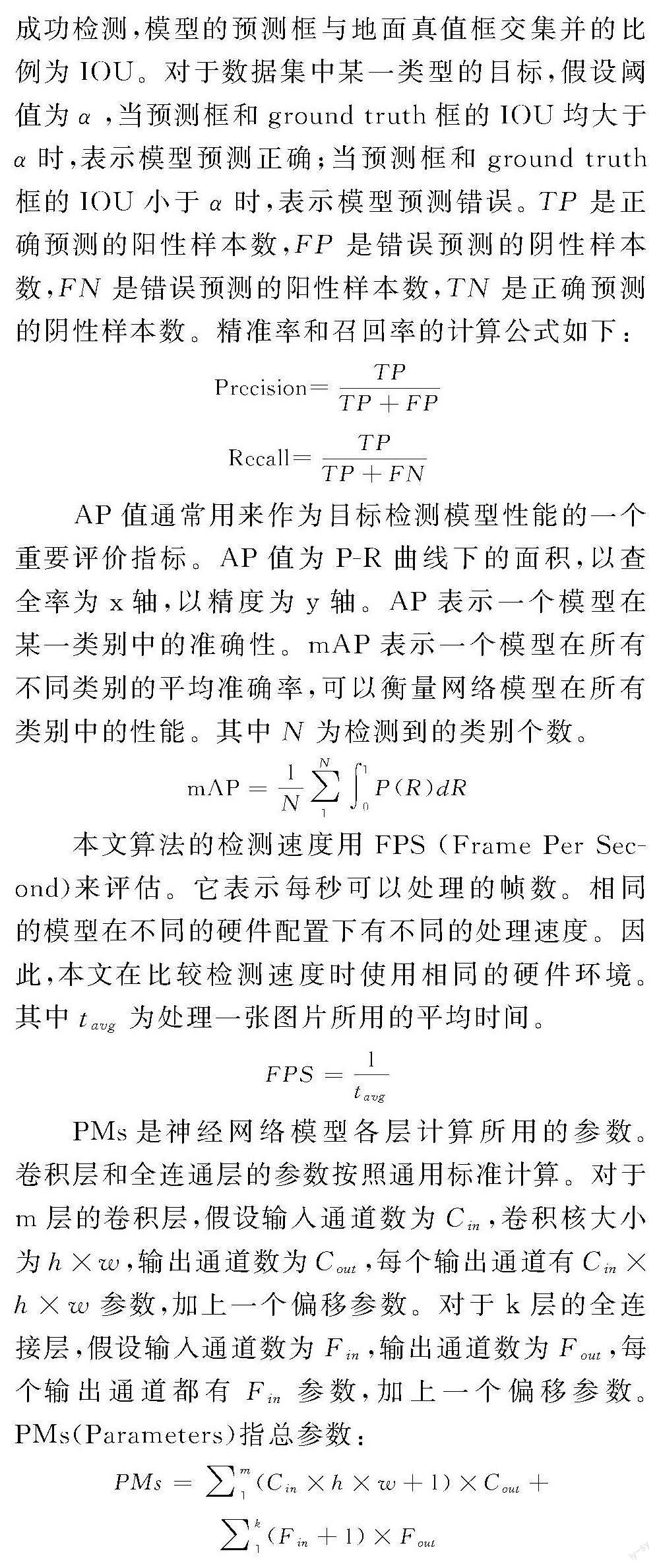

zhc(h)=1W∑0≤i zwc(w)=1H∑0≤j 其中zhc(h)表示c通道高度為h的輸出,zwc(w)表示c通道寬度為w的輸出,xc(h,i) 表示c通道高度為h的輸入,xc(j,w)表示c通道寬度為w的輸入。公式(2)和公式(3)相當(dāng)于將H×W×C 的輸入轉(zhuǎn)換成H×1×C和1×W×C 的輸出。 式(2)和式(3)這2種特征變換利用兩個(gè)一維全局池化操作,將沿垂直和水平方向的輸入特征分別聚合為兩個(gè)單獨(dú)的方向感知特征圖, 然后將這兩個(gè)方向感知特征圖編碼為兩個(gè)注意力圖。這種注意力機(jī)制與在通道注意力方法中只產(chǎn)生單一的特征向量的SE Block[15]有本質(zhì)不同。這樣做的好處是每個(gè)注意力圖都可以沿著一個(gè)空間方向捕獲長(zhǎng)程依賴,沿著另一個(gè)空間方向保留精確的位置信息。 2.2??? Coordinate Attention生成 該部分將上面的變換后的兩個(gè)特征圖進(jìn)行級(jí)聯(lián)操作,然后使用一個(gè)共享的1×1卷積進(jìn)行變換,卷積變換函數(shù)表述如下: f=δ(F1(zh,zw)) (4) 式中δ為非線性激活函數(shù),變換生成的fh∈RC/r×(H+W)是對(duì)空間信息在水平方向和豎直方向的中間特征圖,這里r表示下采樣比例,用來(lái)控制模塊的大小。然后沿著空間維度將f分解為2個(gè)單獨(dú)的張量fh∈RC/r×H和fw∈RC/r×W。利用另外2個(gè)1×1卷積變換Fh和Fw分別將特征圖fh和fw變換為和輸入X具有相同的通道數(shù),得到: gh=σ(Fh(fh)),gw=σ(Fw(fw)) (5) 式中σ是sigmoid激活函數(shù)。為了降低模型的計(jì)算復(fù)雜性和計(jì)算開銷,這里可以使用適當(dāng)?shù)耐ǖ揽s減比r(本文取r=16)來(lái)減少f的通道數(shù)。然后對(duì)輸出gh和gw進(jìn)行一次拓展,分別作為注意力權(quán)重。最后,CA模塊的最終輸出可以表述為公式(6): yc(i,j)=xc(i,j)×ghc(i)×gwc(j)(6) 式中yc(i,j) 表示c通道高度為i寬度為j的輸出, ghc(i)表示c通道高度為i的注意力權(quán)重,gwc(j)表示c通道寬度為j的注意力權(quán)重。 在圖1中,假設(shè)輸入圖像的大小是416×416×3,以第一個(gè)CA模塊為例,輸入特征地圖大小是52×52×256,沿X和Y全局平均池化后,得到兩個(gè)特征圖大小52×1×256和1×52×256,然后經(jīng)過一個(gè)拼接與共享的權(quán)重,維數(shù)變?yōu)? ×104×16,降維系數(shù)是16,然后進(jìn)行標(biāo)準(zhǔn)化和非線性激活,然后再分離并擴(kuò)張維度到52×1×256和1×52×256,得到了兩個(gè)激活后的特征圖譜,將二者分別接一個(gè)Sigmoid激活函數(shù),將輸入的特征圖分別與兩個(gè)激活后的特征圖譜相乘,得到尺寸為52×52×256的帶有位置信息的空間選擇性注意力特征圖。 3??? 實(shí)驗(yàn)分析 3.1??? 輸電線路鳥巢數(shù)據(jù)集 本文數(shù)據(jù)采集自天津地區(qū)特高壓與高壓輸電線路桿塔照片。這些圖像來(lái)自不同電壓等級(jí)、不同桿塔類型的輸電線路。本文為了保證訓(xùn)練數(shù)據(jù)集的各種類型數(shù)據(jù)均衡,在標(biāo)注數(shù)據(jù)之前從原始的數(shù)據(jù)中按比例抽取不同類型的桿塔。然后對(duì)數(shù)據(jù)集中不同線路的圖片進(jìn)行標(biāo)注。選取了遮擋、多云、晴天、背光和強(qiáng)光條件下的1500幅圖像作為數(shù)據(jù)集,保證了數(shù)據(jù)集的多樣性。將標(biāo)注的數(shù)據(jù)隨機(jī)選取72%作為訓(xùn)練集、14%作為驗(yàn)證集、14%作為測(cè)試集。根據(jù)VOC數(shù)據(jù)集生成數(shù)據(jù)集的格式。部分輸電線路鳥巢目標(biāo)數(shù)據(jù)見圖4。 3.2??? 實(shí)驗(yàn)環(huán)境 為了進(jìn)一步加快網(wǎng)絡(luò)訓(xùn)練速度,引入遷移學(xué)習(xí)技術(shù),將預(yù)先訓(xùn)練好的模型加載到voc數(shù)據(jù)集上,對(duì)輸電線路鳥巢數(shù)據(jù)集進(jìn)行訓(xùn)練,模型的訓(xùn)練環(huán)境和測(cè)試環(huán)境是相同的。本文中使用的實(shí)驗(yàn)裝置硬件由windows10操作系統(tǒng),Intel(R) Xeon(R) Gold 5218 CPU @2.30GHz,32GB的內(nèi)存,NVIDIA TITAN RTX 32GB顯存的顯卡。軟件版本為Pycharm2020,pytorch框架,Python3.6.8,Opencv3.4.3,CUDA 10.0和CUDNN 7.5。 訓(xùn)練網(wǎng)絡(luò)參數(shù):批量大小設(shè)置為16,初始學(xué)習(xí)率設(shè)置為0.001,迭代次數(shù)200,學(xué)習(xí)速率衰減0.1,固定圖像尺寸416×416。 3.3??? 輸電線路鳥巢目標(biāo)檢測(cè)性能比較 為了驗(yàn)證改進(jìn)的YOLOv4網(wǎng)絡(luò)的有效性,對(duì)原始YOLOv4訓(xùn)練模型與改進(jìn)的YOLOv4網(wǎng)絡(luò)模型進(jìn)行了對(duì)比實(shí)驗(yàn)。原來(lái)的YOLOv4訓(xùn)練參數(shù)與改進(jìn)后的YOLOv4訓(xùn)練參數(shù)一致。采用常用的目標(biāo)檢測(cè)評(píng)估m(xù)AP對(duì)改進(jìn)前后的模型進(jìn)行比較。在目標(biāo)檢測(cè)任務(wù)中,根據(jù)交集(IOU)來(lái)判斷目標(biāo)是否被成功檢測(cè),模型的預(yù)測(cè)框與地面真值框交集并的比例為IOU。對(duì)于數(shù)據(jù)集中某一類型的目標(biāo),假設(shè)閾值為α,當(dāng)預(yù)測(cè)框和ground truth框的IOU均大于α?xí)r,表示模型預(yù)測(cè)正確;當(dāng)預(yù)測(cè)框和ground truth框的IOU小于α?xí)r,表示模型預(yù)測(cè)錯(cuò)誤。TP是正確預(yù)測(cè)的陽(yáng)性樣本數(shù),F(xiàn)P是錯(cuò)誤預(yù)測(cè)的陰性樣本數(shù),F(xiàn)N是錯(cuò)誤預(yù)測(cè)的陽(yáng)性樣本數(shù),TN是正確預(yù)測(cè)的陰性樣本數(shù)。精準(zhǔn)率和召回率的計(jì)算公式如下: Precision=TPTP+FP Recall=TPTP+FN AP值通常用來(lái)作為目標(biāo)檢測(cè)模型性能的一個(gè)重要評(píng)價(jià)指標(biāo)。AP值為P-R曲線下的面積,以查全率為x軸,以精度為y軸。AP表示一個(gè)模型在某一類別中的準(zhǔn)確性。mAP表示一個(gè)模型在所有不同類別的平均準(zhǔn)確率,可以衡量網(wǎng)絡(luò)模型在所有類別中的性能。其中N 為檢測(cè)到的類別個(gè)數(shù)。 mAP=1N∑N1∫10P(R)dR 本文算法的檢測(cè)速度用FPS (Frame Per Second)來(lái)評(píng)估。它表示每秒可以處理的幀數(shù)。相同的模型在不同的硬件配置下有不同的處理速度。因此,本文在比較檢測(cè)速度時(shí)使用相同的硬件環(huán)境。其中tavg 為處理一張圖片所用的平均時(shí)間。 FPS=1tavg PMs是神經(jīng)網(wǎng)絡(luò)模型各層計(jì)算所用的參數(shù)。卷積層和全連通層的參數(shù)按照通用標(biāo)準(zhǔn)計(jì)算。對(duì)于m層的卷積層,假設(shè)輸入通道數(shù)為Cin,卷積核大小為h×w,輸出通道數(shù)為Cout,每個(gè)輸出通道有Cin×h×w參數(shù),加上一個(gè)偏移參數(shù)。對(duì)于k層的全連接層,假設(shè)輸入通道數(shù)為Fin,輸出通道數(shù)為Fout,每個(gè)輸出通道都有Fin參數(shù),加上一個(gè)偏移參數(shù)。PMs(Parameters)指總參數(shù): PMs=∑m1(Cin×h×w+1)×Cout+∑k1(Fin+1)×Fout 將測(cè)試集的數(shù)據(jù)發(fā)送到訓(xùn)練的目標(biāo)檢測(cè)模型中,選擇不同的模型進(jìn)行實(shí)驗(yàn)比較(表1)。由表1可以看出,結(jié)合MobileNetv3和CA算法的YOLOv4的mAP(IoU=0.5)得到改進(jìn),與原始YOLOv4算法相比,其mAP提高1.80%。由于增加了三個(gè)CA模塊,模型的體積變大,從32.43 MB增加到34.80 MB,平均時(shí)間增加了0.29 ms,模型權(quán)重增加了2.37 MB。注意力機(jī)制增加了特征圖的計(jì)算量,提高了檢測(cè)精度,降低了檢測(cè)速度,但速度仍然滿足實(shí)時(shí)性要求。相較于原始YOLOv4算法,本文漏檢率下降了13%,召回率也提升了13.83%。 在圖5中,第一列(a)是原始輸入圖片,第二列(b)是YOLOv4檢測(cè)結(jié)果,第三列(c)是改進(jìn)的YOLOv4結(jié)合CA算法的檢測(cè)結(jié)果。在第一行圖片中,YOLOv4在高度強(qiáng)光照射環(huán)境下對(duì)鳥巢進(jìn)行識(shí)別的置信度為0.93,改進(jìn)后的YOLOv4算法將鳥巢識(shí)別的置信度提升為1;從第二、三、四、五行圖片中可以明顯看出,改進(jìn)后的YOLOv4算法對(duì)小目標(biāo)的檢測(cè)比原算法更準(zhǔn)確。其中,第二、四排鳥巢目標(biāo)具有較多的背景環(huán)境干擾,改進(jìn)后的YOLOv4具有更強(qiáng)的魯棒性。由第六、七行圖片可以看出,改進(jìn)的YOLOv4算法成功檢測(cè)到在逆光環(huán)境和背景干擾條件下被遮擋鳥巢小目標(biāo);從第五和第六行也可以明顯看出,當(dāng)鳥巢目標(biāo)小且被遮擋時(shí),改進(jìn)的YOLOv4算法對(duì)小目標(biāo)的檢測(cè)精度比原YOLOv4算法高。 4??? 結(jié)論 本文在YOLOv4的基礎(chǔ)上,將主干特征網(wǎng)絡(luò)由CSPDarknet-53替換成Google的輕量級(jí)MobileNetv3網(wǎng)絡(luò),大大降低了網(wǎng)絡(luò)參數(shù)量,使其能應(yīng)用在移動(dòng)端和嵌入式平臺(tái)上。同時(shí)在加強(qiáng)特征提取網(wǎng)絡(luò)PANet中增加了最新的輕量級(jí)Coordinate Attention注意模塊,使神經(jīng)網(wǎng)絡(luò)更加關(guān)注包含重要信息的目標(biāo)區(qū)域,抑制無(wú)關(guān)信息,提高實(shí)時(shí)檢測(cè)精度。實(shí)驗(yàn)結(jié)果表明,改進(jìn)后的輕量級(jí)YOLOv4模型在目標(biāo)檢測(cè)任務(wù)中比原YOLOv4模型精度更高,權(quán)重文件大小為原來(lái)的1/7,mAP50提高了1.80%,檢測(cè)執(zhí)行速度可以滿足實(shí)時(shí)性檢測(cè)要求,驗(yàn)證了這種改進(jìn)算法的有效性。 [參考文獻(xiàn)] [1]焦紅.直升機(jī)巡檢輸電線路圖像中防振錘的識(shí)別定位[D].大連:大連海事大學(xué), 2011. [2]段旺旺,唐鵬,金煒東,等.基于關(guān)鍵區(qū)域HOG特征的鐵路接觸網(wǎng)鳥巢檢測(cè)[J].中國(guó)鐵路, 2015(08): 73-77. [3]LU J, XU X, XIN L, et al. Detection of bird's nest in high power lines in the vicinity of remote campus based on combination features and cascade classifier[J]. IEEE Access, 2018 (99):1-1. [4]CHEN M Y, XU C. Bird's nest detection method on electricity transmission line tower based on deeply convolutional neural networks[C].∥2020 IEEE 4th Information Technology, Networking, Electronic and Automation Control Conference (ITNEC). IEEE, 2020. [5]JIANG H,HUANG W,CHEN J, et al. Detection of bird nests on power line patrol using single shot detector[C].∥2019 Chinese Automation Congress (CAC). IEEE, 2020. [6]BERG AC, FU CY, SZEGEDY C, et al. SSD:?jiǎn)伟l(fā)多盒檢測(cè)器:,10.1007/978-3-319-46448-0_2[P]. 2015. [7]王紀(jì)武,羅海保,魚鵬飛,等.基于Faster R-CNN的多尺度高壓塔鳥巢檢測(cè)[J].北京交通大學(xué)學(xué)報(bào),2019,43(05):37-43. [8]丁建,黃陸明,朱迪鋒,曹浩楠.面向高空塔架鳥巢檢測(cè)的雙尺度YOLOv3網(wǎng)絡(luò)學(xué)習(xí)[J].西安理工大學(xué)學(xué)報(bào),2021,37(02):253-260. [9]REDMON J, FARHADI A. Yolov3: An incremental improvement[J]. arXiv preprint arXiv,2018,1804:02767. [10] W DONG, L WU, Q WANG, et al. An automatic detection method of bird's nest on electric tower based on attention full convolutional neural networks[C].∥2021 4th International Conference on Artificial Intelligence and Big Data (ICAIBD), 2021:304-308, doi: 10.1109/ICAIBD51990.2021,9459088. [11] HOWARD A.G, ZHU M, CHEN B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications[EB/OL].(2022-02-10) [2020-07-03]. https:∥arxiv.org/abs/1704.04861. [12] SANDLER M, HOWARD A, ZHU M, et al. Mobilenetv2: Inverted residuals and linear bottlenecks[C].∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA: IEEE Press,2018:4510-4520. [13] HOWARD A, SANDLER M, CHU G, et al. Searching for mobilenetv3[C].∥In Proceedings of the IEEE International Conference on Computer Vision. Seoul, Korea: IEEE Press, 2019:1314-1324. [14] HOU Q, ZHOU D, FENG J. Coordinate attention for efficient mobile network design[C].∥Proceedings of the IEEE/CVF conference on computer vision and pattern recognition,2021: 13 713-13 722. [15] JIE H, LI S, GANG S, et al. Squeeze and excitation networks[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 42(08): 2011-2023. Improved YOLOv4 Transmission Lines Bird'sNest Detection Method WU Minghu,LEI Changding, LIU Cong School of Electrical and Electronic Engineering, Hubei Univ. of Tech., Wuhan 430068, China Abstract:Transmission line defect detection methods based on deep learning often need expensive hardware support to achieve real time and high precision technical requirements, so it is difficult to be popularized on a large scale. To solve this problem, an improved lightweight YOLOv4 neural network model is proposed. Specifically, in order to improve the detection accuracy, a lightweight attention mechanism is added to the feature extraction network. In order to improve the detection speed, lightweight Mobilenet v3 network is selected as the backbone network of YOLOv4, and deep deprivable convolution is adopted to replace the traditional multi scale characteristic pyramid convolution in YOLOv4 model. The experimental results show that the improved lightweight YOLOv4 model can effectively detect nests in transmission lines, and the average detection accuracy (AP) value reaches 97.56%, which is 1.80% higher than that of YOLOv4 model. The detection speed is 45.8 times that of YOLOv3 and 56.6 times that of YOLOv4, which has strong practical application value. Keywords:deep learning; defect detecting; YOLOv4; Attentional mechanism [責(zé)任編校: 張巖芳]