基于改進YOLOv5 模型的茄科植物葉片實例分割方法

摘 要: 觀測葉片是了解植物生長情況的重要措施,為實現溫室系統智能化管理,確保茄科植物健康生長,使用實例分割技術可以獲取到茄科植物在植物苗期的葉片生長信息。提出一種基于YOLOv5 模型的茄科植物葉片實例分割模型YOLOv5-Biformer,該模型針對茄科植物葉片的小目標特征,在主干網絡中加入稀疏注意力網絡,可以有效提高茄科植物葉片實例分割效率。試驗結果表明,YOLOv5-Biformer 模型在茄科植物葉片數據集上與基準模型相比,在精確度、召回率和平均精度指標上分別提高0.5、1.9 和1.0 個百分點。該模型在智能溫室環境下對于苗期茄科植物葉片的實例分割有顯著效果,為實現溫室系統智能化管理提供新思路。

關鍵詞:茄科植物;葉片;實例分割;YOLOv5;注意力機制;溫室

中圖分類號:S126 文獻標識碼:A 文章編號:2095-1795(2024)06-0026-08

DOI:10.19998/j.cnki.2095-1795.2024.06.005

0 引言

新疆維吾爾自治區(簡稱新疆)的蔬菜作物豐富多樣,2022 年種植面積超過2 萬hm2, 總產量達到290 萬t,其中以番茄、辣椒等茄科植物為主[1]。在苗期觀測植物葉片形態特征對于種類鑒定和生長狀態評估具有重要意義。然而,在自動化農業和植物學研究中,準確分割茄科植物葉片仍然是一個具有挑戰性的任務。葉片實例分割是計算機視覺應用于數字農業上的一項關鍵技術,將植物葉片逐個從復雜的背景中精確地分離出來,為后續的葉片分析和測量提供可靠的基礎[2]。

近年來,深度學習方法在圖像分割領域取得了顯著的突破。卷積神經網絡(CNN)被廣泛應用于植物葉片實例分割任務,這些方法通過端到端的訓練,能夠學習到圖像的高級特征和語義信息,從而在不同場景下實現準確的葉片分割[3]。HARIHARAN B 等[4] 提出的實例分割算法涉及生成掩碼建議(masksuggestion),然后對生成的建議進行分類。HE K 等[5]在Faster R-CNN 的基礎上提出了Mask R-CNN 模型,為了提高分割效果引入了掩碼分支,用于預測分割掩膜;設計了RoIAlign 層,通過采用雙線性插值的方法,計算每個感興趣區域采樣點的輸入特征值,以確保特征提取與輸入的一致性。這一創新顯著提升了分割效果, 為未來的圖像分割研究奠定了可靠的基礎。HUANG Z 等[6] 提出了Mask Scoring R-CNN 模型,對于Mask R-CNN 模型中過于仰賴分類分支置信度作為掩膜質量評價的問題。模型通過使用預測掩膜與標注掩膜的交并比(MaskIoU)來描述掩膜的分割質量;引入了全新的MaskIoU Head 分支,將MaskIoU 與分類得分相乘,從而計算掩膜的分數,以更準確地評估掩膜的質量。這項研究為改進Mask R-CNN 模型的性能提供了有效的解決方案,從而計算出掩膜的分數;這一算法調整有助于校正掩碼質量與得分之間的偏差,顯著提升了分割性能。XIE E 等[7] 提出的Polar Mask 則借鑒了FCOS 算法[8],運用極坐標系對物體輪廓進行了建模,從而實現了在無需檢測框的情況下進行實例分割。ZHANG G 等[9] 提出了名為“Refine Mask”的方法,該方法利用邊緣信息和語義分割信息來進一步優化Mask R-CNN 生成的粗糙掩碼邊緣。WANG Y 等[10]也提出了一種名為“ISTR”的方法,這是首個基于Transformer 的端到端實例分割框架;該方法通過預測低維掩碼嵌入和循環細化策略,實現了對實例的同時檢測和分割。

在植物葉片實例分割領域,王琢等[11] 以Caffe 深度學習框架為基礎,構建全卷積神經網絡(FCN),采用有監督的學習方法,實現葉片圖像的分割。YANGX 等[12] 提出了一種創新性的植物葉片圖像分割方法,方法基于Sc-MRCNN 架構,旨在提高植物葉片圖像分割的精確性和穩定性;通過引入空間和通道信息的融合,將植物葉片的準確分割推向了一個新的高度。PRAVEEN K J 等[13] 提出了一項基于深度卷積神經網絡(Deep-CNN,DCNN)的方法,用于植物葉片分割,通過使用DCNN 從目標區域中提取葉片信息,并應用正交變換技術,實現對CVPPP 蓮座植物數據集上葉片的精準分割,分割準確率達到了96%;在分割過程中,采用了CMYK 顏色空間進行噪聲去除處理,進一步提高了對葉片邊緣的檢測能力。GUO R 等[14] 提出了一種新的端到端模型Leaf Mask 神經網絡,用來劃分每個葉片區域并計算葉片數量,還為雙注意導向Mask 分支設計了新穎靈活的多尺度注意模塊。VAYSSADE J A 等[15]基于卷積神經網絡機制,提出了一種像素級實例分割來檢測茂密樹葉環境中的樹葉,結合深輪廓感知、邊緣的葉片分割槽分類和Pyramid CNN for Dense Leaves;應用分水嶺算法來細化分割結果,并結合計算優化植被指數來更好地識別和區分不同的植物實例或樹葉,但是該方法在植物發育的高級階段并不有效。李婧雯[16]使用3 種光度立體表面重建算法對植物葉片表面進行了三維重建,并獲取了植物葉片表面法向量圖,構建了葉片法向圖數據集,再將其作為神經網絡的輸入,完成對于同一植物不同葉片的分割。

綜上所述,與傳統機器學習方法相比,基于卷積神經網絡的植物葉片分割方法在識別率、準確率及處理速度等方面均取得了顯著的提升并在廣泛的領域得到了應用[17]。目前,在葉片分割領域內主要包括葉邊緣檢測方法和對象檢測方法,多數研究人員使用對象而不是邊緣作為分類的特征,許多基于對象的方法在兩片葉片重疊的情況下效果不是特別理想。本研究旨在探索和改進茄科植物葉片實例分割方法,增強分割算法的精確度和效能。通過綜合應用深度學習技術、圖像增強方法和先進的分割網絡架構,希望能夠有效地解決茄科植物葉片實例分割中的關鍵問題,為農業生產和植物學研究提供有力的支持。

1 YOLOv5 實例分割模型及改進

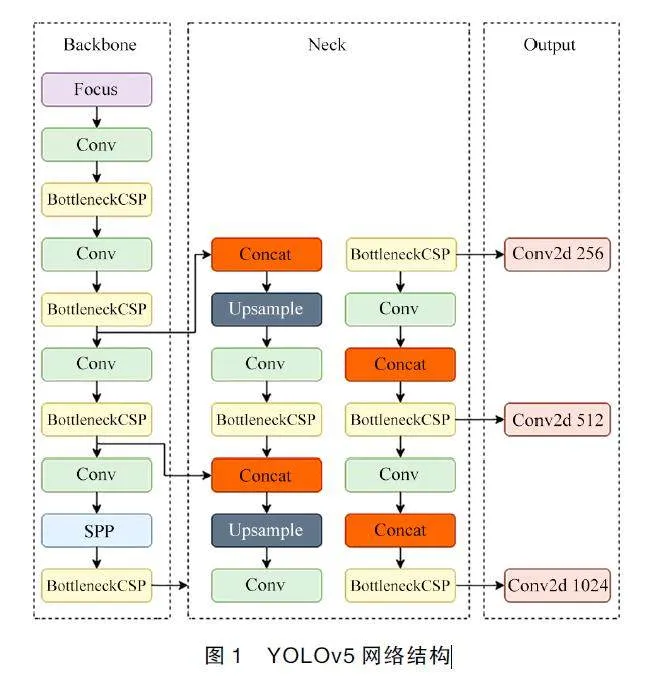

1.1 YOLOv5 模型結構

YOLOv5 是一種單階段目標識別算法[18]。根據網絡深度和寬度的不同,YOLOv5 分為5 個不同的網絡模型版本,分別是YOLOv5s(小)、YOLOv5m(中)、YOLOv5l(大)、YOLOv5n(均衡)和YOLOv5x(超大)。其中,YOLOv5s 網絡的計算速度最快,但平均精度低,而YOLOv5x 網絡則相反。YOLOv5 網絡的模型大小大約是YOLOv4 網絡的1/10,具有更快的識別和定位速度。YOLOv5 網絡結構主要由主干網絡(Backbone)、頸部(Neck)和頭部(Head)3 個關鍵部分組成。一旦輸入圖像進入網絡,主干網絡會在不同的圖像尺度上聚合特征,形成圖像的多層次特征表達。接著,頸部負責將這些特征進行融合,以實現不同尺度和語境的信息相互交織,為后續處理提供更加豐富的信息背景。頭部是網絡的頂部部分,負責最終的預測任務。該層根據任務要求進行進一步處理,以生成目標掩膜區域和對應的類別信息,這一步是網絡輸出預測結果的核心。其結構如圖1 所示。

1.2 YOLOv5 模型改進

Biformer 網絡是一種雙層路由注意力機制,以動態、查詢感知的方式實現計算的有效分配,旨在將雙層路由注意力引入到視覺Transformer 中,以提高計算機視覺任務的性能[19-20]。本研究關注茄科植物葉片,一共涵蓋了4 個不同的類別。為了更好地適應試驗的實際應用需求并提升茄科植物葉片的分割性能,并考慮到小目標分割的挑戰,尤其在實際應用中具有更大的優勢,研究借鑒了注意力機制的思想,以期達到更好的效果。基于這個方法,本研究將Biformer 網絡替換YOLOv5 的主干網絡,提出了一種改進模型YOLOv5-Bifomer。

1.2.1 雙層路由結構

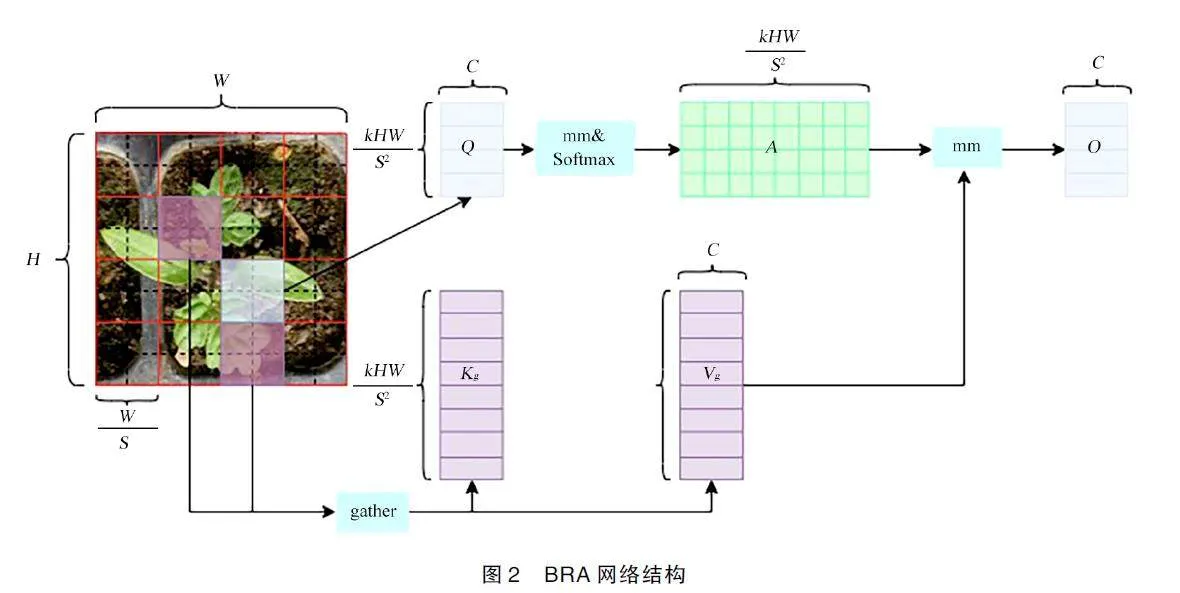

雙層路由注意力(bi-level routing attention,BRA)是Biformer 網絡中最為關鍵的模塊,其目的在于增強注意力機制,使其能夠高效地捕捉輸入序列內的局部及整體依賴關系。網絡Transformers 中的標準自注意力,通常需要在捕捉短范圍內的局部依賴和建模長范圍內的全局依賴之間存在權衡。Biformer 網絡則引入了一個雙層路由的過程,以解決這一問題。它將標準自注意力機制與全局級別的路由注意力機制結合,使得模型可以靈活地捕捉局部和全局的上下文信息。BRA 模塊結構如圖2 所示。這一雙層路由注意機制的引入為模型的注意力機制賦予了更強的表達能力,通過同時考慮局部和全局的依賴關系,BRA 模塊使得模型能夠更全面地理解輸入序列中的關聯信息,從而提升了模型在處理復雜關系時的性能。這種創新性的設計在Biformer 網絡中發揮著關鍵作用,為模型在處理茄科植物葉片等情景下的分割問題提供了有效的解決方案。

首先進行區域劃分, 給定一個2D 輸入特征圖X∈RH×W×C,BRA 將其分割成S×S 個非重疊的區域,使得每個區域包含HW/S2個特征向量。這一步通過將X 重新整形為Xr∈RS2×(HW/S2)×C來完成。這種劃分可以幫助BRA同時考慮到全局和局部的信息。

接下來使用標準的自注意力機制,類似于傳統的Transformer 模型。對于給定的輸入序列,每個位置都計算出一個查詢(query)向量、一組鍵(key)向量和一組值(value)向量。然后,通過點積計算查詢向量與鍵向量,再進行Softmax 操作,得到注意力權重,最后將權重與對應的值向量加權求和,得到當前位置的輸出表示。經過線性投影得到查詢(Q)、鍵(K)和值(V)張量,記為Q,K,V ∈RS 2×(HW/S 2)×C,其中Wq,Wk,Wv∈RC×C 分別是查詢、鍵、值的投影權重,給定輸入序列表示為X。模型如下

Q=XrWq (1)

K=XrWk (2)

V=XrWv (3)

分別對Q 和K 應用每個區域的平均,推導出區域級別的查詢和鍵Qr,Kr∈RS 2×C。Qr 和轉置的Kr 之間的矩陣乘法,得到區域間親和性圖的鄰接矩陣Ar∈ RS 2×S2。模型如下

Ar=Qr(Kr)T (4)

鄰接矩陣Ar 中的元素衡量了兩個區域之間的語義關聯程度。執行的核心步驟是通過僅保留每個區域的前k 個連接來修剪親和圖。具體來說,通過使用逐行的top-k 操作得到一個路由索引矩陣Ir∈NS2×K,Ir 的第i 行包含第i 區最相關區域的k 個指標。模型如下

Ir=ttopkIIndex(Ar) (5)

然后,BRA 模塊引入了全局路由注意力(globalrouting vector),以捕捉更遠處的全局依賴關系。這一步,每個位置的查詢向量將被用來與全局路由向量進行點積運算,得到一個路由權重。全局路由向量可以看作是全局信息的一個表示,它是在整個輸入序列中聚合而得。通過區域到區域的路由索引矩陣Ir,應用細粒度的令牌對令牌的注意力。對于區域i 中的每個查詢令牌,它將關注索引為Ir(i,1),Ir(i,2),……,Ir(i,k)的k個路由后的區域中的所有鍵值對。通過與全局路由向量的點積運算,每個位置都能獲得一個路由權重,該權重表示當前位置對全局信息的重要性。其中ggather 操作用于從輸入張量中按照給定的索引集合收集元素,Kg,Vg2RS 2×(KHW/S 2)×C是收集到的鍵和值張量。模型如下

Kg=ggather(K,Ir) (6)

Vg=ggather(V,Ir) (7)

最后,將局部自注意力的輸出表示與全局路由注意力的輸出表示進行加權求和,得到最終的位置表示。這種加權的方式使得模型能夠在保留局部上下文信息的同時,加入更遠處的全局依賴關系,從而更好地理解輸入序列的雙向上下文。AAttention 表示注意力機制的計算。通常,注意力機制涉及計算查詢向量(Q)與鍵向量(Kg)之間的相似度,然后使用Softmax 函數得到權重,最后用這些權重對值向量(Vg)進行加權求和,LCE(local context entropy)是局部上下文熵。用于引入一些局部的信息或復雜性。局部上下文熵的具體定義會涉及對值向量(V)的操作,以反映局部信息的復雜度。模型如下

O=AAttention(Q,Kg,Vg)+LLCE(V) (8)

1.2.2 BiFormer 網絡結構

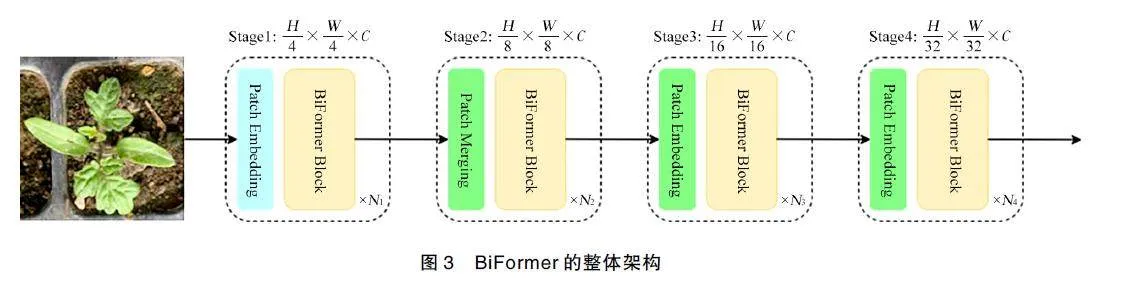

BiFormer 網絡結構如圖3 所示,在設計上汲取了Transformer 網絡的啟發。具體而言,在架構中的第1階段采用了重疊的塊嵌入,而在第2~4 階段則引入了塊合并模塊,以便降低輸入空間的分辨率,同時增加通道數[21-22]。接著,采用了N 個連續的BiFormer 塊來實現特征的轉換。通過將Bi-Level Routing Attention(BRA)融入到BiFormer 架構中,這個模型能夠更加有效地處理雙向的上下文信息,從而提高性能,尤其是在需要同時考慮局部和全局依賴關系的情況下。BRA 作為雙層路由的注意力機制,為模型提供了更靈活的建模能力。

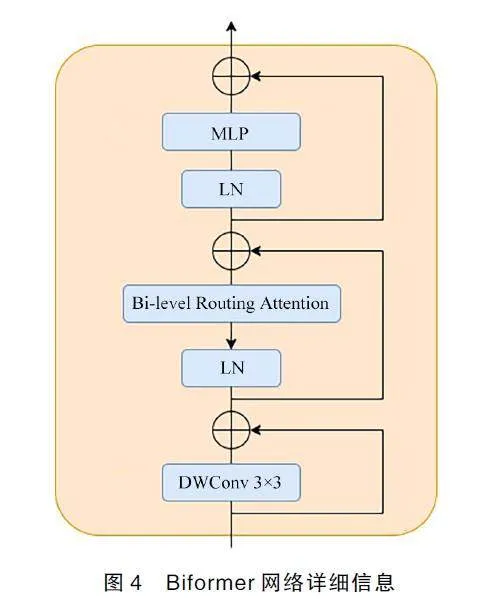

BiFormer 網絡信息如圖4 所示。首先,采用3×3的深度卷積來隱式編碼相對位置信息。然后,分別引入BRA 模塊和由兩層多層感知機(MLP)組成的模塊,分別用于對交叉位置關系進行建模和對每個位置的嵌入進行處理。通過調整網絡的寬度(即基礎通道數C)和深度(即每個階段使用的BiFormer 塊數,Ni,其中i=1,2,3,4),從而實例化了3 種不同規模的BiFormer模型。

2 模型訓練

2.1 數據來源

本研究使用茄科植物作為研究對象,包括番茄、茄子和辣椒3 種。為了對本研究方法進行真實有效的評估,構建了茄科植物葉片數據集,并分成用于訓練和測試的樣本。這些樣本是在實際智能溫室環境中進行拍攝獲取的,以保證數據與真實應用場景一致,智能溫室環境如圖5 所示[23]。該智能溫室裝備了一套綜合環境控制系統,可以直接調節室內的溫度、光照、水分、營養和氣體等多種因素,為植物的生長創造了理想的環境條件。拍攝地點位于新疆烏魯木齊市經濟技術開發區的新疆農業大學陸港校區(三坪教學實踐基地)。使用手機在自然光照的條件下進行植物圖像采集,拍攝的高度保持在植物正上方30 cm。共采集了1 500 張圖像數據,這些圖像以JPEG 格式進行保存。

2.2 圖像數據預處理

在網絡訓練過程中,必須對圖像進行篩選,并對其進行調整以達到模型訓練的需求。首先,需要丟棄不適合的圖像。其次,在調整植物大小時避免改變植物形態,具體步驟:①采集的原始圖像大小4 096 像素×3 072 像素;②將圖像大小調整為640 像素×480 像素(與MS COCO 數據集相同);③在構建數據集的過程中,會保留一部分模糊、遮擋和不完整的圖像作為負樣本[24]。最終,從原始的1 500 張圖像中,挑選出1 000張作為最終數據集。為了更好地豐富樣本圖像,使數據集更具代表性,并能更準確地反映現場數據的真實情況,在數據集構建的基礎上,采取了數據增強的方法,進行了隨機裁剪、旋轉、翻轉和縮放的擴充,進一步提升數據集的多樣性[25]。這一策略可以有效地豐富數據集,提升模型的訓練精度,并減少出現過擬合問題的可能性[26]。

使用Labelme 軟件對數據集中的原始圖像進行標注,并對目標物體的外邊緣進行輪廓勾畫,以獲得用于神經網絡學習的標記數據集,數據標注的類別為番茄真葉(Tomato leaf)、番茄子葉(Cotyledon leaf)、辣椒葉片(Pepper leaf)、茄子葉片(Eggplant leaf),原始圖像和標注圖像如圖6 所示[27]。將數據集中劃分為訓練集和測試集,每個文件夾中包括images 和labels,分別存放圖像和標簽,比例8∶2[28-29]。標注完的坐標信息保存在JSON 格式的文件中, 由于要訓練YOLOv5 和MASK R-CNN 網絡模型,所以要將標注完的JSON 文件轉換成txt 文件和符合MASK R-CNN 模型的JSON 文件。

2.3 環境配置

本研究在配置為Intel Core i7-12650H 處理器、主頻2.3 GHz、運行內存16 GB、顯卡Nvidia 4060、顯存8 GB 及Windows 10 系統的筆記本電腦上展開。編程語言使用Python 3.8,并以PyTorch 深度學習框架為基礎來構建實例分割模型,均方誤差函數曲線收斂后對模型進行分析。

在模型訓練時將圖像分辨率統一裁剪成640 像素×480 像素,選用隨機梯度下降法優化器,訓練100個Epoch,設置批次大小5、初始學習率0.01,動量參數和權值衰減參數分別設置0.937 和0.000 5。

2.4 評價指標

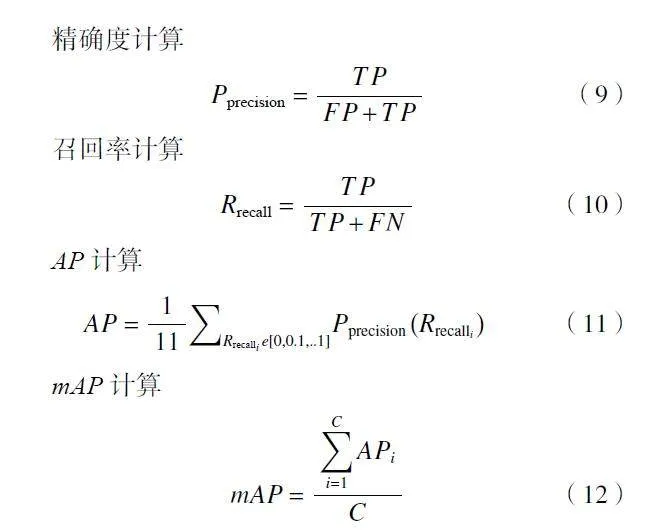

在圖像分割任務中,評估算法的準確性需要采用一系列評價指標[30]。對于實例分割技術而言,通常使用類別平均精度mAP(mean average precision)作為主要評價指標。其中,精確度Pprecision (precision)、召回率Rrecall(recall)及查準率?查全率PR(precision-recall)曲線下的面積AP 是構成mAP 的關鍵要素,高AP 值表示模型性能較佳。在圖像分割任務中,通常需要對不同類別進行分割,mAP 則是各類別AP 的平均值,綜合衡量了模型在多個類別上的表現。

式中 TP——被正確判定為正例樣本數量

FP——錯誤判定為正例樣本數量

FN——被錯誤判定為負例樣本數量

3 試驗結果及分析

3.1 模型分割結果對比

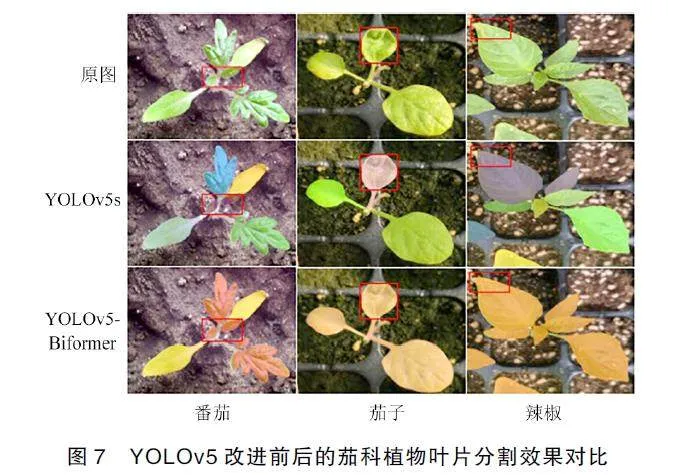

將原YOLOv5 網絡模型和改進后獲得的YOLOv5-BiFormer 模型在205 張測試集上進行試驗對比,選擇同一張茄科植物葉片圖片進行對比,以驗證改進網絡的實際分割效果,如圖7 所示。

由圖7 可知,由于茄科植物的嫩芽目標比較小,原YOLOv5 模型對于多目標場景下的茄科植物嫩芽等小目標分割能力較弱,出現分割不完整和小目標丟失等現象。然而,經過改進的YOLOv5-BiFormer 模型在同樣的多目標范圍下表現出更高的分割準確性。這表明在考慮茄科植物葉片等小目標的分割任務時,采用了BiFormer 架構的模型能夠更好地捕捉目標的細節信息,從而取得了更令人滿意的結果。這個改進不僅提升了嫩芽目標的定位精度,還在整體場景中展現出更好的目標分割能力。

3.2 不同算法比較

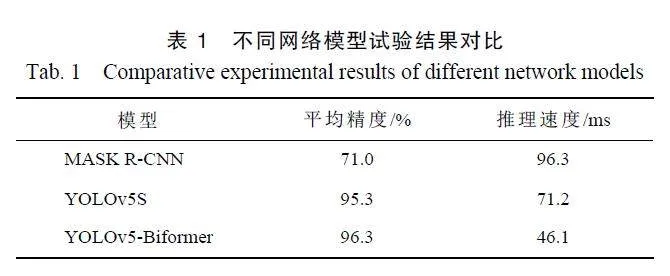

將基于YOLOv5 的YOLOv5-Biformer 模型與主流的實例分割網絡模型MASK R-CNN、YOLOv5s 進行試驗對比, 結果如表1 所示。通過表格可以看出,YOLOv5-Biformer 模型的平均精度比其他模型分別高25.2、1.0 個百分點,推理速度分別減少50.2、25.1 ms。改進后的YOLOv5-Biformer 提升效果顯著,足以滿足茄科植物葉片的實例分割。

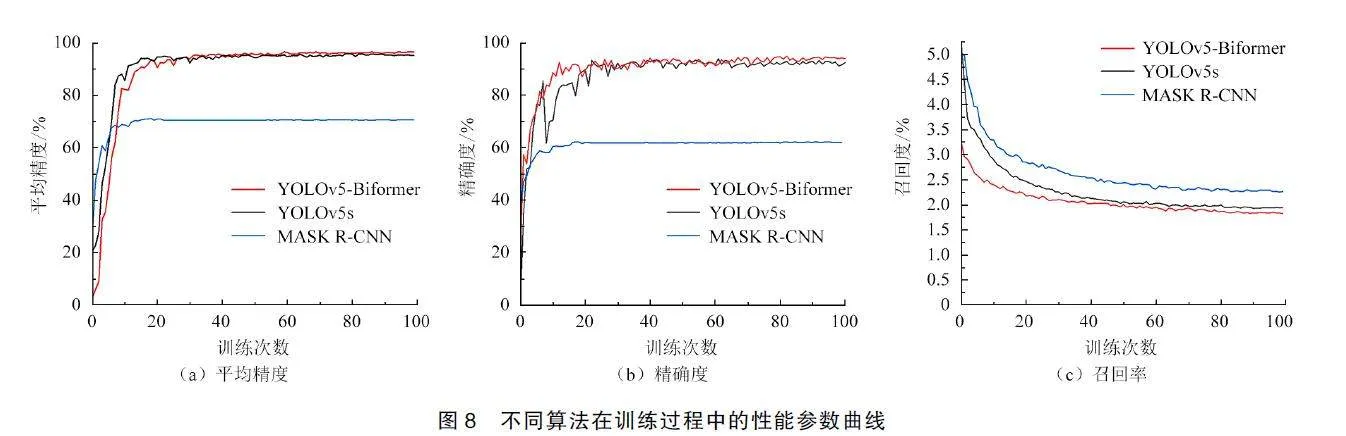

將各模型訓練中的精確度、召回率、平均精度進行對比,如圖8 所示,橫坐標均為訓練次數,縱坐標分別為精確度、召回率、平均精度的數值。由圖8 可知,隨著訓練次數的增加,準確率、召回率、精度數值都有所提升。在訓練次數≤15,平均精度快速提升;訓練次數≥30,改進后的YOLOv5-Biformer 模型的平均精度超過了原YOLOv5s 模型,并始終比其他模型平均精度高。

4 結束語

為了解決在分割茄科植物葉片時小葉片和葉片遮擋導致的YOLOv5 模型不準確的問題,本研究進行了改進, 提出了YOLOv5-Biformer 的模型。在原始的YOLOv5 模型基礎上,引入了雙層路由注意力模塊,以一種動態、查詢感知的方式來分配計算資源。核心模塊BRA 通過在粗區域級別上濾除最不相關的鍵值對,使模型能夠更精準地選擇相關信息,從而提升了模型的效率和性能。

根據茄科植物葉片在智能溫室環境中的特點,本研究對比了不同網絡模型, 分別為MASK R-CNN、YOLOv5s。研究結果表明,本研究提出的YOLOv5-Biformer 模型在精確度、召回率和平均精度等指標上都取得了顯著提升。相對于原始模型,YOLOv5-Biformer 模型的精確度提高0.5 個百分點,召回率提高1.9 個百分點,平均精度提高1 個百分點。此外,該模型的推理速度也有顯著的改善,減少25.1 ms。在實際智能溫室環境中,YOLOv5-Biformer 模型表現出色,其分割效果良好,能夠滿足實際需求。本研究成果為植物葉片的實例分割及智能農業等領域的研發提供了有價值的參考。

參考文獻

[1]曹華.四季果蔬香 種出好“錢”景[N].新疆日報(漢),2022-09-06(1).

[2]史彩娟,陳厚儒,張衛明,等.圖像實例分割綜述[C]//中國高科技產業化研究會智能信息處理產業化分會.第十四屆全國信號和智能信息處理與應用學術會議論文集,2021.

[3]周飛燕,金林鵬,董軍.卷積神經網絡研究綜述[J].計算機學報,2017,40(6):1229-1251.

ZHOU Feiyan, JIN Linpeng, DONG Jun. Review of convolutionalneural network[J]. Chinese Journal of Computers, 2017, 40( 6) :1229-1251.

[4]HARIHARAN B, ARBELáEZ P, GIRSHICK R, et al. Simultaneousdetection and segmentation[C]//Computer Vision–ECCV 2014:13th European Conference, Zurich, Switzerland, Proceedings, PartVII 13.Springer International Publishing,2014:297-312.

[5]HE K, GKIOXARI G, DOLLáR P, et al. Mask R-CNN[C]//Proceedingsof the IEEE International Conference on Computer Vision,2017:2961-2969.

[6]HUANG Z, HUANG L, GONG Y, et al. Mask scoring RCNN[C]//Proceedings of the IEEE/CVF Conference on Computer Visionand Pattern Recognition,2019:6409-6418.

[7]XIE E, SUN P, SONG X, et al. Polarmask: Single shot instancesegmentation with polar representation[C]//Proceedings of theIEEE/CVF Conference on Computer Vision and Pattern Recognition,2020:12193-12202.

[8]TIAN Z,SHEN C,CHEN H,et al.FCOS:fully convolutional onestageobject detection[J].2019.arxiv:1904.01355.

[9]ZHANG G,LU X,TAN J,et al.Refinemask:towards high-qualityinstance segmentation with fine-grained features[C]//Proceedings of theIEEE/CVF Conference on Computer Vision and Pattern Recognition,2021:6861-6869.

[10]WANG Y, XU Z, WANG X, et al. End-to-end video instance segmentationwith transformers[C]//Proceedings of the IEEE/CVF Conferenceon Computer Vision and Pattern Recognition,2021:8741-8750.

[11]王琢,汪雅婷,宋文龍,等.基于深度學習的葉片圖像分割算法[J].森林工程,2019,35(1):42-46.

WANG Zhuo, WANG Yating, SONG Wenlong, et al. The leaf imagesegmentation algorithm based on deep learning[J].Forest Engineering,2019,35(1):42-46.

[12]YANG X, CHEN A, ZHOU G, et al. Instance segmentation andclassification method for plant leaf images based on ISC-MRCNN andAPS-DCCNN[J].IEEE Access,2020,8:151555-151573.

[13]PRAVEEN K J, DOMNIC S. Rosette plant segmentation with leafcount using orthogonal transform and deep convolutional neuralnetwork[J].Machine Vision and Applications,2020,31(1):6.

[14]GUO R, QU L, NIU D, et al. Leafmask: towards greater accuracyon leaf segmentation[C]//Proceedings of the IEEE/CVF InternationalConference on Computer Vision,2021:1249-1258.

[15]VAYSSADE J A, JONES G, GéE C, et al. Pixelwise instance segmentationof leaves in dense foliage[J]. Computers and Electronics inAgriculture,2022,195:106797.

[16]李婧雯.基于光度立體和神經網絡的植物葉片重建與分割[D].西安:西安工業大學,2023.

LI Jingwen. Reconstruction and segmentation of plant leaves based onphotometric stereo and neural networks[D].Xi'an:Xi'an TechnologicalUniversity,2023.

[17]樊東燕.基于CNN 的植物葉片病害智能檢測系統算法設計與仿真[J].農業技術與裝備,2022(11):36-37,40.

FAN Dongyan. Design and simulation of plant leaf disease intelligentdetection system algorithm based on CNN[J].Agricultural Technologyamp; Equipment,2022(11):36-37,40.

[18]JOCHER G, STOKEN A, CHAURASIA A, et al. Ultralytics/YOLOv5: v7.0 - YOLOv5 SOTA realtime instance segmentation[J].Zenodo,2021.

[19]ZHU L,WANG X,KE Z,et al.Biformer:vision transformer withbi-level routing attention[C]//Proceedings of the IEEE/CVF Conferenceon Computer Vision and Pattern Recognition,2023:10323-10333.

[20]VASWANI A, SHAZEER N, PARMAR N, et al. Attention is allyou need[J]. Advances in Neural Information Processing Systems,2017,30.

[21]REN S,ZHOU D,HE S,et al.Shunted self-attention via multi-scaletoken aggregation[C]//Proceedings of the IEEE/CVF Conference onComputer Vision and Pattern Recognition,2022:10853-10862.

[22]LI K,WANG Y,GAO P,et al.Uniformer:unified transformer forefficient spatiotemporal representation learning[J]. 2022. arxiv:2201.04676.

[23]龔琴. 基于物聯網的溫室大棚智能監控系統在農業中的應用[J].電腦與信息技術,2022,30(1):53-56.

GONG Qin. Application of greenhouse intelligent monitoring systembased on internet of things in agriculture[J].Computer and InformationTechnology,2022,30(1):53-56.

[24]LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft coco: commonobjects in context[C]//Computer Vision–ECCV 2014: 13thEuropean Conference, Zurich, Switzerland, Proceedings, Part V13.Springer International Publishing,2014:740-755.

[25]高友文,周本君,胡曉飛.基于數據增強的卷積神經網絡圖像識別研究[J].計算機技術與發展,2018,28(8):62-65.

GAO Youwen, ZHOU Benjun, HU Xiaofei. Research on image recognitionof convolution neural network based on data enhancement[J]. Computer Technology and Development, 2018, 28( 8) : 62-65.

[26]SHORTEN C,KHOSHGOFTAAR T M.A survey on image data augmentationfor deep learning[J].Journal of BIG DATA,2019,6:60.

[27]RUSSELL B C,TORRALBA A,MURPHY K P,et al.LabelMe:adatabase and web-based tool for image annotation[J]. InternationalJournal of Computer Vision,2008,77:157-173.

[28]YU Y, ZHANG K, YANG L, et al. Fruit detection for strawberryharvesting robot in non-structural environment based on Mask-RCNN[J]. Computers and Electronics in Agriculture, 2019, 163:104846.

[29]GONZALEZ S,ARELLANO C,TAPIA J E.Deepblueberry:quantificationof blueberries in the wild using instance segmentation[J].IeeeAccess,2019,7:105776-105788.

[30]劉春燕.圖像分割評價方法研究[D].西安:西安電子科技大學,2011.

LIU Chunyan.Survey on evaluation methods of image segmentation algorithms[D].Xi'an:Xidian University,2011.

基金項目: 新疆維吾爾自治區重大科技專項(2022A02011)