關于Word2Vec文本分類效果若干影響因素的分析

DOI:10.19850/j.cnki.2096-4706.2024.01.026

收稿日期:2023-03-21

摘? 要:Word2Vec向量模型參數眾多,在不同情景下分類效果不一,分析其影響因素很有必要。從Word2Vec模型基本原理出發,分析討論了預訓練語料、詞向量預訓練參數以及分類模型參數三大因素對模型分類效果的影響。結果表明限定域預料效果好于廣域預料;預訓練參數中向量維度越大,效果越好,窗口大小存在最優值,分類算法影響不大;分類模型參數中學習率、激活函數、批次大小對模型分類效果影響較大,訓練輪次相對較小。

關鍵詞:Word2Vec;文本分類;模型效果;影響因素

中圖分類號:TP391? 文獻標識碼:A? 文章編號:2096-4706(2024)01-0125-05

Analysis of Several Influencing Factors on Word2Vec Text Classification Effect

XIE Qingheng

(National Library of China, Beijing? 100081, China)

Abstract: The Word2Vec vector model has numerous parameters, and its classification effect varies in different scenarios. It is necessary to analyze its influencing factors. Starting from the basic principles of the Word2Vec model, this paper analyzes and discusses the impact of three major factors of pre trained corpus, pre trained parameters of word vectors, and classification model parameters on the model's classification effect. The results indicate that the effect of limited domain prediction is better than that of wide domain prediction. And the larger the vector dimension in the pre trained parameters, the better the effect. There is an optimal value in window size, and the classification algorithm has little impact. The learning rate, activation function and batch size of the classification model parameters have a greater impact on the classification effect of the model, and the training round is relatively small.

Keywords: Word2Vec; text classification; model effect; influencing factor

0? 引? 言

文本分類是自然語言處理領域的經典問題,2003年Bengio提出的NNLM[1]是早期使用神經網絡實現語言模型的經典模型。2013年,Word2Vec模型[2]借鑒NNLM的思想,提出用語言模型訓練得到詞向量。盡管GPT2、BERT、XLNet等深度學習神經網絡模型在分類效果上取得了突破性進展,但這些模型的預訓練對硬件要求較高,一般用戶難以承受。相對而言,Word2Vec模型對硬件要求不高,并且在近義詞分析,相近詞的關聯分析中仍有不錯的表現,因此Word2Vec模型至今仍在大量使用。有的學者關注Word2Vec詞向量的優化與改進。張克君等[3]從訓練詞向量的語言模型入手,提出了一種基于關鍵詞改進的語言模型,在查準率和相似度方面有一定優化。彭俊利等[4]通過融合單詞貢獻度與Word2Vec詞向量提出一種新的文檔表示方法,使得模型的準確率、召回率和F1值均有所提升;有的關注其與其他模型的結合使用。唐煥玲等[5]針對文本表示中的語義缺失問題,基于LDA主題模型和Word2vec模型,提出一種新的文本語義增強方法,較其他經典模型效果均有所改善。席笑文等[6]針對傳統LDA主題模型忽略專利文本上下文間語義關聯的問題,提出了基于word2vec和LDA主題模型的技術相似性可視化研究方法,實驗證明了該模型在技術相似性測度分析中具有較好的效果;有的則基于Word2Vec詞向量探討行業應用問題,開拓模型的應用場景。周豐等[7]基于Word2Vec大數據語義分析工具,通過大數據分析各種瓶裝水的評論信息,挖掘其深層印象,從而指導瓶裝水的設計實踐。謝爽等[8]針對體檢數據中文本型數據特征提取問題,提出利用Word2vec和卷積神經網絡相結合的方法對數據中的文本特征進行特征提取,建立高血壓和高血脂疾病的預測模型。可見Word2Vec模型在自然語言處理領域仍有自身優勢和存在價值。然而,Word2Vec模型參數較多,在不同場合表現出的效果差異較大,到底哪些因素影響了模型分類效果?是如何影響的?影響有多大?如何改進提升模型效果?帶著這些問題,本文將從模型原理出發,通過數據分析實驗找出模型分類效果的影響因素,以期為模型的后期使用提升提供一些參考。

1? 模型原理

Word2Vec是由Google的Mikolov等[2]人提出的一個詞向量計算模型。基本模式是輸入大量已分詞的文本,輸出稠密表示的詞向量。詞向量的重要意義在于將自然語言轉換成了計算機能夠理解的向量。詞向量就是用來將語言中的詞進行數學化的一種方式,顧名思義,詞向量就是把一個詞表示成一個向量,One-Hot編碼和分布式編碼是其常見的兩種編碼方式。相對于詞袋模型、TF-IDF等模型,詞向量能抓住詞的上下文、語義,衡量詞與詞的相似性,在文本分類、情感分析等許多自然語言處理領域有重要作用。由于One-Hot編碼存在維度災難、詞匯鴻溝、強稀疏性等缺陷,Word2Vec主要采用分布式編碼方式。Word2Vec是輕量級的神經網絡,主要包括CBOW(圖1)和Skip-gram(圖2)兩種模式,它們的最大區別是Skip-gram是通過中心詞去預測中心詞周圍的詞,而CBOW是通過周圍的詞去預測中心詞,二者本質上區別不大。

以CBOW模式為例,其訓練過程如下:

1)將中心詞的上下文詞語x1,x2,…,xc的one-hot編碼形式輸入到輸入層。

2)將x1,x2,…,xc分別乘以同一個矩陣WV×N后分別得到各自1×N的向量。

3)將這些1×N向量取平均得到一個1×N隱藏向量hi。

4)將隱藏向量hi乘以矩陣 ,得到1×V預測向量。

5)將1×V向量進行softmax歸一化處理。

6)將概率值最大的數對應的詞作為預測詞yj。

7)將預測結果yj向量和真實標簽? 向量進行交叉熵誤差計算。

8)在每次前向傳播之后反向傳播誤差,不斷更新調整WV×N和? 矩陣的值直至誤差達到預先設定的某個值。

訓練結束后WV×N權重矩陣就是詞向量的集合,每行對應一個詞向量。比如第n個詞對應WV×N中的第n行,這樣,就把詞向量從V維的稀疏向量表示轉換成N維的稠密向量表示,便于后續進一步的處理計算。

2? 影響因素

2.1? 數據來源

2.1.1? 語料數據

百度百科中文數據來自互聯網公開數據,文件大小1.42 GB,涵蓋科技、音樂、醫學、文學等社會各方面的各類數據共計4 410 426條;R73類摘要數據來自萬方在線學位論文數據庫。具體處理過程是,采集萬方官網學位論文欄目下近十年來中圖分類號為R733.7、R734.2、R735.1、R735.2、R735.3、R735.7、R737.1、R737.3、R737.9的9類學位論文摘要數據,每類5 000條,共45 000條;同樣的,S5類摘要數據也來自萬方在線學位論文數據庫,采集萬方官網學位論文欄目下近十年來中圖分類號S511、S512、S513、S52、S53、S54、S562、S565.1、S565.2、S566、S567的11類論文摘要數據共32 118條。

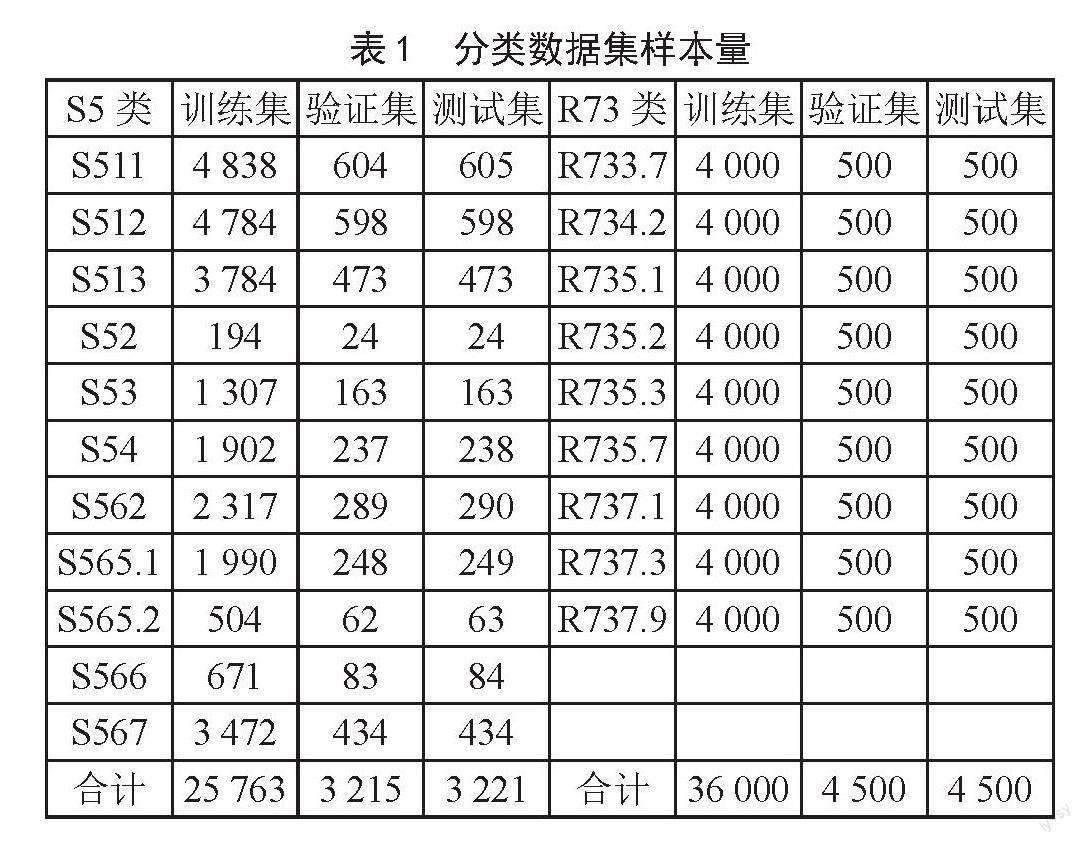

2.1.2? 分類數據

分類數據來自萬方在線學位論文數據庫,如表1所示。其中R73類標題數據采集萬方官網學位論文欄目下近十年來中圖分類號為R733.7、R734.2、R735.1、R735.2、R735.3、R735.7、R737.1、R737.3、R737.9的9類學位論文標題數據。去除純英文標題樣本,有多分類號的論文數據則確保只使用一次,經過數據清洗去重后,篩選出每類5 000條數據,并從中分別隨機抽取10%作為驗證數據,10%作為評價數據。故訓練樣本集共9類36 000條數據,評價樣本集為9類4 500條數據,驗證樣本集為9類4 500條數據,并且各數據集之間不存在任何重復。同樣地,S5類標題數據采集自萬方官網學位論文欄目下近十年來中圖分類號S511、S512、S513、S52、S53、S54、S562、S565.1、S565.2、S566、S567的11類學位論文標題數據,經過刪除純英文標題樣本、清洗去重、確保多分類號的論文數據只使用一次等處理之后,得到非平衡數據樣本總量32 199條,其中樣本量最大的為S511類共6 047條,最小的為S52類共242條,同樣按照8:1:1的比例隨機劃分為訓練集(25 763條)、驗證集(3 215條)和測試集(3 221條)。

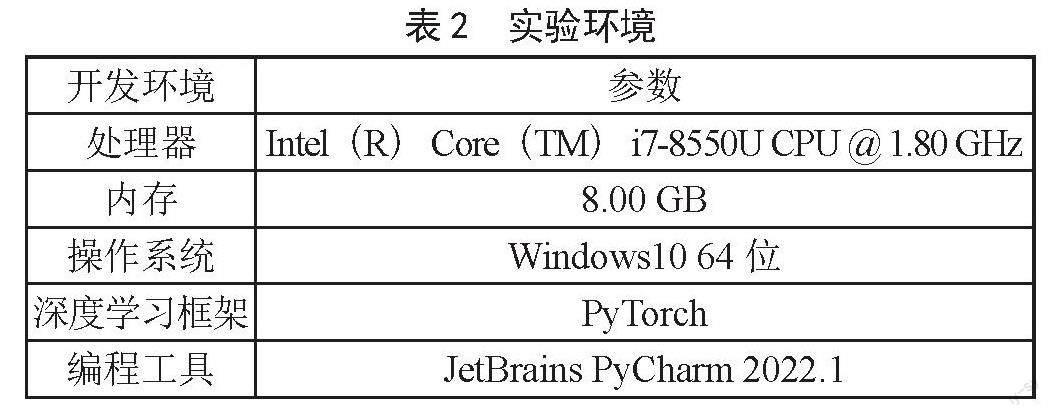

2.2? 實驗環境

由于PyTorch在易用性與速度方面較優,因此本文采用PyTorch搭建深度學習框架,實驗環境如表2所示。

2.3? 預訓練語料

分別選取百度百科中文數據、R73類摘要數據和S5類摘要數據作為預訓練語料,詞向量訓練模型參數設置為:向量維數300,其他均采用gensim模塊中Word2Vec的默認參數設置;分類模型采用softmax線性分類器,將分類樣本詞向量(即基于詞向量模型的學位論文標題數據)直接輸入到線性分類器中得到分類結果,參數dropout率設置為0.5,損失函數采用交叉熵函數。

運行結果如表3所示,R73類中基于百度百科問答資料訓練語料的詞向量特征的分類F1值比基于R73類腫瘤學摘要數據訓練語料得到的詞向量的分類F1值低10.02個百分點,后者分類效果顯著高于前者,表明基于限定域語料預訓練的詞向量表示的文本特征效果優于廣域語料;從S5類的分類結果也可得出同樣結論,基于S5類摘要數據語料的分類結果比基于百度百科語料的分類結果高出11.16個百分點。由此可見,預訓練語料在很大程度上影響了Word2Vec模型的詞向量訓練效果,選取預訓練語料對于Word2Vec模型分類至關重要。限定領域語料相對于廣域語料針對性更強,關注點更聚焦,訓練出的詞向量在限定領域的表征能力更強,從而使得模型分類效果更好。表3顯示基于R73類摘要數據的模型分類效果最佳,故下文的實驗數據集采用R73類數據集,包括摘要數據和標題分類數據。

2.4? 詞向量預訓練參數

Gensim中Word2Vec模型參數主要包括詞向量維度、窗口大小、算法選擇、是否采用負采樣、詞向量最小詞頻、最大迭代次數等。前三個是比較重要的參數,如表4所示。詞向量維度表示詞向量的表達空間大小,維度越大,對文本的表征能力就越強。窗口大小表示詞向量上下文的最大距離,窗口越大,則與該詞產生上下文關系的詞的范圍就越廣。算法包括CBOW和Skip-gram兩種,主要區別在于前者是用周圍詞去預測中心詞,后者是用中心詞去預測周圍詞。默認參數為:詞向量維度為300,窗口大小為5,算法為CBOW。

1)分別設置詞向量維度參數為100、200、300進行實驗(其他參數設為默認),結果表明300維分類結果高出200維0.65個百分點,高出100維5.28個百分點,可見維度越大,分類效果越好;

2)分別設置窗口大小為4、5、6、7進行實驗(其他參數設為默認),結果表明窗口大小對分類效果的影響呈現倒“U”型,窗口大小設為6時分類效果最優,達到96.81%,可見窗口大小設置存在一個最優值;

3)分別設置算法參數分別為0(CBOW)和1(Skip-gram),其他參數設為默認,實驗結果表明CBOW算法效果略優于Skip-gram,效果幾乎相當。

2.5? 分類模型參數

1)分別設置學習率參數為0.000 01、0.000 1、0.001、0.002、0.005、0.008、0.01、0.1、0.15、0.2、0.25,選取300維詞向量模型,訓練輪次為3,批次大小為128,采用Softmax線性分類器,結果表明(圖3),F1值在0.000 01時最小為0.145 3,0.000 1處陡增至0.763 8,在0.001處再次增至0.929 3,之后平緩增加,直至0.008處達到最大值0.938 1,之后保持在最大值附近上下微小波動,說明學習率的選取對模型分類效果影響較大。學習率主要影響損失函數后向傳播中對權重系數的更新(式(1))。學習率lr過小則可能出現權重系數w′更新不充分,使模型陷入局部最優陷阱,找不到全局最優解。圖4顯示學習率在0.12時模型具有較好的收斂性。

(1)

2)分別設置激活函數為ReLU、Sigmoid、Tanh,選取300維詞向量,學習率設為0.12,訓練輪數為3,批次大小為128進行實驗,結果(表5)顯示Tanh激活函數的F1值最高為93.51%,其次是Sigmoid的93.27,最小是ReLU的91.57%,表明Tanh為激活函數分類效果最佳,優于在大多數任務中表現突出的ReLU函數。這也說明激活函數的選取需要根據特定任務進行調整,并非一成不變,需要具體問題具體分析。

3)設置批次大小分別為50、60、80、100、140、160、180,選取300維詞向量,學習率設為0.12,訓練輪數為3進行實驗,結果(圖5)顯示F1值呈現雙波峰形態,在80和160處取到波峰值,在50、128、180處取得波谷值,表明批次大小并非越大越好,也并非越小越好,而是存在一個中間值使模型效果最優。批次大小表示每批數據量的大小,決定了每次迭代用來更新模型權重的數據樣本量,值越小,隨機性越大,越便于模型尋找全局最優,但缺點是模型不易收斂;值越大,越能夠表征全體數據的特征,其確定的梯度下降方向越準確,且迭代次數少,總體速度更快,缺點是相對來講缺乏隨機性,容易使梯度始終向單一方向下降,陷入局部最優。

4)設置訓練輪次分別為3、4、5、6、7、8,選取300維詞向量,學習率設為0.12,批次大小128,softmax作為分類器,損失函數為交叉熵函數。結果(圖6)顯示F1值呈現“鋸齒”形態,在3處取到最小值93.48%,在6處取得最大值94.06%,整體是呈上升趨勢。表明在一定范圍內,訓練輪數越大,模型效果越好,但模型整體效果相差不大,考慮到時間經濟性,選取較小輪數比較合適。

3? 結? 論

本文討論了影響Word2Vec文本分類效果的3大主要因素,即預訓練語料、詞向量預訓練參數以及分類模型參數,得出以下結論:

1)相對于廣域預訓練語料,限定域(專業領域)預訓練語料針對性更強、關注點更聚焦,因此基于限定域訓練得到的詞向量表征能力更強,能更準確的表達文本語義,語料的選取對模型分類效果影響較大。

2)詞向量預訓練參數中向量維度越大,表征能力越強,分類效果越好;窗口大小則呈現到“U”型影響效果,即存在一個最優窗口使得向量表達效果最佳,可見窗口大小選擇對模型效果影響較大;而分類算法在本實驗中則表現出幾乎相當的效果,算法選取對模型分類效果影響不大。

3)分類模型參數中學習率對模型效果的影響存在突變現象,可見學習率選取對模型影響較大;不同激活函數在分類效果是存在差異,本實驗中Tanh函數效果最佳,優于在大多數任務中表現突出的ReLU函數,說明激活函數的選取需要根據特定任務進行調整,并非一成不變,需要具體問題具體分析;批次大小對模型效果的影響呈現雙波峰形態,即批次大小不宜過大過小,需合理選取,說明批次大小對模型分類效果影響較大;訓練輪次對模型的影響則呈“鋸齒”狀緩慢上升,但整體差異較小,考慮到時間經濟性,選取較小輪數比較合適,也說明訓練輪次對模型分類效果影響不大。

參考文獻:

[1] BENGIO Y ,DUCHARME R,VINCENT P,et al. A Neural Probabilistic Language Models [J]. Journal of Machine Learning Research ,2003,3:1137-1155.

[2] MIKOLOV T,CHEN K,CORRADO G,et al. Efficient Estimation of Word Representations in Vector Space [J/OL].arXiv: 1301.3781 [cs.CL].(2023-01-16).https://arxiv.org/abs/1301.3781.

[3] 張克君,史泰猛,李偉男,等.基于統計語言模型改進的Word2Vec優化策略研究 [J].中文信息學報,2019,33(7):11-19.

[4] 彭俊利,谷雨,張震,等.融合單詞貢獻度與Word2Vec詞向量的文檔表示 [J].計算機工程,2021,47(4):62-67.

[5] 唐煥玲,衛紅敏,王育林,等.結合LDA與Word2vec的文本語義增強方法 [J].計算機工程與應用,2022,58(13):135-145.

[6] 席笑文,郭穎,宋欣娜,等.基于word2vec與LDA主題模型的技術相似性可視化研究 [J].情報學報,2021,40(9):974-983.

[7] 周豐,殷麗麗,沈瓊,等.基于word2vec的瓶裝水線上評論智能分析 [J].包裝工程,2022,43(S1):48-55.

[8] 謝爽,范會敏.基于Word2vec和卷積神經網絡特征提取的雙高疾病預測 [J].計算機應用與軟件,2021,38(2):93-96+125.

作者簡介:謝慶恒(1988—),男,漢族,江西豐城人,館員,碩士,研究方向:文獻編目。