基于視覺的相機位姿估計方法綜述

摘 要:相機位姿估計是通過估計相機的位置坐標和環繞三個坐標軸的角度偏轉,來描述其相對于給定場景的方向和位置,是自動駕駛、機器人技術等任務的重要組成部分。為幫助研究人員在相機位姿估計領域的研究,對相機位姿估計的研究現狀和最新進展進行梳理。首先介紹了相機位姿估計的基本原理、評價指標和相關數據集;然后從場景關系搭建和相機姿態解算兩個關鍵技術出發,對兩階段模型結構方法和單通道模型結構方法進行闡述總結,分別從核心算法和利用的場景信息不同上進行分類歸納分析,并對室內室外公開數據集上的表現作對比;最后闡述了該領域當前面對的挑戰和未來的發展趨勢。

關鍵詞:相機位姿估計; 深度學習; 場景關系搭建; 姿態解算

中圖分類號:TP391 文獻標志碼:A

文章編號:1001-3695(2024)08-001-2241-11

doi:10.19734/j.issn.1001-3695.2023.11.0552

Overview of vision-based camera pose estimation methods

Wang Jing, Wang Yibo, Guo Cheng, Guo Ping, Ye Xing, Xing Shujun

(College of Communication & Information Technology, Xi’an University of Science & Technology, Xi’an 710054, China)

Abstract:Camera pose estimation plays a crucial role in tasks such as autonomous driving and robotics, elucidating the direction and position of the camera in relation to a given scene through the estimation of its positional coordinates and angular deviations around the three coordinate axes. To facilitate the understanding of researchers in the realm of camera pose estimation, this paper comprehensively reviewed the current research status and latest progress in this field will. Firstly,it introduced the fundamental principles, evaluation indicators, and pertinent datasets associated with camera pose estimation. Subsequently, the review elaborated and summarized the two-stage model structure method and single-channel model structure method from the two key technologies of scene relationship construction and camera pose calculation. It conducted classification and analysis based on the diverse core algorithms and scene information employed, with performance comparisons drawn from indoor and outdoor public datasets. Lastly, it expounded the current challenges in the field and future development trends.

Key words:camera pose estimation; deep learning; scene relationship construction; pose calculation

0 引言

相機位姿估計是計算機視覺中的一個基本問題,同時也是移動機器人、SLAM[1]、增強現實(AR)[2,3]、自動駕駛[4,5]的核心技術之一,準確估計相機的位姿對于上述領域的應用至關重要。相機位姿估計也被稱為相機定位,具體來講就是通過圖像或視頻來確定相機在世界坐標系下的位置和朝向。在過去的幾十年中,相機位姿估計已經得到了廣泛的研究和應用,而隨著深度學習的發展,越來越多的方法開始將其應用于相機位姿估計中。

回顧相機位姿估計的發展,從一開始的幾何方法到圖像檢索方法,再到近幾年發展迅速的深度學習方法,估計的相機姿態在準確性和魯棒性上有了很大的提升。幾何方法通過對從查詢圖像中提取出的關鍵點進行描述得到特征,進而與3D點云模型進行匹配[6],得到查詢圖像和場景之間的關系[7,8],通過三角測量或PnP(perspective-n-point)[9]等方法進行解算,求得相機位姿。該方法實現簡單,但易受噪聲影響、場景變換導致魯棒性較差,且計算量大。基于圖像檢索法[10]主要是選擇最佳的匹配圖像,在圖像數據庫中檢索與查詢圖像相似的最近鄰圖像[11],利用該近鄰圖像的三維模型信息,計算出相機的位姿。但在實際情況中,檢索過程中往往不能得到相似度極高的近鄰圖,這會大大影響位姿估計的精度[12],且隨著場景尺寸的增大,圖像數據庫的占用量會隨之上升,這對模型實現實時性是一個相當大的挑戰。隨著深度學習在計算機視覺領域取得的成功,受此啟發,2015年,Kendall等人[13]提出了PoseNet,該模型是第一個從輸入查詢圖像直接輸出位姿的模型,由于其估計相機位姿的過程不依賴交叉幀或關鍵點,令其相較于傳統基于結構的方法有著很多優勢,如推理時間短、內存占用少、人工成本低等,但該方法初期對場景信息的利用不充分,性能相較于傳統方法并沒有實現超越,后續眾多研究人員對其進行研究,目前結合深度學習的方法成為了研究趨勢。

本文根據模型結構上的差異將相機位姿估計的方法進行分類,在頂層分類為兩階段模型結構方法和單通道模型結構方法。在這兩個類別上,根據基于結構的混合方法中核心算法不同,以及基于深度學習的場景信息利用上的不同,進行更為具體的分類。其中基于深度學習的方法將關系搭建和位姿解算設計進一個整體的模型里,只需輸入查詢圖像就能得到相機位姿。基于結構的混合方法中,查詢圖像與場景之間的關系搭建和位姿解算是兩個分開的階段。相較于陳宗海等人[14]的橫向分類方法以及Shavit等人[15]的端到端和混合位姿分類方法,本文在不同的類別上更能關注到算法核心點,不再局限于2D-3D之間的映射[16~21],對于場景信息的利用上劃分更為細致。本文將對主流的相機位姿估計方法進行綜述,并介紹最新基于深度學習的相機位姿估計方法,為相關領域的研究人員提供幫助。最后,總結當前研究的局限和挑戰,并得出未來的發展方向。

1 基礎知識

1.1 相機位姿估計

相機采集圖像的本質是將3D空間中的點映射為成像平面,使用相機中的光感傳感器記錄亮度信息,獲取像素點,形成照片。相機成像模型為成像過程提供數學理論支持,其過程如圖1所示,整個過程包括相機坐標系、世界坐標系、圖像坐標系和像素坐標系間的轉換。相機成像過程中構成相似三角形,通過相似三角形建立等比關系:

Zcf=Xcx=Ycy(1)

其中:f為相機焦距;(Xc,Yc,Zc)是相機坐標系下的坐標;(x,y)是圖像坐標系下的坐標。投影后的坐標為

x=fXcZc(2)

y=fYcZc(3)

在相機位姿的表示上,目前有歐氏變換、歐拉角、四元數等表示方式。歐氏變換中使用旋轉矩陣來表示相機位姿過于冗余,而使用歐拉角來表示位姿時因其奇異性容易出現鎖死狀態,四元數表示方法改善了前兩種表示方法的缺點,表示不冗余,并且不會因奇異導致鎖死,其表示公式為

p=p0+p1i+p2j+p3k(4)

其中:i,j,k為虛部,具有以下約束:

i2=j2=k2=1ij=k,ji=-kjk=i,kj=-iki=j,ik=-j(5)

若相機繞著單位向量m旋轉了Φ度,則其旋轉向量表示為

R=1-2p22-2p232p1p2-2p0p32p1p3+2p0p22p1p2+2p0p31-2p21-2p232p2p3-2p0p12p1p3-2p0p22p2p3+2p0p11-2p21-2p22(6)

可將式(6)簡化為

R= b11b12b13b21b22b23b31b32b33(7)

此時旋轉矩陣與四元數轉換關系為

p0=tr(R)+12(8)

p1=b23-b324p0(9)

p2=b31-b134p0(10)

p3=b12-b214p0(11)

四元數表示的相機位姿為

R=[x,y,z,p0,p1,p2,p3]T(12)

1.2 評價指標

評價指標是用來度量和比較不同算法或模型性能的標準。能夠量化不同方面的性能,幫助研究人員直觀地了解算法或模型的表現,為后續算法的優化和改進提供指導。

在測量評估相機位姿估計模型性能的過程中,需要將估計方法所計算的位姿與地面真實姿態進行比較,所得到的誤差越小,說明估計的結果與地面真實姿態越接近。地面真實姿態通過使用運動結構(SfM)[22]工具或者由掃描設備(如Microsoft Kinect)直接提取三維場景中的坐標。

1.2.1 平移和旋轉誤差

大部分的數據集提供地面真實姿態的6Dof信息。在使用估計的姿態來測量偏差時,若輸入為單個圖像,誤差度量為絕對姿態誤差(APE),包含了絕對平移誤差和絕對旋轉誤差。絕對平移誤差為估計的平移分量和地面真實平移分量x之間的歐幾里德距離:

tape=‖x-‖2(13)

絕對旋轉誤差,以度為單位,可以計算得到對準地面實況和估計取向所需最小旋轉角度。

rape=α=2 arccosq180π(14)

若輸入為序列圖像,誤差度量為相對姿態誤差(RPE),包含了相對水平誤差和相對旋轉誤差,與APE相同,使用四元數表示法,RPE主要度量視覺里程計相對運動姿態。

1.2.2 采樣閾值誤差

部分模型采用間接方法測量定位性能,如采樣閾值誤差百分比,即就是通過將估計的相機位姿與真實的相機位姿進行比較,計算誤差(例如歐幾里德距離或角度差),并將其與給定的固定閾值進行比較。如果誤差超過了固定閾值,就會被計入固定閾值錯誤的數量中。固定閾值包括高精度(0.25 m,2°)、中等精度(0.5 m,5°)以及粗精度(5 m,10°)。使用百分比突出顯示總體的準確性,百分比越高,性能越好。

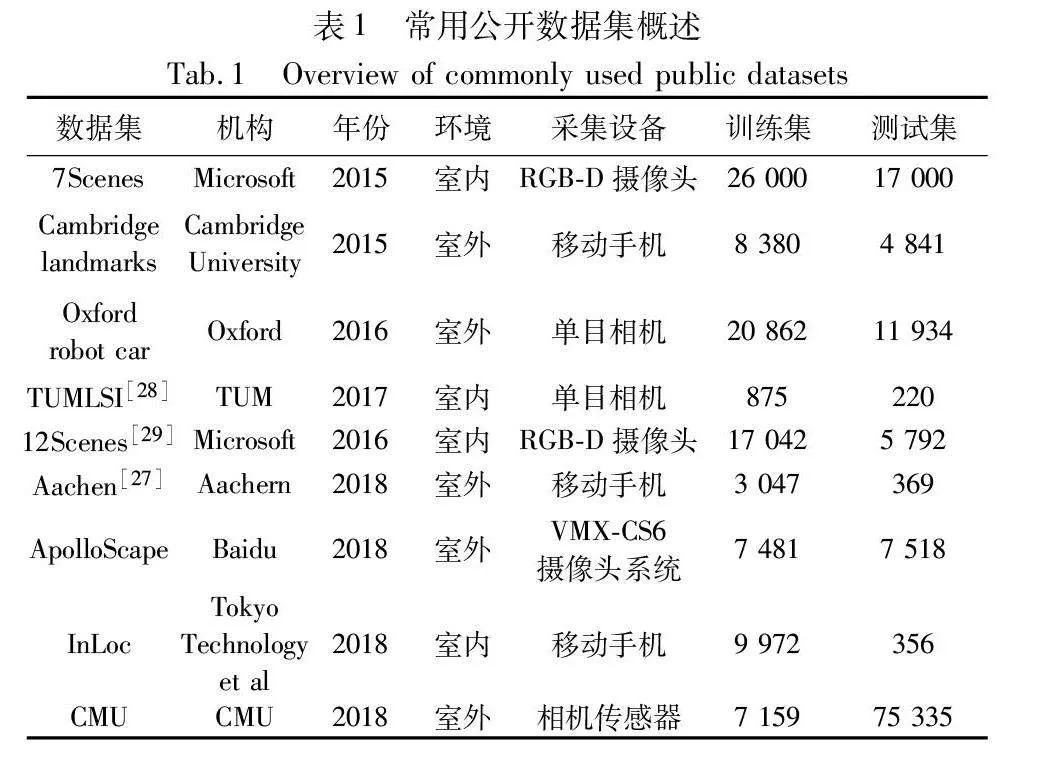

1.3 數據集介紹

數據集是研究和實踐中不可或缺的元素,在衡量和驗證模型算法、系統的性能等方面起著關鍵作用。數據集能夠更好地反映算法和模型適應的場景,從而使得算法和模型在更廣泛的情境下得以驗證和改進。

公開的數據集能夠驗證模型在當前研究現狀中所處的水平,相機位姿估計的數據集按場景分為室內數據集和室外數據集兩種。表1總結了相機位姿估計常用的數據集信息,室內代表公開數據集有7Scenes[23]等,室外代表公開數據集有Cambridge landmarks[13]和Oxford robot car[24]等。本節對使用廣泛的數據集進行了介紹,闡述了其數據集結構和內容,并指明了所介紹數據集應用的視覺任務。

7Scenes是相機位姿估計和場景重建的室內公開數據集,由劍橋大學研究人員創建,包含了chess、fire、heads、office、pumpkin、redkitchen、stairs七個不同的場景。該數據集特點為使用相機勻速拍攝成連續的序列圖像,數據集提供場景的RGB圖像、深度圖以及相機真值,圖像中包含了很多挑戰性元素,如重復性紋理、低紋理以及光照變化等情況。該數據集更加接近現實復雜的室內情況,對相機位姿估計任務有很大的挑戰性,7Scenes是目前使用最為廣泛的室內數據集。

Cambridge landmarks是室外場景的數據集,使用智能手機拍攝劍橋大學周圍五個不同場景的圖像(K.College、Old Hospital、Shop Faade、St M.Church、Great Court),每個場景包含了超百幀的圖像數據,且場景的距離跨度較大。該數據集也提供了相機真值,同時劃分好了訓練集和測試集,數據集圖像中包含了大量干擾信息,有行人、車輛、光照變化、天氣變化以及物體快速變化導致的運動模糊,對模型性能有很大的挑戰。該數據集目前是相機位姿估計領域中使用最為廣泛的室外數據集。

ApolloScape數據集[25]是由百度Apollo團隊制作的室外場景數據集,該數據集除了提供場景RGB信息外,還涵蓋了其他的場景信息。首先,該數據集包含了高質量的激光雷達數據,提供了精準的三維點云信息,更真實地還原了復雜的戶外場景;其次,該數據集還提供了豐富的像素級標注,使研究者能夠進行對語義理解和場景分析相關算法的研究。目前,該數據集依舊在不斷地更新發展,為視覺領域技術的研究提供有力的支持。

InLoc數據集[26]是Tokyo Technology等單位為大規模室內定位而設計的。數據集由一個RGB-D圖像數據庫組成,并通過移動手機拍攝的一組單獨的RGB查詢圖像進行增強,以使其更適合于室內定位。由于大的視點變化、移動的家具、遮擋、照明變換和過道等因素存在,使得待定位的查詢圖像和數據庫圖像之間存在顯著的外觀變化。同時該數據集提供了相機真值以幫助研究人員更好地使用。

CMU數據集[27]是卡內基梅隆大學使用相機傳感器制作的室外數據集。此數據集包含了季節變化和天氣變化,并且采集城市內和郊區兩處場景數據,不僅在時間上跨度較大,場景的距離跨度也很大。數據集整體提供了17個序列場景,并為每個場景建立了3D模型,同時數據集提供了查詢圖像的6DoF真值姿態,以幫助研究人員進行算法的驗證和實現。

2 兩階段模型結構方法

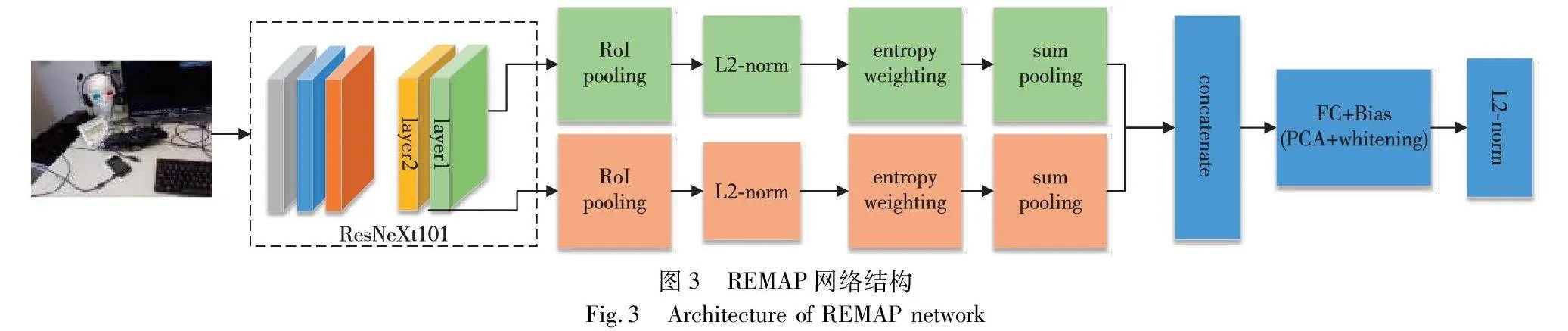

兩階段的模型匹配方法在估計相機位姿時包含場景關系搭建和相機位姿解算兩個工作階段。場景關系搭建階段的目的是建立查詢圖像與場景模型之間的匹配關系。相機位姿解算階段對搭建的場景關系進行約束解算,以恢復相機位姿,經典的做法是應用幾何約束下的PnP來計算位姿,并用RANSAC算法[30~33]來剔除離群值。

兩階段模型結構能夠清晰地了解到模型在當前時刻的作用,整體結構如圖2所示。場景關系搭建階段根據搭建方法不同,分為三種方法。特征點匹配方法主要是從查詢圖像中提取特征點,然后與三維場景進行特征匹配,因此需要重建三維點云模型以縮小特征匹配空間。采用SFM(structure from motion)技術對三維場景進行重建,重建的點云模型存儲了場景圖像中的特征向量和關鍵點,且能夠保存場景中的幾何信息。由于三維點云模型對幾何信息表達冗余,所以在解算過程中有更多的幾何約束信息去剔除離群值,提高精度。基于圖像檢索的方法是二維到二維之間進行特征映射,該方法在搭建匹配關系時需要建立圖像匹配數據庫[34],其匹配關系搭建流程為,首先對查詢圖像的特征進行編碼,獲得全局描述子,其次在圖像匹配數據庫里檢索最近鄰圖片,進行特征點匹配,得到場景關系。坐標回歸方法是直接估計三維場景的坐標,通過訓練神經網絡,可以從輸入查詢圖像直接得到三維場景的坐標,因此無須重建三維點云模型和建立圖像數據庫。

2.1 特征點匹配+解算

二維到三維的特征匹配算法對場景中的遮擋、光照變化有較好的魯棒性,且在相機與場景之間距離較遠時,依舊可以提供較高的位姿精度,但需要場景中具有足夠的3D點和2D特征點進行匹配,對數據需求較高。目前,對于特征點匹配方法的改進主要集中在特征點的提取和匹配上,提取查詢圖像中的特征點主要由關鍵點檢測器來完成,而將所有特征提取非常耗時,特征點的匹配方法是否高效會直接影響解算后位姿的精度,因此很多模型將工作的重點放在了場景關系搭建階段,目的是為了提高效率和精度,部分研究人員將模型的改進重心放在了匹配方法上。

Sattler等人[35]探索了一種正交策略,將3D點量化為一種細分詞匯表[36]來隱式執行特征匹配,通過一種簡單的投票策略來找到局部唯一2D-3D點分配,該方法只需存儲單詞標簽,因此內存占用大大降低,從而加快了特征匹配速度。加速2D-3D匹配過程中會因為量化操作導致匹配損失,尤其是泛化到大場景中,相似或重復紋理的特征點總會影響位姿的精度。為此,Liu等人[37]提出了一種新的全局排序算法,利用了查詢圖像以及3D點之間展示的全局上下文信息,這樣做不僅考慮了每個2D-3D匹配之間的視覺相似性,還兼顧了匹配對之間的全局兼容性。

除了在場景關系搭建階段改進2D-3D匹配方法外,有效地提取局部健壯特征點不僅能夠提升匹配效率,同時能夠提升精度。特征點的提取依賴于關鍵點檢測器,而手工制作的關鍵點檢測器(SIFT[38]、SUSAN[39]等)對于實時性來說并不理想,為了加快檢測器的效率。DeTone等人[40]提出了一個可以在完整大小的圖像上運行的完全卷積模型,能夠訓練出多視角幾何問題的關鍵點檢測器,在關鍵點檢測上引入了一種多尺度、多單應用(homographic adaptation)的方法,用來提升關鍵點檢測的重復性。Tian等人[41]將二階相似性(SOS)[42,43]應用到局部描述符中,提出二階相似性正則化(SOSR),并將其納入訓練中,學習描述符包含局部補丁到運動結構的多種任務信息,實驗表明,描述符匹配魯棒性得到顯著提升。Wang等人[44]提出了一個弱監督框架,無須像素級地面實況,僅從圖像之間的相對位姿學習特征點描述符,性能優于之前的完全監督描述符。

大部分特征點描述在關鍵點檢測器檢測完成后進行提取,為獲取更為健壯的關鍵點,部分研究人員將關鍵點檢測的階段向后推遲。Dusmanu等人[45]提出了一個可實現雙任務的卷積神經網絡D2Net,將關鍵點檢測推遲到特征點描述之后,所獲得的關鍵點更為穩健。Luo等人[46]基于文獻[45]提出ASLFeat,提高了局部特征的提取能力,獲得了更強的幾何不變性。具有同樣的順序思想,Tian等人[47]在2020年提出D2D的描述符模型,先描述再檢測關鍵點位置,該模型無須任何額外的訓練,通過相對或絕對的局部深度特征圖在空間和深度維度上去定義關鍵點。

2.2 圖像檢索+解算

特征點匹配方法泛化到大場景下,精度和魯棒性會受到很大的影響,且大場景下建立3D點云模型需要采集大量的圖像,尤其在大場景戶外環境下,會受到多種因素影響,例如光線變化、天氣變化、遮擋、動態物體等。目前,利用圖像檢索的場景關系搭建方法來求解大場景下相機位姿,相較于特征點匹配有很大的優勢,該方法對于室外大場景的變化有較好的應對表現。基于圖像檢索的方法無須建立3D點云模型,而是建立圖像匹配數據庫,通過對場景中每個圖像提取特征點,并將其存儲于數據庫。在位姿估計時,在數據庫中對查詢圖像進行檢索,得到最相似的圖像,建立場景關系并進行解算。在進行檢索的過程中,通過對局部特征進行編碼來得到用于圖像檢索的全局描述子。傳統局部特征的圖像編碼方法有詞包(BoW)[48]、局部聚集描述符向量(VLAD)[49]等,后續在檢索過程中應用CNN來進行聚合局部特征。

Revaud等人[50]提出一種通過列表排序損失直接優化全局mAP的方法,以改善由于追求最小化本質損失上界而導致平均準確率無法達到最優的問題;針對大量高分辨率圖像會超出GPU內存的問題,引入新的優化方案,可以處理任意圖像分辨率和網絡深度的訓練批量。Teichmann等人[51]針對檢索基準中缺乏邊界框數據集,提出了新的基于Google地表邊界框數據集,目的是利用索引圖像區域來提高檢索準確性。同時,為將檢測的區域信息組合成改進的整體圖像,引入了新的區域聚合選擇匹配核(R-ASMK),在不增加維度的前提下,顯著提升了圖像檢索的準確性。

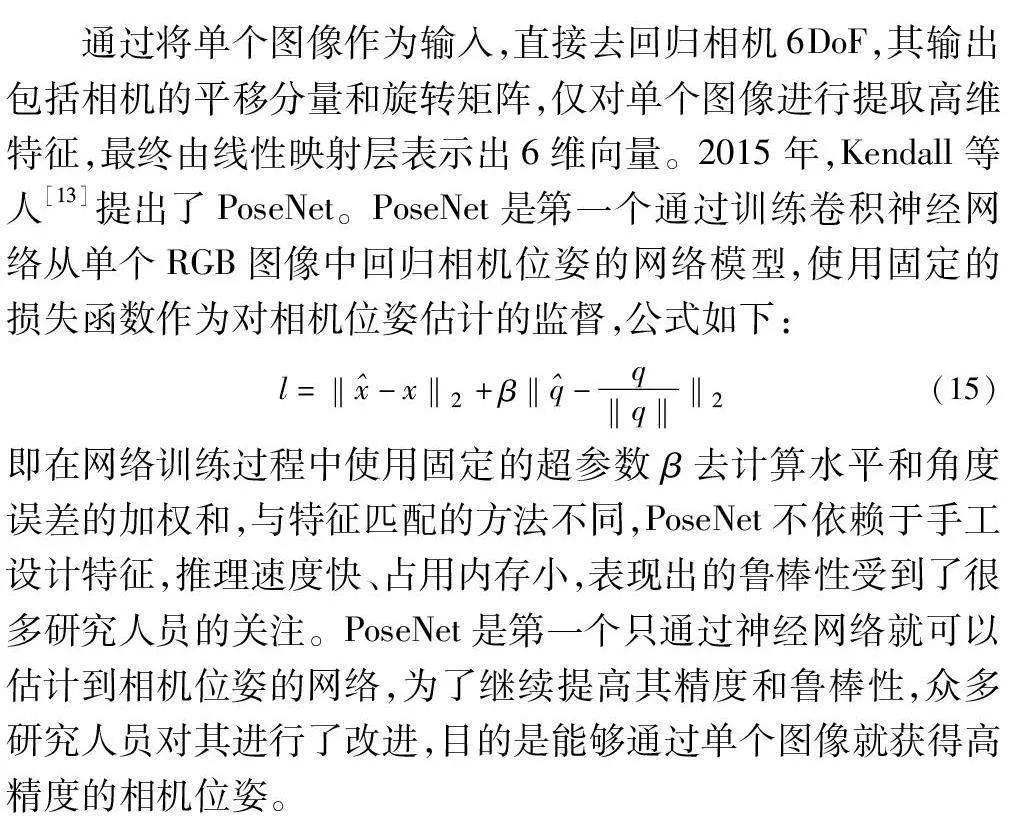

全局描述符在檢索中起到主要作用,健壯的全局描述符可以檢索出相似的最近鄰圖像,相似的最近鄰圖像是模型性能精度的保障。Husain等人[52]提出了新的基于CNN的全局描述符REMAP,其結構如圖3所示。REMAP清晰地學習到不同語義級別的視覺區分性特征,在檢索語義有用的區域和層時,通過使用Kullback-Leibler(KL)散度測量每個區域和層的信息增益,目的是能夠關注全局上下文信息,獲得更為健壯的全局特征描述符。

相較于其他方法,圖像檢索的場景關系搭建方法在模型泛化性上有一定的優越性,因為該方法對3D場景沒有很高的要求。為進一步提高模型在變化場景中的泛化性,Sarlin等人[53]于2019年提出了HF-Net,在模型結構上進行了創新性的變化,使用由粗到細的分層結構,同時對局部特征和全局描述符進行預測,這種分層的結構方法節省了大量運行時間,因此,提高實時性的同時又保證了泛化性。2020年,Zhou等人[54]提出新的圖像檢索框架,首先檢索出與查詢圖像相同的場景圖像集合,計算其與查詢圖像的本質矩陣,利用檢索圖像的基本矩陣得到查詢圖像位姿,該框架不依賴場景三維模型,在新場景中有很好的泛化性。

2.3 坐標回歸+解算

基于特征點匹配或者基于圖像檢索等方式搭建場景關系,依賴于圖像中的特征點,特征點的健壯性會直接影響估計位姿的精度。坐標回歸的方法不再依賴于圖像中的特征點,直接通過查詢圖像對3D場景的坐標進行回歸,無須建立3D點云模型或龐大的圖像檢索庫,在無須特征點檢測和匹配的情況下就可以獲得二維到三維之間的對應關系,通過PnP和RANSAC算法進行相機位姿的解算,使其對場景中的不利因素和變化有很好的魯棒性。

2017年,Brachmann等人[55]提出了DSAC,將場景關系搭建和相機位姿解算過程結合起來,通過訓練神經網絡,預測查詢圖像像素和3D場景坐標點之間的對應關系,接著進行RANSAC,得到模型假設集合,通過評分函數對模型假設集合打分,得到最優模型,最終實現可微分的RANSAC。為提高DSAC訓練時間和泛化能力,Brachmann等人[56]在文獻[55]的基礎上提出了DSAC++,先前預測場景坐標會學習整個位姿估計的流程,而DSAC++證實學習單個組件就可以密集回歸場景坐標,大大減少了訓練時間,使用了新的熵控制軟內點計數的假設評分方法,大大提升了泛化能力,且DSAC++能夠自動發現場景幾何。

將多視角幾何約束添加進場景坐標網絡中是一種新的提升模型各種能力的手段。2020年,Cai等人[57]將時間序列圖像的多視角幾何約束用于對場景的坐標預測,不同視角下場景點的變形誤差信息能夠提高網絡回歸到正確的場景坐標的能力,實驗表明,多視角的網絡更容易收斂。Li等人[58]通過將回歸場景坐標的網絡進行分層,由一系列的輸出層組成,每個輸出層都受前一輸出層的約束,最后一個輸出層輸出預測的3D坐標,這種由粗到精的方式令該分層網絡實現了更精準的3D場景坐標預測。同年,Zhou等人[59]提出KFNet,將場景坐標回歸的問題拓展到時域上,通過將卡爾曼濾波結合進回歸網絡中,解決了時間序列圖像上像素級的狀態推斷,該方法在時域位姿估計中有較高的精度。

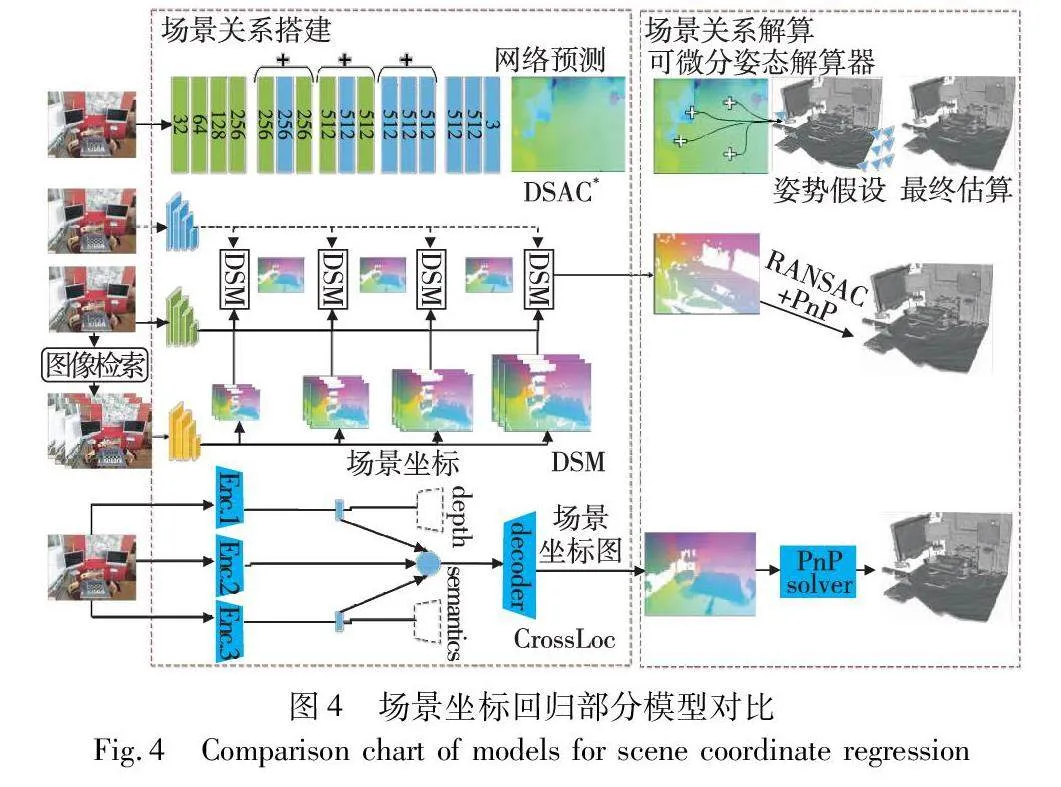

擴展到時域可以提升估計位姿的精度,但如何處理大場景依舊是個難題。2021年,Tang等人[60]提出了新的預測場景坐標方法,場景不可知的相機定位使用密集的場景匹配塊(DSM),結構如圖4所示。DSM模塊接受查詢圖像的特征圖以及部分特征圖對應的場景坐標,再利用DSM模塊接受的信息以一種由粗到細的方式預測場景坐標。DSM在查詢圖像和場景之間構建成本體素,匹配每個查詢圖像像素的場景通過成本量,使得網絡在有限的容量內處理大規模場景,該方法同樣可以擴展到時域上。

如何通過最少的信息挖掘場景中的幾何信息,以幫助估計位姿的精度,并且減少訓練時間,為實時性的應用作出鋪墊。2022年,Brachmann等人[61]提出DSAC*,結構如圖4所示,總結了文獻[55,56]并進行了擴展。在訓練DSAC*網絡時,可以是RGB或RGB-D,也可以將3D模型加入訓練,以減少信息的利用,改進網絡結構減小內存占用,簡化訓練過程,提高訓練效率,改進后的網絡可在訓練時自動發現場景中的三維幾何信息,有助于提高估計位姿精度。場景中的其他信息可以提升估計位姿的精度,因此添加場景其他信息以提高大場景環境下的定位精度,也是一種方法。2022年,Yan等人[62]提出了CrossLoc,該網絡結構如圖4所示。其是一種自我監督進行多模態位姿估計的學習方法,通過使用幾何信息和場景結構信息(如語義)來進行場景坐標的預測,為得到大尺寸數據集的多模態合成數據集,提出TOPO-DataGen方法。實驗表明,在空中場景環境定位時,該方法使用多模態合成數據集進行輔助達到了最先進的基線。為提高模型魯棒性和精度,王靜等人[63]通過引入深度過參化卷積來取代網絡骨架中傳統的卷積層,并在網絡學習過程中增加細粒度信息,以解決空間信息丟失問題,提高信息利用率。當前使用場景坐標方法來搭建場景關系已經取得了很好的精度,但是模型在回歸3D場景坐標時計算密集,較為耗時,很難推廣到實時推理的環境中。2022年,Bui等人[64]提出了一種簡單的場景坐標回歸算法,使用多層感知網絡映射場景坐標,為減小模型尺寸,場景坐標由稀疏描述符得到,而非RGB圖像像素數據。

3 單通道模型結構方法

不同于兩階段的場景關系搭建和相機位姿解算的位姿估計流程,單通道模型結構方法將兩個工作融合進一個神經網絡中,通過場景數據集去訓練優化一個神經網絡,最終直接輸出估計的相機位姿。整個過程并不存儲場景中任何幾何關系,也無須搭建3D點云模型或圖像數據匹配庫。神經網絡能夠提取數據集圖像中的特征,并將其向高維空間映射,最后通過線性映射層(如全連接FC層)得到位姿估計。整個過程通過數據集給出的相機位姿真值構造損失函數對訓練過程進行監督,使網絡實現對場景信息的學習。

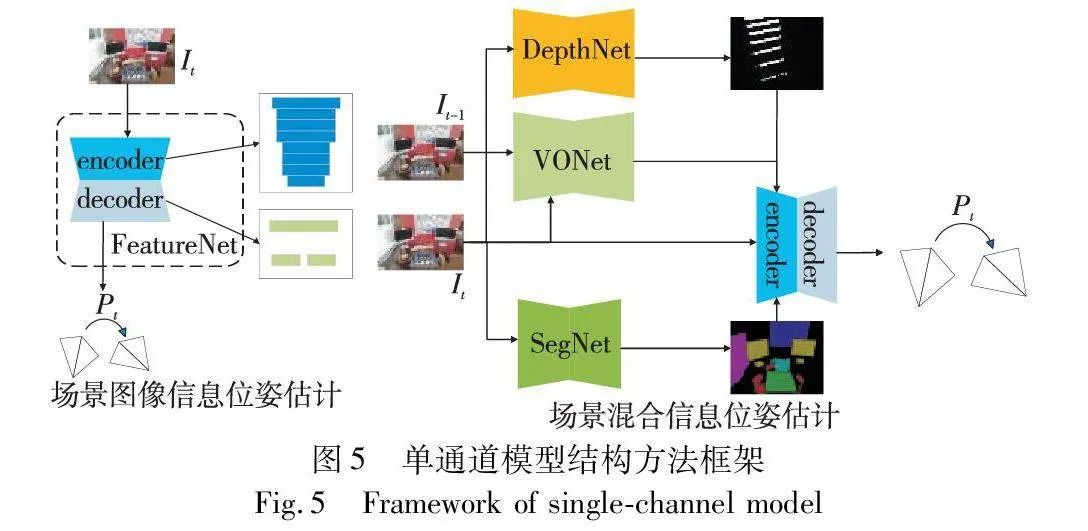

單通道模型結構方法是由一個整體神經網絡去估計位姿的,該神經網絡分為學習特征的編碼器和對位姿回歸的解碼器,整體結構如圖5所示。編碼器的輸出是一個經過學習的表示,其中包含了輸入圖像里的重要信息,解碼器對信息進行特定的映射操作,逐步生成最終的位姿輸出。在訓練神經網絡時,對學習過程中場景信息的使用上,有單一場景圖像信息和混合場景信息的使用,因此將其分為場景圖像信息位姿估計和場景混合信息位姿估計。

在場景圖像信息位姿估計中,神經網絡使用場景的RGB圖像進行網絡訓練,編碼器從輸入圖像中學習特征,解碼器回歸相機位姿。從當前的研究現狀可知,在神經網絡的編碼器中添加技術模塊和網絡單元,可使神經網絡在學習圖像特征時能夠聚焦到局部特征和重要特征,并且能夠降低網絡計算復雜度,進而提高網絡的效率和性能。編碼器學習到特征會將其輸入進解碼器中,解碼器會將學習到的特征進行映射轉換為最終的輸出,解碼器的具體設計取決于視覺任務的性質,一般估計的相機位姿會以6DoF表示,使用全連接FC層進行特征映射。

在場景混合信息位姿估計中,神經網絡的訓練不再局限于場景的RGB圖像,場景中的其他信息會和RGB圖像共同訓練網絡,例如場景運動信息、場景結構信息等。在神經網絡的編碼器中,不僅要考慮高效提取圖像特征,更多地是如何應對多種信息特征的融合或是信息之間的互補。場景混合信息位姿估計在神經網絡的編碼器中同樣會有技術模塊的應用,在獲取場景中的其他信息時,會有相關算法應用于神經網絡中。解碼器的設計和場景圖像信息位姿估計一致,通過FC層進行線性映射。

3.1 場景圖像信息位姿估計

通過將單個圖像作為輸入,直接去回歸相機6DoF,其輸出包括相機的平移分量和旋轉矩陣,僅對單個圖像進行提取高維特征,最終由線性映射層表示出6維向量。2015年,Kendall等人[13]提出了PoseNet。PoseNet是第一個通過訓練卷積神經網絡從單個RGB圖像中回歸相機位姿的網絡模型,使用固定的損失函數作為對相機位姿估計的監督,公式如下:

l=‖-x‖2+β‖-q‖q‖‖2(15)

即在網絡訓練過程中使用固定的超參數β去計算水平和角度誤差的加權和,與特征匹配的方法不同,PoseNet不依賴于手工設計特征,推理速度快、占用內存小,表現出的魯棒性受到了很多研究人員的關注。PoseNet是第一個只通過神經網絡就可以估計到相機位姿的網絡,為了繼續提高其精度和魯棒性,眾多研究人員對其進行了改進,目的是能夠通過單個圖像就獲得高精度的相機位姿。

為應對多個數據集中更換訓練場景需重新訓練的問題。Naseer等人[65]根據PoseNet提出了一個分類網絡的新網絡SVSPoseNet。SVSPoseNet更換了網絡骨架,將GoogLeNet替換為VGG16[66],額外的兩個FC層進行6DoF水平和角度預測,在數據集的多個場景中使用相同參數,不再根據不同的訓練集進行超參數優化,減少了網絡訓練時間,該算法在室外大場景環境下取得了較好的位姿精度。為增強網絡的魯棒性,以應對在不同光照條件或運動模糊等不斷變換場景中精度下降的問題,2017年Melekhov等人[67]提出了一種具有沙漏形狀的網絡Hourglass PoseNet,該網絡整體由編碼器、解碼器和回歸器組成,通過向解碼器引入上卷積層以恢復查詢圖像的細粒度信息,并補充深度卷積網絡,其中編碼器和解碼器使用了修改后的ResNet34[68],相較于PoseNet,增強擴展了原始架構。

在網絡訓練中,固定的損失函數需要進行手動調節超參數,這樣做會導致大量的人工成本,網絡模型性能對于超參數β很敏感,且在場景變化過程中,最佳性能的超參數β極難尋找。針對該問題,2017年Kendall等人[69]提出了可學習的損失函數。可學習損失函數的超參數可以跟隨網絡模型的訓練過程不斷進行變化,自動學習最佳權重,新的損失函數使用同方差不確定性[70]來進行表示,能夠專注于任務本身的不確定性,以概率的方式來聯合收割不同任務的損失。該可學習損失函數可添加進多種模塊或功能進行約束,以得到幾何約束。2019年,Bui等人[71]提出了新的網絡框架,加入判別器網絡和對抗學習,這樣可以在估計位姿時將姿勢進行細化,網絡在可學習損失函數加持下性能得到很大提升。目前利用CNN方法已經表現出針對場景變化的可靠性了,但場景中動態環境依舊是導致模型性能不高和不穩定的因素。2019年,Huang等人[72]提出新的框架去解決動態問題,引入了預先引導的dropout模塊和一個自注意模塊。dropout模塊回歸時可輸出多個假設,對動態環境中動態對象的不確定性進行量化,從而提高魯棒性,自注意模塊能夠讓網絡忽略前景對象的干擾,專注于背景中的關鍵地標,以提升網絡估計精度。在利用單圖像進行估計位姿時,會有較多離群值,通過添加幾何約束能夠改善此問題,研究人員通過實驗發現,注意力機制對于提高估計精度、減小離群值也有很大的作用。2020年,Wang等人[73]提出一種自注意力引導的神經網絡AtLoc,能夠在訓練過程中專注于幾何上更為健壯有用的特征。AtLoc使用可學習的損失函數,在網絡骨架上使用ResNet34作為編碼器網絡,使得模型在輸入僅為單圖像時,也能夠學習到更為魯棒的對象特征。

當前網絡模型的性能體現主要由數據集進行評估,數據集中不同場景分開進行訓練和評估,不同場景之間做遷移會導致精度嚴重下降,這對模型的泛化是一個很大的挑戰。Chidlovskii等人[74]提出了APANet,通過添加對抗學習來表示模型的遷移,同時修改分類領域的自適應技術,并將其加進位姿估計網絡中,驗證場景不變的圖像表示。為進一步提升模型的泛化能力,2021年,Sarlin等人[75]提出PixLoc,通過輸入查詢圖像和場景3維模型,即可輸出得到圖像對應相機位姿。PixLoc將相機位姿問題轉換為度量學習,端到端地學習了像素到位姿的數據先驗,算法著重于表征學習,讓網絡很好地理解幾何原則并魯棒地應對場景變化,固定LM優化算法的參數可以使數據和優化器解耦,達到與場景結構無關適用于任何場景的效果,從而提升泛化能力。2022年,Chen等人[76]提出DFNet,引入一種比之前光度匹配更具健壯性的直接匹配方法,并與絕對姿態回歸結合,彌補真實圖像和合成圖像之間的特征級領域差距,在曝光自適應的新視圖合成(NVS)的支持下,成功解決了室外環境中現有光度基準方法無法處理的光度畸變問題。該文還介紹了一種數據生成策略,通過對訓練數據軌跡進行擴充,使其對未知數據有了更好的泛化性。場景圖像信息位姿估計模型對比如圖6所示。

3.2 場景混合信息位姿估計

以往的方法在估計位姿時,網絡模型僅根據場景圖像進行訓練和估計位姿,主要依賴輸入的圖像信息,但場景中所包含的信息并不單只有圖像中的特征,還有幾何信息(如視覺里程計[77~79])和結構信息(如語義信息[80,81])等,僅使用圖像特征并不能充分利用場景中的信息。因此,很多研究人員在估計位姿網絡中添加了場景其他信息,目的是通過輔助任務約束[82~84]以減小位姿誤差,提高精度和魯棒性。

2018年,Valada等人[85]提出了VLocNet,在位姿估計網絡中添加了幾何信息-視覺里程計作為輔助信息,以兩張序列圖像作為輸入,通過暹羅網絡對視覺里程計進行回歸,使用可學習的損失函數進行約束,并和全局損失函數進行整合,以達到對整體網絡進行約束,實驗表明,位姿精度有了很大的提升。同年,該作者團隊在文獻[85]的基礎上提出VLocNet++[86],在估計相機位姿網絡中添加了場景結構信息,即場景的語義信息,提出自監督扭曲技術以學習一致的語義信息,對于各個任務之間的依賴性提出了自適應融合層,以進行彼此之間的調節,新的可學習損失函數將估計位姿、視覺里程計、語義結合在一起進行網絡約束。實驗結果表明,VlocNet++在感知變化、重復結構和無紋理變化的場景中,表現出了很好的性能和魯棒性。在估計位姿的網絡中添加視覺里程計信息是提升精度的重要手段,且視覺里程計信息是場景中重要的幾何信息,但目前視覺里程計信息在預測時仍存在軌跡漂移現象。2019年,Lin等人[87]提出了DGRNet,該網絡可實現對視覺里程計進行精準預測,并能夠和位姿估計網絡進行融合。該方法在估計視覺里程計網絡和相機位姿網絡中均使用了LSTM單元,能夠挖掘長距離圖像之間的關系,并存儲過去幾幀預測的相機位姿數據,以減少視覺里程計軌跡漂移和提高位姿的估計精度,并使用CTC loss+MSE對整個網絡模型進行訓練。

2020年,Tian等人[88]在估計相機位姿時引入了三維場景幾何感知約束,進一步融合了3D場景幾何信息,通過利用深度圖將約束公式化為光度差和SSIM。相比之下,3D場景幾何約束是像素級的,可以在估計位姿時利用更多的信息,包括相機運動、三維結構和光度信息,在預測精度和收斂性能上都有明顯的提高。2021年,Chen等人[89]提出了語義信息增強的全局檢索方法,使用語義修復網絡(SI-GAN)將場景中動態語義圖像轉換為完整的靜態對象,并使用SME將修復后的靜態語義圖像分割嵌入,生成語義檢索的歸一化向量。SI-GAN能夠減輕場景元素前后遮擋所造成的邊緣信息弱化問題。最后將語義檢索和RGB圖像相結合,該方法在場景復雜、光照變化強的環境中有很好的性能表現。

3.3 深度學習模型對比分析

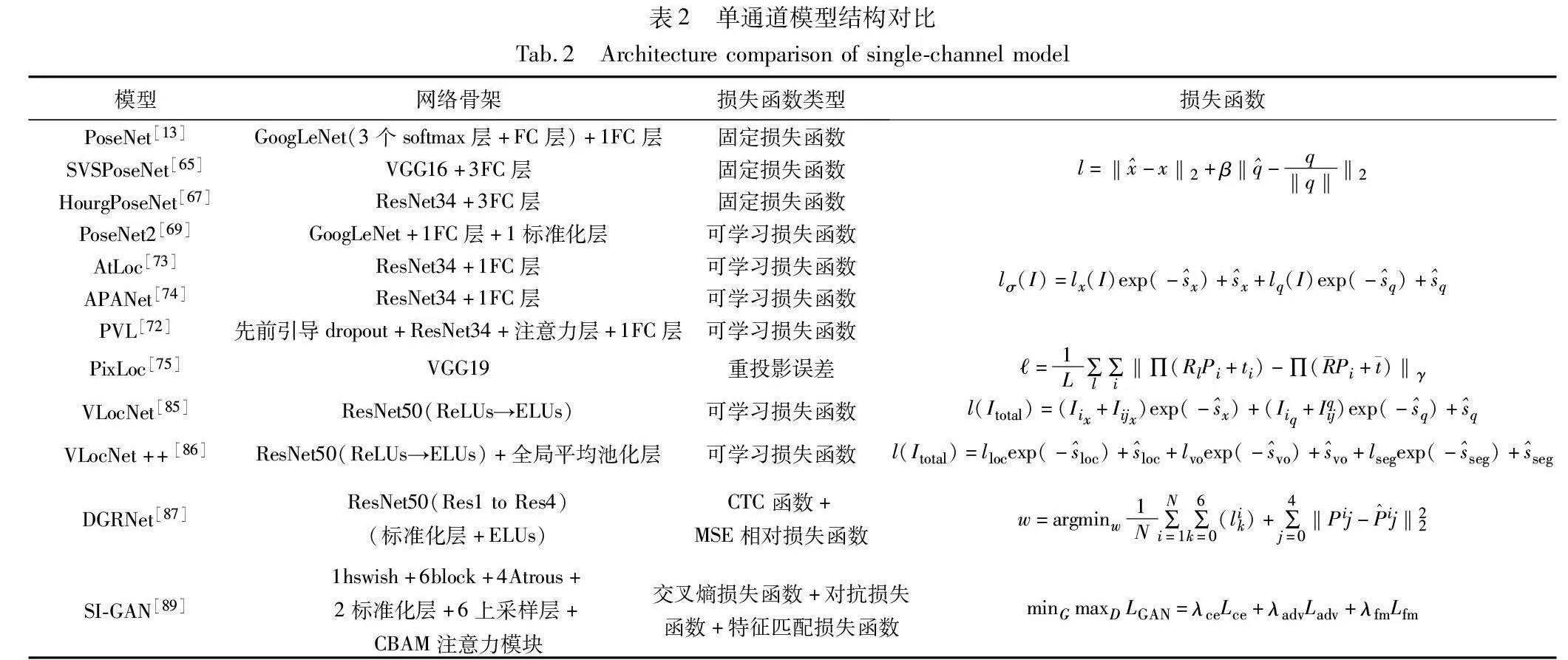

本節匯總了場景圖像信息位姿估計和場景混合信息位姿估計中的部分模型,對比了模型的網絡骨架(編碼器+解碼器)、損失函數類型、損失函數等,如表2所示。

對于神經網絡模型,網絡骨架的選擇對特征的提取能力影響很大,深層網絡相較于淺層網絡表現更為出色。同時損失函數對于模型訓練的約束是相當重要的,設計合理的損失函數也是提高精度的重要手段。很多研究人員根據模型應用的場景特性和表現出的缺點,為模型添加技術模塊和網絡單元,不僅能夠解決網絡相關問題,還能提升整體模型的魯棒性或泛化能力。

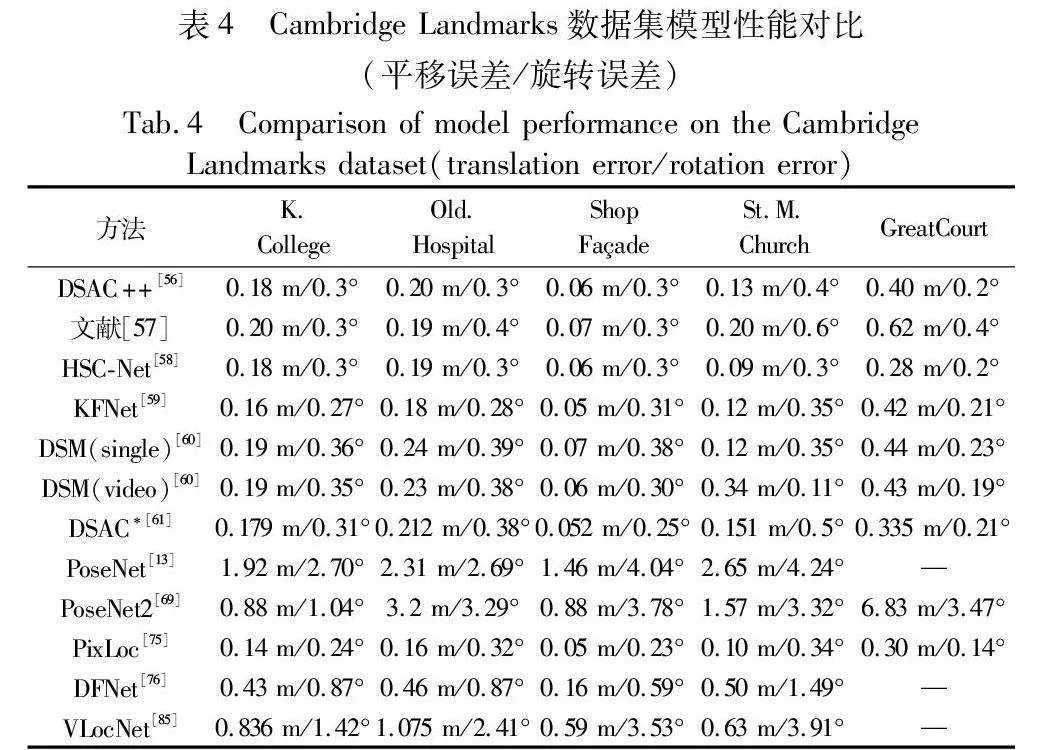

4 性能對比分析

前兩章總結性描述了近幾年的代表性方法,對兩階段模型結構方法和單通道模型結構方法進行分析。依賴2D點和3D模型匹配的方法在相機位姿估計中已經應用得很成熟了。為應對復雜場景和重復紋理的環境,深度學習成為了當前解決該問題的熱點方法。為了能夠比較上述方法,總結了它們在公開數據集7Scenes和Cambridge Landmarks上的性能表現數據,其中數據表示為相機位置的水平誤差(m)和相機姿態的角度誤差(°),如表3和4所示。

4.1 模型解算方法對比

兩階段模型結構方法通過對特征點的匹配關系或3D場景中像素坐標進行解算,以確定相機在世界坐標系中的位置和方向。兩階段方法在位姿解算的方法使用上層出不窮,目前使用頻率較多的方法有2D匹配對極幾何中的矩陣方法(本質矩陣和單應矩陣)以及3D-2D匹配求解的PnP等,這些解算方法在求解位姿時搭配相關算法以提升精度,例如BA調整、RANSAC等方法。對極幾何的矩陣方法中,本質矩陣對于強幾何約束和視角小的相機位姿估計有很強的適用性,這兩種情況一般會發生于靜態場景中,靜態場景能夠通過三角化獲取到精確的三維結構,因此該方法對于穩定精確的幾何關系有較為出色的可解釋性,但在動態場景或場景運動信息豐富的情況下,該解算方法并不適用,且該方法對場景中的噪聲和物體遮擋相當敏感。單應矩陣解算相機位姿需要大量匹配的特征點,這對于模型效率和實時性來說并不友好,但單應矩陣在解算平面場景的相機位姿時表現出色,同樣該方法易受噪聲和異常值的影響,目前使用一些魯棒方法去改善此情況,例如使用RANSAC剔除匹配中的離群值和異常值來提高解算相機位姿精度。

利用坐標回歸算法去估計相機位姿,通常使用PnP方法去解算位姿。PnP在已知一張3D特征點的情況下,只需3個點就可以解算相機位姿。因此,PnP方法簡單且直接,特別適用于少量特征點的情況,并對噪聲和遮擋相對魯棒。PnP求解還有直接線性變換DTL方法,通過已知的空間坐標和歸一化坐標直接求解相機的位姿。目前,還可以把PnP構建成一個重投影誤差的非線性最小二乘問題,利用BA調整,將相機位姿和3D點位置看作優化變量進行優化,這樣能夠對全局進行優化,綜合考慮到多個視角和特征點,非線性的方法使PnP可以處理大規模場景和大量特征點。

單通道模型結構方法在解算相機位姿時,并不使用具體的解算算法,主要利用神經網絡中的解碼器進行估計。解算相機位姿的解碼器結構較為簡單,通常利用全連接FC層進行位姿映射,FC層中的神經元與前一層的所有神經元相連接,將上一層網絡的特征數據作為其輸入,以進行整合分類,最終直接輸出相機位姿。利用FC層解算出的相機位姿精度主要受神經網絡學習能力的影響,因此,如何提高神經網絡學習到更為魯棒的場景特征,才是提升相機位姿精度的主要途徑。

兩階段模型結構方法在解算上依賴于場景匹配的特征點,對于紋理豐富、有明顯特征的場景效果較好,單通道方法通過大規模數據學習更復雜的圖像表示,在解算一些缺乏明顯特征的場景也具有較強的適應性。目前,兩種模型結構中所使用的解算方法在多種場景中仍具有很大的應用需求。

4.2 模型性能分析對比

從表3、4可以得出,坐標回歸加解算的DSAC*精度是最好的。通過分類方法之間的對比,場景關系搭建階段使用的3D坐標回歸的方法,在精度上優于其他方法,并且在進行估計相機位姿時,使用場景中其他信息,會進一步提升精度。DSAC++和DSAC*在估計位姿過程中會自動發現場景中的幾何信息,并利用該幾何信息提升位姿精度。使用場景中的其他信息是提升精度的常用做法,同時也是一種發展趨勢。單通道模型結構方法中,在網絡訓練過程中融合場景其他信息,精度都有較大的提升。VLocNet和DGRNet在網絡中融合視覺里程計信息,讓場景里元素前后變化在網絡中能夠更好地表達。VLocNet++在融合視覺里程計的基礎上加入了豐富的語義信息,在元素前后變化的軌跡上注意到輪廓邊緣結構,以提升場景在模型中的信息利用率,其估計位姿的精度與DSAC*性能相當。KFNet和DSM通過將回歸3D場景坐標的問題引入到時域里,估計的位姿在角度誤差上降低了很多,角度誤差達到SOAT。

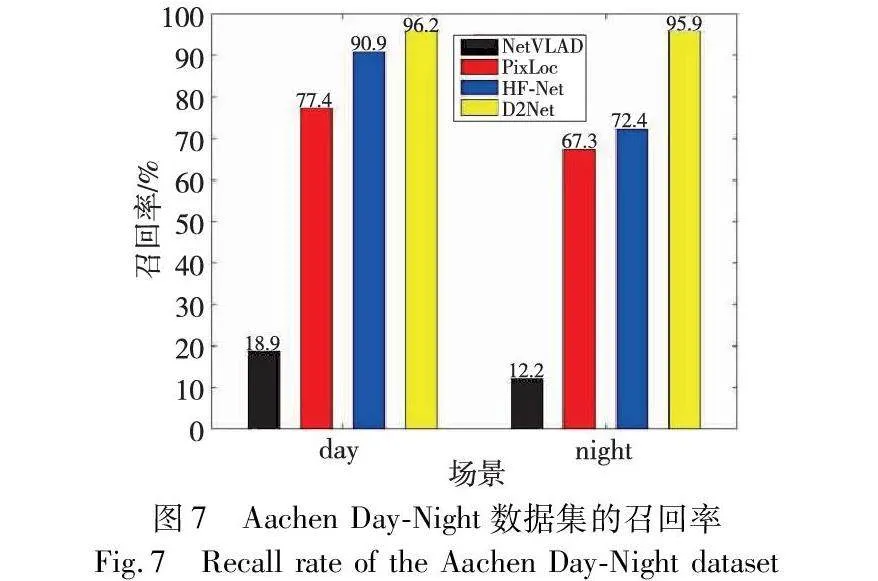

場景坐標回歸方法在室內有很好的表現,但在大場景戶外環境中表現不佳,盡管CrossLoc在泛化性上有了很大的改進,但大量的計算令其犧牲了實時性。模型良好的泛化性能夠應對未知和不斷變化的場景。在場景關系搭建階段,基于圖像檢索的方法展現了較為突出的泛化能力,由于不建立3D場景模型,圖像檢索的方法能較好地實現遷移學習,被查詢的圖像數據庫是龐大的,其預訓練的模型可以在特定任務的小規模數據上進行微調,以應對新的場景。表現較好的方法如HF-Net,在召回率上有很好的表現(見圖7),該方法同時對局部特征和全局描述符進行預測,實現了高精度定位,由粗到細的分層結構節省了運行時間,在大場景上有良好的實時性表現。其中由粗到細的分層結構方法通過逐漸減小搜索空間,讓場景在模型中表達出更為精細的信息,不僅結合了全局和局部信息,還防止大規模場景在變化過程中信息混淆和丟失的問題。使用該分層結構的方法還有CamNet、HSC-Net等模型,在7Scenes和Cambridge Landmarks數據集上表現良好。分層結構的優點不僅滿足較好的位姿精度,而且很容易推廣到大規模戶外場景中。

單通道模型的性能表現能力受網絡骨架和損失函數影響較大,網絡骨架的選擇和設計會直接影響整體模型的特征提取能力、表示能力以及運算效率。當前較多模型會選擇ResNet系列作為模型的網絡骨架,像Hourglass PoseNet、AtLoc、APANet等模型在編碼器結構上使用了ResNet系列,在加深網絡層數以提高特征提取能力的同時,ResNet能夠緩解梯度消失問題和提高網絡收斂速度。損失函數直接反映出模型估計位姿與相機真值之間的差異,是模型優化的目標函數。傳統的損失函數需要微調超參數β,費時費力。PoseNet2提出了一種新的令超參數擁有學習能力的損失函數,不再進行手動調節,PoseNet2在新的損失函數里加入幾何約束,其表現出的性能相較于PoseNet有一定的提升。VLocNet和VLocNet++同樣使用該可學習損失函數,在損失函數里加入了場景幾何約束和結構約束進行監督,模型均表現出較好的結果。

5 結束語

1)挑戰

通過對現有方法的研究和分析,相機進行位姿估計時,已不再局限于場景的RGB圖像數據,融合場景的其他信息成為了主流,目的都是在提高場景信息利用率的同時提高精度。在滿足魯棒性的前提下,泛化性也是一個重要的模型性能,因此近幾年很多研究人員在泛化性上努力著。當前相機位姿估計仍存在很多挑戰:

a)視覺特征匹配。準確的相機位姿估計需要進行準確的特征匹配,但在復雜場景、低紋理區域或遮擋情況下,特征匹配可能變得困難。

b)魯棒性。相機位姿估計需要在不同的環境條件下保持魯棒性,包括光照變化、動態物體和噪聲等因素的干擾。

c)尺度歧義。單個圖像無法提供絕對尺度信息,因此需要結合其他傳感器或利用先驗知識來解決尺度歧義問題。

d)實時性。許多應用場景需要實時的相機位姿估計,因此需要在保持準確性的同時,保持較低的計算時間。

2)展望

a)深度學習方法。深度學習模型在計算機視覺領域取得了巨大成功,將深度學習引入相機位姿估計任務可以進一步提高性能和魯棒性。未來深度學習模型能夠更好地處理復雜、動態的場景,包括城市環境、人群密集區域等。這將為實際應用提供更多的可能性,尤其是在復雜環境中需要準確估計相機位姿的場景下。

b)多傳感器融合。結合多個傳感器(如慣性測量單元、GPS、激光雷達、視覺等)的數據,不同傳感器對環境的感知方式各異,綜合利用這些信息可以獲得更全面的環境感知,僅單目相機傳感器的RGB圖像數據并不能包含場景太多的信息,多傳感器獲取場景數據進行融合能夠降低某一傳感器對系統性能的影響,提高系統的魯棒性。同時,通過融合多源信息,可以更好地抑制傳感器噪聲和誤差,提高位姿估計的穩定性,并解決尺度歧義問題。目前多傳感器數據融合需要克服數據異構特性的挑戰,因此該領域的主要工作集中在融合方法上,在前融合階段和后融合階段有很多研究。前融合階段對于多種傳感器數據融合方法眾多,對于不同信息處理方法各異,例如語義信息和點云數據的拼接操作,或是RGB圖像和激光點云進行特征圖分層融合,同樣也有設置參數權重對特征值按比例融合,控制不同傳感器數據的貢獻率。后融合有匈牙利匹配和卡爾曼濾波等方法,此處融合在獲得傳感器的輸出后,就可以在觀測層面進行融合,例如使用卡爾曼濾波對相機和雷達獲取數據進行融合。當前使用多種傳感器信息去提高相機位姿估計精度是重要的一種技術途徑。

c)語義信息融合。語義信息是通過RGB圖像獲取的,包含了場景中物體元素的邊緣信息,同時也蘊涵了物體元素之間的相對關系、布局結構,能夠為模型估計相機位姿提供更多的幾何約束,因此語義信息的引入為相機位姿估計的準確性、魯棒性和應用范圍提供了更多可能性。然而,這也帶來了挑戰,包括如何有效融合語義信息、處理復雜場景、解決不平衡類別和實時性等方面的問題。未來的研究將集中在解決這些挑戰,并進一步推動相機位姿估計技術的發展。

d)自適應方法。開發自適應的相機位姿估計方法,可以根據場景和任務的特點,自動調整算法參數和策略,能夠提高模型魯棒性、實現多模態融合、優化實時性和效率,引入在線學習和遷移學習,以及環境感知和交互性,增強模型的性能和泛化能力。

e)增強現實和虛擬現實。相機位姿估計在增強現實和虛擬現實應用中具有重要作用,例如導航、教育、醫療、文化、手勢識別以及場景還原等。未來將聚焦于提高位姿估計的精度和實時性,以提供更逼真和流暢的增強現實和虛擬現實體驗。

參考文獻:

[1]Durrantwhyte H, Bailey T. Simultaneous localization and mapping[J]. IEEE Robotics & Automation Magazine, 2006,13(2): 99-110.

[2]Middelberg S, Sattler T, Untzelmann O, et al. Scalable 6-DoF loca-lization on mobile devices[C]//Proc of European Conference on Computer Vision. Cham:Springer,2014:268-283.

[3]Ventura J, Arth C, Reitmayr G, et al. Global localization from monocular slam on a mobile phone[J]. IEEE Trans on Visualization and Computer Graphics, 2014, 20(4): 531-539.

[4]Kim K, Kim C, Jang C, et al. Deep learning-based dynamic object classification using LiDAR point cloud augmented by layer-based accumulation for intelligent vehicles[J]. Expert Systems with Applications, 2021,167: 113861.

[5]Zermas D, Izzat I, Papanikolopoulos N. Fast segmentation of 3D point clouds: a paradigm on LiDAR data for autonomous vehicle app-lications[C]//Proc of IEEE International Conference on Robotics and Automation. Piscataway, NJ: IEEE Press, 2017: 5067-5073.

[6]Yu Tan, Meng Jingjing, Yuan Junson. Multiview harmonized bilinear network for 3D object recognition[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2018:186-194.

[7]Siddharth C, Narayanan P. Visibility probability structure from SfM datasets and applications[C]//Proc of European Conference on Computer Vision. Berlin:Springer, 2012: 130-143.

[8]Irschara A, Zach C, Frahm J M, et al. From structure-from-motion point clouds to fast location recognition[C]//Proc of IEEE Computer Society Conference.Piscataway, NJ: IEEE Press,2009:2599-2606.

[9]Gao Xiaoshan, Hou Xiaorong, Tang Jingliang, et al. Complete solution classification for the perspective-three-point problem[J]. IEEE Trans on Pattern Analysis & Machine Intelligence, 2003, 25(8): 930-943.

[10]Radenovic F, Tolias G, Chum O. CNN image retrieval learns from BoW: unsupervised fine-tuning with hard examples[C]//Proc of European Conference on Computer Vision.Cham:Springer,2016:3-20.

[11]Qiang Hao, Rui Cai, Zhi Weili, et al. 3D visual phrases for landmark recognition[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press, 2012: 214-223.

[12]王靜, 金玉楚, 郭蘋, 等. 基于深度學習的相機位姿估計方法綜述[J]. 計算機工程與應用, 2023, 59(7): 1-14. (Wang Jing, Jin Yuchu, Guo Ping, et al. Survey of camera pose estimation methods based on deep learning[J]. Computer Engineering and Applications, 2023, 59(7): 1-14.)

[13]Kendall A, Grimes M, Cipolla R. PoseNet: a convolutional network for real-time 6-DoF camera relocalization[C]//Proc of IEEE International Conference on Computer Vision.Piscataway,NJ:IEEE Press, 2015: 2938-2946.

[14]陳宗海, 裴浩淵, 王紀凱, 等. 基于單目相機的視覺重定位方法綜述[J]. 機器人, 2021, 43(3): 373-384. (Chen Zonghai, Pei Haoyuan, Wang Jikai, et al. Survey of monocular camera based visual relocalization[J]. Robot, 2021, 43(3): 373-384.)

[15]Shavit Y, Ferens R. Introduction to camera pose estimation with deep learning[EB/OL]. (2019-07-08). https://arxiv.org/abs/1907.05272.

[16]Wu Zhirong, Song Shuran, Khosla A, et al. 3D ShapeNets: a deep representation for volumetric shapes[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2015: 1912-1920.

[17]Kalogerakis E, Averkiou M, Maji S, et al. 3D shape segmentation with projective convolutional networks[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2017: 3779-3788.

[18]Riegler G, Osman U A, Geiger A. OctNet: learning deep 3D representations at high resolutions[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2017: 3577-3586.

[19]Klokov R, Lempitsky V. Escape from cells: deep Kd-networks for the recognition of 3D point cloud models[C]//Proc of IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE Press, 2017: 863-872.

[20]Su Hang, Maji S, Kalogerakis E, et al. Multiview convolutional neural networks for 3D shape recognition[C]//Proc of IEEE Internatio-nal Conference on Computer Vision. Piscataway, NJ: IEEE Press, 2015: 945-953.

[21]Ma Chao, Guo Yulan, Yang Jungang, et al. Learning multiview representation with LSTM for 3D shape recognition and retrieval[J]. IEEE Trans on Multimedia, 2018, 21(5): 1169-1182.

[22]Hartley R, Zisserman A. Multiple view geometry in computer vision[M]. Cambridge: Cambridge University Press, 2003.

[23]Glocker B, Izadi S, Shotton J, et al. Realtime RGB-D camera relocalization[C]//Proc of IEEE International Symposium on Mixed and Augmented Reality. Piscataway,NJ:IEEE Press, 2013: 173-179.

[24]Maddern W, Pascoe G, Linegar C, et al. 1 year, 1000 km: the Oxford RobotCar dataset[J]. International Journal of Robotics Research, 2017,36(1): 3-15.

[25]Huang Xinyu, Wang Peng, Cheng Xinjing, et al. The ApolloScape open dataset for autonomous driving and its application[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2019, 42(10): 2702-2719.

[26]Taira H, Okutomi M, Sattler T, et al. InLoc: indoor visual localization with dense matching and view synthesis[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2018: 7199-7209.

[27]Sattler T, Maddern W, Toft C, et al. Benchmarking 6DoF outdoor visual localization in changing conditions[C]//Proc of IEEE Confe-rence on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2018: 8601-8610.

[28]Walch F, Hazirbas C, Leal-Taixe L, et al. Image-based localization using LSTMs for structured feature correlation[C]//Proc of IEEE International Conference on Computer Vision. Piscataway,NJ:IEEE Press, 2017: 627-637.

[29]Valentin J, Dai A, Niener M, et al. Learning to navigate the energy landscape[C]//Proc of the 4th International Conference on 3D Vision. Piscataway,NJ:IEEE Press, 2016: 323-332.

[30]Cordts M, Omran M, Ramos S, et al. The cityscapes dataset for semantic urban scene understanding[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2016: 6-8.

[31]Fischler M A, Bolles R C. Random sample consensus: a paradigm for model fitting with applications to image analysis and automated cartography[J].Communications of the ACM, 1981,24(6):381-395.

[32]Dániel B, Noskova J, Matas J. MAGSAC: marginalizing sample consensus[C]//Proc of Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2019: 10197-10205.

[33]Lebeda K, Matas J, Chum O. Fixing the locally optimized RANSAC[C]//Proc of British Machine Vision Conference. 2012.

[34]Philbin J, Chum O, Isard M, et al. Lost in quantization:improving particular object retrieval in large scale image databases[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2008: 1-8.

[35]Sattler T, Havlena M, Radenovic F, et al. Hyperpoints and fine vocabularies for large scale location recognition[C]//Proc of IEEE International Conference on Computer Vision. Piscataway,NJ:IEEE Press, 2015: 2102-2110.

[36]Mikulik A, Perdoch M, Ondrˇej C, et al. Learning vocabularies over a fine quantization[J]. International Journal of Computer Vision, 2013, 103(1): 163-175.

[37]Liu Liu, Li Hongdong, Dai Yuchao. Efficient global 2D-3D matching for camera localization in a larges-cale 3D map[C]//Proc of IEEE International Conference on Computer Vision. Piscataway,NJ:IEEE Press, 2017: 2372-2381.

[38]Lowe D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004, 60: 91-110.

[39]Bay H, Ess A, Tuytelaars T, et al. Speededup robust features (SURF)[J]. Computer Vision and Image Understanding, 2008, 110(3): 346-359.

[40]DeTone D, Malisiewicz T, Rabinovich A. SuperPoint: self-supervised interest point detection and description[C]//Proc of IEEE Confe-rence on Computer Vision and Pattern Recognition Workshops. Piscataway,NJ:IEEE Press, 2018: 224-236.

[41]Tian Yurun, Yu Xin, Fan Bin, et al. SoSNet: second order similarity regularization for local descryiptor learning[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2019: 11008-11017.

[42]Cho M, Lee J, Lee K M. Reweighted random walks for graph matching[C]//Proc of the 11th European Conference on Computer Vision. Berlin:Springer, 2010: 492-505.

[43]Cho M, Lee K M. Progressive graph matching: making a move of graphs via probabilistic voting[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2012: 398-405.

[44]Wang Qianqian, Zhou Xiaowei, Hariharan B, et al. Learning feature descriptors using camera pose supervision[C]//Proc of European Conference on Computer Vision.Berlin: Springer, 2020: 757-774.

[45]Dusmanu M, Rocco I, Pajdla T, et al. D2-Net: a trainable CNN for joint description and detection of local features[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2019: 8092-8101.

[46]Luo Zixin, Zhou Lei, Bai Xuyang, et al. ASLFeat: learning local features of accurate shape and localization[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2020: 6589-6598.

[47]Tian Yuren, Balntas V, Ng T, et al. D2D: keypoint extraction with describe to detect approach[C]//Proc of the 15th Asian Conference on Computer Vision.Berlin:Springer, 2020:223-240.

[48]Kesorn K, Poslad S. An enhanced bag of visual word vector space model to represent visual content in athletics images[J]. IEEE Trans on Multimedia, 2011, 14(1): 211-222.

[49]Amato G, Bolettieri P, Falchi F, et al. Large scale image retrieval using vector of locally aggregated descriptors[C]//Proc of Similarity Search and Applications: 6th International Conference. 2013: 245-256.

[50]Revaud J, Almazán J, Rezende R S, et al. Learning with average precision: training image retrieval with a listwise loss[C]//Proc of IEEE/CVF International Conference on Computer Vision. Piscataway,NJ:IEEE Press, 2019: 5107-5116.

[51]Teichmann M, Araujo A, Zhu Menglong, et al. Detect-to-retrieve: efficient regional aggregation for image search[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2019: 5109-5118.

[52]Husain S S, Bober M. REMAP: multi-layer entropy-guided pooling of dense CNN features for image retrieval[J]. IEEE Trans on Image Processing, 2019, 28(10): 5201-5213.

[53]Sarlin P E, Cadena C, Siegwart R, et al. From coarse to fine: robust hierarchical localization at large scale[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2019: 12708-12717.

[54]Zhou Qunjie, Sattler T, Pollefeys M, et al. To learn or not to learn: visual localization from essential matrices[C]//Proc of IEEE International Conference on Robotics and Automation. Piscataway,NJ:IEEE Press, 2022: 3319-3326.

[55]Brachmann E, Krull A, Nowozin S. et al. DSAC-differentiable RANSAC for camera localization[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2017: 6684-6692.

[56]Brachmann E, Rother C. Learning less is more-6D camera localization via 3D surface regression[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2018: 4654-4662.

[57]Cai Ming, Zhan Huangying, Weerasejera W S, et al. Camera relocali-zation by exploiting multi view constraints for scene coordinates regression[C]//Proc of IEEE/CVF International Conference on Computer Vision Workshops. Piscataway,NJ:IEEE Press, 2019: 3769-3777.

[58]Li Xiaotian, Wang Shuzhe, Zao Yi, et al. Hierarchical scene coordinate classification and regression for visual localization[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2020: 11983-11992.

[59]Zhou Lei, Luo Zixin, Shen Tianwei, et al. KFNet: Learning temporal camera relocalization using Kalman filtering[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2020: 4919-4928.

[60]Tang Shitao, Tang Chengzhou, Huang Rui, et al. Learning camera localization via dense scene matching[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2021: 1831-1841.

[61]Brachmann E, Rother C. Visual camera relocalization from RGB and RGB-D images using DSAC[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2022, 44(9): 5847-5865.

[62]Yan Qi, Zheng Jianhao, Reding S, et al. CrossLoc: scalable aerial localization assisted by multi-modal synthetic data[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2022: 17358-17368.

[63]王靜, 胡少毅, 郭蘋, 等. 改進場景坐標回歸網絡的室內相機重定位方法[J]. 計算機工程與應用, 2023, 59(15): 160-168. (Wang Jing, Hu Shaoyi, Guo Ping. et al. Indoor camera relocation method based on improved scene coordinate regression network[J]. Computer Engineering and Applications, 2023, 59(15): 160-168.)

[64]Bui T B, Tran D T, Lee J H. Fast and light weight scene regressor for camera relocalization[EB/OL]. (2022).https://arxiv.org/abs/2212. 01830.

[65]Naseer T, Burgard W. Deep regression for monocular camera-based 6-DoF global localization in outdoor environments[C]//Proc of IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway,NJ:IEEE Press, 2017: 1525-1530.

[66]Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[EB/OL]. (2014). https://arxiv.org/abs/1409. 1556.

[67]Melekhov I, Ylioinas J, Kannala J, et al. Image-based localization using hourglass networks[C]//Proc of IEEE International Conference on Computer Vision Workshops. Piscataway,NJ:IEEE Press, 2017: 879-886.

[68]He Kaiming, Zhang Xiangyu, Ren Shaoqing, et al. Deep residual learning for image recognition[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2016: 770-778.

[69]Kendall A, Cipolla R. Geometric loss functions for camera pose regression with deep learning[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2017: 5974-5983.

[70]Kendall A, Cipolla R. Modelling uncertainty in deep learning for camera relocalization[C]//Proc of IEEE International Conference on Robotics and Automation. Piscataway,NJ:IEEE Press, 2016: 4762-4769.

[71]Bui M, Baur C, Navab N, et al. Adversarial networks for camera pose regression and refinement[C]//Proc of IEEE/CVF International Conference on Computer Vision Workshops. Piscataway,NJ:IEEE Press, 2019: 3778-3787.

[72]Huang Zhaoyang, Xu Yan, Shi Jianping, et al. Prior guided dropout for robust visual localization in dynamic environments[C]//Proc of IEEE/CVF International Conference on Computer Vision. Piscataway,NJ:IEEE Press, 2019: 2791-2800.

[73]Wang Bing, Chen Changhao, Lu C X, et al. AtLoc: attention guided camera localization[C]//Proc of AAAI Conference on Artificial Intelligence. Palo Alto, CA:AAAI Press, 2020: 10393-10401.

[74]Chidlovskii B, Sadek A. Adversarial transfer of pose estimation regression[C]//Proc of European Conference on Computer Vision. Berlin:Springer-Varlag,2020: 646-661.

[75]Sarlin P E, Unagar A, Larsson M, et al. Back to the feature: lear-ning robust camera localization from pixels to pose[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2021: 3247-3257.

[76]Chen Shuai, Li Xinghui, Wang Zirui, et al. DFNet: enhance absolute pose regression with direct feature matching[C]//Proc of European Conference on Computer Vision. Cham: Springer, 2022: 1-17.

[77]Melekhov I, Ylioinas J, Kannala J, et al. Relative camera pose estimation using convolutional neural networks[C]//Proc the 18th International Conference on of Advanced Concepts for Intelligent Vision Systems. Cham:Springer, 2017: 675-687.

[78]Brahmbhatt S, Gu J, Kim K, et al. Geometry-aware learning of maps for camera localization[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press, 2018: 2616-2625.

[79]Balntas V, Li Shuda, Prisacariu V. RelocNet: continuous metric learning relocalisation using neural nets[C]//Proc of European Conference on Computer Vision.Cham:Springer, 2018: 751-767.

[80]Rader N, Bausano M, Richards J E. On the nature of the visual-cliff-avoidance response in human infants[J]. Child Development, 1980,51(1): 61-68.

[81]Toft C, Olsson C, Kahl F. Long-term 3D localization and pose from semantic labellings[C]//Proc of IEEE International Conference on Computer Vision Workshops. Piscataway,NJ:IEEE Press, 2017: 650-659.

[82]Bilen H, Vedaldi A. Universal representation: the missing link between faces, text, planktons, and cat breeds[EB/OL]. (2017). https://arxiv.org/abs/1701. 07275.

[83]Yu Bo, Lane I. Multi-task deep learning for image understanding[C]//Proc of the 6th International Conference of Soft Computing and Pattern Recognition. Piscataway,NJ:IEEE Press, 2014: 37-42.

[84]Rahmatizadeh R, Abolghasemi P, Blni L, et al. Vision-based multi-task manipulation for inexpensive robots using end-to-end lear-ning from demonstration[C]//Proc of IEEE International Conference on Robotics and Automation. Piscataway,NJ:IEEE Press, 2018: 3758-3765.

[85]Valada A, Radwan N, Burgard W. Deep auxiliary learning for visual localization and odometry[C]//Proc of IEEE International Confe-rence on Robotics and Automation. Piscataway,NJ:IEEE Press, 2018: 6939-6946.

[86]Radwan N, Valada A, Burgard W. VlocNet+: deep multitask lear-ning for semantic visual localization and odometry[J]. IEEE Robo-tics and Automation Letters, 2018, 3(4): 4407-4414.

[87]Lin Yimin, Liu Zhaoxiong, Huang Jianfeng, et al. Deep global-relative networks for end-to-end 6-DoF visual localization and odometry[EB/OL]. (2018). https://arxiv.org/abs/1812.07869.

[88]Tian Mi, Nie Qiong, Shen Hao. 3D scene geometry-aware constraint for camera localization with deep learning[C]//Proc of IEEE International Conference on Robotics and Automation. Piscataway,NJ:IEEE Press, 2020: 4211-4217.

[89]Chen Hongrui, Xiong Yuan, Wang Jingru, et al. Long term visual localization with semantic enhanced global retrieval[C]//Proc of the 17th International Conference on Mobility, Sensing and Networking. Piscataway,NJ:IEEE Press, 2021: 319-326.

[90]Ding Mingyu, Wang Zhe, Sun Jiankai, et al. CamNet: coarse-to-fine retrieval for camera relocalization[C]//Proc of IEEE/CVF International Conference on Computer Vision. Piscataway,NJ:IEEE Press, 2019: 2871-2880.