基于人體骨骼關鍵點的心血管患者康復訓練動作評估方法

摘 要:為解決心血管患者日常康復訓練依賴于康復中心專業醫務人員現場指導的問題,圍繞獲得支撐心血管患者自主康復訓練的動作評估系統,提出了基于人體骨骼關鍵點的心血管患者康復訓練動作評估方法(ASRT-PHS)。首先,根據心血管患者的康復訓練動作規范拍攝構建了康復訓練動作數據集;然后,引入基于深度學習的檢測器和姿態估計器采集人體位置信息與人體關鍵點信息,并將提取結果輸入到卷積神經網絡中進行動作識別;接著,通過關節距離比值計算、關節角度閾值計算與標準動作判斷,構建基于關節距離比值的動作切分模型和基于動作關節角度閾值的動作評估模型;最后,通過測試ASRT-PHS在不同關節角度閾值和不同動作識別方法下的動作切分與評估性能,得出了ASRT-PHS的最優工作參數。測試結果表明,ASRT-PHS在動作識別、動作切分與動作評估中的準確率分別達到92.78%、77.6%和87%。此外,真實心血管患者案例測試表明,原型系統的動作評估平均準確率為71.3%,為患者居家自主康復訓練提供了可行的智能輔助系統。

關鍵詞:人體關鍵點; 康復訓練; 心血管患者; 動作評估

中圖分類號:TP391 文獻標志碼:A

文章編號:1001-3695(2024)08-027-2441-07

doi:10.19734/j.issn.1001-3695.2023.11.0606

Action assessment method of rehabilitation training based onhuman skeleton key points for cardiovascular patients

Zhang Ruize1a, Guo Wei2, Yang Guanci1a,1b, Luo Kexin1c, Li Yang1a, He Ling1a

(1.a.Key Laboratory of Advanced Manufacturing Technology of Ministry of Education, b.State Key Laboratory of Public Big Data, c. School of Mechanical Engineering, Guizhou University, Guiyang 550025, China; 2.Guizhou Provincial Staff & Workers Hospital, Guiyang 550025, China)

Abstract:In order to solve the problem that the daily rehabilitation training of cardiovascular patients depends on directing by health care professions in rehabilitation centre,during assessing and correcting the movements system about cardiovascular patients’ independent rehabilitation training at home, this paper proposed an action assessment method for cardiovascular patients’ rehabilitation training based on key points of the human skeleton(ASRT-PHS). Firstly, this paper constructed a dataset for rehabilitation training actions using a camera and data augmentation in accordance with the specified rehabilitation trai-ning specification for cardiovascular patients. Secondly, this paper employed a deep learning-based detector and pose estimator to capture human body positions and extract key points of the human skeleton, respectively, and then input the results into a convolutional neural network for action recognition. Thirdly, by calculating joint angle thresholds, joint distance ratio and assessing standard motions, this paper constructed a motion segmentation model based on joint distance ratios and an action assessment model based on action joint angle thresholds. This paper investigated the optimal combination of ASRT-PHS by assessing its performance with various joint angle thresholds and action recognition approaches. The results show that ASRT-PHS achieves an average action recognition, segmentation and assessment accuracy of 92.78%, 77.6% and 87%, respectively. Furthermore, case tests about the true cardiovascular patients show that the average accuracy of the prototype system is 71.3%, which provides a feasible intelligent auxiliary system for patients’ autonomous rehabilitation training at home.

Key words:human key point; rehabilitation training; cardiovascular patient; action assessment

0 引言

據報道,全球每年約有1 790萬人死于心血管疾病,中國約有3.3億名心血管疾病患者[1]。心血管疾病導致的癱瘓和傷殘使得老年人面臨身體平衡和日常活動能力方面的挑戰,進而影響其獨立生活的能力。康復訓練對于提升患者的日常生活能力至關重要。當前,患者的日常康復訓練依賴于康復中心專業醫務人員的現場指導,不僅需要患者承擔高額的醫療費用,還導致醫療資源緊張。尤其是出院后的家庭康復訓練階段,由于訓練質量要求較高、家庭鍛煉的堅持率較低以及缺乏及時的評估反饋,康復訓練難以達到理想效果。研究顯示,2017—2019年參與門診心臟康復治療的患者中,僅有18.7%的患者完成了24次以上的康復治療[2]。鑒于此,當前亟需采取有效手段,鼓勵患者更主動地參與康復訓練,而研究支撐心血管患者康復訓練動作評估的技術與康復訓練機器人引起了學者的廣泛關注[3,4]。

基于虛擬現實技術的康復訓練方面,Wang等人[5]通過提取腦電信號并分類,設計了基于運動想象的在線腦機接口上肢康復系統,該系統根據實驗者的腦電信號實時控制機器人手臂,但該研究涉及的數據量較小,且未考慮信號采集時的噪聲處理。文獻[6]將VR和BCI融入手部康復系統,將傳統的被動康復轉變為主動康復,該系統能夠提高患者的康復參與度。Liu等人[7]基于虛擬現實設計了虛擬康復訓練與評估系統,通過康復訓練游戲吸引患者的注意力,從而減輕患者可能因長時間康復訓練產生的厭倦情緒。Bortone等人[8]提出了用于神經運動障礙兒童康復治療的沉浸式虛擬現實康復訓練系統,通過自定義與虛擬環境的交互方式,將該系統與可穿戴觸覺設備結合,以滿足不同患者的需求。文獻[9]將VR體能訓練監測與上肢康復技術相結合,通過深度傳感器采集的圖像序列定位人體的關鍵部位,實現了實時評估患者康復訓練的質量并監測康復進展,但該系統僅關注關鍵部位,沒有考慮整體動作。Zhao等人[10]設計了基于智能測控的康復訓練系統,通過康復專家定制子系統、患者培訓子系統、后臺管理子系統構建了康復系統,但該系統主要用于康復管理,依賴于主動輸入的數據。

為了探索機器人遠程輔助康復治療方法,Liu等人[11]設計了居家環境下的遠程康復系統。通過觸覺引導訓練和基于肌電信號的監督訓練,患者在治療師的引導下能夠進行機器人輔助的被動康復或自主康復訓練,該系統依賴可穿戴設備和治療師的指導。Fan等人[12]提出了用于家庭呼吸康復鍛煉的非接觸式運動監測和評估系統。該系統通過多波段微波傳感技術實時監控患者的康復訓練情況,訓練后基于運動信息評估康復運動的質量,無法做到實時評估。Bai等人[13]運用多傳感器融合技術(包括Kinect和姿態傳感器)監測運動軌跡,進而研制了上肢康復訓練評估系統。此系統采用Fugl-Meyer運動評分表評估康復動作,但其僅適用于解決上肢動作軌跡不一致的問題。Kim等人[14]通過在天花板安裝軌道平臺和手推車構建康復訓練系統,該系統能夠通過檢測運動意圖進而預知患者移動方向。

上述研究僅通過虛擬現實或者機器人輔助來進行康復訓練評估,沒有進一步探索與人工智能相結合的動作評估方法。為了評估太極運動,Li等人[15]將評估方法與RGB-D相機結合,開發了實時智能動作質量分析系統,但該系統僅適用于太極運動的動作評估。Parsa等人[16]為在線動作識別提出了一種時空金字塔圖卷積網絡,在姿態估計任務中,該方法取得了高準確率并具備良好的實時性。Zhang等人[17]提出了基于時空特征的動作評估模型,通過捕捉全局時空特征中的深度依賴性來解決表達和泛化能力不足的問題。

在康復訓練過程中,由于人體動作與骨骼關鍵點之間存在十分密切的聯系,通過人體骨骼關鍵點的變化可以反映出執行動作的姿勢、肢體運動路徑等方面的信息,并且隨著人體姿態估計算法的發展,人體骨骼關鍵點檢測精確度也越來越高。將其應用于康復訓練,實現動作精準識別的同時也可以為康復訓練提供更加科學的評估和指導。面對心血管患者日常康復訓練中存在的問題,特別是對康復中心專業醫務人員現場指導的依賴,圍繞獲得支撐心血管患者自主康復訓練的動作評估系統,本文提出基于人體關鍵點的心血管患者康復訓練動作評估方法。

1 康復訓練動作評估數據集構建

當前,已有由Kinect傳感器采集制作成的康復運動數據集UI-PRMD,只支持康復訓練中與鍛煉相關的常見動作識別,而不適用于心血管患者的康復訓練。另一方面,其數據均由人體關鍵點坐標構成,無法實現端到端的動作識別與評估。因此,本文根據康復訓練動作規范的指導[18],構建了心血管患者康復訓練數據集,以達到居家環境心血管患者康復訓練動作評估的目的。康復訓練動作數據集構建方案與過程如下:

1)數據采集設備 采用SAMSUNG S21+智能手機作為數據采集設備。

2)參與人員 邀請課題組內五位研究生作為志愿者參與視頻數據的采集。五位志愿者體重在60~75 kg,身高在1.60~1.85 m,符合大多數人的身材比例。

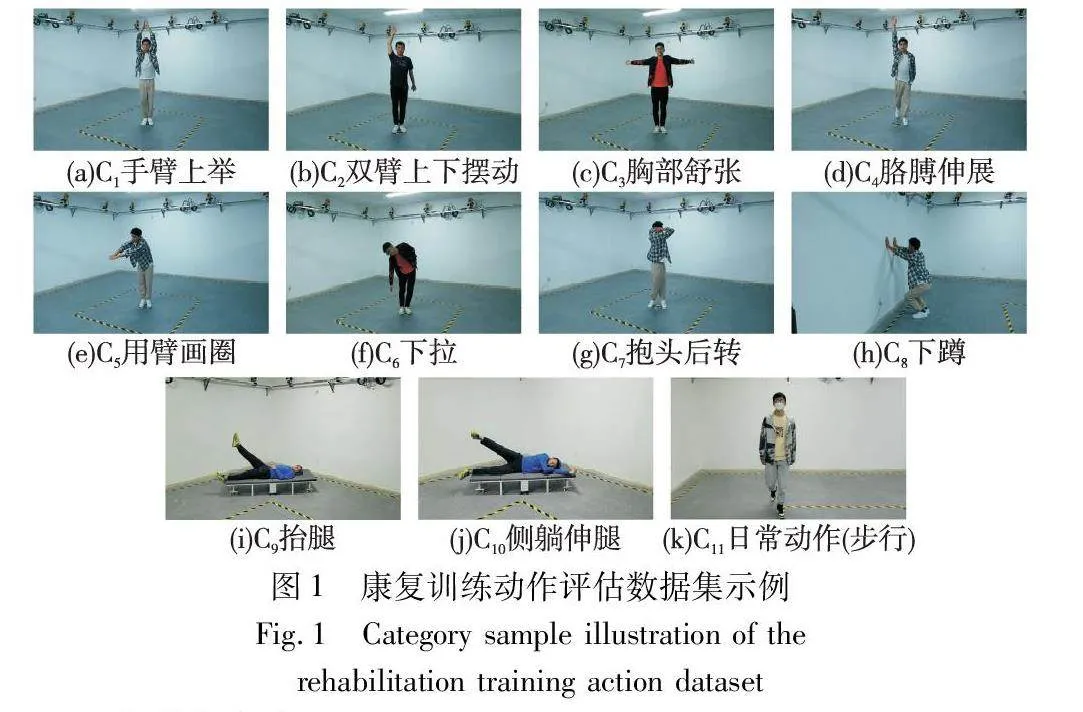

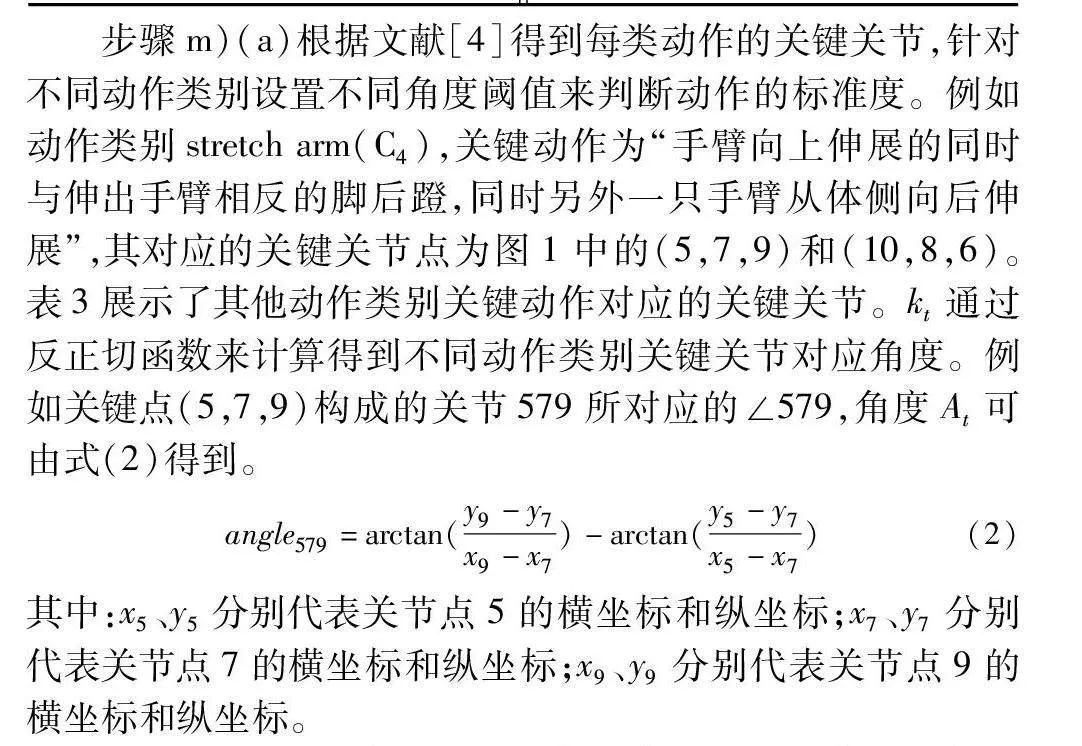

3)動作類型 動作類型分為10類康復動作及1類日常活動動作。10類康復動作分別為:手臂上舉(C1)、雙臂上下擺動(C2)、胸部舒張(C3)、胳膊伸展(C4)、用臂畫圈(C5)、下拉(C6)、抱頭后轉(C7)、下蹲(C8)、抬腿(C9)、側躺伸腿(C10)。1類日常活動動作為步行(C11)。圖1是不同動作類型示例圖。

4)采集方案

a)訓練數據與驗證數據的采集。康復動作數據集包含標準(S)動作視頻和非標準(NS)動作視頻。非標準動作是指不符合規范的動作或者完成度不符合要求的動作,完成度不符合要求是指超過一定閾值的動作(閾值將在3.2節中進行討論)。針對10類康復動作與1類日常動作,其標準動作視頻由5位實驗人員分別在強光近距離、強光遠距離、弱光近距離、弱光遠距離4種不同環境下拍攝,每類動作完成2~4次,同一類動作完成次數相同,每種環境采集1個樣本,每類動作共采集20個樣本。為防止后期動作識別網絡訓練過擬合,只在強光近距離環境下采集10類康復動作的非標準動作視頻,每類動作采集1個樣本。采集過程中攝像頭位置固定,近距離與遠距離代表攝像頭到被測人員的垂直距離,近距離為3.8 m,遠距離為7.5 m。每個動作樣本持續時間為5~9 s,視頻幀率為30,采集過程中動作連續進行。

b)測試數據的采集。本文設計了兩類測試數據來檢驗模型的動作切分與評估性能。實驗方案設計如下:

實驗A 實驗環境與訓練驗證數據相同,測試人員不同。這一實驗驗證在訓練數據集環境相同時,本文康復訓練動作切分與評估方法面向不同被測對象的魯棒性。

實驗B 實驗環境不同,測試人員相同。這一實驗驗證訓練數據集環境變化后,本文模型對不同環境的適應能力。

在實驗B中用中等強度光代替弱光,其余采集方案與訓練數據采集方案相同。每個測試類別包括40個標準視頻、10個非標準視頻和4個日常動作視頻,因此測試數據集共有108個視頻。考慮到C9和C10類別的動作特點與Faster R-CNN的算法特點(需要先檢測到視頻中的人體才能進行關鍵點檢測),將實驗A與B中C9和C10類別的視頻分別旋轉45°或60°,以提高人體檢測的成功率。

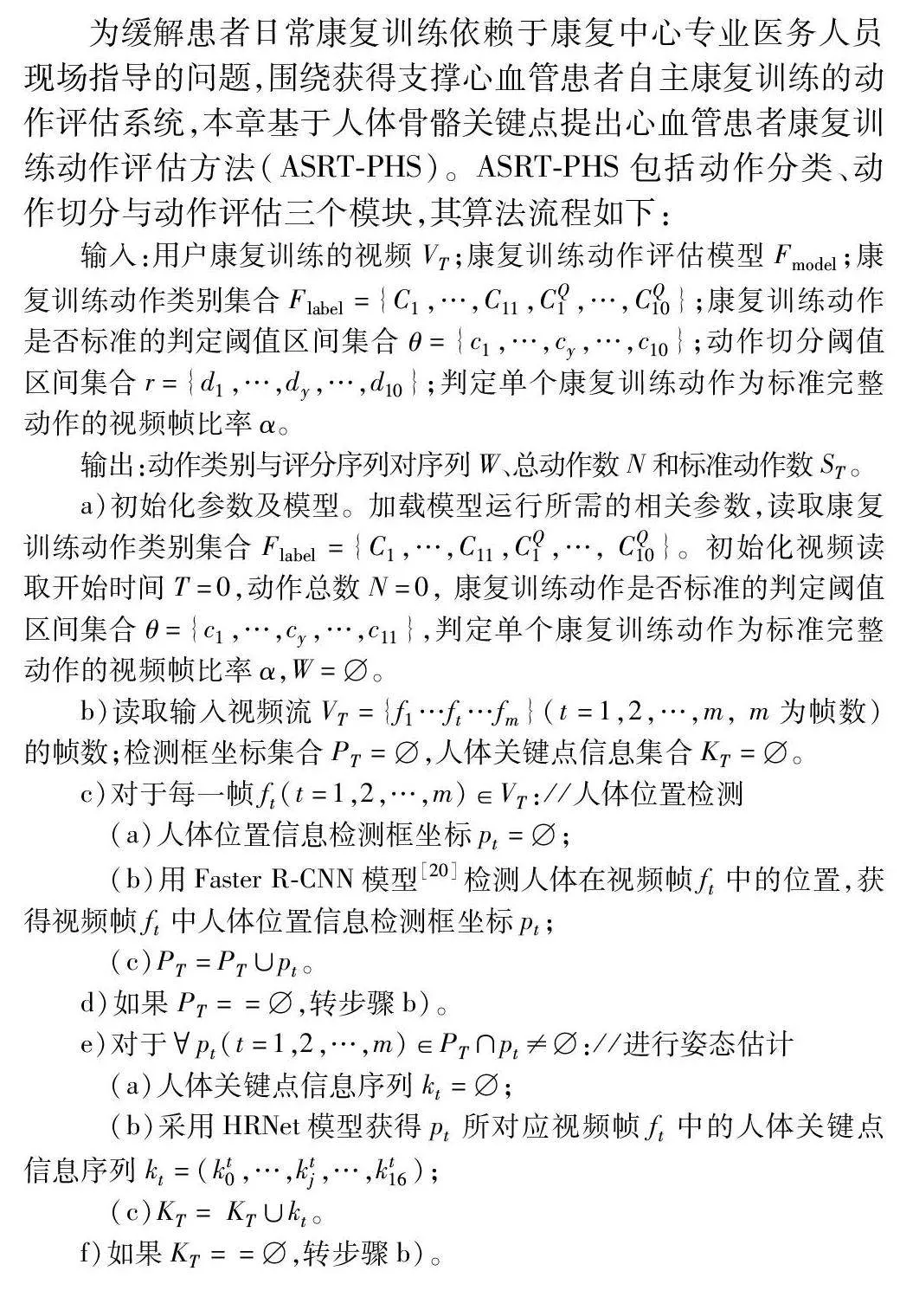

5)數據處理 根據文獻[19]的數據增強方法,對上述采集到的訓練與驗證數據通過對稱變換、旋轉、添加噪聲等方式進行數據增強,將數據擴充1倍,得到訓練數據與驗證數據共有540個視頻。將這些視頻按照7∶3劃分訓練集和驗證集,同時確保每類動作樣本比例均衡。由于測試數據包含108個視頻,所以康復訓練動作評估數據集共有648個視頻,表1是數據集的基本信息。對訓練集和驗證集的每個視頻分別進行分類標注,并用Faster R-CNN和HRNet分別對每個視頻進行特征提取,得到每個樣本對應的含有人體位置信息和關鍵點信息的pkl文件。

2 基于人體關鍵點的心血管患者康復訓練動作評估算法

為緩解患者日常康復訓練依賴于康復中心專業醫務人員現場指導的問題,圍繞獲得支撐心血管患者自主康復訓練的動作評估系統,本章基于人體骨骼關鍵點提出心血管患者康復訓練動作評估方法(ASRT-PHS)。ASRT-PHS包括動作分類、動作切分與動作評估三個模塊,其算法流程如下:

輸入:用戶康復訓練的視頻VT;康復訓練動作評估模型Fmodel;康復訓練動作類別集合Flabel={C1,…,C11,CQ1,…,CQ10};康復訓練動作是否標準的判定閾值區間集合θ={c1,…,cy,…,c10};動作切分閾值區間集合r={d1,…,dy,…,d10};判定單個康復訓練動作為標準完整動作的視頻幀比率α。

輸出:動作類別與評分序列對序列W、總動作數N和標準動作數ST。

a)初始化參數及模型。加載模型運行所需的相關參數,讀取康復訓練動作類別集合Flabel={C1,…,C11,CQ1,…, CQ10}。初始化視頻讀取開始時間T=0,動作總數N=0, 康復訓練動作是否標準的判定閾值區間集合θ={c1,…,cy,…,c11},判定單個康復訓練動作為標準完整動作的視頻幀比率α,W=。

b)讀取輸入視頻流VT ={f1…ft…fm }(t=1,2,…,m, m為幀數)的幀數;檢測框坐標集合PT=,人體關鍵點信息集合KT=。

c)對于每一幀ft(t=1,2,…,m)∈VT://人體位置檢測

(a)人體位置信息檢測框坐標pt=;

(b)用Faster R-CNN模型[20]檢測人體在視頻幀ft中的位置,獲得視頻幀ft中人體位置信息檢測框坐標pt;

(c)PT =PT∪pt。

d)如果PT==,轉步驟b)。

e)對于pt(t=1,2,…,m)∈PT∩pt≠://進行姿態估計

(a)人體關鍵點信息序列kt=;

(b)采用HRNet模型獲得pt所對應視頻幀ft中的人體關鍵點信息序列kt=(kt0,…,ktj,…,kt16);

(c)KT= KT∪kt。

f)如果KT==,轉步驟b)。

g)以Fmodel、康復訓練動作類別集合Flabel、PT和KT作為輸入數據,采用動作分類模型獲得視頻流VT所屬的分類結果CT。

h)如果CTFlabel,轉步驟b)。

i)初始當前視頻VT的標準動作數ST=0,動作符合要求的幀數量Stemp=0, 判斷當前幀的臨時變量ftemp=0,VT中單個動作的開始幀g=0,視頻切分結果集合ET=。

j)遍歷視頻所有幀,根據人體關鍵點序列kt∈KT:得到關鍵關節的向量表示r1 ={r10,…,r1t,…,r1m}和r2 ={r20,…,r2t,…,r2m}。

k)對于當前動作的每一幀的人體關鍵點序列kt∈KT:/*康復訓練動作切分*/

(a)根據不同關節向量r2和r1的比值計算動作切分閾值r。

(b)如果r處于CT類別對應的動作切分閾值dy范圍內并且ft-ftemp>30,則ET =ET∪ft,ftemp=ft。

l)對每一個動作切分結果lt∈ET:

遍歷從該動作開始幀g到結束幀lt的所有幀。

m)對于當前動作的每一幀的人體關鍵點序列kt∈KT: /*判定幀動作是否為標準動作并計數*/

(a)根據人體關鍵點序列kt采用反正切公式計算關鍵關節角度At。

(b)如果At處于CT類別對應的動作評估閾值cy范圍內,則Stemp=Stemp+1。

(c)如果α≤動作評分結果X=Stemp/(lt-g),則記錄標準動作數ST=ST+1, Stemp=0,g=lt,記錄完整動作數N=N+1,形成動作評分序列對w (CT,X),且W=W∪w;

n)如果程序終止,則輸出W,總動作數N和標準動作數ST,否則轉b)。

步驟c)(b)中每個被檢測目標都具有置信度,當被檢測目標置信度不低于0.95時判定為檢測成功。步驟e)(b)中HRNet模型需要在MSCOCO數據集上進行預訓練[21,22]。

步驟k)(a)中任何一類康復訓練動作在練習過程中始終存在長度不變的關節向量(由位置不變的兩個關節點的橫縱坐標差值的絕對值構成,記為r1)和長度循環變化的關鍵動作關節向量(由關鍵關節點的橫縱坐標差值的絕對值構成,記為r2),因此,可以將r2映射到以r1為x軸的坐標系中,通過計算r2與r1的比值r,當r達到一定閾值則說明一個動作完成,且r不會隨相機與受試者的距離變化。例如動作類別arm up,由關節(9,11)構成的關鍵關節r2與關節(11,12)構成的長度固定關節r1的比值可由式(1)得到。

r=r2r1=y9-y11x11-x12(1)

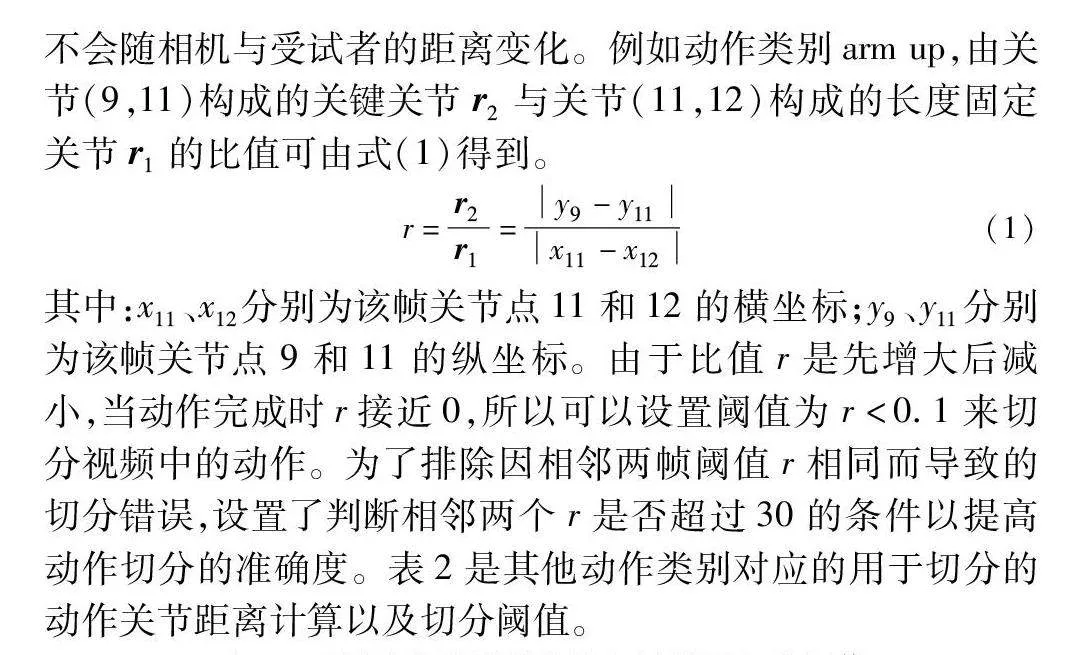

其中:x11、x12分別為該幀關節點11和12的橫坐標;y9、y11分別為該幀關節點9和11的縱坐標。由于比值r是先增大后減小,當動作完成時r接近0,所以可以設置閾值為r<0.1來切分視頻中的動作。為了排除因相鄰兩幀閾值r相同而導致的切分錯誤,設置了判斷相鄰兩個r是否超過30的條件以提高動作切分的準確度。表2是其他動作類別對應的用于切分的動作關節距離計算以及切分閾值。

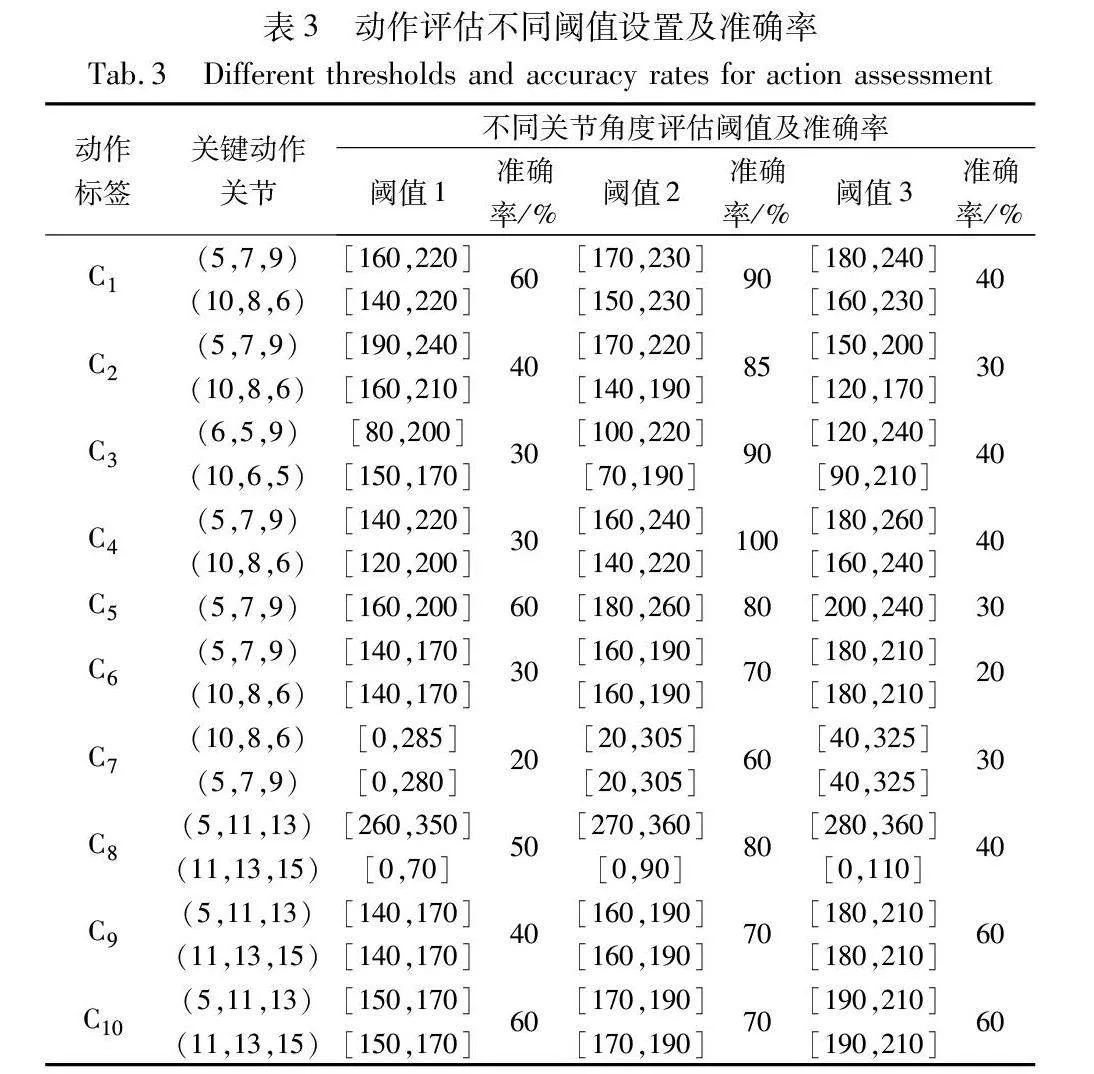

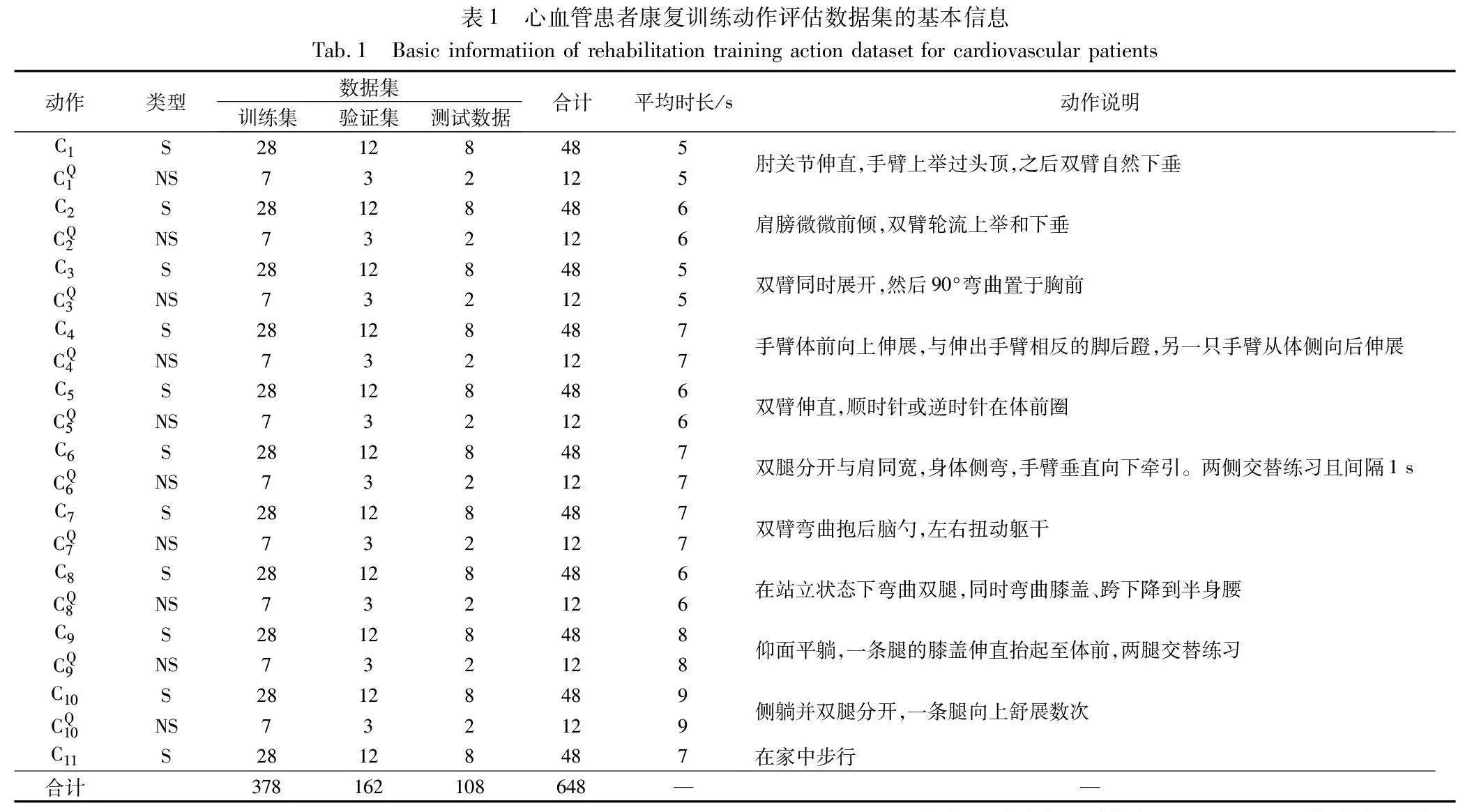

步驟m)(a)根據文獻[4]得到每類動作的關鍵關節,針對不同動作類別設置不同角度閾值來判斷動作的標準度。例如動作類別stretch arm(C4),關鍵動作為“手臂向上伸展的同時與伸出手臂相反的腳后蹬,同時另外一只手臂從體側向后伸展”,其對應的關鍵關節點為圖1中的(5,7,9)和(10,8,6)。表3展示了其他動作類別關鍵動作對應的關鍵關節。kt通過反正切函數來計算得到不同動作類別關鍵關節對應角度。例如關鍵點(5,7,9)構成的關節579所對應的∠579,角度At可由式(2)得到。

angle579=arctan(y9-y7x9-x7)-arctan(y5-y7x5-x7)(2)

其中:x5、y5分別代表關節點5的橫坐標和縱坐標;x7、y7分別代表關節點7的橫坐標和縱坐標;x9、y9分別代表關節點9的橫坐標和縱坐標。

步驟m)(b)中,實驗人員對每個康復訓練動作進行標準度判斷,然后通過模型獲取每一幀的關節角度閾值。具體方法為:對于訓練數據與驗證數據采集的視頻,測試人員判斷視頻中每個動作是否標準,同時利用模型計算每幀動作的關鍵關節角度,從而得到標準動作的閾值。例如動作類別stretch arm,分別作出:a)右臂向上伸展,同時伸出左腳后蹬,左臂向后伸展;b)左臂向上伸展,同時伸出右腳后蹬,右臂向后伸展。當左腋下(由關節點(7,5,11)構成的關節)角度小于90時且當右肘(由關節點(10,8,6)構成的關節)角度閾值為[160,240]時判定該動作標準,當右腋下(由關節點(8,6,12)構成的關節)角度小于90時且當左肘(由關節點(5,7,9)構成的關節)角度閾值為[140,220]時判定該動作標準,否則該動作為非標準。表3中是其他康復訓練動作類別的關節角度評估閾值。

1b2ddf42eee4c724141186fed9574d683 實驗結果與分析

本文實驗處理器采用 Intel Core i5-10400,內存為16 GB,顯卡為 GTX1050 Ti,顯存為4 GB,通過1080P攝像頭采集視頻,操作系統為Ubuntu 20.04,基于PyTorch深度學習框架進行姿態估計模型及動作分類網絡的搭建,并使用GPU加速姿態估計與動作識別模型的識別過程。

3.1 實驗方案和指標

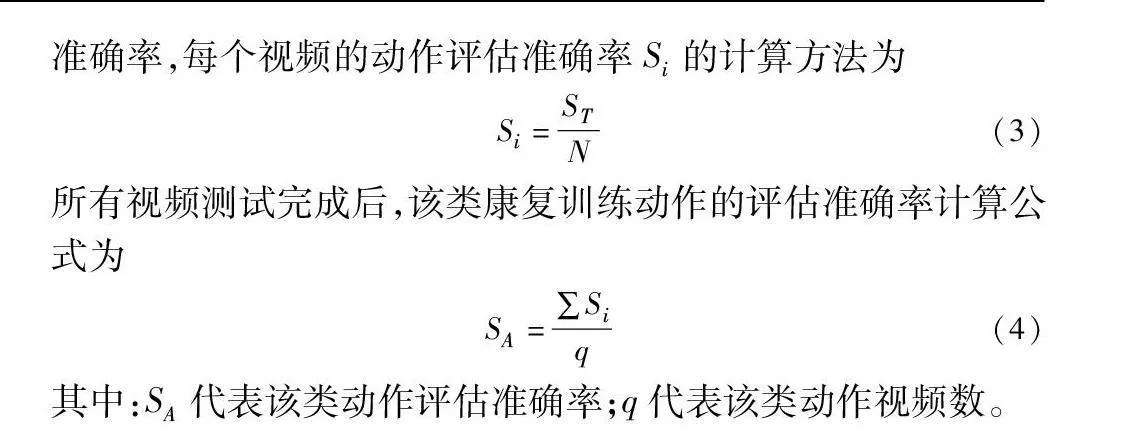

采用動作切分的準確率和動作評估的準確率、推理速度以及動作識別的top-1準確率測試方法的性能。針對動作評估的準確率,每個視頻的動作評估準確率Si的計算方法為

Si=STN(3)

所有視頻測試完成后,該類康復訓練動作的評估準確率計算公式為

SA=∑Siq(4)

其中:SA代表該類動作評估準確率;q代表該類動作視頻數。

針對動作切分的準確率,視頻中每個動作經過模型處理后可以得到切分開始幀與切分結束幀,同時每個動作具有實際的開始幀與結束幀,則模型正確切分部分計算公式為

TP=(Os,Oe)∩(Hs,He)(5)

其中:Os和Oe分別表示模型切分得到的動作開始幀與結束幀;Hs和He表示動作的實際開始幀與實際結束幀。

切分后實際動作與切分動作所占的總幀數為

AP=(Os,Oe)∪(Hs,He)(6)

單個視頻中每個動作模型切分的準確率Preseg的計算公式為

Preseg=TPAP(7)

其中:TP是模型正確切分的動作幀數;AP是模型錯誤切分的動作幀數。每個視頻的切分準確率Vpre的計算公式為

Vpre=∑PresegN(8)

每個動作類別模型切分的準確率Cn的計算公式為

Cn=∑Vpreq n=1,2,…,10(9)

3.2 不同關節角度閾值實驗

為了更全面地優化模型性能,著重考慮兩個關鍵方面:針對不同類別動作關鍵關節的判定準確率以及模型在應對不同受試者時的適用性。因此,對每個動作類別分別設置動作關鍵關節與評估閾值。針對每類動作分別選取不同實驗人員的5個視頻,通過分析視頻數據并與實驗人員討論,得出用于該動作評估的大致閾值。在此基礎上對閾值進行微調,得到3組不同的閾值。通過模型測試與實驗人員驗證得出每類動作的5個視頻中不同閾值評估的準確率。具體來說,當每個視頻中70%的幀經過系統判定為標準并符合實驗人員驗證時,該動作判定為標準,同時根據式(3)(4)計算每類動作在不同閾值下的評估準確率。觀察表3可知,不同閾值設置對評估準確率存在影響,閾值2在動作評估中的準確率相對于閾值1和3要更高,相同條件下能實現評估的結果更加準確,因此選取該閾值進行后續實驗驗證與測試。

3.3 不同動作識別模型與α值實驗

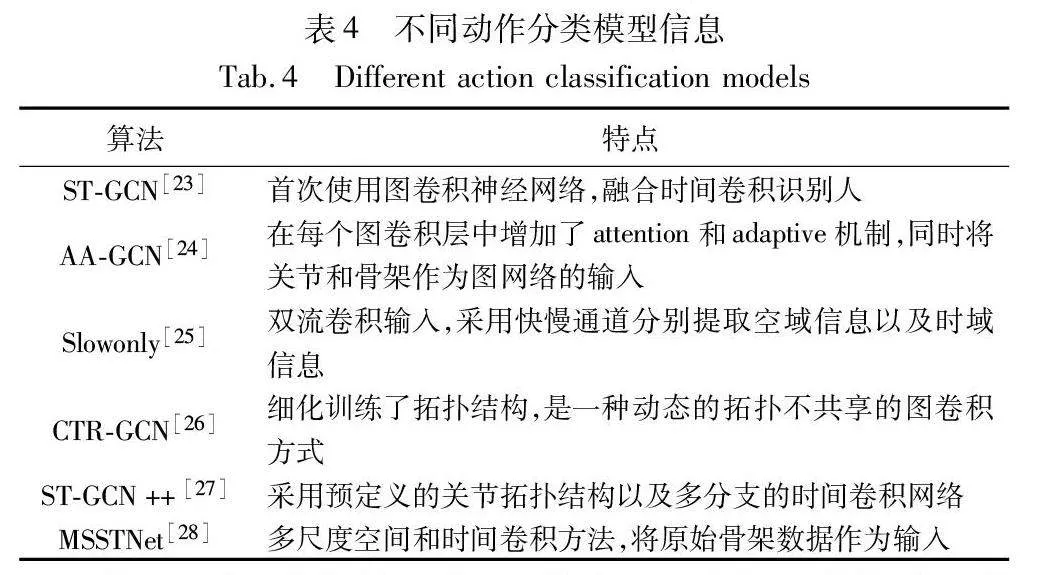

考慮到不同的動作識別模型對算法的性能有影響,因此,本節選擇代表性動作識別模型進行測試,進而選擇出最匹配的動作識別模型。表4是所選擇的模型與特點統計。

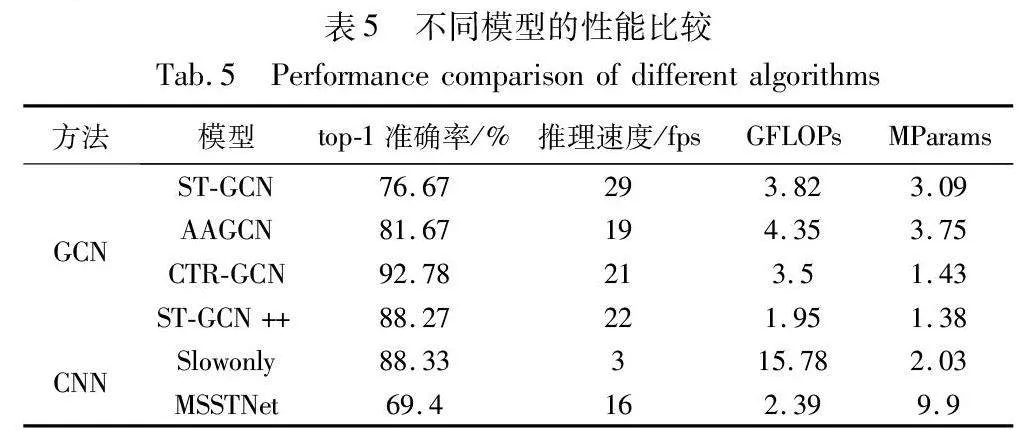

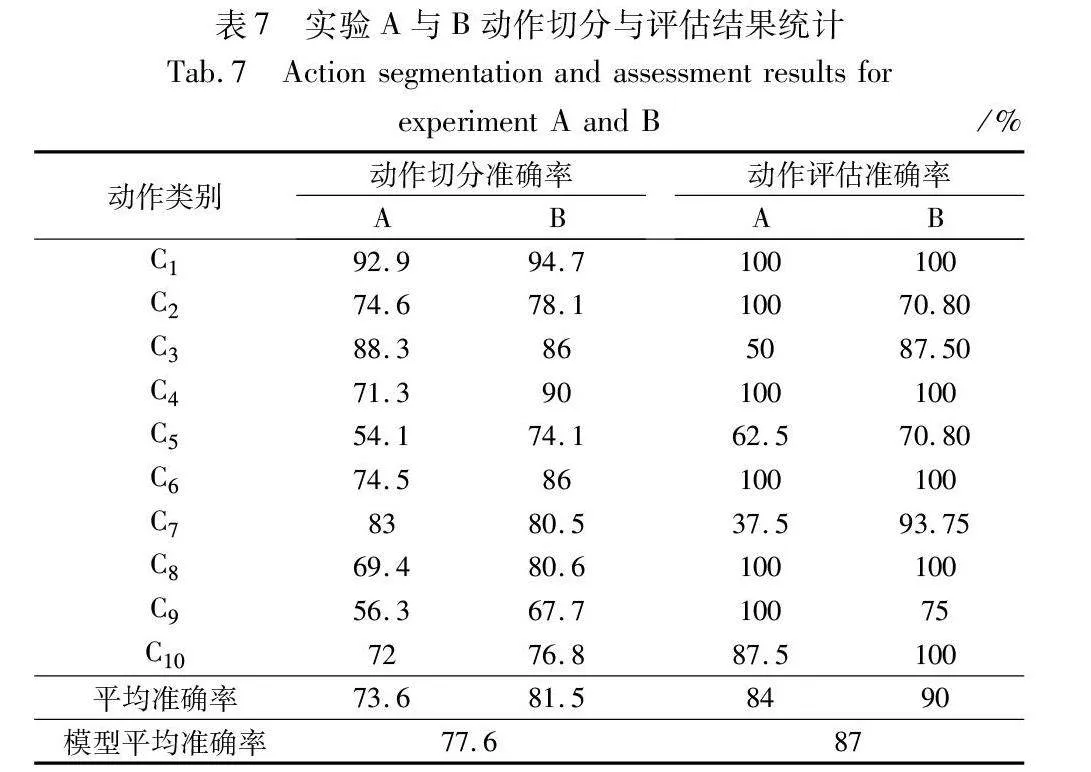

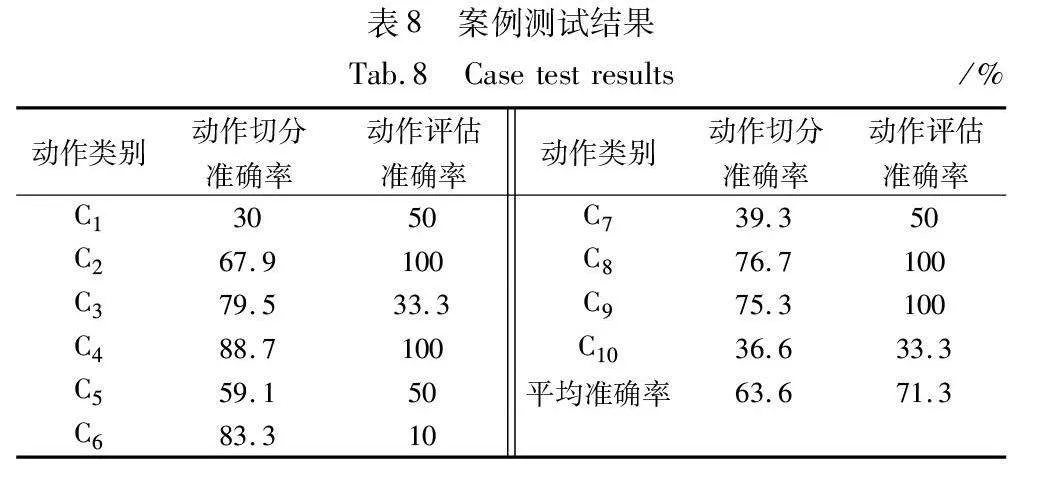

為了充分考慮各模型的特征并實現更高的準確率,表4中MSSTNet在訓練時的學習率設定為0.001,而其他模型則使用學習率為0.1進行訓練。訓練循環30輪,batch-size為4。表5是不同模型的性能比較結果。與此同時,測試了這些方法在訓練后的推理速度,結果也列在了表5中。為了探究不同方法top-1準確率和模型推理速度之間的關系,將表5中的數據按推理速度升序排列進行整理,圖2是不同模型的top-1準確率與推理速度比較結果。

由表5可知,在不同模型的效率方面,基于GCN的模型相較于基于CNN的模型表現出更低的GFLOPs和更高的top-1準確率。以CTR-GCN為例,盡管其GFLOPs和MParams相較于ST-GCN++較高,但卻表現出最高的top-1準確率,因此適用于對top-1準確率要求較高的場景。AAGCN在準確率和推理速度之間取得了平衡。ST-GCN具有最高的推理速度,但top-1準確率低于其他GCN模型,適用于對推理實時性有更高要求的環境。ST-GCN++具有較高的top-1準確率、與CTR-GCN相近的推理速度與更低的GFLOPs和MParams,適用于計算資源有限的環境。在CNN模型中,Slowonly具有與ST-GCN++相近的top-1準確率,但推理速度遠低于STGCN++,且具有更高的GFLOPs,對計算資源的要求也更高。MSSTNet模型展現出相對較低的模型復雜度,然而其top-1準確率較低。相較于GCN模型,MSSTNet并未表現出顯著優勢。

觀察圖2可知,隨著模型推理速度的增加,不同模型的top-1準確率呈現上升或下降的趨勢。雖然STGCN的推理速度最快,但模型的top-1準確率較低;CTR-GCN的推理速度不如ST-GCN,但top-1準確率最高。根據這種規律可以對這些方法進行分類:一類為推理速度慢但top-1準確率高的模型,如Slowonly、CTR-GCN、ST-GCN++;另一類為推理速度較快但top-1準確率低的模型,如ST-GCN、AA-GCN、MSSTNet。綜合對比考慮,選擇CTR-GCN作為動作識別模型進行后續實驗。

接下來,將詳細探討不同α值對動作評估準確率的影響。如3.2節所述,當每個視頻中70%的幀經系統判定為標準并符合實驗人員驗證時,動作評估判定為正確。為了研究系統所判定的標準幀數對動作評估準確度的影響,采用3.2節中閾值實驗的測試方案,分別測試當α為70%、80%、90%時動作評估的準確率。在統計結果時排除了所有因分類錯誤導致系統判斷錯誤的數據。表6是動作評估準確率在不同α值下的測試結果。

由于同一動作當α>70增大時準確率下降,綜合對比,當α>70時可以作為通用的動作評估判定標準。與此同時,根據用戶動作差異,不同的α取值范圍可以提供不同的動作評估判斷標準。綜上所述,當以CTR-GCN為動作識別模型,閾值2為判定閾值,α>70為動作評估判定標準時,算法具有最佳的性能。因此后續集成的系統中,選擇上述參數作為ASRT-PHS默認工作參數。

3.4 算法性能分析

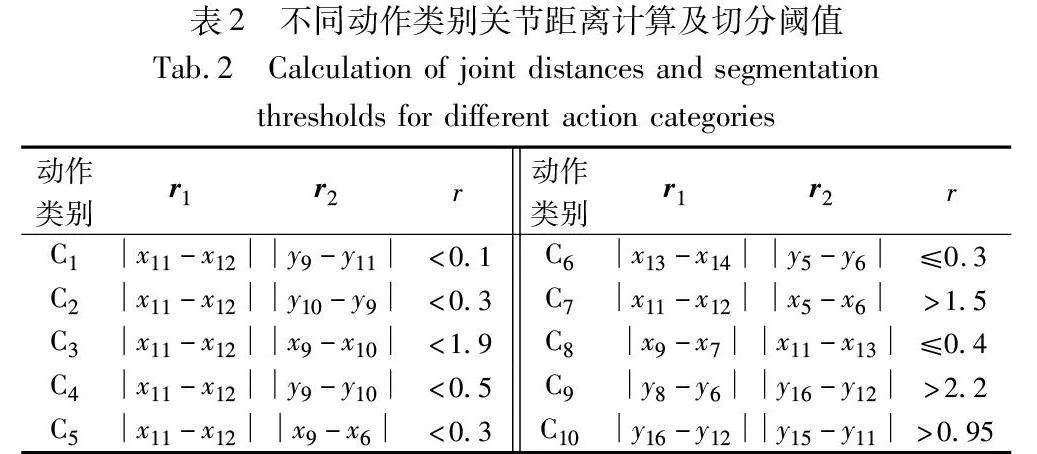

基于上述算法、評價指標與最優工作參數,以及3.1節所給出的計算公式計算每個動作類別的評估準確率和切分準確率。表7是實驗A、B中不同類別的動作切分與評估統計結果。

觀察表7可知,在動作切分的準確率方面,多數動作類別表現出較高的準確率,其中實驗A、B的動作切分平均準確率分別達到了73.6%和81.5%。XHpS2BMn1j187vpPYEpXkH93PX0Z/A1iOOMNHldh0yU=然而,動作類別C5的準確率相對較低,這是由于關鍵點檢測過程中出現抖動,導致部分關鍵點的丟失,進而影響了動作切分的準確性。對于C9和C10類別的視頻,進行了旋轉處理,以確保人體檢測的成功率。然而,這一處理導致在部分遠距離拍攝的視頻中,旋轉后的坐標點位置相對于原始視頻發生較大的變化,因此對于相同的閾值r,其準確率會低于近距離所拍攝視頻。對于C7類別,在實驗A中準確率為83%,這是由于該類別包含了身體轉向的步驟,當受試者朝后轉向時存在關鍵點遮擋,導致部分幀的關鍵點坐標出現錯誤。總體而言,這些觀察結果表明,在動作切分過程中需要考慮抖動問題和距離變化對準確率的影響,以便更有效地處理不同拍攝情境下的視頻數據。

由表7中ASRT-PHS動作評估的平均準確率為87%可知,本文方法在動作評估方面表現出良好的性能。具體而言,實驗A與B的平均準確率分別達到84%和90%,表明在不同實驗條件下,多數動作類別的評估準確率較高。然而,實驗B在強光下的動作評估結果準確率較高,表明環境光照強度對該類動作評估產生了影響。C2和C3類別在實驗A中的準確率較低,是由于不同實驗人員雙臂彎曲的程度不同,對于相同評估閾值設置得到不同評估結果,進而影響了評估的準確性。針對這種差異性,實際工作中需要根據不同受試者的動作特征設置不同的評估閾值,以提高算法的適應性。對于C5和C6類別,由于完成動作時需要彎腰,不同實驗人員存在運動差異,且同一實驗人員每次完成動作也存在細微差異,導致評估準確率較低。同時C6類別的評估準確率也受到動作識別錯誤的影響(動作識別錯誤導致用其他類別的閾值來評估),因此在實際應用中需要針對動作特點進一步優化動作識別模型。C7類別是由于完成動作時需要轉頭至身后,存在部分關鍵點遮擋,導致無法準確識別運動信息。在實驗B中,C9類別的動作評估準確率為75%,說明經過順時針45°旋轉處理后,視頻的動作識別成功

率提高,但由于旋轉后關鍵點坐標位置變化,在相同的閾值條件下,觀察到遠距離拍攝視頻的準確率相對較低,所以近距離拍攝條件更適用于實際工作。同時,不同實驗人員存在運動差異,尤其是抬腿時的幅度不同,導致C9和C10類別在實驗A和B中的準確率存在差異。最后,動作類別C3和C6均含有胳膊彎曲和身體轉向的動作,導致運動過程中存在部分關鍵點遮擋,因此在實驗A和B中的準確率較低。這一現象進一步表明關鍵點遮擋對準確率會產生顯著的負面影響,在實際工作中需要根據患者的運動特征調整閾值以確保判定準確性。

4 案例分析

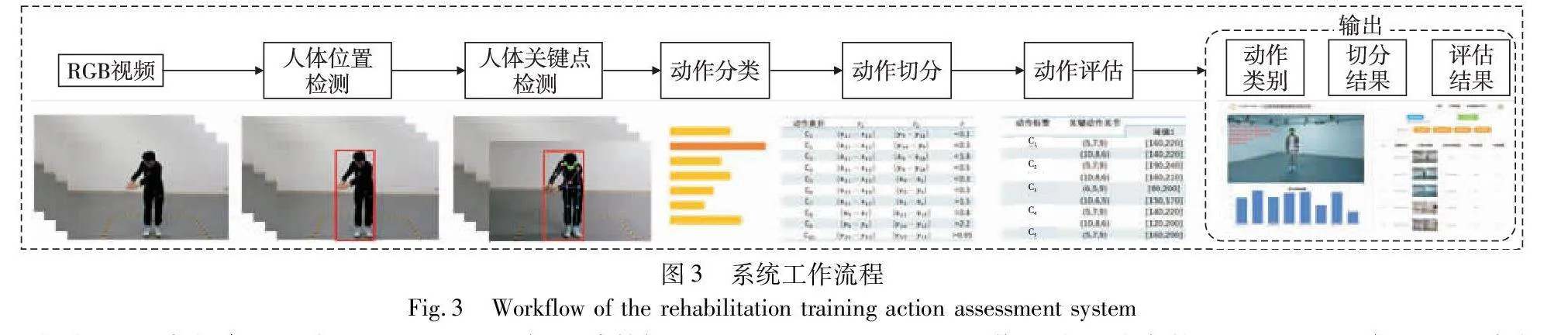

根據上述研究,運用ASRT-PHS開發了康復訓練動作評估系統。系統的總體框架包括前端與后端兩個部分。以攝像頭采集的實時視頻流或錄制視頻數據作為輸入,以終端的動作分類和評估結果作為輸出。為了實現前后端的有效交互,系統以前后端分離的形式進行設計,給前端提供API接口,后端采用Flask封裝深度學習模塊、登錄模塊和MySQL數據庫模塊,前端界面采用Vue構建。Axios用于前端和后端交互。系統的運行流程如下:通過前端采集康復訓練動作視頻數據,由后端服務器運行ASRT-PHS算法對輸入的視頻進行相應處理,輸出動作類別、動作切分結果與動作評估結果,再由前端展示輸出結果等交互界面。系統具有標準視頻示例、動作評估、實時檢測與數據統計四個功能。圖3為系統工作流程。

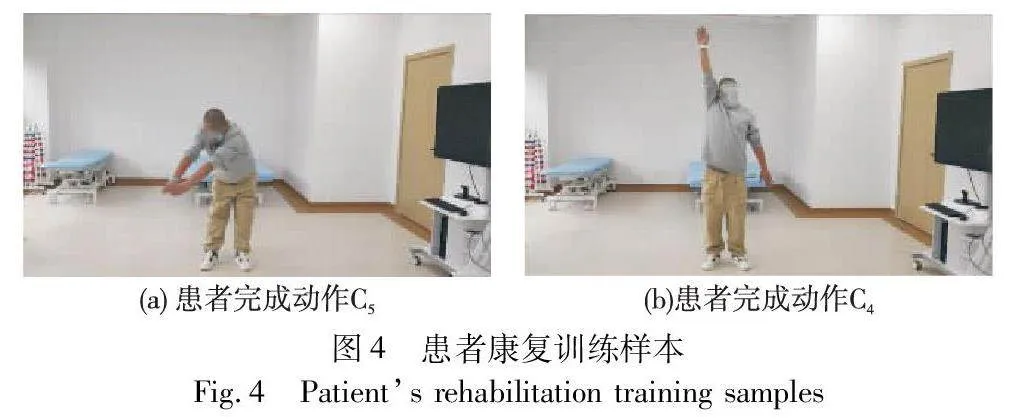

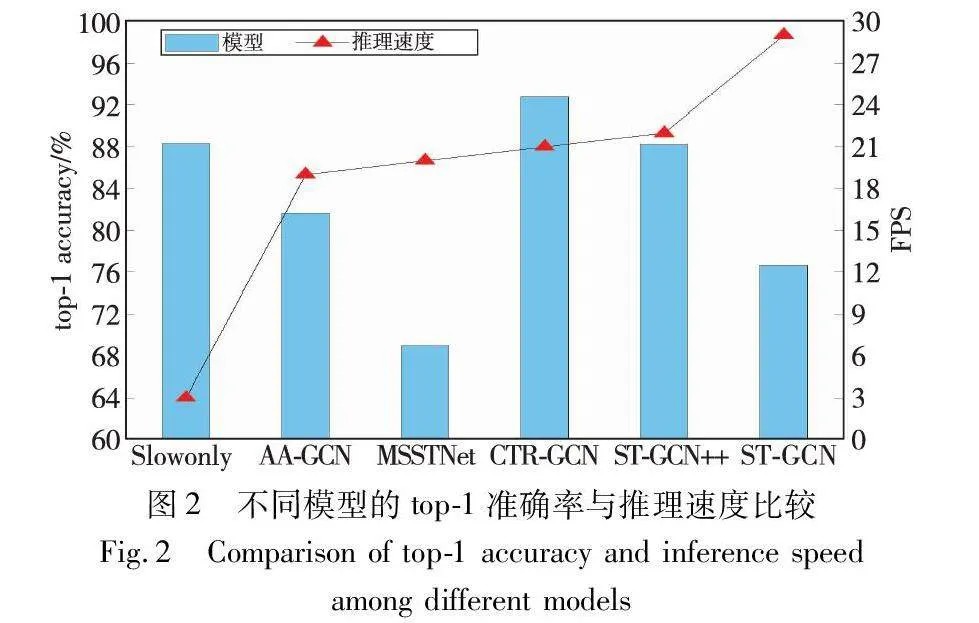

當前,全國康復專業技術人員相對匱乏,據統計數據顯示,全國平均每10萬人口有一名康復治療專業技術人員[29]。為此,在貴州省職工醫院招募了一位心血管患者作為案例測試,驗證并探討本文方法對心血管患者的適用性。該患者為男性,年齡50歲,具有大學文化程度,身高180 cm,體重70 kg,已經接受過心血管疾病相關治療并處于康復階段。首先,給患者介紹了課題組的概況及相關研究內容,并與患者簽訂了本文研究項目的知情同意書;其次,給患者示范了標準動作并告訴其動作要領;最后,在醫生的指導與協助下采集該患者的康復訓練動作數據。用攝像頭采集視頻,其高度與3.1節采集時相同。讓患者完成10類康復訓練動作,每類動作完成兩次共20個視頻。最后,將視頻輸入到系統中進行處理并分析結果,考慮到患者與健康受試者的運動差異,分別測試在不同閾值下動作切分和評估的準確率。圖4是患者康復訓練樣本,表8是案例測試結果。

觀察表8可知,動作切分和評估的平均準確率為63.6%和71.3%,C2、C4、C8和C9類別動作評估的準確率達到100%,表明本文方法對心血管患者的適用性較好。然而,C1和C3類別的動作評估準確率較低,是由于患者未經過康復動作的相關練習,與康復訓練數據集中的健康受試者相比,部分動作步驟存在動作差異(例如患者左臂與右臂動作不能同步進行)。實際應用中需要根據不同患者的運動情況,進行動作切分與動作評估閾值的個性化設置。C6類別的準確率較低,一方面是由于部分視頻動作識別錯誤導致用其他的動作類別閾值評估;另一方面是由于患者腰部無法完全彎曲導致關鍵關節角度無法達到閾值標準。C7類別需要患者身體轉向后方,在此過程中會存在部分關鍵點遮擋,因此準確率較低。對于經過旋轉的C9和C10類別視頻,盡管得到了關鍵點信息,但部分視頻會由于分類錯誤導致動作切分與評估錯誤,所以針對未檢測成功的樣本需要調整攝像頭視角以確保完全檢測到人體信息。而動作切分準確率較低的C1、C5、C7、C10類別,是由于患者的運動差異導致動作完成度未達到切分閾值標準,首個動作切分誤差引起了后續動作的切分誤差。綜上所述,ASRT-PHS適用于心血管患者的康復訓練,但仍需要根據不同患者的運動情況對閾值進行個性化調整。

5 結束語

合理的動作識別網絡參數、動作切分與評估閾值以及實驗環境可以為心血管患者居家康復訓練提供科學的指導與及時的評估反饋。本文通過人體位置檢測、人體關鍵點檢測、動作識別、基于關節距離比值的動作切分方法以及基于關鍵關節角度閾值的動作評估方法實現了康復訓練動作的識別與評估。通過測試分析不同的動作識別算法、關鍵動作關節角度閾值以及多種實驗環境下本文方法的性能表現,對康復系統的性能進行了評估。并針對心血管患者進行了案例測試與分析,進而形成了一套基于人體骨骼關鍵點的心血管患者康復訓練動作評估方法和系統,為心血管患者居家康復訓練動作評估提供了輔助手段。鑒于人體關鍵點檢測算法對動作切分與評估結果有影響,未來將針對該問題展開研究,以提升系統在動作識別、動作評估和動作切分方面的準確性,并通過考察不同患者的運動差異來實現閾值的動態調整,以進一步優化康復訓練動作評估系統的性能。

參考文獻:

[1]國家心血管病中心.《中國心血管健康與疾病報告》2020[J]. 心肺血管病雜志, 2021, 40(10): 1005-1009. (National Center for Cardiovascular Diseases. Annual report on cardiovascular health and diseases in China 2020[J]. Journal of Cardiovascular & Pulmonary Diseases, 2021, 40(10): 1005-1009.)

[2]王祎, 江露瑩, 吳岳, 等. 心血管疾病患者Ⅱ期心臟康復完成率及其影響因素分析[J]. 中國循環雜志, 2021,36(10): 1003-1008. (Wang Yi, Jiang Luying, Wu Yue, et al. Completion rate and influencing factors of phase Ⅱ cardiac rehabilitation program in patients with cardiovascular disease [J]. Chinese Circulation Journal, 2021, 36(10): 1003-1008.)

[3]張延恒, 莫春暉, 張瑩, 等. 移動式康復訓練機器人及下肢康復運動分析[J]. 華中科技大學學報: 自然科學版, 2021,49(3): 6-11. (Zhang Yanheng, Mo Chunhui, Zhang Ying, et al. Design and motion analysis of mobile rehabilitation training robot[J]. Journal Huazhong University of Science & Technology(Natural Science Edition), 2021, 49(3): 6-11.)

[4]陳書立, 張景景, 陳海洋, 等. 鏡像上肢康復機器人研究[J]. 計算機應用研究, 2019, 36(2): 321-326. (Chen Shuli, Zhang Jingjing, Chen Haiyang, et al. Research on mirror rehabilitation robot of upper limbs[J]. Application Research of Computers, 2019,36(2): 321-326.)

[5]Wang Kaiwei, Wang Zhenghui, Ren Wu, et al. Design of sports rehabilitation training system based on EEMD algorithm[J]. Computational Intelligence and Neuroscience, 2022, 2022: article ID 9987313.

[6]Chen Pengcheng, Gao Nuo. Research of VR-BCI and its application in hand soft rehabilitation system[C]//Proc of the 7th International Conference on Virtual Reality. Piscataway, NJ: IEEE Press, 2021: 254-261.

[7]Liu Siyuan, Meng Deyuan, Cheng Long, et al. A virtual reality based training and assessment system for hand rehabilitation[C]//Proc of the 9th International Conference on Intelligent Control and Information Processing. Piscataway, NJ: IEEE Press, 2018: 33-38.

[8]Bortone I, Leonardis D, Mastronicola N, et al. Wearable haptics and immersive virtual reality rehabilitation training in children with neuromotor impairments[J]. IEEE Trans on Neural Systems and Rehabilitation Engineering, 2018, 26(7): 1469-1478.

[9]Maskeliūnas R, Damaevicˇius R, Blazˇauskas T, et al. BiomacVR: a virtual reality-based system for precise human posture and motion analysis in rehabilitation exercises using depth sensors[J]. Electro-nics, 2023, 12(2): 339.

[10]Zhao Nana, Han Xiao, Chen Long. Construction and application of rehabilitation training system based on intelligent measurement and control[J]. Scientific Programming, 2022, 2022: article ID 4442590.

[11]Liu Yi, Guo Shuxiang, Yang Ziyi, et al. A home-based tele-rehabilitation system with enhanced therapist-patient remote interaction: a feasibility study[J]. IEEE Journal of Biomedical and Health Informatics, 2022, 26(8): 4176-4186.

[12]Fan Dou, Yang Xiaodong, Zhao Nan, et al. Exercise monitoring and assessment system for home-based respiratory rehabilitation[J]. IEEE Sensors Journal, 2022, 22(19): 18890-18902.

[13]Bai Jing, Song Aiguo. Development of a novel home based multi-scene upper limb rehabilitation training and evaluation system for post-stroke patients[J]. IEEE Access, 2019, 7: 9667-9677.

[14]Kim J N, Shin M Y, Chong W S, et al. Development of rail-based dynamic rehabilitation training system considering user’s movement[J]. Journal of Mechanics in Medicine and Biology, 2022, 22(3): 2240003.

[15]Li Jianwei, Hu Haiqing, Xing Qingjun, et al. Tai Chi action quality assessment and visual analysis with a consumer RGB-D camera[C]//Proc of the 24th International Workshop on Multimedia Signal Proces-sing. Piscataway, NJ: IEEE Press, 2022: 1-6.

[16]Parsa B, Narayanan A, Dariush B. Spatio-temporal pyramid graph convolutions for human action recognition and postural assessment[C]//Proc of IEEE Winter Conference on Applications of Computer Vision. Piscataway, NJ: IEEE Press, 2020: 1069-1079.

[17]Zhang Zhitao, Wang Zhengyou, Zhuang Shanna, et al. Toward action recognition and assessment using SFAGCN and combinative regression model of spatiotemporal features[J]. Applied Intelligence, 2023, 53(1): 757-768.

[18]何塞·曼努埃爾·桑斯·門希瓦爾. 人人都能看得懂的運動康復指南: 全彩圖解版[M]. 董艷艷, 譯. 北京: 人民郵電出版社, 2017: 83-87. (José M S M. Guide to sports rehabilitation that everyone can understand: full color graphic[M]. Dong Yanyan, Trans. Beijing: Posts & Telecom Press, 2017: 83-87.)

[19]Papakipos Z, Bitton J. AugLy: data augmentations for adversarial robustness[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2022: 156-162.

[20]Ren Shaoqing, He Kaiming, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2017, 39: 1137-1149.

[21]Sun Ke, Xiao Bin, Liu Dong, et al. Deep high-resolution representation learning for human pose estimation[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2019: 5686-5696.

[22]Luo Kexin, Yang Guanci, Li Yang, et al. Croup and pertussis cough sound classification algorithm based on channel attention and multiscale Mel-spectrogram[J]. Biomedical Signal Processing and Control, 2024, 91: 106073.

[23]Yan Sijie, Xiong Yuanjun, Lin Dahua. Spatial temporal graph convolutional networks for skeleton-based action recognition[C]//Proc of the 32nd AAAI Conference on Artificial Intelligence and 30th Innovative Applications of Artificial Intelligence Conference and 8th AAAI Symposium on Educational Advances in Artificial Intelligence. Palo Alto, CA: AAAI Press, 2018: 7444-7452.

[24]Shi Lei, Zhang Yifan, Cheng Jian, et al. Skeleton-based action re-cognition with multi-stream adaptive graph convolutional networks[J]. IEEE Trans on Image Processing, 2020, 29: 9532-9545.

[25]Duan Haodong, Zhao Yue, Chen Kai, et al. Revisiting skeleton-based action recognition[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2022: 2959-2968.

[26]Chen Yuxin, Zhang Ziqi, Yuan Chunfeng, et al. Channel-wise topo-logy refinement graph convolution for skeleton-based action recognition[C]//Proc of IEEE/CVF International Conference on Computer Vision. Piscataway, NJ: IEEE Press, 2021: 13339-13348.

[27]Duan Haodong, Wang Jiaqi, Chen Kai, et al. PYSKL: towards good practices for skeleton action recognition[C]//Proc of the 30th ACM International Conference on Multimedia. New York: ACM Press, 2022: 7351-7354.

[28]Cheng Qin, Cheng Jun, Ren Ziliang, et al. Multi-scale spatial-temporal convolutional neural network for skeleton-based action recognition[J]. Pattern Analysis and Applications, 2023, 26(3): 1303-1315.

[29]張元鳴飛, 楊延硯, 張娜, 等. 2021年度國家康復醫學專業醫療服務與質量安全報告[J]. 中國康復理論與實踐, 2022, 28(12): 1365-1379. (Zhang Yuanmingfei, Yang Yanyan, Zhang Na, et al. 2021 national report on rehabilitation medicine services, quality and safety in medical care system[J]. Chinese Journal of Rehabilitation Theory and Practice. 2022, 28(12): 1365-1379.)