仿人面部表情機器人研究進展

張國亮, 王展妮, 王田, 吳昊

(華僑大學 計算機學院, 福建 廈門 361021)

仿人面部表情機器人研究進展

張國亮, 王展妮, 王田, 吳昊

(華僑大學 計算機學院, 福建 廈門 361021)

首先,梳理近年來國內外這一領域的發展現狀,并從心理學維度空間角度探討了表情機器人的情感建模方法.其次,從機構設計、人臉表情的計算模型、表情特征的提取與分類的識別等多個方面,對表情機器人研究中的關鍵技術展開綜述.最后,在綜述分析的基礎上,對表情機器人研究現狀及其未來發展進行系統的評價,給出今后發展的4個方向.

仿人機器人; 表情機器人; 面部表情; 面部動作編碼; 心理學.

工業機器人在制造業中的快速發展為機器人進入民用服務領域提供了良好的契機.與傳統的固定工位、固定工序和固定操作場景的工業機器人不同,服務機器人對于交互性、智能性和自主性的要求更高.在服務機器人領域中,仿人面部表情機器人因其人機交互友好、學科交叉融合度大等特點,成為當前這一研究領域中的熱點問題.表情機器人的研究不僅涉及到信息傳感、控制等自然學科,而且還需要考慮其內在的情感及情緒等心理變化.因此,本文從表情機器人的心理學建模、物理建模和計算模型等多個角度,詳細闡述了該領域的相關理論與技術,展望了未來的發展方向.

1 國內外表情機器人研究現狀

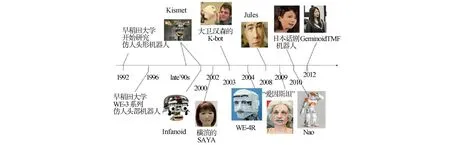

目前,對具有仿人面部表情機器人的研究主要集中在歐美、日本的大學及研究機構[1-2],近年來,國外具有代表性的仿人面部表情機器人的概括,如圖1所示.

圖1 國外面部表情機器人研究進展

20世紀90年代,美國麻省理工學院人工智能實驗室的辛西婭·布雷齊爾博士等研發了嬰兒機器人Kismet.它是較早的具有面部表情的仿人機器人,能以類似嬰兒的行為方式表達出Ekman定義的喜、怒、哀、樂等6種基本情感狀態.日本早稻田大學開發的WE-3RV的情感機器人將6種基本情感擴充到9種,并建立了具有外界刺激的三維情感空間模型.東京理工大學開發的SAYA機器人較早采用了人工肌肉輔助運動機構,從而產生面部表情.SAYA女性的外觀使得其具有較好的親和力,現已嘗試應用于指揮交通、授課及售貨等日常生活領域.英國赫特福德大學的設計Nao機器人,具有1歲嬰兒的情感及行為學習模式.機器人在與人類的接觸過程中,通過觀察身邊人的表情、動作來分析人們的情感變化,從而與人建立雙向情感聯系.日本大阪大學智能機器人教授Hiroshi相繼研究了ReplieeQ1,ReplieeQ2和GeminoidTMF等女性仿人機器人.其中,GeminoidTMF以日本新聞女主播藤井雅子為原型,動作表情與真人極其相似,使人即便在近處也很難分辨真偽.

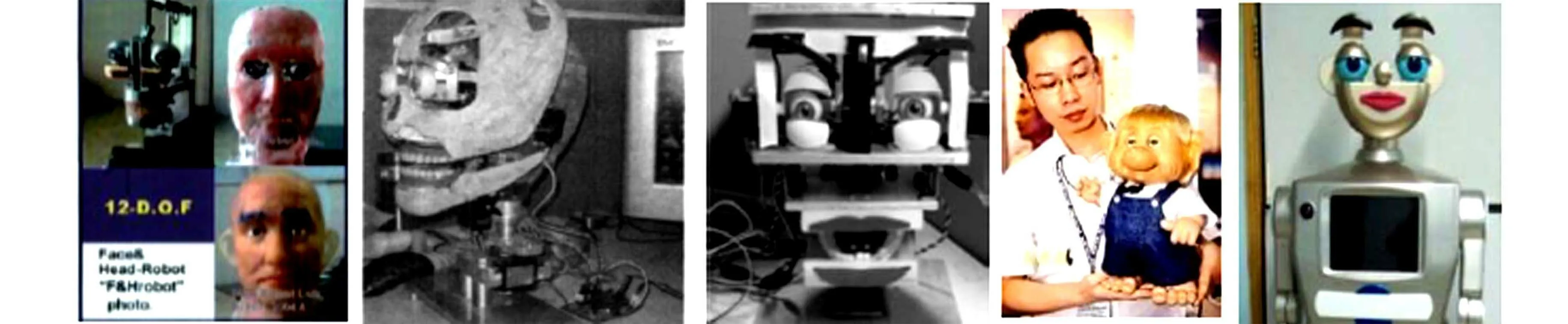

國內仿人表情機器人研究工作起始于哈爾濱工業大學吳偉國教授領導的團隊,2004年,該項目組在國內首次研制了能夠表達8種基本表情的H&Frobot-I,隨后又相繼研究了具有面部動作協調、口形與語音識別協調功能的H&Frobot-II和H&Frobot-III[3].北京科技大學王志良教授[4-5]等較早地對表情機器人的人工情感、多信息融合交互等方面展開研究,設計了具有人機共同注意、動態情緒調節的仿人機器人頭部.2010年,上海大學的柯顯信等[6]基于AT89S52單片機和7個舵機,設計并實現了具有11個自由度的結構相對簡單的SHFR-1表情機器人.除此之外,“百智星”幼教機器人及“童童”3機器人也是近年來國內研發的具有代表性的表情機器人.國內面部表情機器人,如圖2所示.

(a) H&F機器人 (b) 北科大仿人頭部 (c) SHFR-1 (d) 百智星幼教機器人 (e)童童機器人

2 仿人機器人表情的心理學模型

外在的刺激可以由傳感器獲取,但內在的情感及心理活動的變化卻屬于心理學范疇.因此,建立與表情機器人相適應的情感模型是實現預期表情的理論基礎.在心理學研究領域,對于情感的研究非常廣泛,常用的方法主要有基本情感論、維度空間理論、認知情感論、個性化和情緒化情感論等.其中,維度空間理論由于便于將復雜的情感多維量化,在情感機器人建模領域中受到了廣泛的關注,目前多數的具有情感模型的表情機器人都采用了類似的理論模型.

維度空間論認為,人的所有情感分布在由若干維度構成的某一空間中,不同情感之間不是獨立的,而是連續可漸變的.最早提出情感可進行維度量化的是實驗心理學奠基人Wundt,他利用愉快-不愉快、緊張-松弛、興奮-沉靜3個維度來表示情感.美國心理學家Schlosberg提出了與Wundt的方法類似的倒立圓錐情感空間.Schlosberg認為,任何的情感都可以在橢圓錐上找到自己合適的位置,Schlosberg的橢圓錐是西方心理學提出的第一個具有維度情感量化表的情感模型.Plutchik[7]發展了Schlosberg的模型理論,他利用因素分析法假設了情感之間存在著3個基本特征:強度、相似性和兩極性.Plutchik認為原始的情感是從進化過程中分化出來的,居于頂端最強烈,沿著扇形面向下,越靠近底端情感越微弱[8].同一扇面上越臨近,情感性質上越接近,互為對角的兩個扇形中的情感則是相互對立的,距離越遠,差異越大.Plutchik情感模型具有典型的多維量表的模型結構,在表情機器人等應用領域得到深入的研究,如MIT的Kismet表情機器人就采用了與Plutchik情感模型類似的模型結構.將Plutchik的扇形空間轉換為對立性和外界刺激程度二維平面,而將強度轉換為對外界刺激程度的反應.除Plutchik的倒立圓錐模型,由Russell等提出的PAD維度觀測模型也是目前心理學界公認的一種普適的三維情感模型.國內毛峽等[9-10]研究的表情機器人及仿生代理中都采用了相似的模型.

3 仿人表情機器人的關鍵技術

3.1 表情機器人機構設計

表情機器人的頭部機構是表情交互的物理載體,良好的機構設計是實現表情自然交互的前提條件.人類的臉部不僅運動器官眾多,而且器官運動幅度的細微瞬間變化都可能表達不同的情感.因此,為達到表情正常輸出,表情頭部機構的設計不僅需要從生物學的角度模仿,還需要對整個系統綜合考慮,在滿足機構的運動學、動力學、控制能力、驅動系統和傳感器需求的前提下,機構設計一般至少需要滿足以下兩點要求.

1) 外觀上與人類頭部外形、大小、樣貌相似,給人以親切感和可信任感.人的面部器官包括眼睛、鼻子、眉毛、嘴巴和下顎等.在這些器官中,眼睛是人類最為重要的面部器官.然而,對于人類的表情,僅僅依靠人眼是無法獨立表達情感的,眼部表情動作一般需要結合眼球、眼瞼和眉毛一起來表達.眼球具有上、下、左、右共4個自由度(DOF),每一個眼睛包含上、下兩個眼瞼,其設計難點在于眼球運動與眼瞼運動可能存在空間干涉,且由于下眼瞼運動幅度較小,多數研究從簡化機構設計角度,只做了一側眼瞼,但考慮到眼瞼睜開的幅度對表情有很大影響,雙側眼瞼運動的設計能夠表達更豐富的情感.眉毛和嘴部涉及的表情變化非常靈活,目前已出現有1,2,4,8等不同自由度的眉毛,而嘴部運動的變化更加豐富,不僅包含平面的運動,還涉及了空間運動.因此,在表情機器人設計中,從2~6個自由度的形式均有出現.下頜和頸部的承載力度最大,通常需要選擇載荷較大的電機加以控制.

2) 在機構設計中,需要針對表情機器人的應用形式,整體考慮空間的布局和自由度的分配,為驅動和傳感器預留足夠的空間.在表情機器人中,為使每個器官運動的幅度與人類相近,需要把大量傳感器和驅動裝置裝入頭部中,這就需要在有限空間完成復雜機構設計,整個系統具有運動空間狹窄、運動范圍小的特點.針對這種特殊的應用需求,國內外學者在機構設計方面提出了大量可行的研究方案,如德國Kaiserslautern大學的ROMAN機器人利用8個金屬板支撐骨架,依靠10個舵機推拉線控制硅膠面皮,實現表情動作,并加入1個大扭矩輸出舵機控制下頜動作,實現 6種基本表情.日本東京通信研究實驗室設計了15個自由度的Infanoid,其突出特點是在眼部加了5個DOF,眼球能在正負45°范圍內掃視.日本早稻田大學WE-4R機器人共有25個DOF,其設計也非常重視眼部和眉部的運動,眼球的俯仰運動與眼瞼的開合能夠聯動.WE-4R與其他表情機器人最大不同之處是運用藍色和綠色的發光板來表達臉頰面色,面色并將其與眉毛、嘴唇、下頜和聲音一起來表達情感.美國漢森公司研發的“愛因斯坦”是近年來具有最復雜機構的機器人表情頭,它能夠實現31個自由度,可表達28個臉部表情.國內北京科技大學的李娜等[11]設計了11個DOF的表情頭,眼球、眼瞼、眉毛、頸部和下顎的自由度分別為4,2,2,2,1.哈工大的“H&F”系列機器人共有12個自由度,面部表情的驅動裝置采用了電機與繩索相結合的驅動方式,而眼睛機構采用線傳動.

3.2 人臉表情的計算模型

人類的面部表情非常豐富,臉部細小的微變可能表達完全不同的情感.據統計,人臉約可產生1萬種表情,而其中的3 000種是具有情感意義的.因此,為使表情機器人正確表達情感,需要對這些表情進行編碼、統計,從而使其在不同的情境做出合適的表情,其中具有代表性的表情編碼系統包括:面部動作編碼系統(facial action coding system,FACS)、情感面部動作編碼系統(emotional facial action coding system,EMFACS)、最大判別面部運動編碼系統(maximally discriminative facial movement coding system,MAX)、MPEG-4三維人臉動畫標準和面部表情編碼系統(facial expression coding system,FACES)[12]等.

FACS是美國心理學教授保羅·艾克曼于20世紀70年代末提出的,FACS根據解剖學定義了44個運動單元,及運動描述符來描述面部運動,每個運動單元具有不同的位置和強度.FACS是迄今為最為詳盡、最為精細的面部測量系統,很多后續的方法都是以它作為基礎展開的,例如,2002年,Ekman在FACS系統的基礎上,定義了6種基本表情及33種不同的表情傾向,確定了改進的簡化FACS系統.EMFACS則是將情感相關的面部運動與原始的FACS結合,對面部表情重新進行編碼.MAX系統由Izard提出,該系統提供一個有效和可靠的系統測量嬰兒和兒童的面部行為中的情感信號.MPEG-4三維人臉動畫標準利用人臉定義參數(facial definition parameter,FDP)描述特定人臉紋理形狀模型與通用人臉模型之間的差別,利用人臉動畫參數(facial animation parameter,FAP)描述特定人臉表情與中性表情的變化關系.MPEG-4中共定義了68個FAP,每個FAP分別定義人臉某一小區域的運動.在FAP基礎上,MPEG-4還利用了FAP之間的空間關系,定義了人臉動畫參數單元(facial animation parameter unit,FAPU),及其84個特征點,用于校準人臉和產生人臉動畫.美國加利福尼亞大學的Kring等提出的FACES提供了表情的頻率、強度、誘惑力和持續時間等信息,能對分布在情感維度模型上的表情進行度量,并且所需時間較短.FACS考慮了身體位置的移動、手部的遮擋、眼睛、講話、面部抽搐等對表情的影響,增強了系統的可靠性.

3.3 人臉表情識別技術

人臉表情識別是表情機器人應用的關鍵支撐技術.雖然近年來人臉檢測技術已逐漸成熟,但與之密切相關的表情分析識別方法仍有許多難點有待克服,而表情數據庫的建立、人臉特征的檢測、分類的識別是其核心的研究內容.

3.3.1 人臉表情庫 目前人臉表情數據庫大致分為3類.第一類是以6種基本情感為基礎,直接建立具有不同情感的表情庫,例如馬里蘭大學人臉表情庫[13],包含40種不同文化和種族的測試者6種基本情感的人臉表情庫.荷蘭代爾夫特理工大學MMI人臉表情數據庫包含50名測試者的6種基本情感,共500個靜態圖像和2 000個視頻.德國慕尼黑理工大學FG-NET數據庫包含18名測試者的6種基本情感表情和中性表情的序列.伊朗謝里夫理工大學DML-SUT人臉表情數據庫包含10名被試者6種情感表情和中性表情的可見光和紅外視頻序列.五邑大學建立了包含6名男性和5名女性的6種基本情感表情和中性表情的CED-WYU人臉表情庫[14].中國科技大學的建立了包含6種基本情感的可見光和紅外人臉表情圖像庫USTC-NVIE[15].第二類是以FACS是編碼為基礎,建立基于量化數據的細微表情庫.例如,卡內基梅隆大學機器人研究所建立的包含單一運動單元和復合運動單元共23種表情人臉表情數據庫CK+.第3類是針對較大人臉表情姿態變化的三維表情數據庫.如紐約州立大學賓漢姆頓分校建立了BU-3DFE庫[16],包含100名不同種族被試者6種基本情感表情和中性表情的三維信息.英國中央蘭開夏大學建立的ADSIP3-D動態人臉表情數據庫包含10名被試者的害怕、嫌惡、生氣、高興、驚訝、悲傷和疼痛7種表情,并分為輕微、一般和極度3種強度[17].

除了以上3種典型表情庫之外,混合型表情數據庫也受到學者的關注,如北京航空航天大學建立的共包含18種單一表情、3種混合表情和4種復雜表情的BHU數據庫[18].中科院計算技術研究所人臉數據庫建立了具有姿勢、表情、飾品、光照、背景、距離和時間7種不同環境類別的人臉表情庫CAS-PEAL[19],其特殊性是考慮了環境因素的影響.

3.3.2 表情特征提取與分類識別 人的面部表情涉及了大量復雜的肌肉運動變化,在考慮特征選擇及分類模型時,必須考慮柔性形變對于識別性能的影響.因此,中性表情臉的差異化形變特征選取是表情分析識別領域最常采用的特征提取方法.常采用的方法有活動外觀輪廓、點分布模型、Gabor圖像變換和采用主成分分析方法(PCA)等.

表情的分類器模型是建立在特征選擇的基礎之上的,主要包括隱馬爾科夫模型法、神經網絡法、時空運動能量模板法、支持向量機、Adaboost、基于規則推理的方法、PCA等.如胡敏等[20]提出了一種基于梯度 Gabor直方圖的人臉表情特征識別方法.蔣斌[21]在判別分量分析算法的基礎上,提出了針對人臉表情識別的局部判別分量分析算法.希臘雅典國家技術大學Caridakis等[22]提出了對用戶和上下文自適應的神經網絡方法進行表情識別的方法.北航大學的Wang等[23]引入流行學習中較為成熟的LLE代替AAM中的PCA方法描述面部運動,在減小圖像殘差的基礎上,實現了面部較大變化的識別.

4 未來展望

表情機器人集成了人工智能、認知科學、信息科學等多學科的研究成果,近年來取得了較快的發展,但距離完全自然的人機交互還有一段距離,其研究仍然面臨許多挑戰性課題,從目前的研究狀況來看,以下3個方向將是今后發展的趨勢.

4.1 特殊材料的應用

從近年來已面世的表情機器人來看,頭部機械結構雖然較為復雜,但在機構設計方面基本已經成熟,并無太多實質性的研究進展.與之對比,表情機器人的外觀和內部傳感領域卻碩果頗豐,其突出代表是漢森公司發明的人造皮膚和東京理工大學研制的氣動人工肌肉.近十年來,漢森公司在人造皮膚領域取得了令人驚嘆的成就,他們利用人造橡膠和泡沫混合物制造的人造皮膚外觀仿真度極高,不僅可完整地模仿、表達人類的28種面部表情,且面部會隨著年齡的變化而出現皺紋.東京理工大學研究的人工肌肉當被充氣和吸氣時,可以像人的肌肉一樣伸縮,這種氣動結構的肌肉組織具有質量小、運動平滑、動力強勁等特點,適合較大幅度的表情運動.

4.2 特殊情境下的表情識別研究

傳統的表情分析、識別針對的是人類的正常狀態,而特殊情境包括環境存在遮擋、被識別者本身受到某種外界因素干擾,如疲勞和疼痛等.魯棒化識別和細微化識別是這一類特殊應用必須面對的課題.與魯棒性識別相比,表情的細微化識別難度更大,目前,主要有概率模型和強度模型兩種方法.由于人臉細微化表情在運動速度、幅度和時間上特殊性,目前的研究方法僅能對特定細微表情建模分析,很難對有意為之的偽表情和不經意流露出的微表情進行識別.因此,如何提高細微化表情的自動識別的準確性和魯棒性,將是今后研究者深入思考的內容.

4.3 多信息、多方法的融合應用

考慮到表情建模,尤其是細微表情變化度量的復雜性,多信息、多方法的融合受到學者的廣泛關注,這一策略包含兩方面內容:一是方法策略間的融合;二是通過方法間的互補性來提高復雜表情的識別效率.Zhao等[24]提出了結合模糊核分類和支持向量機的面部復雜表情識別方法;Littlewort等[25]結合Adaboost和SVM建立了自發疼痛表情識別系統;為提高痛苦表情識別的準確率,張偉等[26]提出基于監督保局投影與多核線性混合支持向量機的識別方法.

5 結束語

類人表情機器人研究涉及心理學、認知科學、計算機智能、自動控制、機械設計等多領域知識,具有典型的多學科交叉特征.文中系統分析了該領域國內外研究工作的最新進展,并從心理學理論模型和應用關鍵技術兩個方向詳細闡述了當前亟需解決的問題,展望了表情機器人未來的發展方向.

[1] HIRTH J,BRAUN T,BERNS K.Emotion based control architecture for robotics applications[C]∥Proceedings of IEEE International Conference on Robotics and Automation (ICRA).Italy:IEEE Press,2007:2150-2155.

[2] HIRTH J,BRAUN T,ERNS K.Emotion based control architecture for robotics applications[C]∥Proceedings of 30th Annual German Conference on Artificial Intelligence.Osnabrück:IEEE Press,2007:464-467.

[3] 吳偉國,宋策,孟慶梅.仿人頭像機器人“H&F Robot-III”語音及口型系統研制與實驗[J].機械設計,2008,25(1):15-20.

[4] 王巍,王志良,鄭思怡,等.一類具有相同結構的表情機器人共同注意方法[J].機器人,2012,34(3):265-274.

[5] 劉欣,謝侖,楊文祥,等.表情機器人的動態情緒調節過程研究[J].控制理論與應用,2011,28(7):936-947.

[6] 柯顯信,唐文彬,陳玉亮,等.仿人面部表情機器人的控制系統設計[J].上海大學學報(自然科學版),2011,17(1):79-84.

[7] PLUTCHIK R.Emotion: A psychoevolutionary synthesis [M].New York:Harper & Row Publishers,1980:30-52.

[8] RUSSELL S J,SUBRAMANIAN D.Provable bounded-optimal agents[J].Journal of Artificial Intelligence Research,1995,2(1):575-609.

[9] MAO Xia,XUE Yuli,CHENG Leelun,et al.Harmonious Graphics Generating Based on the 1/fFunction Theory[J].Chaos, Solitons and Fractals,2007,32(2):521-525.

[10] 包海燕.智能仿生代理的情感建模方法研究[D].北京:北京航空航天大學,2010:45.

[11] 李娜,陳工,王志良.表情機器人設計與實現[J].機器人技術,2007,23(12):231-234.

[12] KRING A M,SHOAN D M.The facial expression coding system(FACES), development, validation, and utility[J].Psychological Assessment,2007,19(2):210-224.

[13] BLACK M J,YACOB Y.Recognizing facial expressions in image sequences using local parameterized models of image motion [J].International Journal of Computer Vision,1997,25(1):23-48.

[14] 朱明旱,李樹濤,葉華.基于稀疏表示的遮擋人臉表情識別方法[J].模式識別與人工智能,2014,27(8):708-712.

[15] WANG Sangfei,LIU Zhilei,Lyu Siliang,et al.A natural visible and infrared expression database for expression recognition and emotion inference[J].IEEE Transactions on Multimedia,2010,12(7):682-691.

[16] RABIEE H R.DML-SUT facial expression database[EB/OL]. [2011-03-10]. http://fedb.dml.ir.

[17] FROWD C D,MATUSZEWSKI B J,SHARK L K,et al.Towards a comprehensive 3D dynamic facial expression database[C]∥Proceedings of the 9th WSEAS International Conference on Multimedia, Internet & Video Technologies.Hungary:IEEE Press.2009:113-119.

[18] 薛麗麗,毛峽,張帆.BHU人臉表情數據庫的設計與實現[J].北京航空航天大學學報,2007,33(2):224-228.

[19] GAO Wen,CAO Bo,SHAN Shiguang,et al.The CAS-PEAL large-scale Chinese face database and base-line evaluations[J].IEEE Transactions on Systems,2008,38(1):149-161

[20] 胡敏,朱弘,王曉華,等.基于梯度Gabor直方圖特征的表情識別方法[J].計算機輔助設計與圖形學學報,2013,25(12):1856-1862.

[21] 蔣斌,賈克斌.局部判別分量分析算法[J].電子學報,2014,42(1):155-159.

[22] CARIDAKIS G,KARPUZIS K,KOLLIAS S.User and context adaptive neural networks for emotion recognition[J].Neurocomputing,2008,71(13/14/15):2553-2562.

[23] WANG Xiaokan,MAO Xia,Caleanu C D.Nonlinear shape texture manifold learning[J].IEICE Transactions on Information and Systems,2010,E93-D(7):2016-2019.

[24] ZHAO Hui,WANG Zhiliang,MEN Jihui.Facial complex expression recognition based on fuzzy kernel clustering and support vector machines[C]∥Proceedings of 3rd International Conference on Natural Computation.Haikou:Natural Computation,2007:562-566.

[25] LITTLEWORT G C,BARTLETT M S,LEE K.Faces of pain: Automated measurement of spontaneous facial expressions of genuine and posed pain[C]∥Proceedings of the 9th International Conference on Multimodal Interfaces.Haikou:ACM,2007:15-21.

[26] 張偉,黃煒,夏利民,等.基于SLPP與MKSVM的痛苦表情識別[J].計算機工程,2013,39(12):196-199.

(責任編輯: 陳志賢 英文審校: 吳逢鐵)

Develpment of Humanoid Facial Expression Robot

ZHANG Guoliang, WANG Zhangni, WANG Tian, WU Hao

(College of Computer Science and Technology, Huaqiao University, Xiamen 361021, China)

In this paper, the development status of this field has been investigated recently and the method of expression robot modeling has been explored for expression robot. Firstly the key technologies of expression robot are surveyed in detail, such as mechanism design, expression computation model, expression feature extraction and classification and so on. Furthermore, the research status and future development of facial expression robot are evaluated based on the survey analysis and four directions of future development are presented.

humanoid; expression robot; facial expression; facial action coding; psychology

1000-5013(2015)06-0626-06

10.11830/ISSN.1000-5013.2015.06.0626

2015-06-25

張國亮(1978-),男,講師,博士,主要從事機器人視覺伺服、機器人遙操作的研究.E-mail:zhangguoliang@hqu.edu.cn.

國家自然科學基金資助項目(61202299); 福建省自然科學基金資助項目(2013J050901); 華僑大學高層次人才科研啟動項目(11BS107)

TP 391.4

A