基于改進(jìn)卷積神經(jīng)網(wǎng)絡(luò)的人體檢測研究

左艷麗+馬志強(qiáng)+左憲禹

摘 要: 為了解決梯度方向直方圖在復(fù)雜背景下行人檢測性能不足的問題,引入深度學(xué)習(xí)算法進(jìn)行人體特征提取和行人檢測。為了減少卷積神經(jīng)網(wǎng)絡(luò)的訓(xùn)練樣本數(shù)量需求,在保證原數(shù)據(jù)庫背景分布和行人分辨率的基礎(chǔ)上使用基于內(nèi)容的圖像檢索方法進(jìn)行數(shù)據(jù)擴(kuò)充以便于訓(xùn)練。為了提高算法在復(fù)雜背景下的檢測效率,在卷積神經(jīng)網(wǎng)絡(luò)反射傳播權(quán)值更新時引入費舍爾約束準(zhǔn)則,使用誤差反向傳播算法獲取樣本類內(nèi)類間約束函數(shù)的權(quán)值,在考慮誤差的同時保證算法的分類精度。對INIRIA數(shù)據(jù)庫檢測結(jié)果表明,改進(jìn)后算法的漏檢率、檢測率等性能得到一定提高,在大多數(shù)復(fù)雜背景下可以成功檢測出行人。

關(guān)鍵詞: 行人檢測; 深度學(xué)習(xí); 卷積神經(jīng)網(wǎng)絡(luò); 復(fù)雜背景

中圖分類號: TN711?34; TP139 文獻(xiàn)標(biāo)識碼: A 文章編號: 1004?373X(2017)04?0012?04

Research on pedestrian detection based on improved convolutional neural network

ZUO Yanli1, MA Zhiqiang2, ZUO Xianyu1

(1. Computer and Information Engineering College, Henan University, Kaifeng 475000, China;

2. Department of Electronic Information Engineering, Henan Vocational College of Agriculture, Zhengzhou 451450, China)

Abstract: The deep learning algorithm was introduced to execute the human body feature extraction and pedestrian detection because of the low performance of pedestrian detection histogram of oriented gradient in the complex background. The content?based image retrieval method is used for data expansion to reduce the quantity demand of the training samples of convolutional neural network. The method is able to ensure the original database background distribution and pedestrian resolution. The Fisher criterion is imported when the reflection propagation weights of the convolutional neural network are updated in order to improve the detection efficiency of the algorithm. The back propagation algorithm is adopted to obtain the weight values of the inter?class constraint function in sample to ensure the classification accuracy while the errors exist. The test results on the INRIA database show that the omission rate and the detection rate of the improved algorithm have been improved, and can detect pedestrians in the most complex?backgrounds successfully.

Keywords: pedestrian detection; deep learning; convolutional neural network; complex background

行人檢測即在特定的視頻或者圖像中判斷是否存在人體,如果判斷有行人還需輸出人體位置,這是行為分析、步態(tài)分析、行人身份識別和行人跟蹤的前提和基礎(chǔ),在視頻監(jiān)控、車輛輔助駕駛、智能機(jī)器人等智能服務(wù)及安保行業(yè)有廣泛的應(yīng)用[1]。目前行人檢測經(jīng)過幾十年研究發(fā)展,檢測速度和精度都得到充分發(fā)展,但仍存在一定不足,包括實際環(huán)境中復(fù)雜背景[2]、強(qiáng)度不一的光照、人體間相互遮擋及環(huán)境遮擋、多樣化的姿態(tài)及取景[3]等因素都對行人檢測率和正確率造成較大影響,基于各種復(fù)雜環(huán)境的行人檢測方法不斷提出[4],尤其是基于梯度方向直方圖(Histogram of Oriented Gradient,HOG)特征的方法大大推動了行人檢測的發(fā)展[5]。但基于HOG方法的人體檢測方法由于HOG特征魯棒性不強(qiáng),在復(fù)雜背景情況下檢測效果不佳,漏檢率較高,因此魯棒性更佳的深度學(xué)習(xí)逐漸成為行人檢測的主流[6]。本文將深度學(xué)習(xí)理論應(yīng)用于行人檢測,在卷積神經(jīng)網(wǎng)絡(luò)反射傳播權(quán)值更新時引入費舍爾約束準(zhǔn)則,使用誤差反向傳播算法獲取樣本類內(nèi)類間約束函數(shù)的權(quán)值,在考慮誤差的同時保證算法的分類精度,同時結(jié)合基于內(nèi)容的圖像檢索數(shù)據(jù)擴(kuò)充方法,提高了算法的檢測性能。

1 常用方法

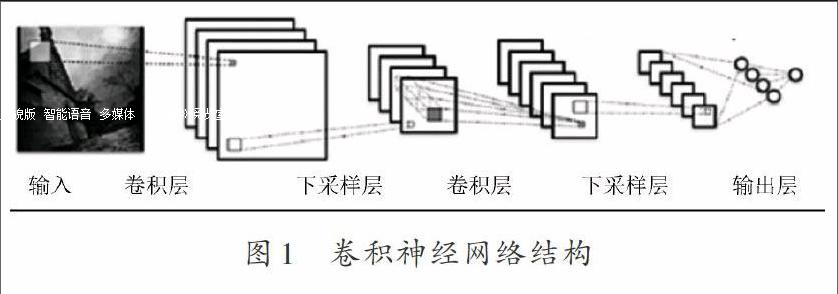

卷積神經(jīng)網(wǎng)絡(luò)是一種深度學(xué)習(xí)模型,可自動學(xué)習(xí)數(shù)據(jù)并提取特征,其結(jié)構(gòu)包含輸入層、卷積層、下采樣層和輸出層,構(gòu)成多層監(jiān)督學(xué)習(xí)網(wǎng)絡(luò),利用誤差反傳算法優(yōu)化網(wǎng)絡(luò)結(jié)構(gòu),解算未知參數(shù)[7]。卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)如圖1所示,在卷積層中各個特征圖神經(jīng)元與上層局部感受野相連,卷積操作后獲得局部特征,多個特征圖各自對應(yīng)不同權(quán)值,即卷積核,從而獲得不一樣的特征,經(jīng)不斷調(diào)整卷積核,特征逐漸有利于分類。

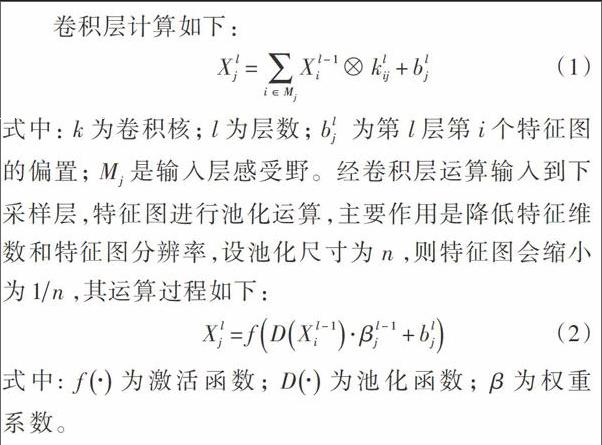

卷積層計算如下:

式中:為卷積核;為層數(shù); 為第層第個特征圖的偏置;是輸入層感受野。經(jīng)卷積層運算輸入到下采樣層,特征圖進(jìn)行池化運算,主要作用是降低特征維數(shù)和特征圖分辨率,設(shè)池化尺寸為,則特征圖會縮小為,其運算過程如下:

式中:為激活函數(shù);為池化函數(shù);為權(quán)重系數(shù)。

傳統(tǒng)的卷積神經(jīng)網(wǎng)絡(luò)并不適合行人檢測。經(jīng)研究發(fā)現(xiàn)設(shè)置合適的卷積核、層數(shù)和發(fā)類器輸入特征維數(shù)之后可較好地提取人體特征并完成行人檢測。但是,在復(fù)雜背景環(huán)境和遮擋存在的情況下,檢測性能仍然存在一定不足[8],因此借鑒費舍爾準(zhǔn)則改進(jìn)卷積神經(jīng)網(wǎng)絡(luò),提高算法在復(fù)雜背景環(huán)境下的檢測性能。

2 系統(tǒng)框架

2.1 圖像檢索擴(kuò)充

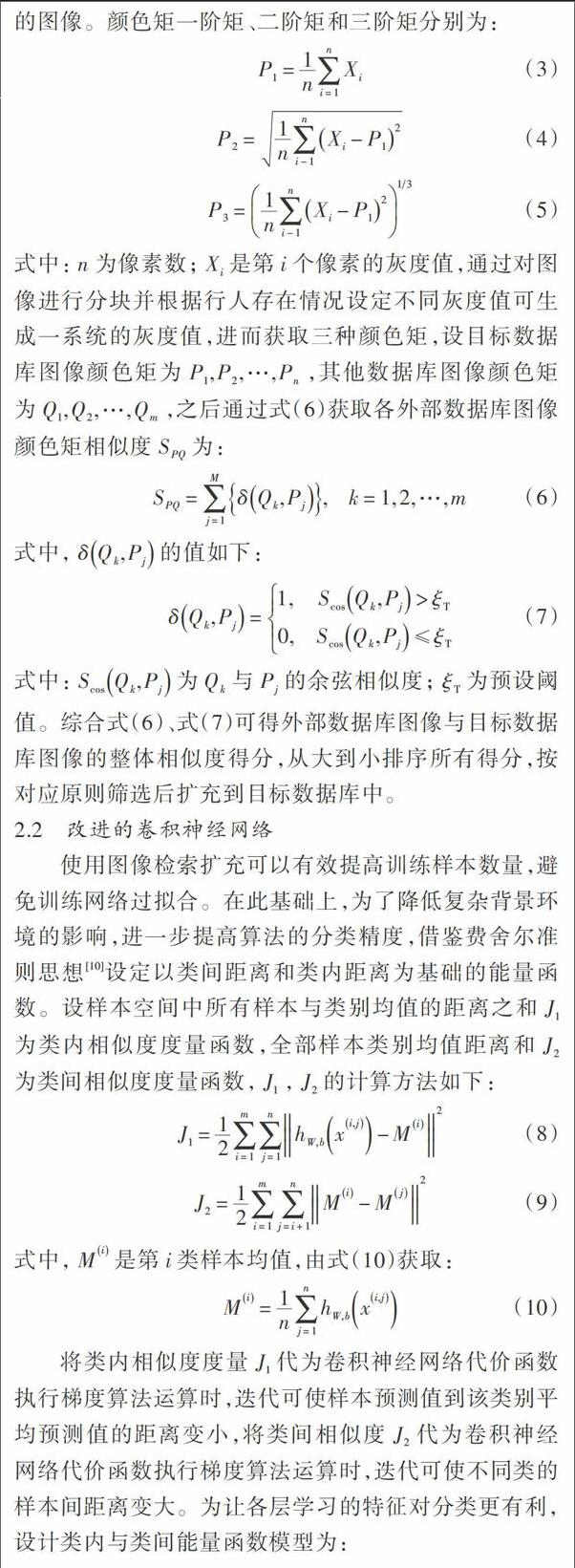

將深度學(xué)習(xí)應(yīng)用于行人檢測前,一般存在訓(xùn)練數(shù)據(jù)較少的情況。為了在較少訓(xùn)練樣本的情況下避免訓(xùn)練網(wǎng)絡(luò)過擬合,前期對目前常用的行人數(shù)據(jù)庫進(jìn)行分析發(fā)現(xiàn):ETH行人數(shù)據(jù)庫行人分辨率和圖像質(zhì)量都較高,但背景過于單一;Caltech行人數(shù)據(jù)庫由于采用車載攝像機(jī)拍攝的圖像,行人分辨率較低;而INRIA行人數(shù)據(jù)庫采用的是高清圖像,行人分辨率高,而且背景復(fù)雜多變[9]。綜上可知三種數(shù)據(jù)庫數(shù)據(jù)分布相似度低,差異較大,若將這些數(shù)據(jù)庫直接合并,訓(xùn)練的檢測效果容易受到影響。因此本文使用圖像檢索的方法實現(xiàn)數(shù)據(jù)擴(kuò)充,擴(kuò)充來源是包含行人的數(shù)據(jù)庫,通過行人長寬比和分辨率可以獲得高相似度行人,主要差異在于背景差別大,為此使用顏色矩搜尋其他數(shù)據(jù)庫中具有相似顏色特征的圖像。顏色矩一階矩、二階矩和三階矩分別為:

式中:為像素數(shù);是第個像素的灰度值,通過對圖像進(jìn)行分塊并根據(jù)行人存在情況設(shè)定不同灰度值可生成一系統(tǒng)的灰度值,進(jìn)而獲取三種顏色矩,設(shè)目標(biāo)數(shù)據(jù)庫圖像顏色矩為,其他數(shù)據(jù)庫圖像顏色矩為,之后通過式(6)獲取各外部數(shù)據(jù)庫圖像顏色矩相似度為:

式中:為與的余弦相似度;為預(yù)設(shè)閾值。綜合式(6)、式(7)可得外部數(shù)據(jù)庫圖像與目標(biāo)數(shù)據(jù)庫圖像的整體相似度得分,從大到小排序所有得分,按對應(yīng)原則篩選后擴(kuò)充到目標(biāo)數(shù)據(jù)庫中。

2.2 改進(jìn)的卷積神經(jīng)網(wǎng)絡(luò)

使用圖像檢索擴(kuò)充可以有效提高訓(xùn)練樣本數(shù)量,避免訓(xùn)練網(wǎng)絡(luò)過擬合。在此基礎(chǔ)上,為了降低復(fù)雜背景環(huán)境的影響,進(jìn)一步提高算法的分類精度,借鑒費舍爾準(zhǔn)則思想[10]設(shè)定以類間距離和類內(nèi)距離為基礎(chǔ)的能量函數(shù)。設(shè)樣本空間中所有樣本與類別均值的距離之和為類內(nèi)相似度度量函數(shù),全部樣本類別均值距離和為類間相似度度量函數(shù),,的計算方法如下:

式中,是第類樣本均值,由式(10)獲取:

將類內(nèi)相似度度量代為卷積神經(jīng)網(wǎng)絡(luò)代價函數(shù)執(zhí)行梯度算法運算時,迭代可使樣本預(yù)測值到該類別平均預(yù)測值的距離變小,將類間相似度代為卷積神經(jīng)網(wǎng)絡(luò)代價函數(shù)執(zhí)行梯度算法運算時,迭代可使不同類的樣本間距離變大。為讓各層學(xué)習(xí)的特征對分類更有利,設(shè)計類內(nèi)與類間能量函數(shù)模型為:

式中:是總體代價函數(shù);是卷積神經(jīng)網(wǎng)絡(luò)的代價函數(shù);分別是,的權(quán)值,通過實驗確定,一般對于不同的網(wǎng)絡(luò)結(jié)構(gòu)和數(shù)據(jù)庫其值略有不同,其取值范圍區(qū)間為。通過式(11),在考慮誤差的同時增大類間間距并減小類內(nèi)間距。權(quán)值調(diào)整時向更便于分類的t方向調(diào)整,可在較少的迭代次數(shù)情況下實現(xiàn)分類的目標(biāo)。本文使用誤差反向傳播(Error Back Propagation,BP)算法更新權(quán)值,關(guān)鍵點是獲取輸出單元殘差,各子函數(shù)分別解算輸出單元殘差。對于,,各單元輸出層殘差計算公式分別為:

通過式(12)、式(13)獲得最后一層輸出的單元殘差后,代入BP算法迭代后可生成全部權(quán)值。

3 系統(tǒng)實現(xiàn)與實驗驗證

3.1 系統(tǒng)實現(xiàn)

算法流程如圖2所示,將INRIA數(shù)據(jù)庫作為訓(xùn)練集和測試集,共有902張圖片,其中288張為測試集,614張為訓(xùn)練集,選擇ETH數(shù)據(jù)庫和Caltech數(shù)據(jù)庫作為訓(xùn)練集擴(kuò)充庫,選擇擴(kuò)充庫中分辨率不小于2 000且寬高比為的行人圖像,按式(3)~式(5)計算圖像的顏色矩,再利用式(6)計算顏色矩相似度,將擴(kuò)充庫圖像顏色矩相似度值進(jìn)行從大到小排序,篩選前30%的圖像擴(kuò)充到訓(xùn)練集中,最后得到的數(shù)據(jù)庫共2 385張,其中2 097張為訓(xùn)練集,288張為測試集。在改進(jìn)的卷積神經(jīng)網(wǎng)絡(luò)中引入費舍爾準(zhǔn)則思想加入類內(nèi)類間約束的能量函數(shù)模型,使用BP算法更新卷積神經(jīng)網(wǎng)絡(luò)代價函數(shù)的權(quán)值以提高算法的分類性能。

3.2 實驗驗證

為了驗證本文算法性能使用Matlab進(jìn)行實驗驗證。對于數(shù)據(jù)庫圖像,將其設(shè)定為大小的窗口,并從RGB模型轉(zhuǎn)換為HSV模型,將HSV模型的三個通道縮小為的尺寸。卷積神經(jīng)網(wǎng)絡(luò)第一個卷積層有64個濾波器,輸入圖像的各相鄰塊作為單個元素輸入濾波器,輸出64個大小為的特征圖,其后在下采樣層壓縮得到64個大小為的特征圖,其后的卷積層和下采樣層處理過程類似。根據(jù)前期實驗結(jié)果設(shè)定類內(nèi)相似度度量和類間相似度的權(quán)值為。分類器選擇支持向量機(jī)。

首先比較擴(kuò)充數(shù)據(jù)庫前后改進(jìn)的卷積神經(jīng)網(wǎng)絡(luò)算法的檢測性能,實驗結(jié)果如圖3所示。可以看出,經(jīng)過圖像檢索擴(kuò)充,改進(jìn)的卷積神經(jīng)網(wǎng)絡(luò)算法誤檢率在0.1時,漏檢率從0.51降低到0.44,說明了圖像檢索擴(kuò)充方法可以有效降低算法的漏檢率,提高檢測效率。

在使用圖像檢索擴(kuò)充的基礎(chǔ)上,使用傳統(tǒng)卷積神經(jīng)網(wǎng)絡(luò)和改進(jìn)的卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行行人檢測,檢測率和檢測速度如表1所示。

從表1中可以看出,改進(jìn)的卷積神經(jīng)網(wǎng)絡(luò)檢測算法速度比傳統(tǒng)的卷積神經(jīng)網(wǎng)絡(luò)算法有所降低,但檢測率和虛警率性能都有所提升,其中檢測率提升了2.6%,證明了本文算法的優(yōu)越性。圖4為使用本文算法對INRIA測試集中部分復(fù)雜背景圖像的檢測結(jié)果,大部分復(fù)雜背景和遮擋情況下都可以準(zhǔn)確檢測出圖像中的行人,但圖4中,第9圖、第10圖中卻有行人沒有成功檢測,主要是由于這些行人分辨率較低,算法難以從復(fù)雜背景中區(qū)分出來。

4 結(jié) 語

本文針對梯度方向直方圖行人檢測方法在復(fù)雜背景下性能不高的問題,引入深度學(xué)習(xí)方法進(jìn)行人體特征提取和行人檢測。使用基于內(nèi)容的圖像檢索方法進(jìn)行數(shù)據(jù)擴(kuò)充并在卷積神經(jīng)網(wǎng)絡(luò)反射傳播權(quán)值更新時引入費舍爾約束準(zhǔn)則以保證算法的分類精度。實驗結(jié)果表明,本文算法在檢測率、虛警率和漏檢率等方面都有一定提升,可以從大多數(shù)復(fù)雜背景下檢測出行人,但當(dāng)行人分辨率較低的情況難以從復(fù)雜背景中分辨出來,這將是下一步重點解決的問題。

參考文獻(xiàn)

[1] YE Q, LIANG J, JIAO J. Pedestrian detection in video images via error correcting output code classification of manifold subclasses [J]. IEEE transactions on intelligent transportation systems, 2012, 13(1): 193?202.

[2] 芮挺,費建超,周遊,等.基于深度卷積神經(jīng)網(wǎng)絡(luò)的行人檢測[J].計算機(jī)工程與應(yīng)用,2016,52(13):162?166.

[3] MUNDER S, GAVRILAD M. An experimental study on pedestrian classification [J]. IEEE transactions on pattern analysis and machine computer vision, 2006, 28(11): 1863?1868.

[4] 雷慶,陳鍛生,李紹滋.復(fù)雜場景下的人體行為識別研究新進(jìn)展[J].計算機(jī)科學(xué),2014,41(12):1?7.

[5] 孫宏國,李天然,蒲寶明,等.復(fù)雜背景下人體檢測算法[J].計算機(jī)系統(tǒng)應(yīng)用,2013,22(4):134?137.

[6] 張陽.結(jié)合紋理特征和深度學(xué)習(xí)的行人檢測算法[J].遼寧工程技術(shù)大學(xué)學(xué)報,2016,35(2):206?210.

[7] CAO Xianbin, WANG Zhong, YAN Pingkun, et al. Transfer learning for pedestrian detection [J]. Neurocomputing, 2013, 100(1): 51?57.

[8] 曾敏,周益龍.基于深度學(xué)習(xí)模型的行人檢測研究與仿真[J].南京郵電大學(xué)學(xué)報(自然科學(xué)版),2015,35(6):111?116.

[9] 王斌.基于深度學(xué)習(xí)的行人檢測[D].北京:北京交通大學(xué),2015.

[10] WONG W K, SUN Mingming. Deep learning regularized Fisher mapping [J]. IEEE transactions on neural networks, 2011, 22(10): 1668?1675.