基于HMM和SVM級聯算法的駕駛意圖識別?

劉志強,吳雪剛,倪 捷,張 騰

前言

隨著我國道路運輸行業的快速發展和機動車保有量的急劇增長,交通安全事故頻發導致財產損失和人員傷亡給人們的生產生活帶來了嚴重影響[1]。先進的駕駛員輔助系統能夠顯著提高駕駛員行車安全性,然而這些系統有些未考慮對駕駛員行為意圖和特性的辨識以實現輔助系統對駕駛員的自適應和駕駛員個性化駕駛[2],導致輔助系統的激活與駕駛員意圖相悖,給駕駛員造成心理壓力,降低了駕駛員對輔助系統的認同感。因此,在駕駛員輔助系統進一步開發中開展駕駛員意圖識別研究具有實際應用價值。

研究表明,駕駛員的駕駛意圖是一個多維結構,單一的特征指標并不能滿足駕駛意圖的判斷[3]。國內外針對駕駛員駕駛意圖識別研究中其參數的選擇絕大部分是基于單獨的自車運動狀態或車-路系統建立單一學習模型[4-6]。部分研究人員建立了多學習模型辨識駕駛意圖,但此類研究也僅考慮在車道保持和車道變換階段駕駛員的生理或心理參數的變化[7-9]。實際的駕駛過程是一個由人-車-路組成的復雜的交通系統[10-11],單一的識別模型導致駕駛意圖誤警率高。

隱馬爾可夫算法能夠分析時間序列的動態信號,根據相鄰狀態間的關系完成模式識別,更大程度反映類別間的相似性而類別的差異性則被忽略。支持向量機算法通過將低維空間線性不可分的樣本映射至高維空間中,以盡可能大的歐氏距離將相似的樣本分隔開,更大程度地反映了類別間的差異性。據此,本文中提出了一種基于HMM和SVM級聯算法考慮人-車-路特征參數的駕駛員意圖識別方法,將隱馬爾可夫動態建模能力和支持向量機模式分類能力結合,同時發揮兩種分類器的優勢,提高整個雙層算法對駕駛意圖的識別能力。

1 實驗方案

1.1 實驗平臺

考慮到在模擬駕駛儀中開展仿真實驗,可根據實驗要求隨意修改車輛和道路環境的參數配置,準確采集車輛多種動態參數的同時不擔心因操作不當而引發危險事故,有效降低實驗采集過程中駕駛員的心理負擔。選用6自由度SCANER II駕駛模擬器和Smart-eyes眼動儀作為主要實驗設備,如圖 1所示。

圖1 模擬駕駛儀與眼動儀系統

1.2 實驗場景設計

按照實驗要求,在駕駛模擬器視景系統中設計雙向六車道,車道寬3.5m,總長度約90km的高速公路場景。同時,為使行車環境與實際過程一致,在道路上設置適宜車流量。其中主要設置兩類輔助車輛,當自車行駛至與所設置的輔助車輛距離500m時,輔助車輛被自動激活。第一類輔助車輛平均車速設置為60km/h,車速變化遵循方差為20km/h的高斯分布;第二類輔助車輛的平均車速為90km/h,其車速變化遵循方差為30km/h的高斯分布。

1.3 實驗人員

以自愿方式招募8男4女共12名駕駛員作為受試對象。受試者滿足以下條件:持有駕駛證、視力良好、性格穩定、無不良駕駛記錄。為便于實驗有序開展和有效提高后期樣本篩選的效率,實驗配備1名記錄員,其主要工作是觀察駕駛員的狀態,并記錄駕駛員不同任務下的操作時刻。

1.4 實驗過程

本文中規定,處于駕駛模擬器環境中的駕駛員主要有 4類駕駛意圖:車道跟馳(CF),左變道(LCL),右變道(LCR)和超車(OT)。實驗中,駕駛模擬器主控機相應的模塊會同步采集車輛縱向加速度、轉向盤轉角、車輛與車道線距離、制動踏板行程、加速踏板行程等運行狀態參數,同時采用Smart-eyes眼動儀系統追蹤駕駛員的眼睛和頭部運動。

2 樣本篩選

若能提早1s察覺到事故危險并采取相應正確措施,很多交通事故都可以避免[12]。圖2為某次換道過程的車輛運行軌跡,其中p點為車輛行駛軌跡和車道線交點,以往的多數研究通常對p點前某時窗內信息進行研究,希望在車輛越過車道線1s前就能辨識出換道意圖,考慮到國內外的研究較為普遍地將時間窗口取為3s左右[13],故選取p點前1s外時間窗口T內的信息作為研究對象,即截取q點前3s內的特征量數據,同樣隨機截取3s內車道保持階段的特征量數據。

結合研究需求共篩選了1 150組樣本,其中CF樣本285組,LCR樣本285組,LCL樣本290組和OT樣本290組。為提高模型的分類準確率和確保有效檢驗效果,用于模型訓練和模型驗證的樣本大致按照2∶1的原則分配。

3 駕駛意圖特征參數選取

對篩選樣本中所涉及的參數數據進行對比分析,排除部分差異性較小的參數。經獨立樣本T檢驗(顯著性差異α=0.05)后,結合指標參量選擇時應遵循易量化、全面性和相互獨立性的原則確定駕駛員特征參數。

3.1 駕駛員參數

視覺掃描是駕駛員搜索外界信息的主要途徑,在駕駛過程中駕駛員獲取的道路環境信息有90%以上來自視覺[14]。

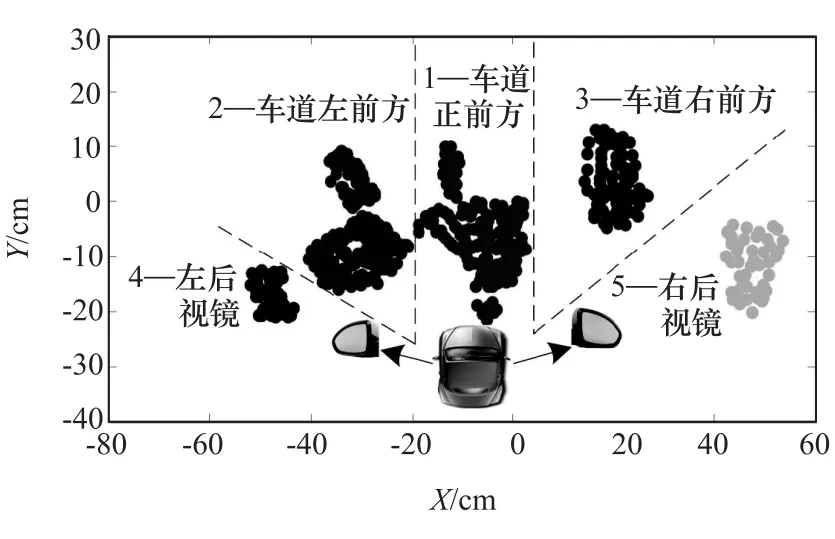

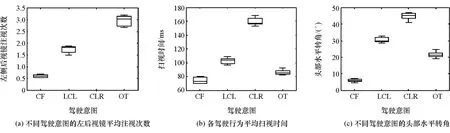

對Smart-eyes眼動儀系統采集的多次全過程駕駛中駕駛員視線點區域進行K-means聚類劃分,見圖3,而后在確定各區域范圍的基礎上統計篩選駕駛員面對不同任務時的典型視覺特征變化規律,見圖4,其中圖4(a)中當駕駛員處于右變道(LCR)意圖時,可認為對左側后視鏡注視次數為零。

圖3 駕駛員興趣區域劃分結果

圖4 不同駕駛意圖下駕駛員視覺參數箱型圖

3.2 車-路參數

行駛過程中,模擬駕駛器CAN系統可讀取出車輛各類典型的運行參數信息。縱向加速度反映駕駛員對后續車速的預期值。轉向盤轉角作為實現變道意圖的直接輸入,駕駛員在各意圖階段均需不斷調整轉向盤以保證車輛安全行駛。車輛與車道中心線距離作為自車相對于車道的位置變化,反映了駕駛員對車輛橫向位置的掌控能力,上述“車-路”參數能較好表征駕駛員的駕駛意圖,變化規律統計見圖5。

圖5 不同駕駛意圖下“車-路”參數箱型圖

結合圖4和圖5中參數差異性的分析,最終確定以左后視鏡平均注視次數、單次平均掃視時間、單次平均頭部水平轉角、轉向盤轉角、縱向加速度和自車與車道中心線距離共6個參數作為意圖識別算法指標量。

4 HMM和SVM級聯算法識別駕駛意圖基本方法

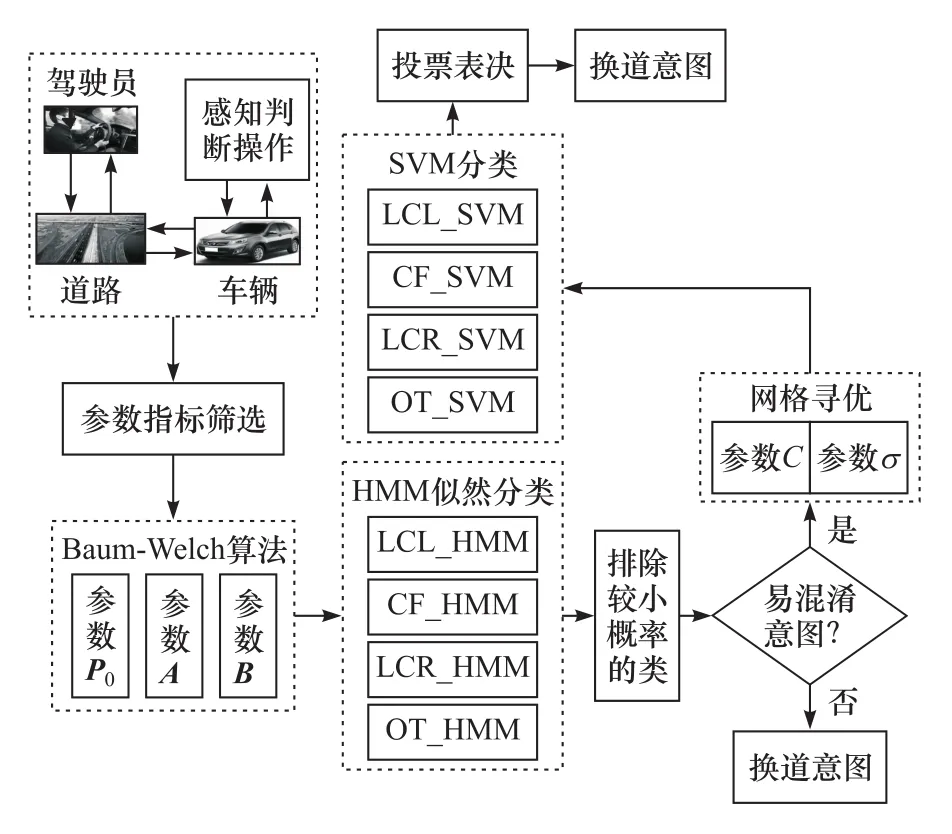

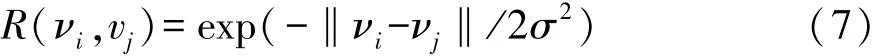

傳統上HMM算法的輸出完全作為SVM的輸入建立HMM-SVM混合模型開展模式識別的分類負擔較大,計算時間較長且并未充分發揮二者的優勢,本文中所建立改進的HMM和SVM級聯算法如圖6所示。將待辨識駕駛意圖對應的指標參數樣本導入第一層HMM中確定其能識別的意圖。將第一層HMM中識別率較低的易混淆的意圖作為與待辨識意圖較為相似的類別,形成候選集,再由第二層SVM在候選模式中對待辨識意圖作最后決策,以期達到提高駕駛員駕駛意圖識別率的目的。

圖6 HMM和SVM級聯算法識別駕駛意圖流程

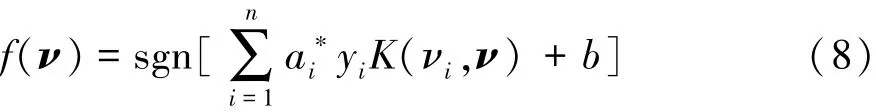

4.1 隱馬爾可夫算法(HMM)

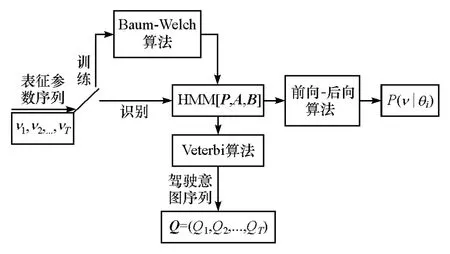

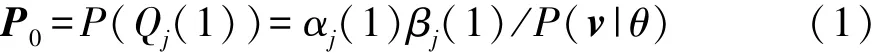

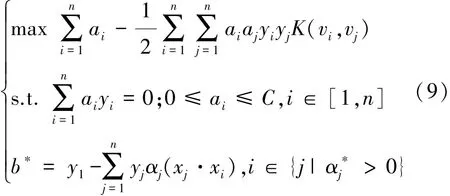

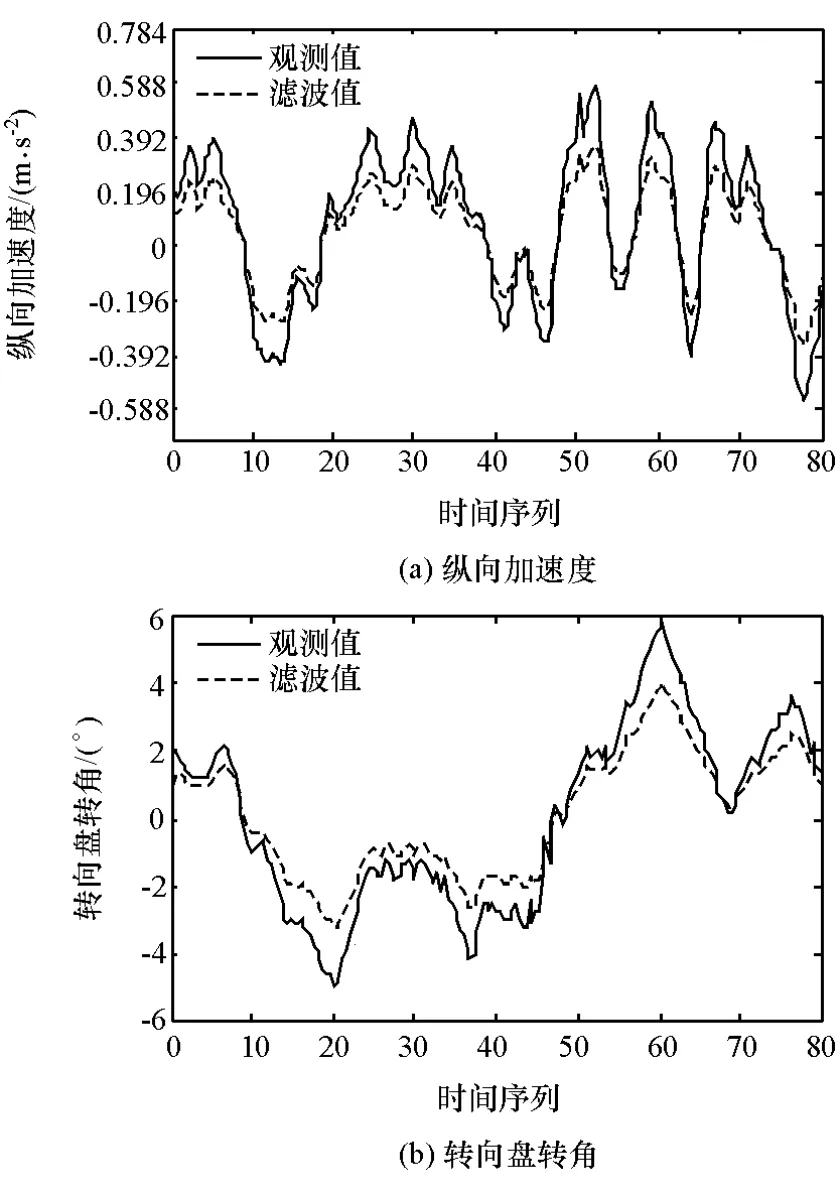

隱馬爾可夫模型作為一個雙隨機過程,由兩部分組成:馬爾可夫鏈和一般隨機過程。前者采用轉移概率描述狀態的轉移,后者采用觀察值概率描述狀態和觀察序列間的關系[15]。一個HMM模型可以用θ=[P0,A,B]來描述,將其用于駕駛意圖識別,關鍵問題是解決HMM模型的訓練和識別問題。

Q=(Q1,Q2,Q3,Q4)表示 4 種隱藏的駕駛意圖;ν=(ν1,ν2,ν3,ν4,ν5,ν6)表示可觀察的駕駛行為序列;A=[aij]表示從意圖Qi到意圖Qj的轉移矩陣;B=[Bjk]表示從意圖 Qj產生駕駛行為νk的產生矩陣。

圖7為基于隱馬爾可夫模型的駕駛意圖辨識原理,采用前向-后向算法對給定訓練數據后獲得的隱馬爾可夫模型參數進行優化。由于初始概率條件P0和駕駛意圖轉移矩陣A的初始值的選擇對系統的影響不大,對比實驗效果后,確定采用4狀態6高斯過程HMM模型。假定均勻選取初始狀態概率P0和A的初值,采用K-means聚類求解B的初始值。

圖7 基于HMM算法的意圖識別基本原理

前向-后向算法獲得HMM參數 θ的重估公式為

在產生換道行為序列ν條件下,從駕駛行為Qi(t-1)轉移到Qj(t)的概率γij為

式中l為長為T的駕駛意圖序列的標記。根據新舊隱馬爾可夫模型參數間的函數關系反復迭代計算aij和bjk,至其收斂為止。最終獲得駕駛行為產生矩陣B=[bjk]。

駕駛意圖識別時,采用viterbi算法求出模型參數θi對輸出駕駛行為序列ν的輸出概率P(ν|θi),然后選擇所有模型中的輸出概率最大的作為未知意圖的識別結果,即

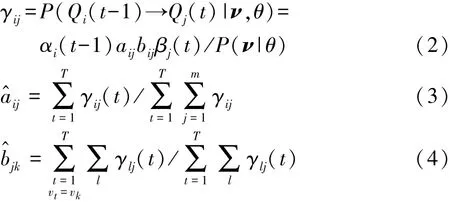

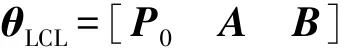

4.2 支持向量機(SVM)

SVM作為一種基于結構風險最小化原則的學習理論,通過在高維空間尋找一個超平面作為兩類的分隔,以保證最小的分類錯誤率[16],以解決小樣本、非線性和二分類的模式識別問題。用SVM實現駕駛意圖分類,首先要將原始空間中線性不可分駕駛意圖參數通過式(7)的 RBF函數映射到高維空間:

將求解最優分類面轉化為求解駕駛意圖的最優決策函數:

通過式(9)獲得a?i和 b。

將第一層HMM算法中n種易混淆駕駛意圖兩兩組合,構建C2n個分類器。使用各易混淆駕駛意圖對應的訓練集數據訓練SVM分類模型。SVM通過將低維空間中線性不可分的易混淆的駕駛意圖樣本映射到可分的高維空間中,最大程度地表現各易混淆意圖間的差異性。

5 模型訓練與仿真分析

5.1 樣本降噪預處理

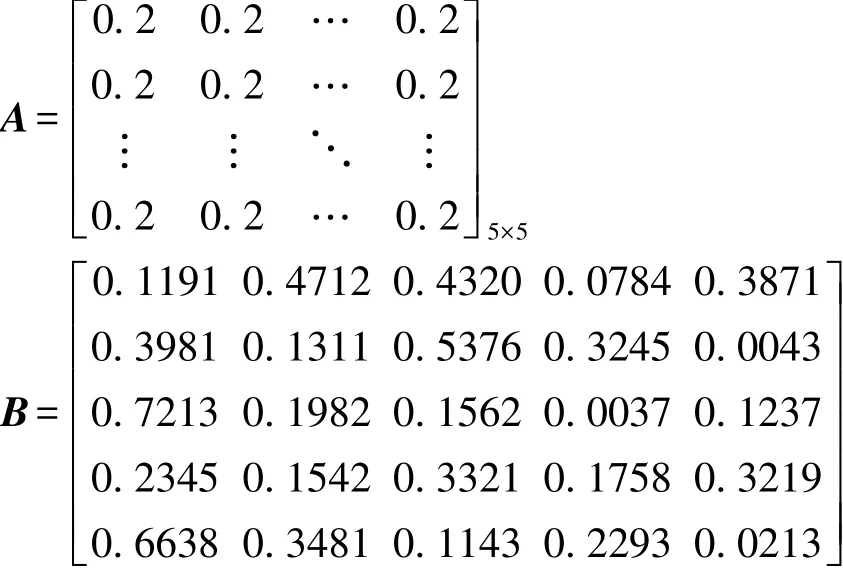

考慮到由于噪聲和傳感器自身性能的影響,會導致部分車載傳感器實驗數據的關聯性降低,為保證駕駛意圖模型識別精度,須對所采集的數據進行卡爾曼濾波處理[17]。縱向加速度和轉向盤轉角濾波處理如圖8所示。

5.2 HMM模型訓練結果

選擇將數據篩選后的765組駕駛意圖導入第一層HMM模型中進行參數θ的優化。利用4.1節中所述HMM模型的前向-后向算法,獲得左變道意圖HMM的描述參數θLCL:

其中P0=[0.2 0.2 0.2 0.2 0.2]T

進而,可依此方法求解其余3類駕駛意圖HMM的模型參數。

圖8 車載傳感器參數的濾波處理

5.3 HMM仿真分析

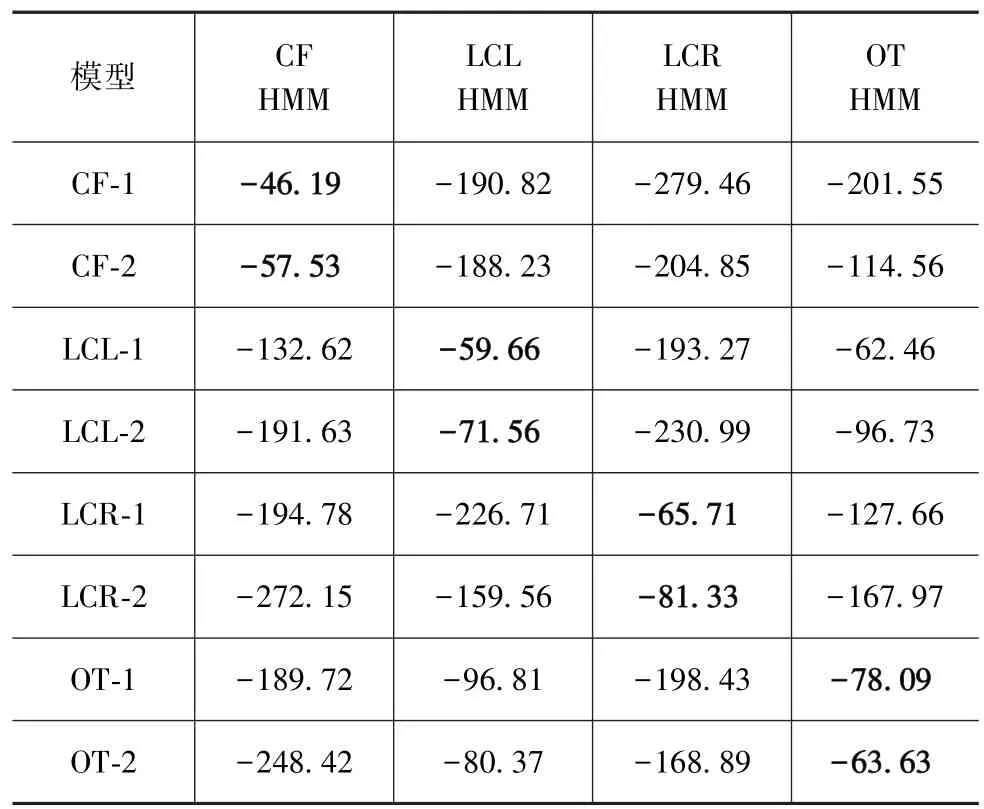

將部分樣本導入第一層HMM算法,似然估計值越大,表明觀察序列與該模型的匹配程度越高,最大似然估計值所對應的模型便是利用HMM分類模型得出的當前駕駛員駕駛意圖,表1中加粗的數值即為識別結果。

表1 各駕駛行為樣本HMM識別結果

基于HMM模型對剩余的750組駕駛意圖檢驗樣本的識別結果如表2所示。

從表2中可以看出,基于第一層HMM算法的LCL和OT兩種駕駛意圖的識別率較低,在進一步的研究中可將其作為易混淆意圖導入第二層SVM進行意圖分類。

表2 檢驗樣本的HMM識別結果

5.4 SVM模型訓練與仿真分析

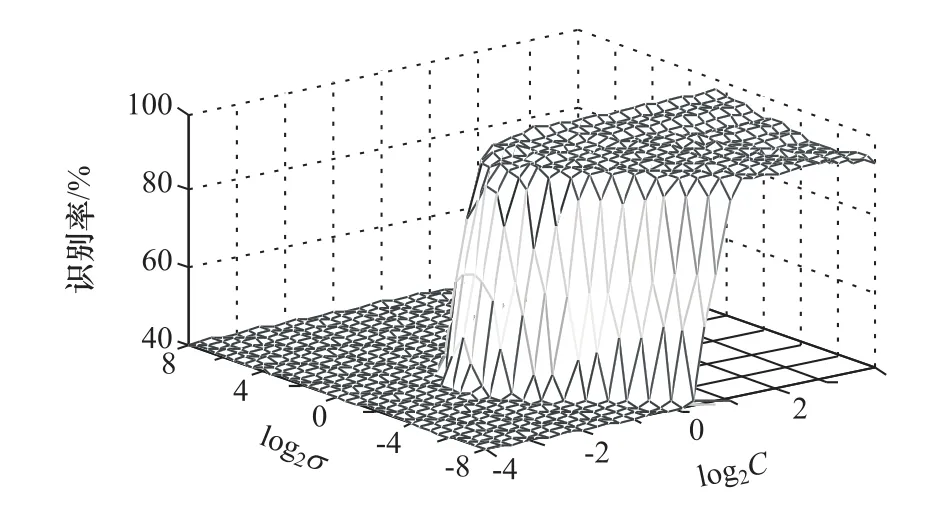

將左換道意圖和超車意圖對應的387組訓練樣本導入第二層SVM算法中,結果如圖9所示。采用網格尋優算法獲得最優參數C=1.14和σ=1.07,對應最佳參數的SVM模型識別準確率為96.58%。

圖9 基于SVM辨識混淆意圖的參數尋優結果

將超車意圖和左換道意圖對應的193組驗證樣本導入訓練的SVM模型進行意圖識別。易混淆意圖識別結果如表3所示。

表3 易混淆駕駛意圖SVM識別結果

基于HMM和SVM級聯算法的駕駛意圖的平均識別率達95.84%,明顯高于HMM或SVM單一學習模型。需要指出的是,對于非易混淆意圖,均直接利用第一層HMM算法完成識別,因此HMM和HMMSVM級聯模型對CF和LCR兩種意圖的識別率相差不大,卻能減輕第二層SVM的分類負擔。

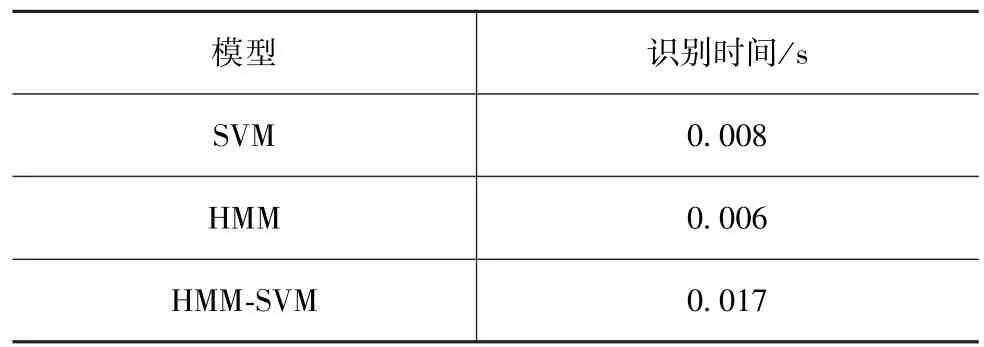

5.5 仿真時間估算

通過在算法的開頭和結尾分別設置tic和toc函數完成單個駕駛意圖識別的仿真時間計算,結果如表4所示。

表4 各種辨識模型識別時間

一般情況下,駕駛員處理突發事件的反應時間為0.2~0.4s[18]。本文中所提出的HMM和SVM級聯算法明顯能夠滿足要求。

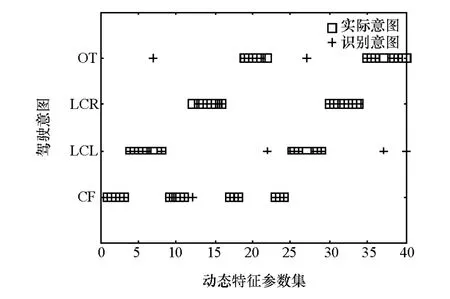

5.6 駕駛意圖在線識別

基于本文中所建立的級聯算法進行駕駛意圖的在線識別,識別結果見圖10。

圖10 基于HMM和SVM級聯算法在線識別意圖

本文中所提出的HMM和SVM級聯算法識別駕駛意圖,綜合了HMM算法和SVM的優勢,彌補了HMM中只能根據最大似然估計作為輸出,當幾種意圖的最大似然估計值相近時造成意圖識別錯誤率高的缺點。通過HMM排除能夠識別的意圖,將易混淆意圖對應的駕駛樣本導入SVM,依據識別準確率設置投票表決算法完成意圖分類。

6 結論

(1)確定了“人-車-路”交通系統中可作為駕駛意圖識別指標共6個參數,彌補了目前國內外針對駕駛意圖簡單采取車-路系統參數的不足的同時擴展了待識別意圖種類。

(2)基于所提出的HMM和SVM級聯算法識別駕駛意圖的平均準確率達95.84%,較HMM或SVM單一模型高,單次意圖識別時間為0.017s,滿足駕駛員處理突發事件的反應時間要求。