虛擬化環(huán)境中的內(nèi)存資源動態(tài)管理技術(shù)研究

謝慧

摘 ? 要:數(shù)據(jù)信息量的爆炸式上升促使存儲設(shè)備的容量愈來愈大,如何高效地開展存儲管理成為飽受重視的問題。與此同時,監(jiān)管疏忽的問題也愈發(fā)明顯,數(shù)據(jù)資源的爆炸性增加與監(jiān)管能力的相對缺乏間的沖突越發(fā)尖銳。在廣域網(wǎng)區(qū)域內(nèi),一方面大量存儲資源長久空置或者被低效能使用,而另一方面也有大量用戶的儲存需求不能獲得滿足,進而存儲虛擬化技術(shù)應(yīng)然而生。存儲虛擬化技術(shù)有著存儲資源使用率高、可以屏蔽物理裝置異構(gòu)性、內(nèi)存資源監(jiān)管靈巧等優(yōu)勢,提供大容量、高效能動態(tài)管理系統(tǒng)。

關(guān)鍵詞:儲存虛擬化 ?內(nèi)存 ?動態(tài)管理

中圖分類號:TP3 ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ?文獻標識碼:A ? ? ? ? ? ? ? ? ? ? ? ?文章編號:1674-098X(2019)08(c)-0124-02

1 ?研究背景

于現(xiàn)代信息中心,虛擬化技術(shù)與資源監(jiān)管、客戶端整合、提升資源使用率等領(lǐng)域展現(xiàn)了極大的作用,現(xiàn)已成為云計算框架中的重要技術(shù)支撐。在虛擬的環(huán)境中,若要確保高資源使用率與系統(tǒng)效能,就必須有一個高效能的內(nèi)存資源的管理技術(shù),從而使得虛擬機的物理內(nèi)存能夠適應(yīng)程序?qū)τ趦?nèi)存需求的不斷變化。同時,數(shù)據(jù)資源的快速上升還對于儲存系統(tǒng)的穩(wěn)定性與擴展性提出了考驗,大量信息與計算能力的分布,迫切需要在儲存虛擬機當(dāng)中提供內(nèi)存資源動態(tài)監(jiān)管技術(shù)。所以,如何在信息中心內(nèi)開展內(nèi)存資源的靈活調(diào)整,就成為一個決定性的問題。

2 ?研究內(nèi)容

2.1 內(nèi)存動態(tài)調(diào)配

依據(jù)內(nèi)存工作設(shè)置的預(yù)判結(jié)果,我們可以在單獨的主機內(nèi)進行及時的虛擬機內(nèi)存分派,接著更進一步使用遠程緩存系統(tǒng)與虛擬機在線遷移系統(tǒng)把本地內(nèi)存調(diào)配拓展到信息中心,以此提升總體系統(tǒng)的內(nèi)存使用率。

2.2 基于遠程緩存的多機內(nèi)存資源調(diào)配

現(xiàn)代信息中心的服務(wù)器均是千兆以太網(wǎng)甚至于更加快的網(wǎng)絡(luò)介質(zhì)聯(lián)網(wǎng),但是磁盤訪問的延遲要比網(wǎng)絡(luò)傳輸?shù)难舆t高很多,因此這為我們提供了一個緩解虛擬機頁面抖動的方法,即遠程硬盤緩存。

2.3 全局內(nèi)存管理

我們研發(fā)了一個全局內(nèi)存管理器來調(diào)解信息中心的各個服務(wù)器的存儲器需求及供應(yīng),每臺主機上的內(nèi)存預(yù)測器可以實時感知本地的存儲器需求。全局調(diào)配器會定時詢查每一個主機,一旦詢查到某個主機出現(xiàn)內(nèi)存負載過大,便會尋找另外一臺有充足空余內(nèi)存的服務(wù)器用作遷移目標機器從而引起遷移,進而使信息中心的內(nèi)存資源獲得最大化的采用。

3 ?虛擬機動態(tài)管理系統(tǒng)的設(shè)計與實現(xiàn)

為提高信息中心的效能,降低云計算服務(wù)商的實際成本,必須對云數(shù)據(jù)中心虛擬機展開監(jiān)控,因此,建開源云計算平臺OpenStack并且融合此前提請的虛擬機監(jiān)控機制,研發(fā)、搭建并對云計算數(shù)據(jù)中心展開VDMCloud監(jiān)控系統(tǒng)部署。

3.1 VDMCloud的設(shè)計與實現(xiàn)

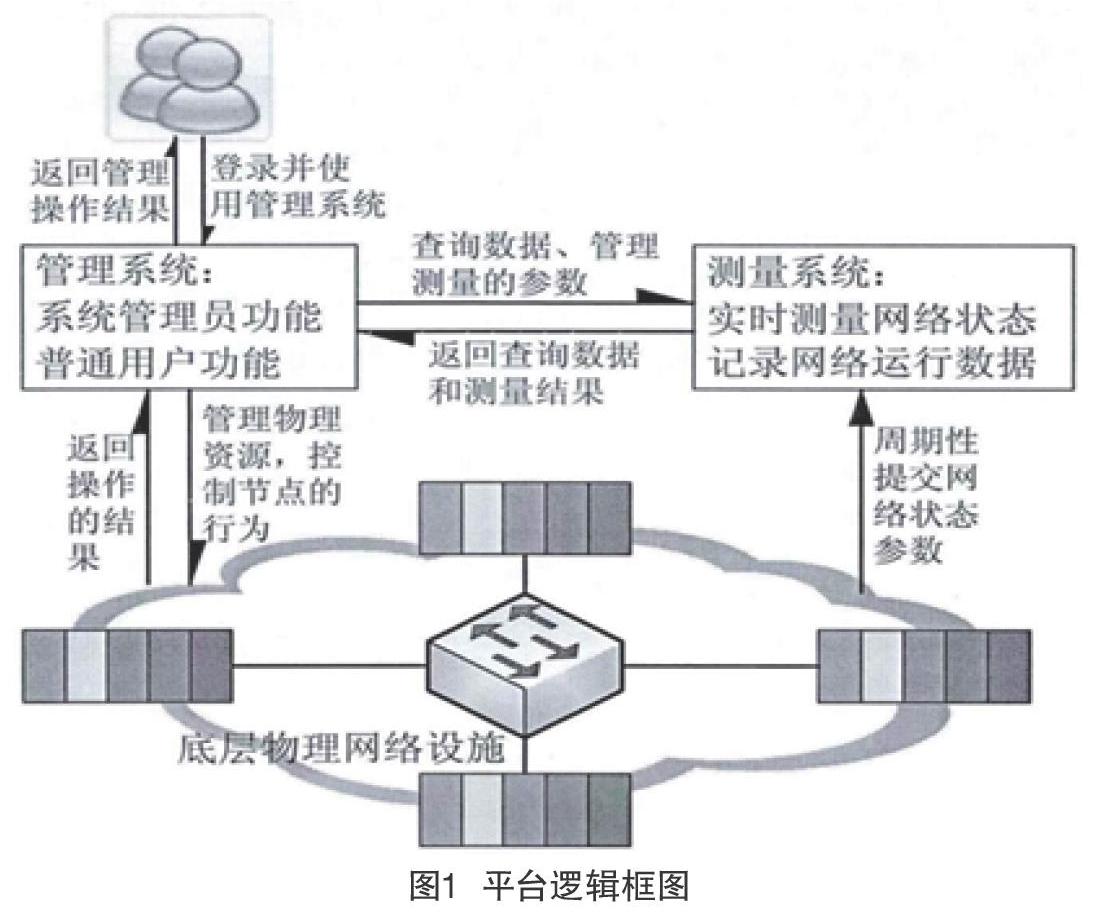

虛擬機動態(tài)監(jiān)管系統(tǒng)VDMCloud的整體框架和各組件間邏輯關(guān)系如下圖所示。VDMCloud主要涵蓋界面展現(xiàn),資源監(jiān)測,引發(fā)遷移,虛擬機選取,存放路徑選取,遷移操控等主要組件。

3.2 界面展示模塊

VDMCloud的用戶界面是一個根據(jù)JavaWeb的界面,它是使用者認識虛擬機動態(tài)監(jiān)管系統(tǒng)運轉(zhuǎn)狀況的接口。透過該視覺化界面,使用者可以便捷的獲取云信息中心運算結(jié)點資源使用訊息與SLA違反次數(shù)、電力消耗、平均資源使用率以及資源平穩(wěn)信息;使用者也能夠透過該界面獲取運算結(jié)點上運轉(zhuǎn)的虛擬機的資源選用數(shù)據(jù)。

3.3 資源監(jiān)控模塊

服務(wù)器引發(fā)遷移最初應(yīng)展開主機狀況檢驗,因此VDMCloud需設(shè)置資源監(jiān)控組件。本組建負責(zé)獲得運算結(jié)點服務(wù)器以及虛擬機存儲信息、CPU以及網(wǎng)絡(luò)資源利用信息。運行在OpenStack平臺當(dāng)中每個運算結(jié)點,與此同時對于運算結(jié)點和運轉(zhuǎn)在該服務(wù)器上的虛擬機進行監(jiān)視。

3.4 虛擬機選擇模塊

觸發(fā)遷移組件決策服務(wù)器引發(fā)遷移之后,需要由虛擬機選取組件從運行在該運算結(jié)點上的虛擬機中選取要遷移的虛擬機,并且向全局監(jiān)管系統(tǒng)發(fā)布遷移要求。虛擬機選擇組件透過資源監(jiān)視系統(tǒng)獲得的虛擬機使用數(shù)據(jù)記錄,通過虛擬機選擇機制獲取到需遷移的虛擬機。

4 ?技術(shù)設(shè)計框架

平臺的邏輯框圖如圖1所示。下層物理網(wǎng)絡(luò)設(shè)施是整個研究平臺的內(nèi)核所在,它以一系列的虛擬結(jié)點為主體設(shè)備,通過交換機相互連接組建而成,為提高整體利用效率,通過對資源分配流程進行整體改進,讓高速交換機連接所有的軟硬件虛擬路由器,這樣便使虛擬節(jié)點相互間形成了一條物理鏈路。

5 ?結(jié)語

高效率的虛擬化信息中心需要高效的資源管理策略,本研究基于內(nèi)存資源管控,并重點研究了通過內(nèi)存資源動態(tài)管控解決數(shù)據(jù)中心內(nèi)存資源利用效率低的問題。理想的內(nèi)存資源調(diào)節(jié)必須使虛擬機的可用物理存儲器可以符合應(yīng)用程序動態(tài)的存儲器需求,所以,率先必需一個準確的在線內(nèi)存預(yù)測器。結(jié)合之前的工作,我們實行了一系列的改進舉措,于不阻礙預(yù)測器精確度的前提下盡量減少了系統(tǒng)開支。我們通過硬件計數(shù)器來進行WSS監(jiān)控,另外也提升了LRU鏈表的信息架構(gòu),從而形成了一個精準的內(nèi)存需求預(yù)測系統(tǒng)。并且把系統(tǒng)開支掌控于非常少的區(qū)域內(nèi)。除此之外,依據(jù)內(nèi)存負荷的時限長度,我們研發(fā)了兩種多機內(nèi)存資源調(diào)整策略:遠程內(nèi)存方針與虛擬機遷移策略。

首先根據(jù)先期預(yù)測對遠程內(nèi)存策略進行了分析,在此策略下所有的物理機邏輯通通對等,具有充足內(nèi)存的服務(wù)器充當(dāng)內(nèi)存服務(wù)器,并且隨著存儲活動的變化來動態(tài)修改角色。一旦出現(xiàn)內(nèi)存負載變,便會立即展開遠程內(nèi)存策略。用戶機通過互聯(lián)網(wǎng)采用遠程內(nèi)存服務(wù)器的內(nèi)存減輕內(nèi)存壓力。

其次,對于如何確認全局內(nèi)存分配策略展開了討論。于目前的運用情節(jié)當(dāng)中,我們絕不能預(yù)測需求持續(xù)時間,一旦虛擬機資源欠缺時,便啟動遠程存儲器。但遠程存儲器的效能仍然難以和本地內(nèi)存相比,若內(nèi)存持續(xù)負荷,則應(yīng)啟用虛擬機遷移,并且這兩個流程的目標服務(wù)器應(yīng)盡可能確保相似,透過重用遠程存儲器的成效來縮減遷移時限。但遠程內(nèi)存開啟的時限則是我們研究的重點,找到一個恰當(dāng)?shù)拈撝担軌蛴谳^大水平上提高系統(tǒng)的內(nèi)存效能。

參考文獻

[1] 王柳峰.基于虛擬化的云計算平臺內(nèi)存資源協(xié)同共享技術(shù)研究[D].國防科學(xué)技術(shù)大學(xué),2015.

[2] 劉文志.網(wǎng)絡(luò)虛擬化環(huán)境下資源管理關(guān)鍵技術(shù)研究[D].北京郵電大學(xué),2012.

[3] 盧建平.虛擬化系統(tǒng)中處理器資源管理和控制技術(shù)研究[D].解放軍信息工程大學(xué),2018.

[4] 徐辰光.云計算平臺資源分配的動態(tài)管理技術(shù)研究[D].南京郵電大學(xué),2014.

[5] 王宋君.基于虛擬化技術(shù)的服務(wù)器資源管理系統(tǒng)的設(shè)計與實現(xiàn)[D].中南大學(xué),2015.

[6] 李俊濤.云計算數(shù)據(jù)中心虛擬機資源分配策略的研究[D].杭州電子科技大學(xué),2015.

[7] 袁曉潔.虛擬用戶環(huán)境中資源動態(tài)管理機制研究[D].華中科技大學(xué),2017.