算法推薦新聞的技術(shù)創(chuàng)新與倫理困境:一個綜述

王仕勇

摘 要:“算法主導(dǎo)下信息傳播的社會影響與挑戰(zhàn)”成為2018年度“中國十大學(xué)術(shù)熱點”,算法推薦新聞也是學(xué)界關(guān)注的重要話題。大數(shù)據(jù)時代,新聞分發(fā)正在進(jìn)行變革,對于算法推薦新聞的模式及其實踐,從一開始就伴隨是好是壞的爭論。一方面認(rèn)為,算法推薦新聞實現(xiàn)了信息超載時代用戶需求信息的精準(zhǔn)推薦,凸顯了受眾的主動地位;提高了內(nèi)容分發(fā)效率,實現(xiàn)了對信息和人的精準(zhǔn)與高效匹配,有利于增強用戶黏性;為社會民意搭建了一個前所未有的社會基礎(chǔ)平臺。另一方面認(rèn)為,算法推薦導(dǎo)致隱私侵犯、算法偏見和算法歧視;導(dǎo)致新聞娛樂化、低俗化與同質(zhì)性;導(dǎo)致信息繭房和群體極化;導(dǎo)致價值觀分化與社群區(qū)隔,不利于社會整合。對于算法推薦新聞,要深入思考數(shù)據(jù)的所有權(quán)和信息的選擇權(quán)、對什么負(fù)責(zé)與對誰負(fù)責(zé)、工具理性和價值理性等幾個問題,秉持寬容審慎和科學(xué)的態(tài)度進(jìn)行研究。

關(guān)鍵詞:算法推薦;新聞分發(fā);人工智能;倫理;技術(shù)

基金項目:重慶市教育委員會人文社會科學(xué)研究重點項目“政府社會輿情治理視角的網(wǎng)絡(luò)質(zhì)疑現(xiàn)象研究”(18SKGH060);重慶市社會科學(xué)規(guī)劃重大委托項目“強化互聯(lián)網(wǎng)思維推進(jìn)政府社會治理精準(zhǔn)化對策研究”(2016ZDWT25)。

[中圖分類號] G210 [文章編號] 1673-0186(2019)09-0123-010

[文獻(xiàn)標(biāo)識碼] A? ? ? [DOI編碼] 10.19631/j.cnki.css.2019.09.012

人工智能是影響未來新聞業(yè)發(fā)展趨勢的重要技術(shù)。智能算法進(jìn)入新聞生產(chǎn)和新聞分發(fā)環(huán)節(jié),正在對新聞業(yè)和新聞學(xué)研究產(chǎn)生革命性的影響。人工智能在新聞業(yè)界實踐的速度和影響出乎人們的意料,“算法主導(dǎo)下信息傳播的社會影響與挑戰(zhàn)”成為2018年度“中國十大學(xué)術(shù)熱點”。人工智能與新聞分發(fā)結(jié)合產(chǎn)生的算法推薦新聞,引起了其“是‘好東西’、‘壞東西’、還是有待驗證的‘新東西’”[1]的討論。

大數(shù)據(jù)是人工智能的基礎(chǔ)。大數(shù)據(jù)在改變身份概念的含義,同時也在改變我們與這個概念的所指之間的倫理關(guān)系[2]。基于大數(shù)據(jù)技術(shù)和神經(jīng)網(wǎng)絡(luò)算法的算法推薦新聞,改變了編輯、記者、用戶等身份概念,也改變了媒體和用戶的倫理關(guān)系。

一、大數(shù)據(jù)時代的新聞分發(fā)變革

美國學(xué)者比爾·科瓦奇(Bill Kovach)和湯姆·羅森斯蒂爾(Tom Rosenstiel)在《真相:信息超載時代如何知道該相信什么》一書中提出,我們處在一個用戶主導(dǎo)的新媒體時代,“我們會比以往獲得更多信息,同時也更容易困惑;我們會更容易看見真相,同時真相也更難獲得”,這是我們面臨的信息超載的現(xiàn)實。在過剩的信息海洋里,閱讀由享受變?yōu)樨?fù)擔(dān)。大數(shù)據(jù)為解決信息超載的困惑找到了一把科學(xué)的鑰匙,實現(xiàn)了信息的精準(zhǔn)獲取。

(一)信息過載與算法推薦新聞的出現(xiàn)

在報紙、電視等傳媒主導(dǎo)內(nèi)容傳播的時代,內(nèi)容行業(yè)的競爭多屬于業(yè)內(nèi)競爭,其內(nèi)容分發(fā)是一種點對面的方式,傳媒從業(yè)者幾乎承擔(dān)著全部傳播責(zé)任。隨著互聯(lián)網(wǎng)進(jìn)入人們的日常生活,內(nèi)容傳播的時間和空間概念均發(fā)生了變化。從空間上講,理論上每一個連接互聯(lián)網(wǎng)的用戶都可以接收到分發(fā)的信息,但內(nèi)容分發(fā)范圍的變化仍然沒有從根本上改變傳播的主體,只不過是網(wǎng)站、論壇、視頻網(wǎng)站等和報社、電視臺等內(nèi)容生產(chǎn)的專業(yè)機(jī)構(gòu)一道實現(xiàn)內(nèi)容分發(fā)。

隨著社交媒體、新聞客戶端等的出現(xiàn)與發(fā)展,我們進(jìn)入了一個信息過載的時代。國外研究機(jī)構(gòu)的數(shù)據(jù)顯示,互聯(lián)網(wǎng)每天生產(chǎn)的內(nèi)容可以刻滿1.68億張DVD;社區(qū)論壇發(fā)布的帖子接近《時代》雜志770年的文字量;在Facebook上有1.72億人登錄,上傳2.5億張圖片,如打印出來相當(dāng)于80座埃菲爾鐵塔的高度;在YouTube上傳86.4萬小時視頻,如果不間斷全部播完要98年……來源于互聯(lián)網(wǎng)交易、移動終端、各種網(wǎng)絡(luò)設(shè)備和傳感器、社交媒體等的數(shù)字?jǐn)?shù)據(jù),海量內(nèi)容,已經(jīng)遠(yuǎn)遠(yuǎn)超過所能接受、處理或有效利用信息的范圍,用戶對信息反應(yīng)的速度也遠(yuǎn)遠(yuǎn)低于信息傳播的速度。強大的內(nèi)容生產(chǎn)能力,要求傳統(tǒng)的內(nèi)容分發(fā)必須變革,以解決用戶對有用信息的分辨及選擇能力不足的問題。于是,出現(xiàn)了以微信為代表的個性化“訂閱分發(fā)”方式,以知乎為代表的“社群分發(fā)”方式,以今日頭條為代表的“算法分發(fā)”方式等。

算法推薦新聞作為新聞分發(fā)的一種方式,是基于內(nèi)容資源、大數(shù)據(jù)技術(shù)和用戶三者統(tǒng)一的一種信息精準(zhǔn)分發(fā),屬于用戶新聞的“私人訂制”。它的出現(xiàn)與挖掘海量數(shù)據(jù)的大數(shù)據(jù)技術(shù)分不開。大數(shù)據(jù)技術(shù)把文字、圖片、音頻、視頻等海量信息數(shù)據(jù)化;把不同類型媒體上的同類數(shù)據(jù)整合;借由標(biāo)準(zhǔn)的標(biāo)記體系和收集記錄的工具,實現(xiàn)地理信息的標(biāo)準(zhǔn)化和量化;把能體現(xiàn)個性化特征的人與人之間的網(wǎng)絡(luò)信息溝通與交流行為數(shù)據(jù)化;把現(xiàn)實社會與虛擬社會聯(lián)系起來并實現(xiàn)意義交換。算法推薦新聞,可以說是一個“業(yè)務(wù)數(shù)據(jù)化—數(shù)據(jù)業(yè)務(wù)化”的閉環(huán)反饋過程[3]。

(二)算法推薦新聞模式

算法推薦新聞的基本邏輯是通過大數(shù)據(jù)技術(shù),從互聯(lián)網(wǎng)上采集新聞內(nèi)容信息、用戶個人網(wǎng)絡(luò)行為及社交關(guān)系等,根據(jù)“信息與人”的匹配原則向用戶推送符合其興趣偏好的特定信息。關(guān)于算法推薦新聞的模式,學(xué)界根據(jù)業(yè)界的實踐進(jìn)行了分析。

目前,算法推薦在新聞中的應(yīng)用還處于初級階段。周勇、趙璇認(rèn)為,算法新聞的本質(zhì)是努力實現(xiàn)“信息與人”的匹配[4]。目前的內(nèi)容分發(fā)根據(jù)算法使用程度,可分為三類:一是與內(nèi)容生產(chǎn)方合作,根據(jù)用戶信息推薦內(nèi)容并由用戶發(fā)現(xiàn)和選擇訂閱的“人工推薦為主”模式;二是通過記錄用戶搜索信息推薦新聞的“人工+算法”模式;三是基于用戶行為數(shù)據(jù)和社交媒體數(shù)據(jù),運用機(jī)器學(xué)習(xí)推薦新聞的“完全算法”模式。

劉存地、徐煒根據(jù)算法推薦原理把推薦算法分為五類:一是協(xié)同過濾推薦算法,包括根據(jù)相似用戶預(yù)測相似偏好的基于用戶(User-Based)的協(xié)同過濾、根據(jù)用戶對信息的評價及信息之間的相似度進(jìn)行推薦的基于項目 (Item-based)的協(xié)同過濾;二是基于內(nèi)容的推薦算法,包括憑借經(jīng)驗與實際情況擬合度的啟發(fā)式算法,以用戶瀏覽行為為基礎(chǔ)通過機(jī)器學(xué)習(xí)的預(yù)測模型法;三是基于關(guān)聯(lián)規(guī)則憑借大數(shù)據(jù)相關(guān)性發(fā)現(xiàn)能力以實現(xiàn)預(yù)測用戶需求的推薦算法;四是結(jié)合用戶偏好變化和滿足程度的基于效用的推薦算法;五是以用戶資料中能夠支持推理的知識結(jié)構(gòu)為基礎(chǔ)進(jìn)行預(yù)測的基于知識的推薦算法[5]。

彭蘭從新聞分發(fā)渠道的角度,提出把新聞分發(fā)平臺沉淀為一個連接用戶社交關(guān)系、物和環(huán)境的用戶平臺是未來趨勢[6]。她把互聯(lián)網(wǎng)進(jìn)入大眾傳播領(lǐng)域以來新聞分發(fā)平臺劃分為六大類:以“多源聚合 + 人工分發(fā)”為特征的整合類平臺,以“多源搜索 + 算法調(diào)度”為特征的搜索引擎平臺,以“人際網(wǎng)絡(luò) + 大眾傳播”為特征的社會化媒體平臺,以“個性分析 + 算法匹配”為特征的個性化推薦平臺,以“臨場體驗 + 社交傳播”為特征的視頻和 VR /AR 平臺,以“生活場景 + 新聞推送”為特征的服務(wù)類平臺。并認(rèn)為,未來新聞分發(fā)平臺將以集聚維護(hù)用戶、匯聚多元化內(nèi)容生產(chǎn)者、匹配內(nèi)容生產(chǎn)與消費、營造多重新聞體驗環(huán)境、關(guān)聯(lián)內(nèi)容與其他互聯(lián)網(wǎng)服務(wù)為實現(xiàn)目標(biāo)。

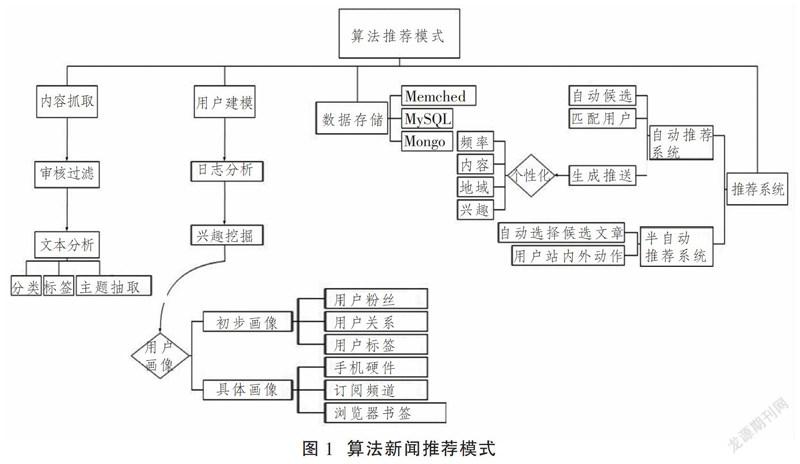

為了進(jìn)一步了解算法新聞推薦的模式,我們根據(jù)今日頭條的核心架構(gòu)分析,制作出推薦模式圖(圖1)[7]。

由此可見,對內(nèi)容的分類和標(biāo)簽化、對用戶日志的分析和用戶興趣的挖掘?qū)W習(xí)、對用戶的社交畫像是算法推薦新聞的基礎(chǔ)。

二、“好東西”:算法推薦新聞的技術(shù)創(chuàng)新

對于算法推薦新聞的模式及其實踐,從一開始就伴隨是好是壞的爭論。算法推薦新聞,其基石是大數(shù)據(jù)技術(shù)。這就意味著爭論的根本是對科技價值的評判。價值是反映客體滿足主體需要的關(guān)系范疇,如果能滿足個體需要我們說有個人價值,如果能符合社會整體利益并促進(jìn)社會進(jìn)步我們說有社會價值。關(guān)于科技價值觀,西方有樂觀主義和悲觀主義兩種思潮。馬克思主義肯定科技的巨大社會作用,對科技帶來的社會后果總體上也持積極樂觀的態(tài)度,認(rèn)為“科技是推動社會進(jìn)步的革命力量”。在當(dāng)前的研究中,肯定算法推薦新聞的個人價值和社會價值的觀點,主要集中在以下幾個方面。

從個人價值來講,算法推薦新聞實現(xiàn)了信息超載時代用戶需求信息的精準(zhǔn)推薦,凸顯了受眾的主動地位。當(dāng)前算法推薦內(nèi)容在我國資訊信息分發(fā)市場占比已經(jīng)超過一半,這是一種主動選擇的結(jié)果。算法推薦新聞是信息技術(shù)在傳播領(lǐng)域的創(chuàng)新型運用,是新聞分發(fā)的巨大變革,它根據(jù)用戶畫像、用戶社交關(guān)系、關(guān)聯(lián)內(nèi)容、地理位置等信息消費行為,挖掘用戶的媒介消費興趣、習(xí)慣及特點,并對用戶未來的媒介消費內(nèi)容進(jìn)行預(yù)測,繼而為用戶推薦“量身定制”的新聞產(chǎn)品,實現(xiàn)精準(zhǔn)推送和有效供給,最大程度滿足了用戶的個性化信息需求[8]。“意義建構(gòu)理論”提出者布倫達(dá)·德爾文(Brenda Dervin)提出,個體的信息行為過程是對信息主動搜索、主動發(fā)現(xiàn),并主動建構(gòu)信息意義的過程。算法推薦新聞改變了傳統(tǒng)的信息行為模式,它通過對用戶媒介消費興趣和社交圖譜的建構(gòu),實現(xiàn)對用戶需求內(nèi)容的個性化精準(zhǔn)化推薦[9]。傳統(tǒng)分發(fā)模式,受眾始終無法擺脫“木偶”這一角色,算法推薦新聞對用戶賦能和賦權(quán),賦予用戶主體身份[10],這樣既節(jié)省了用戶的時間成本,又提高了信息的閱讀效率,還把用戶的主動地位凸顯出來。

從媒介需要來講,算法推薦新聞提高了內(nèi)容分發(fā)效率,實現(xiàn)了對信息和人的精準(zhǔn)與高效匹配,有利于增強用戶黏性,為高效實現(xiàn)內(nèi)容產(chǎn)品的商業(yè)變現(xiàn)提供了技術(shù)支持。從傳統(tǒng)媒體時代到互聯(lián)網(wǎng)時代,新聞分發(fā)變革是媒介技術(shù)發(fā)展的必然要求。算法推薦新聞以智能推薦工具替代傳統(tǒng)物流分發(fā)流程,實現(xiàn)自動化發(fā)行與營銷[11],有利于增強用戶與新聞產(chǎn)品之間的黏性,提升新聞價值,提高用戶興趣和參與意識,擴(kuò)大用戶影響和范圍。

從社會價值來講,算法推薦新聞實現(xiàn)了為社會民意搭建一個前所未有的社會基礎(chǔ)平臺。算法推薦新聞通過“模型泛化”挖掘和洞察與用戶相似的社群特征和需求,然后針對性發(fā)送,由于其“對流量的分配獨立于社交關(guān)系而不受 ‘大號’壟斷的影響”[12],可以有效解決社交過濾存在的不足。同時,由于算法可以自我學(xué)習(xí)自我訓(xùn)練,人們“可通過大數(shù)據(jù)將個體的訴求隨時隨地表達(dá)、記錄及價值挖掘,并且對這些數(shù)據(jù)進(jìn)行連接、分析,算法實現(xiàn)了為社會民意搭建一個前所未有的社會基礎(chǔ)平臺” [10]。

三、“壞東西”:算法推薦新聞的倫理困境

企鵝智酷發(fā)布的《未來地圖:中國新媒體趨勢報告(2017)》顯示,在2017年,算法推薦新聞首次在用戶感知上面已經(jīng)超過新聞和社交推薦。51.5%的被調(diào)查者最看重新聞資訊中的新聞推送功能,新聞推送功能躍升新聞產(chǎn)品功能第一位[13]。今天,智能推薦算法在信息分發(fā)市場中的運用占比越來越高,其地位已呈現(xiàn)出超越人工推薦的趨勢。溫特、良太小野(Jenifer Winter,Ryota Ono)在《未來互聯(lián)網(wǎng)》一書中提出,按照技術(shù)樂觀主義的觀點,人工智能在未來幾十年內(nèi)將超過人類大腦,能夠無限度地使人類與機(jī)器并存和融合[14]。但人們在擁抱算法這一趨勢的同時,也體現(xiàn)出了很多擔(dān)憂。這種擔(dān)憂更多的是對其帶來的倫理問題的擔(dān)憂。

(一)隱私侵犯、算法偏見和算法歧視

信息技術(shù)與個人隱私共存正在變得越來越模糊。隨著公共和私人信息之間界限不斷移動,關(guān)于如何劃分信息密級的辯論也越來越激烈。侵犯隱私是算法推薦新聞被質(zhì)疑的一個熱點問題。專家認(rèn)為,個別 App在協(xié)同過濾的算法推薦過程中,會竊取用戶的手機(jī)通信錄、短信等信息,導(dǎo)致用戶行為數(shù)據(jù)和隱私泄露等安全風(fēng)險增大[8]。有學(xué)者提出,“對于信息的細(xì)化過程都不是道德中立的”,即使算法程序是中立的,但數(shù)據(jù)本身是帶有偏向性的,在這種機(jī)制中存在的偏見令人更加難以察覺[15]。同時,掌握數(shù)據(jù)的技術(shù)平臺基于商業(yè)利益的考量,他們在用戶無意識狀態(tài)下收集、獲取和使用用戶信息,把用戶在平臺上的數(shù)字痕跡可能以某種無法知曉的方式銷售給廣告客戶,從而侵犯用戶個人隱私。

與隱私侵犯相關(guān)聯(lián)的擔(dān)憂還有“算法偏見”(algorithmic bias)和“算法歧視”(algorithm discrimination)。國外社會學(xué)專家認(rèn)為,算法推薦根據(jù)自己的運算規(guī)則為每個用戶預(yù)設(shè)了一個身份,給每個個體劃定了邊界,算法不斷增加的復(fù)雜性可能使底層永遠(yuǎn)成為底層,導(dǎo)致算法偏見[16]。弗里德曼(Friedman)和尼森鮑姆(Nissenbaum)研究發(fā)現(xiàn),計算系統(tǒng)(主要指機(jī)器學(xué)習(xí))存在偏見,由人編寫的算法必然包含著人自身的偏見。算法推薦不但不能阻止技術(shù)偏見,還會在看似中立的算法規(guī)則中,由于數(shù)據(jù)源、版權(quán)、監(jiān)管等問題和設(shè)計者的主觀因素產(chǎn)生新的偏見[15]。關(guān)于算法歧視,學(xué)界多次提到美國弗格森案件,由于存在種族歧視,F(xiàn)acebook采用機(jī)器算法和利用人們對社交媒體的依賴,干預(yù)用戶觀看有關(guān)弗格森槍擊案的信息,向用戶推薦與此案不相關(guān)的內(nèi)容。

(二)娛樂化、低俗化與同質(zhì)性

算法推薦的一個重要指標(biāo)是資訊內(nèi)容的點擊量,其目標(biāo)是獲取更多用戶的注意力。在信息超載時代,移動化、碎片化、淺表化是用戶閱讀的基本特征。為了滿足用戶接受輕松省力信息的需求,在算法推薦中會特意推薦那些聳人聽聞的標(biāo)題、離奇夸張的故事情節(jié)和低俗淺表的內(nèi)容吸引受眾,用戶點擊越多,算法推薦的權(quán)重越大,造成惡性循環(huán),這樣使得娛樂化、低俗化的信息湮沒了理性、深度、高質(zhì)量的信息[8]。

與娛樂化、低俗化相伴隨的必然是同質(zhì)性。由于把迎合用戶需求、追求最大點擊量作為算法推薦最重要的目標(biāo),因此,算法推薦以所謂的“中立性”“技術(shù)主導(dǎo)”,將含有“腥”“星”“性”等低俗化、娛樂化因子的信息以公式算法和系數(shù)加權(quán)的方式,實現(xiàn)了“標(biāo)準(zhǔn)化”“同一化”推送,導(dǎo)致新聞娛樂化。李彪、喻國明稱之為“繭房內(nèi)的同質(zhì)性”。算法新聞的個性化推薦,不僅強化了信息傳播的閉環(huán),而且使標(biāo)題黨、低俗甚至是別有用心的議題輕松便捷找到其用戶,從而消解傳統(tǒng)媒體堅守的情懷與專業(yè)主義[9]。今天,“奶頭樂”新聞、公共議題泛娛樂、自媒體新聞世俗化等傳播亂象,使得淺薄化、娛樂化以及“三俗”的資訊內(nèi)容充斥網(wǎng)絡(luò),新聞生態(tài)逐漸污濁,算法推薦無視人類行為背后的認(rèn)知、情感和意識,以“形式合理性掩蓋了實質(zhì)合理性”,人們甚至開始懷疑真正的新聞是否正在死去。

(三)信息繭房和群體極化

娛樂化、低俗化導(dǎo)致的“繭房內(nèi)的同質(zhì)性”是信息繭房的一種表現(xiàn)。針對算法推薦新聞,學(xué)者非常關(guān)注由于信息消費的窄化、固化導(dǎo)致的“信息繭房”效應(yīng),以及由于用戶長期接受同質(zhì)化信息導(dǎo)致的群體意見極化現(xiàn)象。

多數(shù)研究算法推薦新聞局限性的論文,都會使用到“信息繭房”這一概念。由于算法推薦新聞是根據(jù)個人偏好定向推送的,這很容易導(dǎo)致用戶接觸不到自由市場中開放多元的意見,也很難與代表不同價值觀念、取向的意見和觀點進(jìn)行交流交鋒,長此以往用戶會沉浸于自己的“舒適地帶”之中,沉浸在自主選擇的“滿足感”里,逐漸把自己封閉和隔離起來,脫離本來豐富多彩、文化多元的大千世界,產(chǎn)生自我重復(fù)、自我固化的“孤島效應(yīng)”,形成信息繭房[17]。這正如《人民日報》評論所言,“技術(shù)為用戶量身打造信息,開啟了符合讀者口味的一扇窗,卻關(guān)上了多元化的一道道門”[18]。

千人千面的個性化算法技術(shù)推薦模式,除了使人的視野變得狹窄,還會塑造人的認(rèn)知,使人的認(rèn)知出現(xiàn)局限性,導(dǎo)致態(tài)度和觀點的極化[19]。姜紅、魯曼認(rèn)為,算法推薦新聞為用戶營造的“過濾氣泡”式的閱讀環(huán)境,既建構(gòu)了用戶對社會的想象,又通過新聞信息的傳遞潛移默化地影響用戶的情感和態(tài)度。克雷默( Kramer) 等三名學(xué)者通過對 689 003人的實驗證實, Facebook 消息推送可顯著影響人們的情感和態(tài)度[20]。布赫( Bucher) 的研究也發(fā)現(xiàn),算法機(jī)制通過對用戶的閱讀行為和社會網(wǎng)絡(luò)的分析,不斷向用戶發(fā)送信息,并記錄下用戶閱讀信息的情緒,有相似新聞出現(xiàn)就會連續(xù)不斷地發(fā)送類似信息,不斷刺激用戶的神經(jīng),影響和規(guī)制著用戶[21]。關(guān)于這一點,桑斯坦(Cass R.Sunstein)也認(rèn)為:“如果互聯(lián)網(wǎng)上的人們主要是同自己志趣相投的人進(jìn)行討論,他們的觀點就會僅僅得到加強,因而朝著更為極端的方向轉(zhuǎn)移。”[22]這些被繭化的用戶因信息的不斷感染,很容易把信息暗示的觀念變成自身的行動傾向,產(chǎn)生極化行為。如果是被相同的情緒極化的,如仇官仇富的被繭化用戶,可能會因為與某些污名化官員或富人的信息長期接觸,強化仇官仇富情緒,形成群體極化。

(四)價值觀分化與社群區(qū)隔

社群區(qū)隔與價值觀分化是與信息繭房、群體極化緊密關(guān)聯(lián)的兩個概念。信息繭房多指繭房內(nèi)的同質(zhì)化,繭房與繭房之間因為彼此不同質(zhì),不能產(chǎn)生溝通交流行為,這種繭房之間的異質(zhì)性就造成社群區(qū)隔。社群區(qū)隔的主要原因是價值觀分化。

美國傳播學(xué)者博奇科夫斯基把90后一代在社交媒體中偶遇新聞的現(xiàn)象稱為“不期而遇的新聞”,認(rèn)為這種現(xiàn)象不僅改變了他們的新聞獲取與閱讀方式,還決定了他們看到的政治觀點和社會意見[23]。算法推薦新聞針對不同價值觀的人群,傳遞分發(fā)不同價值觀的內(nèi)容信息,算法替代了傳統(tǒng)媒體中的“把關(guān)人”。算法技術(shù)“為每個人量身定制過濾器,使每個人都成了一座信息孤島,人與人之間形成了區(qū)隔”[24],從而可能導(dǎo)致社會分層的固化。算法作為技術(shù)盡管是中立的,但發(fā)明和掌控算法的個人或企業(yè),如果唯利是圖,只把算法推薦作為謀取利益的新工具,那么被操縱的算法可能會成為推薦偏離社會真實圖景的信息的“隱形獨裁者”,算法推薦系統(tǒng)可能成為“扭曲的棱鏡”,導(dǎo)致公眾的社會認(rèn)知偏差,“可能給公共生活造成難以彌合的分裂”[25]。

社會是需要共識的,而思想的活躍與繁榮是社會共識形成的基礎(chǔ)和條件。正是在不同思想觀點的交流和碰撞中,人們?nèi)ふ易畲蠖鄶?shù)的認(rèn)同群體,形成思想和觀點的“最大公約數(shù)”,促進(jìn)社會共識。而算法推薦造就了高度分眾化的群體和社群區(qū)隔,導(dǎo)致社會共識的形成變得困難,給社會凝聚力的增強帶來了新挑戰(zhàn)[5]。

四、“新東西”:算法推薦新聞的未來及規(guī)制

科技樂觀主義認(rèn)為,科技是社會發(fā)展的一個決定性因素,其帶來的一切問題都能依靠科技本身解決。科技悲觀主義認(rèn)為科技將使人類淪為奴仆,甚至毀滅人類的本性,導(dǎo)致人類的生存危機(jī)。“任何技術(shù)都傾向于創(chuàng)造一個新的人類環(huán)境”,算法推薦新聞作為一種新生科技事物,作為一種知識性的存在,正在改變著我們認(rèn)知世界的方式,也在改變著我們所處的環(huán)境。因此,對算法推薦新聞這種技術(shù)分發(fā)新聞方式,我們需要進(jìn)行審慎細(xì)致的反思。

(一)數(shù)據(jù)的所有權(quán)和信息的選擇權(quán)

算法推薦新聞的一個重要特征,就是搜集挖掘用戶的信息喜好、社交關(guān)系和網(wǎng)絡(luò)行為痕跡,并據(jù)此進(jìn)行信息匹配,有針對性地推薦新聞。在關(guān)于“好東西”與“壞東西”的討論中,問題的焦點是算法搜集挖掘信息尤其是使用信息的合法性、科學(xué)性問題(涉及隱私侵犯、算法歧視和算法偏見等),以及用戶的選擇權(quán)問題(涉及信息繭房等)。也就是用戶在網(wǎng)絡(luò)上的信息痕跡到底歸誰所有?算法是絕對中立的嗎?用戶的信息選擇權(quán)該歸誰來掌握?

隱私是作為法定權(quán)利基礎(chǔ)的天賦權(quán)利,是人格的根本。人格的根本是我們能夠掌控自己的信息。每一個用戶都樂意讓人們把他們的個人信息當(dāng)作是保密的而不是可以隨意買賣的商品。隱私權(quán)的目標(biāo)是確保個人擁有一個能成為個人的而不是集體成員的空間。在這個空間內(nèi),他能進(jìn)行自己的思考,擁有自己的秘密,過自己的生活,只讓外部世界看到他愿意公開的東西[26]。由此看來,用戶不愿意公開的網(wǎng)絡(luò)行為信息自然屬于隱私。但在互聯(lián)網(wǎng)時代隱私的邊界發(fā)生變化了嗎?如果算法是中立的、科學(xué)的,用戶的信息可以讓渡給機(jī)器嗎?霍奇斯(Hodges)認(rèn)為,保護(hù)隱私是一種道德的善,作為個體存在的我們需要隱私,作為社會存在的我們需要彼此的公開信息。“因為我們是個體存在,所以消滅隱私就消滅了我們所理解的人來存在;因為我們是社會性的,所以把隱私提升到絕對高度同樣會使人類社會不復(fù)存在”,這說明問題的焦點在于隱私的邊界。對于隱私,戴維斯、帕特森認(rèn)為,用戶線上預(yù)期同線下預(yù)期之間的差別, 涉及個人對與他們自身相關(guān)的私人數(shù)據(jù)的公開使用權(quán)所具有的控制程度,是一個深刻的倫理探索課題[2]。

在算法推薦新聞過程中,算法技術(shù)看似居于核心地位,但對問題的理解、數(shù)據(jù)的選取、變量的選擇、算法的評價等都貫穿著人為因素[27],如何認(rèn)識算法的中介本質(zhì),在算法中規(guī)避有意識或無意識的認(rèn)知偏見,給予用戶更多的信息選擇權(quán)和知情權(quán)才是問題的核心所在。真正把信息選擇權(quán)讓渡給用戶,讓用戶明白自己的需要和選擇,增強算法的透明性,而不是讓用戶“被算法喂食”,倡導(dǎo)以間性“算法集”為視角、以“數(shù)據(jù)主體”的規(guī)范理念為出發(fā)點來推進(jìn)落實“可理解的透明度”是算法要努力解決的問題[16]。

(二)對什么負(fù)責(zé)與對誰負(fù)責(zé)

上一個問題回答了對什么負(fù)責(zé)和對誰負(fù)責(zé)的問題,那就是對隱私負(fù)責(zé)和對用戶負(fù)責(zé)。但關(guān)于算法推薦的擔(dān)憂無論是在西方語境還是中國語境中,都不是一個簡單問題。算法推薦被指將用戶置于隨時被監(jiān)控的“圓形監(jiān)獄”,造成價值觀分化與社群區(qū)隔,這無疑是從社會責(zé)任的視角來觀照算法技術(shù)的。

有研究者在《算法機(jī)制對媒體社會責(zé)任的影響》中提出,圍繞算法機(jī)制的優(yōu)劣有堅守派和破除派兩種觀點,堅守派希望媒體通過對特定價值觀的堅持和引導(dǎo)達(dá)成社會共識實現(xiàn)社會和諧,破除派則認(rèn)為不應(yīng)堅持特定價值觀,而應(yīng)通過多元價值的相互博弈促成社會和諧進(jìn)步[28]。不管是堅守派還是破除派,其實都在肯定媒體在算法推薦中的社會責(zé)任。算法新聞除了滿足受眾的信息需求,還應(yīng)通過有意義、有價值的信息傳播,促使社會形成一個能相互協(xié)調(diào)與配合的統(tǒng)一有機(jī)體,履行輿論引導(dǎo)功能。無論算法新聞如何變革,必須確保人文情懷、責(zé)任擔(dān)當(dāng)?shù)刃侣剺I(yè)的核心價值觀不因技術(shù)的變革而消亡,確保技術(shù)變革有利于社會和人類的可持續(xù)發(fā)展[11]。

從社會責(zé)任的視角,我們可以用行動者網(wǎng)絡(luò)理論(ANT)來探究算法技術(shù)與社會責(zé)任的關(guān)系問題。行動者網(wǎng)絡(luò)理論認(rèn)為,“任何通過制造差別而改變了事物狀態(tài)的東西都可以被稱為行動者”,行動者可以是人,也可以是技術(shù)、觀念等力量。算法技術(shù)根據(jù)用戶偏好和接觸信息的變化而變化,根據(jù)用戶標(biāo)簽推送內(nèi)容,為用戶塑造一種自己的媒介環(huán)境。算法不是一成不變的,算法總是根據(jù)用戶的行為不斷調(diào)整和改進(jìn),用戶在改變算法,算法也在改變用戶。因此,算法是一個非人類的“行動者”。人與算法構(gòu)成一個網(wǎng)絡(luò),在這個網(wǎng)絡(luò)里,用戶與算法技術(shù)是既相互依存又相互影響的主體間性的相與關(guān)系,非人的“行動者”(算法技術(shù))通過有資格的“代言人”(agent)來獲得主體的地位、資格和權(quán)利,與用戶一道共同營造相互協(xié)調(diào)的行動之網(wǎng)。顯然,這個有資格的“代言人”的社會責(zé)任就會特別重要。

社會責(zé)任理論的心理學(xué)基礎(chǔ)是:人并不是完全理性的動物,本性也并非全然的“善良”。因此,傳媒應(yīng)該對社會承擔(dān)責(zé)任,與社會“分享共同價值”。對什么負(fù)責(zé)和對誰負(fù)責(zé),歸根結(jié)底就是傳媒除了發(fā)揮娛樂功能外,更應(yīng)發(fā)揮其雷達(dá)功能、控制功能、教育功能。算法技術(shù)作為與人相互影響的“行動者”,應(yīng)對人的自由全面發(fā)展負(fù)責(zé),對社會健康有序運行負(fù)責(zé),算法的設(shè)計者在整個行動網(wǎng)絡(luò)中處于樞紐和關(guān)鍵地位。

(三)工具理性和價值理性

算法是一種技術(shù)工具,算法推薦中產(chǎn)生的低俗、淺薄內(nèi)容甚至算法偏見與歧視,將算法對用戶的“控制”形容為“信息繭房”“個性化圈套”“信息孤島”,從技術(shù)反思的角度看,需要我們?nèi)プ匪菁夹g(shù)與人的關(guān)系、技術(shù)與社會的關(guān)系。對于算法技術(shù)對人與社會的影響,需要科學(xué)嚴(yán)謹(jǐn)?shù)拈L期的實驗方法進(jìn)行研究。

工具理性強調(diào)把技術(shù)的效用發(fā)揮到最大,價值理性強調(diào)倫理的重要性。對算法推薦的價值考量,主要圍繞著工具理性和價值理性的博弈。對技術(shù)保持懷疑批評,對價值保持敬畏尊重,找到工具理性和價值理性的黃金結(jié)合點,是算法推薦要努力解決的問題。我們要肯定算法技術(shù)對社會的推動作用,也要對其價值關(guān)懷格外重視。技術(shù)與社會是互動的,良性的互動才能給人類帶來福祉。過度強調(diào)價值會阻礙技術(shù)創(chuàng)新,過度強調(diào)算法技術(shù)會導(dǎo)致“創(chuàng)新性破壞”。對新興事物的立法與規(guī)制,應(yīng)當(dāng)兼顧社會公平、個人權(quán)利,使其不至于扼殺創(chuàng)新[29]。

對于算法推薦新聞,不能沿用老辦法管制,應(yīng)秉持“寬容審慎”的態(tài)度。比如,有學(xué)者提出,互聯(lián)網(wǎng)時代,隱私權(quán)的邊界發(fā)生了變化,“隱私權(quán)不能僅僅理解成獨處不被打擾或不被不希望出現(xiàn)的意見和刺激擾亂心神的權(quán)利等靜態(tài)的隱私”;“‘信息繭房’并不是算法時代獨有的產(chǎn)物,‘信息繭房’存在的根源是‘選擇性心理’”等[30]。因此,對于算法推薦新聞的研究,還需要以一種審慎的心態(tài)進(jìn)行。

參考文獻(xiàn)

[1]? 祝建華:算法推薦新聞是“好東西”、“壞東西”、還是有待驗證的“新東西”?[EB/OL].[2017-11-22].https://www.jfdaily.com/news/detail?id=71705.

[2]? 科德·戴維斯,道格·帕特森.大數(shù)據(jù)倫理: 平衡風(fēng)險與創(chuàng)新[M].趙亮,王健,譯.沈陽: 東北大學(xué)出版社,2016:17.

[3]? 傅丕毅,陳毅華.M G C機(jī)器生產(chǎn)內(nèi)容+AI人工智能的化學(xué)反應(yīng)——“媒體大腦”在新聞智能生產(chǎn)領(lǐng)域的迭代探索[J].中國記者,2018(7):30-32.

[4]? 周勇,趙璇.大數(shù)據(jù)新聞生產(chǎn)的實踐與反思[J].新聞與寫作,2016(06) :44-48.

[5]? 劉存地,徐煒.能否讓算法定義社會——傳媒社會學(xué)視角下的新聞算法推薦系統(tǒng)[J].學(xué)術(shù)論壇.2018(4):28-37.

[6]? 彭蘭.未來傳媒生態(tài): 消失的邊界與重構(gòu)的版圖[J].現(xiàn)代傳播,2017(1):8-14+29.

[7]? 今日頭條的核心架構(gòu)解析[EB/OL].[2017-05-19].https://www.aliyun.com/jiaocheng/154571.html.

[8]? 吳衛(wèi)華.算法推薦在公共傳播中的理性問題[J].當(dāng)代傳播,2017(3):79-81.

[9]? 張瀟瀟.算法新聞個性化推薦的理念、意義及倫理風(fēng)險[J].傳媒,2017(6上):82-84.

[10]? 喻國明,楊瑩瑩,閆巧妹.算法即權(quán)力:算法范式在新聞傳播中的權(quán)力革命[J].編輯之友,2018(5):5-12.

[11]? 吳鋒.發(fā)達(dá)國家“算法新聞”的理論緣起、最新進(jìn)展及行業(yè)影響[J].編輯之友,2018(5):48-54.

[12]? 張志安,湯敏.論算法推薦對主流意識形態(tài)傳播的影響[J].社會科學(xué)戰(zhàn)線,2018(10):174-182.

[13]? 企鵝智酷:2017中國新媒體趨勢報告[EB/OL].[2016-11-16].http://www.199it.com/archives/654084.html.

[14]? 珍妮弗·溫特,良太小野.未來互聯(lián)網(wǎng)[M].鄭常青,譯.北京:電子工業(yè)出版社.2018:155.

[15]? 常江.生成新聞:自動化新聞時代編輯群體心態(tài)考察[J].編輯之友,2018(4):76-82.

[16]? 仇筠茜,陳昌鳳.黑箱:人工智能技術(shù)與新聞生產(chǎn)格局嬗變[J].新聞界,2018(1):28-34.

[17]? 吳獻(xiàn)舉.聚合媒體的新聞生產(chǎn):方式變革、社會影響與優(yōu)化路徑[J].編輯之友,2018(6):63-67.

[18]? 人民網(wǎng).民日報評論部:算法盛行更需“總編輯”[EB/OL].[2016-12-13]. http://opinion.people.com.cn/n1/2016/1223/c1003-28970666.html.

[19]? 劉凱.“千人千面”技術(shù)模式下政策類新聞傳播的優(yōu)化策略[J].中國記者,2018(03):64-66.

[20]? Kramer,A. D. .Guillory,J. E. ,& Hancock ,J. T. Experimental Evidence of Massive- Scale Emotional Contagion Through Social Networks[J]. Proceedings of the National Academy of Sciences of the United States of America,111( 24) ,8788,2014.

[21]? Bucher,T.. The Algorithmic Imaginary: Exploring the Ordinary Affects of Facebook Algorithms[J]. Information,Communication & Society,2017(1), 30-44.

[22]? 凱斯·R.桑斯坦.極端的人群:群體行為的心理學(xué)[M].尹弘毅,郭彬彬,譯.北京:新華出版社,2010:103.

[23]? 李彪,喻國明.新聞2.0時代硅谷如何馴化美國新聞業(yè)[J].江淮論壇,2018(3):166-170.

[24]? 姜紅,魯曼.重塑“媒介”: 行動者網(wǎng)絡(luò)中的新聞“算法”[J].新聞記者,2017(4):26-32.

[25]? 胡凌.人工智能的法律想象[J].文化縱橫,2017(2):108-116.

[26]? ?Thomas I.Emerson.The System of Free Expression (New York:Vintage Books).Louis Hodges(2009)[M]."Privacy and the press,"in The Handbook of Mass Media Ethics,eds.Lee Wilkins and Clifford Christians(New York:Routledge),1970:545.

[27]? 張超.作為中介的算法 :新聞生產(chǎn)中的算法偏見與應(yīng)對[J].中國出版,2018(1):29-33.

[28]? 董小菲.算法機(jī)制對媒體社會責(zé)任的影響[J].網(wǎng)絡(luò)傳播,2017(9):94-96.

[29]? 馬思源,姜文琪.推薦算法規(guī)制的他山之石[J].新聞戰(zhàn)線,218(3):106-108.

[30]? 林小勇,張苗苗.未來媒體藍(lán)皮書:中國未來媒體研究報告[M].北京: 社會科學(xué)文獻(xiàn)出版社,2018:186.

(責(zé)任編輯:易曉艷)