基于大數據特征選擇的深度學習算法

劉芳

摘要:隨著信息社會進入大數據時代,數據的快速增長既是機遇也是挑戰.一方面,大數據可以為深度學習提供大規模的樣本集進行訓練繼而對數據挖掘和選擇,有效地分析和處理這些數據;另一方面,大數據的異構性和海量性又會造成維數災難,同時需要先進的硬件平臺支撐以及優化技術.因此,選擇一種合適的深度學習模型是解決這一問題的關鍵.本文針對傳統的深度學習模型無法選擇大量不同的數據特征,提出一種基于大數據特征選擇的深度學習算法,首先構建一個大數據特征選擇框架繼而進行數據融合和深度學習.實驗表明,算法較好地解決了數據龐大與信息貧乏之間的矛盾,具有一定的前瞻性.

關鍵詞:大數據;特征選擇;深度學習

中圖分類號:TP391.4 ?文獻標識碼:A ?文章編號:1673-260X(2019)05-0046-03

隨著互聯網技術以及高清數字視頻的普及,數據量正在呈現指數規模的增長,數據的規模達到了TB級、PB級甚至是EB級,這就使數據具有規模性[1].然而大量的數據,只有極少數數據被分析和有效利用,這就造成了數據龐大與信息貧乏之間的矛盾[2].因此,需要找到一種能夠對大數據進行充分挖掘的智能學習算法,從規模龐大的數據中發現隱藏的規律和特點,挖掘大數據的潛在價值進行特征選擇,繼而進行后續的分類或決策.深度學習作為機器學習的一部分,能夠在龐大的數據中進行映射變換,借助復雜的模型處理規模龐大的數據,提取到數據的多層特征[3].雖然深度學習能夠對大數據進行變換提取,但由于數據具有異構性、動態變化以及不完整性,因此深度學習仍需進一步優化.

1 大數據特征選擇

1.1 大數據的基本特征

隨著云計算、移動互聯等技術的應用數據量由TB到PB模式的增長,1996年John Mashey提出了大數據的概念,大數據是融合信息空間、人類社會和物理世界的連接器[4].麥肯錫在此基礎上重新定義了大數據的概念:數據集合規模大的傳統數據庫程序無法對其進行管理、分析,計算時間遠遠大于預期的數據集合[5].大數據隱含有小數據不具備的規律和價值,但對大數據準確的定義并沒有統一的說法,并不僅僅體現在規模和速度上.普遍認為的大數據具有的三個特征為:高速性(Velocity)、大容量(Volume)和多樣性(Variety),即所謂的3V特征,也就是數據的異構多樣性和大規模,同時數據流的快速運行[6].在3V特征的基礎上,有人認為大數據的特征不僅僅局限于此,提出了數據的真實性(Veracity)、價值性(Value)等概念,也就是所謂的4V和5V特征,總結起來,大數據的基本特征可以概括為以下幾個方面,如表1所示.

1.2 特征選擇過程

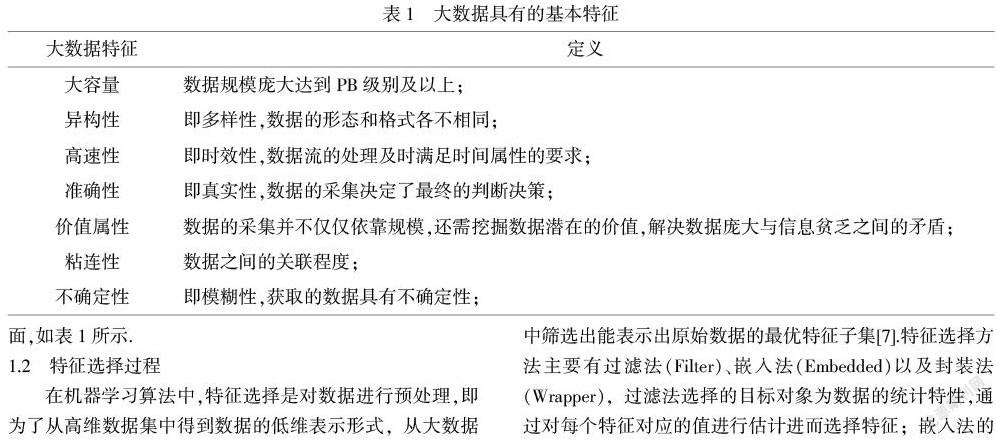

在機器學習算法中,特征選擇是對數據進行預處理,即為了從高維數據集中得到數據的低維表示形式,從大數據中篩選出能表示出原始數據的最優特征子集[7].特征選擇方法主要有過濾法(Filter)、嵌入法(Embedded)以及封裝法(Wrapper),過濾法選擇的目標對象為數據的統計特性,通過對每個特征對應的值進行估計進而選擇特征;嵌入法的前提是已知特征空間的模型,繼而從特征空間中尋找能夠提高系統性能的最優子空間,通過分析樣本中是否具有已知數據分為無監督學習和有監督學習;封裝法是利用得到的特征子空間進行分類,通過分析分類的準確率來判斷特征,由于選擇的特征子空間對象不同,因此需要對樣本進行多次訓練得到.特征選擇的一般流程如圖1所示:

特征選擇的實質是求解線性或非線性組合優化的過程,亦稱為屬性約簡,屬于NP問題,評價函數和搜索方法是特征選擇的核心部分,搜索作為解決組合優化的主要方法,有啟發搜索策略、完全搜索策略和隨機搜索策略;作為影響特征選擇結果的評價函數是度量特征集優劣的標準,而評價函數則通過誤差度量、一致性度量、距離度量和依賴性度量準則,作為評判特征集的優劣影響特征選擇結果[8].

2 深度學習

2.1 淺層學習與深度學習

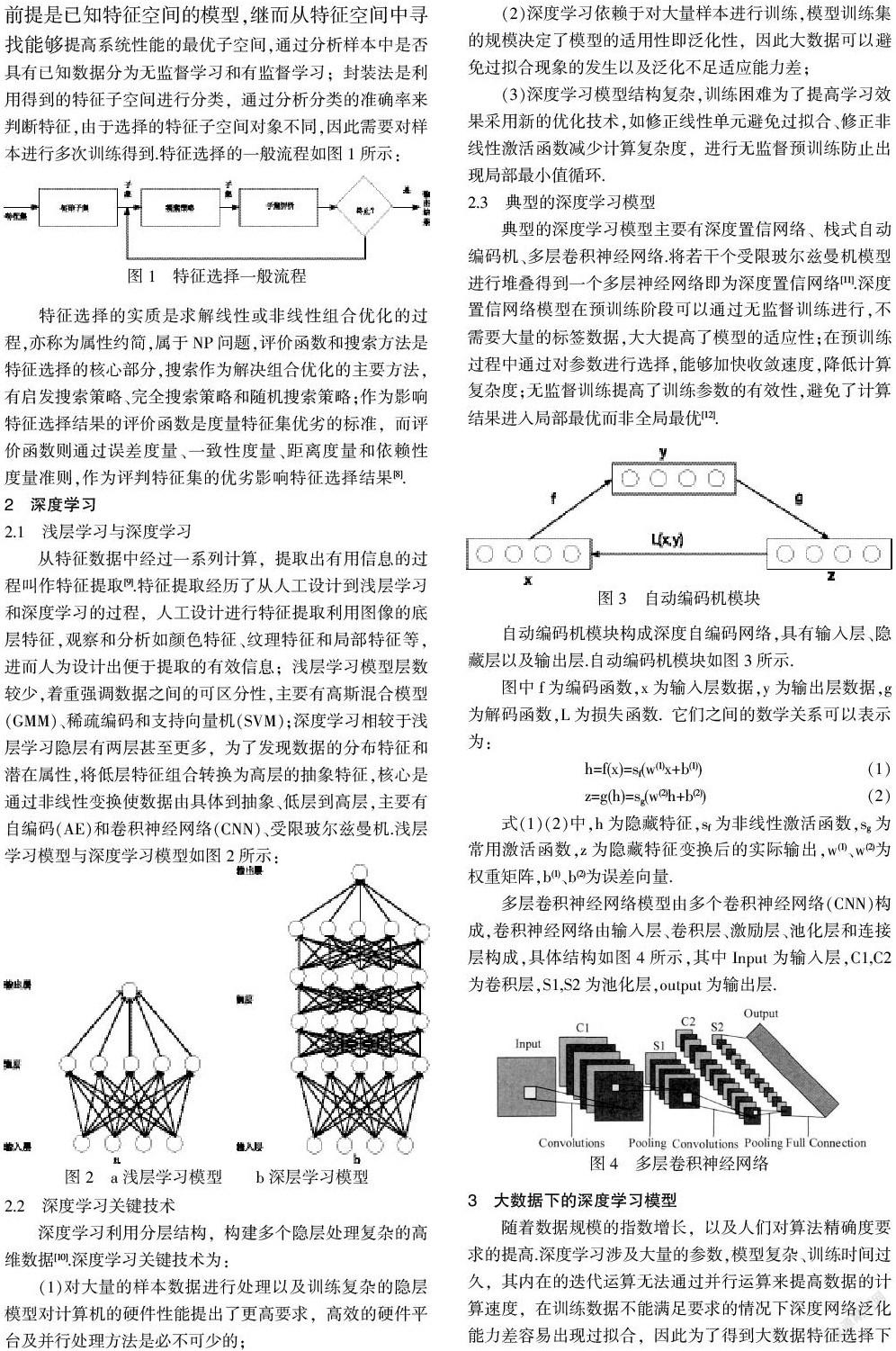

從特征數據中經過一系列計算,提取出有用信息的過程叫作特征提取[9].特征提取經歷了從人工設計到淺層學習和深度學習的過程,人工設計進行特征提取利用圖像的底層特征,觀察和分析如顏色特征、紋理特征和局部特征等,進而人為設計出便于提取的有效信息;淺層學習模型層數較少,著重強調數據之間的可區分性,主要有高斯混合模型(GMM)、稀疏編碼和支持向量機(SVM);深度學習相較于淺層學習隱層有兩層甚至更多,為了發現數據的分布特征和潛在屬性,將低層特征組合轉換為高層的抽象特征,核心是通過非線性變換使數據由具體到抽象、低層到高層,主要有自編碼(AE)和卷積神經網絡(CNN)、受限玻爾茲曼機.淺層學習模型與深度學習模型如圖2所示:

2.2 深度學習關鍵技術

深度學習利用分層結構,構建多個隱層處理復雜的高維數據[10].深度學習關鍵技術為:

(1)對大量的樣本數據進行處理以及訓練復雜的隱層模型對計算機的硬件性能提出了更高要求,高效的硬件平臺及并行處理方法是必不可少的;

(2)深度學習依賴于對大量樣本進行訓練,模型訓練集的規模決定了模型的適用性即泛化性,因此大數據可以避免過擬合現象的發生以及泛化不足適應能力差;

(3)深度學習模型結構復雜,訓練困難為了提高學習效果采用新的優化技術,如修正線性單元避免過擬合、修正非線性激活函數減少計算復雜度,進行無監督預訓練防止出現局部最小值循環.

2.3 典型的深度學習模型

典型的深度學習模型主要有深度置信網絡、棧式自動編碼機、多層卷積神經網絡.將若干個受限玻爾茲曼機模型進行堆疊得到一個多層神經網絡即為深度置信網絡[11].深度置信網絡模型在預訓練階段可以通過無監督訓練進行,不需要大量的標簽數據,大大提高了模型的適應性;在預訓練過程中通過對參數進行選擇,能夠加快收斂速度,降低計算復雜度;無監督訓練提高了訓練參數的有效性,避免了計算結果進入局部最優而非全局最優[12].

4 實驗仿真

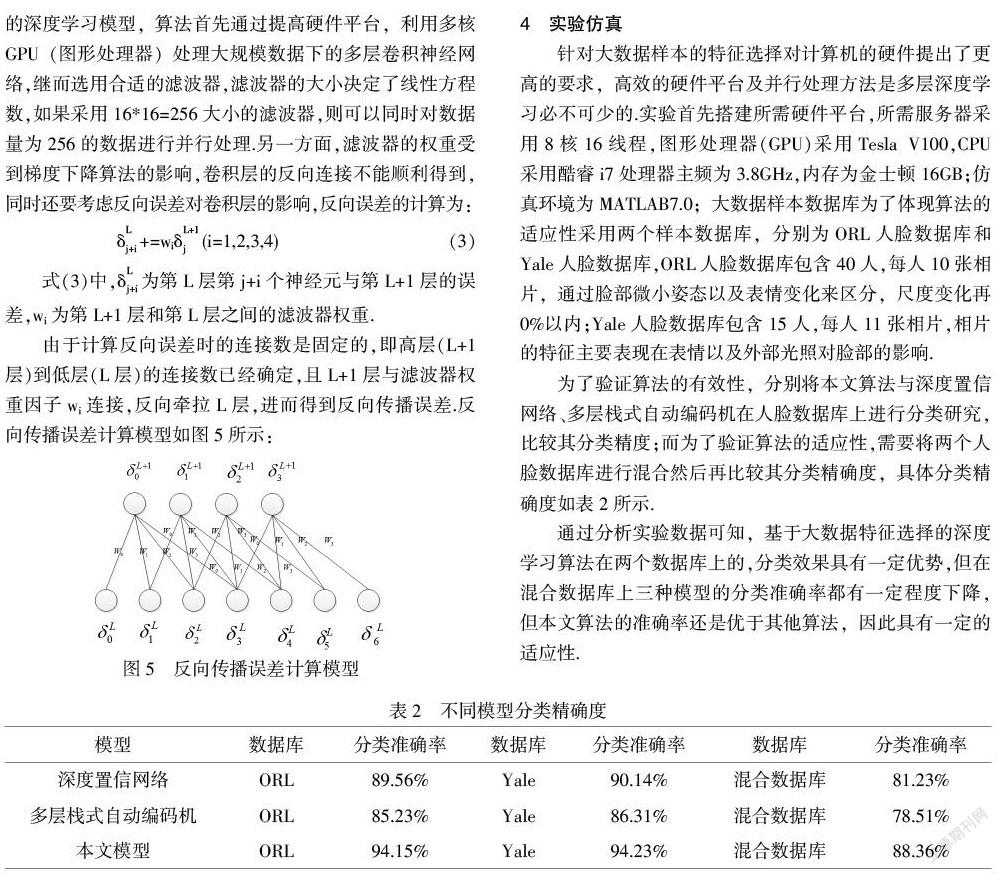

針對大數據樣本的特征選擇對計算機的硬件提出了更高的要求,高效的硬件平臺及并行處理方法是多層深度學習必不可少的.實驗首先搭建所需硬件平臺,所需服務器采用8核16線程,圖形處理器(GPU)采用Tesla V100,CPU采用酷睿i7處理器主頻為3.8GHz,內存為金士頓16GB;仿真環境為MATLAB7.0;大數據樣本數據庫為了體現算法的適應性采用兩個樣本數據庫,分別為ORL人臉數據庫和Yale人臉數據庫,ORL人臉數據庫包含40人,每人10張相片,通過臉部微小姿態以及表情變化來區分,尺度變化再0%以內;Yale人臉數據庫包含15人,每人11張相片,相片的特征主要表現在表情以及外部光照對臉部的影響.

為了驗證算法的有效性,分別將本文算法與深度置信網絡、多層棧式自動編碼機在人臉數據庫上進行分類研究,比較其分類精度;而為了驗證算法的適應性,需要將兩個人臉數據庫進行混合然后再比較其分類精確度,具體分類精確度如表2所示.

通過分析實驗數據可知,基于大數據特征選擇的深度學習算法在兩個數據庫上的,分類效果具有一定優勢,但在混合數據庫上三種模型的分類準確率都有一定程度下降,但本文算法的準確率還是優于其他算法,因此具有一定的適應性.

5 總結展望

規模龐大的數據量一方面帶來維數災難,對計算機的硬件帶來新挑戰,另一方面大數據提供了大量訓練樣本,可以解決深度網絡泛化能力差容易出現過擬合的缺點.因此,基于大數據特征選擇的深度學習模型具有一定的實用價值,通過實驗發現深度計算模型在分類準確性和適應性上,都得到了進一步提高.

參考文獻:

〔1〕馮登國,張敏,李昊.大數據安全與隱私保護[J].計算機學報,2014,37(1):246-258.

〔2〕程學旗,靳小龍,王元卓,等.大數據系統和分析技術綜述[J].軟件學報,2014(9):1889-1908.

〔3〕陳海華,張立臣.大數據下的CPS自適應路由服務[J].計算機工程與應用,2018,54(1):94-101.

〔4〕魯亮,于炯,卞琛,等.大數據流式計算框架Storm的任務遷移策略[J].計算機研究與發展,2018,55(1):71-92.

〔5〕胡志剛,劉佳.面向大數據實體識別的超圖分割算法[J].小型微型計算機系統,2018,39(7):32-33.

〔6〕林學民,杜小勇,李翠平.基于圖結構的大數據分析與管理技術專刊前言[J].軟件學報,2018,29(3):70-74.

〔7〕馬世龍,烏尼日其其格,李小平.大數據與深度學習綜述[J].智能系統學報,2016,11(6):728-742.

〔8〕江洲,朱旭東.基于大數據和深度學習的人臉識別布控系統[J].電子世界,2018(9):52-55.

〔9〕段艷杰,呂宜生,張杰,等.深度學習在控制領域的研究現狀與展望[J].自動化學報,2016,42(5):643-654.

〔10〕李爽.基于多特征融合和深度學習的圖像分類算法[J].河南科技學院學報,2018,46(4):50-55.

〔11〕卜范玉,陳志奎,張清辰.基于深度學習的不完整大數據填充算法[J].微電子學與計算機,2014(12):55-61.

〔12〕陳瑞瑞.基于深度卷積神經網絡的圖像分類算法[J].河南科技學院學報,2018,46(4):56-60.