基于級聯卷積神經網絡的作物病害葉片分割

王 振,張善文,趙保平

1.西京學院 信息工程學院,西安 710123

2.寶雞市農業科學研究院,陜西 寶雞 721000

1 引言

作物病害是影響作物產量與質量的重要因素之一。由于大部分病害的癥狀主要表現在作物葉片上,所以通過觀察作物葉片特征可判斷病害發生和病害類型[1]。傳統的通過人工觀察方式判斷病害類型,存在主觀性、盲目性和效率低等問題[2]。近年來,隨著計算機視覺技術的不斷發展,使用自動化方式判斷作物病害成為一種趨勢,能夠有效解決人工判斷病害的缺點[3]。在基于病害葉片圖像的病害識別過程中,病斑區域的精準分割直接影響病害識別的準確率。

作物病害葉片圖像分割方法很多,病害葉片圖像可以分為基于傳統圖像分割的方法和基于深度學習的分割方法。傳統的作物病害圖像分割方法可分為4類:基于閾值的分割方法[4-5]、基于聚類的分割方法[6-8]、基于分類的分割方法[9-10]和基于圖論的分割方法[11-12]。第一類方法通過尋找關鍵閾值點進行作物病害葉片圖像分割,該方法適用于簡單背景下的病害葉片圖像分割。第二類方法根據圖像像素點的不同進行分類來完成病斑區域分割,但該方法在分割過程中需要進行多次迭代才能確定最優聚類點,降低了分割方法的時效性。第三類方法利用多種圖像特征對分類器進行訓練,使用訓練后的分類器對像素點進行分類從而實現分割,由于在特征提取階段需要設定較為復雜的特征提取算法,所以這種方法的實用性較差。第四類方法將原始圖像映射為帶權無向圖,通過求解函數最優解完成圖像分割,這種方法適用于背景簡單或像素相似度較低的條件。以上基于傳統的圖像分割方法只適用于背景較簡單的作物病害葉片圖像,當作物病斑區域與背景顏色相似或界限模糊時,使用傳統的圖像分割方法難以將兩者區分開,分割效果較差。

近年來得益于深度學習技術的發展,利用卷積神經網絡(CNN)對圖像進行語義分割成為一種趨勢[13]。許多學者嘗試將CNN用于解決作物病害葉片圖像分割問題。劉立波等[14]將Markov與CNN相結合完成對棉花病斑圖像分割,該方法利用CNN提取圖像深層語義特征,結合特征圖像素間的相對關系構建條件隨機場能量函數并對其進行優化訓練;段凌鳳等[15]利用水稻病害數據集訓練基于全卷積神經網絡(FCN)的水稻病害葉片圖像分割模型,完成了復雜背景下水稻病害葉片圖像的分割;趙兵等[16]將FCN與CRF相結合進行葡萄病害葉片分割。該方法在分割過程中將CRF作為概率圖描述圖像的細節信息,所以需要網絡模型的訓練時間較長。Xiong等[17]將超像素分割與CNN結合,實現了不同生長時期的大田稻穗分割,其缺點是在復雜背景下的分割效果較差。馬浚誠等[18]基于CNN設計了一種溫室黃瓜病害識別系統,該系統在預處理階段將復合顏色特征與CNN相結合,能夠實現對不同病害的完整分割。楊晉丹等[19]基于Alex Net提出一種草莓葉部病害檢測方法,在草莓病害葉片圖像上的檢測中效果較好,但對于有遮擋的情況效果較差。Pound等[20]利用CNN對小麥根尖、穗尖以及穗基等不同部位進行分割,取得了較好的效果。由于CNN需要對原始圖像進行預處理操作,降低了該方法的普適性。以上基于深度學習的作物病害葉片圖像分割方法在不同種類作物病害葉片圖像分割問題上均得到較高的分割精度,但現有基于深度學習的分割方法只是針對單一的植物病害完成分割任務,不能解決多種植物病害的分割問題,降低了分割方法的實用性;而且部分方法的網絡模型結構較為復雜,很難將其擴展為進一步的作物病害識別任務;許多方法所建立的網絡模型需要進行大量的模型參數訓練,難以滿足作物病害分割的實時性需求。因此本文針對作物葉部病害分割難題,提出一種基于級聯卷積神經網絡的作物病害分割方法,并將其應用于不同環境下的作物病害葉片圖像分割。

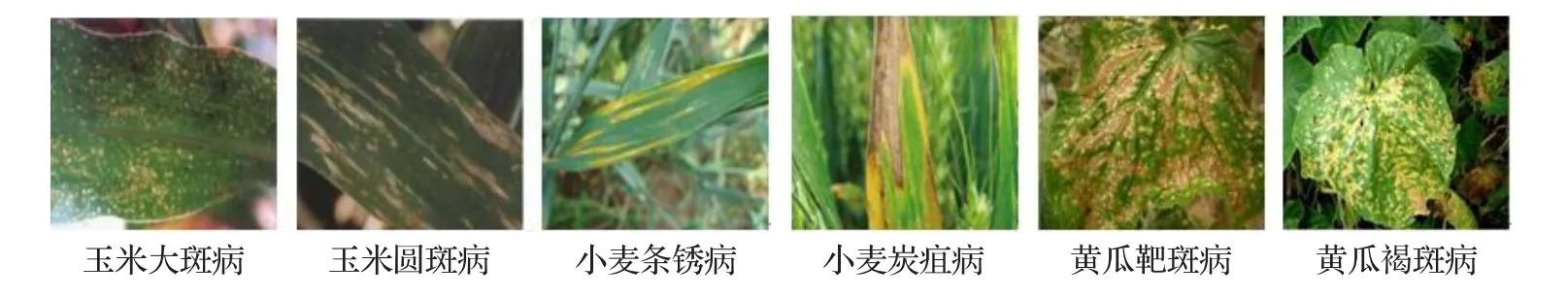

圖1 部分作物病害葉片圖像

2 材料與方法

2.1 圖像采集

實驗圖像采集于陜西省寶雞市大田試驗基地,采集時間為2018年4月—7月。為充分考慮自然光照對分割效果的影響,每日8:00、10:00、16:00和18:00時間段進行拍攝。主要作物病害葉片包括玉米大斑病、玉米圓斑病、小麥條銹病、小麥炭疽病、黃瓜靶斑病和黃瓜褐斑病,共拍攝900幅作物病害葉片圖像,每種病害葉片圖像150幅。采集設備為Cannon EOS650D數碼相機,無任何補充光源,拍攝時距離作物葉片約15~30 cm。為提高網絡模型的訓練效率,利用Photoshop將圖像統一裁剪為256×256像素大小。部分作物病害葉片圖像如圖1所示。

在裁剪后的作物病害葉片中隨機挑選650幅組成訓練集、125幅作為驗證集、125幅作為測試集。將訓練集圖像輸入分割網絡模型中,對模型的權重參數進行訓練;利用驗證集確定模型結構,同時控制模型的復雜程度,對模型參數進行調優;選用測試集圖像對模型的分割效果進行測試。

2.2 基于級聯卷積神經網絡的圖像分割方法

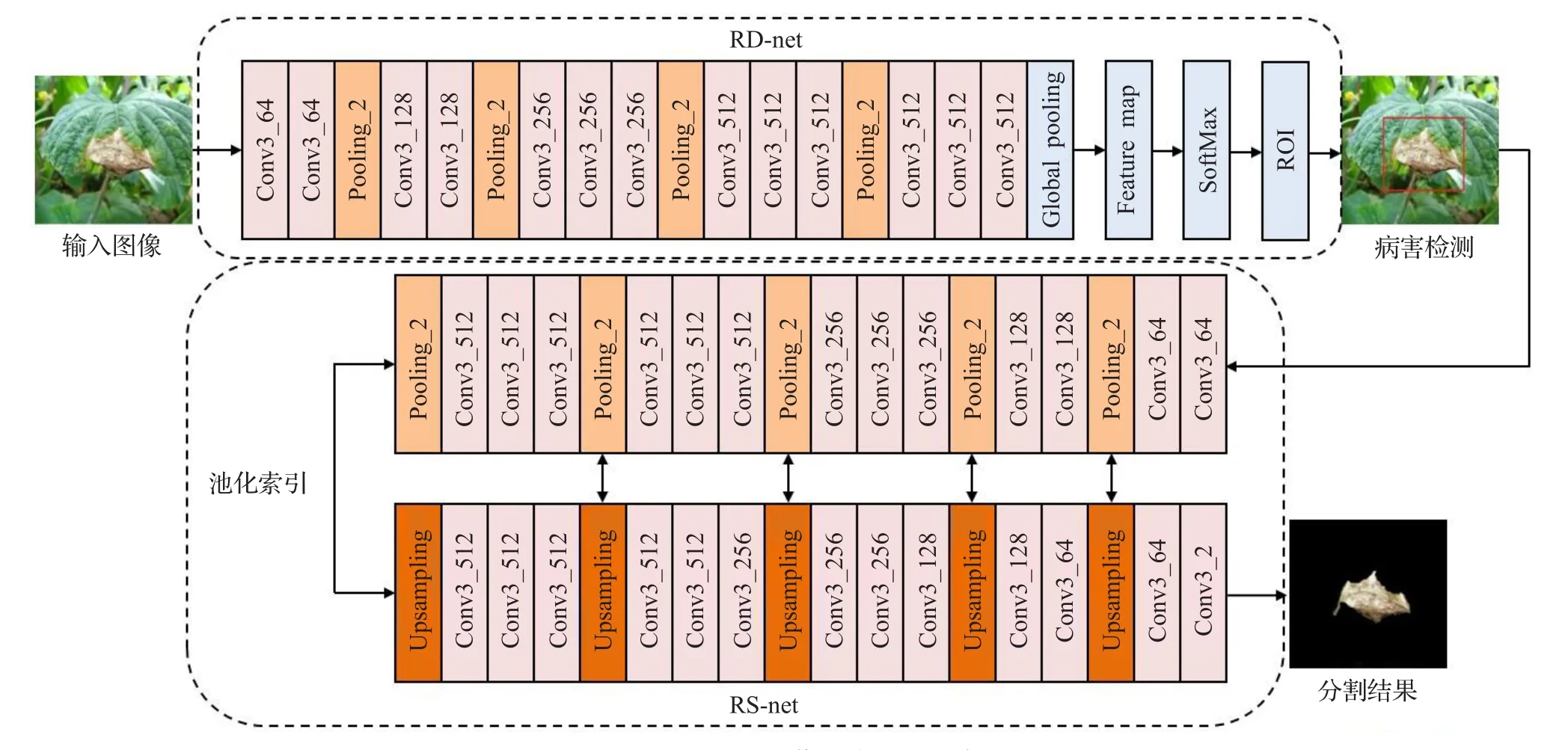

基于級聯卷積神經網絡(CCNN)的作物病害葉片圖像分割方法的整體流程如圖2所示。由于作物病害葉片圖像中葉片的病害部分與正常區域的像素相似度較高,而且采集圖像包含大量的背景噪聲,為此將卷積層、全局池化層和SoftMax相結合,建立區域病斑定位網絡(RD-Net),對葉片中的病斑區域進行檢測,即對病斑區域進行定位,減少背景信息對分割效果的影響。基于Encoder-Decoder模型架構,建立區域病斑分割網絡(RS-Net),進行病害葉片圖像分割。在CCNN中,使用多尺度卷積核擴大原始卷積核的局部感受野,將RD-Net的輸出結果輸入到RS-Net,然后對定位的病斑區域進行分割。現有的基于深度學習的分割方法多數使用端到端的分割模型,這種方法直接對圖像進行分割任務,無法定位圖像中所要分割的具體位置,這種方式降低了分割效率。在本研究中使用RD-Net與RS-Net相結合的方法,提高了網絡模型的分割精度,在經過RD-Net對圖像中的病斑區域進行定位后,增強了CCNN網絡模型對病斑區域的視覺顯著性,加快了模型的分割速度。

圖2 基于CCNN的作物病害葉片分割模型

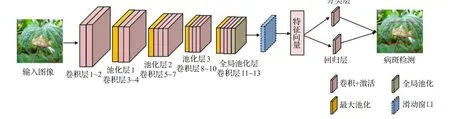

圖3 RD-Net網絡模型結構

2.2.1 區域病斑檢測網絡模型(RD-Net)

RD-Net基于傳統CNN網絡構建,其結構主要包括卷積層、池化層以及全連接層。其結構如圖3所示。在圖3中,前半部分是基于傳統VGG16網絡進行構建,主要用來對輸入圖像進行深層特征提取;后半部分則由一個n×n的滑動窗口、一個分類層(cls)和一個回歸層(reg)組成,用來產生區域檢測框以及相應的類別和位置信息。

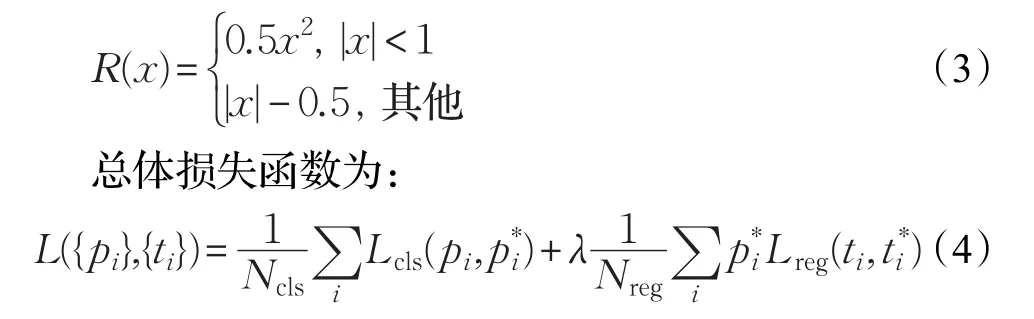

RD-Net網絡主要包括13個卷積層(Conv1~Conv13)、4個池化層以及1個全局池化層組成。將所有卷積核設置為3×3大小,卷積層的滑動步長設置為1;為保持與輸入圖像的維數一致,通過邊界擴充的方式將pad參數設置為1對卷積層邊緣進行補全。池化層(Pooling1~Pooling3)大小設置為3×3,并采用最大池化操作,池化窗口設置為2×2,滑動步長設置為2。由于傳統的VGG16網絡在末端采用全連接層,導致網絡模型需要進行大量的參數計算。為了減少模型的計算量,采用全局池化層代替全連接層。使用n×n的滑動窗口在卷積層前部分卷積層輸出的特征映射圖上進行卷積操作,將經過滑動窗口得到的卷積層映射為一個特征向量,并將特征向量輸入到兩個同級的分類層和回歸層,分類層用于判別是否為葉片正常區域或病斑區域,利用回歸層對病斑區域的具體位置進行定位。在具體的病斑區域檢測過程中,將滑動窗口的中心點定義為錨點,窗口的每一次滑動都分別對應三種尺度和三種長寬比,由此每一次滑動都會產生n=9個錨點,同樣產生相同數量大小的區域檢測框。將檢測后的病害葉片圖像與原始手工標注圖像做比較,通過使用兩個不同的損失函數計算檢測值與真實標注值之間的誤差。分別對類別損失和位置損失利用反向梯度傳播算法進行回傳,使用隨機梯度下降算法對每層網絡的權重參數進行修正,使得網絡的正確檢測率更高,實現對病斑區域的精準定位。在損失函數的計算過程中,將類別損失函數表示為:

式中,R(x)為正則化損失函數,即

式中,λ為權重系數,pi表示檢測區域屬于病害的概率,為真實標注類別,其中表示背景類,表示病斑區域,Ncls和Nreg為用于避免過擬合的正則項,i是檢測候選區域的索引值,ti為原始坐標框的位置參數為該候選區域的實際坐標。

2.2.2 區域分割網絡模型(RS-Net)

RS-Net結構與SegNet[23]相似,主要由編碼網絡、解碼網絡和SoftMax分類器組成。其中編碼網絡是基于VGG16網絡結構進行構造,但由于作物病害葉片的細節特征較為復雜,所以使用傳統的卷積核難以提取復雜特征。為了提取病害葉片圖像的復雜病斑特征,需要通過增加卷積層數量或引入多個尺寸卷積核,但僅僅使用簡單的卷積層數堆疊會降低模型的非線性變化,使得每個卷積層提取的圖像特征相同。而引入多個尺寸卷積核只會大量的增加參數計算量,導致模型訓練時間增加,降低模型的效率。因此在編碼網絡中使用多尺度卷積核代替原始卷積核,通過在同一個卷積層引入不同尺度卷積核來獲取圖像的不同尺度特征,再將這些特征進行融合,得到原始圖像的多尺度特征圖。

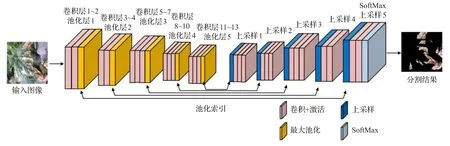

SegNet網絡能夠得到精確的語義分割結果主要得益于其解碼網絡的設計,通過記錄編碼網絡的最大池化層索引,并利用索引因子在解碼網絡中直接進行上采樣,使得SegNet網絡模型相比于全卷積神經網絡(Fully Convolutional Neural network,FCN)具有更高的分割精度。使用與SegNet相同的解碼網絡,主要包括卷積層(Conv1~Conv14)和上采樣層(Upsampling_1~Upsampling_5),通過卷積層對編碼網絡獲取的多尺度特征圖進行深度特征提取,并利用上采樣層恢復圖像分辨率。作物病害葉片的分割相當于一個二分類問題,分割的目的主要是區分葉片正常部分與病斑部分,因此將解碼網絡卷積層Conv14通道數設為2,并在其后面增加一個像素級分類器SoftMax,將分類器的分類個數也設置為2。

在以上分析的基礎上,構建病斑分割網絡RS-Net。其結構如圖4所示,主要包括編碼網絡(Encoder Network)和解碼網絡(Decoder Network)兩個子網絡。其中編碼網絡和解碼網絡的卷積層數均為13,而且與池化索引對應的卷積層大小相同,每個卷積層的滑動步長(stride)設為1,為使輸入與輸出圖像維度不變,將邊界擴充Pad參數設置為1。池化層(Pooling_1~Pooling_5)均采用最大池化(Max Pooling)操作,池化層大小設為2×2,滑動步長設為2。上采樣層(Upsampling_1~Upsampling_5)的采樣尺度(scale)設為2。

圖4 RS-Net網絡模型結構

2.2.3 模型訓練

在CNN訓練過程中,需要利用大量的訓練樣本對網絡模型參數進行更新,提高網絡模型性能。使用構造的訓練數據集圖像對級聯卷積神經網絡(CCNN)進行訓練,從而得到分割精度高、運行速度快的網絡模型。但在訓練樣本數較少或訓練集內容相似度較高的情況下,模型容易產生過擬合或分割效果差等問題。為提升網絡模型的訓練效率以及分割性能,CCNN采用遷移學習的方式對網絡進行訓練。利用遷移學習對模型參數進行初始化可以使模型提取特征具有級層特性,使用淺層網絡提取圖像的低層初級特征,使用深層網絡提取圖像的高層語義特征。其中低層特征主要包括顏色、邊緣等初級信息,使用不同數據集對網絡進行訓練所得到的低層特征較為相似。因此當數據集規模較小時,利用遷移學習的方式將在大規模數據集上得到的低層信息移植到所要訓練的網絡模型中,不僅解決模型的過擬合問題,而且減少了模型訓練時間[22]。

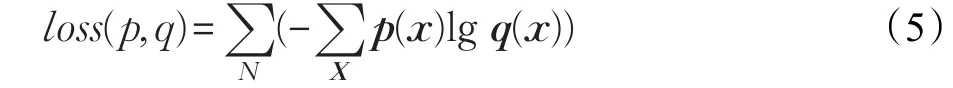

評定模型性能主要通過計算分割圖像與標注圖像之間的差異。通過計算標注圖像與分割圖像之間的交叉熵值來評定模型訓練的效果。交叉熵函數是神經網絡中常用的模型性能評價指標,當交叉熵值越小,表明模型的訓練效果越好。在CCNN的訓練過程中,將標注圖像與分割圖像的每一個像素點進行計算交叉熵并取平均值,利用平均像素交叉熵損失函數評定CCNN的訓練效果。平均交叉熵損失函數如下:

式中,p(x)為標注圖像的像素分類向量,q(x)為分割圖像的像素分類向量,N為圖像包含的總像素個數,X表示輸入圖像的特征向量,x為輸入圖像每個像素的特征向量。

由式(5)得到像素間損失值后,利用反向傳播算法將損失值回傳到網絡模型的每一個卷積層中,對卷積層的權重參數進行更新,經過多次循環迭代,直到輸出損失值穩定時結束訓練。

3 實驗與結果

在作物病害葉片圖像數據集上驗證所提出的物理模型,并與已有的模型Hseg、FCN8s、SegNet、JointSeg和DeepLab分割算法進行性能對比。實驗軟件環境為Ubuntu 16.04 LTS,使用Matlab編程,硬件環境為Intel?core?i7-7550k cpu@3.60 GHz處理器,RAM為32 GB,GPU為GTX1080Ti的PC機上進行實驗。深度學習開發框架為Matconvent。

3.1 實驗參數設置及訓練過程分析

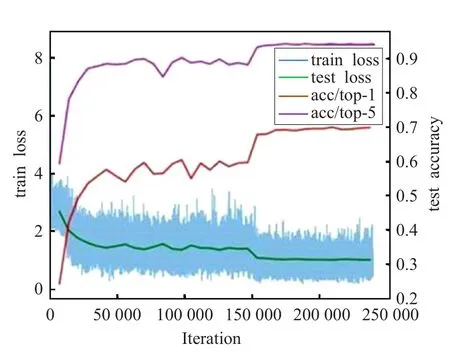

實驗過程采用批量訓練方式。將構建后的訓練集、驗證集和測試集圖像以批次(Batch)的形式送入網絡模型中,訓練集中共包含650幅圖像,將每10幅圖像分為一個批次,完成模型的訓練共需要65個批次。為保障模型的訓練效率以及分割精度,使用訓練集圖像對模型進行700次遍歷(Epoch),模型的迭代次數設置為250 000次。使用梯度下降和反向傳播算法對模型的權重參數進行更新,將學習率設置為1×10?10。由于使用帶動量的梯度下降算法,為防止模型出現過擬合現象,設置動量因子為0.99。利用驗證集對模型權重參數進行局部修正。訓練集和驗證集的損失值和準確率變化曲線如圖5所示。

圖5 模型損失值和準確率變化曲線

從圖5中看出,隨著模型不斷增加迭代次數,訓練集和驗證集的損失值在不斷下降,但訓練集的變化波動范圍比較大,這是因為在模型參數的初始訓練階段需要進行大量的迭代訓練,當次數不斷增加時訓練集loss值趨于穩定;驗證集的變換曲線波動較小,而且隨著迭代次數的增加,驗證集loss值也逐漸減小,當迭代200 000次時,loss值趨于穩定,主要是因為驗證集優化了模型參數提高了模型性能。準確率曲線總體趨于上升趨勢,隨著迭代次數的增加像素的分類準確率不斷提高,其中top-1準確率是將像素分為兩類的準確率,即葉片的正常區域和病斑區域被分為兩類的準確率;top-5準確率表示將像素分為多類的準確率,即對葉片的病斑區域和正常區域產生誤分的概率;從圖5中可以看出像素的分割準確率在持續上升,當模型的loss值基本收斂時,模型的top-1準確率達到最高,表明模型達到了較好的訓練效果。

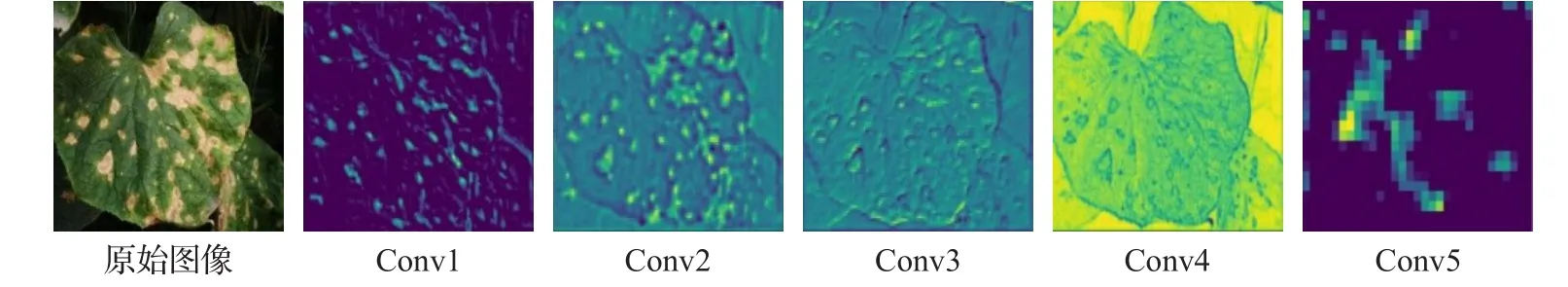

3.2 可視化分析

卷積神經網絡的訓練過程中,卷積層用于對輸入圖像進行特征提取,而且不同卷積核所提取的特征不同[23]。其中淺層卷積核主要提取圖像的初級特征,主要包括顏色和輪廓等;深層卷積核提取圖像更多的語義特征,包括紋理和細節特征。為更好地顯示不同卷積核所提取到的不同特征,將卷積核和特征圖進行可視化。圖6和圖7分別為不同卷積層的卷積核和得到的特征圖。從圖6可以看出,卷積核(Kernel1~Kernel3)顯示的信息較為粗糙,卷積核(Kernel4~Kernel5)顯示更多的細節特征。由圖7可以看出,卷積層(Conv1~Conv3)得到的特征圖主要為圖像輪廓特征,卷積層(Conv4~Conv5)得到的特征圖主要包含圖像的紋理特征。圖6和圖7的可視化結果充分體現了卷積神經網絡的權值共享技術,隨著卷積層數的不斷增加,模型獲取了輸入圖像更多的細節特征,同時說明模型訓練過程中不同卷積核能夠得到輸入圖像的不同特征,各卷積核分別關注圖像的不同部分,能夠充分學習各自關注部分的圖像顯著區域,為后續圖像的精準分割打下基礎。

圖6 Conv1~Conv5的卷積核

圖7 Conv1~Conv5的特征圖

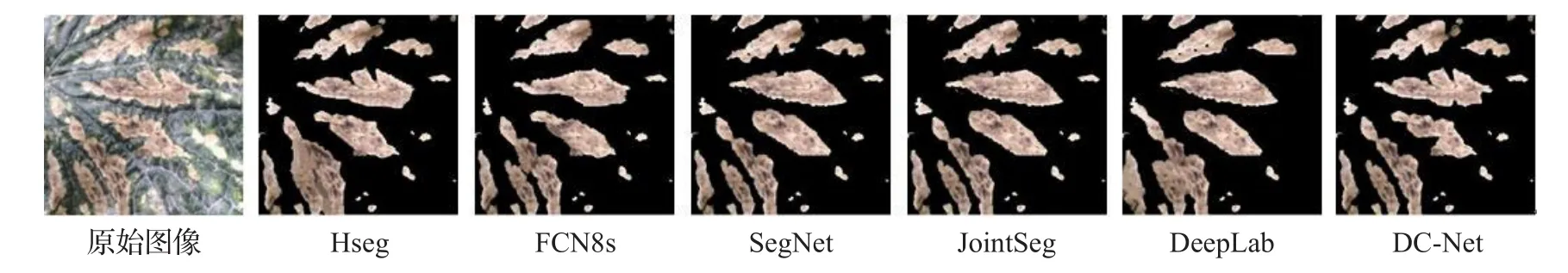

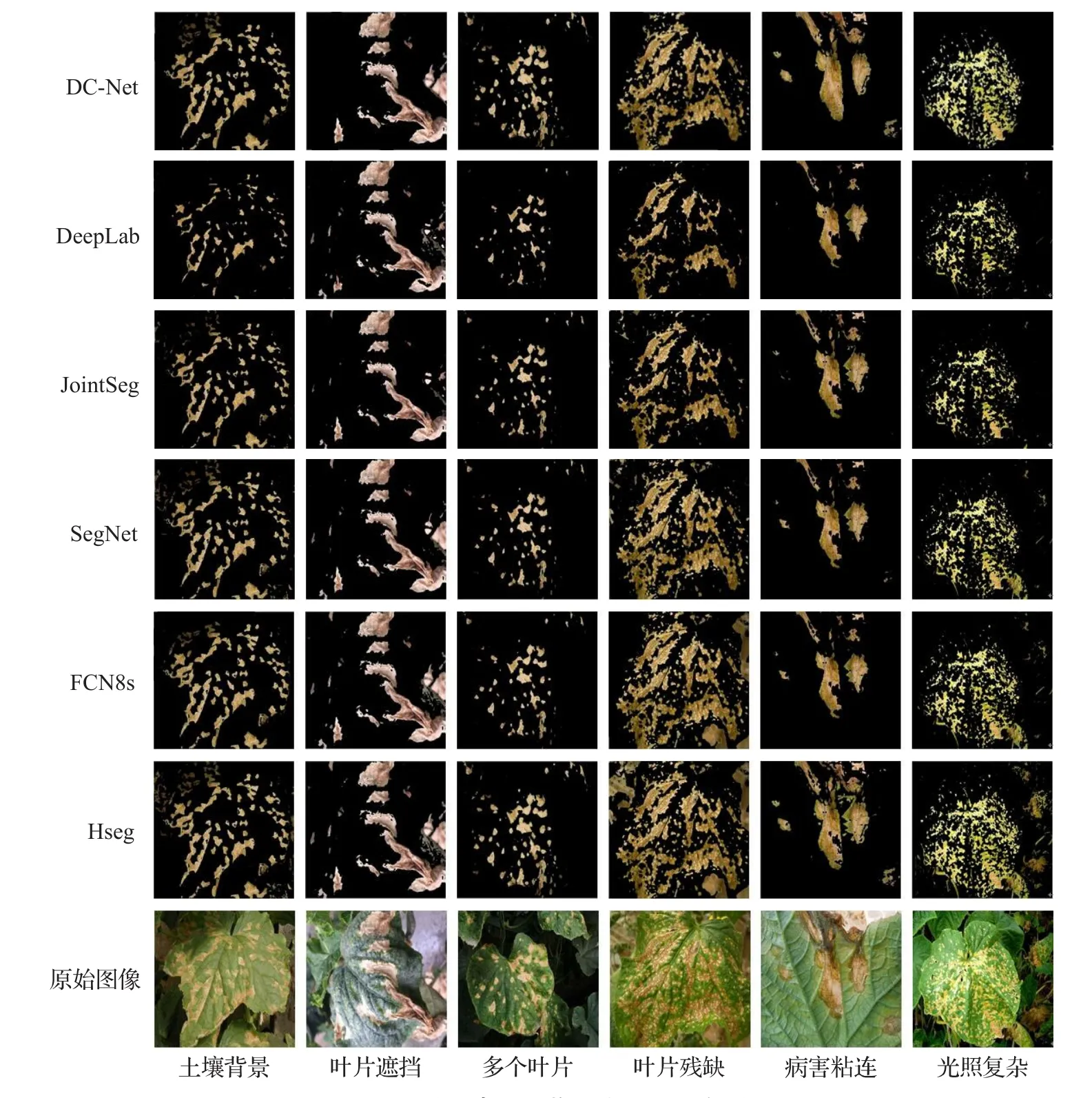

圖8 不同分割方法的病斑分割效果

3.3 結果與分析

利用150幅自然場景的作物病害葉片圖像作為測試集對網絡模型分割效果進行測試。為了更客觀地評價病害葉片的分割效果,引入分割精確度P、召回率R以及平均F值作為評價指標,衡量分割結果與實際標注圖像之間的差異。其中分割精確度P是反應病害葉片區域與真實病斑區域之間的相符程度;召回率F是正確分割的樣本數占總體樣本數的比例;平均F值則將分割精度P與召回率R結合起來綜合考慮,反映整體精度的評價指標。由于分割時間是評價模型實用性的關鍵技術指標,使用單幅圖像分割時間作為衡量分割速度的時間指標。分割精度P、召回率R以及綜合評價指標F值計算如下:

式中,TP為經過分割網絡得到的分割結果與原始葉片病斑區域的重合部分;TN為分割出的葉片正常區域與原始葉片正常區域的重合部分;FP為分割結果中不屬于病斑區域的部分,FN為不屬于正常區域的部分。

不同分割方法得到的分割結果如圖8所示。從分割結果中可以看出Hseg分割方法將大部分正常區域誤分為病斑區域,無法完成葉片病害的分割任務;采用FCN8s網絡模型進行分割時效果好于Hseg,而且從分割結果中不難看出該方法能夠分割出病害的大致輪廓,但對細小病斑部分的分割效果較差;SegNet分割網絡使用與所提出的RS-Net相同的網絡結構,能夠取得較好的分割效果,但該方法對于葉片的邊緣病斑區域分割效果較差,分割精度有待提升;JointSeg網絡模型對于邊緣區域的分割效果優于SegNet,而且對病斑的細節部分能夠實現完整分割,但分割結果受光照的影響較大,當分割光照較強的病斑區域時,出現了明顯的誤分割現象;DeepLab[24]網絡模型能夠完整分割出葉片中的病斑區域,而且對細小病斑區域的分割效果較好,但是當葉片中病斑出現粘連情況時,該方法不能將粘連病斑進行分割,產生較多的誤分割現象。而方法首先通過RD-Net模型對葉片病斑區域進行定位,確定了葉片中病斑區域的具體位置;然后利用基于編解碼網絡架構的RS-Net模型對定位后的病斑區域進行分割,保證病斑區域分割的完整性;由于葉片中病害的邊緣部分難以分割,而且容易產生誤分割現象,因此利用形態學優化層對分割后結果進行優化,在保證病斑區域分割完整性的同時,增強了對細節部分的分割效果。

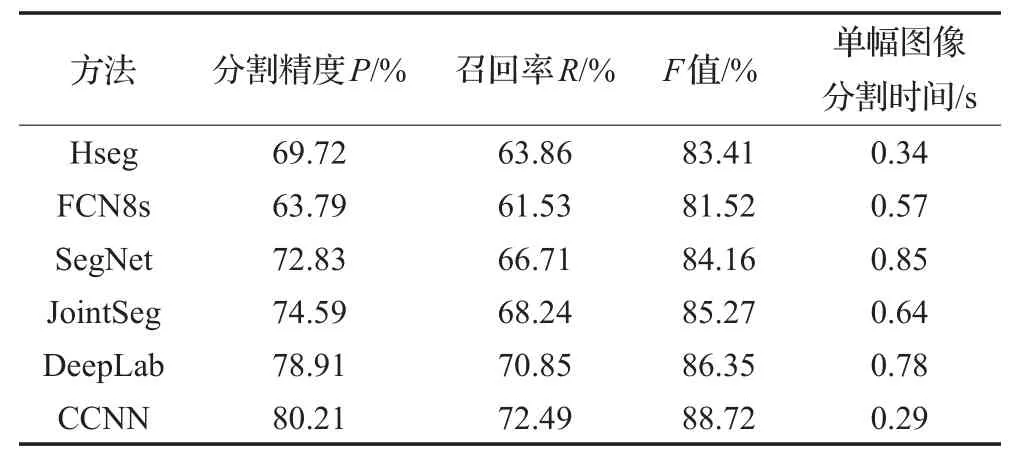

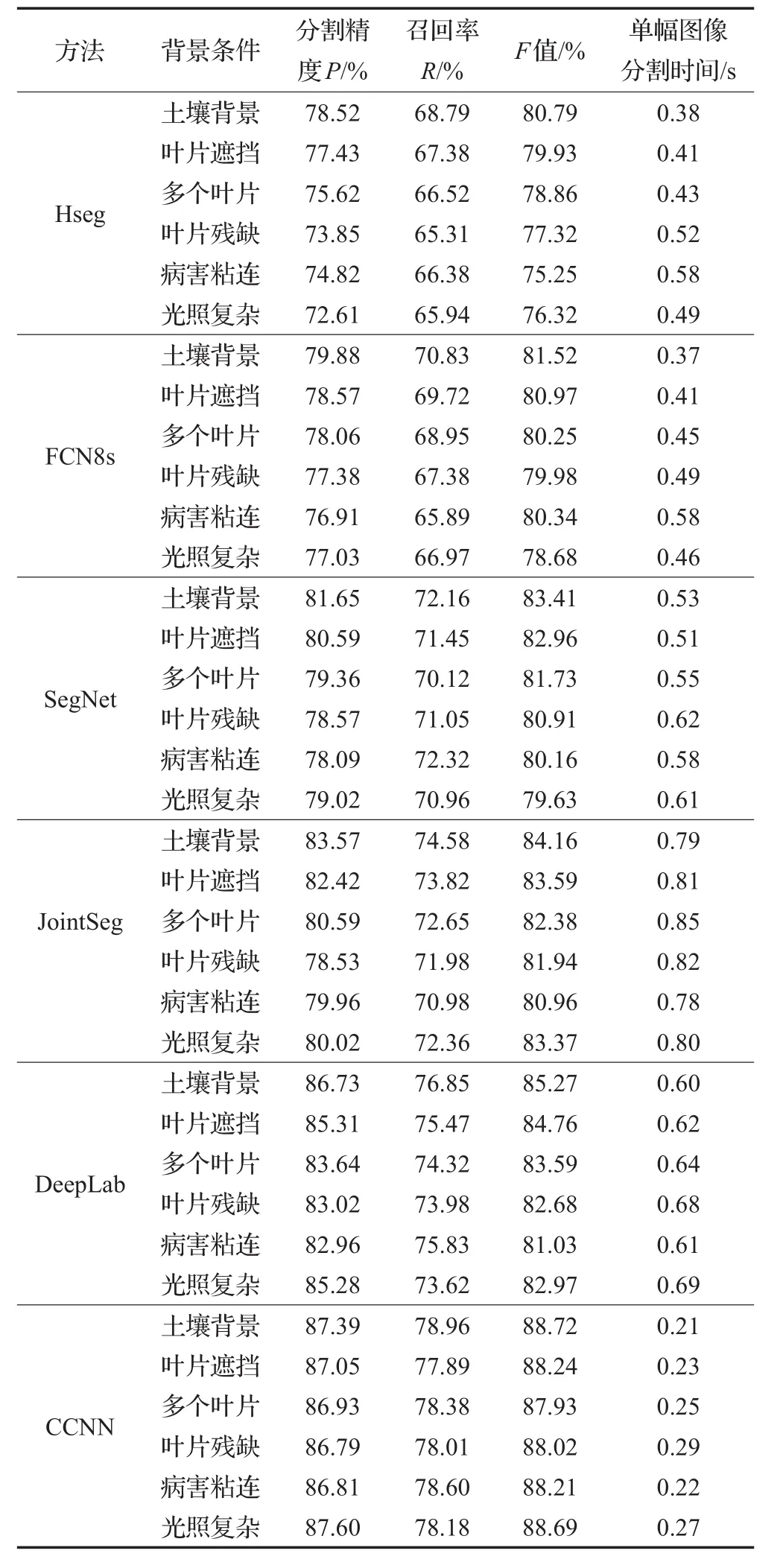

為量化不同分割方法的分割性能,分別對這些方法求取分割精確度P、召回率R、平均F值(F-measure)以及單幅圖像分割時間,如表1所示。

表1 不同方法分割作物葉片圖像的性能比較

從表1中看出,CCNN方法的分割精度P、召回率R以及F值最高,分別為80.21%、72.49%和88.72%。盡管DeepLab網絡模型與CCNN使用相同的分割網絡架構,但CCNN在性能評價指標上分別高出1.3%、1.64%和2.37%,主要是由于CCNN在模型的第一階段構建了區域定位網絡,對病害部分進行精確定位,大范圍減小了模型的誤分割現象。FCN8s使用反卷積過程恢復圖像分辨率優化分割結果,但該方法的下采樣操作弱化了模型的特征提取能力,導致其對小面積病斑區域的分割能力較差,因此其分割性能指標較差。CCNN與傳統基于閾值分割方法的Hseg相比較,在分割性能上遠優于Hseg分割算法,主要由于Hseg是通過設定固定閾值對圖像進行分割,所以分割結果較差。SegNet和JointSeg都是基于空洞卷積的分割模型,空洞卷積能夠擴大原始卷積核的局部感受野,但有些病斑區域在整體葉片中所占比例較小,所以這兩種分割方法在性能評價指標上均落后于CCNN。根據以上結果能夠判斷CCNN具有較好的分割效果,對病斑區域的分割結果最接近于真實值,能夠滿足自然狀態下對病害葉片圖像分割的高精度要求。但由于作物葉片圖像的病斑區域邊界較為復雜且所占面積較小,同時部分病斑區域與正常區域的相似度較高,導致正常區域邊界與病斑區域邊界難以區分,所以從表1中看出算法的分割性能評價指標值仍然較低。

在單幅圖像分割時間上,CCNN方法的分割時間小于其他分割算法。由于SegNet和JointSeg均是使用空洞卷積的方式對網絡模型進行構造,所以網絡模型需要耗費大量的訓練時間,導致模型分割效率下降,對單幅圖像的分割時間較長,分別為0.85 s和0.64 s。Hseg方法不需要對模型進行訓練,但在分割后需要對每幅圖像進行形態學操作,所以需要耗費分割時間;FCN8s在分割時需要進行反卷積操作恢復圖像的分辨率,從而增加了單幅圖像分割時間;方法采取級聯的方式進行訓練,將區域定位網絡和區域分割網絡進行分階段訓練,而且使用了遷移學習的訓練方式,不僅減少網絡模型對硬件的需求,而且減少模型訓練時間。因此CCNN方法在單幅圖像分割時間為0.29 s,能夠滿足對病害葉片圖像病害葉片圖像分割實時性的需求。

為驗證所提出模型的魯棒性,分別使用不同分割算法在多種復雜背景下的作物病害葉片圖像上進行分割試驗,其中復雜背景主要包括待分割圖像中存在土壤背景、葉片遮擋、多個葉片、葉片殘缺、病害粘連、光照條件復雜等情況。針對每種復雜背景選取20幅圖像共120幅圖像進行魯棒性對比試驗,分割效果如圖9所示。表2為不同方法在不同復雜背景圖像的分割結果。

圖9 不同環境下作物病害葉片分割效果

表2 不同場景下分割方法性能對比

由圖9所示,在多種復雜背景下的分割結果中,CCNN網絡模型幾乎不受環境的影響,能夠有效地分割出作物葉片的病斑區域。在有土壤背景的分割過程中,SegNet分割方法將大面積的背景區域誤分為病斑區域,DeepLab方法分割效果較好,但對于小面積病斑區域分割精度不夠;當出現葉片遮擋情況時,幾種分割方法均出現誤分割現象,其中Hseg最為嚴重,無法對被遮擋部分的病斑進行分割;在多個葉片的分割環境下,幾種分割方法均出現分割不完整現象,未能將多個葉片中同時出現的病斑區域分割出來;在葉片殘缺的情況下,不同的分割方法均出現程度不一的誤分割現象,其中Deep-Lab分割方法將部分病斑區域誤分割為正常區域,而Hseg分割方法則將正常區域誤分為病斑區域;在病害粘連圖像中進行分割時,由于葉片中不同的病斑區域相似度較高,所以幾種分割方法都無法將粘連的病斑分割開來;對于復雜光照下的葉片分割問題,由于光照強度的增強,加大了分割的復雜度,導致幾種分割算法都將背景區域的病害部分誤分為病斑區域。CCNN分割模型能夠有效分割出不同場景下的葉片病斑區域,分割效果受自然條件影響較小,穩定性較高,能夠滿足不同場景下的作物病害葉片分割任務。

從表2看出,CCNN網絡模型性能最佳,分割精度P的最大值與最小值之間的差值僅為0.81%,召回率R最大值與最小值之間的差異僅為1.07%,綜合評價指標F值最大與最小之間的差值僅為0.79%,表明CCNN對于不同場景下的分割結果相差極小,該方法具有較強的魯棒性。其他幾種分割算法在包含土壤背景的條件下分割精度較高,表明土壤背景對不同分割方法的結果影響不大;在葉片遮擋、多個葉片和葉片粘連的分割場景中,指標值出現不穩定現象,但總體指標值波動范圍較小,說明分割方法能夠適應稍微復雜的分割場景;當對處于病害粘連和光照復雜場景的葉片進行分割時,幾種分割算法指標值均出現下降現象,表明病害粘連和復雜光照對分割效果影響較大;在單幅圖像分割時間上,CCNN均低于其他分割方法,多個場景下的單幅圖像平均分割時間為0.24 s。

4 結語

針對傳統的作物病害葉片圖像分割難題,提出了一種級聯卷積神經網絡(CCNN)的作物病害葉片分割方法。首先利用區域定位網絡(RD-Net)對葉片中的病害部分進行精確定位,減少背景干擾;再利用基于Encoder-Decoder結構建立的區域分割網絡對定位后的病斑區域進行精確分割。為驗證算法的魯棒性,將CCNN分割模型與其他分割方法在不同場景下進行分割試驗,結果表明CCNN網絡模型能夠完成不同場景下的病害分割任務,而且所有評價指標均為最高。在分割時效性上,CCNN優于其他分割方法,單幅圖像的分割時間僅為0.21 s,表明該方法能夠滿足對病害分割時效性的需求。實驗結果表明,本文提出的病害葉片分割方法的分割精度高、運行速度快,能夠完成對作物病害葉片分割的實時性要求。但該方法只能完成小范圍場景內的分割任務,對于大范圍場景或者惡劣環境下病害葉片分割問題有待研究,而且通常在自然場景下單個葉片中會包含不同的病害類型,或者有些病害在葉片中所占比例極小,這些情況都會給病害精準分割帶來挑戰,以后進一步對本文所提出的方法進行優化。