微表情類別與區域間關聯度的分析方法研究

張延良,盧 冰,蔣涵笑,洪曉鵬,趙國英,張偉濤

1.河南理工大學 物理與電子信息學院,河南 焦作454000

2.西安交通大學 電子與信息工程學院,西安710049

3.奧盧大學 機器視覺和信號分析研究中心,芬蘭 奧盧FI-90014

4.西安電子科技大學 電子工程學院,西安710071

1 引言

微表情是無意識下非自主控制的面部表情,它通常出現在人們想要掩藏和抑制他們真實情感的時候[1-3]。微表情識別能夠檢測謊言、揭示真實情感,因此它廣泛應用在心理診斷、公共安全、審訊等領域[4-5]。與常規表情相比,微表情出現在面部區域的面積更小,肌肉動作幅度更輕微,而且速度非常快(在1/25~1/3 s之間),因此運用計算機自動識別微表情具有相當的難度。

微表情識別的研究主要集中在特征提取和分類上。賁晛燁及張軍平分別[6-7]對微表情識別中的一些關鍵技術進行了綜述。芬蘭奧盧大學趙國英等人最早用動態紋理描述子LBP-TOP 算子提取微表情特征[8]。后續又出現了許多對該描述子的改進方法,如CBP-TOP[9]、LBP-SIP[10]、STCLQP[11]等。文獻[12]以光流場為描述微表情運動模式的基礎特征,提出用面部動力譜特征進行微表情識別。不同的微表情數據集是在不同的環境下用不同的拍攝設備建立的,文獻[13-14]運用遷移學習的方法研究了跨庫微表情識別的問題。文獻[15]運用遷移學習深度神經網絡研究了小樣本集微表情識別的問題。

這些方法大多是通過對面部全局區域進行無差別分塊,然后將各塊的時空模式特征串聯構成總的特征向量用于分類。這種基于全局區域的方法忽略了微表情類別與各局部區域之間的聯系。

心理學研究發現,不同類別的微表情出現在面部區域位置也不同[3],如高興體現為臉頰和嘴角區域的肌肉動作(表現為臉頰提升和嘴角上揚)、驚奇出現在眉毛和嘴部區域(表現為眉毛上提和雙唇微張)等。通過大量觀察發現,面部產生微表情的同時,也存在與微表情無關的面部動作變化。因此,準確剔除與微表情無關的面部區域,只提取與微表情緊密相關的局部區域的特征,是提高識別效果的關鍵所在。這就要求研究微表情類別與面部各局部區域的關聯度,找出微表情經常發生的關鍵區域。

本文提出了一種劃分面部關鍵局部區域及分析它們與微表情類別關聯度的方法。首先根據各類微表情對應動作單元所在的位置信息確定出人臉最為關鍵的局部區域,即眼睛、鼻子、嘴巴、下巴及面頰等,然后采用面部形變鑒別模型自動檢測出的面部關鍵點并自動劃分出這些區域塊。通過分析各區域塊對各類微表情進行分類的準確率來確定兩者之間的關聯度。

2 全局區域方法與局部關鍵區域塊的劃分

2.1 全局區域微表情識別

全局區域的微表情識別是把整個面部圖像作為研究對象,再將人臉分割為若干個重疊或者不重疊的塊[4,8,16],如圖1 所示。其中,圖(a)中人臉被劃分為不重疊的9×8 個區域塊,圖(b)中人臉被劃分為相互重疊的4×3 個區域塊。在每個區域塊上分別提取局部區域時空模式特征,然后將串聯后的特征作為整幅圖像的特征向量,過程示意圖如圖2所示。最后將特征向量輸入分類器實現微表情的分類。

圖1 人臉分割區域塊

圖2 特征向量的提取

全局區域的微表情識別,在全面地提取到人臉特征的同時,也會提取到與微表情無關區域的肌肉動作,從而降低識別的效果。為了剔除這些無關區域,需要確定面部各局部區域與微表情的關聯度。

2.2 面部動作單元與特定微表情的關系

面部動作編碼系統(Facial Action Coding System,FACS)是美國心理學家Ekman 和Friesen 為客觀進行人類面部表情識別而制定的[17]。該系統定義了46 個動作單元(Action Units,AUs),其中的32個AUs與面部肌肉動作有關,每個AUs描述面部一個局部肌肉群的特定動作模式。例如AU1表示眉毛內端上揚,AU10表示上嘴唇上揚等。任何一個面部表情都可以認為是由一個或者若干個AUs 的組合運動引起的。6 種常規表情與相應AUs的對應關系,如表1所示[17]。

微表情是人在高度緊張等特殊情形下面部肌肉的短暫、輕微動作,其與AUs的對應關系與常規表情不同。例如,“厭惡”在常規表情時對應AU9+AU15+AU16,但在微表情出現時對應AU9 或者AU10 或者AU4+AU7。微表情數據集CASME2的建立者中科院心理所傅小蘭課題組從該數據集中總結的微表情與相應AUs 的對應關系,如表2所示[3]。

表1 常規表情與相應FACS AUs的對應關系

表2 微表情與相應FACS AUs的對應關系

2.3 人臉局部區域塊的自動劃分

依據表2 中給出的與微表情類別相應AUs 所在的面部區域位置,可以將面部區域劃分為7 個局部區域塊,如圖3 所示。其中,1、2 局部區域塊為眼睛,3 為鼻子,4為嘴巴,5、6為臉頰,7為下巴。每塊區域都是一個或幾個面部動作單元的組合,所對應的FACS AUs如表3 所示[18]。對表2 和表3 進行比較可知,本文所劃分的7個局部區域塊完整涵蓋了各微表情類別所對應的全部FACS AUs,并且剔除了與微表情無關區域,有效避免了無關區域對微表情識別的影響。

圖3 局部區域塊的劃分

表3 面部區域劃分及其對應的FACS AUs

對于局部區域塊的自動劃分,首先要進行面部關鍵點的定位。本文采用一種判別式算法—形變鑒別模型方法[19],它不同于經典的主動外觀模型方法(Active Appearance Model,AAM)[20],是自動標識人臉的49 個關鍵點坐標,可以實現面部模型的增量學習,因此對關鍵點的定位精度高,同時速度也很快,可以達到80 f/s。依據這一方法可以實現上述區域塊的自動提取。圖4展示了49個關鍵點位置坐標,依據相應的關鍵點坐標,分割出人臉的7 個矩形局部區域塊。矩形區域框的位置和大小取決于4個邊界(即上、下、左、右)對應的坐標點,這7個區域塊邊界對應的坐標點,如表4所示。

圖4 49個關鍵點位置

表4 各局部區域邊界坐標點

3 局部時空模式特征提取

局部二值模式(Local Binary Patterns,LBP)是由Ojala 等人[21]在1996 年最先提出的,并成功地將其應用在紋理分類中。LBP 算子是一種有效的局部紋理描述子,可以度量和提取灰度圖像中局部近鄰區域的紋理信息。其特點是計算簡單且對光照變化不敏感,具有旋轉不變性和灰度值單調變化的不變性。它是以一個像素點為中心,對該像素點周圍像素的灰度值進行運算,然后對每個像素點賦予不同的權值,計算結果表示中心像素點的LBP值。

式中,是一個符號函數,gc表示中心點像素值,gp表示鄰域內的一個像素值。鄰域像素的灰度值與中心像素點灰度值進行比較,大于或等于中心像素點灰度值時標記為1,反之,標記為0。將所有的0和1串聯,形成一個二進制數作為中心像素點的局部二進制模式。圖5給出了鄰域像素點數p=8 時,計算一個像素LBP 模式的過程。通過統計紋理圖像中所有像素對應的LBP 模式出現頻率的直方圖作為該圖像的特征向量。

圖5 LBP計算過程

LBP算子主要用于靜態紋理分類中,為了將LBP從2D 擴展到3D,Zhao 等人[16]提出考慮3 個正交平面上二維LBP模式的LBP-TOP描述子。將每個正交平面上的特征向量進行串聯,如圖6所示。可以把這個視頻序列當作一個長方體,那么可以獲得該圖像序列的3個正交面XY、XT、YT。XY平面提供了空域信息,XT和YT平面提供了人臉圖像隨時間變化信息。

圖6 特征描述子LBP-TOP

然而,LBP-TOP 的向量維度是3×2p,p是鄰域點個數。這樣高的維度增加了計算成本,降低了識別的性能。為了克服這一缺點,采用UniformLBP描述子[22],在一個平面上的向量維度從2p降到p(p-1)+3,從3 個平面(XY、XT和YT)上提取出來的特征向量串聯起來作為LBP-TOP特征。

4 實驗結果與分析

本文采用的是中科院心理研究所建立的CASME2微表情數據集。該數據集里面的微表情視頻序列全部采用自然誘發的真實微表情,在拍攝過程中,要求所有參與者在出現自然的、動態的微表情前后,均保持中性表情。該數據集包括26 個測試者的微表情視頻序列,表情類別有高興、厭惡、驚奇、壓抑、悲傷、害怕及其他共7種。由于數據集中悲傷、害怕這兩種微表情樣本較少,故本文實驗中涉及到的微表情類別是剩余的5 種,共247個視頻序列。

在進行人臉區域塊劃分和特征提取分類的實驗之前,需要首先對微表情視頻序列進行人臉對齊。采用主觀形狀模型(Active Shape Model,ASM)自動標定所有視頻序列人臉圖像的68 個關鍵點[23],以這些點為基礎,運用局部加權平均算法計算每個視頻序列的第一幀面部圖像與模板面部圖像的形變關系矩陣,將這一矩陣作用于對應序列的其他圖像。這一人臉對齊步驟,可以較好的消除不同人臉、不同序列在無表情狀態下的形狀和位置差異,從而提高后續操作的精確度。

為了科學分析各類微表情與2.3節劃定的局部關鍵區域的關聯度,在每個區域上分別提取LBP-TOP特征,并利用支持向量機進行微表情分類。采用留一交叉驗證法對各區域的識別效果進行評判。在該方法中,選擇一個測試者的視頻序列作為測試數據,其他測試者的視頻序列作為訓練數據。這個過程重復K次,K=26 是數據集中被測者的數量,然后綜合26 次的識別效果以形成最終的分類準確率。本文以分類準確率作為評判標準,實驗的運行環境是MATLAB R2016a。

4.1 全局區域和局部區域對比實驗

本章對比全局區域和局部區域兩類方法的微表情分類準確率,以檢驗本文劃分的各局部區域對微表情識別的有效性。在提取面部局部時空模式LBP-TOP特征時,需要設置如下參數,鄰域像素點數p,鄰域半徑r,時空區域塊劃分方法(n,m,t),其中n、m及t分別是沿X軸、Y軸及T軸的等分數目。

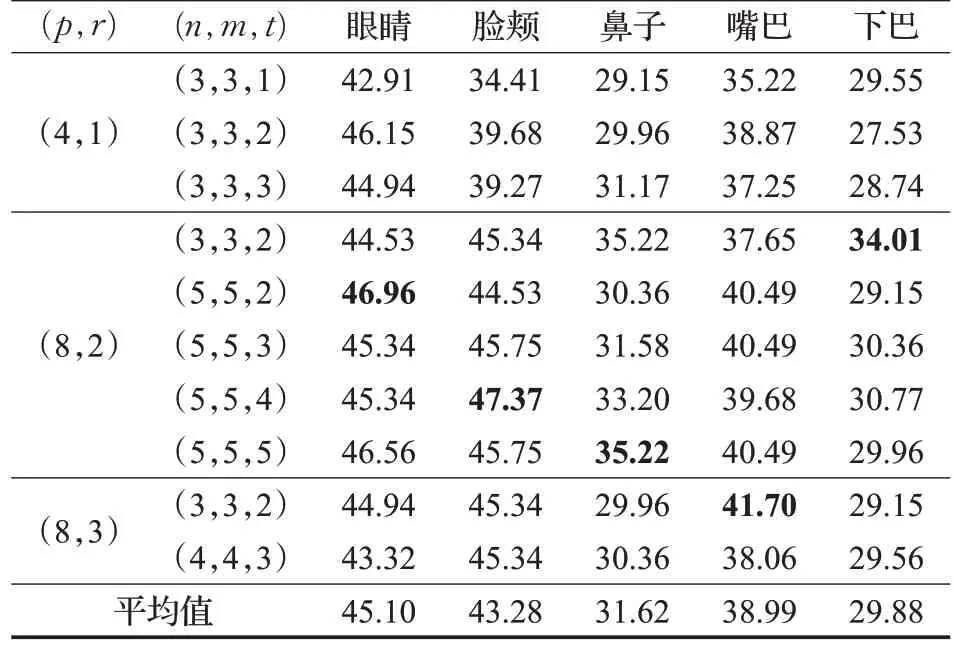

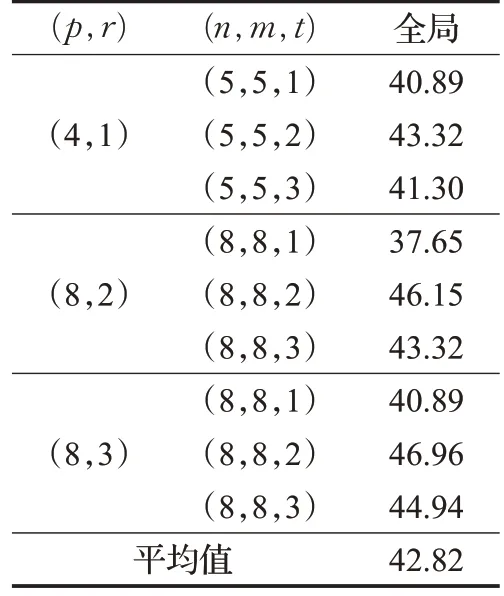

表5列出了各局部區域塊在不同參數組合下的微表情分類準確率及平均值,表6列出了全局區域方法在不同參數組合下的分類準確率及平均值。在表中,各個區域在不同參數組合情況下的最佳分類準確率加粗標示。從表5 及表6 中可以看出,全局區域方法對微表情的平均分類準確率為42.82%,臉頰、眼睛區域的平均分類準確率分別為45.10%、43.28%,高于全局區域方法的平均分類準確率。這說明臉頰和眼睛區域是各類微表情動作比較集中的區域,由于舍棄了全局方法中與微表情動作無關區域的特征,使其在較小的觀測區域內實現了比全局方法更好的識別效果。而鼻子、嘴巴、下巴等局部區域對微表情的平均分類準確率分別為31.62%、38.99%、29.88%,低于全局方法的分類準確率。原因是這些區域與單一微表情動作有關,而僅用其中一個區域實現對全部種類微表情的識別,勢必會降低整體的分類準確率。

表5 各局部區域不同參數組合下的分類準確率%

表6 全局區域方法不同參數組合下分類準確率 %

4.2 局部區域與微表情類別關聯度實驗

本部分實驗通過各局部關鍵區域對各微表情類別分類準確率的混淆矩陣[24]來分析兩者之間的關聯度。心理學研究發現,不同類別微表情的發生區域有一定的規律。因此,可以通過局部區域對各微表情類別識別的準確率高低來估計兩者之間的關聯程度。具體來說,某區域對某類微表情的識別準確率高,意味著這類微表情在該區域發生的概率較高,兩者有較高的關聯度,反之亦然。

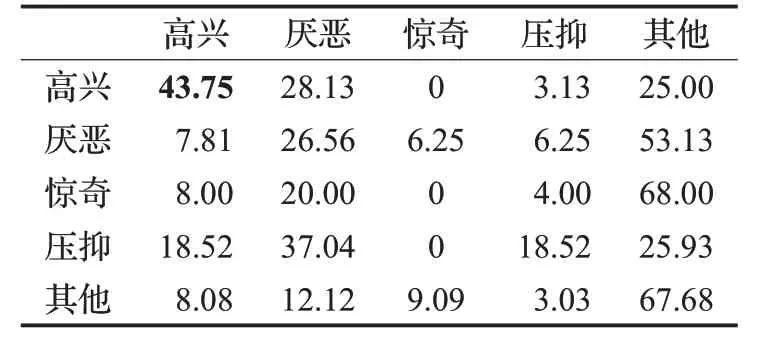

不失一般性,這里列出了在4.1 節最優參數組合下各局部區域對微表情進行分類得到的混淆矩陣。由于在CASME2 數據集里標定為“其他”的類別,不是某種特定的微表情,而是除了主要微表情類別之外其他多種微表情的集合。因此,這里僅分析微表情類別“高興”“厭惡”“驚奇”、“壓抑”與各局部區域的的關聯度。眼睛、臉頰、嘴巴、鼻子及下巴區域的混淆矩陣分別如表7~11所示。混淆矩陣中,主對角線上的元素給出了各類微表情正確識別率(準確率較高的元素已加粗顯示),其他元素給出了將某類微表情(縱軸所示)誤識別為另一類微表情(橫軸所示)的比率。混淆矩陣每一行元素的和為100%。

表7 眼睛區域的混淆矩陣%

表8 臉頰區域的混淆矩陣%

表9 嘴巴區域的混淆矩陣 %

表10 鼻子區域的混淆矩陣 %

表11 下巴區域的混淆矩陣%

從表7中可以看出,眼睛區域對“高興”識別準確率是18.75%,將“高興”誤識別為“厭惡”“壓抑”的比率均為9.38%;該區域對微表情“厭惡”和“驚奇”的識別準確率分別是46.88%和52%,說明這兩種微表情在眼睛區域發生的概率較高,表明眼睛區域與微表情“厭惡”和“驚奇”的關聯度較大。

如表8所示,臉頰區域對“高興”和“厭惡”的識別準確率均為40.63%,表明臉頰區域與“高興”和“厭惡”的關聯度較大。

表9列出了嘴巴區域識別率的混淆矩陣,從表中可以看出,嘴巴區域對“高興”識別準確率為43.75%,表明嘴巴區域與“高興”的關聯度較大。

從鼻子區域識別率混淆矩陣表10 中可以看出,鼻子區域對“高興”“厭惡”“驚奇”“壓抑”4種微表情的正確識別率均低于誤識別率,說明鼻子區域與各種微表情均沒有顯著的關聯度。

從表11 中可以看出,下巴區域對“壓抑”識別準確率為40.74%,表明下巴區域與“壓抑”的關聯度較大。

綜合上述實驗結果,可以得出,微表情“驚奇”及“厭惡”與眼睛區域、微表情“高興”與嘴巴區域、微表情“壓抑”與下巴區域有較高的關聯度。

此外,對CASME2 數據集中測試者中性表情和微表情發生時的面部圖像進行了對比,從主觀感受角度分析微表情類別與局部區域的關系。圖7列出了部分“高興”“厭惡”“驚奇”“壓抑”的微表情樣本,用方框圈出了微表情發生時肌肉動作明顯的區域。通過對比分析,發現微表情“驚奇”和“厭惡”與眼睛區域、“高興”與嘴巴區域、“壓抑”與下巴區域有較高的關聯度,這和實驗結果相符,進一步印證了相關結論。

圖7 CASME2數據庫不同情緒下的微表情樣本

5 結束語

不同于常規表情,微表情具有動作幅度和區域小、持續時間短的特點。現有的基于全局區域的微表情識別方法是建立在對面部進行無差別整體分塊的基礎上,忽略了微表情類別和局部關鍵區域的關聯。本文提出的面部關鍵區域劃分方法,充分利用了微表情發生時對應動作單元的位置信息。更進一步,本文通過分析各局部區域對各類微表情的分類準確率,從定量角度分析了所劃分區域和各微表情的關聯度。本文的有關結論是在分析CASME2數據集的247個微表情樣本得出的,樣本數量較少,后續需要在更廣泛的微表情數據集上展開研究,以期得出更為詳盡乃至數量化的微表情類別與面部各區域的關聯度結果。本文的有關結論,為后續設計更為科學、高效的微表情識別算法提供了有益的指導。