基于深度學(xué)習(xí)的大型食草動(dòng)物種群監(jiān)測(cè)方法

羅巍 陳曙東 王福濤

摘要:借助無人機(jī)遙感手段對(duì)分布在青海省瑪多縣的大型食草動(dòng)物進(jìn)行監(jiān)測(cè)。監(jiān)測(cè)對(duì)象包括家養(yǎng)藏羊、家養(yǎng)牦牛、馬3種家養(yǎng)食草動(dòng)物和藏原羚、藏野驢、巖羊3種野生食草動(dòng)物。運(yùn)用深度學(xué)習(xí)模型mask r-cnn對(duì)航拍影像中的各類大型食草動(dòng)物進(jìn)行檢測(cè)和定位,得到的召回率、正確率、漏識(shí)別率均值分別為89%、98.4%、10.8%。通過提取Mask R-CNN檢測(cè)過程中生成的掩膜獲取動(dòng)物的輪廓矢量,進(jìn)而可以估算出各類大型食草動(dòng)物的種群數(shù)量和分布信息。通過與青海省草原總站提供的家畜存欄信息對(duì)比,兩者的差值百分比分別為家養(yǎng)藏羊7.5%,家養(yǎng)牦牛為8.8%,馬為2.8%。

關(guān)鍵詞:大型食草動(dòng)物;無人機(jī)遙感;深度學(xué)習(xí);目標(biāo)檢測(cè);種群分布;種群密度

中圖分類號(hào):S127?? 文獻(xiàn)標(biāo)志碼: A? 文章編號(hào):1002-1302(2020)20-0247-09

隨著遙感影像分辨率的提高和計(jì)算視覺技術(shù)的不斷發(fā)展,研究人員開發(fā)了許多自動(dòng)或半自動(dòng)的動(dòng)物識(shí)別和計(jì)數(shù)方法[1-4],但到目前為止大多數(shù)研究?jī)H停留在小范圍試驗(yàn)水平上,研究區(qū)域通常僅數(shù)平方公里或數(shù)張影像,且要求監(jiān)測(cè)對(duì)象與背景差距較大,環(huán)境較為單一[5-6]。一般來說,圖像識(shí)別與分類算法主要分為基于像素和基于對(duì)象2種。其中,基于像素的方法是最常用的、最簡(jiǎn)單的自動(dòng)或半自動(dòng)動(dòng)物識(shí)別方法,主要包括監(jiān)督分類、非監(jiān)督分類、閾值分割法(thresholding)等[7-9]。使用的影像主要為分辨率較低的衛(wèi)星影像[5,10]和熱紅外航空影像[9,11],因?yàn)閯?dòng)物在這些影像上通常只有幾個(gè)像素,面向?qū)ο蟮姆椒◣椭邢轠2,5,9]。監(jiān)測(cè)動(dòng)物包括雞[7]、琵鷺[8]、海豹[9]、考拉[11]、鹿[11]、南露脊鯨[12]、大紅鸛鳥[11]等。與基于像素的方法僅使用光譜、紋理等進(jìn)行對(duì)象識(shí)別相比,面向?qū)ο蟮姆椒ㄟ€可以使用分割對(duì)象的形狀、光譜、紋理、上下文背景等信息,因而通常精度更高[1]。一些研究嘗試使用基于對(duì)象分類法或融合基于對(duì)象和基于像素2種分類法來提高識(shí)別精度。Yang 等組合使用基于像素和基于對(duì)象2種分類法[13],開展了基于 GeoEye-1 影像的非洲角馬和斑馬識(shí)別,平均數(shù)量誤差僅8.2%,丟失對(duì)象 6.6%,錯(cuò)分對(duì)象 13.7%。Dominique等發(fā)展了一種基于面向?qū)ο蟮难Z識(shí)別與計(jì)數(shù)法,可適應(yīng)多種復(fù)雜的環(huán)境、多變的光照和曝光條件,獲得了較好的精度,與手動(dòng)計(jì)數(shù)法相關(guān)性達(dá)0.998,回歸系數(shù)為0.974[1]。雖然基于像素分類法或傳統(tǒng)面向?qū)ο蠓诸惙ê?jiǎn)單易行,有時(shí)也能取得較高精度,但由于需要人為選擇識(shí)別特征,精度受用戶的經(jīng)驗(yàn)技能影響較大[5-6,14]。

厘米級(jí)航空影像(含無人機(jī)影像)的出現(xiàn)提供了更為豐富的動(dòng)物特征細(xì)節(jié),相關(guān)的機(jī)器學(xué)習(xí)識(shí)別算法得到快速發(fā)展[15-17]。Christiansen等發(fā)展了一種基于離散余弦變換(discrete cosine transform,簡(jiǎn)稱DCT)特征提取和K最近鄰分類器 (k-NearestNeighbor,簡(jiǎn)稱KNN)從熱紅外影像中自動(dòng)識(shí)別野兔和雞的算法[7],當(dāng)飛行高度在3~10 m時(shí)識(shí)別精度達(dá)93.3%。Rey等發(fā)展了一種基于改進(jìn)支持向量機(jī)(EESVM)的主動(dòng)學(xué)習(xí)系統(tǒng),開展了基于 6 500 張無人機(jī)影像的非洲薩瓦納草原大型哺乳動(dòng)物的識(shí)別試驗(yàn),但當(dāng)召回率為75%時(shí),精度僅為10%[4]。Xue等發(fā)展了一種基于機(jī)器學(xué)習(xí)從GeoEye-1 影像識(shí)別非洲角馬和斑馬的算法,該算法采用自適應(yīng)神經(jīng)網(wǎng)絡(luò)(adaptive-network-based fuzzy inference system,簡(jiǎn)稱ANFIS),不僅能使用已有的專家知識(shí),而且能從數(shù)據(jù)中學(xué)習(xí)動(dòng)物特征,從而獲得了比傳統(tǒng)基于閾值分割法更高的精度[18]。

近年來,深度學(xué)習(xí)理論和實(shí)踐均取得了突破性進(jìn)展。深度學(xué)習(xí)能夠從大數(shù)據(jù)中自動(dòng)學(xué)習(xí)到一些人類難以手動(dòng)提取到的特征,因而精度更高,可以取得比以往傳統(tǒng)淺層機(jī)器學(xué)習(xí)模型(如ANN)難以達(dá)到的效果。相關(guān)成果已應(yīng)用在動(dòng)物識(shí)別領(lǐng)域并被《Nature》[19-20]《PNAS》[21]等期刊爭(zhēng)相報(bào)道,逐漸成為遙感[22]、地球系統(tǒng)科學(xué)[20]等大數(shù)據(jù)處理領(lǐng)域不可或缺的工具。Benjamin等使用卷積神經(jīng)網(wǎng)絡(luò)(convolutional neural networks,簡(jiǎn)稱CNNs)從數(shù)千張4 cm分辨率無人機(jī)RGB 影像中識(shí)別了20余種大型哺乳動(dòng)物(試驗(yàn)中沒有區(qū)分物種,統(tǒng)一當(dāng)作動(dòng)物一類)[23],取得了較傳統(tǒng)淺層機(jī)器學(xué)習(xí)[4]更高的精度。Norouzzadeh等組合使用AlexNetGoogLeNet、ResNet等9種深度神經(jīng)網(wǎng)絡(luò)模型,開展了基于地面熱紅外觸發(fā)相機(jī)圖像中的動(dòng)物識(shí)別與分類,取得了與志愿者人工解譯相近的精度(判斷圖像中是否存在動(dòng)物的準(zhǔn)確度達(dá)96.6%)[24]。

1 材料與方法

1.1 研究區(qū)概況

青藏高原是世界高寒地區(qū)生物多樣性集中區(qū),據(jù)統(tǒng)計(jì)區(qū)內(nèi)有69種國家重點(diǎn)保護(hù)動(dòng)物,其中16種國家Ⅰ級(jí)重點(diǎn)保護(hù)動(dòng)物,53種國家Ⅱ級(jí)重點(diǎn)保護(hù)動(dòng)物[25]。建立三江源國家自然保護(hù)區(qū)以來,該地區(qū)的生態(tài)環(huán)境明顯改善,大型食草動(dòng)物種群數(shù)量逐年增加,如何系統(tǒng)全面地掌握該地區(qū)大型食草動(dòng)物的種群數(shù)量和分布成為對(duì)該地區(qū)進(jìn)行科學(xué)合理保護(hù)的關(guān)鍵。

1.2 無人機(jī)遙感數(shù)據(jù)獲取

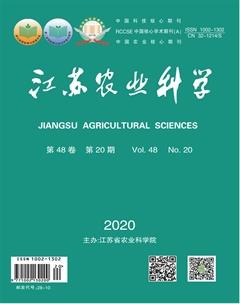

2019年7月8日至18日,作者及作者所在課題組相關(guān)成員赴三江源地區(qū)開展航拍,此次航拍主要在青海省瑪多縣境內(nèi)完成,飛行航跡如圖1所示。飛行總面積約200 km2,分辨率為8 cm,拼接后用于大型食草動(dòng)物調(diào)查的范圍為150 km2。

航拍主要采用中國科學(xué)院成都山地所長期在高原地區(qū)使用的2款自主研發(fā)無人機(jī),如圖2所示。

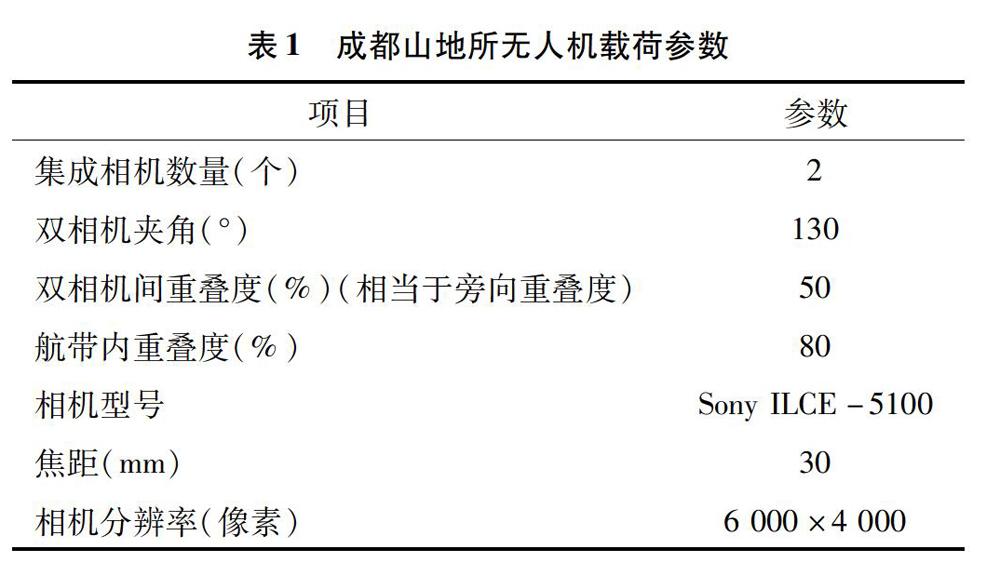

在700 m航高時(shí),單個(gè)相機(jī)的拍攝寬度(幅寬)為800 m。為增加每條航帶的覆蓋范圍采用雙相機(jī)拍攝系統(tǒng),這樣每條航帶的寬度增加至1 200 m。雙相機(jī)系統(tǒng)詳細(xì)參數(shù)見表1。

1.3 解譯標(biāo)志及數(shù)據(jù)預(yù)處理

在瑪多縣獲取的包含14個(gè)無人機(jī)起落的遙感影像中選取10 000張作為樣本庫,其中7 000張影像作為訓(xùn)練集,剩余3 000張作為測(cè)試集。解譯的對(duì)象包括家養(yǎng)牦牛、家養(yǎng)藏羊、馬3類家養(yǎng)食草動(dòng)物以及藏野驢、藏原羚、巖羊3類野生食草動(dòng)物。本研究依據(jù)遙感解譯諸要素,總結(jié)建立可應(yīng)用的解譯標(biāo)志,并歸納,詳見表2。借助上述解譯標(biāo)志,使用labelme標(biāo)注工具對(duì)每一幅訓(xùn)練集影像中的大型食草動(dòng)物進(jìn)行標(biāo)注[26]。

1.4 訓(xùn)練深度學(xué)習(xí)模型

構(gòu)提出的新的卷積神經(jīng)網(wǎng)絡(luò),該網(wǎng)絡(luò)在有效地檢測(cè)目標(biāo)的同時(shí)完成了高質(zhì)量的語義分割。Mask R-CNN的主要思路就是把原有的Faster R-CNN進(jìn)行擴(kuò)展,添加一個(gè)分支使用現(xiàn)有的檢測(cè)對(duì)目標(biāo)進(jìn)行并行預(yù)測(cè)。同時(shí),這個(gè)網(wǎng)絡(luò)結(jié)構(gòu)比較容易實(shí)現(xiàn)和訓(xùn)練,速度也算比較快,可以很方便地應(yīng)用到其他領(lǐng)域,如目標(biāo)識(shí)別、場(chǎng)景分割、關(guān)鍵點(diǎn)檢測(cè)等,并且比現(xiàn)有的其他算法效果都要好。

首先,為強(qiáng)化基礎(chǔ)網(wǎng)絡(luò),Mask R-CNN替換了原先在Faster R-CNN中使用的VGG網(wǎng)絡(luò),轉(zhuǎn)而使用特征表達(dá)能力更強(qiáng)的殘差網(wǎng)絡(luò)。另外為了挖掘多尺度信息,還使用了FPN網(wǎng)絡(luò)。通過 ResNeXt-101+FPN 用作特征提取網(wǎng)絡(luò),達(dá)到 state-of-the-art 的效果,其結(jié)構(gòu)如圖3所示。

其次,ROI Align layer代替了原先Faster R-CNN的ROI Pooling過程,可以更有效、精準(zhǔn)地檢測(cè)圖片中的較多小目標(biāo)。因此,使用mask rcnn對(duì)于提高動(dòng)物識(shí)別概率有很大的幫助, 本試驗(yàn)中對(duì)各類成年家養(yǎng)牦牛體長多在1.6~2.2 m。以4 cm分辨率航片為例,個(gè)體長度多在40~50像素。幼年牦牛可小至0.8 m(但幼年牦牛不會(huì)離群?jiǎn)为?dú)出現(xiàn))??????? 成年家養(yǎng)藏羊體長多在1.2 m左右,一般體長不會(huì)超過1.5 m。以4 cm分辨率航片為例,個(gè)體長度多在25~35像素。幼年藏羊可小至0.4 m(但幼年藏羊不會(huì)離群?jiǎn)为?dú)出現(xiàn))???????? 成年家馬體長多在1.6~2.2 m。以4 cm分辨率航片為例,個(gè)體長度多在40~55像素。幼年家馬可較小,但不應(yīng)遠(yuǎn)離馬群及母馬出現(xiàn)形狀整體形狀近橢圓形、長方形。長寬比多在1.5 ∶ 1~3 ∶ 1之間 整體形狀近橢圓形、水滴形。長寬比多在1.5 ∶ 1~3 ∶ 1之間整體形狀近長條塊狀或長柄長圓形。長寬比多在3 ∶ 1~5 ∶ 1之間大型食草動(dòng)物的檢測(cè)結(jié)果如圖5所示。

1.5 掩膜生成及矢量化

由于mask rcnn是針對(duì)像元進(jìn)行語義分割,因此在檢測(cè)的同時(shí)可以輸出掩膜圖像,本試驗(yàn)采用Python語言作為開發(fā)工具,通過編碼實(shí)現(xiàn)對(duì)動(dòng)物掩膜的自動(dòng)提取并轉(zhuǎn)化為輪廓矢量輸出[26],將得到的動(dòng)物掩膜輪廓矢量導(dǎo)入地學(xué)分析軟件ArcGIS中,即可獲得動(dòng)物的種群數(shù)量、面積和分布信息[26]。

2 結(jié)果與分析

2.1 深度學(xué)習(xí)模型損失曲線的生成

深度學(xué)習(xí)模型mask rcnn在檢測(cè)過程中生成了相應(yīng)的損失曲線(以牦牛為例),如圖4所示。從左上角順時(shí)針依次是分類損失曲線、回歸損失曲線、mask分割損失曲線以及rpn回歸損失曲線。

2.2 各類大型食草動(dòng)物的檢測(cè)結(jié)果

通過海量訓(xùn)練生成相應(yīng)的訓(xùn)練模型,測(cè)試程序通過調(diào)用該模型對(duì)測(cè)試集中的各類大型食草動(dòng)物進(jìn)行檢測(cè)及定位,檢測(cè)結(jié)果樣例如圖5所示。

2.3 各類大型食草動(dòng)物的精度評(píng)價(jià)

采用準(zhǔn)確率、 召回率和漏識(shí)別率作為對(duì)大型食草動(dòng)物檢測(cè)進(jìn)行精度評(píng)價(jià)的指標(biāo),識(shí)別效果如表4所示。可以看出,mask r-cnn模型對(duì)各類大型食草動(dòng)物的檢測(cè)精度較高,平均召回率達(dá)89%,平均準(zhǔn)確率為89.4%,平均漏識(shí)別率僅為10.8%。

2.4 各類大型食草動(dòng)物的分布情況

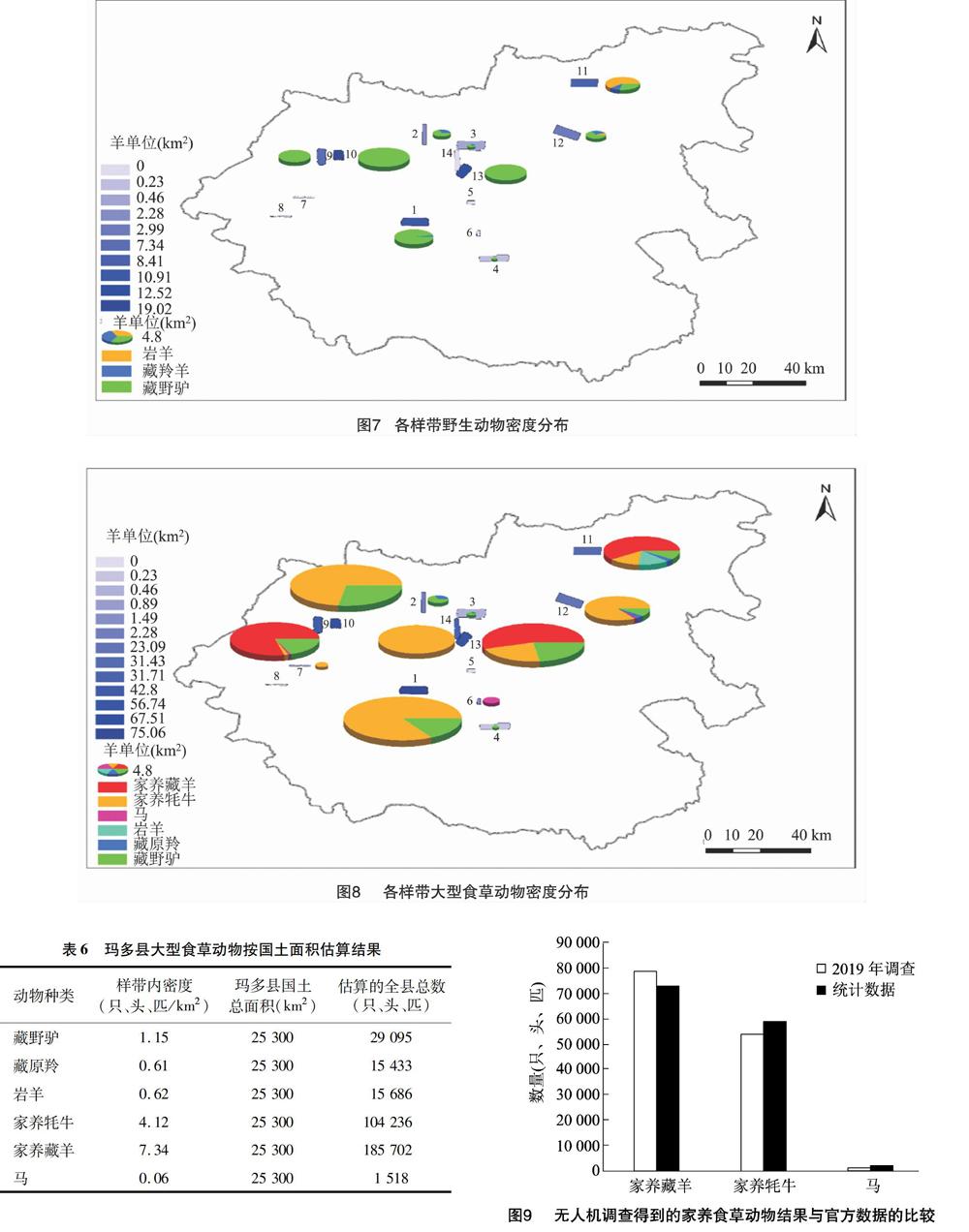

匯總上一節(jié)得到的各調(diào)查樣帶中各類大型食草動(dòng)物的統(tǒng)計(jì)結(jié)果(表5中將各類家羊食草動(dòng)物換算成羊單位),可以對(duì)分布在不同調(diào)查樣帶當(dāng)中的大型食草動(dòng)物的密度進(jìn)行推算,結(jié)果如圖6至圖8所示。

2.5 各類大型食草動(dòng)物的總數(shù)估算

基于無人機(jī)樣帶調(diào)查結(jié)果,根據(jù)瑪多縣國土面積可以推算出瑪多縣全境的食草動(dòng)物種群數(shù)量。據(jù)計(jì)算, 有18.570 2萬只家養(yǎng)藏羊, 10.423 6萬頭家養(yǎng)牦牛,2.909 5萬只藏野驢,1.543 3萬只藏原羚,1.568 6萬只巖羊。由此可見,大型野生食草動(dòng)物數(shù)量遠(yuǎn)少于家畜數(shù)量,僅為后者的20.66%(表6)。

2.6 與官方家畜數(shù)的對(duì)比分析

基于2019年家畜估算結(jié)果,假設(shè)仔畜出生率為30%,2018年底瑪多縣家養(yǎng)藏羊存欄數(shù)應(yīng)為78 615只,家養(yǎng)牦牛應(yīng)為54 461頭。馬無需考慮出生率,2018年底馬存欄數(shù)應(yīng)為1 476匹。

根據(jù)青海草原總站提供的數(shù)據(jù),2018年底瑪多縣實(shí)際存欄有73 133只家養(yǎng)藏羊,59 235頭家養(yǎng)牦牛,1 576匹馬。通過對(duì)比分析,兩者的差值百分比家養(yǎng)藏羊?yàn)?75%, 家養(yǎng)牦牛為 8.8%, 馬為 2.8%(圖9)。由此可知,本研究使用基于無人機(jī)樣帶調(diào)查和深度學(xué)習(xí)模型分類的方法對(duì)大型食草動(dòng)物進(jìn)行種群數(shù)量估算, 估算結(jié)果與動(dòng)物實(shí)際存欄數(shù)誤差在10%以內(nèi),方法具有較高的估算精度和廣闊的應(yīng)用前景。

3 結(jié)論

無人機(jī)遙感是在高海拔高寒地區(qū)開展大型食草動(dòng)物監(jiān)測(cè)行之有效的手段。鑒于研究區(qū)極為開闊,樣帶調(diào)查獲取的高分辨率影像數(shù)量巨大,逐一開展目視解譯費(fèi)事費(fèi)力。利用深度學(xué)習(xí)模型對(duì)影像中的大型食草動(dòng)物進(jìn)行檢測(cè)和定位不僅大大提高了解譯效率,而且具有較高的精度。MASK R-CNN模型針對(duì)像元進(jìn)行語義分割,在檢測(cè)的同時(shí)輸出動(dòng)物的掩膜圖像。通過自動(dòng)提取掩膜輪廓并轉(zhuǎn)化為矢量輸出,可以獲取研究區(qū)大型食草動(dòng)物的種群數(shù)量、面積和分布等信息。通過與官方數(shù)據(jù)對(duì)比,本研究所采用的方法誤差率很低。盡管深度學(xué)習(xí)方法在處理遙感大數(shù)據(jù)時(shí)優(yōu)勢(shì)明顯,但訓(xùn)練得到的模型是不可解釋的[22]。本質(zhì)是一種黑匣解決方案,實(shí)際應(yīng)用中除了需要標(biāo)記大量樣本外,還要根據(jù)實(shí)際情況調(diào)整模型以便獲取更高的精度和效率[19,23]。

[16]Olivares-Mendez M,F(xiàn)u C H,Ludivig P,et al. Towards an autonomous vision-basedunmanned aerial system against wildlife poachers[J]. Sensors 2015,15(12):31362-31391.

[17]Torney C J,Dobson A P,Borner F,et al. Assessing rotation-invariant feature classification for automated wildebeest population Counts[J]. PLoS One,2016,11(5):e0156342.

[18]Xue Y F,Wang T J,Skidmore A K. Automatic counting of large mammalsfrom very high resolution panchromatic satellite imagery[J]. Remote Sensing,2017,9(9):1-16.

[19]Lecun Y,Bengio Y,Hinton G E. Deep learning[J]. Nature,2015,521(7553):436-444.

[20]Reichstein M,Camps valls G,Stevens B,et al. Deep learning and process understanding for data-driven Earth system science[J]. Nature,2019,566(7743):195-204.

[21]Waldrop M M . News feature:what are the limits of deep learning?[J]. Proceedings of the National Academy of Sciences,2019,116(4):1074-1077.

[22]Zhu X X,Tuia D,Mou L,et al. Deep learning in remote sensing:a comprehensive review and list of resources[J]. IEEE Geoence & Remote Sensing Magazine,2018,5(4):8-36.

[23]Benjamin K,Diego M,Devis T. Detecting mammals in UAV images:best practices to address a substantially imbalanced dataset with deep learning[J]. Remote Sensing of Environment,2018,216:139-153.

[24]Norouzzadeh M S,Nguyen A,Kosmala M,et al. Automatically identifying,counting,and describing wild animals in camera-trap images with deep learning[J]. Proceedings of the National Academy of Sciences of the United States of America, 2018,115(25):5716-5725.

[25]邵全琴,樊江文. 三江源區(qū)生態(tài)系統(tǒng)綜合監(jiān)測(cè)與評(píng)估[M]. 北京:科學(xué)出版社,2012.

[26]羅 巍,王東亮,夏列鋼,等. 一種基于深度學(xué)習(xí)的林業(yè)資源調(diào)查方法[J]. 林業(yè)科技通訊,2020(8):17-22.張 坤,劉永強(qiáng),阿依尼格爾·亞力坤,等. 塔克拉瑪干沙漠腹地土壤熱通量的陸面過程與衛(wèi)星遙感研究[J]. 江蘇農(nóng)業(yè)科學(xué),2020,48(20):256-264.