基于卷積神經網絡的鋅渣識別方法研究

邱意 陳勁杰

摘? 要:由于實際工業中工作池內鋼水與表面鋅渣存在部分重疊和邊界不清以致識別較難的情況,提出了一種基于U-Net(U型神經網絡)網絡的鋅渣識別方法。該方法先是把工業攝像頭采集到的工作池圖像進行灰度化,均值濾波等多種平滑模糊處理后,再采用完善的U-Net網絡進行輪廓提取。接著將所得圖像做二值化處理后,通過OpenCV(跨平臺計算機視覺庫)自帶函數獲得結果并對其進行分析。實驗結果表明,基于U-Net的鋅渣識別方法不僅能準確快速地區分鋼水與表面鋅渣,也能降低人工經驗中存在的誤差。

關鍵詞:U-Net網絡;鋅渣識別;圖像分割;深度學習

中圖分類號:TP391.4? ? ?文獻標識碼:A

文章編號:2096-1472(2021)-01-02-03

Abstract: In industry, the molten steel in working pool and surface slag are partially overlapped and the boundary is unclear, which makes it difficult to visually differentiate them. Aiming at this problem, the paper proposes a zinc slag recognition and segmentation method based on U-Net (U-shaped Neural Network). Firstly, the working pool images collected by industrial camera are smoothed and blurred by grayscale processing and average filtering. Then, perfect U-Net is used for contour extraction. Next, the obtained images are binarized. Finally, the result is obtained and analyzed by the built-in function of OpenCV (Computer Vision). The experimental results show that this zinc slag recognition method based on U-Net can accurately and quickly distinguish molten steel from surface zinc slag, as well as reduce errors in manual experience.

Keywords: U-Net; slag recognition; image segmentation; deep learning

1? ?引言(Introduction)

目前,眾所周知帶鋼的耐腐蝕性能需要進行提升的話,工業上很常用的就是在其表面加上一層耐腐蝕的鍍層,而熱鍍是多種手段中最受認可的。在該技術中,不管是熱鍍什么金屬成分一般都用鋅鍋,具體實施方法是將鍍層金屬熔融在鋅鍋內,然后把目標鍍件浸沒到鍍液中進行熱鍍。在加工過程中,一定會產生鋅渣,而這些表面浮渣一旦處理不當,就會對鍍件連續熱鍍鋅產生不好的效果,這不僅會降低產品的表面質量,也會造成液面浮渣凝結,以致后續工業生產無法持續進行。因此,在熱鍍過程中需要對鋅鍋內的表面浮渣進行撈渣作業,但是撈渣作業的環境非常差,所需的勞動強度又大,容易對工作人員的身體健康造成不良的影響。可見人工撈渣既耗費很多人力物力,準確性和效率又不盡如人意,需要現代先進的解決辦法。

伴隨著計算機圖像處理技術這一領域日新月異的迅猛變化,卷積神經網絡在圖像分類上的表現已經十分出色,適應多種問題狀況,并且圖像分割從某一些層面來說也不外乎是分類的一個分支,因此卷積神經網絡適合用來解決鋅渣識別問題。本文考慮到目前常用的方法在應對工作池鋅渣圖像時有識別速度慢、泛用性不強等問題,提出了一種基于U-Net[1]網絡的鋅渣識別方法,該方法適應了多種清晰度的目標圖像,實現了對工作池圖像鋼水與鋅渣的準確識別與分割。

2? ?總體設計路線(Overall design route)

本文的研究目的是完成零散的工作區域拼接并對合并的區域圖像進行圖像處理,分析圖像中鋅渣的分布和占比面積,并將鋅渣區域標識出來,為以后引導機器人智能撈渣提供識別基礎。總體設計路線一共是兩條:第一條路線是將工業攝像頭采集得到的現場圖像制作成訓練集,接著對訓練集作圖像預處理后,通過U-Net模型完成神經網絡的訓練,得到最優參數。第二條路線是通過已經完成參數調整的U-Net模型掃描測試圖像的輪廓范圍,繪制出輪廓圖,接著做二值化處理后,利用OpenCV[2]自帶函數獲得鋅渣分布情況和占比,完成鋅渣識別。總體設計路線如圖1所示。

3? 數據準備和預處理(Data preparation and preprocessing)

3.1? ?數據集的準備

本文所使用的數據是通過工業攝像機獲取的鋅鍋內的工作池圖像,接著為了使U-Net網絡模型的輸入圖像具有統一標準,方便訓練,進行了一系列處理,包括數據裁剪等。第一手獲得的圖像分辨率是1 280×768。出于提升效率的目的,本文從圖像中篩選出互相沒有重復部分的50張圖像,分配比例是80%用來當訓練集,20%用來當測試集。接著,那些圖像經灰度化和濾波后成為樣本集。然后,經過裁剪處理獲取其中含有鋅渣的區域,同時將圖像分辨率變為800×600。最后,為每張圖像打上標簽制作標簽集,將兩者組合成訓練集。U-Net模型的訓練樣本總計為835 000個,這些樣本都是從前述訓練集圖像中隨機生成的,每張圖片獲取大約30 000個樣本,標準尺寸為50像素×50像素。

3.2? ?輪廓檢測

圖像預處理過程如圖2所示,將測試圖像經過灰度化、均值濾波的預處理[3,4]后,降低了圖像的噪聲,鋅渣邊緣更加明顯,即這是一個只保留了有用信息的精簡圖像。而將這些預處理過的圖像當作后續步驟的基礎,不僅能減少信息雜糅,還能改進U-Net訓練的效率。U-Net網絡完成鋅渣識別后,結果如圖3所示。

3.3? ?連通區域標記

為了深入了解鋅渣在工作池圖像中的分布情況,就不可避免地要處理檢測后的連通區域。本文決定使用OpenCV自帶函數完成對鋅渣輪廓的連通域標記。

(1)為了將工作池內的鋼水和鋅渣分開,經嘗試選取閾值為0.5,產生二值化圖,如圖4所示。再選取OpenCV的部分函數分析圖像的各種參數:可以用findContours命令統計該圖像的輪廓情況;可以用contourArea命令得到各個輪廓的面積。

(2)不難發現圖像中鋅渣范圍存在些許孔洞,那么要充分實現上一步標記的效果,則可以用形態學的算法來輔助。通常理論上講,最多見的是以(2R+1)×(2R+1)正方形的結構元素為基本掃描圖像,接著做連通域標記,可以把單獨一個域當作一個聚類,而去除的一般是很小的部分。至于最終填充目標孔洞則是適量增加結構元素半徑R。本文的操作是以像素[0,0]為起點,接著從此點開始通過四連通結構單元不斷擴張至全圖。待擴展完成,通過取反得到新的圖像,現在這一張圖就包含了所有的孔洞。之后將兩張圖像相加,即是需要的結果,填充后的圖像如圖5所示。最后通過OpenCV的drawContours命令處理,可以得到分割結果圖。

4? ?U-Net網絡模型設計(Design of U-Net network model)

4.1? ?U-Net網絡模型搭建

神經網絡的組成一般總共分五大部分,除去必需的輸入、輸出層,關鍵在于卷積、池化、全連接這三種層如何取舍與搭配[5]。而本文使用的U-Net是在全卷積網絡(Fully Convolutional Network,FCN)[6]的基礎上改變結構所得。它的特色在于,整個模型訓練集規模小,但是識別效果好。U-Net網絡結構是通過兩條對稱的路徑搭建的,如圖6所示。前段信息提取,而后段則是找準位置。前段主要是幾組3×3卷積層和2×2最大池化層搭建,激活函數則是線性整流函數(Rectified Linear Unit,ReLU),交叉熵是損失函數。后段每一次操作進行反卷積,再把所得和后續特征圖做拼接,接著通過兩次3×3卷積。最后一層是1×1卷積核,將每個二位特征向量映射到網絡的輸出層。

4.2? ?U-Net模型訓練

利用訓練集對U-Net網絡做訓練調整優化,具體參數如表1所示。“batch_size”代表一次代碼迭代對應的圖數量;“epochs”代表大循環完成后單樣本共計訓練次數;“images_train”表示訓練樣本總數;“Resolution”表示圖像訓練樣本的分辨率。本文實驗采用隨機梯度下降法。

4.3? ?U-Net模型測試與預測

U-Net模型的測試過程如圖7所示。第一步準備好所有測試圖像,接著經由U-Net網絡,實施前向傳播過程獲取一個輸出結果,然后把結果和標簽比對,即可統計出準確率數值。當然,訓練和測試兩個步驟可以先后操作,而預測過程的算法過程大同小異,變化的只有輸入,即每次一個數據。

5? 實驗結果與分析(Experimental results and analysis)

適合工作池鋅渣識別的U-Net模型搭建完畢,接著本文通過計算機完成了相應實驗,計算機的具體配置如表2所示。

如圖8和圖9所示,經過多次訓練,U-Net模型的參數不斷調整優化,準確率這一性能指標慢慢趨于一個理想的結果,總計300次的訓練其數值約達到99.89%,而損失函數的數值呈逐次降低的走勢,這意味著鋅渣識別的誤差越來越小。

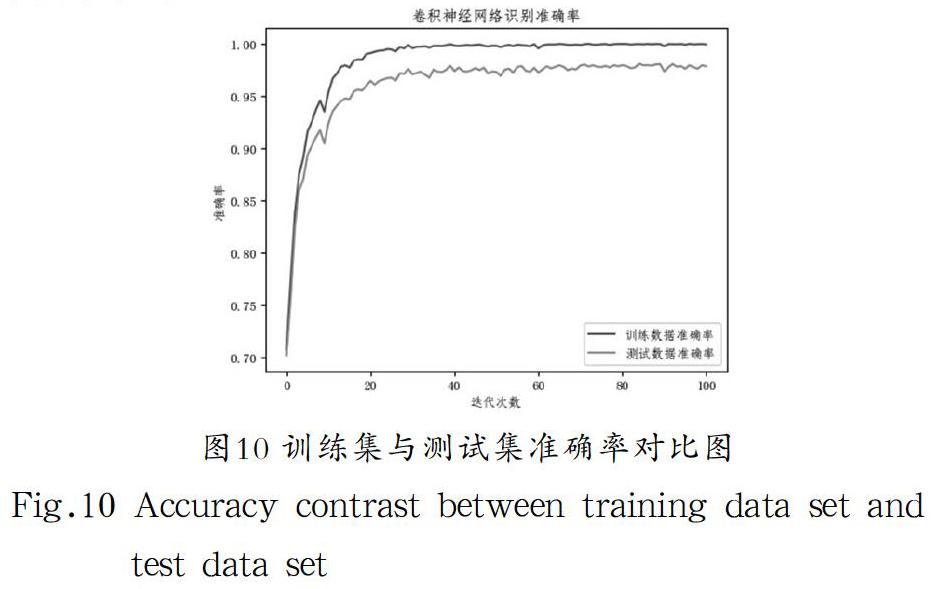

每完成一輪訓練并更新參數后,都相應要完成測試,以此來檢驗此模型的泛化性和穩定性。如圖10所示,測試集的性能指標趨勢也是逐次提高,兩者的準確率大體相近,不難發現該模型并未存在過擬合的情況,U-Net模型搭建科學,識別效果好。隨著迭代次數增加,到100個循環后,測試集的準確率最終是97.84%。

同時,圖11呈現了測試集中兩張不同生產時刻的分割效果,可以看出能夠較準確地提取鋅渣區域的輪廓,分割鋼水與鋅渣的模糊邊緣。

6? ?結論(Conclusion)

本文將U-Net網絡模型用于鋅渣識別,為實際生產作業環境提供了一種計算機圖像處理方法,為以后引導機器人智能撈渣提供識別基礎。具體來說,本文針對工作池鋅渣識別這一工程問題,完成了鋅渣識別路線的規劃,并收集和預處理了原始圖像,以及U-Net模型的完整創建及調試,最后經由實驗驗證了該系統的可操作性,證明了其對工作池鋅渣圖像識別的有效性。

參考文獻(References)

[1] Ronneberger O, Fischer P, Brox T. U-Net: convolutional networks for biomedical image segmentation[C]. International Conference on Medical Image Computing and Computer-Assisted Intervention. Munich, 2015:234-241.

[2] 蘇慧娟,于正林,張桂林.基于OpenCV的圖像處理[J].科技資訊,2014,12(8):18-19.

[3] Paul Viola, Michael J. Jones. Robust Real-Time Face Detection[J]. International Journal of Computer Vision, 2004(2):137-154.

[4] Richard Szeliski. Computer Vision: Algorithms and Applications[M]. Springer, 2010:101-118.

[5] Yu Chen, Hongbing Meng, Xinling Wen, et al. Classification methods of a small sample target object in the sky based on the higher layer visualizing feature and transfer learning deep networks[J]. EURASIP Journal on Wireless Communications and Networking, 2018(1):127-138.

[6] Shelhamer E, Long J, Darrell T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4):640-651.

作者簡介:

邱? ? 意(1995-),男,碩士生.研究領域:圖像處理.

陳勁杰(1969-),男,碩士,副教授.研究領域:智能機器人,機器學習.