融合知識圖譜信息的命名實體識別方法

閻志剛,李成城 ,林民

內蒙古師范大學計算機科學技術學院,呼和浩特 內蒙古010022

0 引言

命名實體識別(Named Entity Recognition,NER)作為自然語言處理中的一項基本任務,在問答系統[1]、句法分析[2]以及機器翻譯[3]等高級自然語言處理任務中廣泛應用.其具體任務目標是從文本中有效提取并識別出各類實體,具體包含三大類(實體類、時間類和數字類)、七小類(人名、機構名、地名、時間、日期、貨幣和百分比)命名實體.NER 主要經歷了傳統方法、基于傳統機器學習的方法和基于深度學習的方法三個階段.

早期主要有基于字典[4]、基于規則[5]與基于統計[6]等傳統的識別方法,識別過程通常需要大量人工參與,識別效率低下.基于傳統機器學習的命名實體識別方法[7~9]主要經歷了監督、半監督、無監督和混合方法等發展歷程.

隨著深度學習的迅速發展,研究者開始使用深度神經網絡[10](Deep Neural Network,DNN)來進行命名實體識別.神經網絡模型RNN[11](Recurrent Neural Network,RNN)有長期記憶的性能并且能解決可變長度輸入,在各個領域都表現出良好的性能,但是會伴有梯度消失的問題.于是在RNN 神經網絡模型的基礎之上提出了長短時記憶(Long-short Term Memory,LSTM)模型[12].張海楠等人[13]將字特征和詞特征統一結合,解決了基于詞特征的分詞錯誤和字典稀疏問題.針對傳統機器學習方法需要人工設計特征及語料不足的問題,馮艷紅等人[14]提出使用基于BLSTM 的命名實體識別方法,對于每一個輸入序列,通過上下文關系可以獲取當前詞項的語義信息,利用雙向LSTM(Bidirectional LSTM,BLSTM)來解決LSTM 無法捕捉到文本后續相關語法語義信息的問題.Liu 等人[15]提出字符任務感知型神經語言模型,將字符進行向量化表示,可以很好地識別新實體.劉宇鵬等人[16]提出了BLSTM-CNN-CRF 模型,可以同時自動獲取基于字符和詞語的語義表示,不再需要人工選擇特征和數據預處理. Devlin 等人[17]提出了基于Transformer 的BERT 模型.該模型采用先預訓練,再微調的方法可以捕獲到更加豐富的語義信息.基于注意力機制建模的Transformer 模型在特征提取方面性能良好,采用編碼器-解碼器的架構,可以捕獲長距離的依賴關系,還可以進行并行化處理.通過縮小序列中任意兩個位置之間距離的方法,為不同的信息分配不同的注意力權重,從而提取出長距離的全局信息.王子牛等人[18]提出了基于BERT 的神經網絡方法進行中文命名實體識別,利用大規模未標注語料對BERT 進行訓練,獲得文本抽象特征. 然后利用BiLSTM 神經網絡捕獲序列化文本的上下文特征.最后,通過CRF 進行序列解碼標注,提取出相應的實體. 楊飄等人[19]通過嵌入BERT 預訓練語言模型,構建BERT-BiGRU-CRF 模型用于表征語句特征.利用具有雙向Transformer 結構的BERT 預訓練語言模型增強字的語義表示,根據其上下文動態生成語義向量. 針對BERT 模型參數量大,訓練時間長,實際應用場景受限等問題,鄧博研等人[20]提出了一種基于ALBERT(A Lite BERT,ALBERT)的中文命名實體識別模型ALBERT-BiLSTM-CRF.在結構上,先通過ALBERT 預訓練語言模型在大規模文本上訓練字符級別的詞嵌入,然后將其輸入BiLSTM 模型以獲取更多的字符間依賴,最后通過CRF進行解碼并提取出相應實體.

鑒于中文命名實體存在結構復雜、形式多樣、一詞多義等問題,同時考慮到知識圖譜可以提供豐富的結構化知識事實,從而更好地進行語言理解.本文提出了一種融合知識圖譜的中文命名體識別方法,通過知識圖譜中的信息實體增強語言的外部知識表示能力,從而提升中文命名體的識別效果.

1 相關工作

1.1 知識圖譜

圖是一種有效表述數據間結構的表示形式,知識圖譜是由圖和知識組成的[21].知識總體上可以分為陳述性知識和過程性知識兩大類.陳述性知識是描述客觀事物的性能、狀態等靜態信息,主要分為事物、概念、命題三個層次.過程性知識是描述問題如何求解的動態信息,分為規則和控制結構兩種類型.根據知識的主客觀性,又可以把知識分為事實性知識和主觀性知識.事實性知識通常是指確定的、不隨狀態的變化而改變的知識.在知識圖譜中,存儲的大都為事實性知識.

將數據結構化并與已有的結構化數據相關聯,就構成了知識圖譜.2012 年谷歌正式提出知識圖譜(Knowledge Graph)的概念,旨在實現更智能的搜索引擎[22].知識圖譜本身是一個網狀知識庫,由實體通過關系鏈接而形成.它以結構化的形式描述客觀世界中的概念、實體及其之間的關系,將互聯網的信息表達成更接近人類認知世界的形式.知識圖譜的表示形式為G=(E,R,S),其中E={e1,e2,…,e|E|}表示知識庫中的實體集合,R={r1,r2,…,r|E|}表示知識圖譜中的關系集合,S?E×R×E 表示知識圖譜中三元組的集合[23].

1.2 BERT 模型

1.2.1 Transformer 體系結構

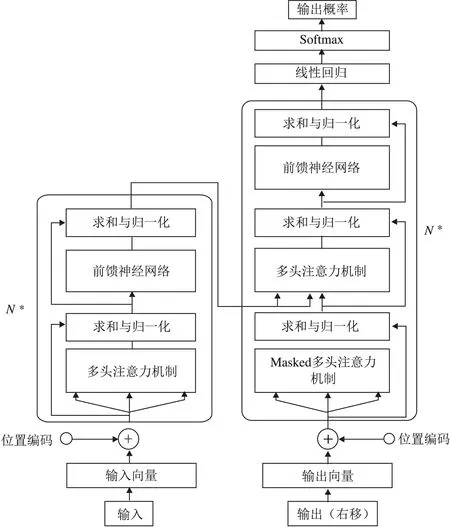

BERT 的模型體系結構是基于Vaswani 等人[24]描述的原始實現,是一個多層的Transformer,具體Transformer 模型的編碼器共四層,第一層是多頭注意力機制(Multi-Head Attention);第二層是求和與歸一化層,用于解決深度神經網絡中的梯度消失問題;第三層是前饋神經網絡層;第四層也為求和與歸一化層,用于生成中間語義編碼向量并傳送給解碼器.

解碼器和編碼器結構類似,共包含六層.區別在于第一層是帶MASK 操作的多頭注意力機制層,在輸出時,當前時刻無法獲取未來的信息,因此解碼器的輸出需要右移,并遮擋后續的詞項進行預測.最后解碼器再經過一個線性回歸和Softmax 層輸出解碼器最終的概率結果.Transformer 模型架構如圖1 所示.

1.2.2 BERT 模型的輸入表示

BERT 模型將詞向量、句向量和位置向量疊加起來一同作為輸入,且在開頭和結尾分別加入[CLS]、[SEP]兩個特殊字符,兩個句子之間使用[SEP]進行分割,BERT 模型的輸入具體包括以下三個方面:

(1)使用學習的位置向量,支持的序列長度最多為512 個詞項.每個序列的第一個詞項始終是特殊分類嵌入([CLS]),對應于該詞項的最終隱藏狀態(即Transformer 的輸出),常被用作分類任務的聚合序列表示.對于非分類任務,將忽略此向量.

(2)句子對作為一個序列進行輸入,以兩種方式區分句子.首先,用特殊標記([SEP])將它們分開.其次,添加一個學到的句子A 嵌入到第一個句子的每個詞項中,一個句子B 嵌入到第二個句子的每個詞項中.

(3)對于單個句子輸入,只使用句子A 嵌入.

圖1 Transformer 模型架構Fig.1 Transformer model architecture

2 融合知識圖譜信息的命名實體識別方法

傳統的BERT 可以較好地挖掘出文本數據中的語義信息,但幾乎沒有考慮結合知識圖譜對命名實體進行識別.針對語言理解,知識圖譜能夠為其提供更豐富的結構化信息.基于傳統的BERT 模型,該方法加入了知識圖譜信息,使詞嵌入以及知識嵌入聯合嵌入,這樣可以更有效的學習到語義知識單元的完整語義表示,提升命名實體識別的性能.

2.1 標記策略

設定詞項序列標記設定為{w1,w2,…,wn},其中n 是詞項序列的長度.同時將與詞項序列對齊的實體序列標記設定為{e1,e2,…,em},其中m 表示實體序列的長度. 此外,將包含所有標記的整個詞匯表記為V,包含知識圖譜中所有實體的實體序列表的集合記為E.如果一個詞項w∈V,并且有與其對齊的實體e∈E,則定義這種對齊方式為f(w)= e.

2.2 模型結構

模型主要包含抽取知識信息與訓練語言模型兩大步驟:

(1)對于抽取并編碼的知識信息,首先識別文本中的命名實體,然后將識別出的實體與知識圖譜中的實體進行匹配.該模型并不直接使用知識圖譜中基于圖的事實,而是通過知識嵌入算法對知識圖譜的圖結構進行編碼,并將多信息實體嵌入作為相關輸入,基于文本和知識圖譜對齊,將知識模塊的實體表示整合到語義模塊的隱藏層中.

(2)借鑒BERT 模型的思想,該模型采用帶Mask 的語言模型,同時預測下一句文本作為預訓練目標.除此之外,為了更好地融合文本和知識特征,設計了一種新型的預訓練目標,即隨機掩蓋掉部分對齊了輸入文本的命名實體,并要求模型從知識圖譜中選擇合適的實體以完成對齊.此外,相較于傳統BERT 模型僅利用局部上下文預測詞項的方法,本文模型要求同時聚合上下文和知識事實的信息,并預測詞項和實體,從而構建出一種知識化的語言表示模型.

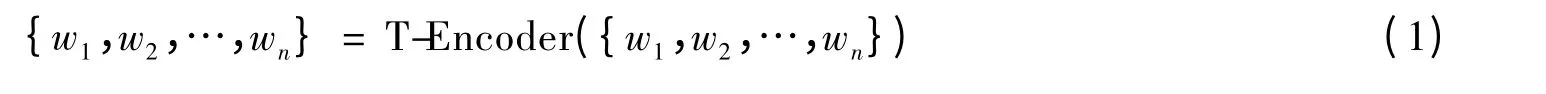

模型結構如圖2 所示,一方面,利用T-Encoder 從文本中捕獲基本的詞法和語法信息.另一方面,利用K-Encoder 將知識圖譜集成到底層的文本信息中.最終將詞匯信息和實體的異構信息表示為統一的特征空間.

2.2.1 T-Encoder 與K-Encoder 編碼器

在T-Encoder 編碼器中,首先對詞嵌入、句子嵌入及位置嵌入進行合并,作為T-Encoder 的輸入,即圖2的詞項輸入.而后通過式(1)計算詞法和語義特征.

圖2 模型結構Fig.2 Model structure

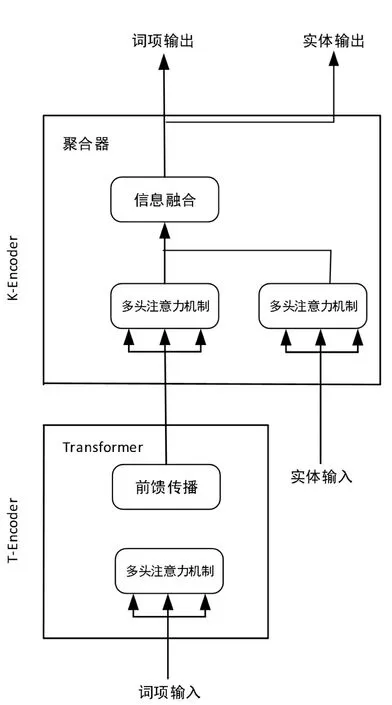

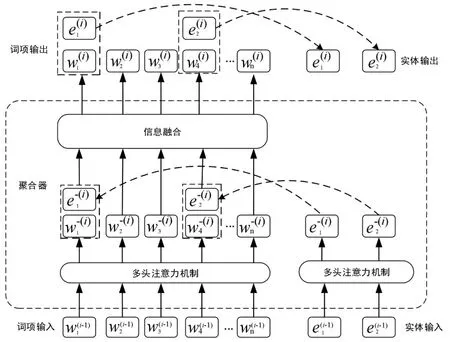

圖3 K-Encoder 編碼器中的聚合器Fig.3 Aggregators in the K-Encoder

如圖3 所示,在K-Encoder 編碼器中,首先抽取文本中對應的實體,通過知識圖譜嵌入法將實體轉為對應向量表示{e1,e2,…,em}.然后將{w1,w2,…,wn}及{e1,e2,…,em}作為K-Encoder 的輸入,即式(2).

2.3知識增強

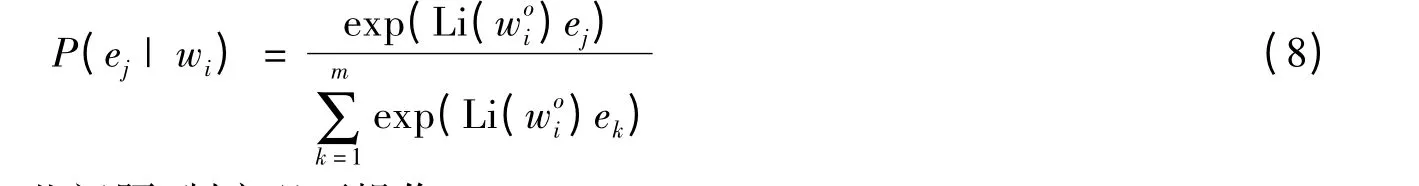

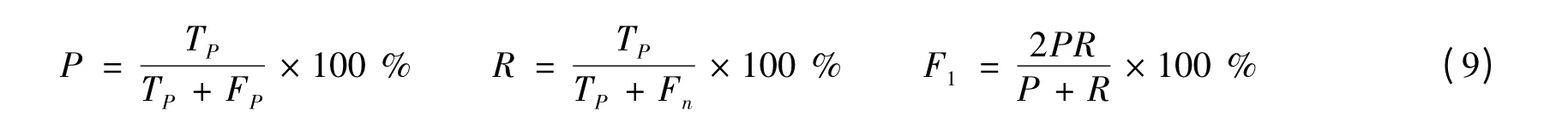

為了將知識融入信息性實體的語言表示中,提出了一項新的預訓練任務,該任務隨機掩蓋了一些已經對齊的詞項和實體,而后要求系統根據對齊的詞項來預測所有相應的實體.給定詞項序列{w1,w2,…,wn}和與它對齊的實體序列{e1,e2,…,em},關于詞項wi,對齊的實體分布定義如式(8),式中Li 表示線性層,該式也將用于計算預訓練任務的交叉熵損失函數.

鑒于詞項實體對齊方式存在一些問題,制定以下操作:

在5 %的時間內,對于給定的詞項實體對齊方式,將實體替換為另一個隨機實體,目的是訓練相關的實體模型,解決詞項與錯誤實體對齊的問題;

在15 %的時間內,掩蓋掉詞項實體對齊方式,目的是訓練相關模型,解決實體對齊方式未提取全部現有對齊方式的問題;

在剩余時間內,保持詞項實體對齊不變,使得模型將實體信息集成到詞項表中,以更好地理解語言.

與BERT 模型相似,該模型還采用掩碼語言模型(MLM)以及下一個句子預測作為預訓練任務,使模型能夠從文本標記中捕獲詞匯和句法信息.

3 實驗設計

3.1 數據集與評價指標

實驗數據集采用MSRA 以及搜狐新聞網數據集,其中MSRA 數據集是由微軟亞研院發布的專門用來做實體識別的數據集,該數據集16 MB 左右,共計50 000 余條信息,標注質量較高,是傳統NER 的首選數據集.搜狐新聞網數據集為手工標注數據集,大小6 MB 左右,共計20 000 余條信息.實驗中將上述數據集隨機劃分為三部分,即訓練集占比70 %、驗證集占比20 %、測試集占比10 %.在中文命名體識別研究領域,MSRA 以及搜狐新聞網數據集被廣泛應用在科學研究中.

基于準確率P、召回率R 以及F1值對模型性能進行全面評估,即式(9).

式(9)中,TP表示正確識別出的命名實體數量,FP表示識別錯誤的命名實體數量,Fn表示未識別出的命名實體數量.

3.2 實驗參數設置

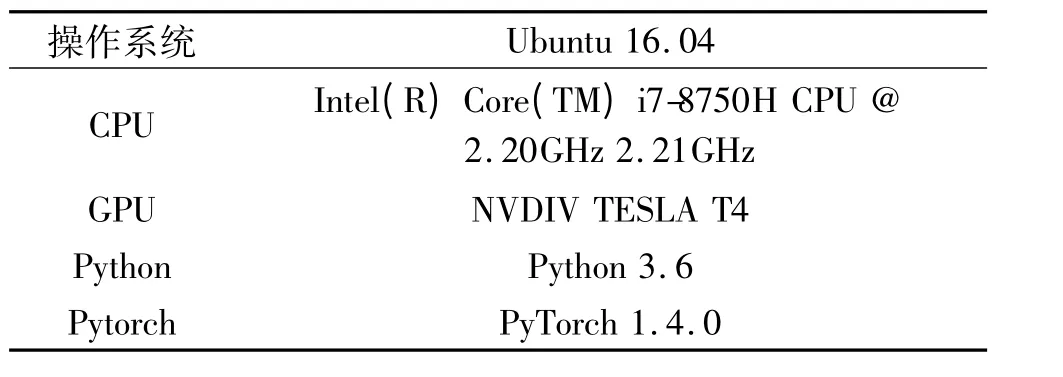

相關實驗的軟硬件環境如表1.

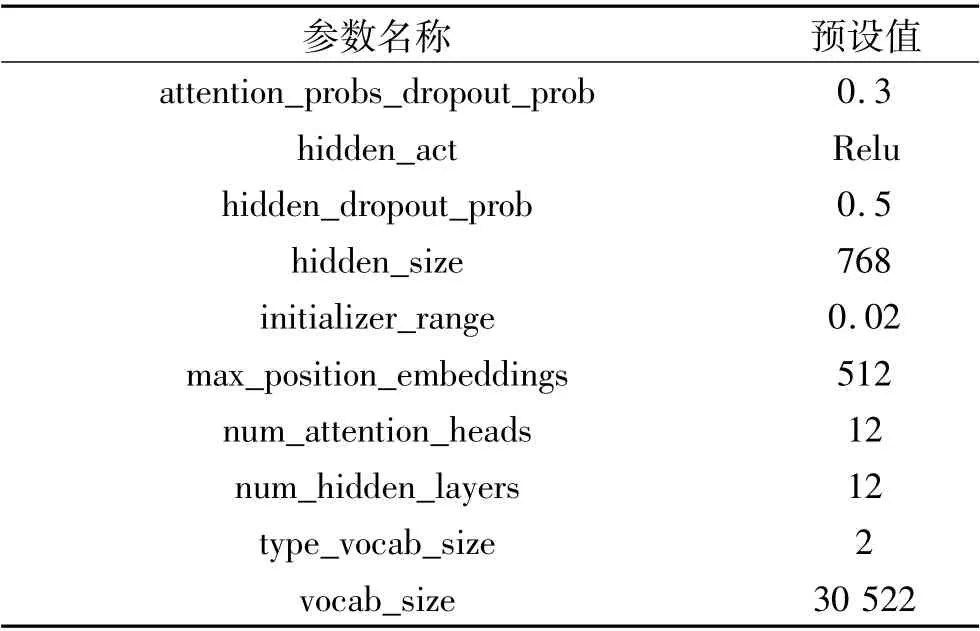

在對模型進行訓練時,基于隨機梯度法優化模型,通過Dropout 層減少過擬合情況的發生. 訓練迭代次數默認為8 500 次,初始學習率為5e-5,權重懲罰項為權重衰減,預設值為0.05. 懲罰attention 時,softmax 后dropout 概率為0.3,激活函數選擇ReLU 函數,隱藏層的Dropout 為0.5,隱藏層單元數為768,初始化范圍為0.02,用于生成位置嵌入的參數設置為512,每個隱藏層中的注意力頭數為12,隱藏層數為12,segment_ids 類別[0,1],詞典中詞數為30522. 具體設置如表2 所示.

3.3 實驗結果分析

3.3.1 相關對比模型

為驗證提出模型的有效性以及魯棒性,對比以下3 種較經典的命名體識別模型,進而評價改進模型的性能.相關解釋分析如下:

(1)HMM:隱馬爾可夫模型是關于時序的概率模型,隨機生成狀態序列,每個狀態生成一個觀測,而由此產生的隨機序列稱為觀測序列.

(2)BiLSTM-CRF:該模型是序列標注任務中的經典神經網絡模型,采用預訓練好Word2Vec 向量作為BiLSTM 網絡的輸入進行特征提取,最后將其特征矩陣輸入到CRF 中完成序列標注.

(3)BERT:該模型將文本中的每個字轉換為一維向量,作為模型輸入;模型輸出則是融合全文語義信息后的向量表示.此外,模型輸入除了字向量,還包含另外兩個部分:

文本向量:該向量的取值在模型訓練過程中自動學習,用于刻畫文本的全局語義信息,并與單字/詞的語義信息相融合.

位置向量:由于出現在文本不同位置的字/詞所攜帶的語義信息存在差異(比如:“我愛你”和“你愛我”),因此,BERT 模型對不同位置的字/詞分別附加一個不同的向量以作區分. 最后,BERT 模型將字向量、文本向量和位置向量的加和作為模型輸入.

3.3.2 改進方法的單一性能評估

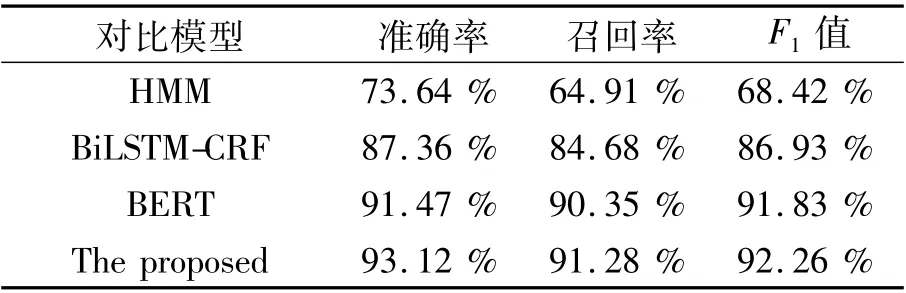

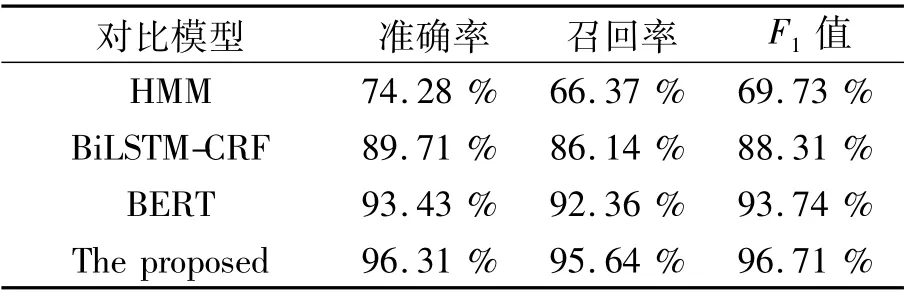

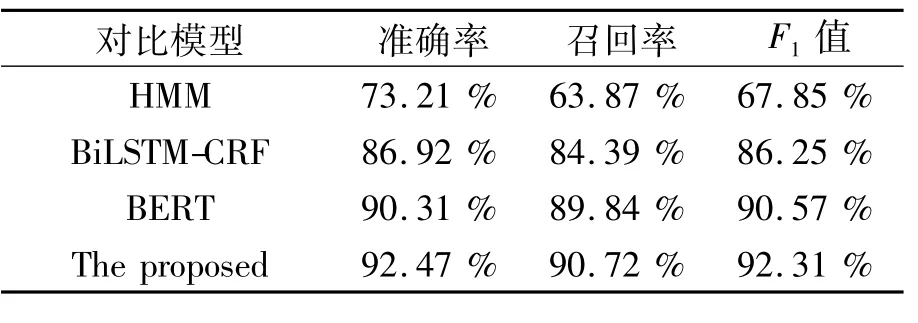

為驗證本文方法對特定種類實體的識別效果,基于手工標注的搜狐新聞數據集,實驗選取了人名、地名、組織名三類特定實體,與現有方法進行對比,實驗結果如表3 ~表5 所示.

表1 相關實驗的軟硬件環境Tab.1 Hardware and software environment of relevant experiments

表2 模型相關參數設置Tab.2 Model parameters setting

表3 地名識別效果對比Tab.3 Comparison of place name recognition effect

表4 人名識別效果對比Tab.4 Comparison of name recognition effects

由表3 ~表5 可知,與現有的模型相比,改進方法的準確率、召回率以及F1值均有一定程度的提升,說明了融合知識圖譜信息對中文命名實體檢測的方法是有效的.此外,由于組織類實體容易出現地名以及人名的嵌套,對其識別造成了一定的干擾,識別難度與地名、組織名相比有所提升.觀察實驗結果可知,組織名的識別效果相較于地名、人名有所下降,符合實驗預期結論.

3.3.3 改進方法的綜合性能評估

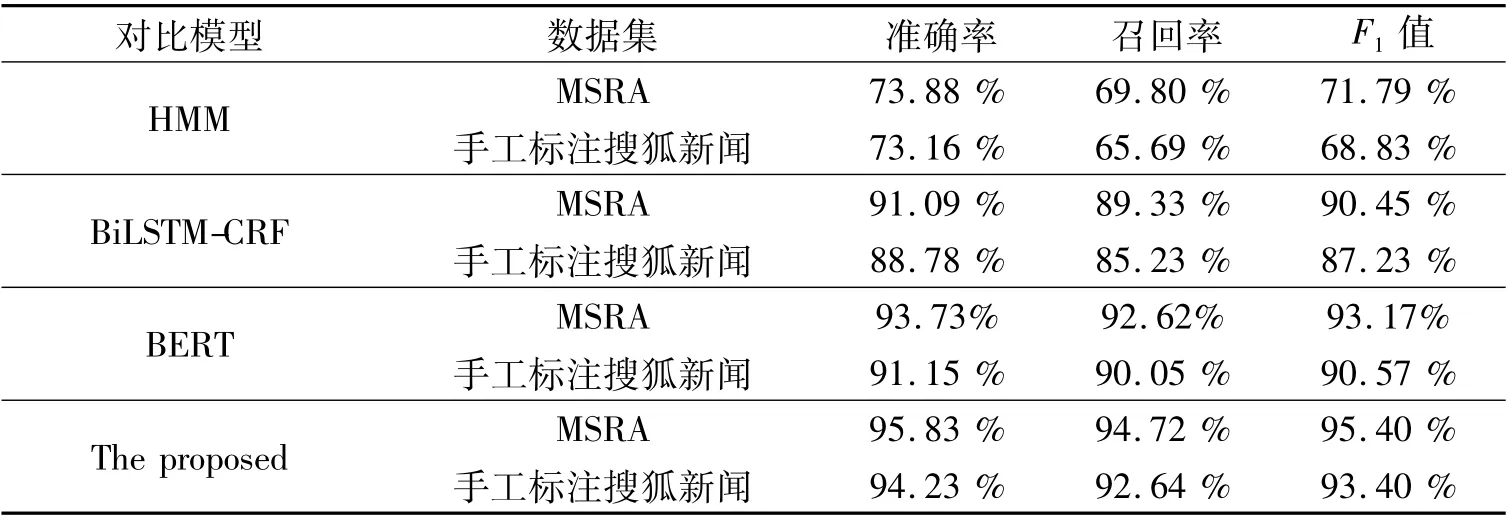

借助混淆矩陣,在兩個數據集上分別進行訓練,對模型的綜合性能進行評估,相關結果如表6 所示.

表5 組織名識別效果對比Tab.5 Comparison of organizational name recognition effects

表6 實驗結果對比Tab.6 Comparison of experimental results

由表6 可知,本文提出模型的識別效果領先于HMM、BERT 與BiLSTM-CRF.BERT 模型強調通過強力的Transformer 直接構建語言模型,而本文模型一方面通過融入知識圖譜信息加強模型學到的語言知識.另一方面,通過K-Encoder 知識聚合器和知識增強策略,將文本和知識圖譜中的異構信息更好的相融合.此外,對比不同模型的數據量(刪除MSRA 數據集中的部分數據,再將刪除后的數據用于本文模型的訓練,此次訓練的數據量為原有MSRA 數據集的50 %),可以得出所提出模型的命名體識別效果優于HMM、BILSTM-CRF 與BERT 不是因為數據量.

綜上所述,本文提出的模型更具有競爭力,明顯優于對比的其他方法.在MSRA 與搜狐新聞網標注數據集的實驗對比中取得了最佳的結果,F1值分別達到了95.4 %與93.4 %,驗證了該模型在中文命名實體識別中的有效性.

4 結束語

在本文中,將知識圖譜信息融入命名體識別模型中,為了更好地融合文本和知識圖譜中的異構信息,使用了K-Encoder 知識聚合器和知識增強策略.實驗結果表明,與傳統的命名體識別模型相比,如HMM、BiLSTM-CRF 等,融合知識圖譜信息的命名實體識別方法具有更好的識別效果.未來的研究主要從兩方面進行,一方面,將多種結構的知識引入命名體識別模型,從而增強模型的魯棒性.另一方面,啟發式地標注更多真實語料庫,以進行更大規模的預訓練.