基于卷積神經(jīng)網(wǎng)絡(luò)技術(shù)實現(xiàn)街道字符識別

袁姍姍

摘要:卷積神經(jīng)網(wǎng)絡(luò)作為深度學(xué)習(xí)領(lǐng)域近年來最優(yōu)秀的算法之一,已經(jīng)廣泛應(yīng)用于各種計算機(jī)視覺任務(wù),尤其在圖像分類任務(wù)中,卷積神經(jīng)網(wǎng)絡(luò)憑借其極高的分類準(zhǔn)確率,使用率已經(jīng)遠(yuǎn)超過傳統(tǒng)的機(jī)器學(xué)習(xí)算法。街道字符識別作為圖像分類任務(wù)的一種,為了完成這個分類任務(wù),全文基于卷積神經(jīng)網(wǎng)絡(luò)技術(shù),首先對數(shù)據(jù)集進(jìn)行讀取、并針對數(shù)據(jù)量較少問題,采取一系列的數(shù)據(jù)增強(qiáng)操作,然后完成卷積神經(jīng)網(wǎng)絡(luò)模型的構(gòu)造。通過對模型的訓(xùn)練,測試結(jié)果顯示測試集和驗證集準(zhǔn)確率分別為0.9523和0.7453,出色地完成了對街道字符的識別任務(wù),并驗證了所搭建模型的有效性和優(yōu)異性。

關(guān)鍵詞:深度學(xué)習(xí);卷積神經(jīng)網(wǎng)絡(luò);圖像分類;街道字符識別

1 引言

圖像作為重要的信息傳遞方式引起了當(dāng)今學(xué)者們和工業(yè)者極大的重視,圖像信息及圖像深層蘊(yùn)含的語義信息有著巨大的價值。街道字符作為圖像分類領(lǐng)域典型的分類任務(wù)之一,如何將街道字符中包含的街道信息和數(shù)字等字符信息提取出來并正確分類,是一個具有實際意義的研究課題。在街道上,隨處可見的街牌、門牌的背后蘊(yùn)含豐富的數(shù)字信息、地址信息以及文化信息,更應(yīng)該合理地運用這寶貴的圖像信息資源,挖掘信息中的內(nèi)在聯(lián)系,首要的就是通過計算機(jī)對這些街道字符信息進(jìn)行自動地識別。文中采用卷積神經(jīng)網(wǎng)絡(luò)技術(shù),就如何高精度正確的區(qū)分街道字符這一問題展開研究,結(jié)合街道字符信息特點和卷積神經(jīng)網(wǎng)絡(luò)的技術(shù)手段,來完成任務(wù)要求。

2 卷積神經(jīng)網(wǎng)絡(luò)簡介

卷積神經(jīng)網(wǎng)絡(luò)[1](CNN)是一種優(yōu)秀的人工神經(jīng)網(wǎng)絡(luò)。卷積神經(jīng)網(wǎng)絡(luò)在許多領(lǐng)域都有優(yōu)異的性能,卷積神經(jīng)網(wǎng)絡(luò)最大的優(yōu)點是其訓(xùn)練結(jié)果的精度遠(yuǎn)遠(yuǎn)高于傳統(tǒng)的算法。特別是在計算機(jī)視覺領(lǐng)域,卷積神經(jīng)網(wǎng)絡(luò)是解決圖像分類、圖像檢索、目標(biāo)檢測和語義分割問題的主流模型。卷積神經(jīng)網(wǎng)絡(luò)的每一層都由許多卷積核組成。每個卷積對圖像進(jìn)行卷積操作,并將它們輸出到下一個輸入。隨著網(wǎng)絡(luò)層的增加,卷積核會逐漸擴(kuò)大接受域,減小圖像的大小。從結(jié)構(gòu)上看,卷積神經(jīng)網(wǎng)絡(luò)是一個分層模型。輸入的是原始圖像數(shù)據(jù),最終輸出的是經(jīng)過多層運算后的精度結(jié)果。卷積神經(jīng)網(wǎng)絡(luò)由卷積、池化、輸入、輸出和全連接層組成。以最經(jīng)典的LeNet[2]模型為例,說明卷積神經(jīng)網(wǎng)絡(luò)的結(jié)構(gòu)組成。LeNet模型的網(wǎng)絡(luò)結(jié)構(gòu),是由兩個卷積層,兩個池化層和兩個全連接層組成。LeNet模型卷積核的大小都是5×5,步長stride=1,池化層使用最大池化。通過多次卷積和池化,將輸入圖像像素映射到具體輸出。例如,在分類任務(wù)中,將不同類別的概率輸出進(jìn)行轉(zhuǎn)換,然后計算卷積神經(jīng)網(wǎng)絡(luò)模型的真實標(biāo)簽和預(yù)測結(jié)果之間的差異,并通過反向傳播更新每一層的參數(shù),更新完成后再次重復(fù)正向傳播,以此類推,直到訓(xùn)練完成。與傳統(tǒng)的機(jī)器學(xué)習(xí)模型相比,卷積神經(jīng)網(wǎng)絡(luò)有一種端到端的方法,即只需要輸入相應(yīng)的數(shù)據(jù)集,經(jīng)過訓(xùn)練后就可以直接輸出結(jié)果。因此,在卷積神經(jīng)網(wǎng)絡(luò)的訓(xùn)練過程中,直接從圖像輸入到最終結(jié)果的輸出,不涉及煩瑣的特征提取步驟也不需要任何的人為參與,就可以得到結(jié)果。

回顧卷積神經(jīng)網(wǎng)絡(luò)的發(fā)展歷程,模型大多都是隨著層數(shù)和參數(shù)量的增長來更新?lián)Q代的。模型的交替更新中,不得不提到LeNet-5、AlexNet[3]兩個優(yōu)秀的卷積神經(jīng)網(wǎng)絡(luò)模型。LeNet-5模型是在1998年由Yann LeCun等搭建的模型。他們不但提出了卷積、池化、也第一次正式提出卷積神經(jīng)網(wǎng)絡(luò)局部感受野的理論依據(jù)。LeNet-5模型算是卷積神經(jīng)網(wǎng)絡(luò)引起學(xué)者們廣泛關(guān)注的看開端。而AlexNet模型就是將卷積神經(jīng)網(wǎng)絡(luò)推入學(xué)者們研究熱點的催化劑。AlexNet模型在2012年由Hinton等人設(shè)計搭建完成的。在ImageNet大規(guī)模的圖像分類競賽中,AlexNet模型以極大的優(yōu)勢領(lǐng)先其他的機(jī)器學(xué)習(xí)的算法,將人們的目光聚焦在卷積神經(jīng)網(wǎng)絡(luò)技術(shù)上,作為推廣卷積神經(jīng)網(wǎng)絡(luò)的強(qiáng)力推手,AlexNet模型功不可。隨后,越來越多的CNN模型,如VGG[4]、InceptionV3[5]和ResNet[6]等,被學(xué)者們搭建出來,并成功在各個領(lǐng)域廣泛的應(yīng)用。

3 基于卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行街道字符識別

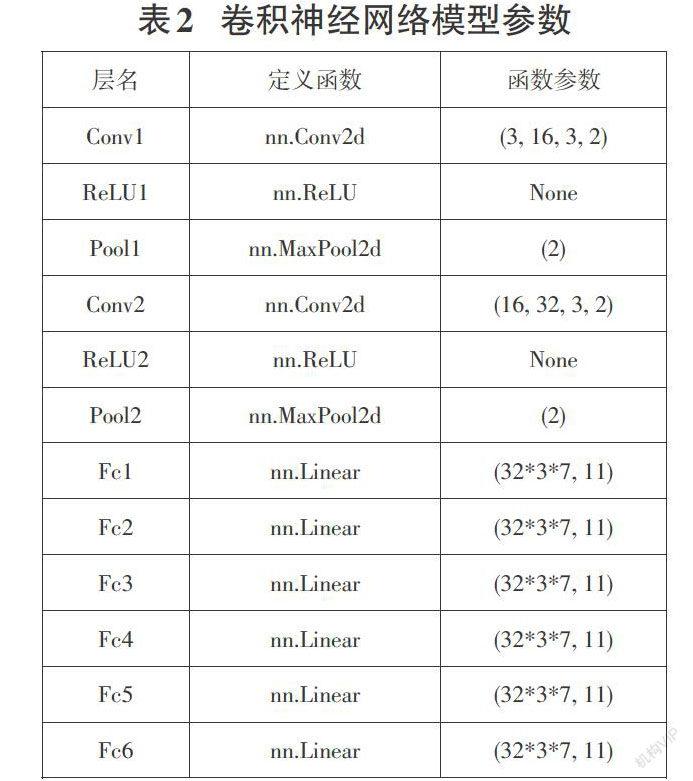

基于卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行街道字符識別主要分為數(shù)據(jù)集的準(zhǔn)備、數(shù)據(jù)讀取、數(shù)據(jù)增強(qiáng)、模型的訓(xùn)練與驗證這四個步驟。數(shù)據(jù)集的獲取是整個實驗的基礎(chǔ),選取合適的數(shù)據(jù)集,不僅有利于實驗還可以更方便地進(jìn)行橫向的對比,來驗證模型的優(yōu)劣。數(shù)據(jù)讀取與數(shù)據(jù)增強(qiáng)屬于對圖像數(shù)據(jù)的預(yù)處理工作,將圖像進(jìn)行規(guī)范的讀取,并用數(shù)據(jù)增強(qiáng)的方法來增加數(shù)據(jù)集的樣本量來更好的訓(xùn)練所構(gòu)建的卷積神經(jīng)網(wǎng)絡(luò)。模型的訓(xùn)練與驗證中從模型的搭建、驗證集的構(gòu)造、模型的保存、調(diào)參等多個方面,對模型訓(xùn)練驗證過程做出了詳細(xì)的說明。通過對卷積神經(jīng)網(wǎng)絡(luò)模型的訓(xùn)練,結(jié)果顯示,所搭建的模型高精度地完成了對街道字符的識別任務(wù)。文中實驗基于python編程語言。實驗使用pytorch框架對卷積神經(jīng)網(wǎng)絡(luò)模型進(jìn)行搭建。

3.1 數(shù)據(jù)集

本文任務(wù)是街道字符識別任務(wù),數(shù)據(jù)集選用The Street View House Numbers[7] 數(shù)據(jù)集,簡稱SVHN。SVHN數(shù)據(jù)集中所有的圖像,都是真實存在的,它們是源自真實的房屋號碼。在SVHN的使用中,SVHN數(shù)據(jù)集常用于模式識別,圖像分類算法的開發(fā)。因為SVHN數(shù)據(jù)集中圖像像素偏小,所以它只需要簡單的預(yù)處理和讀取操作即可,同時訓(xùn)練時相對時間較短。盡管SVHN數(shù)據(jù)集中圖像的裁剪數(shù)字很小,但是它合并了更多數(shù)量級的標(biāo)簽數(shù)據(jù),標(biāo)簽數(shù)據(jù)量超過600,000個圖像。此數(shù)據(jù)集主要的應(yīng)用就是用于識別自然場景圖像中的字符和數(shù)字的模型的訓(xùn)練及測試。數(shù)據(jù)集大小為2.5G,格式為.mat 文件,共含有10個類別,一共含有630,420張圖片。所有原始圖片的大小均已調(diào)整為固定的32 x 32像素分辨率,原始字符邊框在適當(dāng)?shù)某叽缟蠑U(kuò)展為方形窗口,其中包含圖像中每個圖像的邊界框的位置、大小和標(biāo)簽。

3.2 數(shù)據(jù)讀取

本文任務(wù)是針對原始的圖像數(shù)據(jù),精準(zhǔn)地識別街道路牌圖像中的字符。第一步要做的是讀取數(shù)據(jù),我們使用的是Python語言,調(diào)取常用的Pillow庫和OpenCV庫完成對數(shù)據(jù)的讀取和寫入。 下文從兩個庫的具體用法,包括常用函數(shù)等方面,舉例說明這兩個函數(shù)庫的使用方法。