基于小波時頻圖與輕量級卷積神經網絡的螺栓連接損傷識別

卓德兵,曹 暉

(1. 重慶大學土木工程學院,重慶 400045;2. 重慶大學山地城鎮建設與新技術教育部重點實驗室,重慶 400045;3. 吉首大學土木工程與建筑學院,張家界 427000)

螺栓連接廣泛應用于工程結構,尤其是鋼結構和組合結構。在服役期內,結構遭遇的不可避免的振動和沖擊等外部作用會導致螺栓連接狀態的改變,出現松動、滑移甚至脫落等問題,從而降低結構的剛度、破壞結構的完整性,危及結構安全[1]。因此,螺栓連接狀態的監測,對于保證結構安全、避免重大安全事故和降低事故危害性具有重要意義。

目前,常用的螺栓連接損傷檢測方法分為基于模態和基于阻抗兩類[2]。螺栓松動會改變結構連接狀態,從而導致結構模態參數發生相應的變化[3]。將實測的結構模態參數與基準參數比較,從而判斷螺栓連接狀態是基于模態的檢測方法的基本原理。然而,結構的低階振動參數和低頻段傳遞特性等特征參量對螺栓連接損傷這樣的局部特性變化不夠敏感[4]。如果要提高特征參量的靈敏度,就需要在高頻段甚至極高頻段準確測量和識別結構的模態參數,這在目前還存在很大困難。此外,結構模態參數的識別多是基于線彈性振動的假設,會不可避免地過濾掉重要的非線性振動現象。這使得其在螺栓連接狀態監測上存在先天不足[5 ? 6]。

基于阻抗的方法是比較結構監測狀態與基準狀態下的高頻段阻抗譜,判別螺栓連接的損傷程度。自Sun等[7]首次提出應用壓電阻抗方法監測桁架結構的節點狀態以來,不少學者研究了基于該方法的螺栓連接狀態的監測和辨識[8 ? 10]。這種方法受到測點數量的制約。以具有大量的連接節點和螺栓的鋼桁架為例,同時監測所有的節點,需要大量的傳感器,經濟性不佳[2]。而且與基于模態的方法一樣,基于阻抗的技術往往對激勵和實測環境有嚴格的要求,比如通常需要結構的某些功能暫時中斷,這給在線監測造成了困難[1 ? 2]。此外,這類方法使用的采集設備通常較大或昂貴(或二者兼具),不利于實際應用[7 ? 9]。

近年來,利用聲音信號進行損傷檢測的技術愈發興起。聲音信號具有時間分辨率高,傳播具有全向性且不受能見度限制等優點[11]。不同于傳統的振動信號測量,需要將傳感器固定于被測物體表面且對布點有較高的要求,聲音測量屬于非接觸式測量,采用的傳聲器測量裝置受空間限制少、安裝方便且造價相對較低[12],并能夠有效避免加速度傳感器測量時普遍存在的飽和及失效現象。Garcia-Perez等[13]基于高分辨率光譜分析的多信號分類算法,利用聲音信號對存在單個故障的感應電動機的故障狀態進行識別。Amarnath等[14]采用決策樹機器學習方法,對從軸承現場附近采集的聲音信號進行分析處理,實現旋轉機械軸承故障診斷。Madhusudana等[15]提出了一種基于決策樹和聲信號小波變換技術的故障診斷方法,可以對銑刀表面粗糙度、尺寸公差和刀具狀態進行識別和監控。Lu等[16]提出了一種基于瞬態聲信號分析的變速器軸承故障診斷方法,該方法可以準確地估計故障引起的脈沖的相位信息,為實現變速電機軸承故障診斷提供了一種簡單有效的方法。瞿金秀等[17]構建了一種基于聲音信號的結構損傷識別模型,并將該模型應用于實驗懸臂梁和鐵路轉轍機動作桿的裂紋損傷識別。

基于聲音信號的損傷識別方法研究目前大多集中在旋轉機械領域,借鑒傳統的語音識別技術,即通過人為選取特征參數,采用決策樹、支持向量機等方法進行建模,識別損傷狀態下的聲音信號。依靠人工選取的特征往往比較單一并帶有較強的主觀性。決策樹和支持向量機屬于淺層模型,需要進行復雜的調參,且每個方法都是針對具體應用,泛化能力及魯棒性較差,影響了其實用性[18]。近年來,得益于計算機硬件水平的提升,尤其是云計算和大規模GPU并行計算的發展,以深度卷積神經網絡為代表的深度學習技術在圖像分類、目標檢測和圖像分割等計算機視覺任務中表現出了巨大的優越性[19],更多更深的卷積神經網絡如AlexNet(2012年)、VGGNet(2014年)、GoogleNet(2014年)、ResNet(2015年)等相繼被提出[20 ? 22]。深度學習技術主要依靠數據驅動進行特征提取,通過學習大量樣本得到深層的、特定的特征表示,對樣本集的表征更高效和準確,魯棒性更強,泛化能力更好。目前,利用深度卷積神經網絡解決工程問題成為了眾多領域的研究熱點[23 ? 27]。深度卷積神經網絡在聲學建模方面也取得了飛速的發展,并逐漸成為語音識別的主流模型[28]。在非語音信號識別中,如環境聲音識別[29],變壓器聲紋識別[30],深度學習也有一定的應用。

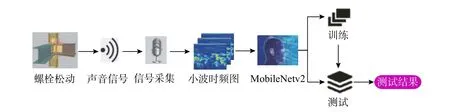

本文以振動環境下螺栓連接結構為研究對象,提出基于聲音信號的螺栓連接損傷智能識別方法。對于常年處于振動環境中的鋼桁架結構,如載人索道支架,當結構桿件的連接螺栓發生松動時,螺栓連接界面在鋼絲繩和吊籃激勵作用下發生碰撞而發出特有的聲音信號。與普通旋轉機械故障產生的聲音信號不同,螺栓松動發出的聲音信號具有典型的時變非線性特征,同時考慮到工程結構所處室外環境噪聲干擾嚴重,本文將小波時頻圖與輕量級卷積神經網絡MobileNetv2相結合,充分發揮小波時頻分析處理非平穩信號的優勢和MobileNetv2強大的圖像分類能力,實現基于聲音信號的螺栓連接損傷識別。

1 螺栓松動損傷識別原理

1.1 聲音信號的預處理

首先,對麥克風采集的聲音信號進行分幀、加窗處理,同時求取各幀信號的短時能量。

假設x(n)為麥克風接收到的聲音信號離散序列,ω(n) 為窗函數,L為幀長,inc為幀移,N為分幀后的總幀數,則第i幀信號xi(n)可以表示為:

第i幀信號xi(n) 的短時能量E(i)定義如下:

1.2 小波時頻分析

經分幀加窗處理之后,對聲音信號進行連續小波變換。連續小波變換的公式如下:

式中,母小波ψ 采用Complex Morlet小波。Complex Morlet是一種常用的復值小波,與其它小波相比,該小波在時頻兩域均具有良好的分辨率,在時頻圖上反映的時頻聚集性好,適合于處理非平穩的聲音信號。

將聲音信號進行連續小波變換生成為時頻圖,需要用到matlab小波工具箱中的cwt( )、scal2frq( )、imagesc( )等函數,其步驟為:首先確定小波基和尺度,并利用cwt( )求小波系數coefs,然后用scal2frq( )將尺度序列轉換為實際頻率序列f,最后結合時間序列t,用imagesc(t,f,abs(coefs))畫出小波時頻圖。

1.3 MobileNetv2輕量級卷積神經網絡

自從2006年Hinton等[31]在《Science》上首次提出深度學習的概念,深度神經網絡的表征學習能力得到了廣泛關注。在深度學習領域中,已經驗證的典型成熟算法有卷積神經網絡(CNN)、循環神經網絡(RNN)、生成對抗網絡(GANs)、深度強化學習(RL)等。其中CNN是深度學習最為典型的網絡模型,一般由卷積層、池化層和全連接層等組成,CNN通過構建多個能夠提取輸入數據特征的卷積核,結合稀疏連接、權重共享、空間或時間上的降采樣,對輸入數據進行逐層卷積及池化,逐級提取隱藏在數據之中的拓撲結構特征。

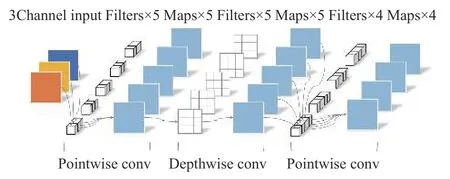

然而,經典的CNN由于模型參數和運算量龐大,分析時需要占用大量的存儲空間且對計算機硬件要求高。在工程應用中,很多設備(如移動、嵌入式設備)的計算能力和存儲空間都很有限,難以運行這樣的模型,不利于CNN技術的工程普及。為了能夠讓深度網絡適應這些設備,2017年,Howard等[32]提出了輕量級CNN網絡MobileNetv1。MobileNetv1的核心層使用了一種稱之為Separable Convolution的操作來替代傳統的標準卷積,該網絡在保證計算精度基本不降低(或小幅降低)的前提下大幅減少模型參數與運算量。2018年,Sandler等[33]又進一步提出了MobileNetv2。MobileNetv2網絡在卷積過程中使用了一種名為Inverted Residuals and Linear Bottlenecks的結構,如圖1所示,解決了上一版本中Separable Convolution存在的輸入層Kernel數量固定的瓶頸,而且模型更小,準確率更高。

圖1 MobileNetv2卷積過程Fig.1 Convolution process of MobileNetv2

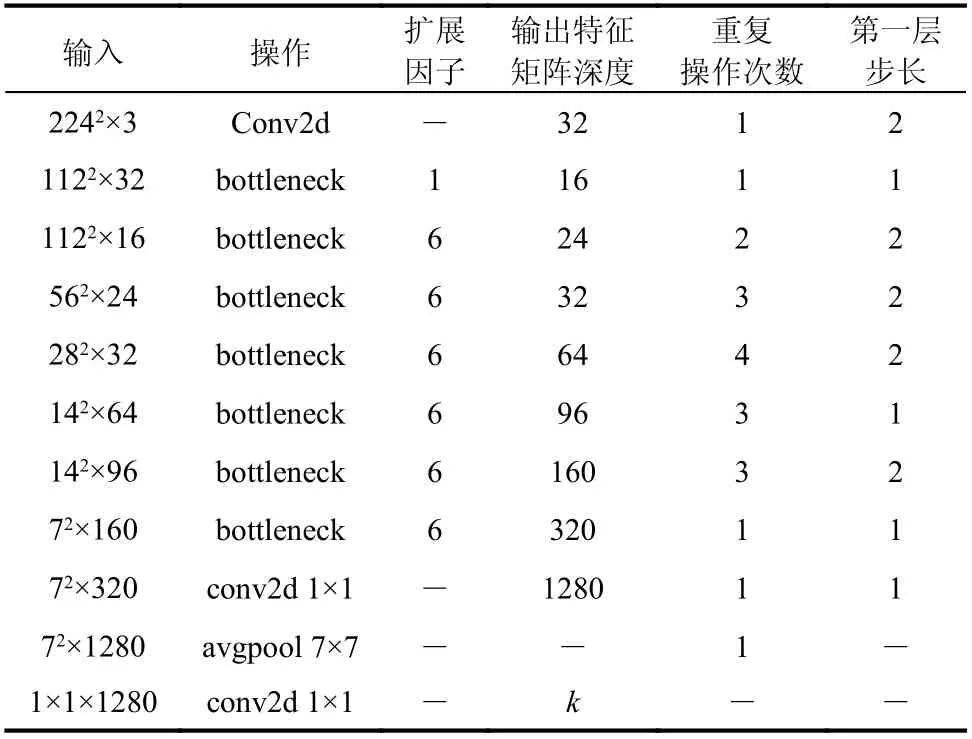

本文采用的網絡結構模型為MobileNetv2模型,如表1所示。

在表1中,擴展因子用于調整輸入圖像的大小,同一序列中的所有層具有相同的輸出通道數,除第一層外,其他層的步長為1;所有空間卷積使用3×3的核。

表1 網絡結構模型Table 1 Network structure model

1.4 基于小波時頻圖與MobileNetv2的螺栓松動識別方法

基于小波時頻圖與MobileNetv2的螺栓松動識別方法結構圖如圖2所示。該方法分為訓練和測試兩個階段,訓練階段是利用傳聲器采集足夠數量的螺栓松動聲音信號和環境噪聲信號,通過信號處理方法提取聲音信號的小波時頻圖作為輸入,利用設置好參數的MobileNetv2進行訓練得到螺栓松動識別模型。測試階段則是利用訓練好的模型對輸入的未知信號進行識別。

圖2 小波時頻圖- MobileNetv2螺栓松動損傷識別方法結構圖Fig.2 Structural diagram of bolt loosening damage identification method based on wavelet time frequency diagrams and MobileNetv2

2 鋼桁架試驗

2.1 試驗簡介

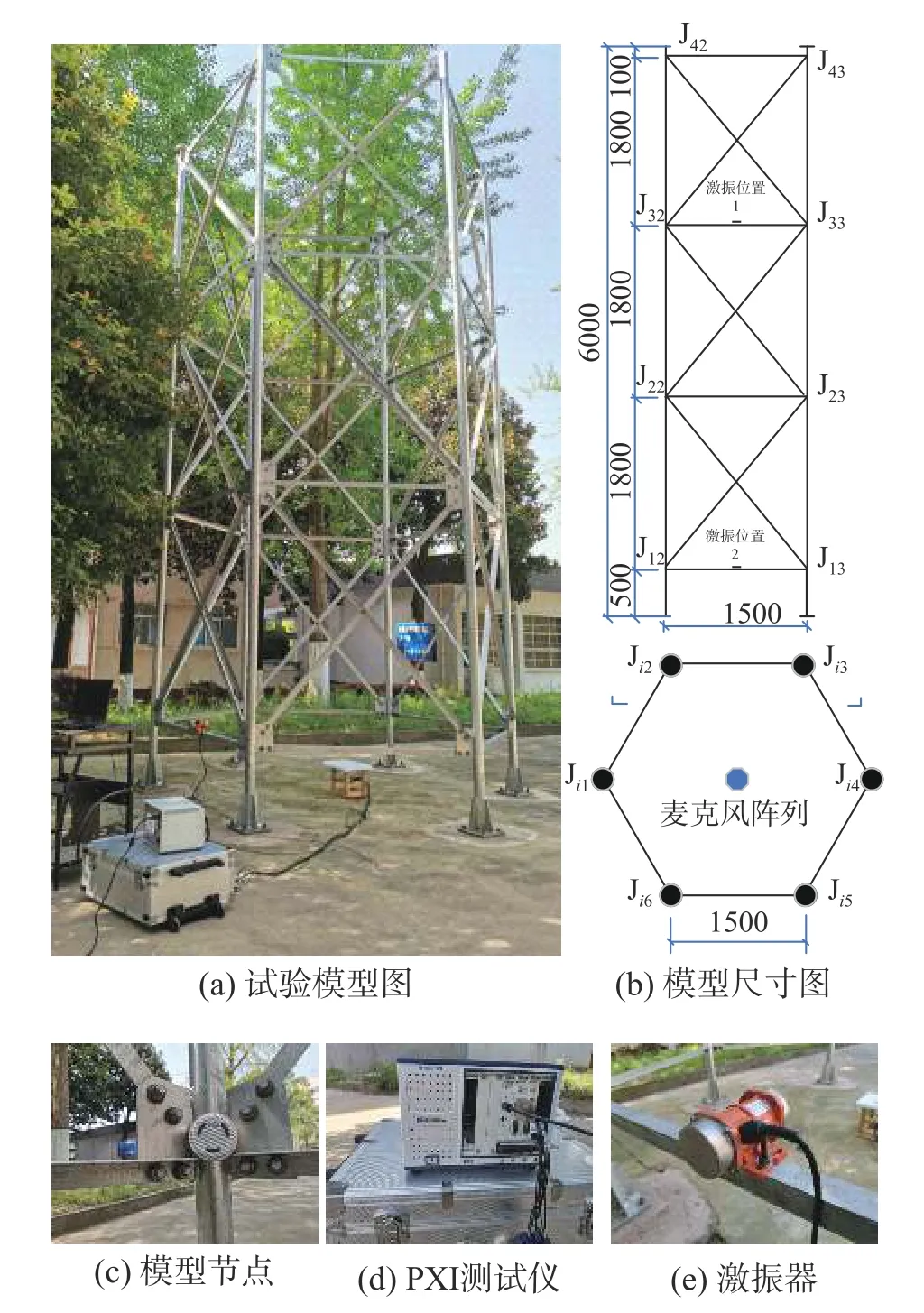

試驗模型為一位于室外地坪上的正六邊形鋼管塔架結構,如圖3所示。模型邊長為1.5 m,高度為6 m,共四層,底層距離地面高度為0.5 m,其余三層高度為1.8 m。塔身立柱采用直徑為16 cm的Q235無縫鋼管,所有的水平桿件和斜桿均采用等邊角鋼L40×4,各桿件端部與立柱節點板間采用2個M20螺栓連接(如圖3(a)),每根立柱與地面采用四個地腳螺栓連接。模型每層有6個節點,4層共計24個連接節點。為便于下文分析,對各節點統一編號,如圖3(b)所示,如Ji4表示第i層第4個節點。

本試驗數據采集系統由拾音設備、數據采集設備及計算機組成。拾音設備為放置于模型底部中心位置的8個麥克風組成的環形麥克風陣列,陣列直徑20 cm,距地面20 cm。麥克風采用MPA416全指向性麥克風,數據采集模塊采用PXI動態信號測試分析儀,如圖3所示。

試驗步驟如下:

步驟1:損傷工況、噪聲工況及復雜工況的模擬。通過松動不同位置、不同數量以及不同程度的螺栓,模擬10種損傷工況,如表2所示。通過一放置于J12節點位置處的手機控制的藍牙音箱(見圖3(c))模擬蟬鳴聲、音樂聲、下雨聲和語音4種常見環境噪聲工況。通過組合工況6+蟬鳴聲、工況6+下雨聲構造2種復雜工況。

表2 損傷工況Table 2 Damage cases

步驟2:模型激振。采用小型偏心式激振器進行激振,當測試第1層~第2層節點時,激振器固定于J12與J13節點之間的橫桿位置處。當測試第3層~第4層節點時,激振器固定于J32與J33節點之間的橫桿位置處,如圖3(e)所示。

圖3 試驗模型及測試系統Fig.3 Test model and test system

步驟3:信號采集。利用PXI動態信號測試分析儀分別采集10種損傷工況、4種噪聲工況以及2種復雜工況共計16種工況的聲音信號,信號采樣頻率為20 kHz。

2.2 聲音信號小波時頻分析

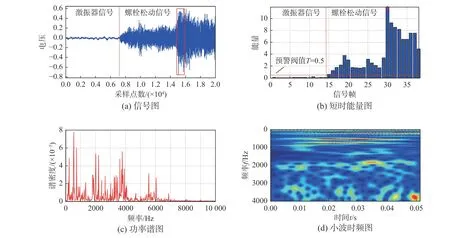

對采集到的各工況聲音信號進行分幀、加窗處理,并分析其短時能量。分幀的幀長取1024點,幀移取512點,加漢寧窗。采用Complex Morlet進行連續小波變換,其中帶寬參數和小波中心頻率均取3,尺度序列長度取256。

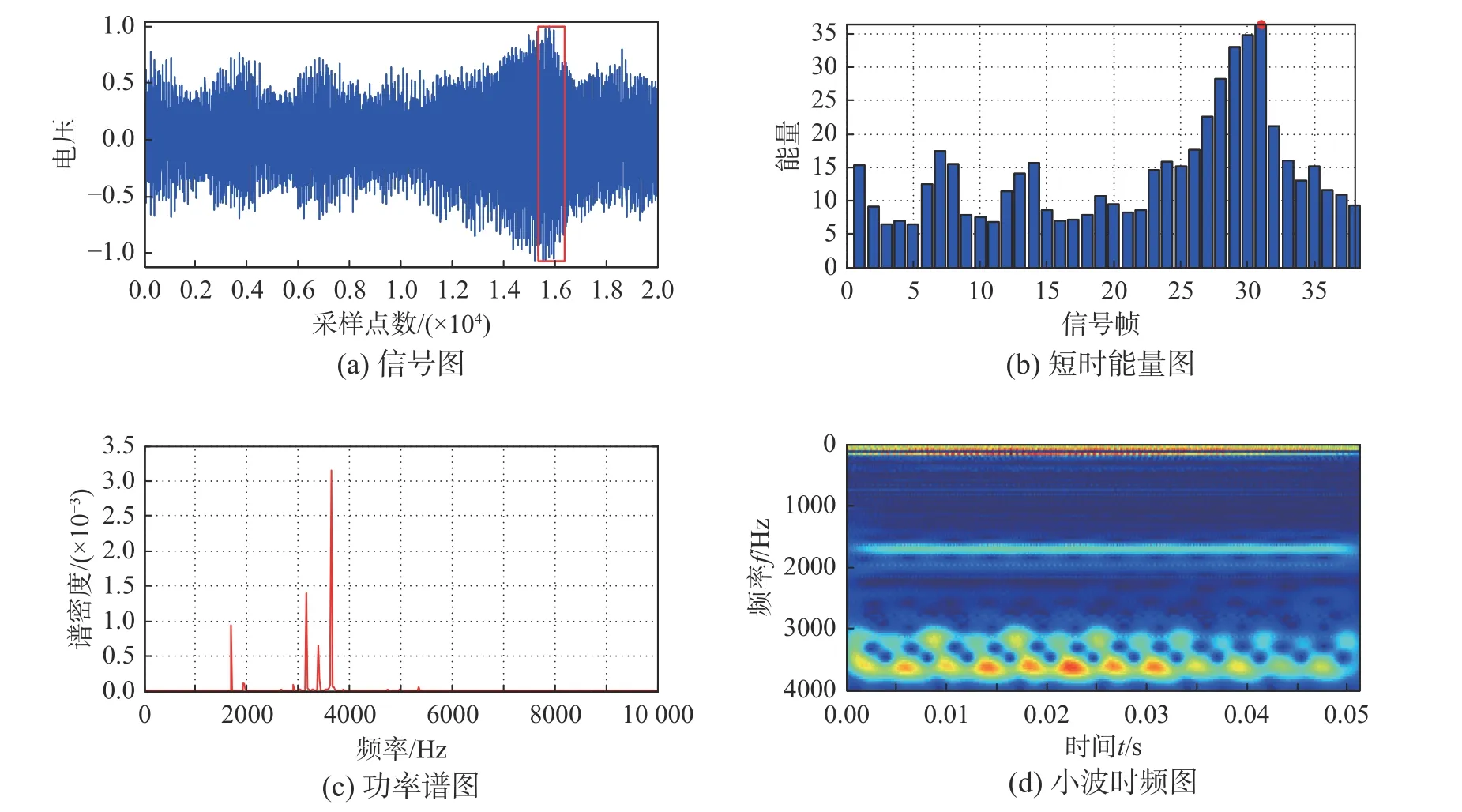

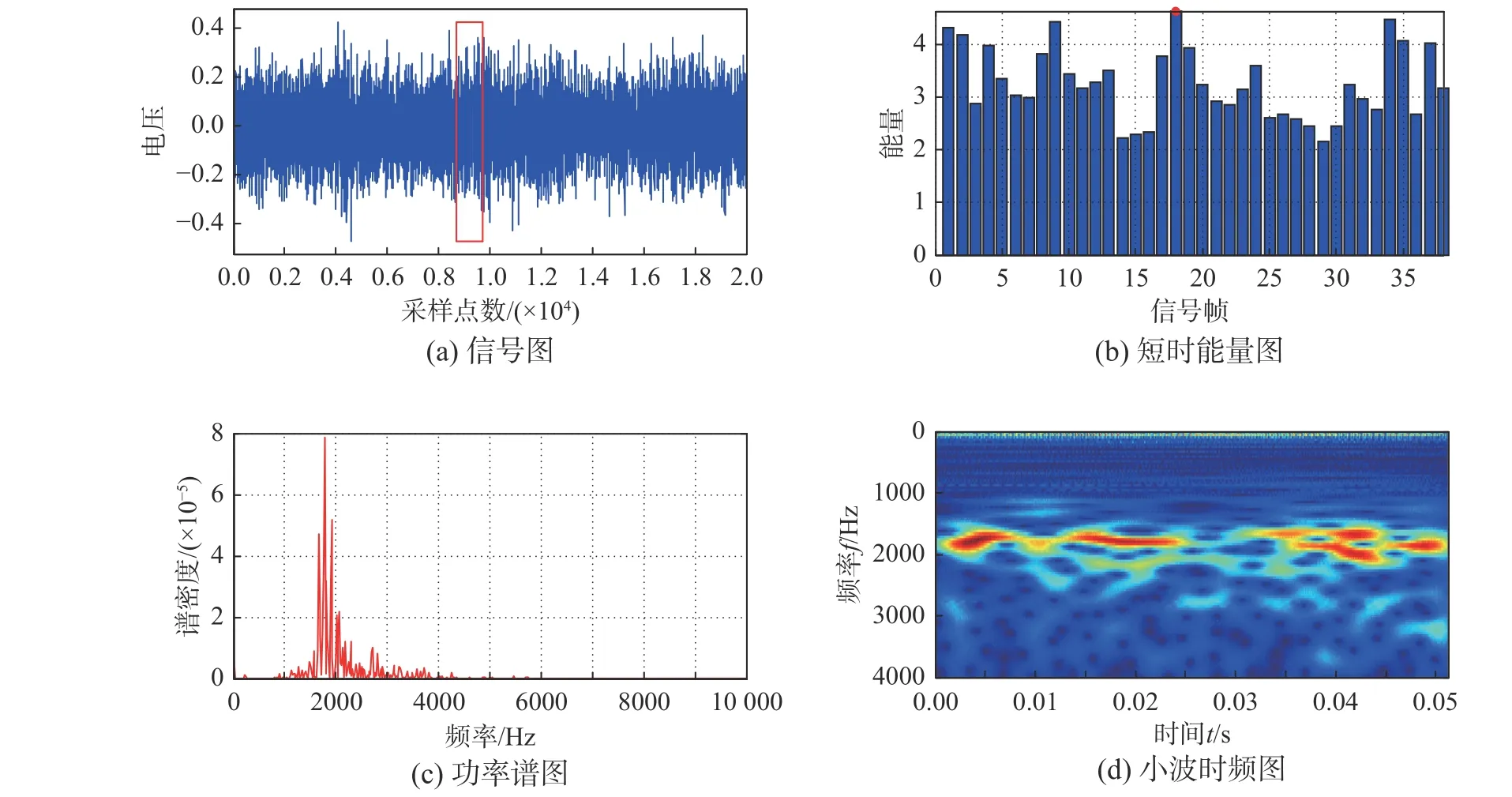

圖4~圖6分別給出了時長為1 s的蟬鳴聲、下雨聲、工況6聲音信號的典型波形圖和相應的38幀短時能量分布圖,以及利用短時能量最大的信號幀分析得到的功率譜圖和小波時頻圖。從圖4~圖6的功率譜圖可以看出,三類信號的頻率成分非常豐富,其中蟬鳴聲頻率主要分布在2000 Hz附近和3000 Hz~4000 Hz,下雨聲主要分布在1000 Hz~3000 Hz,而螺栓松動聲音的頻率在0 Hz~4000 Hz均有分布。因此,很難根據功率譜圖的特征識別各工況下的聲音信號。

圖4 蟬鳴聲信號圖及短時能量最大幀的分析結果Fig.4 Cicada sound signal diagram and analysis results of frame with the largest short-time energy

圖5 下雨聲信號圖及短時能量最大幀的分析結果Fig.5 Rain sound signal diagram and analysis results of frame with the largest short-time energy

圖6 工況6信號圖及短時能量最大幀的分析結果Fig.6 Signal diagram of Case 6 and analysis results of frame with the largest short-time energy

與功率譜圖不同,小波時頻圖顯示了信號頻率成分隨時間的變化。小波時頻圖通過冷暖顏色反映信號各頻率成分攜帶的能量大小,顏色越暖能量越大。從圖4~圖6中可以看出,三種信號的小波時頻圖暖色部分大多呈現不規則塊狀分布,且沿時間軸的顏色變化也十分復雜。這樣的時頻圖很難通過人工判斷或常規的模式識別方法找出其規律,從而辨別各工況下螺栓松動聲音信號。對此,輕量級卷積神經網絡MobileNetv2可以發揮其強大的圖像分類功能。

2.3 數據集構造

數據是深度學習的“原材料”,學習結果的好壞與數據的規模和質量密切相關。對本文設定的16種工況聲音信號重復實測3次,依次對麥克風接收到的聲音信號進行分幀、加窗預處理,根據短時能量大小選擇特定數目的信號幀,進而進行小波時頻分析構造數據集。本文在進行數據集構建時每一工況選取的典型信號時長為15 s,經分幀后共計有584幀信號。去除短時能量低于某一特定閾值的信號幀,選擇短時能量偏大的500幀信號進行小波時頻分析獲得其小波時頻圖。將每一個小波時頻圖作為一個樣本,可以得到一個由500個典型樣本構成的數據集。

圖6展示的是工況6采集到的一段時長為1 s的聲音信號,其中前半部分為激振器信號(含弱環境干擾),后半部分為螺栓松動信號。從圖6中可以看出,激振器信號的短時能量(約為0.2)要明顯小于螺栓松動信號。因此,為了排除激振器信號對最終結果的影響,提高分析效率,本文取一個稍微偏大的預警閥值T=0.5,即僅選擇T≥0.5的信號幀進行小波時頻分析。

對16種工況聲音信號分析得到的各小波時頻圖進行歸類并標注,其中10種損傷工況依次用A~J表示,4種噪聲工況用K~N表示,2種復雜工況用O和P表示。每個數據集按照8∶1∶1的比例隨機劃分出400個樣本作為訓練集,用以訓練模型參數。50個樣本作為驗證集,用來對模型的參數進行調優并初步評估模型的準確性,剩余的50個樣本作為測試集,用于評價模型的泛化能力。因此,最終構造的數據集為8000個樣本,其中訓練集樣本為6400個,驗證集和測試集樣本各為800個。

3 模型訓練

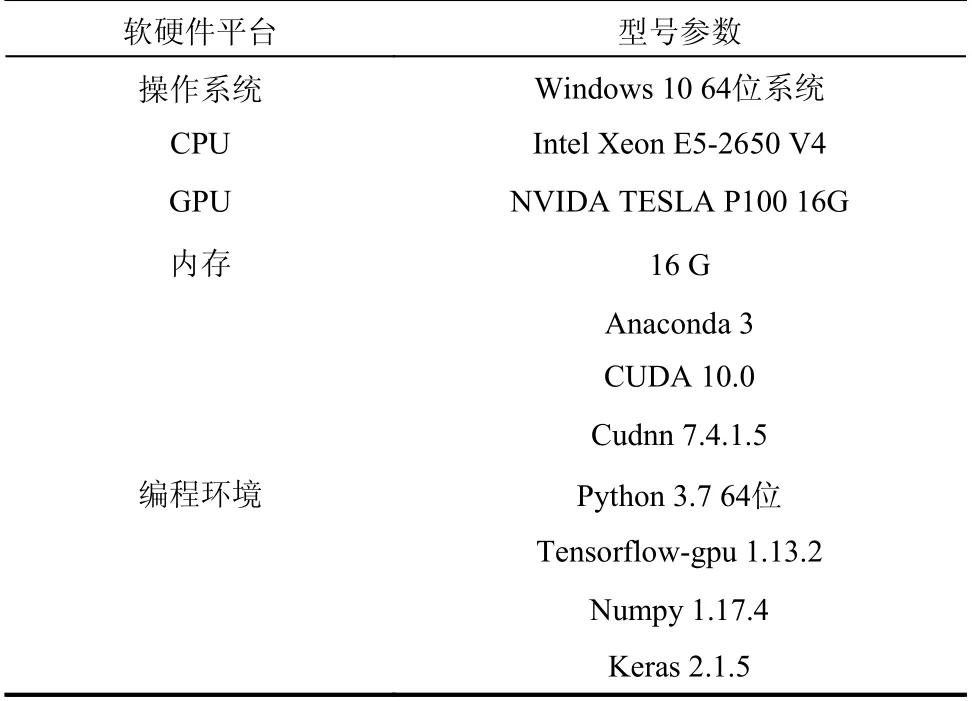

MobileNetv2卷積神經網絡在訓練時需要設置的參數主要有BatchSize、learning_rate、Dropout、Epochs、num_classes等。綜合考慮訓練集樣本特征和大小、計算機硬件水平、網絡結構的深度和復雜度等因素,設定BatchSize為32、learning_rate為0.0005、Dropout為0.2、Epochs為100、num_classes為16、損傷函數采用交叉熵(Cross-Entropy)損失函數。MobileNetv2模型運行的計算機平臺及編程環境如表3所示。

表3 計算機平臺及環境配置Table 3 Computer platform and environment configuration

圖7展示了當輸入模型的樣本幀長分別取128、256、512、1024和2048時,訓練集和驗證集的準確率(Accuracy)和損失值(Loss)隨著迭代次數(Epochs)的變化曲線圖。從圖7中可以看出,當幀長在1024以內時,樣本的幀長對模型訓練結果影響較大,幀長越長,模型的準確率越高,收斂速度越快,識別結果越穩定,相應最終損失值越小;而當幀長大于1024時,其改善效果不再明顯。因此,幀長設定為1024。

圖7 樣本幀長對MobileNetv2模型識別結果的影響Fig.7 Influence of sample frame length on recognition results of MobileNetv2 model

從圖7中還可以看出,當迭代次數在20以內時,訓練集和驗證集的準確率曲線和損失值曲線都變化較快;當迭代次數位于20和50區間時,其曲線變化速度明顯放緩;而當迭代次數大于50時,曲線變化則基本趨于穩定。如圖7中幀長為1024的情況,當迭代次數為1~20時,其訓練集準確率由63%提高到99%,損失值由1.06降為0.03,驗證集準確率由92%提高到99%,損失值由0.23降為0.0004;而當迭代次數等于100時,兩類準確率均達到100%,損失值則趨近于0。

此外,本文還將MobileNetv2模型的訓練結果與AlexNet、VGG16、GoogleNet與ResNet50等經典的圖像識別CNN模型的訓練結果進行了比較。各模型訓練集與驗證集的準確率曲線和損失值曲線如圖8所示,經100次迭代以后的識別結果如表4所示。

圖8 MobileNetv2模型與不同CNN模型的訓練結果對比Fig.8 Comparison of training results between MobileNetv2 and other CNN models

表4 各模型迭代100次的分類準確率和損失值Table 4 Classification accuracy and loss of each model after 100 iterations

從圖8和表4中不難看出,MobileNetv2模型與其它4種方法在經過100次迭代以后都已經收斂,其中從訓練集和驗證集準確率來看,MobileNetv2最好,其最終準確率都達到了100%,ResNet50和VGG16次之,而GoogleNet和AlexNet相對較差,尤其是后者驗證集準確率不到99%。從識別穩定性來看,MobileNetv2和ResNet50最好,其識別準確率和損失值曲線除了在少數位置出現波動以外,總體非常穩定。而其它三者相對較差,尤其是GoogleNet和AlexNet出現了較大程度的波動。因此,可以看出,相較于其它幾種模型,MobileNetv2無論是在識別準確率還是在穩定性方面的表現都更為優異。

為了考察MobileNetv2模型對計算設備存儲的占用情況,本文對比分析了各模型經100次迭代后的總參數量和分析過程生成的權重文件大小,如表5所示。結果表明:MobileNetv2模型的權重文件和總參數量都遠遠小于其它四類模型的權重文件和總參數量,證明了其在移動設備或嵌入式設備中應用的優越性。

表5 各模型100次迭代后的總參數量和權重文件大小Table 5 Total parameters and weight file size of each model after 100 iterations

4 模型測試

為了檢驗經過上述訓練之后得到的MobileNetv2模型的有效性及泛化能力,采用一組全新的測試集對模型進行測試。測試集的構造方法如2.3節所示。

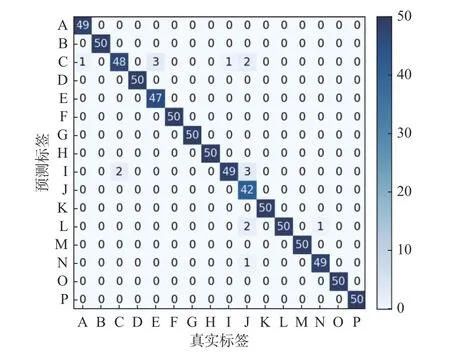

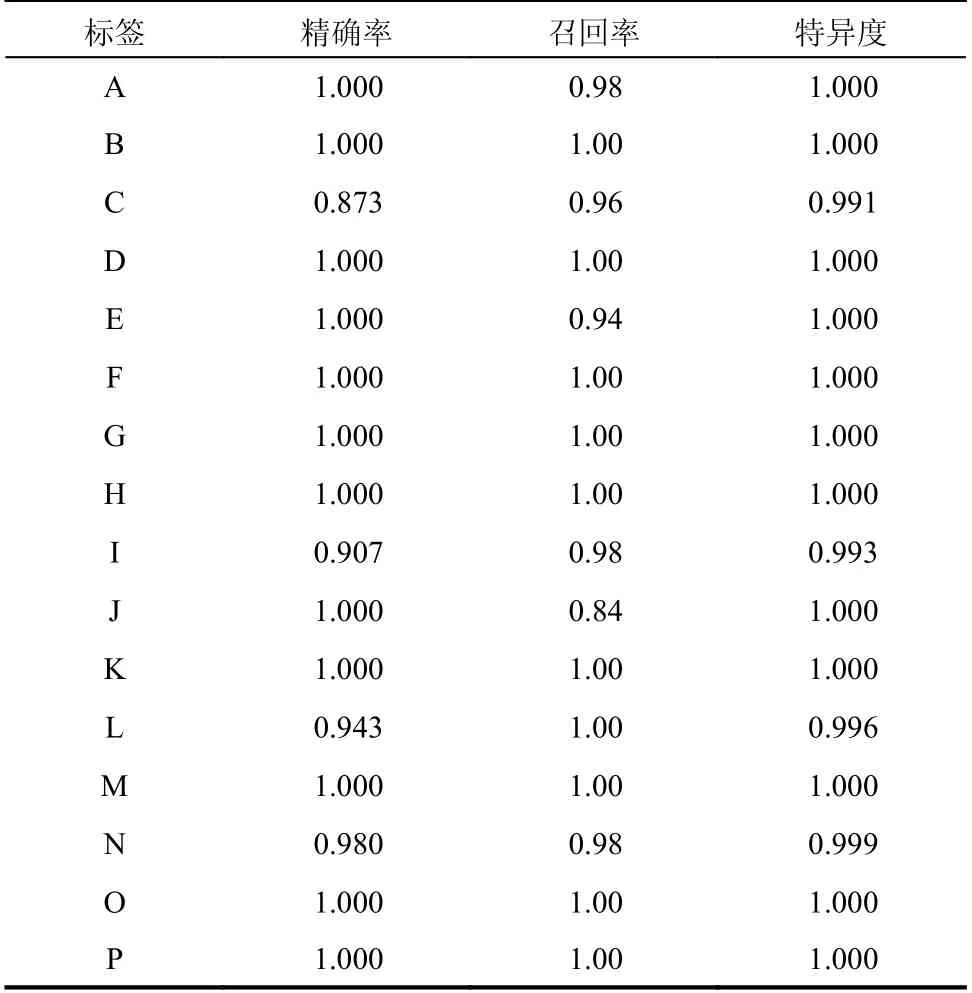

本文采用混淆矩陣(Confusion matrix)、精確率(Precision)、召回率(Recall)和特異度(Specificity)四個指標來衡量模型對測試樣本的分類準確程度[27],分析結果如圖9和表6所示。

圖9 混淆矩陣Fig.9 Confusion matrix

表6 分類精確率、召回率和特異度Table 6 Precision, recall and specificity

分析發現,訓練得到的MobileNetv2模型對測試樣本分類準確率達到99.8%,錯誤率僅為0.2%。其中,除了標簽A、I和N有1個樣本,C有2個樣本,E有3個樣本,J有8個樣本被錯分到其它類別以外,其它標簽的50個測試樣本全部被正確識別并分類。通過表6可以看出,盡管標簽L對應的50樣本全部被準確識別,但由于標簽G有2個樣本被錯分為L,因此,其精確率和特異度分別為0.943和0.996。對于標簽C,盡管只有2個樣本被錯分為I,但由于E有3個樣本,I有1個樣本,J有2個樣本被錯分為C,因此,其精確率只有0.873,而召回率和特異度分別為0.96和0.991,以此類推。

上述結果表明:本文所采用的基于小波時頻圖的MobileNetv2模型不僅能識別不同類型的環境噪聲信號,還能很好地區分不同位置、不同數目和松動程度的螺栓松動聲音信號。

5 結論

針對目前大型結構螺栓連接狀態監測的困難,本文采用聲音信號識別的思路,提出了基于小波時頻圖與輕量級卷積神經網絡MobileNetv2的螺栓松動識別方法。

(1)該方法通過對采集到的聲音信號進行預處理和連續小波變換得到小波時頻圖,以小波時頻圖作為樣本對輕量級卷積神經網絡MobileNetv2進行訓練,從而實現螺栓松動聲音信號的識別。

(2)對一鋼桁架模型的室外試驗研究表明,該方法充分發揮了小波時頻分析在處理非平穩信號方面的優勢和MobileNetv2強大的圖像分類能力,能實現對不同環境噪聲信號,不同位置、數目和松動程度的螺栓松動聲音信號的精準識別。

(3)該方法不僅識別準確率高、穩定性好,而且對計算和存儲的要求低,便于應用于移動設備和嵌入式設備。

進一步的研究工作,將對具有更多的損傷工況和處在更加復雜的環境下的模型進行試驗,并將考慮對工作狀態下的大型鋼桁架結構進行實測。