干擾環境下基于計算機視覺的多目標動位移高精度監測方法

周洲 陳太聰

摘要: 當前基于計算機視覺的動位移測量研究通常要求高速高分辨率攝像機和理想拍攝環境,以保證測量的性能和精度。然而高速相機成本較高,目標成像需要較高對比度,且實際拍攝過程中環境條件也難以保持穩定,導致應用受限。結合時空上下文算法和光流算法,提出一種無需人工標靶點、魯棒的多目標位移監測方法,通過智能手機實現干擾環境下的結構多點動位移同步測量。開展懸臂小球模型的掃頻實驗,檢驗方法在一定頻率范圍內的測量效果。其中,使用智能手機對激振小球進行拍攝,并在實驗中保留復雜背景和模擬光照變化。分別采用所提方法和常用的特征光流算法對視頻進行處理,得到動位移結果,并與位移傳感器測量值進行對比。結果表明,在有光照變化干擾下,所提方法具有更強的抗干擾性,各監測點的最大位移偏差在5%以內。

關鍵詞: 結構健康監測; 位移測量; 計算機視覺; 時空上下文; 光流

中圖分類號: O327; TU317 文獻標志碼: A 文章編號: 1004-4523(2021)05-0979-08

DOI:10.16385/j.cnki.issn.1004-4523.2021.05.011

引 言

在結構健康監測實踐中,加速度傳感器得到了廣泛應用,可直接測量結構的加速度響應,但對于低頻范圍的應用效果不佳[1]。相反,位移傳感器的低頻測量結果更加精確,然而由于安裝和測試的不便,應用相對較少,包括線性可變差動變壓器需要固定支座輔助測量,而多普勒激光測振儀雖然可實現無接觸測量,但測量結果受激光聚光影響較大,且設備成本也相對較高。

近年來,隨著圖像數據采集和計算機視覺技術發展,基于視覺的位移測量技術表現出無接觸、遠距離、低成本和高精度等優點,受到了廣泛關注[2?3]。Dworakowski等[4]和韓建平等[5]利用圖像模板匹配技術,使用高速相機實現了單點動位移測量,其中需要安裝人工目標板輔助測量。另外,高速相機的目標成像需較高對比度,從而也要求高亮度的光照條件。周穎等[6]和Yoon等[7]分別根據特征點匹配算法和光流算法,在不附加任何人工標靶點的情況下,采用消費級相機獲得結構的位移響應和動力特性。為減少特征誤識別,方法對目標的紋理特征有一定的要求。Feng等[8]提出基于圖像相關的亞像素模板匹配技術,改善了目標動態位移的提取精度。值得說明的是,上述研究都是在理想的測量條件下進行的,需要穩定的光照環境,未考慮光照環境干擾對測量結果的影響。基于此,Dong等[9]應用時空上下文算法,實現了光照變化和霧氣環境下的位移監測。但研究僅限于單點動態位移測量,未實現多點同步監測,此外所采用的專業攝像機,成本較高。

針對上述若干問題,本文提出應用智能手機同步監測光照環境變化情況下多目標動位移的技術方法。其中,結構振動視頻由智能手機采集,且監測目標點的數目不受限,多個監測目標點由多個預定義的可重疊區域自動集合而成。繼而,應用時空上下文(Spatio?Temporal Context,STC)算法和光流(Optical Flow,OF)算法,同步跟蹤和獲取所有目標監測點的高精度位移時程信息。最后,為了驗證方法的可行性和可靠性,開展懸臂小球模型的掃頻實驗,使用智能手機對激振小球進行拍攝,通過實驗模擬光照變化,對比考查本文方法與常用特征光流算法和位移傳感器的測量結果。

1 多目標動位移監測流程

本文的研究重點集中在智能手機應用、多目標位移監測和高精度位移提取等三方面。其中,第一方面需要解決智能手機的相機廣角畸變的校準問題;第二方面解決多目標選擇和預定義問題;第三方面解決環境干擾下針對各目標的跟蹤和高精度位移提取問題。

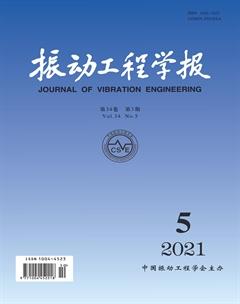

相應地,本文基于計算機視覺的結構振動位移測量流程如框圖1所示。內容分為三大部分:相機標定、多目標定義、多目標跟蹤和位移提取。本文方法所需測量設備為商業智能手機,無需其他傳感器和設備。

以下分別對三大部分所用分析方法和具體操作展開詳細論述。

2 智能手機的相機標定與圖像校準

本文采用智能手機作為視頻拍攝設備,安裝其上的商業相機為了增大拍攝范圍,大多選用的是廣角鏡頭,但是該鏡頭會引入較大的徑向和切向畸變。因此,為了減少畸變產生的位置誤差,有必要對相機進行標定,識別相機的內外參數和畸變系數。基于標定后的畸變模型,校準所拍攝的圖像,最終建立圖像位移到結構位移的準確轉換關系。

相機成像所基于的小孔成像模型,采用下式描述三維空間目標點與相機成像平面中的對應點 之間的關系[10]:

式中 ,和分別表示點在世界坐標系、相機坐標系和圖像像素坐標系中對應坐標。為縮放因子;外部參數矩陣和分別表示旋轉矩陣和平移矩陣,他們與相機物理位置有關;內部參數矩陣與相機構造和材料有關,表示為

式中 和分別為圖像像素坐標系和軸上的比例因子;為坐標軸傾角參數;和為原點坐標。

式(1)和(2)代表理想成像關系,而實際上相機鏡頭會產生徑、切向畸變,導致相機成像點發生偏移,可采用以下非線性畸變模型[11]進行描述

相機標定的基本原理,即是根據已知目標點的準確坐標(通常設計為)和相應成像點的畸變像素坐標(),結合式(1),(2)和(4),識別得到相機的內外參數矩陣、徑向和切向畸變系數。通常采用最優化方法,反復迭代求解使得誤差最小的內外參數和畸變參數。該誤差定義為三維空間目標點計算的投影圖像像素坐標與實際圖像像素坐標之間的差值平方和。

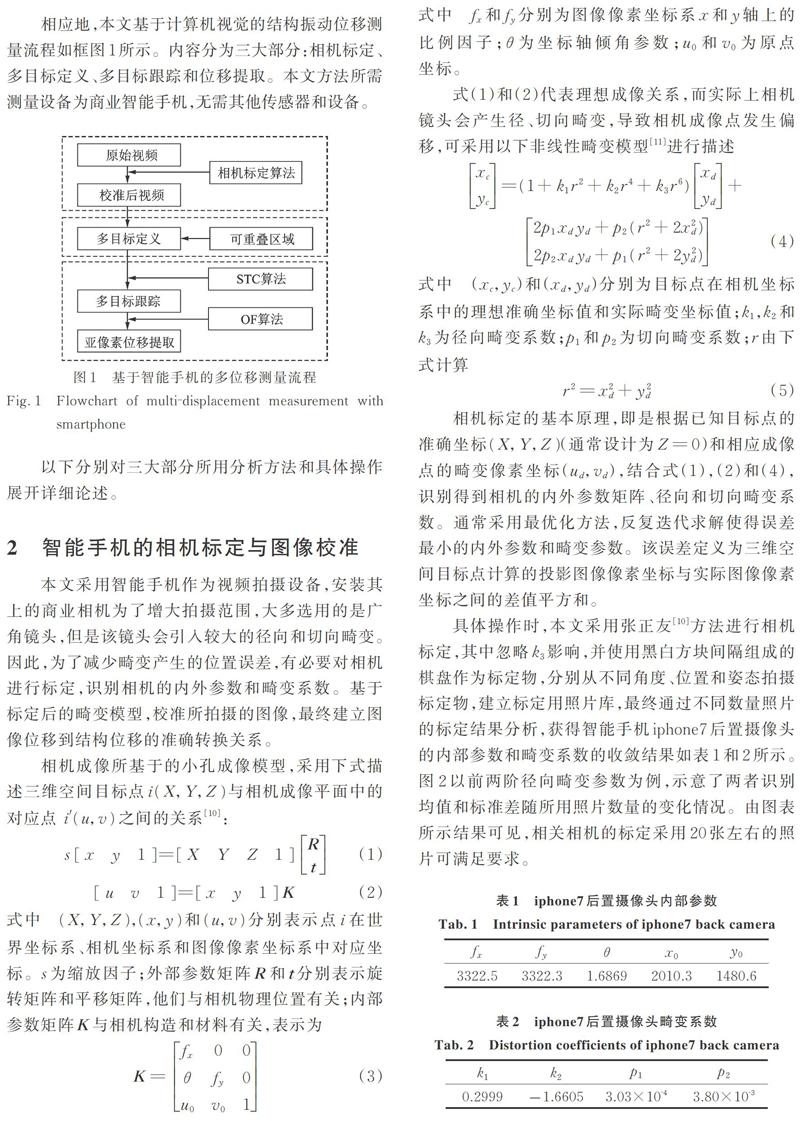

具體操作時,本文采用張正友[10]方法進行相機標定,其中忽略影響,并使用黑白方塊間隔組成的棋盤作為標定物,分別從不同角度、位置和姿態拍攝標定物,建立標定用照片庫,最終通過不同數量照片的標定結果分析,獲得智能手機iphone7后置攝像頭的內部參數和畸變系數的收斂結果如表1和2所示。圖2以前兩階徑向畸變參數為例,示意了兩者識別均值和標準差隨所用照片數量的變化情況。由圖表所示結果可見,相關相機的標定采用20張左右的照片可滿足要求。

當相機完成標定獲得相關參數后,即可結合式(2)和(4),先由實際照片上的畸變像素坐標() 計算(),繼而得到理想坐標(),最終得到校準后的照片上的理想像素坐標()。如圖3所示即為標定用黑白棋盤的某一張照片的局部在校準前后的圖像對比。可見,原始圖片中黑白方塊的畸變扭曲邊緣已較好地被修正為平直邊緣。

3 多目標定義

在結構振動過程中,對多點動位移進行同步監測,不僅有益于全面了解結構振動形態,也有利于模態特征辨識等工作開展。

基于視頻的多目標位移同步監測,要求能實現每個目標與其他目標的區分,并能跟蹤各個目標在每幀照片中的位置。要達成這兩個目標,一方面需要在首幀照片中預先定義監測目標對象;另一方面需要目標跟蹤算法支持針對多目標對象的處理。

本文后續將采用時空上下文(STC)算法進行目標跟蹤,然而傳統STC目標跟蹤算法只關注單個目標,無法同時跟蹤多個目標[9, 12]。因此,本文對傳統STC算法進行改進,通過并行化設計,及引入區域相容條件,實現了對多個可重疊目標區域的同步跟蹤。

如圖4所示為在結構振動視頻的首幀照片中完成的多目標預定義。目標區域可根據典型結構區域自行定義,數量不限,且可部分重疊。每個目標區域(圖中矩形框)的特征點為各區域的中心點(圖中×形標記點),監測所得的各目標區域位移可由該區域中心點的位移進行代表。

4 基于STC算法的目標跟蹤

4.1 STC算法基本模型

在利用計算機視覺技術進行目標跟蹤時,目標對象與其局部場景之間存在密切關聯,利用這種關系,更易于找到目標。STC算法[12]即基于貝葉斯框架,根據目標區域與其局部上下文的圖像強度和位置之間的統計相關性進行建模計算。

該算法通過極大化以下置信度函數來追蹤目標位置[12]

式中 為目標位置;為場景中的目標;為目標區域中心點位置;為歸一化系數,以保證()在0?1間變化;和分別為尺度參數和形狀參數。

當前幀照片中,目標區域的局部上下文特征集定義為

式中 為位置處的圖像強度;為目標點周圍的局部上下文區域。如圖5所示,黃色框代表跟蹤目標,紅色框代表其局部上下文。

依據貝葉斯概率公式,式(6)中的置信度函數可展開為

式中 為聯合概率函數;為條件概率函數,表示目標位置與其局部上下文之間的空間關系;為上下文先驗概率函數,表示局部上下文的外觀特征。

首先,根據首幀照片的圖像強度,以及預定義的目標位置,可計算上下文先驗概率

式中 為歸一化系數,以保證在0?1間變化;為尺度參數,和分別為目標區域的長度和寬度。

其次,定義條件概率函數為

式中 為空間上下文模型函數,取決于目標位置和局部上下文位置之間的相對距離和方向,且設置為非徑向對稱函數,該設置有助于解決距離和背景相似帶來的歧義。

將式(9)和(12)代入式(8),可得

式中 代表卷積運算符。

每一幀圖片中的像素點數量眾多,式(13)的卷積運算效率低且計算復雜。已知在時域中進行卷積運算的結果與其在頻域的乘積運算結果一致,因此,為了提高計算效率,STC算法結合快速傅里葉算法(FFT),將卷積運算轉換成乘積運算,可大幅提高運算效率。由此,式(13)經FFT轉化為

式中 表示傅里葉變換,表示對應位置的乘積。

對式(14)進行傅里葉逆變換,并將式(6)代入,最終可得空間上下文模型函數的求解列式為

式中 表示傅里葉逆變換(IFFT)。

4.2 STC算法跟蹤過程

STC算法將目標跟蹤任務轉換為對置信度函數)的最大值搜索任務,其流程如圖6所示。在第t幀照片中,通過式(15)計算得當前幀照片的空間上下文模型,繼而根據下式更新下一幀照片的時空上下文模型

式中 為學習速率因子;定義為前一幀照片的時空上下文模型和空間上下文模型的加權和。這種加權處理可以有效地抑制物體外觀強度突變引起的噪聲干擾。

在獲得后,由式(14),第t+1幀的置信度函數相應更新為

最后,通過搜索置信度函數的最大值,從而確定第t+1幀照片中的目標位置為

這里需要說明的是,由于本文僅以結構平面內振動為例進行論述,因此忽略了縱向測試距離上的尺度變化,即圖片大小比例未發生變化;如果要觀測結構三維振動,即存在平面外運動,結構與相機間的縱向測試距離會發生明顯的變化,則還需引入目標尺度更新模型[12]進行修正。

為了達到穩健的跟蹤效果,在STC跟蹤算法中的若干關鍵計算參數,按照參考文獻[12]的建議,取:=2.25,=1,=0.075,=1。

5 基于OF算法的亞像素位移估計

根據以上STC算法得到的圖片目標位置的分辨率為單個像素,此時目標實際位移的測量精度為單個像素所對應的實際位移。因此,為了獲得更精確的目標實際位移,除了提高相機的分辨率以加密圖片中的像素點之外,還可以采用光流(OF)算法,對圖片目標在單個像素內的位置變化進行估計,以提取亞像素位移[13]。

一般地,視頻中相鄰兩張照片的圖像強度和之間滿足以下關系

在利用STC跟蹤算法獲得整像素位移()后,參照該位移,在目標圖像中截取新的模板圖像。新的模板圖像和目標圖像之間仍存在微小位移(),此時應用光流算法,可建立新的模板圖像和目標圖像之間的近似關系

式中 偏導數可采用有限差分計算,即及。

如圖7所示為視頻中相鄰圖像的亞像素位移估計的計算流程。相關研究表明[13],根據光流算法優化得到的亞像素位移精度可達到0.0125像素,可以有效地識別目標在單個像素內的位置變化,有利于提升實際目標位移的測量精度。

6 模型實驗

本文將開展懸臂小球模型的強迫振動實驗,以檢驗所提出的方法在無人工標記點和有光照變化環境下,能否利用商業相機準確地獲取結構的多點動位移時程。實驗將以位移傳感器測量結果為基準,對比本文方法與常用特征光流算法[7]的效果。

6.1 實驗設計

實驗裝置如圖8所示,小鋼球通過豎直連桿固定在底部支座上,激振器與豎直連桿相連。小鋼球上連接有直線位移傳感器,傳感器另一端支撐在左端立柱上。實驗中,激振器輸入外部激勵引起小球水平振動,位移傳感器記錄小球的水平位移時程,并由數據采集卡和電腦進行自動采集。同時,由放置在小球前端、安裝在三角架上的iphone7手機錄制小球振動視頻,設置圖片分辨率為1920×1080像素,幀率為60幀/s。實驗測量的小球振動時長為20 s。

實驗中,為了檢驗結構常見振動頻率范圍內的方法可行性,設置激振器激勵為1?10 Hz間的重復線性掃頻。此外,為了考查方法在真實背景環境下的應用效果,沒有對小球背后的復雜背景進行遮擋。

為了考查方法在光照變化環境下的應用效果,特設計兩組對比實驗:(1)情況一,在小球振動過程中,光照條件不變化;(2)情況二,在小球振動過程中,3次調節臨近的臺燈光照亮度。實驗用臺燈有3檔亮度可調,如圖9(a)所示為關閉臺燈時的照片,如圖9(b)所示為打開臺燈最亮檔時的照片,由圖可見兩者差別明顯。

6.2 實驗結果

為了便于與位移傳感器的測量結果進行直接對比,選擇圖4中與位移傳感器同一高度的兩個目標作為跟蹤目標。如圖10所示為初始設置的兩個跟蹤目標,紅色框為目標區域1,綠色框為目標區域2,藍色點為各目標區域的中心。

根據本文提出的技術方案,首先將拍攝視頻中的每一幀照片進行校準;繼而計算每一幀照片中目標區域的置信度函數,通過STC算法和OF算法對相鄰幀進行匹配,得到目標的圖像位移;最后將圖像位移乘以縮放影響矩陣得到最終位移。

作為對比分析用的常用特征光流算法,則是采用Lucas?Kanade光流與Harris角點相結合的算法,通過計算相鄰兩幀的關鍵特征點的光流,獲取關鍵點的位移[7]。

為了比較本文算法與特征光流算法的性能,現定義如下兩類評價指標[14],歸一化均方誤差指標NMSE和相關系數指標:

式中 和分別代表基于視覺算法和位移傳感器獲得的位移數據;和分別代表不同方法得到的數據均值。兩個指標的取值范圍都在0?1之間,指標值越大,意味著越相關,數據相似程度越高。

如圖11和12所示分別為光照不變化情況和光照變化情況下的12 s位移時程對比圖,其中STC1和STC2代表應用本文方法識別得到的目標1和目標2結果,LK?Harris代表特征光流法識別結果,Sensor代表位移傳感器測量結果。如表3和4所示為兩種情況下的不同方法評價指標結果,表中還列出了最大位移對比結果。

由圖表所示結果可見:

(1)在光照不變化情況下,本文方法和特征光流法所得的位移時程與位移傳感器的測量結果在形狀和趨勢上可保持一致,表明兩種方法都有良好的適應復雜背景的能力,總體上本文方法結果更接近實測位移結果。表列數據也顯示了同樣結論,NMSE和都接近于1,最大位移偏差都小于6%,而本文方法的指標值更為優越。需要說明的是,STC1和STC2的結果不完全一致,除了視頻識別誤差外,振動過程中的支撐桿彎曲變形,導致兩個目標點的水平位移也會存在輕微的客觀差異。

(2)在光照變化情況下,特征光流法的位移時程發生了明顯的偏移,表明目標跟蹤失敗,而本文方法所得的位移時程仍可與位移傳感器的測量結果在形狀和趨勢上保持一致。表列數據也顯示了同樣結論,特征光流算法的NMSE和明顯偏小,最大位移誤差大于15%;而本文方法的指標值雖然較光照不變化的理想情況略有降低,但NMSE和仍能保持在0.95左右,最大位移偏差小于5%,表明本文方法具有良好的抗光照變化能力。

7 結束語

本文針對計算機視覺技術在結構工程振動領域的應用開展研究,基于時空上下文算法和光流算法,提出了應用智能手機實現環境變化情況下多目標動位移同步監測的技術方法。實驗表明,本文方法具有良好的復雜背景適應能力和抵抗光照變化能力,顯示了較強的工程應用潛力。未來的實際應用還有必要進一步研究更為復雜的環境變化情況,如遮擋、霧天和相機抖動等的不利影響。

參考文獻:

[1] Cho S, Spencer Jr B F. Sensor attitude correction of wireless sensor network for acceleration‐based monitoring of civil structures [J]. Computer‐Aided Civil and Infrastructure Engineering, 2015, 30(11): 859-871.

[2] Spencer Jr B F, Hoskere V, Narazaki Y. Advances in computer vision-based civil infrastructure inspection and monitoring [J]. Engineering, 2019, 5(2): 199-248.

[3] Feng D, Feng M Q. Computer vision for SHM of civil infrastructure: From dynamic response measurement to damage detection—A review[J]. Engineering Structures, 2018, 156: 105-117.

[4] Dworakowski Z, Kohut P, Gallina A, et al. Vision-based algorithms for damage detection and localization in structural health monitoring[J]. Structural Control and Health Monitoring, 2016, 23(1): 35-50.

[5] 韓建平, 張一恒, 張鴻宇. 基于計算機視覺的振動臺試驗結構模型位移測量[J]. 地震工程與工程振動, 2019, 39(4): 22-29.

HAN Jian-ping, ZHANG Yi-heng, ZHANG Hong-yu. Displacement measurement of shaking table test structuremodel based on computer vision [J]. Earthquake Engineering and Engineering Dynamics, 2019, 39(4): 22-29.

[6] 周 穎, 張立迅, 劉 彤, 等. 基于計算機視覺的結構系統識識[J]. 土木工程學報, 2018, 51(11): 17-23.

ZHOU Ying, ZHANG Li-Xun, LIU Tong, et al. Structural system identification based on computer vision [J]. China Civil Engineering Journal, 2018, 51(11): 17-23.

[7] Yoon H, Elanwar H, Choi H, et al. Target‐free approach for vision‐based structural system identification using consumer‐grade cameras [J]. Structural Control and Health Monitoring, 2016, 23(12): 1405-1416.

[8] Feng D, Feng M Q, Ozer E, et al. A vision-based sensor for noncontact structural displacement measurement [J]. Sensors, 2015, 15(7): 16557-16575.

[9] Dong C Z, Celik O, Catbas F N, et al. A robust vision-based method for displacement measurement under adverse environmental factors using spatio-temporal context learning and Taylor approximation[J]. Sensors, 2019, 19(14): 3197.

[10] Zhang Z Y. A flexible new technique for camera calibration [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22(11): 1330-1334

[11] 高 翔, 張 濤. 視覺SLAM十四講: 從理論到實踐[M]. 北京: 電子工業出版社, 2017.

GAO Xiang, ZHANG Tao. Visual SLAM Lecture 14: From Theory to Practice[M]. Beijing: Publishing House of Electronics Industry, 2017.

[12] Zhang K, Zhang L, Liu Q, et al. Fast visual tracking via dense spatio-temporal context learning [C]. Proceedings of the European Conference on Computer Vision, Zurich, 2014: 127-141.

[13] Chan S H, V? D T, Nguyen T Q. Subpixel motion estimation without interpolation [C]. Proceedings of the International Conference on Acoustics, Speech and Signal Processing, IEEE, 2010: 722-725.

[14] Khuc T. Computer vision based structural identification framework for bridge health monitoring [D]. Florida: University of Central Florida, 2016.

作者簡介: 周 洲(1996-),男,碩士研究生。電話:13060858565;E-mail:947665753@qq.com

通訊作者: 陳太聰(1977-),男,博士,副教授。電話:13903019936;E-mail:cvchentc@scut.edu.cn