基于遷移學(xué)習(xí)和注意力機(jī)制的偽裝圖像分割

吳 濤, 王倫文, 朱敬成

(國防科技大學(xué)電子對抗學(xué)院, 安徽 合肥 230037)

0 引 言

自然界中,偽裝是一些動(dòng)植物賴以生存的基本技能。變色龍被認(rèn)為是自然界里的偽裝高手;枯葉蝶在處于危險(xiǎn)中時(shí),會(huì)將自己藏于植物葉片中,宛似一片干枯的葉子。許多動(dòng)物為了躲避捕食,會(huì)將自己很好地融入于周圍的環(huán)境中,使之不易被察覺和發(fā)現(xiàn),從而躲避被捕食的命運(yùn)。顏色、整體形狀和紋理,是偽裝的重要特征,利用好這些特征,就能實(shí)現(xiàn)與周圍環(huán)境的有效融合。偽裝是自然界動(dòng)植物能夠長久安全生存的有力武器,被用來說明自然選擇的力量。第二次世界大戰(zhàn)期間,英軍狙擊手將顏料涂在作訓(xùn)服上,實(shí)現(xiàn)自己的偽裝。二戰(zhàn)后,德國人首先設(shè)計(jì)并研制出一種迷彩裝飾衣,在作戰(zhàn)中發(fā)揮了較好的偽裝效果。作戰(zhàn)人員偽裝、作戰(zhàn)裝備偽裝愈來成為軍事中不可或缺的一環(huán),也是非常關(guān)鍵的一環(huán)。

對偽裝的研究由來已久,但大多是對偽裝產(chǎn)生的機(jī)理進(jìn)行研究,與基于深度學(xué)習(xí)的目標(biāo)檢測和分割研究不同,兩者的側(cè)重點(diǎn)不一樣。在計(jì)算機(jī)視覺領(lǐng)域,偽裝研究,就是從背景中識別出偽裝目標(biāo)的存在,對圖像進(jìn)行逐像素的分類標(biāo)記,并識別出每個(gè)分割區(qū)域的語義信息,具有重要的理論意義和實(shí)踐價(jià)值。例如,在醫(yī)學(xué)檢測中,對病變器官的分割等,雖然不是屬于直接的偽裝范疇,但是與偽裝圖像在本質(zhì)上有很多相似之處;在稀有物種檢測和發(fā)掘中,以及軍事上都有著巨大的應(yīng)用價(jià)值。

語義分割的方法有很多,傳統(tǒng)的目標(biāo)檢測分割算法包括基于區(qū)域的分割方法、基于邊緣檢測的分割方法、基于閾值的分割方法等。傳統(tǒng)的分割算法雖然計(jì)算不復(fù)雜、效率高,但是選取的特征較為簡單,大多是一些淺層的特征,缺乏對樣本數(shù)據(jù)特征的深入挖掘,分割效果往往不是十分理想;細(xì)節(jié)信息捕捉不夠,分割結(jié)果較為模糊;傳統(tǒng)分割方法還有一個(gè)較為明顯的局限性,即對噪聲十分敏感,因此傳統(tǒng)分割方法并不適用于偽裝目標(biāo)的研究。隨著深度學(xué)習(xí)的不斷發(fā)展,利用卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行目標(biāo)分割的研究越來越多,并取得較好的分割效果。Carreira等人在2012年提出了采用CPMC(constrained parametric minCut)進(jìn)行候選區(qū)域劃分的提議,取得了較好的分割結(jié)果。后續(xù)的Girshick等人、Hariharan等人提出了相應(yīng)的分割算法或在前者工作上進(jìn)行了改進(jìn)提高。由于基于候選區(qū)域的提議分割結(jié)果缺少空間信息,小物體的分割效果不理想,為很好地解決這個(gè)問題,Long等人提出了完全卷積網(wǎng)絡(luò)(fully convolutional networks,F(xiàn)CN)分割網(wǎng)絡(luò)模型,語義分割精度得到了很好地提升;在FCN基礎(chǔ)上,許多對稱分割網(wǎng)絡(luò)被提出來,例如SegNet、UNet等。

1 算法描述

本文提出的算法包括2個(gè)框架1個(gè)模塊:① 利用視覺幾何組(visual geometry group,VGG)遷移網(wǎng)絡(luò)進(jìn)行模型的前半部分訓(xùn)練,去掉全連接層的VGG網(wǎng)絡(luò)的下采樣部分與Unet的編碼網(wǎng)絡(luò)進(jìn)行了有效銜接與對應(yīng);網(wǎng)絡(luò)的后半部分是Unet的上采樣過程,恢復(fù)原始圖像尺寸并進(jìn)行預(yù)測;② 嵌入了有效通道注意力(effective channel attention,ECA)機(jī)制模塊,對提取到的有效特征進(jìn)行加權(quán)處理,提高有效特征在網(wǎng)絡(luò)中的權(quán)重值。

1.1 UNet網(wǎng)絡(luò)結(jié)構(gòu)

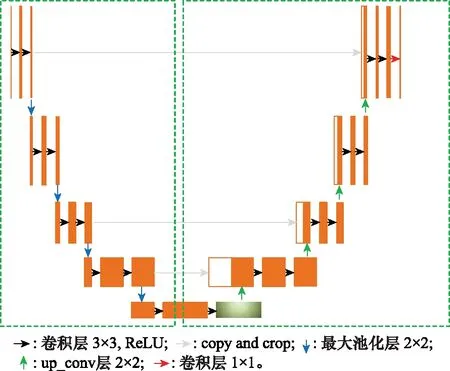

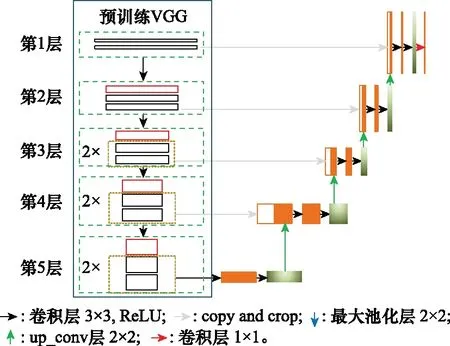

UNet是一種十分對稱的端到端的分割算法,包含了編解碼2個(gè)模塊。編碼階段是一段連續(xù)的下采樣過程,用于不斷提取更深層次的特征信息。下采樣過程主要是通過3×3的卷積層和2×2的最大池化層來實(shí)現(xiàn)的,圖像的尺寸不斷被壓縮,特征通道數(shù)不斷增加,提取到的特征更抽象,更豐富,對目標(biāo)的表達(dá)能力更強(qiáng),更具有魯棒性能。但是,由于對圖像的不斷壓縮,許多目標(biāo)的細(xì)節(jié)信息存在丟失的問題,所以在解碼階段,通過上采樣或反卷積的手段,逐像素還原原圖像精度,恢復(fù)細(xì)節(jié)信息。圖1展示了UNet的網(wǎng)絡(luò)結(jié)構(gòu),分為編碼和解碼兩個(gè)部分,左側(cè)部分用于編碼,右側(cè)部分用于解碼。

圖1 UNet網(wǎng)絡(luò)模型結(jié)構(gòu)Fig.1 Structure of UNet model

1.2 遷移學(xué)習(xí)

遷移學(xué)習(xí)在大量的實(shí)驗(yàn)中被證明是一種有效的模型改進(jìn)方式,尤其是當(dāng)目標(biāo)數(shù)據(jù)不足時(shí),遷移的方式能夠在小樣本的情況下獲得比較好的訓(xùn)練結(jié)果,提升模型的訓(xùn)練精度和魯棒性能。遷移學(xué)習(xí)是模型訓(xùn)練效果的一種泛化,文獻(xiàn)[12]從模型復(fù)雜性和學(xué)習(xí)算法的穩(wěn)定出發(fā),導(dǎo)出了模型泛化的理論邊界。

對于假設(shè)空間,定義對稱差假設(shè)空間Δ為

Δ={()⊕′():,′∈}

(1)

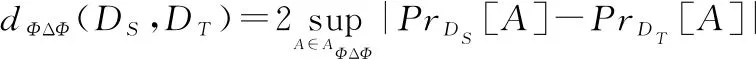

式中:⊕表示異或函數(shù)。則在不同分布,之間的對稱差距離定義為

(2)

式中:Δ是空間的子集合。

(3)

則最小風(fēng)險(xiǎn)誤差為

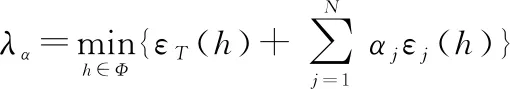

(4)

式中:是假設(shè)空間。由此,可得出在較為理想的情況下遷移學(xué)習(xí)的理論邊界:

(5)

式(5)表明遷移學(xué)習(xí)泛化邊界函數(shù)收斂,存在上邊界,說明遷移學(xué)習(xí)應(yīng)用到模型訓(xùn)練中是可行的且有效的。

1.3 ECA注意力機(jī)制

注意力機(jī)制被廣泛用在自然語言處理、計(jì)算機(jī)視覺等任務(wù)中,是一種能提高特征權(quán)重的有效手段,在許多實(shí)驗(yàn)中都表現(xiàn)出較好的性能。注意力是模仿人類大腦處理大量信息時(shí)的一種機(jī)制,即關(guān)注重點(diǎn)區(qū)域,而忽視不重要的部分,這樣做的目的就是增加了有用特征的權(quán)重,從而獲得更多待分割目標(biāo)的細(xì)節(jié)信息,提高分割精度。

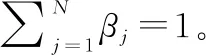

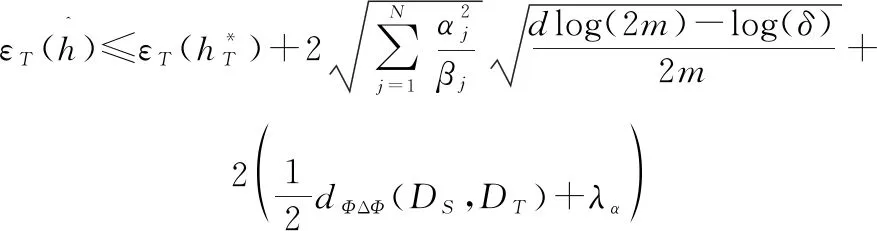

ECA_Net提供了一種十分有效的產(chǎn)生特征權(quán)重的方式,在不增加模型復(fù)雜度的情況下,能夠獲得十分明顯的性能增益。與SENet等其他注意力機(jī)制不同的是,ECA采用不降維的方式產(chǎn)生權(quán)重,避免降維對利用注意力機(jī)制學(xué)習(xí)特征十分重要;ECA利用1×1的卷積實(shí)現(xiàn)局部交叉通道交互策略,卷積核的大小為,代表了局部通道交互的覆蓋率,這是一個(gè)超參數(shù),但ECA實(shí)現(xiàn)了對的自適應(yīng)調(diào)節(jié)。ECA網(wǎng)絡(luò)模塊如圖2所示。

圖2 ECA注意力機(jī)制模塊Fig.2 ECA attention mechanism module

從圖2可以看出,ECA是一種通道維度上生成特征權(quán)重的方式,首先將輸入的特征圖進(jìn)行全局自適應(yīng)平均池化,與SENet不同之處在于,SENet會(huì)先進(jìn)行降維操作,降低通道數(shù)量為原來的1/。ECA避免了降維這一操作,直接生成一組特征向量:

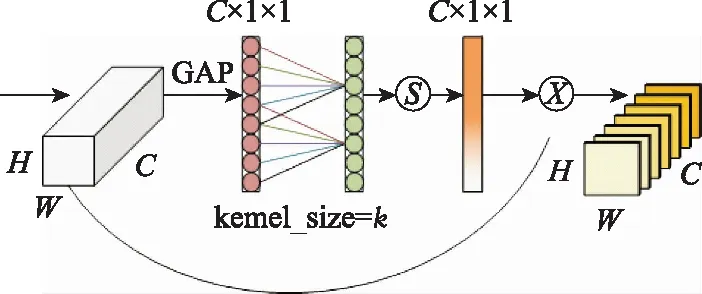

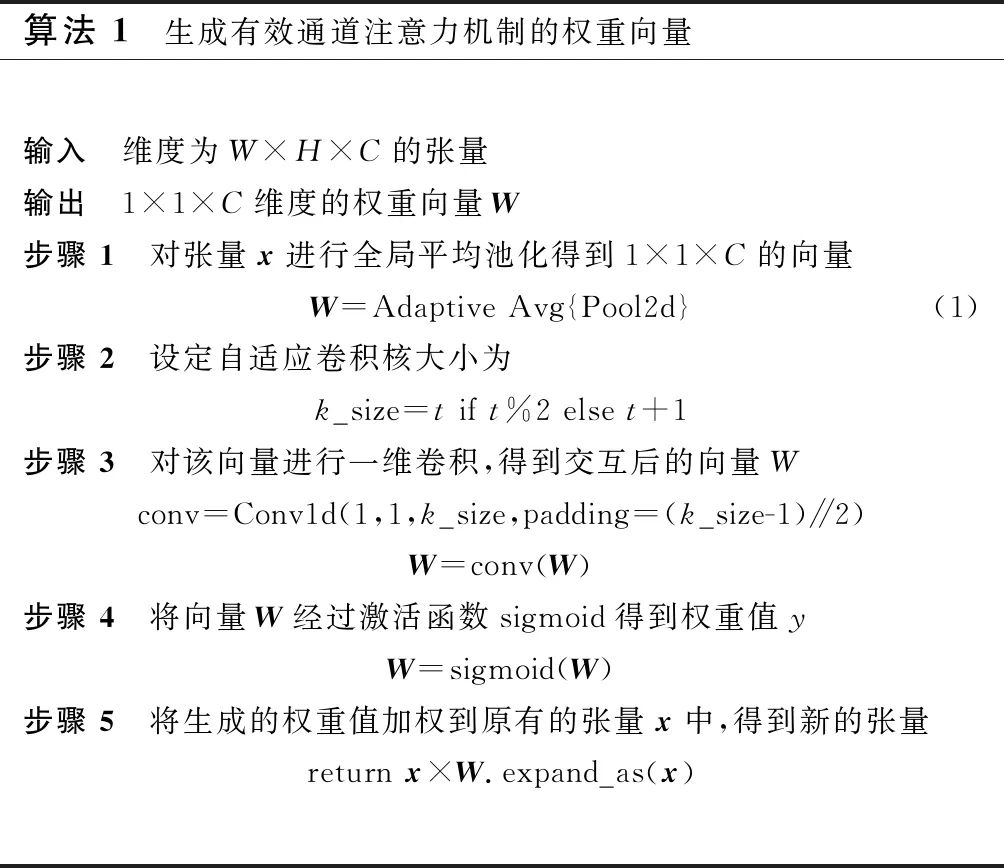

算法 1 生成有效通道注意力機(jī)制的權(quán)重向量輸入 維度為W×H×C的張量 輸出 1×1×C維度的權(quán)重向量W步驟 1 對張量x進(jìn)行全局平均池化得到1×1×C的向量W=Adaptive Avg{Pool2d}(1)步驟 2 設(shè)定自適應(yīng)卷積核大小為k_size=t if t%2 else t+1步驟 3 對該向量進(jìn)行一維卷積,得到交互后的向量Wconv=Conv1d(1,1,k_size,padding=(k_size-1)∥2)W=conv(W)步驟 4 將向量W經(jīng)過激活函數(shù)sigmoid得到權(quán)重值yW=sigmoid(W)步驟 5 將生成的權(quán)重值加權(quán)到原有的張量x中,得到新的張量return x×W.expand_as(x)

ECA利用1×1的卷積實(shí)現(xiàn)局部通道之間的交互,卷積核的大小_size代表了交互的覆蓋率。這是一個(gè)超參數(shù),但ECA實(shí)現(xiàn)了對的自適應(yīng)調(diào)節(jié)。

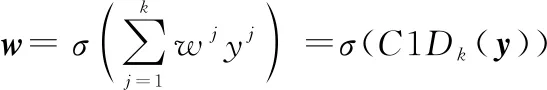

=()

(6)

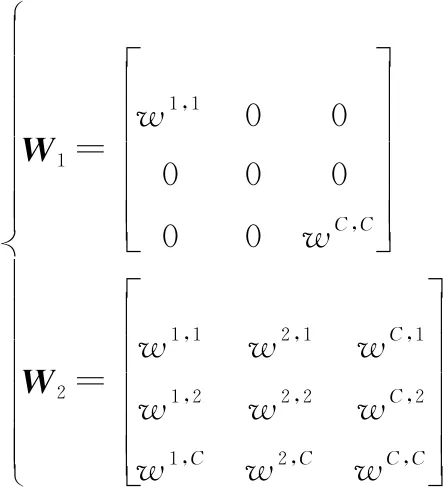

對的構(gòu)造中,有兩種較為常見的方式:

(7)

在第一種方式中采用的是對角矩陣的方式,第二種則是一個(gè)完全矩陣。這兩種方式的區(qū)別在于第二種矩陣權(quán)重之間存在交互,采用對角矩陣的方式則權(quán)重之間相對獨(dú)立。如果卷積核大小設(shè)置為,則經(jīng)過卷積之后得到的向量為

(8)

2 網(wǎng)絡(luò)結(jié)構(gòu)

2.1 遷移學(xué)習(xí)網(wǎng)絡(luò)

深度學(xué)習(xí)需要大量高質(zhì)量的標(biāo)注數(shù)據(jù),可以通過遷移學(xué)習(xí)的方式,在已有的大規(guī)模優(yōu)質(zhì)數(shù)據(jù)集上進(jìn)行預(yù)訓(xùn)練,將預(yù)訓(xùn)練的結(jié)果遷移到待分割的網(wǎng)絡(luò)中,可以實(shí)現(xiàn)特征遷移和參數(shù)共享,提高模型的泛化能力,降低訓(xùn)練結(jié)果對數(shù)據(jù)集的依賴,減少訓(xùn)練成本,并通過微調(diào)的方式,將部分網(wǎng)絡(luò)層加入到新的網(wǎng)絡(luò)中進(jìn)行訓(xùn)練,以更好適應(yīng)新網(wǎng)絡(luò)特性。

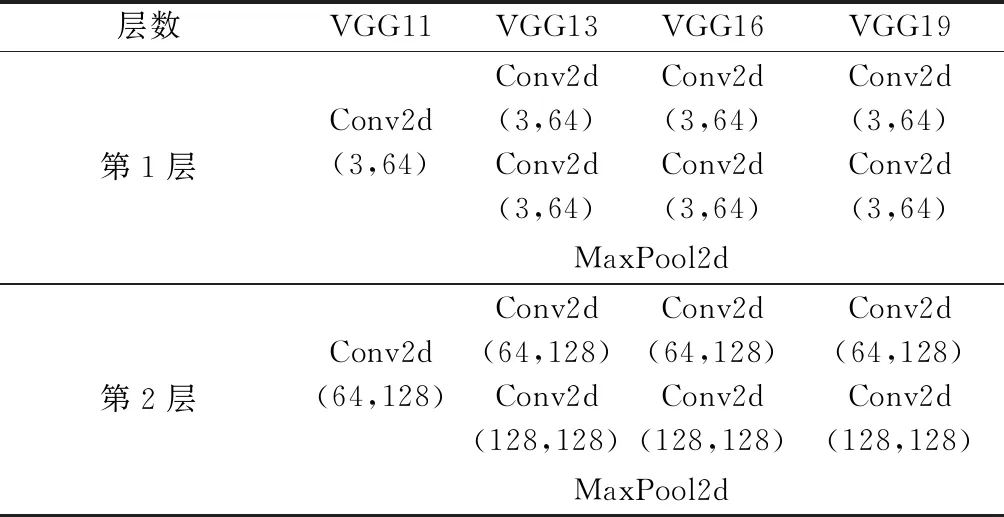

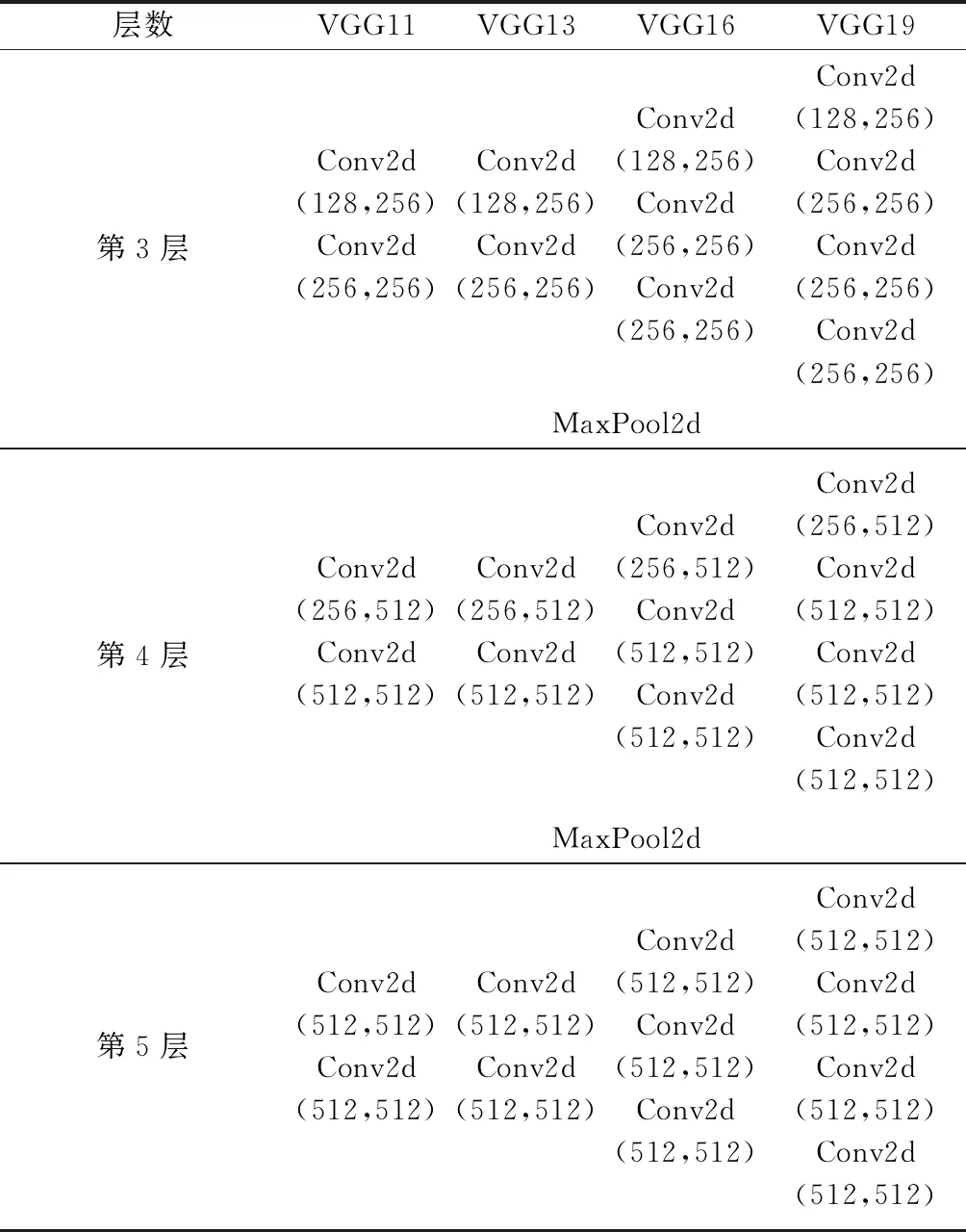

觀察VGG網(wǎng)絡(luò)結(jié)構(gòu)可知,VGG系列網(wǎng)絡(luò)與Unet網(wǎng)絡(luò)具有十分類似的上采樣結(jié)構(gòu),可以不改變Unet網(wǎng)絡(luò)的基本結(jié)構(gòu)而進(jìn)行網(wǎng)絡(luò)的遷移學(xué)習(xí)。VGG系列包含了VGG11、VGG13、VGG16和VGG19等。VGG相較于AlexNet,采用了連續(xù)的小卷積核代替大卷積核,大大減少了訓(xùn)練參數(shù),保證了在增加網(wǎng)絡(luò)深度時(shí)仍具有很好的學(xué)習(xí)能力。VGG網(wǎng)絡(luò)結(jié)構(gòu)如表1所示(不包含全連接層)。

表1 VGG系列模型各層結(jié)構(gòu)及參數(shù)

續(xù)表1

2.2 模型改進(jìn)

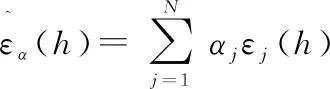

由于偽裝目標(biāo)特征模糊,與背景融合度較高,目前運(yùn)用深度神經(jīng)網(wǎng)絡(luò)進(jìn)行偽裝圖像分割的研究較少,偽裝圖像分割任務(wù)的準(zhǔn)確程度還不是很高。本文將經(jīng)典的基于深度卷積神經(jīng)網(wǎng)絡(luò)的算法在偽裝圖像分割中進(jìn)行了諸多嘗試,并對其中的UNet模型進(jìn)行了相關(guān)改進(jìn),以適應(yīng)偽裝目標(biāo)分割任務(wù),提高分割精度,如圖3所示。

圖3 改進(jìn)后的模型Fig.3 Improved model

本文對于UNet的改進(jìn)點(diǎn)在于:

(1) 針對偽裝目標(biāo)特征模糊的問題,本文在網(wǎng)絡(luò)編碼-解碼階段均引入了有效通道注意力ECA,將其嵌入到UNet的采樣過程中,貫穿模型訓(xùn)練全過程,使模型在訓(xùn)練過程中能始終關(guān)注目標(biāo)區(qū)域,很大程度上克服了偽裝圖像因其目標(biāo)“被偽裝”而帶來分割上的困難;

(2) 利用在大型數(shù)據(jù)集ImageNet上預(yù)訓(xùn)練的VGG模型,將其訓(xùn)練參數(shù)和訓(xùn)練特征遷移到偽裝目標(biāo)分割網(wǎng)絡(luò),實(shí)現(xiàn)特征遷移和參數(shù)共享,提高網(wǎng)絡(luò)的泛化能力,減小模型對訓(xùn)練樣本的依賴,降低訓(xùn)練成本。

3 實(shí)驗(yàn)過程及結(jié)果分析

3.1 實(shí)驗(yàn)條件設(shè)置和數(shù)據(jù)集

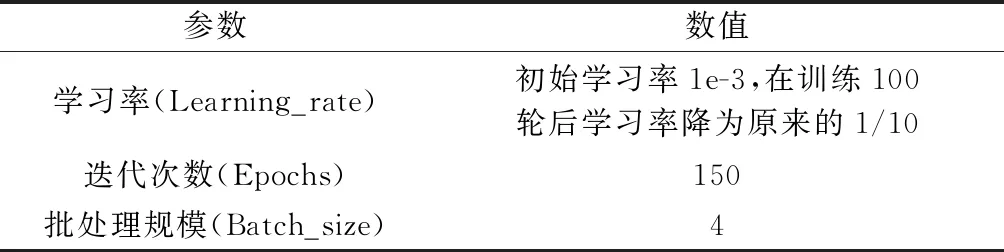

實(shí)驗(yàn)計(jì)算機(jī)配置如下:Intel(R) Core(TM) i7-9700 CPU @3.00 GHz, GeForce 1060Ti GPU (6 GB顯存) 的Windows操作系統(tǒng)。實(shí)驗(yàn)采用pytorch架構(gòu),在訓(xùn)練過程中,采用AdamW優(yōu)化器進(jìn)行優(yōu)化,采用FocalLoss損失函數(shù)。具體實(shí)驗(yàn)細(xì)節(jié)如表2所示。

表2 實(shí)驗(yàn)參數(shù)

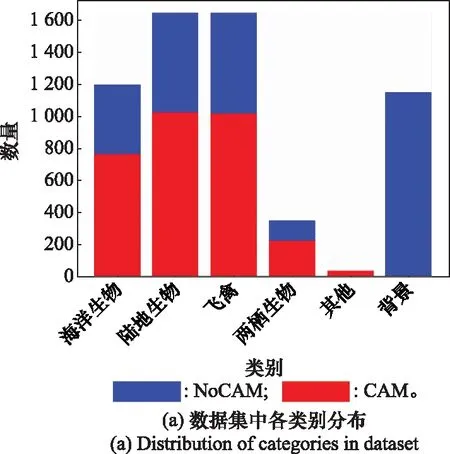

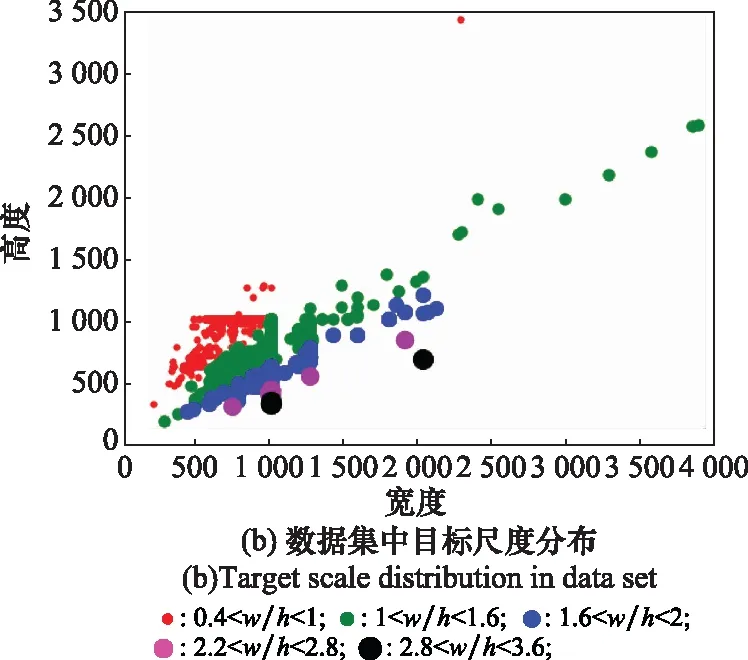

本次實(shí)驗(yàn)采用公開的COD10K數(shù)據(jù)集,該數(shù)據(jù)集是專門針對偽裝目標(biāo)研究而制定的,包含了海洋生物、陸地生物、兩棲動(dòng)物以及飛禽等共69個(gè)類別,物種豐富,涵蓋范圍廣泛;其中訓(xùn)練數(shù)據(jù)集6 000張,測試數(shù)據(jù)集4 000張,為提高算法模型的魯棒性,數(shù)據(jù)集中還包括非偽裝目標(biāo)數(shù)據(jù)4 934張。表3和圖4展示了訓(xùn)練集和測試集中偽裝目標(biāo)和非偽裝目標(biāo)的統(tǒng)計(jì)情況。

表3 訓(xùn)練和測試數(shù)據(jù)集統(tǒng)計(jì)信息

圖4 數(shù)據(jù)集種類與尺度大小分布Fig.4 Data set types and scale size distribution

同時(shí),算法還在其他2個(gè)公開數(shù)據(jù)集上進(jìn)行測試。其中CHAMELEON數(shù)據(jù)集共有圖片76張,CAMO數(shù)據(jù)集共有圖片2 500張。圖5是偽裝數(shù)據(jù)的部分展示。

圖5 部分偽裝數(shù)據(jù)集Fig.5 Part of camouflage datasets

3.2 FocalLoss損失函數(shù)

FocalLoss不同于交叉熵?fù)p失,通過添加系數(shù)調(diào)節(jié)難易樣本的損失權(quán)重。在類別不平衡問題中,交叉熵?fù)p失對所有樣本賦予相同的關(guān)注,使得一些難分、錯(cuò)分的樣本很難被挖掘出來。FocalLoss通過添加調(diào)節(jié)系數(shù),降低易分樣本的權(quán)重,提高難分、錯(cuò)分樣本的損失值比重,使得模型在訓(xùn)練時(shí)對這類樣本賦予更多的關(guān)注。偽裝目標(biāo)在檢測過程中,由于特征模糊,難分錯(cuò)分的概率非常大,因此實(shí)驗(yàn)中采用FocalLoss作為損失函數(shù),對難例樣本進(jìn)行挖掘。

=-(1-)log

(9)

式中:和是權(quán)重調(diào)節(jié)系數(shù),通過改變調(diào)節(jié)系數(shù)可增加對難挖掘樣本的關(guān)注程度。表示分類概率,越大,表示樣本被正確分類的概率越大,1-就會(huì)越小,所以和對權(quán)重起到了很好的調(diào)節(jié)作用,可以控制樣本分類比重。

3.3 評價(jià)指標(biāo)

為了更好對比不同算法之間的性能,對改進(jìn)后的模型進(jìn)行合理正確的評估,我們在CHAMELEON、CAMO、COD10K3個(gè)數(shù)據(jù)集下采用以下指標(biāo)進(jìn)行衡量。

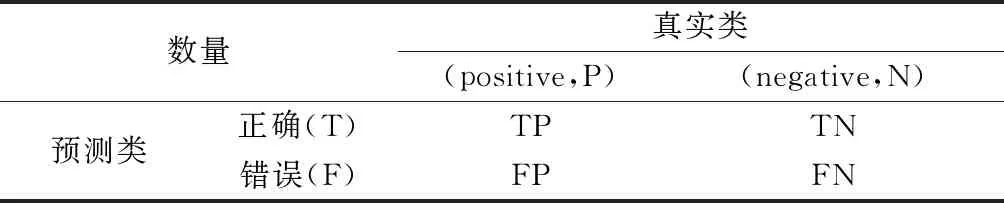

混淆矩陣:混淆矩陣是具有特定布局的統(tǒng)計(jì)類表格(見表4),所有其他評價(jià)指標(biāo)都是基于混淆矩陣基礎(chǔ)上的衍生。

表4 混淆矩陣

TP:真陽性,表示標(biāo)簽是偽裝圖像,且預(yù)測為偽裝圖像的像素點(diǎn)數(shù);

FP:假陽性,表示標(biāo)簽是背景,但預(yù)測為偽裝圖像的像素點(diǎn)數(shù);

TN:真陰性,表示標(biāo)簽是背景,且預(yù)測為背景的像素點(diǎn)數(shù);

FN:假陰性,表示標(biāo)簽是偽裝圖像,但預(yù)測為背景的像素點(diǎn)數(shù)。

可以計(jì)算出,TP+TN是表示正確分類的像素總數(shù)量,TP+FN表示圖像像素的總數(shù)量,FP+TN表示背景像素的總數(shù)量。通過以上計(jì)算可以得出以下衍生指標(biāo):

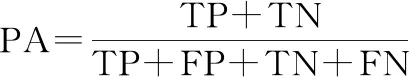

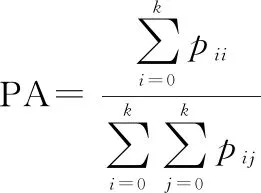

像素精度(pixel accuracy,PA):像素精度是衡量分割效果的最直接的衡量指標(biāo),代表的含義是分類正確的像素?cái)?shù)量之和在所有像素?cái)?shù)量中的占比。像素精度一定程度上能夠反映出衡量的好壞,但存在一個(gè)明顯的問題,當(dāng)圖像中正負(fù)樣本極不均衡,負(fù)樣本的數(shù)量遠(yuǎn)遠(yuǎn)大于正樣本數(shù)量時(shí),就會(huì)出現(xiàn)在完全預(yù)測為負(fù)樣本的情況下有很高的像素精度值的情況,所以PA存在很高的下限值。計(jì)算公式如下:

(10)

也可以寫成如下形式:

(11)

敏感度(Sensitivity):在分割任務(wù)中,可以用敏感度表示召回率,兩者具有相同的含義。

(12)

重合率(Dice):重合率是衡量分割性能好壞的合理有效的指標(biāo),是兩個(gè)物體重合度的一種測量,表示兩個(gè)物體相交的面積占總面積的比值,是交并比(intersection over union,IoU)的另一種表達(dá)形式。

(13)

為了保證Dice的值域在0到1之間,添加了調(diào)節(jié)系數(shù)2,計(jì)算后得到的結(jié)果就能確保落在0到1之間。

本文通過上述指標(biāo)對比分析所提算法預(yù)測的值與真實(shí)標(biāo)簽值之間的差異,上述指標(biāo)值愈大,預(yù)測的精度越高,性能越好。

3.4 實(shí)驗(yàn)及結(jié)果分析

3.4.1 Canny檢測算法

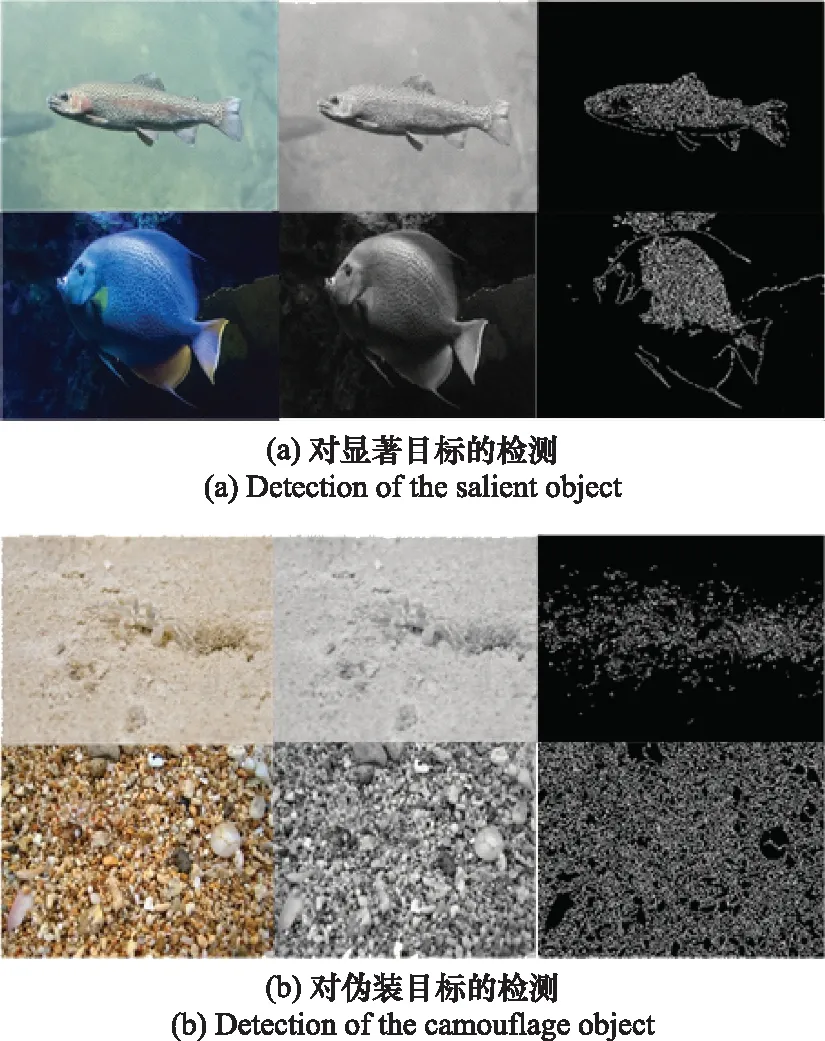

本文首先基于傳統(tǒng)算法—Canny算法對偽裝目標(biāo)進(jìn)行檢測。在給定的偽裝圖像數(shù)據(jù)集中,部分顯著圖像輪廓十分清晰,與背景的區(qū)分度比較大,使用傳統(tǒng)的邊緣檢測算法能夠取得比較好的檢測效果。首先對圖像進(jìn)行灰度化處理,得到原圖的灰度圖;然后通過降噪處理,傳統(tǒng)的檢測算法受噪聲影響普遍較大,所以為了得到較好的檢測處理效果,先需要進(jìn)行降噪處理;接著,檢測圖像的邊緣,圖像的邊緣是圖像中梯度下降最快的地方;最后通過設(shè)置不同的閾值對檢測的像素進(jìn)行閾值篩選,低閾值取50,高閾值取150,篩選出圖像中目標(biāo)的強(qiáng)邊緣像素,即大于高閾值的邊緣像素,對低于低閾值的邊緣像素進(jìn)行剔除。對顯著和偽裝目標(biāo)的分割結(jié)果如圖6所示。

從圖6中可以看到,Canny算法對顯著圖像的檢測效果十分理想,能夠十分清晰地勾勒出目標(biāo)的輪廓;但對于偽裝目標(biāo)而言,傳統(tǒng)的算法難以有效發(fā)揮其檢測性能,由于偽裝目標(biāo)與周圍環(huán)境高度融合,背景噪聲大,特征模糊難以提取,Canny算法并不能很好地提取目標(biāo)的位置信息和輪廓信息,說明了偽裝目標(biāo)相對于顯著目標(biāo),檢測難度更大。

圖6 傳統(tǒng)算法檢測顯著與偽裝目標(biāo)效果對比Fig.6 Traditional algorithm detecting salient and camouflaged targets

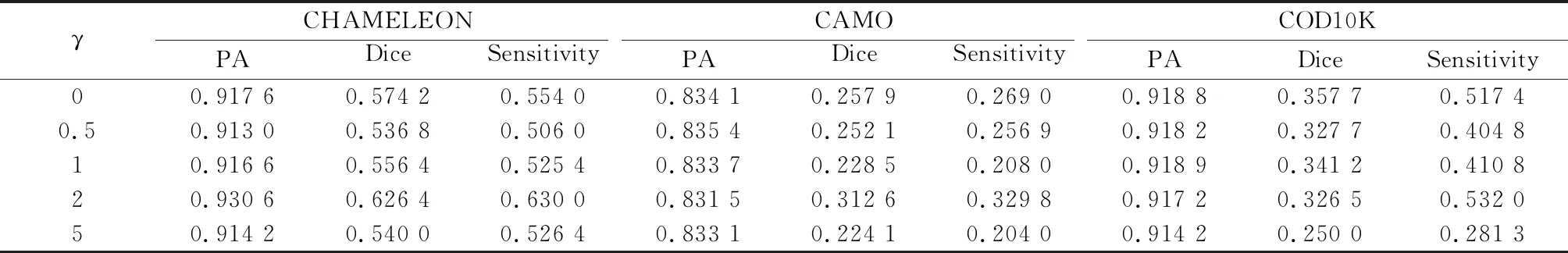

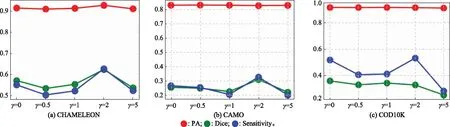

3.4.2 γ取值對結(jié)果的影響

FocalLoss中不同值代表了賦予樣本損失值不同的權(quán)重, 值越大,表明對困難樣本的關(guān)注程度更高,本文探究了不同的γ對偽裝目標(biāo)分割精度的影響。

從表5和圖7中可以看出,當(dāng)在訓(xùn)練過程中提高困難樣本的權(quán)重時(shí),能夠一定程度上提高模型對偽裝目標(biāo)的分割效果。相較于其他數(shù)值,當(dāng)γ=2時(shí)分割效果較好。

表5 不同γ在測試集上的定量評測結(jié)果

圖7 不同γ對于分割結(jié)果的影響Fig.7 Impact of different γ on the segmentation results

3.4.3 改進(jìn)模型的實(shí)驗(yàn)結(jié)果

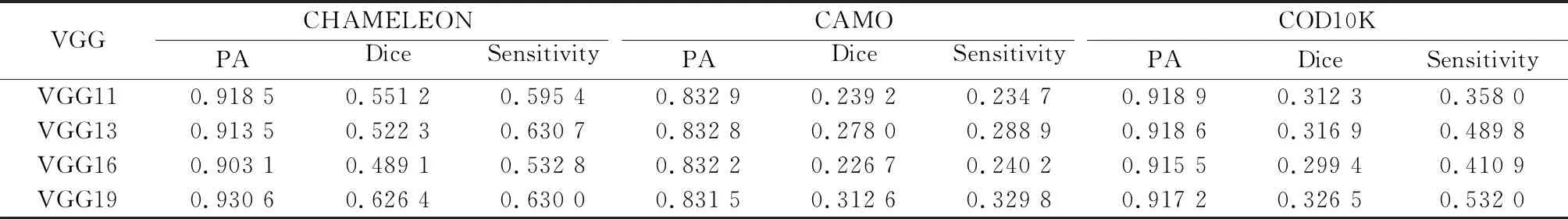

同時(shí),對VGG系列VGG11、VGG13、VGG16和VGG19等4種不同深度的網(wǎng)絡(luò)進(jìn)行了實(shí)驗(yàn),這4種網(wǎng)絡(luò)都在大型數(shù)據(jù)集ImageNet上進(jìn)行了預(yù)訓(xùn)練,對這4種網(wǎng)絡(luò)進(jìn)行遷移學(xué)習(xí),共享其參數(shù)和特征。實(shí)驗(yàn)對比結(jié)果如表6所示。

實(shí)驗(yàn)結(jié)果表明,在這4種VGG模型中,19層的模型結(jié)構(gòu)對偽裝圖像的分割效果優(yōu)于其他模型,如圖8所示。

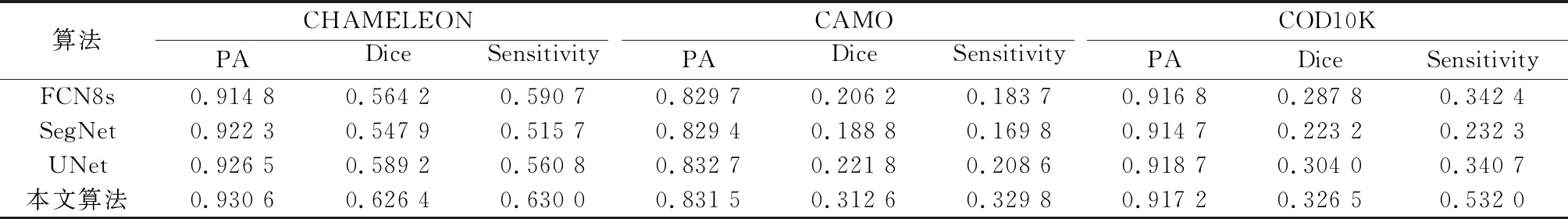

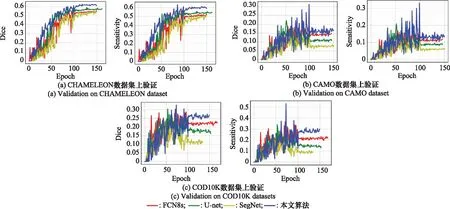

在上述對比結(jié)果下,本文模型選用了權(quán)重系數(shù)γ為2,遷移模型選用VGG19,并在CHAMELEON、CAMO、COD10K 3個(gè)數(shù)據(jù)集上分別進(jìn)行了驗(yàn)證,與FCN8s、SegNet、UNet模型對PA、Dice和Sensitivity指標(biāo)值進(jìn)行了定量對比分析。實(shí)驗(yàn)結(jié)果如表7和圖9所示。

表6 不同遷移模型的定量評測結(jié)果

圖8 不同的遷移模型對分割結(jié)果的影響Fig.8 Effect of different migration models on segmentation results

表7 不同模型的定量評測結(jié)果

圖9 不同模型在3個(gè)驗(yàn)證數(shù)據(jù)集上的Dice和SensitivityFig.9 Dice and Sensitivity of different models on three validation datasets

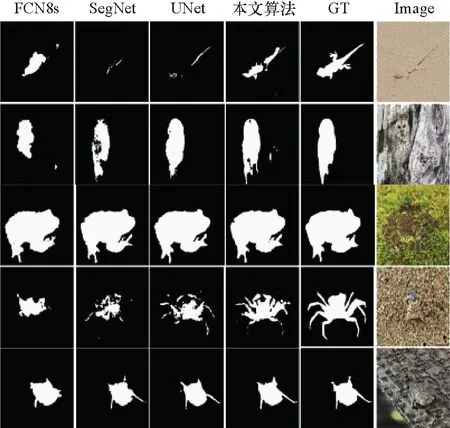

從表7和圖9中可以看出,改進(jìn)后的模型相較于改進(jìn)前的模型,在性能上具有大幅度提升,相較于其他模型,部分?jǐn)?shù)據(jù)集上具有較大提升,說明了改進(jìn)后的模型的有效性。圖10和圖11展示了不同模型的分割結(jié)果圖,改進(jìn)后的模型具有更好的分割效果,分割結(jié)果的細(xì)節(jié)信息更加明顯。

圖10 不同模型的分割結(jié)果對比Fig.10 Comparison of segmentation results of different models

圖11選擇的部分分割結(jié)果Fig.11 Selected partial segmentation results

4 結(jié) 論

基于UNet基礎(chǔ)模型,提出了一種結(jié)合遷移學(xué)習(xí)和注意力機(jī)制的UNet分割方法。在偽裝目標(biāo)分割研究中,遷移學(xué)習(xí)的方式,能夠?qū)崿F(xiàn)參數(shù)共享和特征遷移,減小訓(xùn)練結(jié)果對樣本數(shù)據(jù)的依賴,降低訓(xùn)練成本;在網(wǎng)絡(luò)的上采樣過程中嵌入注意力機(jī)制,能夠提高有效特征權(quán)重,提高模型分割精度。改進(jìn)后的模型在一定程度上能夠?qū)崿F(xiàn)對偽裝目標(biāo)的分割。通過對實(shí)驗(yàn)數(shù)據(jù)的分析得知,與改進(jìn)前的UNet相比,在CAMO、CHAMELEON和COD10K上進(jìn)行驗(yàn)證,改進(jìn)后的模型在Dice和Sensitivity指標(biāo)上有了顯著提升。