太陽射電頻譜爆發識別的元學習方法

郭軍成, 萬 剛, 胡欣杰, 嚴發寶, 王 帥,*

(1. 航天工程大學航天信息學院, 北京 101416;2. 山東大學空間科學研究院空間電磁探測技術實驗室, 山東 威海 264200;3. 中國人民解放軍66444部隊, 北京 100042)

0 引 言

太陽射電爆發事件是射電天文最早研究的現象之一,射電爆發時的輻射頻率最高可達到上百兆赫茲,同時其輻射強度也可達到平靜太陽活動時的上萬倍。由于太陽射電爆發時的輻射強度、輻射頻率和譜形等均與輻射源區的磁場、等離子體和能量離子的性質有關,使得對太陽射電爆發的有關觀測成為認識空間天氣事件和太陽活動,特別是日冕物質拋射和耀斑等太陽射電爆發過程的一種獨特和有效的診斷工具。太陽射電爆發時,射電輻射的急劇增強會對電離層狀態,以及通訊和導航等活動產生顯著影響。此外在軍事方面,太陽射電爆發還可影響全球定位系統(global positioning system, GPS)的定位精度,減弱雷達監視系統的分辨和目標識別能力等。

太陽射電信號通常通過射電動態頻譜儀和日像儀觀測。射電頻譜儀可以記錄在一定頻率范圍內射電信號強度隨頻率和時間的變化,通常稱之為動態頻譜。中國太陽射電寬帶動態頻譜儀(solar broadband radio spectrometer, SBRS)在第23個太陽活動周期間投入工作,通過將分量分光計安裝在北京、昆明和南京的不同天線上,SBRS可以全天候對太陽進行觀測,也由此產生大量的射電頻譜數據,而其中包含的太陽射電爆發數據卻少之又少,這對天文工作者開展后續研究造成了一定困難。隨著機器學習和人工智能技術在計算機視覺和天文學領域上的廣泛應用,利用神經網絡進行射電頻譜圖像的自動處理和分類識別已經逐漸成為主流,并取得了一系列成果。2015年,Gu等首先使用PCA對太陽射電頻譜圖進行降維,然后使用 SVM 對太陽射電進行分類,這是首個關于太陽射電頻譜圖自動分類的研究。2016年,Chen等人提出了用于太陽射電爆發分類的多模態深度學習方法,在學習的聯合表示的基礎上,對太陽射電爆發進行分類。實驗結果表明,所提出的多模式學習網絡能夠有效地學習太陽射電譜的表示,提高分類精度。2018年,陳思思提出了一個基于卷積神經網絡(convolutional neural network, CNN)的太陽射電頻譜圖分類算法,該網絡采用了1×5和1×3卷積核代替了傳統的卷積核,避免了通道之間的干擾,最終爆發頻譜圖像取得了84.6%的TPR值。2019年,崔澤瀟采用將太陽射電爆發作為平靜太陽射電活動噪聲的思想,將射電爆發的識別問題轉換為異常值檢測的問題。2020年,張巧曼首先利用CNN對槎山觀測站采集到的頻譜圖像進行了分類識別,然后對太陽射電爆發事件進行了定位檢測和處理分析。

針對太陽射電頻譜圖像的少樣本分類識別問題,本文分析了數據增強和遷移學習等少樣本學習方法的局限性,提出了基于元學習和遷移學習的頻譜圖像分類算法。該方法利用MiniImageNet和Omniglot少樣本數據集作為源域數據,將太陽射電頻譜數據集作為目標域數據;首先通過讓模型在源域數據集上進行多任務的元知識學習,然后將其學到的元知識遷移到目標域的分類任務中,最終實現少樣本射電頻譜圖像的分類識別任務。實驗結果證明,本文所提出的方法具有可行性。

1 元學習概述

依賴于大數據的支撐,近年來深度學習在人機交互、自動駕駛、智能推薦和模式識別等領域都取得了不俗的成績。然而,由于深度神經網絡包含的參數很多,需要海量的標簽數據才能進行有效訓練,而在許多場景下,獲取大量的有標簽數據是十分困難甚至是不現實的。與機器不同的是,人類并不需要大量的數據訓練就可以實現快速地學習。比如,幼年時期的人類就可以實現,僅僅通過一兩張某個動物的照片便可以分辨出該類動物。為了使得機器學習更加接近人類思維,真正邁向智能化,少樣本學習的概念應運而生。自2003年Li等人首次提出少樣本學習問題并利用貝葉斯框架對視覺對象進行學習以來,少樣本學習技術日漸成熟,并發展形成了以基于數據增強的方法、基于遷移學習的方法和基于元學習的方法為代表的3類神經網絡方法。

數據增強是解決深度學習模型訓練過程中樣本不足問題的最簡單方法。基于無監督方式的數據增強是在已有的數據集基礎上采用縮放、旋轉、位移等仿射變換進行數據的擴增。這種基于幾何變換和圖像操作的方式可以在一定程度上解決數據量不足、模型過擬合的問題,但是其所增加的新樣本并未改變目標特征,缺乏多樣性。生成模型是有監督數據增強任務中最為關鍵的技術。生成模型不僅可以擬合高維數據分布,而且泛化能力更強,生成圖像的質量更高,但其訓練過程不穩定,容易出現梯度消失和彌散問題。總的來說,數據增強方法雖然簡單直接的增加了新的訓練樣本,但是對于零樣本學習來說,并沒有從根本上解決少樣本學習的問題。

遷移學習旨在利用源任務中模型參數的先驗分布知識來學習目標任務的后驗知識,從而實現將已經學會的知識遷移到一個新的領域中。遷移學習的主要策略是通過在目標域上繼續訓練來微調源域預訓練網絡的權重,但要求目標領域和源域之間必須具有一定的關聯性,才能使得在源域數據中學到的知識和特征表示可以更好地幫助目標域實現模型的訓練。此外,使用淺層的源域神經網絡模型進行復雜信息的篩選和特征表示對于領域間的知識遷移具有局限性。

元學習又稱學會學習,是利用以往的知識經驗來指導新任務的學習,使網絡具備學會學習的能力,也是解決少樣本學習問題常用的方法之一。元學習的本質是增加學習器在多任務中的泛化能力。元學習對于任務和數據都需要采樣,因此學習到的元知識可以在少樣本的任務中迅速建立起映射。元學習中的“元”體現在網絡對于每個任務的學習,通過不斷的適應每個具體任務,使網絡具備了一種抽象的學習能力。簡而言之,元學習主要是通過對多個歷史任務的學習,得到一個較好的模型超參數、架構、或者算法本身等元知識,使之能夠快速適用于新的任務。

按照模型所學習到的元知識,元學習目前的研究大致可以分為3個較為主流的方向:基于度量的元學習、基于優化的元學習和基于模型的元學習。目前,基于度量的元學習分類算法有原型網絡、匹配網絡和關系網絡等。這類方法的目標是獲取一個可以度量相似性的特征空間,隨后把這一特征空間用于新的任務,即在元學習的框架下構造一個可以端到端訓練的分類器,實現對樣本間距離分布的建模。但是當訓練任務和測試任務相似性比較低的時候,模型效果受限。

基于模型的元學習方法是先學習任務的表示,再用任務的表示生成分類模型的部分參數。在訓練時,對于每一個任務,神經網絡按照順序依次處理數據集,在每一個時間步中都會有一個輸入改變模型的內部狀態,使得模型的內部狀態可以捕捉相關的特定于任務的信息,并將這些信息用于生成另一個分類模型的部分參數。基于這個思想,逐步發展形成了以MANNs(meta-learning with memory-augmented neural networks)、CNPs(conditional neural processes)和SNAIL(simple neural attentive meta-learner)為代表的少樣本學習方法。

基于優化的元學習方法是通過對模型參數優化來快速的學習新任務。不同于經典的機器學習算法采用梯度下降來優化模型參數,基于優化的元學習器既可以通過學習來優化部分模型參數,也可以對整個模型的優化過程進行學習。元學習通過在多任務下執行參數優化,使得模型可以在更廣泛的任務上學會快速學習新任務。但是,這種方法的計算量一般很大,需要更多計算資源,并且模型容易在訓練任務上過擬合。這類方法包括MAML(model-agnostic meta-learning)、Meta-learner LSTM(long short-term memory)和LEO(Meta-learning with latent embedding optimization)等經典算法。

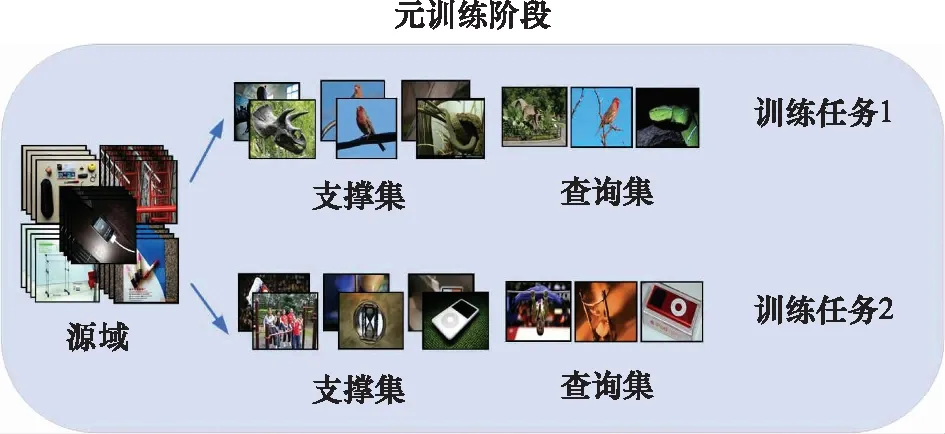

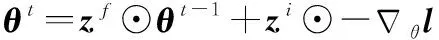

如圖1所示,與一般的機器學習算法不同,元學習模型的基本訓練單位為任務。為了區別概念,元學習中將訓練過程定義為元訓練階段,測試過程定義為元測試階段,相應過程中的任務稱之為訓練任務和測試任務。區別于一般神經網絡端到端的訓練方式,將每個任務中用于訓練模型的數據集稱為支撐集,用于測試的數據集稱為查詢集。 其中,元測試階段所借助的數據稱之為源域數據,元測試階段所要學習的少樣本數據稱之為目標域數據。

需要注意的是,一般情況下源域和目標域是沒有交集的。元學習所解決的是目標域中樣本量少的問題,由于無法直接在目標域的小樣本上進行訓練,所以借助了源域的數據進行元知識的學習。在元測試階段,為了對元學習模型進行泛化,每次訓練都會從目標域中隨機抽取個類別,每個類別個樣本作為支撐集,稱這種樣本抽取方式為N-way K-shot。與此同時,為了保持元測試和元測試階段的一致性,元測試階段中源域每個任務的支撐集也保持相同的和。

2 基于優化的元學習方法

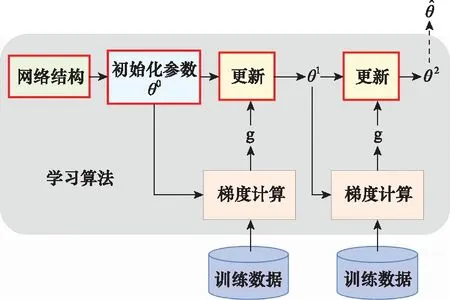

如圖2所示,神經網絡框架包括參數更新過程都可以視為學習算法,其中網絡架構、初始化參數和更新規則都是可以人為設計的超參數,因此不同的超參數往往意味著不同的學習算法。基于優化的元學習方法可以通過讓機器在源域數據上自主學習到部分超參數,再將學到的元知識遷移到目標域數據中,實現目標任務的元學習過程。

圖2 神經網絡的梯度下降過程Fig.2 Gradient descent of neural network

2.1 MAML

2.1.1 基本思想

Finn等人提出了MAML模型,使得可以在少量樣本上,用少量的迭代步驟就可以獲得較好的泛化性能。同時,模型容易微調也無需關心模型的形式,無需為元學習增加新的參數,可以直接用梯度下降算法來訓練學習器。MAML本質上是學習任意標準模型的初始化參數,并讓該模型能快速適配。采用一些更加適合遷移的具有泛化性的中間表達,使得MAML可以適應很多任務(分類、回歸、增強學習),并通過微調來獲得好的效果。

2.1.2 訓練細節

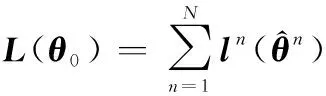

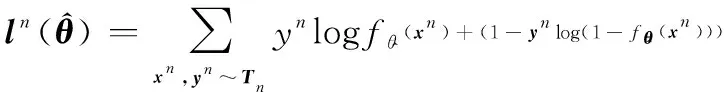

MAML通過多任務的學習,利用梯度下降算法讓模型自主學習到一個最好初始化參數,并定義了一個損失函數()來評估所學到的初始化參數的好壞:

(1)

(2)

在不同的任務上進行訓練時,按照梯度下降算法進行更新:

(3)

(4)

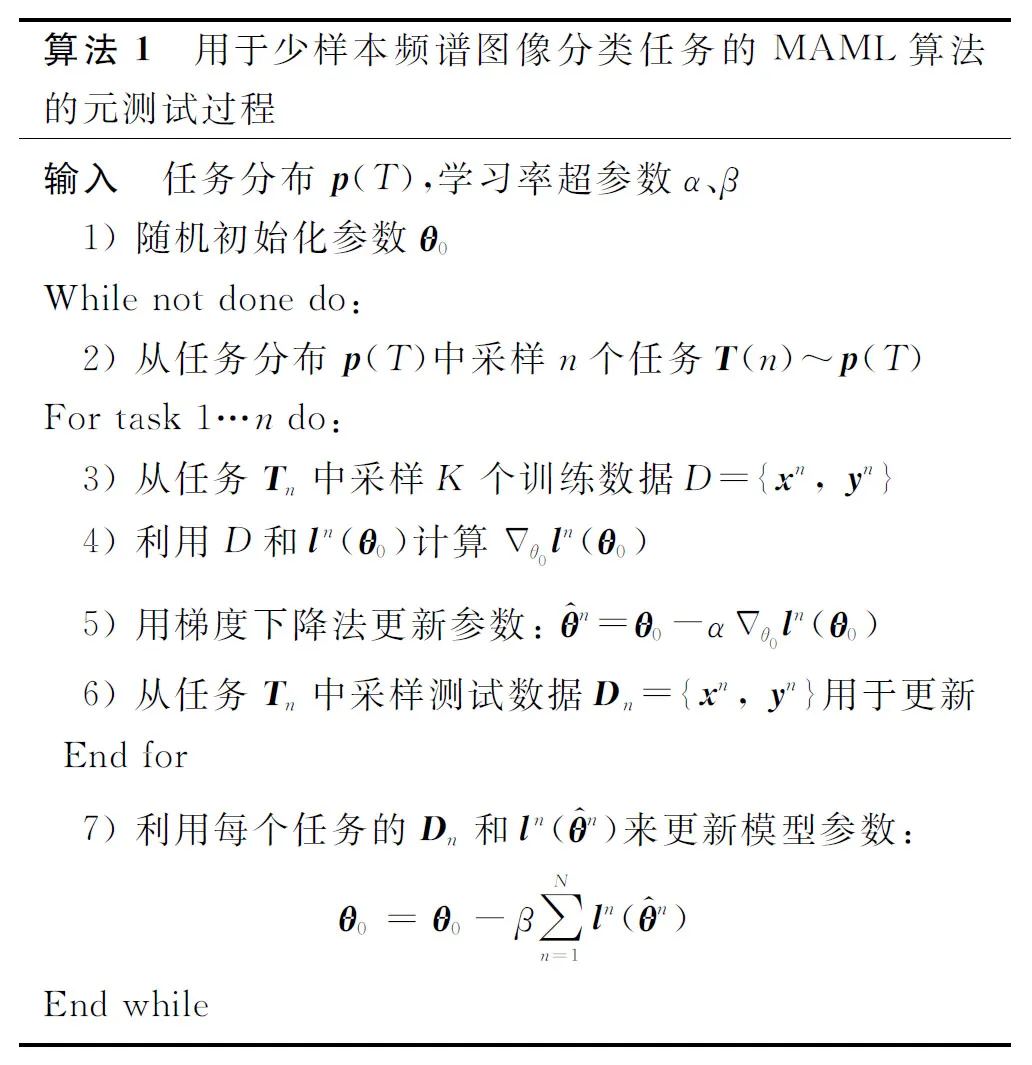

213 算法流程

用于少樣本頻譜圖像分類任務的MAML算法的元測試過程如算法1所示。

214 與遷移學習的異同

2.2 Meta-learner LSTM

221 基本思想

在學習算法的梯度下降過程中,可以通過讓機器自主的學習一些關鍵部分,使得學習算法可以在經過多個任務的訓練之后,能夠快速的適應few-shot的新任務。比如,通過學習初始化參數(initialization parameters),MAML和Retpile算法可以找到最適合測試任務的模型初始值,這個初始參數可以使得模型在新的任務上只需要少量數據便可以在支撐集上完成參數更新,并在查詢集上取得最優的實驗結果。而實際上,我們還可以對學習算法的梯度下降過程直接進行學習,使得模型在訓練任務上完成訓練之后,可以學到適應于測試任務的參數更新方式。這個更新模型可以僅通過在測試任務上的少量數據就能使算法完成對任務模型參數的快速準確更新,從而使模型在查詢集上取得不俗表現。

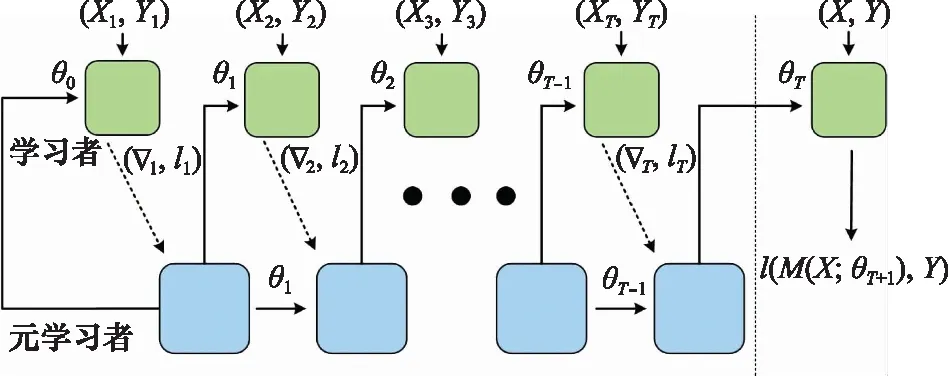

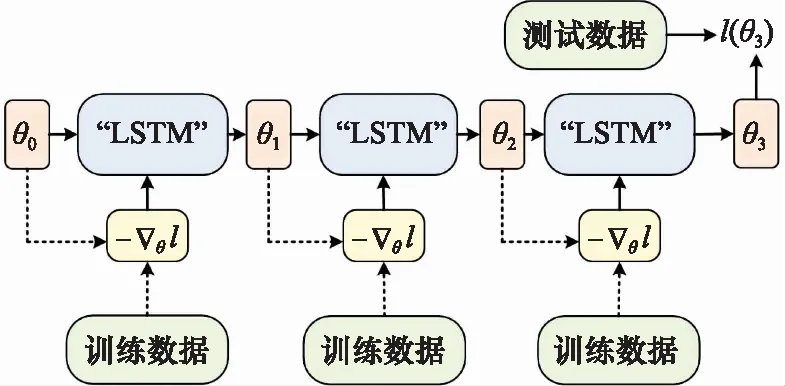

Meta-learner LSTM學習基于梯度下降的參數更新算法,采用LSTM表示元學習器,用其狀態表達目標分類器的參數更新。該優化算法最終學會如何在新的分類任務上,對分類器網絡進行初始化和參數更新。同時,模型考慮到了一個任務的短時知識和跨多個任務的長時知識信息,并使用記憶機制保存這種信息。

2.2.2 記憶單元和梯度下降

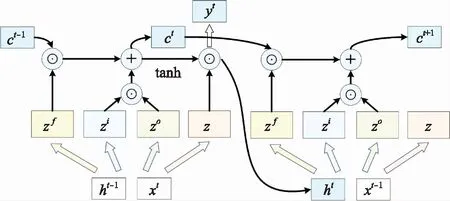

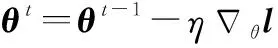

如圖3所示,作為記憶模型的LSTM一般由多個cell所構成,每個cell部分都有3個輸入、-1和-1。

圖3 LSTM的內部運算結構Fig.3 Internal operation structure of LSTM

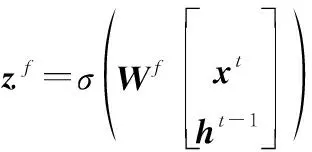

在時刻,LSTM中的每個cell中都發生以下的輸入運算:

(5)

定義輸入門:

(6)

遺忘門:

(7)

輸出門:

(8)

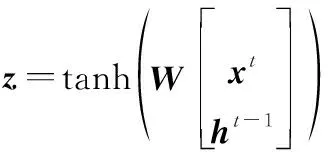

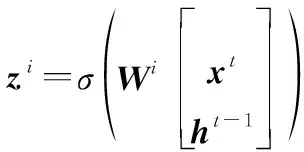

其中,是各個門的輸入權重,tanh和表示門控開關。每個cell同時也都輸出3個值、和。其中,是LSTM的輸出,是LSTM的各個cell之間的記憶存儲部分,是一個中間變量。在時刻,每個cell的輸出運算表達為

=⊙-1+⊙

(9)

=⊙tanh()

(10)

=()

(11)

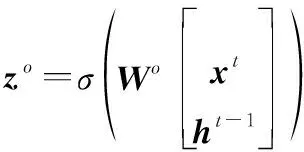

式中:⊙表示點積運算。在梯度下降算法中,每個時刻的參數按照下面的規則進行更新:

(12)

式中:表示更新步長;表示模型的損失函數。

(13)

更進一步的,如果將遺忘門換成1,輸入門換成,那式(13)就和式(12)完全一致了。因此,可以將梯度下降算法視為LSTM的簡化版,并且在梯度下降算法中也存在輸入門和遺忘門,只不過和與一般LSTM中的值不一樣,是人為指定的1和學習率,是不需要通過訓練去學習到的。

223 學習過程

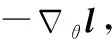

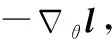

通過對LSTM和梯度下降算法的參數更新過程進行分析比較,元學習方法Meta-learner LSTM希望通過訓練讓機器自動地學習到動態的輸入門和遺忘門,而不是固定不變的值(即學到一種新的優化方法或者說是更新規則),以實現模型參數在少樣本學習任務上的快速優化更新來達到好的效果。如圖4所示,具體來說,Meta-learner LSTM的訓練過程要經過以下幾個步驟:

(1) 首先,要給學習算法給定初始值,以及LSTM的輸入門和遺忘門的初始值, 在學習過程中稱LSTM為元學習者,稱整個學習算法為學習者;

(2) 用源域的個訓練任務對元學習者進行依次訓練,對每個任務取出其支撐集和查詢集;

圖4 Meta-learner LSTM的訓練過程示意圖Fig.4 Training process of Meta-learner LSTM

2.2.4 訓練細節

輸入門在更新過程中,相當于梯度下降算法中的學習率,但是不同于梯度下降算法中恒定不變,在LSTM的學習過程中是動態的調整,使參數快速達到最優。遺忘門的作用相當于一個regularization,它會把前一個時刻算出來的參數進行縮放,而這個縮小的比例也是LSTM在學習過程中不斷變化的,而不是在梯度下降算法中的固定值1。這樣做是為了防止更新參數時陷于局部最優解中,從而無法做到有效優化。

圖5 Meta-learner LSTM的梯度獨立性假設Fig.5 Gradient independence hypothesis of Meta-learner LSTM

一般的LSTM中含有多個cell,但在實際的訓練過程中,為了簡化問題,此時的LSTM只有一個cell,而且所有的學習算法的參數都共用一個LSTM的參數來處理,這樣做有以下幾個好處:

(1) 合理的設置模型的尺寸和參數數量,使訓練更加快速有效;

(2) 此時的LSTM和其他人為設計的參數更新算法(RMSProp、Adam)一樣,都是對所有的參數采用相同的更新規則;

(3) 在MAML和Reptile方法中,要求訓練模型和測試模型的結構保持一致。但在Meta-learner LSTM方法中,由于所有的參數都用同一個LSTM來更新, 所以訓練和測試的模型結構可以不一樣。

3 少樣本頻譜圖像分類實驗

3.1 數據集介紹

3.1.1 MiniImageNet數據集

ImageNet是一個非常有名的大型視覺數據集,它的建立旨在促進視覺識別研究。ImageNet為超過1 400萬張圖像進行了注釋,而且給至少100萬張圖像提供了邊框。ImageNet包含2萬多個類別,比如:“氣球”“輪胎”和“狗”等類別,并且每個類別均有不少于500張圖像。由于訓練ImageNet數據集需要消耗大量的計算資源。因此,在2016年,google DeepMind團隊的Oriol等人在ImageNet的基礎上提取出了MiniImageNet數據集,并將其用于少樣本學習研究,自此MiniImageNet數據集成為了元學習領域應用最為廣泛的數據集之一。MiniImageNet數據集包括100類60 000張彩色圖片,其中每類有600個樣本,每張圖片的規格不定,并按照4∶1的比例劃分訓練集和測試集。

3.1.2 Omniglot數據集

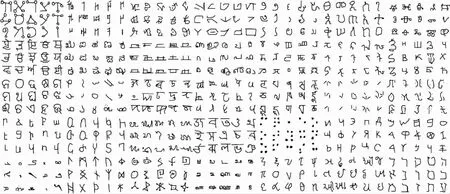

Omniglot數據集也是元學習領域的基準數據集之一,由50多種國際語言和虛構字符集組成的,每種語言都包括15到40多種字母,每個字母都是由20個不同的人通過亞馬遜的 Mechanical Turk在線繪制的。總的來說,Omniglot數據集包括1 623種不同類型的字符,每種類型有20張大小為64×64的灰度圖片,并按照3:2的比例劃分訓練集和測試集(見圖6)。

圖6 部分Omniglot數據集樣本Fig.6 Some Omniglot dataset samples

3.1.3 太陽射電頻譜數據集

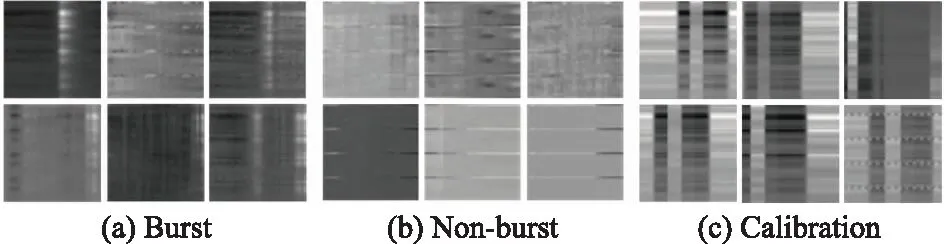

太陽射電頻譜數據集中的頻譜圖像來源于SBRS,SBRS所采集的數據最終可以轉換為以采樣時間為橫軸,以采樣頻率為縱軸的灰度圖像,圖像的像素值代表太陽射電的輻射強度。2015年,Chen等人建立了太陽射電頻譜數據集,數據集中共有4 408張大小為240×2 520的射電頻譜圖像。這些圖像按照爆發形態被分別3類,其中Non-burst代表圖像中不存在太陽射電爆發現象,Burst代表圖像中存在太陽射電爆發現象,Calibration類型代表圖像受到觀測設備等因素的影響需要進一步進行校準,圖7展示了太陽射電頻譜數據集中的3種類型圖像。

圖7 太陽射電頻譜數據集中的3種類型圖像Fig.7 Three types images in solar radio spectrum dataset

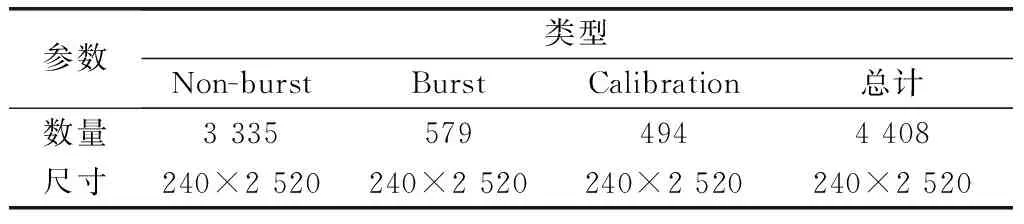

如表1所示,原始的太陽射電頻譜數據集存在明顯的樣本數量不均衡問題,尤其是Calibration類型的圖像只有494張,這對于傳統深度學習網絡來說,很容易造成模型過擬合。為了與元學習任務相匹配,本文對數據集進行了預處理,處理后的射電頻譜數據分布如表2所示。

表1 原始頻譜數據集樣本分布

3.2 實驗方案設計

本文將頻譜圖像的分類問題轉換成少樣本有監督學習任務,通過元學習方法來提高爆發頻譜圖像的檢測精度。在實驗中,采用MiniImageNet數據集和Omniglot數據集作為源域進行元知識的學習,然后將射電頻譜數據集作為測試任務的目標域進行知識的遷移,最后通過對比分析驗證元學習方法在射電頻譜數據集上的有效性。

為了保持源域和目標域的樣本形狀一致以及為了加速網絡訓練速度,在輸入神經網絡之前,將所有樣本的大小都縮放到了60×60。其中,MiniImageNet是三通道彩色圖像,Omniglot是單通道灰度圖像,為了使得各自學到的元知識更好的遷移到射電頻譜數據集上,在進行實驗時針對不同的源域數據對頻譜圖像的通道數進行了相應的調整。實驗中所用的分類模型是采用4個3×3卷積層、池化層和全連接層構成的網絡結構。在元測試階段,每個任務的支撐集都從源域的數據集中隨機選取3類樣本,每類樣本取1、5或20張圖像組成;查詢集是每類樣本取5張圖像進行模型精度檢驗和參數更新。在元測試階段,支撐集會在射電頻譜數據集中每次取3類樣本,每類樣本取和源域數據一致的圖像數量進行領域遷移和參數更新;查詢集是每類取5張圖像進行最后實驗結果評估,即實驗中設置=3,分別取1、5或20,=5。各實驗數據集的具體參數如表2所示。

表2 各實驗數據集的樣本參數

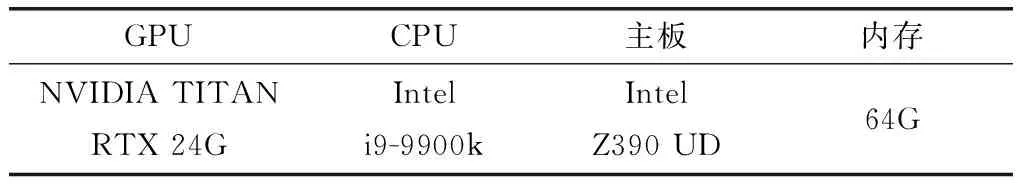

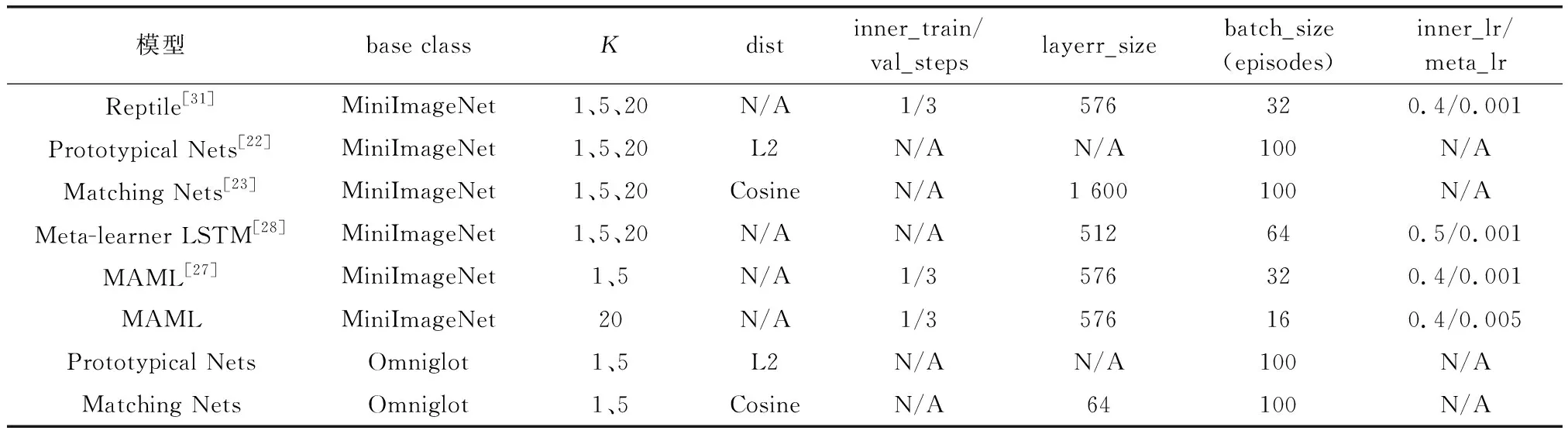

實驗中,分別將MiniImageNet數據集和Omniglot數據集作為元學習的源域,將射電頻譜數據集作為目標域,進行了多組對照試驗。基于MiniImageNet數據集,開展了分別取1、5和20時,5個元學習模型的分類對比實驗,并設置迭代次數epoch為1 000;基于Omniglot數據集,開展了分別取1和5時,兩個元學習模型的分類對比實驗,并設置迭代次數為500;所有實驗的查詢集數量都為5;實驗的硬件環境如表3所示,每個對比實驗的具體參數如表4所示。

表3 實驗所用的硬件環境配置

表4 各對比實驗的具體參數

3.3 實驗結果分析

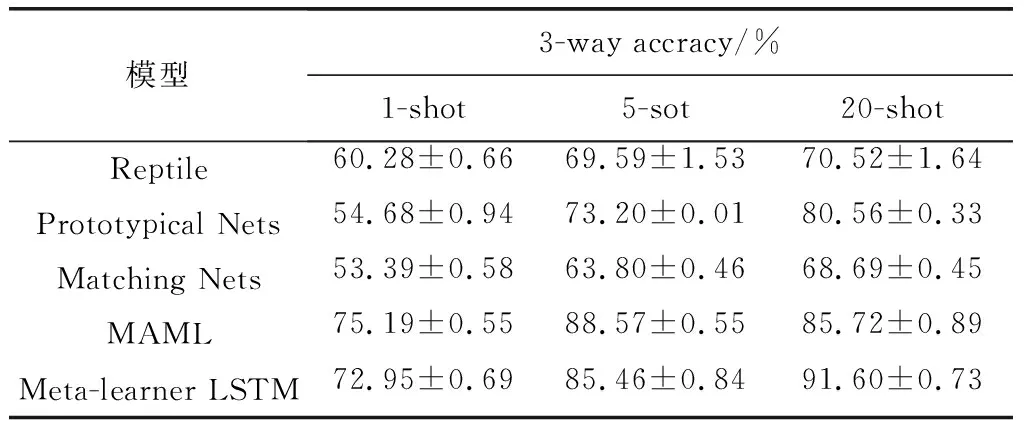

表5和表6分別是MiniImageNet數據集和Omniglot數據集作為源域時,少樣本頻譜圖像的分類精度,從中可以發現:

(1) 在MiniImageNet數據集上,基于優化的元學習方法(MAML、Meta-learner LSTM)在新領域樣本的適應度和學習能力要明顯強于其他兩個基于度量的學習方法(Prototypical Nets、Matching Nets);隨著支撐集數量K的增加,每種模型的分類精度都在顯著提升;當K 的數量達到20時,Meta-learner LSTM的分類精度反超MAML,達到了最優值91.60%;從表4的各模型參數中可以發現,此時的MAML由于硬件內存條件限制導致學習率和批大小參數未達到最優,從而使得=20時的精度較之=5時沒有提升,反而有一些下降。

表5 基于MiniImageNet數據集的少樣本頻譜圖像分類精度

表6 基于Omniglot數據集的少樣本頻譜圖像分類精度

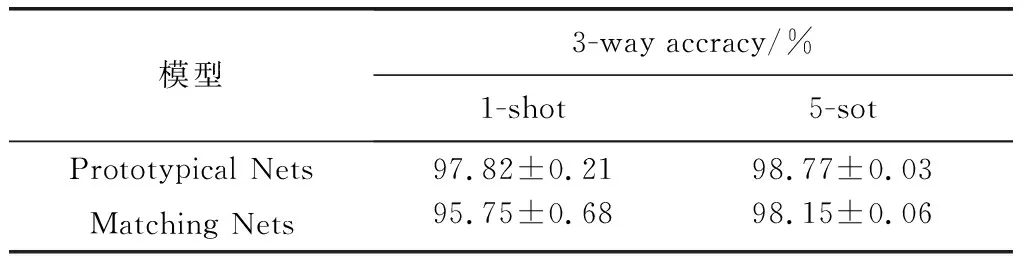

(2) 在Omniglot數據集上,原型網絡的精度要普遍高于匹配網絡,并且隨著支撐集數量的增加,精度明顯提高;受限于Omniglot數據集的各類樣本數量,Prototypical Nets模型在=5時取得了最優的分類精度98.77%。

(3) 相較于MiniImageNet數據集,Omniglot數據集均為灰度圖像且樣本特征比較簡單,也與射電頻譜圖像較為相像。這使得在源域學到的元知識可以更加合理的遷移到目標域中,從而可以取得更高的分類精度。

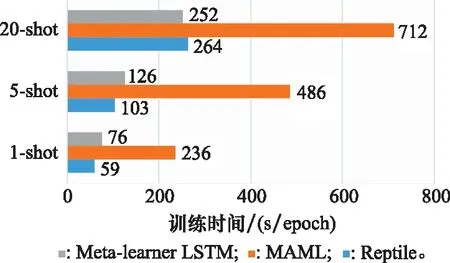

圖8和圖9分別描述了各個實驗的訓練過程和在MiniImageNet數據集上的訓練時間對比,通過分析比較可以看出:

(1) 相比于度量的元學習方法,基于優化的方法訓練過程更穩定,精度震蕩更小,但同時Prototypical Nets和Matching Nets的收斂速度卻更快。

(2) 因為Omniglot數據集更加簡單,學習過程也更為訊速,只需要MniImageNet數據集一半的訓練時間就可以達到收斂狀態。

(3) MAML是通過對初始參數的學習來快速適應新任務的,因此其訓練過程相較于其他基于優化元學習方法更為復雜,所耗費的時間代價也最大;同時,隨著支撐集數量K的增加,時間開銷呈現翻倍式的增長。

圖8 各對比試驗訓練過程中的精度變化Fig.8 Accuracy changes during the training process of each comparative experiment

圖9 各模型在MiniImageNet數據集上的訓練時間Fig.9 Training time of each model on MiniImageNet dataset

4 結 論

本文針對少樣本射電匹配圖像的分類任務,提出了一種基于元學習和遷移學習相結合的分類方法。通過將MiniImageNet數據集和Omniglot數據集作為源域數據,射電頻譜圖像作為目標域數據,采用基于優化的元學習方法將學習到的源域知識遷移到目標域中,實現對少樣本射電頻譜圖像的分類。通過設計多個對比實驗,證明了本文所提出方法的有效性和先進性。