基于深度學習的無人機影像夜光藻赤潮提取方法

李敬虎,邢前國,鄭向陽,李琳,王麗麗

(1.魯東大學信息與電氣工程學院,山東煙臺 264025;2.中國科學院煙臺海岸帶研究所,山東煙臺 264003;3.中國科學院大學,北京 100049)

0 引言

近年來,隨著海洋資源的大力開發利用,海洋生態環境遭受破壞,赤潮事件在全球范圍內呈現多發態勢[1]。赤潮是有害藻華(Harmful Algal Blooms,HAB)的一種常見類型[2],呈紅色或棕色,赤潮爆發期間會產生有毒物質,造成海洋生物死亡,對沿海地區的漁業和旅游業造成嚴重破壞[3],開展赤潮監測和研究工作具有重要現實意義。

針對赤潮對漁業和旅游業造成的惡劣影響,眾多監測手段被提出用于赤潮監測工作[4]。早期依賴于實地取樣和葉綠素a(Chlorophyll a,Chl-a)濃度實驗分析的現場觀測方法,資源密集且耗時,而通過固定點水質傳感器監測赤潮,存在無法靈活改變監測地點和深度的問題,導致赤潮研究局限于相對較小的區域或較短的時間段[5]。衛星遙感作為一種重要觀測手段,在目標識別、環境監測中發揮著重要作用[6]。目前,已經成功開發出眾多利用衛星光學遙感數據進行赤潮監測的算法[7-9]。借助衛星遙感,赤潮監測工作不再受限于現場采樣效率,降低了時間和經濟成本[10]。

隨著機器學習、深度神經網絡不斷優化改進,展示了其在遙感等領域的應用潛力[11-12],為赤潮信息提取提供了新的解決方法。Kim 等[13]利用U-Net 模型對地球靜止海洋水色成像儀(Geostationary Ocean Color Imager,GOCI)數據進行分析,成功提取了朝鮮半島南部沿海地區的赤潮;Lee 等[14]對2013 年朝鮮半島南部沿海地區赤潮的Landsat-8 OLI(Operational Land Imager)數據進行分析,結合實地考察,提出了結合深度學習的赤潮監測方法。

受限于衛星遙感的固定時空分辨率,衛星遙感無法為赤潮監測提供更加精準和實時的技術支持。近年來,搭載高分辨率攝像機的無人機(Unmanned Aerial Vehicle,UAV)作為傳統衛星遙感的重要補充,具有使用成本低、操作簡單、獲取影像速度快、地面分辨率高等傳統遙感無法比擬的優勢,在環境監測中得到越來越多的應用[15-16]。目前常見的無人機配備高分辨率的RGB(Red-Green-Blue)數碼相機,若能用于赤潮高效的提取,會大幅提高赤潮的遙感監測水平。

基于以上討論,本文以無人機采集夜光藻(Noctiluca scintillans)赤潮RGB 視頻影像作為監測數據,通過在原始UNet++網絡[17]基礎上,修改主干網絡為VGG-16(Visual Geometry Group-16)[18],引入空間dropout(spatial dropout)策略[19],同時使用ImageNet 數據集[20]預先訓練VGG-16 網絡進行遷移學習,提出了一種基于深度學習的無人機影像夜光藻赤潮提取方法,實現了對復雜環境中夜光藻赤潮自動化、高精度的提取。在自建的赤潮數據集Redtide-DB 上,通過與多種方法進行對比測試,探究所提方法的優勢和不足。

1 數據采集和數據采樣

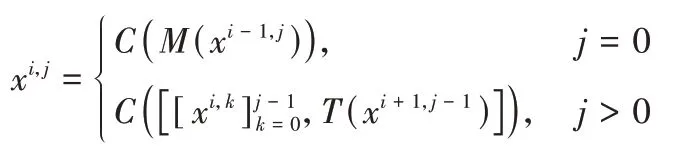

本文無人機獲取的夜光藻赤潮影像來自北黃海近岸海域,數據保存為視頻格式,視頻分辨率為1 280 像素×720 像素。數據獲取所用的無人機型號為大疆“御”Mavic 2 專業版,搭載RGB 相機。夜光藻赤潮數據采集期間大氣能見度一般(如圖1 所示)。

圖1 無人機采集的夜光藻赤潮樣本數據Fig.1 Sample data of Noctiluca scintillans red tide taken by UAV

為便于夜光藻赤潮提取工作,首先按照固定頻率,對視頻格式的數據進行采樣,最終形成2 691 張圖片的樣本庫,部分數據如圖1 所示。樣本庫中的2 511 張圖片作為訓練樣本參與模型訓練,視頻最后30 s 采樣所得的180 張圖片作為測試樣本,用于評估所提方法的夜光藻赤潮提取精度。

2 夜光藻赤潮提取與精度評估

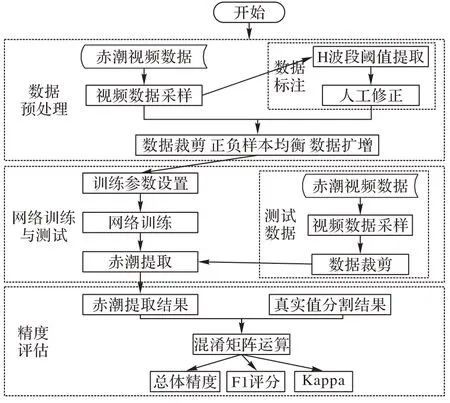

針對目前衛星遙感中夜光藻赤潮識別精度低、實時性差的問題,以無人機采集的高分辨率夜光藻赤潮RGB 視頻影像作為監測數據,提出一種基于深度學習的無人機影像夜光藻赤潮自動提取方法,由數據預處理、網絡訓練與測試、精度評估構成,提取流程如圖2 所示。

圖2 基于深度學習的無人機影像夜光藻赤潮提取流程Fig.2 Flow of Noctiluca scintillans red tide extraction from UAV images based on deep learning

2.1 數據預處理

為構建用于訓練的數據集,首先對數據進行標注。夜光藻赤潮區域分為明顯區域和不明顯的區域,如圖1 所示。夜光藻赤潮不明顯區域由于邊界模糊,人工標注容易受到主觀因素的影響。為減小數據集標注導致的誤差,首先在HSV(Hue-Saturation-Value)顏色空間選取H(Hue)波段閾值法對夜光藻赤潮進行提取;然后結合目視解譯對提取結果進行修正;最終將數據標注為背景、夜光藻赤潮明顯區域和非明顯區域三部分。

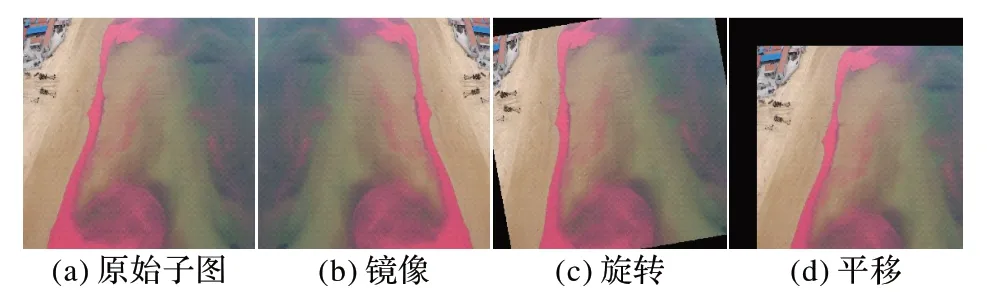

訓練過程中為減少圖片尺寸過大帶來的硬件壓力,將圖片切割為512×512 大小的子圖;同時,為減少正負樣本失衡對分類器性能的影響,去除背景像元占單樣本像元總數90%以上的樣本;最后對數據進行鏡像、隨機旋轉、隨機平移的數據擴增操作,如圖3 所示。

圖3 數據擴增Fig.3 Data augmentation

經過上述圖片裁剪、正負樣本均衡和數據擴增處理之后,得到有效樣本數為6 560 的赤潮數據集Redtide-DB。Redtide-DB 數據集被隨機分為兩部分,其中80%作為訓練集,20%作為驗證集。最后,在對圖片進行預測時,使用Overlap-tile 策略[21]保留圖片邊緣特征,以獲得更準確的赤潮提取結果。

2.2 網絡訓練與測試

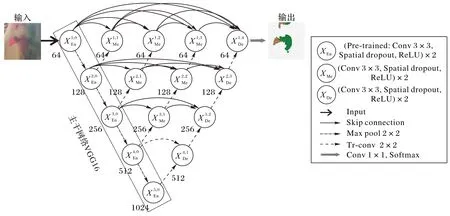

在原始UNet++網絡基礎上,通過修改主干網絡為VGG-16 網絡,以提高其特征提取能力,同時引入空間dropout 策略,將dropout 擴展到整個網絡來防止過擬合。本文網絡模型訓練過程中,使用ImageNet 數據集預先訓練VGG-16 網絡進行遷移學習,提高收斂速度。

本文網絡的拓撲結構如圖4 所示,由編碼器、解碼器和密集跳躍連接組成,其中:Input、Conv、Max pool、Tr-conv、Softmax 分別代表輸入層、卷積層、最大池化層、反卷積(Transposed convolution)層、分類層;每個圓圈代表一個特征提取模塊,由兩個3×3 的卷積層組成,其卷積操作之后,依次連接空間dropout 單元和修正線性單元(Rectified Linear Unit,ReLU)。每個特征提取模塊節點下面的數字表示當前節點輸出的通道數,節點內部En、Me、De 用來區別編碼路徑、密集跳躍連接、解碼路徑的單元。

圖4 網絡拓撲結構Fig.4 Network topology

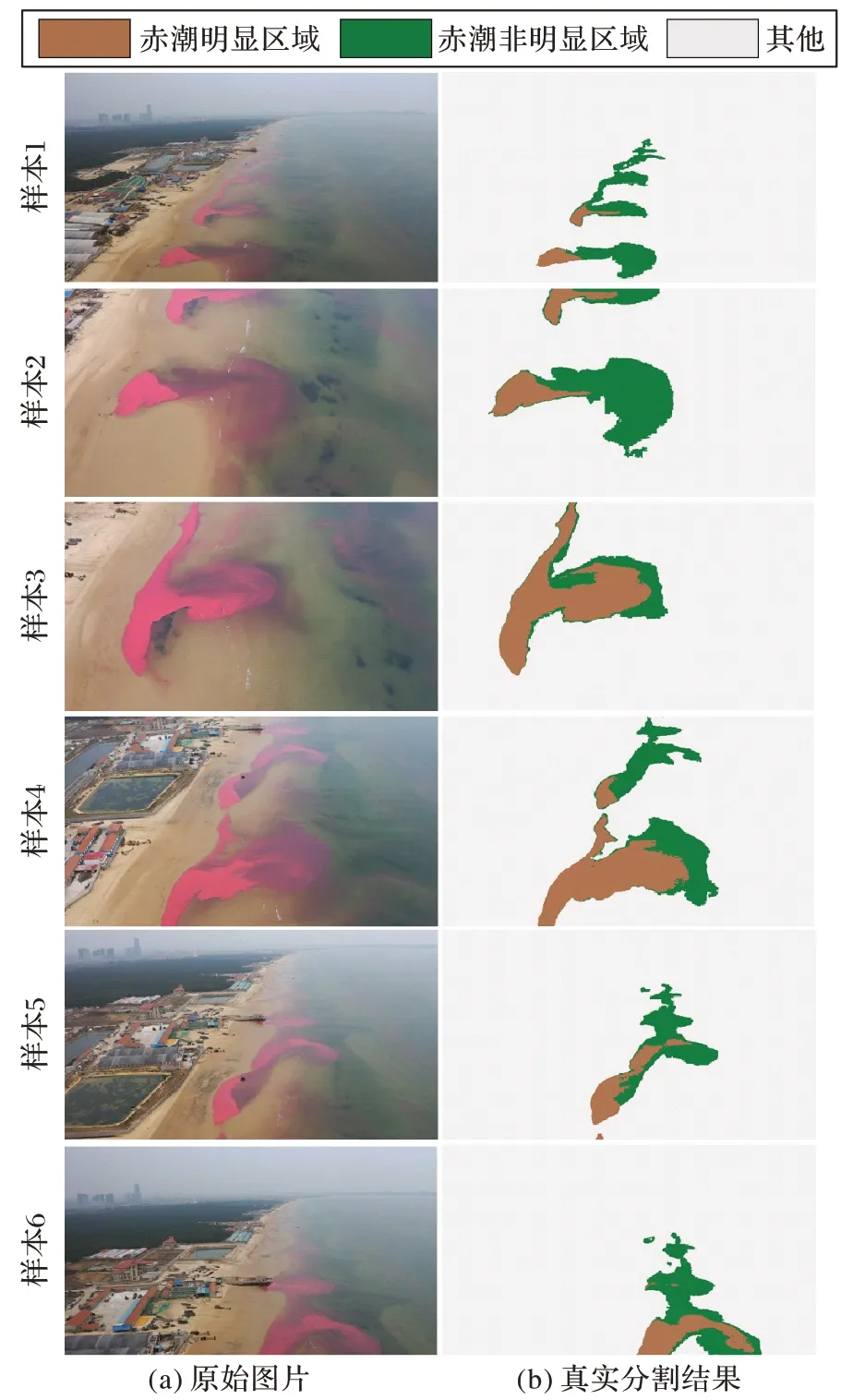

在本文網絡模型中,通過編碼結構中降采樣操作,可以不斷增加感受野大小,從而避免較小感受野造成的分割邊緣模糊問題;同時,在不斷下采樣過程中,可以得到不同程度的下采樣分支,進行多尺度特征的融合,以提高分類精度。在解碼結構中,對密集跳躍連接融合的特征圖進行上采樣,將特征圖尺寸還原為原始圖片大小,以便對圖片中各個像素進行分類。在相同層之間通過跳躍連接(skip connection)的方式將特征向后傳遞,從而將編碼特征與解碼特征進行連接,減少特征提取過程中的信息損失;在不同層之間,特征自上至下深度聚合,縮小了編碼特征與解碼特征跳躍連接時的語義鴻溝(semantic gap),從而提升模型的特征學習能力。網絡中每個模塊的輸出結果為:

式中:xi,j表示當前特征提取模塊的輸出,i表示網絡模型的層序,從上至下依次取值為1~5,j表示同一層的模塊序號,j=0表示為編碼器特征提取模塊;C(·)表示特征提取模塊的卷積操作;M(·)表示最大池化操作;T(·)表示反卷積操作;[·]表示特征通道合并(concatenate)。

本文以PyTorch 作為深度學習開發框架,在硬件配置為Intel Core i5 CPU,NVIDIA Tesla T4 GPU,16 GB 顯存,16 GB內存,操作系統為Ubuntu16.04,編程語言python 的環境上進行訓練和測試。使用Lovasz 損失函數[22];損失函數優化算法采用自適應矩估計法(Adaptive moment estimation,Adam);基礎學習率為0.000 1;批大小設為8;設置100 個epoch;空間dropout 參數為0.5。

2.3 精度評估

為驗證本文所提出的夜光藻赤潮提取方法的可靠性,選用總體精度(Overall Accuracy,OA)、F1 評分(F1 score)和Kappa 作為評價指標,在驗證集上進行夜光藻赤潮提取測試和精度評估,其中OA 代表所有正確分類的像元占總像元的比例。

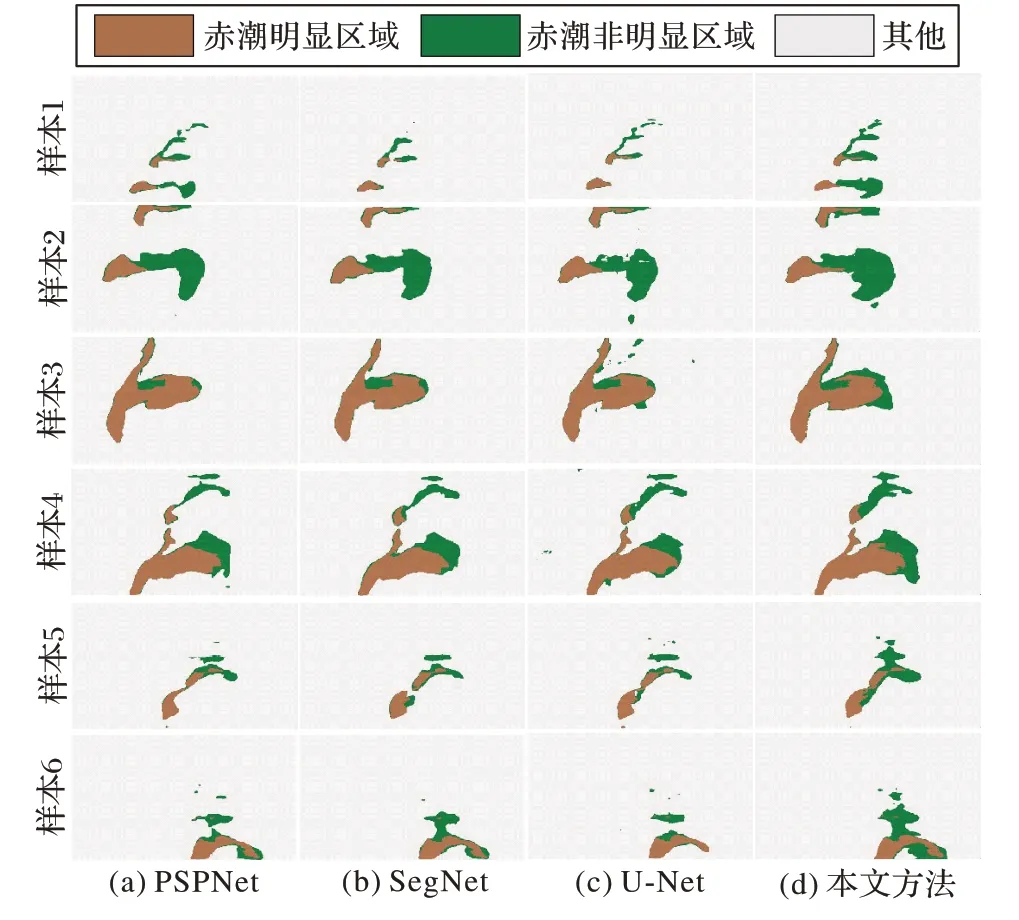

為了探究所提方法與其他方法相比在提取夜光藻赤潮時的優勢和不足,選取不同拍攝角度和高度的6 張典型測試圖片對提取結果進行展示,其原圖及目視解譯的真實分割結果如圖5 所示。

圖5 用于細節展示的原始圖片和真實分割結果Fig.5 Original images and actual segmentation results for detail display

3 實驗及結果分析

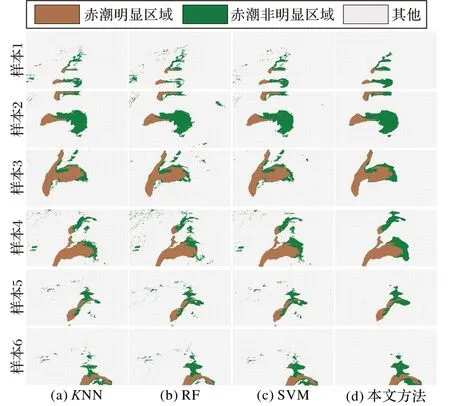

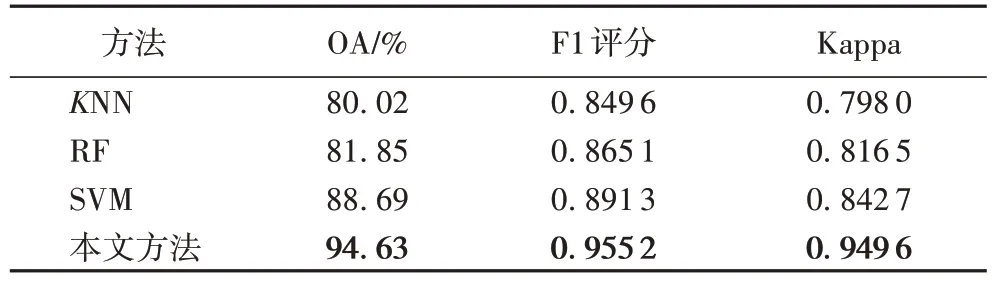

3.1 機器學習方法夜光藻赤潮提取結果對比

為驗證本文所提出的夜光藻赤潮提取方法的優越性,采用K近鄰(K-Nearest Neighbors,KNN)[23]、支持向量 機(Support Vector Machine,SVM)[24]和隨機森 林(Random Forest,RF)[25]這3 種機器學習方法進行對比測試。在實驗過程中,KNN 方法參數為:采用KD 樹(K-Dimensional tree)算法,K值設為5,使用歐幾里得距離,距離的權重選擇無;SVM方法參數為:核函數為徑向基函數(Radial Basis Function,RBF),其中調整懲罰系數值為10,gamma 參數值為0.1;RF方法參數為:森林中樹木的數量為30,最大分裂數為249。在驗證集上,KNN、SVM、RF 和本文方法的夜光藻赤潮提取評價指標如表1 所示,6 張典型測試圖片的分類細節如圖6所示。

圖6 不同機器學習方法的夜光藻赤潮提取結果對比Fig.6 Noctiluca scintillans red tide extraction results comparison of different machine learning methods

表1 機器學習方法的夜光藻赤潮提取評價指標對比Tab.1 Comparison of evaluation indexes of machine learning methods on Noctiluca scintillans red tide extraction

在機器學習方法中,SVM 方法的夜光藻赤潮提取評價指標(OA=88.69%,F1 評分=0.891 3,Kappa=0.842 7)高于其他2 種機器學習方法。但是由于建筑物區域和夜光藻赤潮區域的像元光譜信息相近,機器學習方法沒有充分利用圖像的上下文信息,導致其提取結果中出現較多的建筑物誤識別。

與機器學習方法對比,本文提出的基于深度學習夜光藻赤潮提取方法具有明顯的精度優勢,其夜光藻赤潮提取的三個評價指標均高于機器學習方法。本文所提方法在準確識別夜光藻赤潮的同時,有效避免了建筑物、云霧、耀光等因素的干擾,具有較強的抗干擾能力,且計算簡單,不用人工提取特征。

3.2 語義分割網絡赤潮提取結果對比

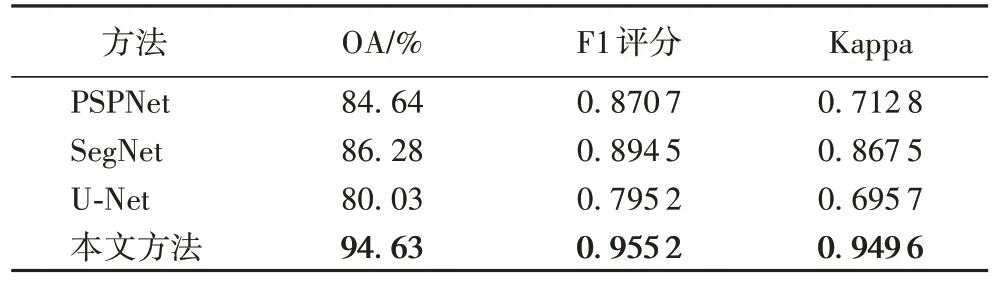

為比較本文方法相比其他語義分割網絡在赤潮提取任務上的性能差異,采用PSPNet(Pyramid Scene Parsing Network)[26]、SegNet[27]和U-Net[21]這3 種典型的語義分割網絡進行對比測試。在實驗過程中,3 種典型語義分割網絡的超參數設置與本文方法保持一致。在驗證集上,3 種語義分割網絡(PSPNet、SegNet 和U-Net)及本文方法的夜光藻赤潮提取評價指標如表2 所示,6 張典型測試圖片分類細節如圖7所示。

表2 語義分割網絡的夜光藻赤潮提取評價指標對比Tab.2 Comparison of evaluation indexes of semantic segmentation networks on Noctiluca scintillans red tide extraction

從表2 可以看出,評價指標的最高值(OA=94.63%;F1評分=0.955 2;Kappa=0.949 6)均為本文方法的提取結果。從圖7 可以看出,3 種語義分割網絡都可以有效識別建筑物等干擾信息,但是在赤潮非明顯區域的信息提取上效果較差;本文方法相較于其他3 種語義分割網絡,可以更好地保留夜光藻赤潮的細節信息,在細弱目標識別上具有較高精度。

圖7 語義分割網絡的夜光藻赤潮提取結果對比Fig.7 Noctiluca scintillans red tide extraction results comparison of semantic segmentation networks

3.3 泛化能力分析

在實際應用中,本文所提出夜光藻赤潮提取方法對新樣本的泛化能力也是一項重要的評價指標,選用不同拍攝環境和不同拍攝設備獲取的夜光藻赤潮影像進行測試,并驗證精度。用于測試的圖片尺寸為3 968×2 976,相機型號為HMAAL00。本文所提方法的夜光藻赤潮提取結果如圖8 所示。

圖8 泛化能力測試Fig.8 Test of generalization ability

分析結果可知,基于深度學習的無人機影像夜光藻赤潮提取方法的在新樣本上同樣具有較好的分類結果,經過定量精度評估其OA 為97.41%,F1 評分為0.965 9,Kappa 為0.938 2,說明其對新樣本具有一定泛化能力,可以應用于不同拍攝設備和環境。

4 結語

無人機具有獲取影像靈活和分辨率高的特點,使得快速對赤潮做出反應成為可能。為快速和準確地處理無人機獲取的大量視頻數據,本文通過融合UNet++模型、VGG16 主干網絡、空間dropout 策略,提出了一種基于深度學習的無人機影像夜光藻赤潮提取方法。

研究表明,機器學習方法(KNN、SVM、RF)無法準確提取復雜環境中的夜光藻赤潮信息,并且訓練數據需要人工提取特征,操作困難且效率低;PSPNet、SegNet 和U-Net 3 種典型的語義分割網絡在赤潮圖像的細弱目標識別上效果較差。本文所提出的夜光藻赤潮提取方法在對比實驗中表現最優,實現了高精度提取,且自動化程度高,魯棒性強,使業務化的夜光藻赤潮無人機監測具有較高的可行性。不同的赤潮具有不同的顏色,本文提出的模型能否應用于其他優勢種的赤潮,我們將進一步開展研究。