基于近紅外光譜和深度模型轉移預測煙絲總糖含量

賓俊王志國杜文鐘科軍陳增萍

(1.湖南中煙工業有限責任公司技術中心,湖南 長沙 410007;2.湖南大學化學化工學院,湖南 長沙 410082)

近紅外光譜是一種簡單、快速、綠色、非破壞性的分析技術,已廣泛應用于煙草常規化學成分、無機元素、物理指標和煙氣成分的檢測等[1,2];在煙葉分級、卷煙配方識別、卷煙輔料分析和在線質量控制等方面也得到成功應用[3]。隨著煙草行業近紅外光譜數據的不斷積累,模型會越來越大,使用深度學習方法構建模型勢在必行,深度學習由于具有強大的多層次特征學習和提取能力,可彌補傳統機器學習方法函數形式簡單、特征提取依賴經驗的缺陷,已逐漸成為多元信號建模的有力工具[4],在煙草行業、光譜數據分析方面都獲得了大量應用[5]。如果訓練樣本足夠,深度神經網絡的準確性和魯棒性高于傳統的機器學習算法[6,7]。

但是,隨著近紅外光譜技術應用場景的日益復雜,測量環境溫度/濕度變化、儀器或其配件/精度改變、樣品物理狀態/化學成分變化等,2次測量光譜之間的吸光度差異、波長漂移、背景漂移是不可避免的[8,9],與傳統機器學習方法類似,大多數深度學習模型對儀器和樣品也具有高度特異性,因而基于源域的深度學習模型無法直接應用于目標域樣品的預測[10]。通常目標域數據樣本量較小,重新建模效果較差,為提高預測準確率,降低建模成本,可采用遷移學習將訓練成功的源域模型作為預訓練網絡,而已經訓練好的模型對相似的新樣品數據具有極高的特征提取能力,經過微調更改相關層,共享相關參數信息,可以完成對目標域樣品的預測任務[11,12]。基于此,本文擬通過深度模型轉移策略消除不同儀器、不同物理狀態對煙葉檢測的影響,利用一臺儀器上已成功構建的煙粉總糖卷積神經網絡(CNN)模型實現對新儀器上煙絲樣品總糖含量的準確預測,以期提高模型應用效率、降低建模成本。

1 材料與方法

1.1 光譜采集及預處理

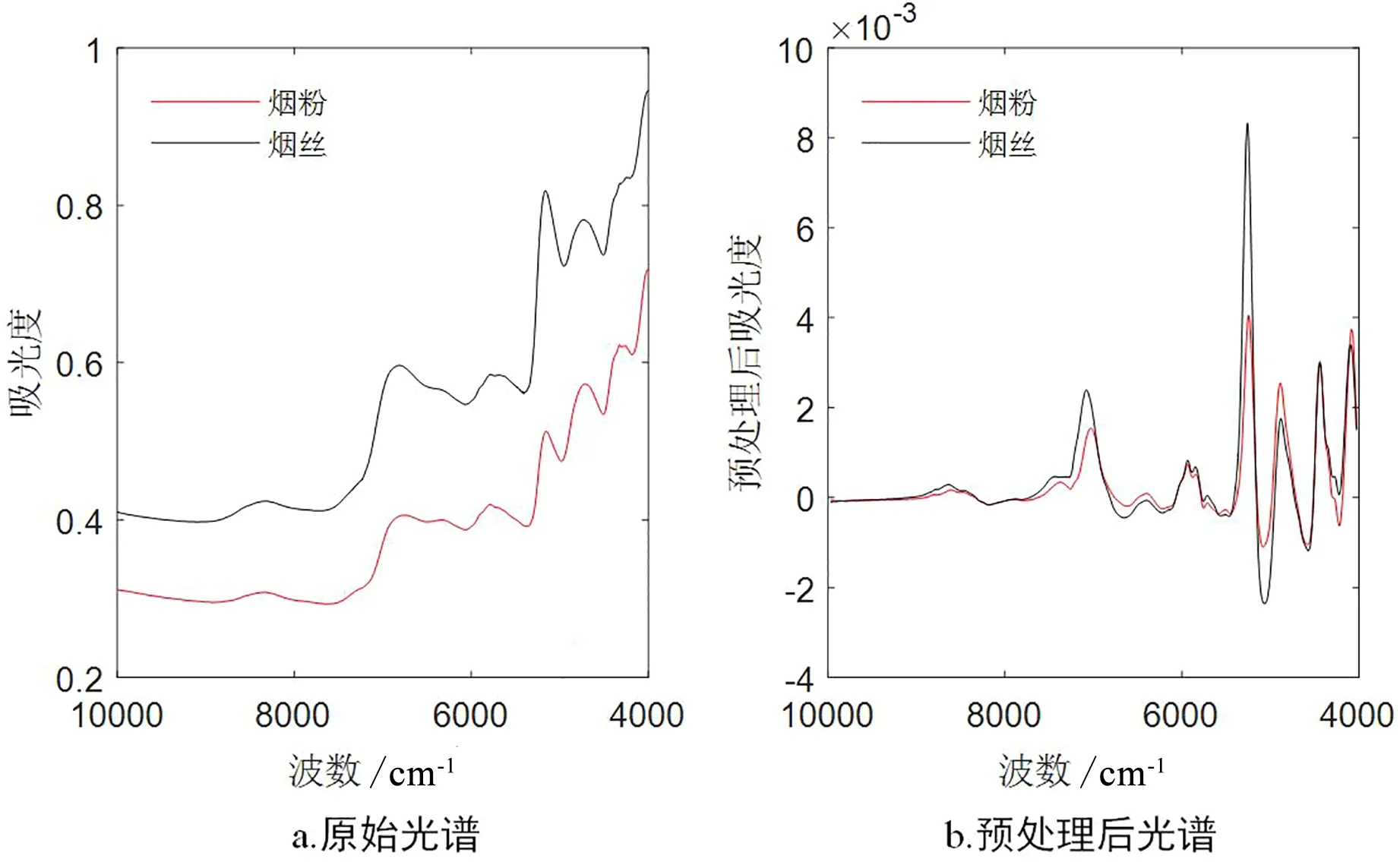

本研究收集煙粉樣品330個、煙絲樣品100個,源機為MPA傅里葉變換近紅外光譜儀(德國Bruker Optics公司),目標機為Antaris Ⅱ傅里葉變換近紅外光譜儀(美國Thermo Fisher Scientific公司)。利用源機測量煙粉樣品的光譜,目標機測量煙絲樣品的光譜,測量的波長范圍為4000~10000cm-1,每條光譜包含1555個波長點。所有樣品的總糖含量參照煙草標準YC/T 159-2002測定。采用Norris一階導數濾波結合平滑法對源機和目標機所有近紅外光譜進行預處理,預處理前后的近紅外光譜見圖1。

圖1 煙葉近紅外光譜圖

1.2 樣本劃分

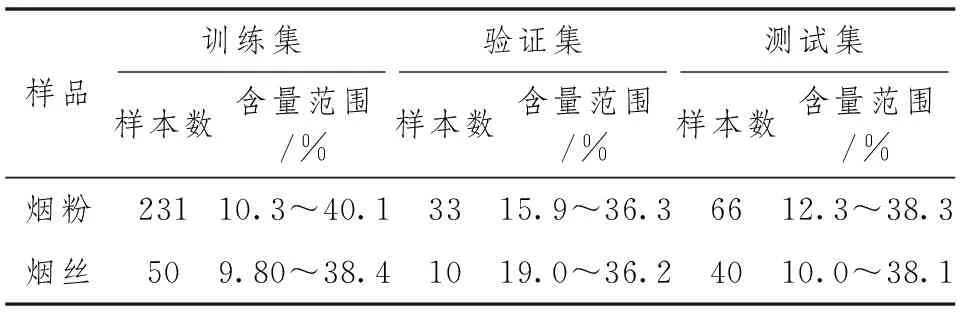

采用Kennard-Stone樣本劃分方法[13]按照7∶1∶2的比例將煙粉光譜數據劃分為訓練集、驗證集和測試集。訓練集和驗證集用于深度學習模型的訓練和參數優化,測試集用于深度學習模型性能測試。為了傳遞模型,將煙絲光譜數據按照5∶1∶4的比例劃分為微調訓練集、微調驗證集和外部測試集。微調訓練集和微調驗證集用于轉移模型的深度模型轉移和參數優化,而外部測試集用于轉移模型的效果測試,具體的數據集劃分結果見表1。

表1 樣本信息統計

1.3 1D-CNN模型構建

卷積神經網絡(CNN)[14,15]是一種典型的前饋神經網絡,在圖片、人臉和語音識別領域表現突出。CNN的基本結構通常由卷積層、池化層和全連接層3個部分組成。卷積層的目的是不斷地學習輸入的樣本特征。池化層的主要作用是控制實現圖像或者數據的空間不變形,降低特征圖的分辨率,將前一層所有的神經元與當前層的每個神經元相連接。全連接層的作用是將輸出傳遞到輸出層。

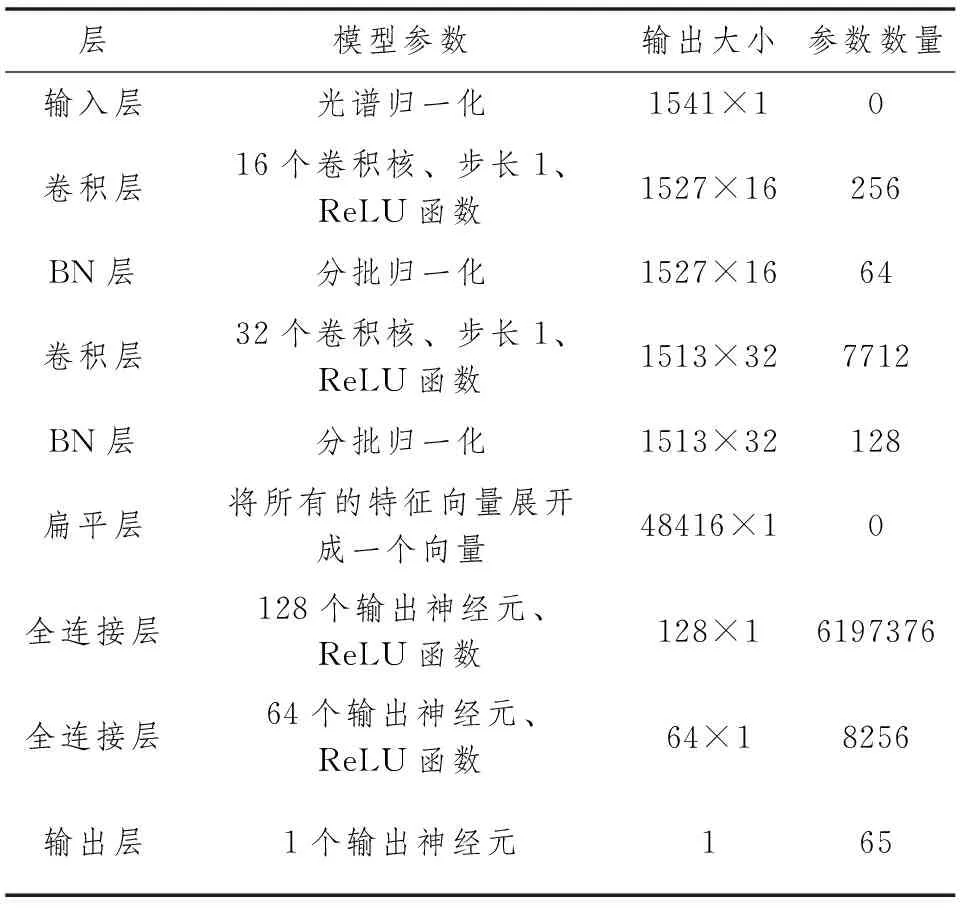

由于煙葉近紅外光譜是一維向量,本研究設計了一個包括2個卷積層、2個批歸一化層和2個全連接層的一維CNN(1D-CNN)模型,見表2。與許多用于圖像識別問題的二維CNN模型由一系列卷積層和池化層組成不同,僅使用2個分別帶有16個、32個卷積核的卷積層。考慮到輸入向量尺寸小和網絡層數少,沒有使用池化層,因為池化層可能會導致信息丟失。在每次卷積運算后應用線性整流函數(ReLU)變換以確保非線性。卷積層后設置批歸一化(BN)層用于加速網絡收斂,改善梯度彌散,提高網絡的泛化能力。轉換后的數據分別流經128個和64個神經元的2個全連接層,激活函數設置為ReLU。用1個單一神經元全連接層的線性激活函數來實現回歸分析。

為了提高優化算法的收斂性,采用“He_normal”對各層的權值進行初始化,使用自適應矩優化算法(Adam)進行模型優化,可以自適應學習速率,初始學習率(LR)根據LR=0.01×(批處理大小)/256設置,在訓練過程中不斷迭代減小,減少訓練初始階段的收斂時間,并且通過逐步減小LR步長,使Adam算法能夠逼近極小值。使用均方誤差(MSE)作為損失函數,在訓練過程中觀察損失函數變化,若經過一定次數的歷元,驗證集損失函數趨于穩定或增大,則停止訓練。

表2 卷積神經網絡設置

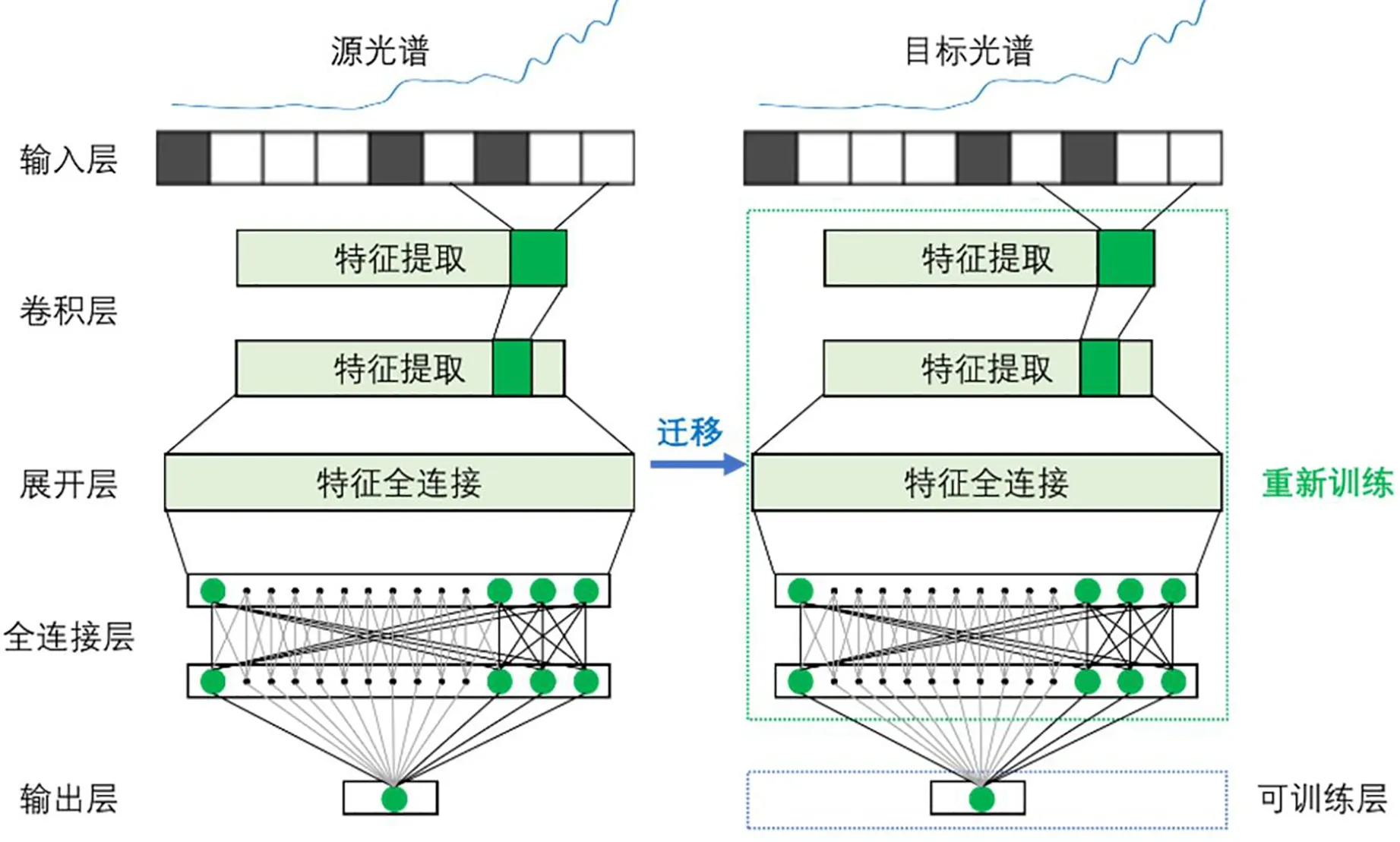

1.4 深度模型轉移方法

本文所構建的CNN模型主要分為3個部分:卷積層的特征增強/提取,全連接層非線性建模部分和映射到響應變量的最終輸出層。計算機視覺領域中廣泛使用的遷移學習方法是通過凍結特征增強/提取部分(將先前學習的權重保持為常數)來適應新任務,并允許重新訓練其他層(全連接層和輸出層)上的權重以適應新場景。假設由卷積層從第一圖像集提取的低水平特征對所有圖像都是通用的,并且只需要根據目標數據以不同的方式組合。這些低層特征也被認為是空間不變量,即CNN可以在圖像中的任何地方找到這些模式。有研究表明,使用正確的結構構建的一維CNN應用于特定類型的光譜,也可以實現光譜特征的類似平移不變性。

圖2 深度模型轉移流程圖

由于本研究包括儀器不同、樣品狀態不同2種差異,凍結卷積層可能無法達到與二維CNN相同的效果。這是因為在許多情況下儀器的差異是局部的,但是樣品狀態的差異是全局的,可能需要重新訓練卷積層的權重。但是,也不應完全替換全連接層中的權重,因為其已經學習到了卷積層提取的特征與響應變量之間的一些有用映射關系,遷移學習過程是通過在一個小的新數據集上重新訓練模型來微調這些預先學習的權重,少量的數據樣本足以擴展神經網絡的“信息/知識”[10,16]。因此,本文深度模型遷移策略是全連接層用預先訓練的權重初始化,并利用新的微調數據對模型進行重新訓練,具體流程圖見圖2。

1.5 模型評價與軟件

模型的評價參數選擇相關系數(R2)和均方根誤差(RMSE),R2越大,表明分析組分與模型預測結果的相關性越好,RMSE越小,表明預測性能越好,模型傳遞的效果越好。

所有光譜數據預處理、模型轉移計算均使用Python(v3.8.2)平臺上完成。此外,CNN模型的訓練和驗證都是使用Keras庫(v2.4.3)和TensorFlow(v2.4.0)后端實現的。所有操作都是采用英特爾核心1.8GHz CPU、16GB內存和Windows操作系統的電腦完成。

2 結果與討論

2.1 光譜差異分析

煙粉和煙絲的光譜如圖1所示。從圖1可知,相對來說,煙粉的光譜平均響應較煙絲的響應低,且2臺儀器光譜之間有輕微的峰漂移,在整個光譜范圍內都存在。引起這種差異的因素可能是儀器光源、檢測器和樣品狀態的不同。因此,如果在一臺儀器光譜上建立的模型用于新儀器采集光譜的預測時,由于2個應用場景存在的差異,預測結果不會太好。所以,校正差異的模型轉移是必須的。

2.2 深度學習模型建立

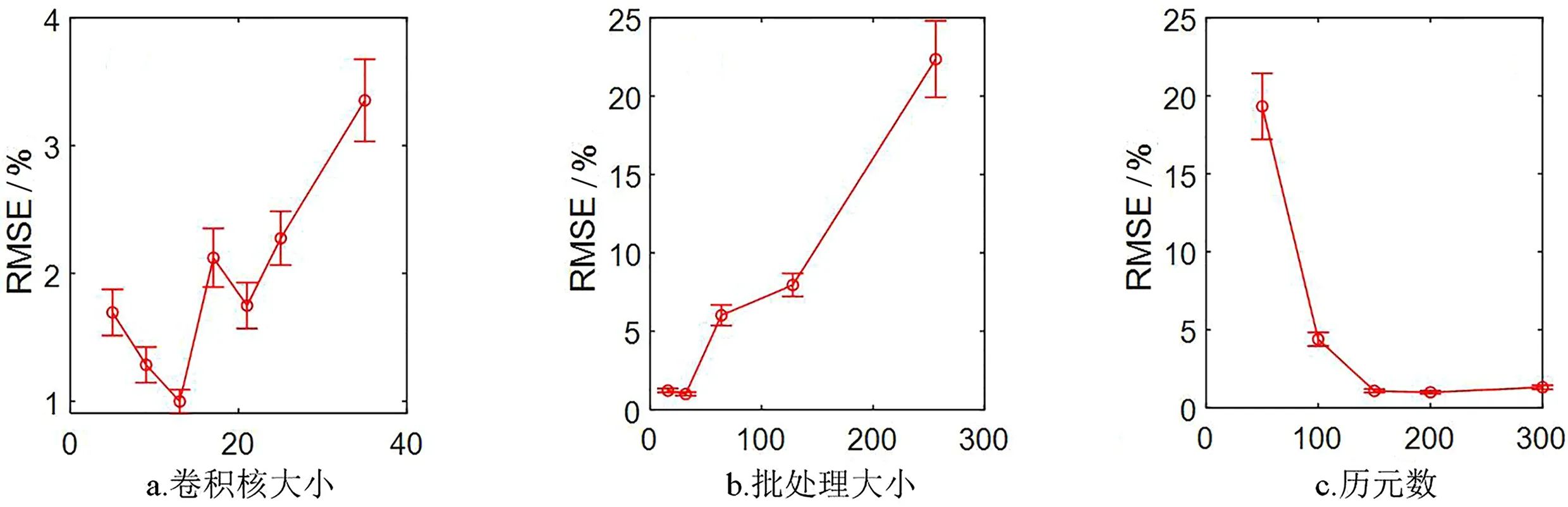

為了獲得較高的預測精度,需要對CNN模型訓練中的幾個關鍵參數進行優化,本文研究了卷積核大小、批處理大小和歷元次數對模型的影響。

2.2.1 卷積核大小

研究了卷積核大小對CNN模型的影響,分別計算卷積核尺寸為5、9、13、17、21、25和35的預測誤差,如圖3a所示,卷積核大小對CNN預測結果的影響較小,當卷積核大小設置為13時,校正集和驗證集的預測均方根誤差達到最小。因此,在CNN模型構建中,卷積核大小被設置為13。

2.2.2 批處理大小

采用批處理方法對數據集進行分割,可以加快更新參數,適當的批處理大小有助于模型訓練。實驗比較了16、32、64、128和256的批處理大小對模型的影響,如圖3b所示,當批處理大小為32時,驗證集的預測誤差最低。因此,批處理大小被設置為32。

2.2.3 歷元次數

歷元次數是CNN模型構建中的一個重要參數。如果歷元太小,模型的泛化能力就不高。如果歷元過大,模型很容易過度擬合,需要大量的訓練時間。為了評估歷元大小對模型性能的影響,歷元大小為50、100、150、200和300的CNN模型預測結果如圖3c所示。當歷元較小時,模型訓練不足,分類精度較低。分類精度隨歷元大小的增加而增加。當歷元次數大于150時,預測結果變化不大,趨于穩定。因此,CNN建模的歷元次數設置為150。

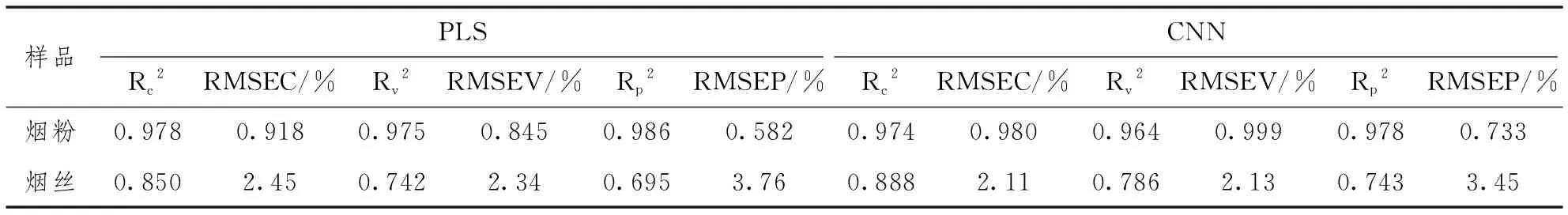

表3為煙粉和煙絲偏最小二乘(PLS)[17]、CNN模型的性能參數,CNN模型參數為運行5次的平均值。從表3可知,煙粉的PLS模型預測性能略優于CNN模型,總體相差不大,而煙絲的CNN模型預測性能略優于PLS模型,總體而言,煙粉的PLS和CNN模型預測性能皆優于煙絲模型,可以獲得令人滿意的結果。因此,將煙粉模型進行轉移用于煙絲樣品的預測是可行的。

圖3 卷積神經網絡參數優化

表3 建立的煙粉、煙絲光譜PLS、CNN模型性能參數

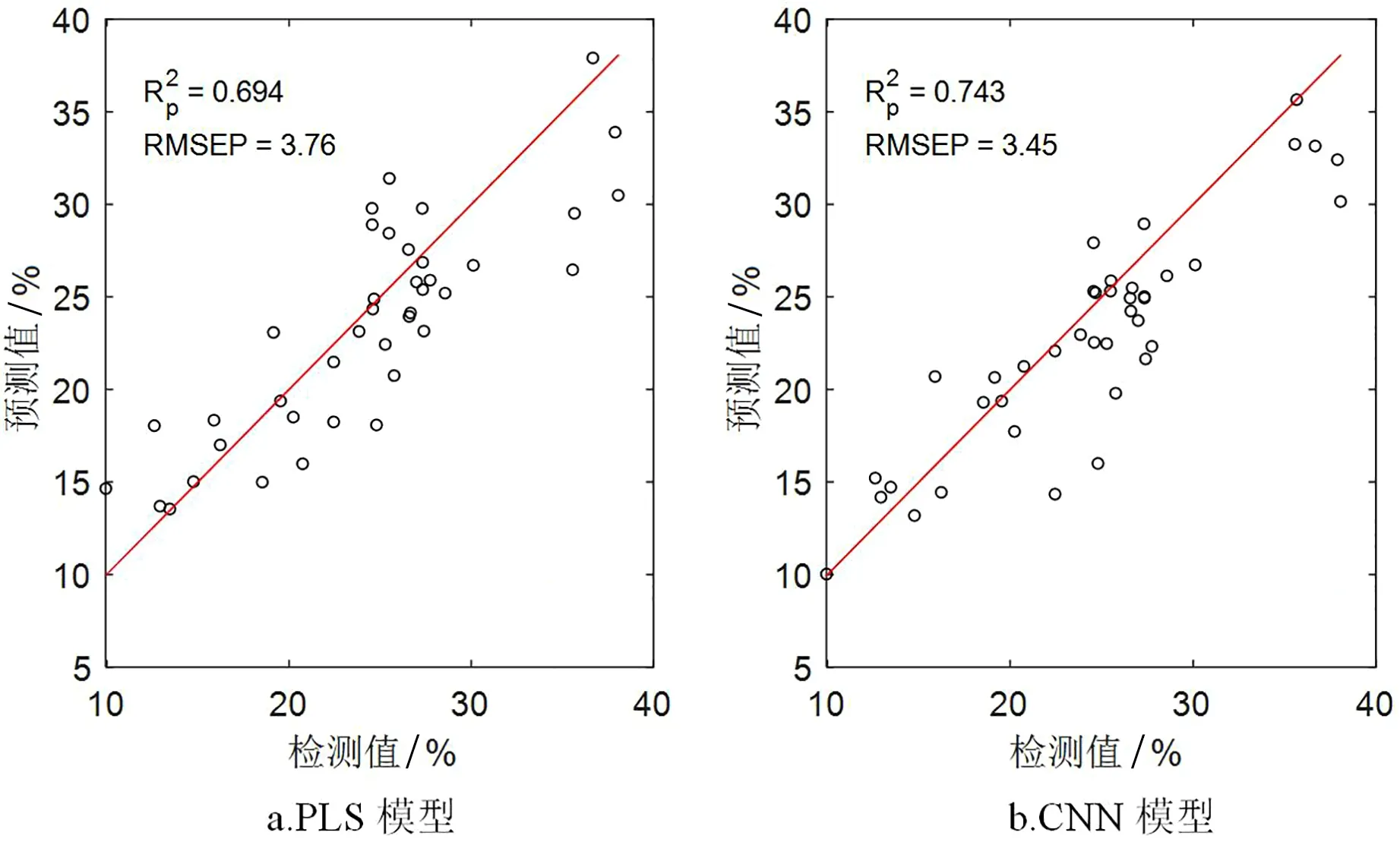

圖4 煙絲測試集預測散點圖

2.3 深度模型轉移分析

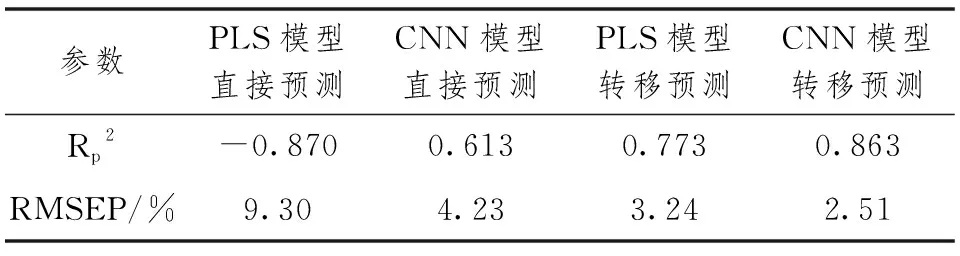

采用上節建立的煙粉PLS模型和CNN模型直接用于預測新儀器采集的煙絲光譜,預測的Rp2分別為-0.870和0.613、RMSEP值分別為9.30和4.23,結果見表4。這說明用煙粉模型直接預測煙絲光譜無法得到較好的結果。RMSEP的急劇增大是由于不同儀器、不同物理狀態之間的光譜有較大差異,導致模型不能通用。

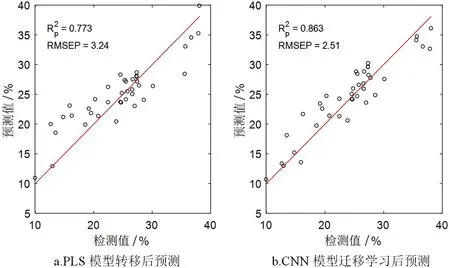

進一步采用模型轉移方法對煙粉PLS模型和CNN模型進行了轉移研究。由于沒有標準樣品,考慮使用無標樣方法——線性模型校正(LMC)[18]對煙絲光譜進行標準化,使之適合煙粉PLS模型的預測。通過深度模型轉移,將煙粉CNN網絡結構遷移到煙絲光譜的預測,預測集散點圖見圖5,可以注意到,2種模型轉移方法都能使RMSEP值顯著降低,Rp2顯著提高,并且深度學習模型的傳遞性能優于PLS模型。因此,只需要在新儀器上測量少量新樣品,通過深度模型轉移方法就可以恢復深度模型在新場景的預測能力。在許多情況下,用戶無法得到大量樣品,使用盡可能少的樣品可以減少實驗負擔以節省時間和成本。

隨著近紅外光譜技術在煙草行業的廣泛應用,在特定儀器上已經獲得了多年和多次實驗的大量數據,并且開發了有價值的模型。假設舊儀器損壞,無法獲得標準樣品數據,常規模型轉移方法無法使用[19]。在這種情況下,深度模型轉移就可發揮作用,只需要少量新數據就可以微調模型,校正儀器響應和物理狀態的全局和局部差異,使之適用于新場景的預測。因此,對深度模型進行轉移研究,具有較高的研究價值。

表4 煙絲光譜預測結果

圖5 煙絲測試集預測散點圖

3 結論

與傳統化學計量學多元校正模型一樣,深度學習模型直接用于預測新儀器/樣品狀態檢測的光譜無法得到滿意的結果。為了實現煙粉深度學習模型在多次檢測之間的通用,本文通過一種深度模型轉移策略,基于模型微調的概念,使用少量新儀器采集的煙絲樣品光譜,對已成功構建的煙粉深度學習模型的全連接層進行重新訓練,校正2次檢測光譜之間的差異,實現對深度模型的轉移。轉移學習后的模型能夠實現對煙絲總糖的有效預測,與煙絲直接建立的PLS和CNN模型相比,預測R2分別提高了24.4%和16.2%、RMSEP值分別降低了33.2%和27.2%。無標樣深度模型轉移方法能應用于源機設備無法再次使用的情況,具有較好的應用前景。