跨模態檢索技術研究綜述

徐文婉,周小平,王 佳

北京建筑大學 電氣與信息工程學院,北京 100044

進入大數據時代,數據化的信息涉及到電子商務、健康醫療、社交網絡、工業機械等多個領域。這些信息以不同的數據類型存儲,模態指的就是數據類型。現有研究的模態可以分為圖像[1-2]、文本[3-4]、語音[5]、3D圖像[6]、3D模型[7]、視頻[8]、時間[9]、空間位置[10]這幾種。以電子商務領域為例,多采用以輸入關鍵詞檢索商品標題的單模態檢索方式,該方法所得到的信息有限,而同一商品有文本和視頻等不同模態的信息,如圖1所示,這些信息并沒有充分利用。跨模態這一概念來源于人類的多器官感知[11]:多個器官感知通道提供對感知實物的不同特征印象并傳遞給大腦,以加深對實物的特征感知。跨模態檢索是指輸入的查詢數據和輸出的被查詢數據屬于不同模態的檢索方式。它比普通檢索得到的信息更為全面準確且真實,在海量數據中應用能提高信息利用率和檢索效率,具有十分重要的研究意義。

圖1 商品的文本視頻模態信息(來源:https://zhongpai.jd.com)Fig.1 Text-video modal information for commodity

由于不同特征空間的數據存在語義理解的差距,各個模態的數據具有多樣性[12],如何減小語義差距并保留數據的有效對比特征是跨模態檢索的關鍵問題。目前,跨模態檢索實現[13]的主要思路是:利用表示同一語義的異構數據構建不同模態間的對應關系,構建數學模型并進行優化求解,然后對各個模態的數據進行相似性對比,從而檢索到同一語義的不同模態信息。研究者主要采用不同的建模方法和相似性對比方法解決問題。本文系統整理了現有的跨模態檢索技術,對不同的跨模態相關技術研究概括分析。首先對跨模態檢索研究進行簡要概述;然后按照數據編碼類型分為實值表示和二進制表示,再根據技術不同分為:基于子空間學習、基于主題統計模型、基于深度學習、基于傳統哈希和基于深度哈希五種方法,并進行分析對比各類技術的特點;也為相關研究人員評估各類方法整理了最新的多模態相關數據集;最后總結了跨模態領域研究遇到的挑戰并指出未來的研究方向。

跨模態研究開展以來,其他研究者們也曾提供了各種分析思路:Chen等人[14]主要對圖像和文本兩種模態和基于深度學習的方法進行綜述。陳寧等人[15]圍繞公共子空間建模技術進行了分類及詳細介紹,具體分為基于傳統統計分析、基于深度學習和基于哈希學習三類技術。上述綜述研究針對跨模態檢索工作做了較好的總結和探討,圍繞不同的主要研究方法展開調研,而本研究的創新點可以概括為以下三個方面:(1)全面整理已有的研究工作,將以圖像文本為主流的模態擴展到其他更多模態的文獻研究;(2)在前人基礎上分析實值和二進制兩種表示下的跨模態檢索技術,包含以建模技術和相似性對比為主線的最新相關文獻研究;(3)總結最新的多模態數據集和面臨的挑戰,為相關的研究提供參考資料并為工程人員指出研究方向。

1 跨模態檢索研究概述

本章首先對跨模態檢索問題進行定義,然后采用文獻分析工具對跨模態檢索領域的相關文獻進行分析并總結概括研究現狀。

跨模態檢索問題主要圍繞不同模態間的語義如何減小相似度差距,增大非相似度差距進行研究。用數學公式表示跨模態檢索問題的定義可使其更加清晰,問題符號定義如表1所示。假設以X與Y表示文本和圖像兩種模態,其數據集定義為公式(1),包含該模態下n個數量的特征向量。由于不同模態之間數據無法直接比較,需要定義兩個模態X與Y的轉換函數如公式(2);數據轉換成相互對應的特征值后,將不同特征值的數據放在同一個空間Z;最后利用相似度函數計算特征數據之間相似度,例如X模態的數據映射到公共空間Z,相似度函數計算如公式(3)。

表1 問題符號定義Table 1 Question symbol definition

研究者們當前解決跨模態檢索問題有著各種各樣的技術方案。早期研究中主要是通過建立模型表示數據的對應關系。2003年Jeon等人[16]提出了跨媒體關聯模型(cross-media relevance models,CMRM)。它實際上利用圖像自動注釋來檢索圖像的方法,也屬于檢索內容直接關聯的跨模態檢索。2008年張鴻等人[17]提出跨模態關聯圖的概念,將不同模態的關系用關聯圖的概念表示,這種方法后來也被稱為圖正則化的方法。近年來,國內外跨模態檢索發表文獻數量逐年遞增,這表明越來越多的研究人員開始關注這一領域。

本研究重點對近五年的研究成果進行分析,采用Citespace軟件工具對跨模態領域的研究熱點進行可視化的系統分析。對該領域近5年發表數量較多的中英文文獻高頻關鍵詞進行聚類分析如圖2所示,總結分析了以下幾點:(1)哈希二進制編碼出現頻率排名第一,表明哈希編碼用于檢索的方法是目前研究熱點;(2)利用深度學習嵌入空間進行檢索的方法取得了顯著進展;(3)聯系上下文內容加深對模態場景的理解,說明基于主題場景分析的方法也占據了一席之地;(4)跨模態檢索研究的模態由圖像文本擴展到音頻等更多模態。

圖2 近年高頻關鍵詞聚類圖Fig.2 High frequency keyword clustering map in recent years

通過文獻調研與科學分析,系統梳理現有的重點文獻,緊緊結合研究熱點進行歸納分類。本研究按照數據表示編碼方式將跨模態檢索技術分為實值表示與二進制表示兩類,跨模態檢索技術分類如圖3所示。

圖3 跨模態檢索技術分類Fig.3 Classification of cross-modal retrieval techniques

2 跨模態檢索技術分析

本章對跨模態檢索技術進行分類及詳細介紹,其中實值表示學習中各種模態特征的共同表示都是沒有經過哈希轉換的值,具有相對方便的優點。二進制表示學習中各種模態特征表示為二進制,與實值表示相比具有存儲空間小、易于計算的優點,但二進制碼可能會產生信息丟失的問題,檢索精度相對較低。

2.1 實值表示

在實值表示學習中,為了解決不同模態數據無法直接比較的問題,本文主要將其分為三種方法:基于子空間學習的方法、基于主題統計模型的方法和基于深度學習方法。

2.1.1 基于子空間學習的方法

子空間學習法是跨模態檢索中一種直觀的方法,圖4以狗的檢索特征為例,說明了子空間特征學習框架圖。該方法從不同模態提取特征中后,利用一個公共的子空間將不同模態數據映射到同一空間,從而進行相似性度量。本小節介紹特征映射到公共子空間時所采用的不同算法,分為典型相關分析(canonical correlation analysis,CCA)及其相關方法、語義標簽方法和其他方法三類。

圖4 子空間特征學習框架Fig.4 Subspace feature learning framework

最經典的是Rasiwasia等人[18]提出的CCA算法,它根據空間向量關系模型計算子空間距離以解決線性問題。但它是一對一的兩層模型,沒有利用類信息,也找不到原變量之間的直接映射關系,不適用于學習非線性特征。為了適用于學習非線性特征,Hwang等人[19]提出核典型相關分析方法(kernel canonical correlation analysis,KCCA),它可以表示更復雜的相關性,提高算法性能,但它訓練速度慢,測試時要求成對數據且需要提前存儲訓練集。為解除所有數據必須成對的要求,Rasiwasia等人提出基于聚類[20](Cluster-CCA)的方法,但是它應用于大型數據集時計算量比較大,處理效率低,后續可結合深度學習方法不斷改進。為了得到更高級的語義信息,Shao等人[21]提出融合線性投影和非線性隱藏層的雙向訓練的ICCA(Improved-CCA),改善了控制傳統雙視圖的CCA,使得在有類似原始數據輸入時也有精細輸出。為了同時保證檢索效率和精度,Shu等人對ml-CCA[22]方法做出改進,提出可擴展多標簽典型相關分析[23](scalable multi-label-CCA)方法,不僅可以學習共同語義之間的相關性,還可以同時學習特征相關性以提高跨模態檢索精度。

除CCA外還有其他的方法,Tenenbaum等人[24]提出雙線性模型(bilinear model,BLM)方法,它具有廣泛的適用性但不能準確描述內在幾何關系或物理現象。Chen等人[25]提出偏最小二乘法(partial least squares,PLS),這種數學計算的回歸分析模型需要很大的計算量。后來這兩種方法研究得較少,另外一種重要的方法叫語義標簽法。Pereira等人[26]針對跨模態圖像文本檢索問題提出三種匹配方法:其中CM是一種基于無監督的跨模態關聯建模方法,SM是一種依賴于語義表示的監督方法,而語義相關匹配(semantic correlation matching,SCM)則綜合了它們的優點,同時考慮了相關特征向量與語義空間以改善檢索效果。2020年Xu等人[27]提出基于半監督圖正則化的語義一致性跨模態檢索方法(semantic consistency cross-modal retrieval,SCCMR),它將標簽的預測和投影矩陣的優化整合到統一的框架中,可以確保得到全局最優解。Zhang等人[28]提出廣義半監督結構化子空間學習方法(generalized semi-supervised structured subspace learning,GSS-SL),主要利用標簽空間作為鏈接對無標簽信息進行預測補充,從而保證檢索的準確度。Xu等人[29]提出共享子空間分離方法(private-shared subspaces separation,P3S),可排除不相關的背景圖像或文本中的錯句以提高標簽的質量,使得子空間學習可獲得更有效的公共表示。

在子空間學習方法中,CCA及其改進方法是最基礎的方法,現在常常被用作對比實驗方法。它是將不同模態的特征映射到特征空間,建立投影矩陣從而直接度量特征相似度,但該方法需要找到對應的特征關系,會有特征分辨力不足的問題,需要結合深度學習等技術進行改善。另一種語義標簽的方法主要是通過補充預測處理標簽,完善不同模態之間的信息相關性,提高同類不同模態間的信息不相關性。標簽信息越豐富它們的分辨力就會越強大,只是標簽的大量補充是一個費時費力的工作,因此標簽的補充預測會是未來研究的難點。

2.1.2 基于主題統計模型學習的方法

基于主題統計模型學習是另外一種通過建模來實現跨模態檢索的方法。主題指的是具有同一特征的抽象空間維度,主題模型是統計模型學習中最重要的一種。該方法利用隱藏的語義空間來發現數據中出現的抽象空間維度。將這些特征映射到一個公共語義空間來統計相關性,用于在一種模態中查找結果的條件概率,同時在另一種模態中查詢結果。主題模型的核心就是可以用公式(4)求解X和Y兩模態的主題聯合分布概率。

最初的主題模型方法是將隱狄利克雷分配(linear discriminant analysis,LDA)應用于多模態的聯合分布模型[30]。Wang等人[31]提出有監督的多模態相互主題強化建模技術(multi-modal mutual topic reinforcement modeling,M3R),利用一個聯合跨模態概率圖形模型,對各模態數據相關性進行分析,從而找到相同語義主題。Wu等人[32]提出具有主題約束的區域強化網絡模型(region reinforcement network with topic constraint,RRTC)來概括圖像的中心主題,從而約束原始圖像的偏差,然后考慮區域間關系和重新分配區域詞的相似性來推斷圖像和文本細粒度的對應關系。該方法彌補了主題概率法檢索不夠準確的缺點。

除了主題統計模型外,統計模型還包括馬爾可夫模型、馬爾可夫隨機場等。Jia等人[33]提出多模態文檔隨機場(Markov random field,MRF),通過定義馬爾可夫隨機變量之間的相似性對文本進行建模,找到內容相關概率,最終確定最接近的檢索結果。為了避免出現主題沖突的情況,Wu等人[34]提出一種跨模態在線低秩相似函數學習法(cross-modal online low-rank similarity,CMOLRS)。通過訓練數據三元組的相對相似性對跨模態關系進行建模,并將相對關系表述為凸鉸鏈損失,利用多級語義相關性減小了跨模態數據之間的內容分歧,保證檢索結果可靠性。

基于主題統計模型學習的方法能夠保留它特有的主題特征,保證檢索內容上最大的概率相關性,而且有可能發現有意義的潛在新情景。相較于子空間學習方法,基于概率的聯合特征學習可以消除原始空間中的冗余和噪聲問題,從而得到更完整、客觀的描述。概率估計的方法雖然對于一些整體主題的判別有著不錯的效果,但是它的準確度可能會不理想,而且該方法對存儲空間要求較大,處理龐大的數據要付出昂貴的計算成本。

2.1.3 基于深度學習的方法

上述兩種方法主要考慮的是模態之間的建模方法,從而得到特征的有效映射。然而深度學習網絡主要考慮的是對有效特征的提取,并加入一些新的訓練機制,提高模態間的不相關性和模態內的相關性,再進行相似性對比。對于提高高階語義的相關性,深度學習的跨模態檢索方法能夠處理更為龐大的真實數據集,得到了廣泛的應用。本小節介紹了具有代表性的深度網絡模型與相關算法、對抗性學習合成特征方法、知識遷移學習方法和多模態通用的跨模態檢索的方法。

從深度學習所采用神經網絡模型與相關算法的不同總結出以下幾種代表類方法。Xia等人[35]提出基于深度學習的深度典型相關分析方法(deep-CCA)訓練大規模數據,先求出兩個具有最大相關性視圖的投影向量,再通過多層堆疊的非線性變換來計算相似度,其效果明顯優于CCA方法。Feng等人[36]提出對應自動編碼器模型(correspondence autoencoder,Corr AE),關聯兩個相互對應的單峰自動編碼器來表示隱藏信息。隨后他又提出通信受限玻爾茲曼機[37],通過不同模態學習自編碼表示并最小化模態間相關學習誤差,不斷訓練使得模型不斷優化。經實驗驗證,這種兩兩對應的方法能夠發現新的屬性,對于跨模態檢索研究有著較大促進作用。Jiang等人[38]基于相似度理論對圖文進行檢索,使用局部二值模式(local binary pattern,LBP)作為圖像描述符,深度信念網絡(deep belief network,DBN)作為深度學習算法。該方法為跨模態檢索提供了新思路,但由于理論分析的難度較大,該方法較難實際應用。還有一種圖卷積神經網絡,可同時學習各個節點的特征與結構信息,比卷積神經網絡適應性更廣。Dong等人[39]提出基于圖卷積網絡(graph convolutional network,GCN),利用樣本與其鄰域之間的鄰接關系重構樣本表示并基于局部圖重構節點特征,將兩種模態的特征映射到公共空間中,從而獲取隱藏的高級語義信息并增強具有相同語義的樣本相似信息。但圖卷積網絡計算量比較大,難以處理新加入節點信息,這些問題還有待解決。

對抗性學習方法有著強大的區分能力,能夠很好地彌補異質差距以提高跨模態檢索效率,是深度學習中重要的方法之一。Peng等人[40]提出跨模態生成對抗網絡(cross-modal generative adversarial networks,CM-GAN),使用兩對生成器和鑒別器共同工作對模態內和模態間進行判別,最終生成具有高分辨性的通用表示。然而CM-GAN方法傾向于全局特征的描述,為此Kou等人[41]提出結合對象注意和對抗性學習的方法。其中對象注意模型用來生成高質量的圖像文本特征,反映更為豐富的語義,再加上生成對抗網絡用來生成高質量的特征,使得檢索效果有所改善。Shi等人[42]基于互補注意機制的特征提取來提高語義表示相關性,并在對抗式學習框架中訓練公共特征映射和模態分類,獲得了通用語義表示以減小模態間語義差距,其效果優于傳統的深度學習算法。CM-GAN方法在各個模態生成特征時具有不穩定性,可能會有錯誤的數據影響檢索效果。為此Xu等人[43]提出聯合特征合成與嵌入方法(joint feature synthesis and embedding,JFSE),采用了兩個改進的耦合GAN用于多模態特征合成,并將類嵌入作為特征級跨模態數據合成的輔助信息,有效地關聯每個模態的特征合成。

遷移學習是深度學習中的一種重要方法,常常會與對抗學習結合來解決跨模態檢索中的未知類問題。Huang等人[44]提出端到端兩個網絡結構的跨模態對抗混合傳輸網絡(modal-adversarial hybrid transfer network,MHTN),一端利用遷移學習將相關表示從單模態源域遷移到多模態目標域;另一端在公共表示空間構建對抗訓練機制進行語義學習,實現了多模態數據的有效檢索。為了保留原始數據的潛在結構以獲取更好的檢索效果,Zhen等人[45]提出深度多模態遷移學習方法(deep multimodal transfer learning,DMTL),由兩個多模態特定的神經網絡和一個聯合學習模塊組成,并采用映射到公共子空間的思想實現跨模態檢索。遷移學習方法從先前標記的類別源域中遷移知識,可以提高未標記的新類別目標域的檢索性能,然而不能有效處理新增加的模態,需要重復地訓練數據。

由于跨模態檢索的模態不斷增加,固定模態如圖像文本模態的研究并不能完全應用于其他模態,總需要重復訓練或重新設計網絡模型,無用工作較多且設計復雜,因此學者提出通用的跨模態檢索方法。Cao等人[46]提出混合表示學習(hybrid representation learning,HRL),由堆疊受限玻爾茲曼機(SRBM)提取每種模態表示,多模態深度信念網絡(DBN)提取模態互表示,以及使用包含聯合自動編碼器和三層前饋神經網絡的雙層網絡。該方法通過多模態推斷圖像的缺失信息以挖掘潛在圖像表示,而且采用堆疊雙峰自動編碼器可以獲得多種模態的最終共享表示。Hu等人[47]提出可擴展的深度多模態學習(scalable deep multi-modal learning,SDML)檢索方法,在預定義公共子空間分別為n個模態訓練獲得n個網絡,這是第一個提出將多模態數據分別投影到預定義的公共子空間的技術。

綜上所述,深度學習方法已經是大數據時代跨模態檢索的重要方法,在信息數量越多時檢索效果越好,且適用于圖像文本等更多模態的檢索。隨著深度學習網絡模型的不斷改進并與其他建模方法結合,能不斷地優化處理多模態數據和特征提取問題。對抗遷移學習方法可以檢索未知類數據,尤其是使用對抗學習可以生成相關特征以提高分辨能力,而且沒有對于模態的限制。另外,通用多模態表示技術如混合表示、多層表示的方法,能夠綜合不同技術的特點,只要設計好合理的網絡結構,就能在多種模態應用中取得很好的效果。本文認為,在未來研究中可以將深度學習的思想與各種建模方法融合,也可以利用GAN及其改進方法生成多模態特征以減小語義差距,還可以設計混合的多模態學習框架以適應多種模態的跨模態檢索。

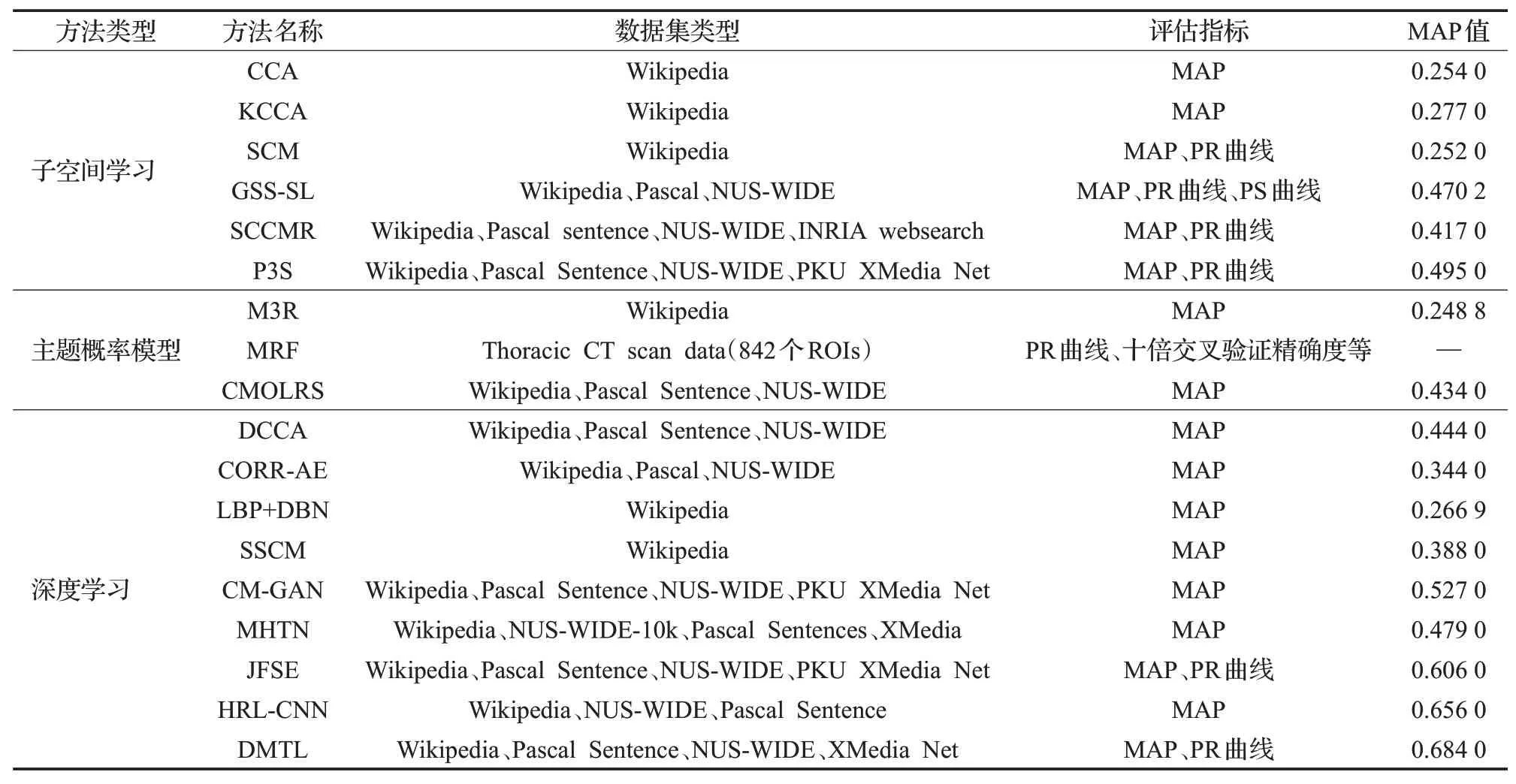

2.1.4 實值表示技術總結分析

實值表示方式可以包含不同的數據類型,能夠保留原始數據且滿足多種模態的檢索需求,但它需要大量的存儲空間,不能滿足高效的檢索要求。其中子空間模型與主題統計模型都是為實現跨模態檢索提供一個數據比較的模型,基于深度學習的方法是提供一種特征提取的有效手段。本研究選取了幾種實值表示技術,比較它們在Wikipedia數據集上應用的MAP值。如表2所示,可以看出P3S在基于子空間學習的方法中效果最好,CMOLRS在基于主題概率模型的方法中效果最好,DMTL方法的MAP值遠高于其他方法。

表2 實值表示方法數據集及評價指標對比Table 2 Comparison of real value representation method datasets and evaluation indexes

實值表示方法還可以在檢索精度和效率、多模態的相互表示上進一步優化。對于檢索精度的提升,上面提到了補充語義標簽等方法;對于檢索效率的提高,融合神經網絡模型與聯合學習的機制是可行的,該方法所呈現的檢索效果往往優于單一模型的檢索機制,不過融合模型太多會將簡單問題復雜化,在實際應用中需要衡量實用價值選擇適合的方法。

2.2 二進制表示

不同于實值表示的數據直接表示,二進制表示將數據轉換成另一種更短的存儲方式,能夠降低存儲成本。利用哈希算法學習轉換數據可以提高檢索效率,跨模態哈希有二進制碼和哈希函數兩大重點內容。跨模態哈希函數通常是在目標函數中使用額外的二進制約束,并利用迭代量化或離散優化算法來學習二進制代碼。本節按照二進制實現算法分為基于傳統哈希的方法和基于深度哈希的方法。傳統的哈希算法是針對任意長度的二進制值,映射為較短的固定長度的二進制值以節省存儲空間。深度的哈希算法不再限制二進制碼的長度,只要滿足在一定范圍就可進行計算。

2.2.1 基于傳統哈希的方法

傳統的哈希算法本質上是近似最近鄰搜索的優化問題,求解哈希函數最優解以更好地實現模態的相關表示。大部分哈希函數學習分為降維和量化兩個階段:降維是將信息從原始空間映射到低維空間表示,量化是將實際特征線性或非線性轉換為二進制的特征空間。

Yu等人[48]通過結合圖正則化學習哈希函數的無監督級聯哈希技術(unsupervised concatenation hash,UCH)進行降維,將原始特征投影到哈希碼中建模求解,該方法的MAP值遠高于CCA等傳統的方法。Yu等人[49]之后又提出利用多個視圖之間的互補信息來更好地學習哈希碼的學習框架(multi-view hash,MVH),為3D模型的跨模態檢索提供一種新思路。Shen等人[50]提出采用語義標簽關系來縮小模態差距的跨模態哈希監督子空間關系學習技術(subspace relation learning for cross-modal hash,SRLCH),將兩種模態的語義標簽映射到具有變換矩陣的子空間來減小相似度計算距離。Liu等人[51]提出矩陣三因子分解哈希框架(matrix trifactorization hash,MTFH),首次采用不同的哈希長度對異構數據進行編碼的方法,能在不完全成對關系的多模態數據以及任意的哈希長度編碼的場景下工作。它利用哈希函數學習特定于模態的哈希碼,同時學習兩個語義相關矩陣,以便對異構數據的不同哈希表示進行語義關聯,提升了檢索效果。

傳統哈希方法往往會放松離散約束,導致相對較高的計算成本和量化損失,故研究者們提出了各種離散優化的方法。Zheng等人[52]提出快速離散協作多模態哈希方法(fast discrete collaborative multi-modal hash,FDCMH)同時具有高效計算和存儲的性能。首先采用高效的協作多模態映射模塊,保證多模態特征的互補性和語義相關性,此外還有一個非對稱哈希學習模塊,在公共潛在空間和哈希碼之間建立連接,將更多的標簽信息嵌入到二進制代碼中以增強對語義哈希碼的識別能力。Wang等人[53]提出有監督的跨模態哈希(scalable asymmetric discrete cross-modal hash,BATCH)方法也采用了非對稱哈希模塊。和FDCMH的區別在于:它利用矩陣分解來學習標簽和不同模態的公共潛在空間以便于關聯不同模態二進制碼。在離散優化模塊,它引入了量化最小化項和正交約束大大減少了量化誤差和冗余。Liu等人[54]提出一種有監督的潛在語義增強離散哈希,也是利用矩陣分解獲得不同模態的個體潛在語義表示,采用離散優化策略以減少量化損失。該方法是目前處理圖像到文本檢索任務時準確性最高的跨模態哈希方法。

基于傳統哈希的跨模態檢索方法依據樣本的二進制編碼,能夠優化復雜計算和減小存儲空間,已成為目前較為熱門的方法。但由于哈希算法會產生量化損失影響信息準確度,離散優化問題會成為未來研究的關鍵。本文總結了提高效率的協作多模態映射模塊、提高識別能力的非對稱哈希模塊來減小量化損失,為哈希算法的探索提供了新思路。

2.2.2 基于深度哈希的方法

基于深度哈希的方法融合了深度學習和哈希算法的優點,不僅具有強大的特征學習能力,其高效的檢索性能遠遠超過傳統哈希算法,近年來已成為跨模態檢索研究的熱門方法。本小節對近年來主要的深度哈希算法進行分析,最后對現有的方法進行總結。

為提高檢索效率,Cao等人[55]提出深度視覺語義哈希模型(deep visual semantic hash,DVSH),文中第一次提出端到端網絡框架,融合了多模態嵌入和跨模態哈希。多模態嵌入的一端是視覺語義融合網絡,以圖像卷積神經網絡和學習文本的遞歸神經網絡(long shortterm memory,LSTM)緊密關聯組成;另一端是兩個特定模態的哈希網絡,用于學習特定哈希函數便于對未知的數據編碼。另外,Deng等人[56]提出基于三元組的深度哈希網絡(triplet-based deep hash,TDH),使用三元組標簽能靈活捕捉更高級的語義信息并容易生成各種約束,再由圖正則化和模態內外間雙重視圖生成三重損失函數,保持哈希編碼之間原始語義的相似性,從而提升檢索精度。

基于注意力機制方法能夠準確定位到主要信息,減小無用信息的干擾,在深度哈希方法里廣泛應用。Zhang等人[57]提出具有注意力機制的深度對抗性哈希(attention-aware deep adversarial hash,AADAH)用于增加內容特征相似性的測量,證明了注意力機制針對多媒體的信息片段有強大的識別能力。吳吉祥等人[58]提出加入多模態注意力機制的跨模態哈希網絡(hash network based on multi-modal attention mechanism,HX-MAN),將注意力機制引入到端到端的深度跨模態哈希技術[59](deep cross-model hash,DCMH)方法中來提取不同模態的關鍵信息,能夠準確地檢索圖像和文本模態的局部細粒度特征,明顯改善了檢索精度。Wang等人[60]提出自約束和基于注意力的哈希網絡(selfconstraining and attention-based hash,SCAHN),將早期和后期的標簽約束及其融合特征集成到哈希表示和哈希函數學習中,提升了跨模態檢索的精度。

離散優化是解決深度哈希和傳統哈希中量化損失問題的有效方法。Xu等人[61]首先提出離散跨模態哈希(discrete cross-modal hash,DCH),它學習特定模態的哈希函數以生成統一的二進制代碼,然后采用離散約束求二進制解。之后他又提出離散潛在語義哈希[62](discrete latent semantic hash,DLSH),使用離散優化算法直接學習二進制碼,再次減小量化損失。為了解決同時學習二進制代碼和哈希函數優化的復雜性問題,Zhang等人[63]提出了一種兩階段監督離散哈希(two-stage supervised discrete hash,TSDH)方法。它將各模態生成潛在標簽后直接學習哈希函數,以增強二進制碼的可辨別性,分為兩階段處理可以更快進行優化從而提升檢索效率。

零樣本的跨模態檢索具備可擴展性,它可以檢索出不同模態的新類且不需要每次對新類重復訓練。Liu等人[64]提出跨模態零樣本哈希方法(cross-modal zeroshot hash,CZSH),零樣本哈希學習使用類別屬性來尋找語義嵌入空間,使用已知類中的樣本訓練的哈希模型對未知類的樣本進行擴展,然而要在大量標記數據的情況下才會有好的檢索效果。Xu等人[65]提出具有自我監督的三元對抗網絡(ternary adversarial networks with self-supervision,TANSS)。它由兩個特定模態形成端到端的網絡結構,分別是兩個語義學習子網絡和自監督語義學習子網絡,并在整個網絡上應用對抗式學習。與之前語義標簽方法不同,該方法提出新的自監督機制學習新類標簽,有助于有效地迭代參數優化。

另外,跨模態深度哈希學習中還有些其他的方法。Zhang等人[66]提出混合跨模態相似性學習模型(hybrid cross-modal similarity learning,HCMSL),首先從標記和未標記的跨模態對中捕獲足夠的語義信息,在具有相同分類標簽的模態內配對;然后將兩個連體CNN模型用于相同模態的樣本中學習模態內相似性。該方法可以融合模態內外相似性,從而減小模態差距。Li等人[67]提出多層表示學習方法(multi-level similarity learning,MLSL),首先采用多標簽卷積神經網絡框架對語義層信息進行編碼,再應用圖形匹配建模結構層對應關系,最后結合上下文對應不同模態細節并采用三元組損失來減少跨模態差異,最終改善圖像文本檢索任務。Li等人[68]提出圖像文本雙向學習網絡(bidirectional learning network,BLN),用一種多層監督網絡來學習生成表示的跨模態相關性,其雙向學習中的雙向交叉損失函數能有效減少高級語義信息的丟失。這些混合模型、多層表示、雙向學習方法的思想可以應用于多模態,能有效減小模態差異。

本小節總結分析了不同的網絡模型以提高檢索效率和精度,如端到端網絡模型、三元組標簽哈希模型、基于注意力機制的哈希網絡,還有解決量化損失問題的離散優化方法,解決未知類問題的具有可擴展性的零樣本跨模態檢索方法和其他綜合類方法。基于深度哈希方法的研究主要是通過改善模型和優化算法來尋找更佳的跨模態檢索技術,目前仍然具有很大的發展空間。隨著深度學習技術的不斷優化和哈希算法的不斷改進,在未來的研究中可以選擇更適合的模型與算法融合以提高信息利用率和檢索效率。

2.2.3 二進制表示技術總結分析

二進制表示技術的跨模態檢索本質上是一種降維量化的方法。它的優勢在于能夠節省存儲空間,提高檢索效率,得到了廣泛應用。注意力機制與對抗性學習的方法也大大提高了采用二進制方法的效率和精度。另外多模態的擴展問題也因零樣本跨模態檢索有了新突破。但降維會破壞數據原始結構,且哈希算法是不可逆的,可能會產生過擬合問題。它還存在離散約束問題,對此在傳統哈希和深度哈希中都提到了從算法和哈希函數學習進行離散優化的方法。如表3所示,本文整理了各種二進制表示技術的數據集和評價指標,并分析了方法的特點,以便于后續研究者使用。

表3 二進制表示方法數據集及評價指標對比Table 3 Comparison of binary representation method datasets and evaluation indexes

表4總結了所有的跨模態檢索技術并將其分為兩類表示技術的不同類型方法,從具體思路、優勢、局限性和適用場景展開對比分析。實值表示保留原始數據的結構,二進制表示對數據進行哈希轉換,可以提高檢索效率,但同時會破壞數據結構。其中子空間學習與主題概率學習模型在處理特定場景問題時具有一定優勢。深度哈希方法或許是未來跨模態檢索技術的研究熱點,它可以融合新的深度網絡模型和先進的哈希算法,能夠處理復雜的問題。其他的方法也同樣重要,深度哈希技術的發展也離不開對于深度學習方法與哈希算法的進一步深入研究。

表4 跨模態檢索不同表示方法分析Table 4 Analysis of different representation methods for cross-modal retrieval

3 數據集及評價指標

3.1 數據集

本節對常用的多模態數據集進行總結并分析,如表5所示。

表5 數據集統計表Table 5 Dataset statistics table

(1)Wikipedia[18]:由一個文檔語料庫和相關的文本和圖像對組成,分為10個語義類。維基百科將每篇文章分為29個概念,最終的語料庫有2 866份文件。

(2)WIKI-CMR[69]:數據主要集中在地理、人文、自然、文化和歷史領域,包含圖像、段落、超鏈接類別標簽共74 961個文檔。文檔分為11個不同的語義類。圖像使用8種類型的特征表示,包括密集篩選、Gist、PHOG、LBP和其他特征,文本使用TF-IDF表示。

(3)NUS-WIDE[70]:數據類似于真實世界的網絡圖像。包括81個類別的約27萬幅圖像以及5 018個相關標簽,共6種類型的低層圖像特征。

(4)Pascal VOC[71]:其名稱概念為模式分析、統計建模、計算學習和視覺對象。它包含帶注釋的消費者圖片,由9 963幅圖像和24 640個注釋對象組成,分為20個不同類別。注釋中提到的實體包括類、邊界框、視圖、截斷實體和困難實體。

(5)Flickr 30k[72]:Flickr 30k是Flickr 8k數據集的擴展,其包含31 783張日常圖像與158 915個相關字幕。這兩個數據集都來自Flickr網站,數據主要在某些動作的人或動物(以狗為主),可用于圖像和長文本。

(6)MS COCO[73]:由總計328 000張圖像和250 000個標記實例的日常場景圖片組成,共91個不同的類別,每個圖片有5句對應的注釋,注釋分為標記圖像中存在的概念、定位和標記概念的所有實例、每個對象實例的分割共三種。

(7)PKU XMedia[74]:數據由5 000個文本、5 000個圖像、500個視頻、1 000個音頻片段和500個3D模型組成,共20個類別,每個類別有600個媒體實例。數據集被隨機分成包含9 600個對象的訓練集和包含2 400個媒體對象的測試集。

(8)PKU XMedia Net[13]:數據有200個類別,分為5種模態類型,文件格式分別為txt、jpg、avi、wav和obj,其數據量依次為40 000、40 000、10 000、10 000、2 000。數據集分成81 600個媒體對象的訓練集和2個測試集,以4∶1切分數據集與訓練集。

(9)M5Product[75]:該數據集包含600萬個多模態樣本、分為5種模態類型。具有100萬家商戶針對電子商品的粗粒度和細粒度注釋,600萬個類別注釋,包含6 000多個類別、5 000個屬性和2 400萬個值,比具有相似模態數量的最大公開可用數據集大500個。

3.2 評價指標

本研究的評價指標采用廣泛使用的性能評估標準平均精度(mean average precision,MAP)。MAP度量綜合考慮了排序信息和精確率。精確率往往反映檢索的整體效果,即所有返回樣本中正確相關的樣本所占的比例。理想的情況是檢索結果排序越靠前的樣本與查詢樣本的相關性越好,平均準確率(AP)可以更好地反映檢索的效果,定義如公式(5),其中N是檢索集中相關實例的數量,P(r)表示前r個檢索實例的精度。平均準確率平均值定義如公式(6):

另外,采用其他評價指標,如精度召回(precisionrecall,PR)曲線表示精度和召回之間的關系,精度是結果相關性的度量,而召回是實際返回多少相關性結果的度量;采用前N個精度曲線(TopN-precision)反映精度隨檢索實例數量變化的狀態。它們的值越大表明性能越好。對于跨模態檢索中的圖像文本模態檢索,Wikipedia數據集通常用MAP來評估算法性能,而MSCOCO、Flickr30k數據集還會用在前K個結果中檢索到的正確圖像或文本的百分比(Recall@K,R@K)來評估算法性能。

4 結論與挑戰

本文對跨模態檢索技術進行綜述,針對如何減小語義差距并進行有效相似度對比的問題給出了解決方案。文中對實值和二進制表示中具有代表性的技術方法進行分類研究討論,包括子空間學習、主題統計模型、深度學習、傳統哈希和深度哈希的五類方法。這些跨模態檢索技術可以從海量信息中快速準確地找到最有價值的數據類型,從而提高信息利用率和檢索效率,具有重要的實際意義。

本文根據跨模態檢索技術發展現狀,列出以下幾點跨模態檢索面臨的挑戰,也是未來研究的重要方向。

(1)擴展模態范圍。不同的應用場景需要選擇不同的模態數據,而固定的模態數據并不能完全應用于其他模態。未來可以利用混合表示模型、多模態學習模型等方法擴展各模態范圍,提高跨模態方法的通用性。

(2)精細化模態細粒度。當前基于子空間和主題概率模型的方法可以提取顯性特征進行相似性比較,但仍存在隱藏語義特征提取不完整的問題。通過對語義標簽的進一步補充預測或借鑒零樣本檢索探尋未知類可以找到更精確的語義特征,從而精細化模態細粒度的分類。

(3)提升檢索效率。檢索效率的提升包含了檢索準確度和檢索速度兩部分。目前的跨模態哈希方法已經在檢索速度上取得了一定進展,但對哈希檢索算法的信息丟失問題,還要繼續進行離散優化。對于檢索精度的提升,為滿足更高準確度的檢索要求還可以繼續改進損失函數與哈希函數。