基于MS-PLNet和高光譜圖像的綠豆葉斑病病級分類

余驥遠, 高尚兵, 李 潔, 陳 新, 李士叢, 張浩淼, 袁星星, 唐 琪

(1.淮陰工學院,江蘇淮安 223001; 2.江蘇省農業科學院經濟作物研究所,江蘇南京 210014)

針對目前綠豆葉部病害分類研究較少的現狀,本研究以國內外其他農作物葉部病害的分類案例為基礎展開對綠豆葉部病害的分類研究。Lowe等利用高光譜圖像分析技術對植物病害和脅迫早期發作進行分類與檢測[5]。呂夢棋等提出一種改進的ResNet模型對玉米種子進行分類,對大、中、小種子的識別率分別達到96.4%、93.5%、92.3%[6]。王美華等改進了注意力CBAM模塊,提高了模型的分類準確率[7]。黃英來等采用改進殘差網絡對玉米葉片病害進行分類,提高了玉米葉片病害圖像分類準確率[8]。閆建偉等利用改進的RetinaNet模型對刺梨果實進行識別,平均識別率為94.86%[9]。趙志焱等通過研究玉露香梨葉蟲害圖像,提出一種自動識別的TACNN網絡,取得了81.18%的分類準確率[10]。宋余慶等提出了多層次增強高效空間金字塔(extremely efficient spatial pyramid,簡稱EESP)卷積深度學習模型,在植物病蟲害圖像尺寸不同的情況下達到88.4%的分類準確率[11]。Gao等提出一種雙分支、高效、通道注意力(DECA)的作物病害識別模型,在公開數據集PlantVillage 上得到了99.74%的疾病識別準確率[12]。尚靜等使用高光譜成像儀對獼猴桃成熟度進行無損檢測[13]。謝鵬堯等利用Mask-RCNN模型對水稻冠層進行檢測,檢測準確率達到94.30%[14]。Hussain等使用EfficientNetV2模型對豆蔻病害進行檢測,病害檢測準確率為98.26%[15]。Bhujel等通過結合不同的注意力模塊設計的輕量級卷積神經網絡對番茄葉病進行分類,分類準確率達到99.69%[16]。劉慶飛等提出一種基于深度可分離卷積的逐像素分類方法,實現作物、雜草和土壤的逐像素分類,平均準確率為94.99%[17]。閆壯壯等利用VGG16卷積神經網絡模型對大豆豆莢進行識別,準確率可以達到98.41%[18]。

雖然使用卷積神經網絡在農作物葉部病害分類方面已經取得了豐富的成果,但大多數情況下由于每種農作物病害機理不同,因此并不能直接使用已有的其他農作物的葉片分類方法。本研究以綠豆葉片高光譜圖像為研究對象,研究有關綠豆葉斑病的分類問題,提出了一種基于MS-PLNet的綠豆葉斑病分類方法,對5種不同葉斑病抗性等級的葉斑病圖像進行分類,在保證本研究設計的MS-PLNet具有較小參數量的前提下,分類平均準確率達到97.4%。

1 圖像采集與預處理

1.1 圖像來源

于2020年4—6月在江蘇省農業科學研究院開展相關試驗,挑選顆粒飽滿,相似大小的綠豆種子備用,抗葉斑病精準鑒定在具備良好的試驗室環境的抗病材料室中進行。試驗的材料采取隨機排列的方法,每份材料種植在10 cm×10 cm的花盆中,每個花盆種4株苗,一共種植12株。每10份材料設置1組已知抗病或者感病材料進行對照,常用的對照材料為V1197(感)、V4718(抗),在實驗中如果鑒定出植株出現抗、感自交系統生長排異的情況,就在原有對照試驗組的情況下,添加適合試驗環境并具有穩定抗感性的新對照組材料。

先把存儲在實驗室的致病力較強的變灰尾孢菌株置于V8培養基,然后將培養基放入28°C培養箱中約7 d,菌種活化后,將其接種在新的V8培養基上進行病原體大量擴繁,約7~10 d菌絲布滿整個平板。在材料室接種的當天,繼續使用直徑為5 mm的無菌穿孔器在菌種和菌落的生長邊緣打孔,以更好地接種。在接種期間,在綠豆的第1組復葉展開后,收集完全展開的復葉,用水洗滌未折疊的復葉并放在吸水紙上,將吸水紙放入盒子中,然后在待接種復葉上使用刀片造成4 mm的小傷口并繼續接種5 mm的菌餅,并將接種盒敷上保鮮膜。在25 ℃條件下保持黑暗36 h后,再使用與上述室溫和光周期一致的條件使葉子發病。1個品種做3個重復試驗和1個對照試驗,每個重復試驗采用1組復葉進行,對照為不接菌葉片。接種7 d后進行調查,檢測病斑的大小,根據斑點的大小,確定綠豆葉的葉斑病抗性水平,即高抗病性、抗病性、中抗病性、中感病性、感病性和高感病性,以上抗性類型分別標記為HR、R、MR、MS、S、HS等6種,由于HS型的葉片在本實驗中基本不發生,故在下文的綠豆葉斑病分類中只采用HR、R、MR、MS、S等5種葉片。

使用單反相機(型號:Canon EOS 550D;光圈值:f/5;曝光時間:0.5 s;ISO速度:ISO-200;焦距:45 mm;測光模式:圖案;閃光燈模式:無閃光,強制)從相同角度獲取實驗室培養的所有綠豆葉片圖像。共采集到綠豆葉片圖像1 000幅。部分圖像如圖1所示。

神經網絡的形式是單隱層的BP網絡。輸入層設有200個PE,它們輸入采集的加速度幅值譜值,輸出層的3個PE代表建筑各層層間柱子構件,其活性值取在0~1之間,0代表完全破壞,1代表無損壞,中間的數值代表以構件剛度降低百分數表達的損壞程度。

1.2 數據預處理

1.2.1 綠豆葉片高光譜圖像轉化 使用Specim高光譜成像儀獲取綠豆葉片高光譜圖像,該成像儀由取景器攝像機、聚焦環、聚焦攝像機組成。首先將單反相機拍攝的RGB圖像傳入IQ Studio,然后將IQ Studio處理后的圖像導入Specim, 獲取本研究使用的高光譜圖像,部分高光譜數據如圖2所示。

1.2.2 圖像裁剪 由于本試驗中進行圖像分類是對單個圖片中的單個葉片進行抗性分類,然而轉換的高光譜圖像中包括很多葉片。因此首先需要對圖像進行裁剪,將圖像中聚集在一起的多個葉片分割為便于觀察的單個葉片。首先使用LabelImg標注圖像,相同抗性類別的綠豆葉片圖像標注為同一類別,然后導出XML標注文件并使用python進行原圖裁剪和分辨率調整。經過裁剪的不同抗性綠豆葉片圖像如圖3所示。

1.2.3 數據增強 在圖像分類任務中,如果用來訓練模型的數據越多,通常訓練出來的模型精度也會越高,魯棒性和泛化性也會越強,數據增強是深度學習中常用的數據擴充方法[19]。本研究使用上下翻轉、左右翻轉、隨機對比度變換,最后進行歸一化操作[20]。在模型測試的時候進行雙線性插值和歸一化操作來保證測試結果的穩定性[21]。經過處理后的部分圖像如圖4所示。

2 搭建MS-PLNet圖像分類模型

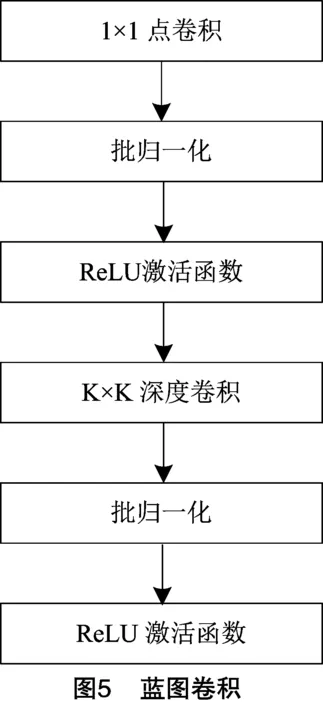

2.1 藍圖卷積

與深度可分離卷積的不同之處在于,深度可分離卷積首先逐個通道卷積,然后將深度方向上的特征圖加權在一起,而藍圖卷積(blueprint separable convolution)如圖5所示,先對深度方向上的特征圖加權,然后再進行卷積[22]。

藍圖卷積參數量大小為:

PBS=K×K×N+C×N。

(1)

藍圖可分離卷積計算量大小為:

FBS=K×K×N×H×W+C×H×W。

(2)

式中:N和C的含義和深度可分離卷積相反,N為輸入特征圖通道數,C為卷積核數量或者輸出特征圖通道數。

深度可分離卷積隱式地假設了一個用于所有內核的三維藍圖,而藍圖卷積則是依賴于每個內核的單獨二維藍圖。研究表明,單個內核的內部相關性有更大的潛力進行有效分離。

2.2 SE模塊

卷積神經網絡中的注意力機制(attention mechanism)分為軟注意力(soft-attention)和強注意力(hard-attention)[23]。本研究選擇基于通道注意力的壓縮和激活模塊(squeeze-and-excitation block)重新組合特征[24]。

函數 U 首先執行擠壓運算,該運算將特征映射集成到空間維度上以生成通道描述符。然后將生成的通道描述符嵌入到通道中,幫助網絡在較低層利用來自全局感受野的有用信息。然后執行激活操作,通過基于通道間依賴性的自門控機制確定通道間依賴的程度。當2次操作完成后,重新加權的特征圖作為SE模塊的輸出進入到后續層中參與訓練,如圖6所示,其中AvgPooling表示全局平均池化,FC1和FC2表示特征圖,ReLU和Sigmoid表示激活函數。

卷積過程可以表示為:

(3)

式中:uc表示一個通道輸出的特征圖;vc表示卷積過程;X表示輸入和輸出的所有通道特征圖,其中輸入特征圖X∈RH×W×C,輸出特征圖X∈UH×W×C,H、W、C分別表示特征圖的高和寬以及通道數。

2.3 分類流程與MS-PLNet網絡結構

本研究基于卷積神經網絡對綠豆葉斑病進行分類,首先加載綠豆葉斑病數據集,對該數據集進行數據預處理,然后將處理后的圖像送入本研究構建的MS-PLNet模型進行訓練,最后通過Softmax函數對獲取的特征進行分類。

2.3.1 MS-PLNet網絡結構 構建MS-PLNet葉斑病識別網絡,如圖7所示,總共包括了3個分支的特征提取模塊、一個SE Block特征融合模塊和分類器模塊。首先將高光譜圖像輸入特征提取模塊,然后構建3個尺度的特征提取模塊,特征提取模塊使用普通卷積和藍圖卷積搭建,在搭建過程中每個尺度的特征提取模塊中使用3步藍圖卷積模塊,其中第1步藍圖卷積用來增加通道數,第2步藍圖卷積用來減少通道數,第3步藍圖卷積用來增加通道數,最后將3個尺度的特征提取模塊計算得到的特征圖輸入到SE Block通道注意力模塊。在獲得特征融合的特征圖后,通過由全局平均池化層和全連接層組成的分類器進行綠豆葉斑病的分類。

在MS-PLNet網絡搭建的過程中使用的多尺度特征(multi-scale feature)能改善圖像分類的效果,本研究使用的是多尺度特征提取中典型的特征金字塔結構[25]。從圖像的每一層中提取不同比例的特征,得到特征圖,通過逐層降低分辨率和下采樣,在達到卷積停止狀態后才停止采樣。通過不斷的下采樣操作,相應的圖像越小,分辨率越低。

在特征提取階段,第1個分支經過上采樣后輸入圖像為256像素×256像素,特征提取模塊一共有18層,包括16個卷積層、2個反卷積層[26]。其中包括5個由1×1的點卷積和7×7的組卷積構成的藍圖卷積,每個藍圖卷積的輸入通道數和輸出通道數均不同。第2個分支輸入圖像為128像素×128像素,特征提取模塊一共有17層,包括15個卷積層,2個反卷積層,其中包括5個由1×1的點卷積和5×5的組卷積構成的藍圖卷積。最后一個分支經過下采樣后輸入圖像為64像素×64像素,特征提取模塊一共20層,包括16個卷積層、3個反卷積層、1個最大池化層,其中包括4個由1×1的點卷積和3×3的組卷積構成的藍圖卷積。搭建的MS-PLNet網絡的具體參數如表1所示。

表1 MS-PLNet特征提取模塊參數

3 結果與分析

3.1 算法運行環境

本研究進行綠豆葉斑病圖像分類采用的算法運行平臺為深度學習服務器,配置為Intel? Xeon? Silver 4210R CPU @ 2.40 GHz、顯卡Quadro RTX 4000、內存DDR4 8G。使用Xshell 7下的Pytorch 1.10深度學習框架和CUDA11.3計算架構。

3.2 訓練過程與結果

采用Pytorch官方權重參數,結合本研究的綠豆葉斑病具體分類要求,調整MS-PLNet模型的訓練參數。具體的參數設置如表2所示。

表2 訓練參數

將5個抗性類型的綠豆葉斑病類別每個類別的2 000張葉斑病圖像輸入MS-PLNet模型訓練,并且在訓練過程中通過卷積、池化和反向傳播不斷更新MS-PLNet模型的權重,多次迭代后,使得搭建的卷積神經網絡誤差趨近于零、準確率達到擬合,得到權重最優的模型。另外采用8:2的比例去劃分訓練集和驗證集,其中8 000張圖片被用于訓練,每個抗性類別分別占1 600張;2 000張圖片被用于驗證,每個抗性類別分別占400張。為與本研究所提出的圖像分類方法進行比較,在所有試驗參數設置相同的情況下,分別對比了使用瓶頸結構為主搭建的輕量級模型MobileNet-V2、MobileNet-V3,使用MBConv結構為主搭建的EfficientNet-B0,使用SandGlass模塊為主搭建的MobileNeXt[27-30],以及和沒有使用深度可分離卷積思想搭建的其他深度卷積神經網絡模型ResNet50、VGG16、DenseNet121進行了廣泛的比較[31-33]。

訓練結果如表3所示,給出5種抗性類別下的綠豆葉斑病圖像在以上模型和本研究搭建的 MS-PLNet 模型上的驗證準確率、訓練損失值和模型訓練時間。表4給出了所有模型的計算量、模型大小、模型參數數量以及模型深度。

由表3可知,與其他先進方法相比,本研究所提出的MS-PLNet方法達到了最好的訓練結果。經過300個迭代和1 000個迭代的訓練,所提出的方法分別實現了96.8%、98.4%的驗證準確率,而且訓練1 000次后損失值已經降到了0.052。另外,也可以看出MS-PLNet訓練300次和訓練1 000次所花費的時間遠遠低于其他模型。MobileNet-V2訓練300次后驗證準確率為96.6%,僅比MS-PLNet低0.2百分點,但是比MS-PLNet要多花費近154%的訓練時間;EfficientNet-B0訓練1 000次后驗證準確率達到98.3%,僅比MS-PLNet低0.1百分點,但是卻比MS-PLNet要多花費近127%的訓練時間。

圖8為MS-PLNet訓練300次和訓練1 000次的驗證準確率圖和訓練損失圖。可以看到,隨著訓練次數的不斷增加,模型的驗證集準確率在不斷上升,訓練集損失在不斷下降,當訓練到第300次的時候,不管是準確率還是損失都沒有到達擬合點,在第1 000次訓練的時候,模型仍然還有上升的空間,但已經擬合。從圖8還可以看到,訓練過程中,曲線基本上不表現噪聲,整個上升和下降的過程總體上非常平滑,這也證明本研究搭建的MS-PLNet卷積神經網絡模型具有較好的魯棒性,非常適合本試驗中提供的綠豆葉斑病高光譜圖片的分類。

由表3、表4可知,本研究提出的MS-PLNet在綜合考慮了模型大小、參數數量和計算量開銷的前提下,優于其他先進方法的性能。本研究的MS-PLNet模型計算量僅僅比MobileNet-V2大0.07 GMac,比MobileNet-V3大0.31 GMac,能夠高效地利用內存空間和GPU資源,提高了算法的運算效率。

表3 模型性能對比

表4 模型大小與計算速度

3.3 評價指標

考慮到具體分類過程中準確識別和錯誤識別的統計數據,本研究MS-PLNet方法的性能以及本研究中討論的其他最先進的方法是用不同的指標來衡量的。使用分類準確率(Accuracy)、精度(Precision)、召回率(Recall)和F1得分(F1-Score)來對MS-PLNet方法的圖像分類效果進行評價。其中,Accuracy是在全部預測樣本中正確預測的樣本所占的比例;Precision是在全部陽性預測樣本中,正確預測的樣本所占的比例;Recall是正確識別的陽性樣本在所有真陽性樣本中所占的比例;F1-Score同時考慮了假陰性和假陽性。更具體地說,評價指標使用(4)~(7)進行計算。

(4)

(5)

(6)

(7)

式中:TP(真陽性)為正確分類的陽性樣本數量;FN(假陰性)為分類錯誤的陽性樣本數量;FP(假陽性)為被錯誤分類為陽性類別的陰性樣本數量;TN(真陰性)為準確分類的負數樣本數量。

3.4 綠豆葉斑病分類結果

由表5可知5種抗性類型的綠豆葉片在本研究搭建的MS-PLNet模型上面的分類準確率、分類精度、召回率和F1-分數等分類評價指標結果,其中每個抗性類別的圖片選擇200張,一共使用1 000張圖片進行測試。所提方法區分了5種不同的綠豆葉斑病抗性類型,并達到了97.4%的平均準確率、95.0%的平均分類精度、99.9%的平均召回率和97.4%的平均F1-分數,能夠有效地對綠豆葉部病害進行分類。

表5 不同綠豆葉片的分類結果

4 結論與討論

對本研究MS-PLNet方法所得結果的可靠性解釋是注意力機制將基于位置的柔性注意力機制集成到模型中,這增加了模型提取綠豆葉斑病圖像中微小病變特征的能力。MS-PLNet采用多尺度特征提取能夠提取到綠豆葉片不同尺度的更加豐富的病斑特征。另外,在模型訓練中應用了三階段的藍圖卷積,使模型獲得了最優權重參數,并且盡可能地減小了模型大小,節省了訓練過程中的內存開銷。這種從粗到細再到粗的模型搭建策略使模型首先感知到粗略的特征,然后將注意力轉移到精細的細節上,最后再次關注已經得到的特征圖的全局信息,以防止模型忽略其他重要的細節特征,從而提高模型的識別準確性。本研究提出的MS-PLNet網絡結構克服了傳統卷積神經網絡模型參數量大、模型運算量高的不足,既能有較好的葉斑病分類準確率,又能使模型具有較小的參數量,實現葉斑病的快速識別和統計分析。

本研究提出的卷積神經網絡模型用于對綠豆葉斑病高光譜圖像和抗性等級進行分類和評估,通過構建MS-PLNet模型,與MobileNet-V2、MobileNet-V3、EfficientNet-B0、ResNet50等現有的先進模型進行比較。本研究提出的MS-PLNet模型在達到最高驗證準確率的同時,訓練300次僅需要1個小時49分鐘,其中驗證準確率較高的MobileNet-V2比MS-PLNet要多花費近154%的訓練時間;訓練1 000次僅需要10個小時26分鐘,其中驗證準確率較高的EfficientNet-B0比MS-PLNet要多花費近127%的訓練時間。MS-PLNet是所有進行對比的模型中訓練花費時間最少的,極大地節省了模型的推理時間和訓練資源,方便部署。

它通過構建多尺度的特征提取模塊,在3個分支的特征提取模塊中輸入高光譜圖像以及采用3個尺度的卷積核進行特征提取,在降低了模型參數的前提下,訓練出來的模型達到了較高的分類精度,能夠實現綠豆葉斑病的快速識別。

為實現對綠豆葉斑病的精準快速分類,本研究提出一種基于MS-PLNet卷積神經網絡結構和高光譜圖像的綠豆葉斑病分類方法。MS-PLNet網絡訓練1 000次能夠達到98.4%的驗證準確率,并且該方法對HR、R、MR、MS、S等5種抗性類型的綠豆葉斑病圖片的分類平均精度為95.0%,可用于實驗室條件下的綠豆葉斑病和其他農作物葉斑病的快速分類,識別準確率高,且具有較好的魯棒性與廣泛的應用價值。本研究使用的綠豆葉斑病數據集為實驗室收集得到,下一步將收集真實大田環境下的數據,驗證本研究搭建的MS-PLNet模型在復雜環境下的分類準確率。