重復(fù)性結(jié)構(gòu)零件的三維重建

涂福泉,魏斯佳

(武漢科技大學(xué)冶金裝備及其控制教育部重點(diǎn)實(shí)驗(yàn)室,湖北 武漢,430081)

隨著機(jī)器視覺(jué)技術(shù)的發(fā)展,圖像三維重建技術(shù)因成本低且易于實(shí)現(xiàn),已成為工業(yè)零件質(zhì)量檢測(cè)的有效方法之一。三維重建根據(jù)二維圖像提供的三維信息對(duì)目標(biāo)物體進(jìn)行恢復(fù),其準(zhǔn)確性主要依賴于對(duì)圖像間場(chǎng)景重疊的識(shí)別。運(yùn)動(dòng)恢復(fù)結(jié)構(gòu)(structure from motion,SfM)作為三維重建中最常用的方法之一,其能恢復(fù)一系列無(wú)序圖像的三維空間點(diǎn)和相機(jī)姿態(tài),應(yīng)用場(chǎng)景廣泛且復(fù)雜,但也存在一定的問(wèn)題[1],如機(jī)械工程領(lǐng)域中軸承、齒輪、液壓件等零件常存在重復(fù)性結(jié)構(gòu),這種相似、模糊的結(jié)構(gòu)極易導(dǎo)致重建得到錯(cuò)誤模型,即使Colmap、Bundler等主流軟件也難以避免該類問(wèn)題的發(fā)生[2]。

為此,Zach等[3-4]提出了“缺失對(duì)應(yīng)”的概念,即獲取3張匹配良好的圖像構(gòu)成視圖三聯(lián)體,通過(guò)第3張圖像中的補(bǔ)充信息來(lái)完善圖像間的對(duì)極幾何關(guān)系,以此來(lái)檢測(cè)和去除不正確視圖,但該方法較為絕對(duì),很可能會(huì)排除正確視圖。針對(duì)此概念,Jiang等[5]提出了一種新的優(yōu)化標(biāo)準(zhǔn),他們首先證明了所述目標(biāo)函數(shù)的全局最小值與正確的三維重建相關(guān),然后設(shè)計(jì)了一個(gè)有效的最小化算法以保證目標(biāo)函數(shù)收斂至最小值,該方法可用于處理高度歧義場(chǎng)景,但無(wú)法用于區(qū)分非連通模型。不少研究者認(rèn)為重復(fù)結(jié)構(gòu)中的背景信息同樣具有利用價(jià)值,如Wilson等[6]根據(jù)可見(jiàn)性圖中的局部背景信息來(lái)剔除錯(cuò)誤的特征點(diǎn)軌跡,該方法適用于大規(guī)模網(wǎng)絡(luò)數(shù)據(jù)集,Heinly等[7]對(duì)此方法進(jìn)行改進(jìn),但某些情況下仍存在模型過(guò)分割問(wèn)題。Yan等[8]認(rèn)為視覺(jué)上模糊相似的結(jié)構(gòu)也存在測(cè)地線距離,由此提出一種基于測(cè)地線一致性的方法來(lái)檢測(cè)重復(fù)結(jié)構(gòu),但相關(guān)參數(shù)仍需要根據(jù)特定場(chǎng)景來(lái)調(diào)整,該方法難以有效推廣。張浩鵬等[9]提出將序列目標(biāo)圖像的成像時(shí)間順序作為先驗(yàn)指導(dǎo),然后依次加入新圖像以實(shí)現(xiàn)空間與時(shí)間的結(jié)合,但該方法不適用于無(wú)序圖片。Kataria等[10]改進(jìn)了相機(jī)初始位姿估計(jì),僅使用可靠的匹配點(diǎn)來(lái)初始化位姿,并賦予短的匹配軌跡更大權(quán)重,該方法能在一定程度上減少因重復(fù)結(jié)構(gòu)引起的歧義信息。Xu等[11]開(kāi)發(fā)了一種基于圖像相關(guān)性的圖像自動(dòng)聚類方法,并創(chuàng)建了一個(gè)最優(yōu)合并列表來(lái)決定合并順序,但重復(fù)性結(jié)構(gòu)的存在仍可能造成聚類紊亂。

為解決重復(fù)性結(jié)構(gòu)零件的三維重建精度問(wèn)題,本研究對(duì)SfM方法中特征點(diǎn)對(duì)應(yīng)搜索和增量三維重建兩個(gè)關(guān)鍵步驟進(jìn)行改進(jìn),即在對(duì)應(yīng)搜索階段提出一種基于匹配點(diǎn)空間相關(guān)的方法,以去除錯(cuò)誤匹配,并利用沖突度量對(duì)三維結(jié)構(gòu)恢復(fù)的稀疏點(diǎn)云進(jìn)行優(yōu)化,最后通過(guò)對(duì)比實(shí)驗(yàn)來(lái)檢驗(yàn)所提算法的有效性和精度,以期為三維重建技術(shù)在零件合格率檢測(cè)領(lǐng)域的應(yīng)用提供依據(jù)。

1 算法設(shè)計(jì)

增量式三維重建方法的基本步驟如圖1所示,本研究主要對(duì)特征點(diǎn)對(duì)應(yīng)探索和增量式三維重建[12]步驟進(jìn)行改進(jìn)。

圖1 增量三維重建基本流程

1.1 特征點(diǎn)對(duì)應(yīng)搜索

特征點(diǎn)檢測(cè)與匹配是三維重建中的基礎(chǔ)步驟,匹配質(zhì)量很大程度上決定了最終重建模型的精度。經(jīng)典SIFT(scale-invariant feature transform, SIFT)算法雖然具有尺度不變性,但其缺少對(duì)全局空間信息的約束,極易出現(xiàn)錯(cuò)亂匹配,故本文選用其改進(jìn)算法SURF[13](speeded-up robust features,SURF)進(jìn)行特征點(diǎn)檢測(cè),并使用FLANN[14](fast library for approximate nearest neighbors,FLANN)算法搜索匹配點(diǎn)。

FLANN是一種近似最近鄰匹配算法,通常采用K-means樹(shù)或多重隨機(jī)KD樹(shù)(K-dimension tree)等方法對(duì)高維實(shí)數(shù)向量空間進(jìn)行搜索,能快速有效地處理SURF特征檢測(cè)產(chǎn)生的64維描述子,其核心在于使用歐氏距離找到特征點(diǎn)之間的近似距離(式(1)),具體匹配過(guò)程如下:

(1)對(duì)圖像X的特征點(diǎn)集{x1,x2,…,xn}與圖像Y的特征點(diǎn)集{y1,y2,…,ym}進(jìn)行歐氏距離計(jì)算,找到特征點(diǎn)xi的最近鄰yj和次近鄰yk:

(2)分別計(jì)算yj、yk到xi的歐氏距離D1、D2,得到比值d=D1/D2;

(3)設(shè)置閾值μ(μ<1),并比較d與μ:若d<μ,則yj為xi的匹配點(diǎn),否則該點(diǎn)匹配失敗,xi無(wú)對(duì)應(yīng)匹配點(diǎn)。

(1)

式中:X、Y為一對(duì)待匹配點(diǎn)的SURF特征向量;當(dāng)使用SURF特征檢測(cè)時(shí),d取64。D(x,y)值越小,表明兩者距離越“近”,即相似程度越高。

FLANN算法得到的初始集合中包含許多低精度匹配點(diǎn),故需進(jìn)一步剔除低相關(guān)數(shù)據(jù)點(diǎn)以獲得精確匹配。圖2所示為直接使用隨機(jī)抽樣一致算法(random sample consensus,RANSAC)對(duì)FLANN匹配進(jìn)行處理后所得到的圖像對(duì),可以看出,圖中仍存在明顯錯(cuò)誤,爪極內(nèi)部下方區(qū)域有部分特征點(diǎn)錯(cuò)誤匹配到爪極上部,如圖中a、b點(diǎn)所示。

圖2 SURF+FLANN+RANSAC算法得到的匹配圖像

針對(duì)該類誤匹配問(wèn)題,本文提出了一種基于匹配點(diǎn)空間相關(guān)的解決方法,即利用特征點(diǎn)簇的內(nèi)部相關(guān)性,假定在空間中屬于同一區(qū)域的特征點(diǎn)對(duì)應(yīng)在二維圖像中的大部分特征點(diǎn)是接近的,依此在RANSAC之前對(duì)圖像中匹配點(diǎn)進(jìn)行過(guò)濾。從圖像A左上角的第一個(gè)像素點(diǎn)開(kāi)始尋找匹配點(diǎn),對(duì)“密集”區(qū)域的錯(cuò)誤特征匹配進(jìn)行剔除。以匹配點(diǎn)Ai為圓心,在半徑為R(R=50)的區(qū)域內(nèi)搜索,當(dāng)匹配點(diǎn)數(shù)目不小于15時(shí),稱該區(qū)域?yàn)椤懊芗逼ヅ鋮^(qū)域OAi,隨即進(jìn)行下一步檢測(cè);否則,繼續(xù)搜索以下一個(gè)匹配點(diǎn)為圓心的區(qū)域,直至滿足“密集”條件。在圖像B中找到Ai的匹配點(diǎn)Bj,以Bj為圓心、R′為半徑,確定區(qū)域圓OBj,與OAi構(gòu)成對(duì)應(yīng),其中A為主圖像,B為A的待匹配圖像。假設(shè)圓OAi與OBj中的點(diǎn)全部在區(qū)域內(nèi)形成匹配,則認(rèn)為兩圓內(nèi)的點(diǎn)匹配正確;若存在圓OAi內(nèi)的某點(diǎn)與圓OBj外的另一點(diǎn)相匹配,則認(rèn)為兩區(qū)域匹配可疑,需進(jìn)一步分析。根據(jù)與OBj匹配位置的不同,將OAi中的點(diǎn)分為內(nèi)點(diǎn)和外點(diǎn),內(nèi)點(diǎn)表示OAi中匹配在OBj內(nèi)部的點(diǎn),其余為外點(diǎn)。若內(nèi)點(diǎn)數(shù)目小于外點(diǎn),則將內(nèi)點(diǎn)視為疑點(diǎn),暫存疑點(diǎn)集S1,反之,外點(diǎn)為疑點(diǎn)。當(dāng)以疑點(diǎn)集S1中的點(diǎn)為圓心進(jìn)行匹配時(shí)同樣能夠得到疑點(diǎn)集S2,刪除兩點(diǎn)集公共部分的匹配點(diǎn),認(rèn)為該部分匹配點(diǎn)為誤匹配點(diǎn)。

以圖2為例,圓OAi中除a點(diǎn)以外的其他點(diǎn)全部在區(qū)域圓OBj內(nèi)形成對(duì)應(yīng),匹配點(diǎn)對(duì)a、b點(diǎn)可疑,進(jìn)而可根據(jù)上述方法剔除該類型的錯(cuò)誤匹配點(diǎn),即:

(2)

通過(guò)以上步驟可去除大部分誤匹配點(diǎn),最后使用RANSAC算法對(duì)其進(jìn)行細(xì)化。

1.2 增量三維重建

對(duì)典型增量SfM輸出的稀疏點(diǎn)云進(jìn)行后處理優(yōu)化,流程如圖3所示,其中在評(píng)估拆分相機(jī)對(duì)的有效性時(shí)需要對(duì)特征點(diǎn)進(jìn)行明確區(qū)分。

(a)初始相機(jī)圖 (b)MST構(gòu)造和圖像分割 (c)圖像對(duì)評(píng)估 (d)超像素分割

(1)構(gòu)建最小生成樹(shù)(minimum spanning tree,MST)

根據(jù)圖像間的幾何約束關(guān)系得到一組空間相關(guān)的相機(jī)圖[3](camera graphs,CGs),節(jié)點(diǎn)對(duì)應(yīng)于相機(jī),當(dāng)兩相機(jī)存在足夠的匹配點(diǎn)時(shí),使用邊連接,如圖3(a)所示。為減小重復(fù)結(jié)構(gòu)的影響,使用式(3)計(jì)算邊緣權(quán)重,并由此構(gòu)造MST,得到權(quán)重之和最小的樹(shù)結(jié)構(gòu)來(lái)減少邊數(shù)量。

(3)

式中:Oi、Oj是在每個(gè)相機(jī)中可見(jiàn)的3D點(diǎn)的集合,wij為i、j兩相機(jī)之間的邊緣權(quán)重。

具有較小wij值的邊緣將同一結(jié)構(gòu)的相鄰相機(jī)組合起來(lái),而具有較大wij的邊緣則表示相機(jī)可能連接錯(cuò)誤,即對(duì)應(yīng)為混淆邊緣(如圖3(b)中e2表示的邊緣),故需要對(duì)該類邊緣進(jìn)行分割,生成兩個(gè)不同的相機(jī)子圖,進(jìn)而評(píng)估拆分的有效性。

(2)圖像對(duì)分割與評(píng)估

原本連接的視圖中有一部分會(huì)因構(gòu)造生成樹(shù)而被分割,并且隨著混淆邊緣的斷開(kāi)而處于兩個(gè)不同的相機(jī)子圖中(如圖3(c)所示e1、e2、e3連接的視圖對(duì)),對(duì)于這些視圖對(duì),使用沖突度量來(lái)判斷是否拆分。沖突度量將場(chǎng)景中的獨(dú)特點(diǎn)投影到相機(jī)對(duì)的另一個(gè)圖像中,當(dāng)獨(dú)特點(diǎn)存在大量重疊時(shí),將其視為錯(cuò)誤連接[7]。

為簡(jiǎn)化相機(jī)拆分圖并減少計(jì)算量,首先對(duì)其進(jìn)行初始篩分,斷開(kāi)具有明顯錯(cuò)誤的連接。將待分割的兩個(gè)相機(jī)子圖表示為A組和B組,分別得到兩組中所有3D點(diǎn)的集合JA、JB,為減小噪聲影響,其中每個(gè)3D點(diǎn)均能在3個(gè)以上的相機(jī)中觀察到,因此,可將各點(diǎn)分為以下兩類:兩組之間的匹配點(diǎn)DAB(將其視為可能的重復(fù)結(jié)構(gòu)點(diǎn))和兩組中的唯一點(diǎn)UA、UB,即:

(4)

根據(jù)式(5),若唯一點(diǎn)與重復(fù)結(jié)構(gòu)點(diǎn)的比值超過(guò)閾值α,則在忽略少量因匹配錯(cuò)誤而產(chǎn)生的唯一點(diǎn)外,認(rèn)為兩子圖中存在完全不同的場(chǎng)景,可對(duì)兩圖連接的混淆邊緣進(jìn)行分割。此方法可在一定程度上避免遮擋或大視點(diǎn)情況的影響。

(5)

N=near(U′1,proj(U′2))∩

near(U′2,proj(U′1))

(6)

式中:near()函數(shù)用于計(jì)算處于同一超像素內(nèi)的點(diǎn),proj()函數(shù)計(jì)算該點(diǎn)處于圖像對(duì)中另一幅圖像的投影點(diǎn)。

t=min(|{u1:u1∈U′1∧u1∈N}|,|{u2:u2∈U′2∧u2∈N}|)

(7)

獨(dú)立計(jì)算所有存在混淆邊緣的相機(jī)組,若沖突值高于閾值τ,則拆除該邊。待獲得所有正確相機(jī)子圖后,將其融合為完整的三維重建模型。

2 實(shí)驗(yàn)結(jié)果與分析

本研究使用Python-OPenCV和Matlab軟件作為算法的主要運(yùn)行平臺(tái),在Windows10 64位操作系統(tǒng)(內(nèi)存16 GB、8核16線程,CPU i7-10700、2.90 GHz)下實(shí)現(xiàn),測(cè)試對(duì)象為3000像素×4000像素的爪極圖像。

2.1 特征匹配實(shí)驗(yàn)

特征匹配階段是在PyCharm平臺(tái)上利用OpenCV3.4.2軟件運(yùn)行改進(jìn)算法。圖4(a)為經(jīng)過(guò)SURF特征檢測(cè)及FLANN匹配后得到的圖像對(duì),圖4(b)則是后續(xù)再使用匹配點(diǎn)空間相關(guān)的方法去除誤匹配得到的圖像對(duì)。從視覺(jué)效果上看,使用SURF方法能提取出爪極圖像中存在的豐富特征信息,并能通過(guò)FLANN實(shí)現(xiàn)有效匹配,然而由于重復(fù)結(jié)構(gòu)的影響,圖4(a)中存在許多錯(cuò)誤匹配,圖中標(biāo)注出其中3對(duì),經(jīng)改進(jìn)方法處理后,該現(xiàn)象得到改善,圖4(b)中并未出現(xiàn)明顯錯(cuò)亂匹配,具體驗(yàn)證結(jié)果如表1所示。

表1 特征匹配數(shù)據(jù)對(duì)比

(a)SURF+FLANN (b)SURF+FLANN+本文方法

2.2 三維重建實(shí)驗(yàn)

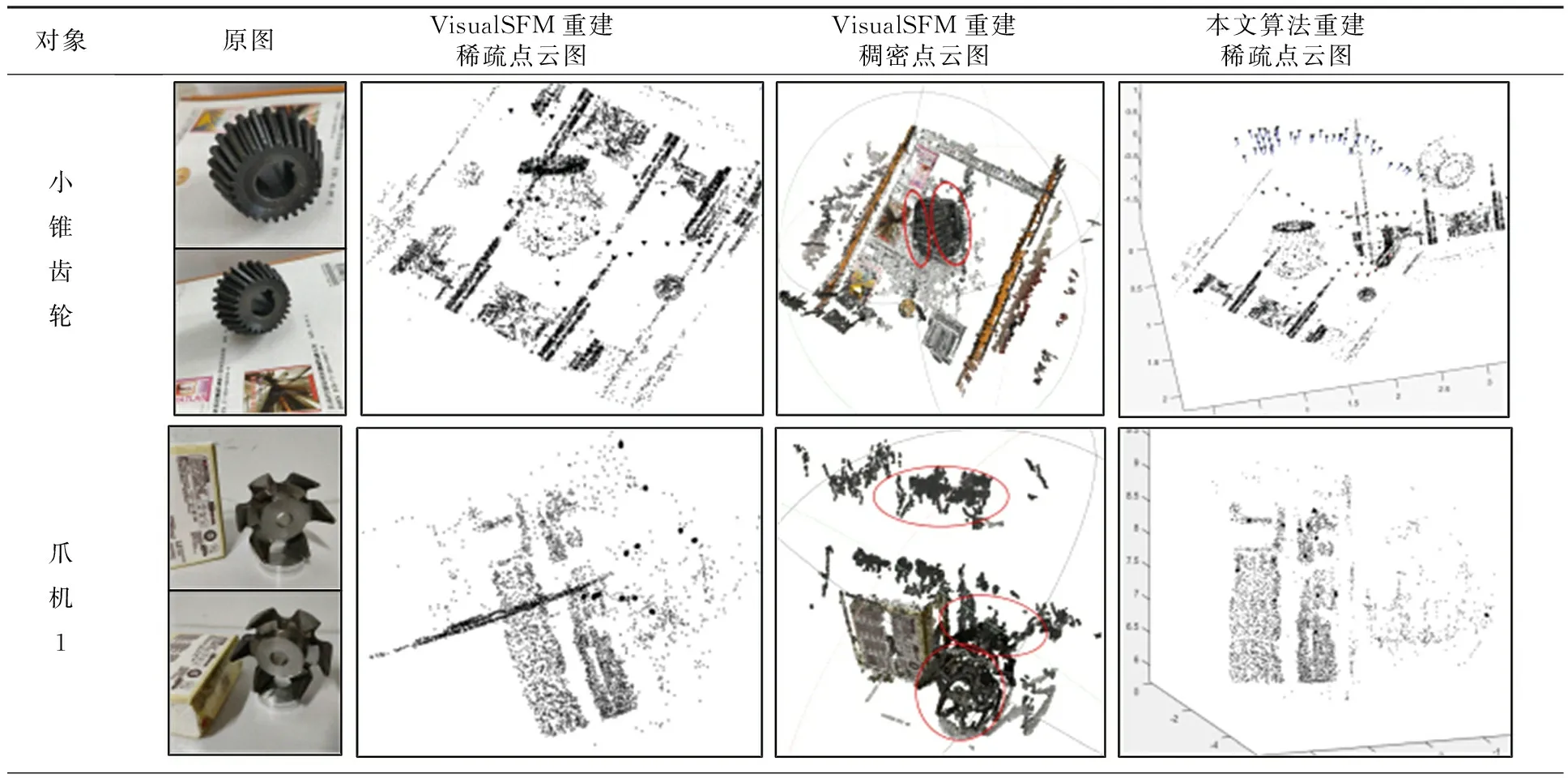

三維重建實(shí)驗(yàn)在Matlab軟件中進(jìn)行,該階段主要是利用改進(jìn)的沖突度量方法對(duì)稀疏點(diǎn)云進(jìn)行重建,并將重建結(jié)果與開(kāi)源軟件VisualSFM得到的稀疏模型相比較,然后利用基于聚簇和面片模型的多視角密集匹配(CMVS/PMVS)實(shí)現(xiàn)多視圖稠密重建,得到最終三維重建結(jié)果。經(jīng)過(guò)多次實(shí)驗(yàn)演算,閾值α設(shè)為1.0,沖突閾值τ設(shè)為7.0。

VisualSFM等成熟軟件可對(duì)大多數(shù)三維場(chǎng)景進(jìn)行準(zhǔn)確重建,但若存在重復(fù)結(jié)構(gòu),VisualSFM軟件極易出錯(cuò)。本實(shí)驗(yàn)主要拍攝了三組結(jié)構(gòu)件的照片,包括103張小錐齒輪、38張爪機(jī)1和63張爪機(jī)2的圖像,如表2所示,可以看出,圖中均存在重復(fù)性場(chǎng)景或結(jié)構(gòu)。當(dāng)使用VisualSFM軟件重建時(shí),出現(xiàn)混亂缺損的三維點(diǎn)云,小錐齒輪和爪機(jī)2的稠密重建中明顯出現(xiàn)了多個(gè)錯(cuò)誤實(shí)體(橢圓標(biāo)出的區(qū)域),而改進(jìn)的沖突度量方法能對(duì)不同場(chǎng)景或結(jié)構(gòu)進(jìn)行有效區(qū)分。相比于Heinly等[7]提出的方法,本文提出的方法效率有所提升,例如對(duì)于爪機(jī)2,利用文獻(xiàn)[7]提出的方法得到?jīng)_突值為0,即無(wú)需對(duì)其進(jìn)行分割,表明該方法無(wú)法辨別本次實(shí)驗(yàn)中存在的錯(cuò)誤,而使用改進(jìn)的沖突度量方法能明顯看出爪極形態(tài),且計(jì)算速度加快8 s,表明本文提出的改進(jìn)算法是有效的。

表2 實(shí)驗(yàn)重建模型

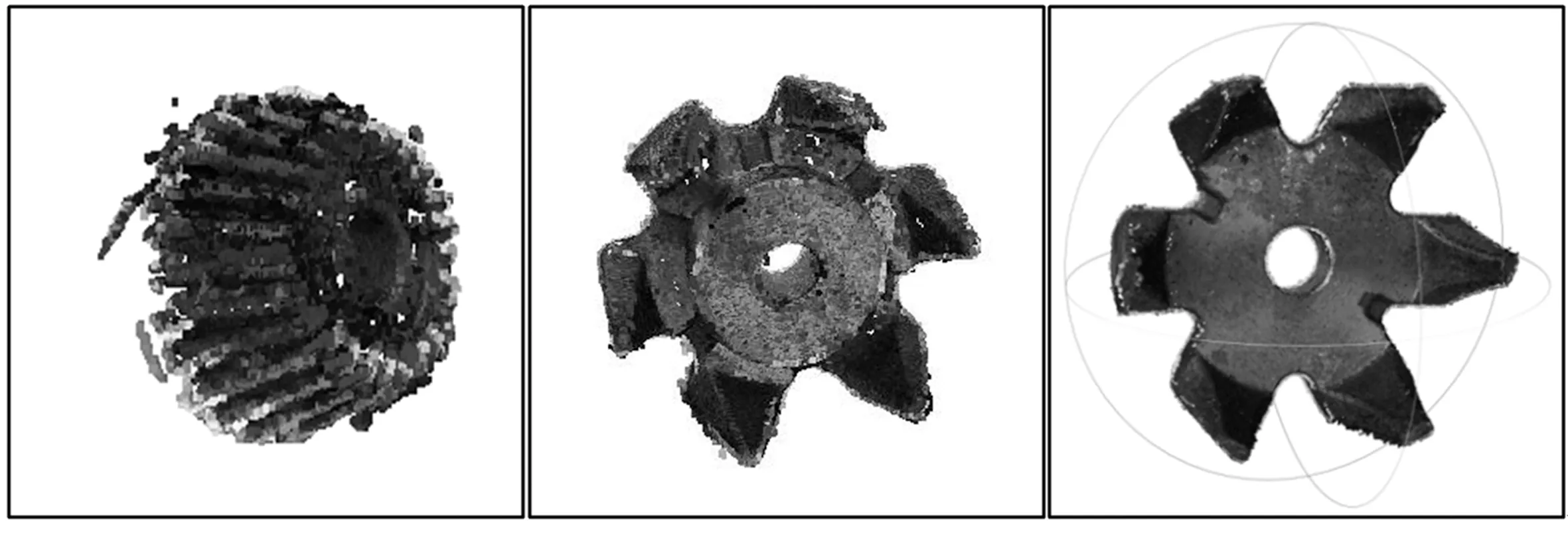

2.3 重建結(jié)果精度分析

對(duì)沖突為0的稀疏點(diǎn)云進(jìn)行稠密重建,并使用MeshLab進(jìn)行可視化處理,得到結(jié)果如圖5所示,對(duì)其中關(guān)鍵點(diǎn)進(jìn)行測(cè)量得到相應(yīng)的距離,為減少誤差,每?jī)牲c(diǎn)之間距離測(cè)量3次取平均值,然后與實(shí)際結(jié)構(gòu)件的尺寸進(jìn)行對(duì)比,結(jié)果列于表3中。結(jié)合圖5和表3可知,本文提出算法的重建精度最高可達(dá)98.52%,這進(jìn)一步驗(yàn)證了在工業(yè)中使用三維重建技術(shù)對(duì)零件合格率進(jìn)行判別的可行性[15]。

表3 結(jié)構(gòu)件的三維重建尺寸

(a)小錐齒輪 (b)爪機(jī)1 (c)爪機(jī)2

3 結(jié)語(yǔ)

為提高重復(fù)性結(jié)構(gòu)零件的三維重建精度,本文提出了一種基于SfM方法的改進(jìn)算法。首先,針對(duì)SfM方法中特征信息匹配精度不高的問(wèn)題,在對(duì)應(yīng)搜索階段提出一種匹配點(diǎn)空間相關(guān)的方法,改進(jìn)方法有效減少了因重復(fù)結(jié)構(gòu)所導(dǎo)致的錯(cuò)亂匹配;在三維重建階段,提出了沖突度量方法對(duì)SfM輸出的稀疏點(diǎn)云進(jìn)行后優(yōu)化處理,這能有效剔除錯(cuò)誤連接,提高了SfM算法的魯棒性,改進(jìn)算法對(duì)重復(fù)零件的三維重建精度最高可達(dá)98.52%。