基于 EfficientNetV2和遷移學習的乳腺癌病理圖像分類

楊傳德 李格璇 李海軍

摘? 要:針對人工識別乳腺癌腫瘤存在無法避免人為因素的問題,提出一種基于EfficientNetV2和遷移學習的乳腺癌病理圖像分類算法。首先,由于現有公開數據集BreaKHis樣本數據量過小,通過數據預處理實現數據增強,從而使模型學習到更多魯棒性的特征。然后將數據集在微調后的EfficientNetV2網絡模型上進行遷移學習訓練,同時采用Nadam進行梯度下降優化,進而實現乳腺癌病理圖像的自動分類。實驗結果表明,相較于其他深度學習模型,該模型以更少的參數與更高的準確率很好地以底層視覺特征映射了高層語義,有效提升了臨床醫學診斷的效率。

關鍵詞:EfficientNetV2模型;遷移學習;Nadam

中圖分類號:TP391.4;R737.9 文獻標識碼:A 文章編號:2096-4706(2023)10-0136-04

Abstract: Aiming at the problem that artificial recognition of breast cancer tumors cannot avoid human factors, a classification algorithm of breast cancer pathological images based on EfficientNetV2 and transfer learning is proposed. Firstly, due to the small sample size of the existing public dataset BreakKHis, data augmentation is achieved through data preprocessing, thereby enabling the model to learn more robust features. Then, transfer learning training is carried out on the database on the finely tuned EfficientNetV2 network model, and the gradient descent optimization is carried out with Nadam, so as to realize the automatic classification of breast cancer pathological images. The experimental results show that compared to other deep learning models, this model effectively maps high-level semantics with lower level visual features with fewer parameters and higher accuracy, effectively improving the efficiency of clinical medical diagnosis.

Keywords: EfficientNetV2 model; transfer learning; Nadam

0? 引? 言

據世界衛生組織國際癌癥研究機構(IARC)發布的全球最新癌癥負擔數據顯示,乳腺癌已取代肺癌成為全球第一大癌癥[1]。伴隨著乳腺癌患者年輕化趨勢加強,對于病理學專家的需求越來越大。當前,乳腺癌疾病的檢測和診斷可以借助成像系統程序,例如熱圖以及超聲圖像等[2]。這些方式雖然在一定程度上幫助了病理醫師進行乳腺癌病理圖像診斷,但診斷結果仍然受制于病理醫師個人主觀因素的影響,故準確率難以保證。

近年來使用機器學習和經典計算機視覺對乳腺癌病理圖像進行診斷成為一個快速發展的研究領域。深度學習已成為乳腺癌數字組織病理學的首選方法。與人工診斷相比,深度學習的方法不需要憑借人工提取的方式對乳腺癌病理圖像進行特征提取,從而降低了對專業病理醫師的需求,節省了人力資源。

為了減少深度學習模型訓練參數,同時又能夠確保乳腺癌病理圖像分類模型的精度、網絡收斂性和訓練速度等基本性能評價指標,本文主要針對BreaKHis數據集7 909張4種不同放大倍數的病理圖像,利用了以EfficientNetV2為主干網絡的圖像分類模型進行良性樣本與惡性樣本的分類。

1? 方法介紹

對于乳腺癌病理圖像領域的計算機視覺技術研究可追溯到多年之前。在基于卷積神經網絡的方法這一策略上,為了將乳腺癌腫瘤細胞圖像分成良性與惡性兩大類,Spanhol等人[3]分別測試了LeNet[4]和AlexNet[5]模型,兩模型準確率分別達到了接近人力平均水平的72%和80.8%~85.6%。在基于深度殘差網絡的方法這一策略上,Koné等人利用ResNet50模型對乳腺癌病理圖像進行分類,這一策略在乳腺癌4種分類問題上取得了81%的分類精度;但上述方法由于神經網絡大程度的加深,網絡也變得笨拙起來,在進行深度學習模型訓練時,巨大的計算機資源將被消耗,而且模型預測結果與金標準差距較大,不具有普適性。故本文以EfficientNetV2作為網絡權重,并在此基礎上對乳腺癌數據集預處理工作后進行深度遷移學習訓練,同時利用Nadam優化器進行梯度下降優化,從而進一步提高模型泛化能力。

1.1? 模型搭建

1.1.1? EfficientNetV2網絡

本文使用的主干網絡EfficientNetV2[6],前身是由Tan等提出的EfficientNetV1[7]。其利用神經網絡搜索(Neural Architecture Search, NAS)的方法,設置了合適的合成比例系數,很好的平衡了網絡的寬度、深度和分辨率,這樣不僅使得網絡模型學習到了更加豐富復雜的特征,而且使得網絡模型可以在很好的應用到其他任務的同時還更容易訓練。整個網絡的運算可以抽象為:

其中,N表示一系列復合層的操作疊加。d、w、r分別表示平衡網絡深度、寬度、分辨率的系數。⊙i=1…s表示連乘運算,Fi表示一個運算操作,則FiLi表示在Stagei中Fi運算被重復執行Li次。X表示輸入Stagei的特征矩陣。

在EfficientNetV1中雖然Depthwise convolutions結構相比普通卷積擁有更少的參數以及更小的FLOPs,但現有的加速器無法對其提供充分的支持,導致實際運用起來并沒有想象中快。EfficientNetV2基于此拋棄了一些MBConv模塊中的深度可分離卷積,隨之更替為普通卷積。Fused-MBConv與MBConv結構如圖1所示。

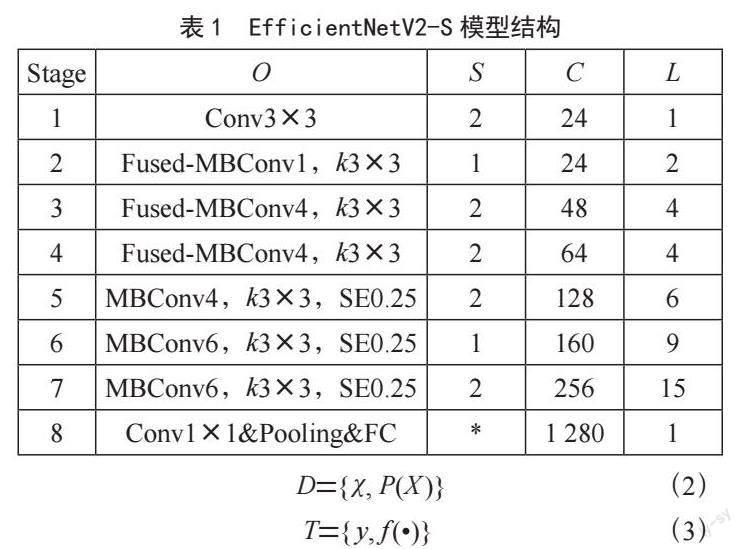

根據混合系數φ取值的不同,EfficientNetV2的其中配置分別為EfficientNetV2-S、EfficientNetV2-m、EfficientNetV2-l,以及B0至B3共7種網絡模型。以規模最小的EffficientNetV2-S網絡為例[7],其結構如表1所示。

其中,O即Opereator,表示每一個Stage利用到的模塊;S即Stride,表示步長;C即Channels,表示輸出的通道數;L即Layers,表示Stage中模塊反復堆疊的數量;模塊Conv3×3表示3×3的普通卷積和常用的激活函數層及批量歸一化BN層;Fused-MBConv模塊后接數字,表示縮放因子expansion ratio;k3×3意味著kenel_size為3;SE模塊即Squeeze-and-Excitation模塊,表示這一模塊由一個全局平均池化層和兩個全連接層組成;0.25意為SE模塊中首個全連接層節點數是輸入MBConv模塊通道數的0.25倍。

EfficientNetV2通過平衡網絡的寬度、深度以及分辨率使得計算機資源不被過度浪費的同時,得到了更高的精度及效率。而高精度與高效率正是目前診斷乳腺癌在臨床試驗中提出的要求。因此,本文采用EfficientNetV2-B1網絡模型對乳腺癌病理圖像數據集進行遷移學習訓練,它可以以更少的參數量、更小的計算機資源訓練出具有更強魯棒性的網絡模型。

1.1.2? Nadam優化器

Nadam算法是由Dozat提出的[8],其通過將Nesterov動量和Adam算法結合在一起,使得Nadam優化器在擁有Adam算法幾乎所有優點的同時,也更加直接的影響梯度并可以加強對學習率的約束。一般情況下,Nadam優化器相較于Adam優化器可以取得更好的效果。故采用Nadam優化器進行優化。

1.2? 深度遷移學習

傳統深度學習側重在優化原有結構,偏向于神經網絡結構上的突破。而遷移學習更趨向于在已有的網絡基礎上,研究領域適應性問題[9]。通常將源域與目標域分別表示為D和T;χ與y分別表示特征空間與標簽空間;P(X )表示邊際概率分布,其中X={x1, k, xn}∈ χ;f (·)表示目標的預測函數,遷移學習即利用有標注的D來學習T的知識,具體過程可由如下形式進行闡釋:

深度遷移學習的基本思想是通過在一個現有的大型數據集上(例如ImageNet)預訓練一個神經網絡模型,然后利用這個已經預訓練好的神經網絡的權重作為整個模型的初始化權值,然后將其遷移到目標數據集上進行訓練和微調。遷移學習之所以可行是因為神經網絡的前面幾層學習的是樣本的泛型特征,例如點、線、輪廓等共性底層特征,后幾層學習的是目標數據集的特有特征。

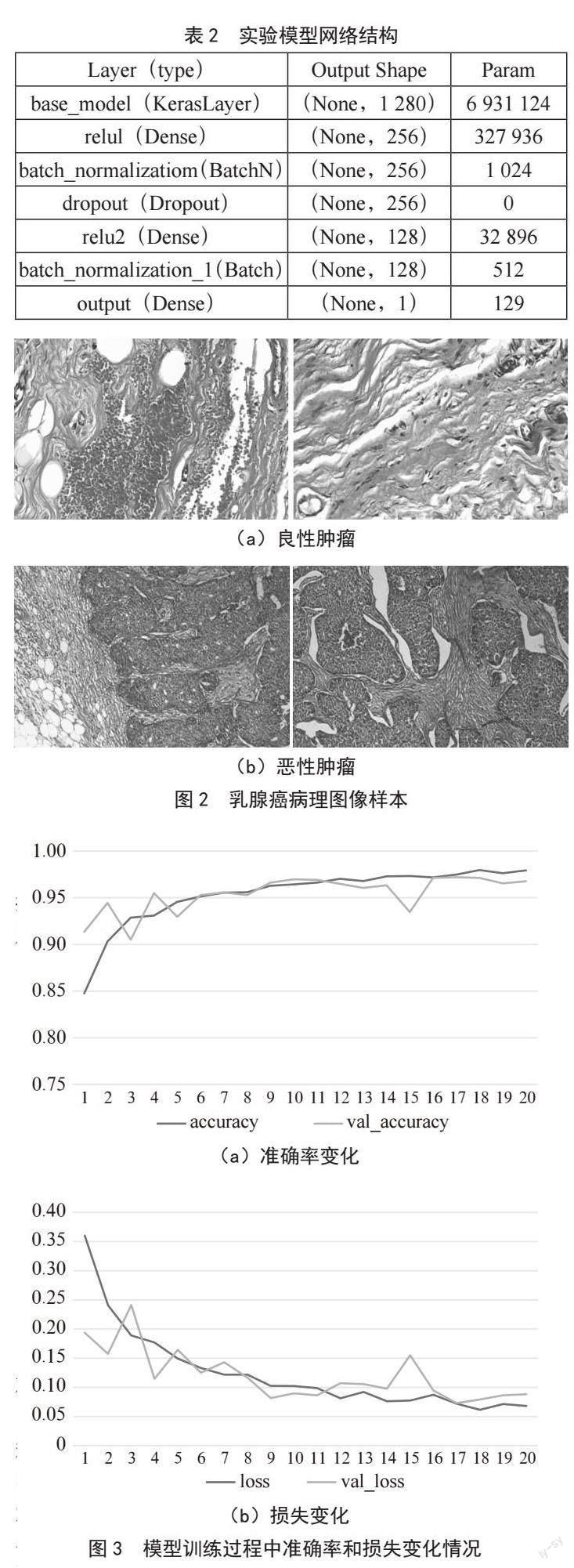

本文的實驗模型在ImageNet這樣一個超大型的數據集(包括約120萬自然圖像和1 000個不同類別)上進行預訓練,將預訓練得到的模型參數作為網絡的初始化參數,之后依據經驗定制全連接層,以此使感受野得到增大,進而學習到乳腺癌病理圖像更高細粒度特征模板。表2是本模型的具體網絡結構組成。

2? 實驗分析

2.1? 實驗環境

本實驗采用Python編程語言,GPU處理器為NVIDIA GeForce GTX 3080 Ti,內存為16 GB,操作系統為Ubuntu 20.04,深度學習框架為TensorFlow。

2.2? 實驗數據

數據集BreakHis(Breast Cancer Histopathological Database)來自P&D實驗室,其包括了來自82位患者的7 909張已標注好的乳腺組織病理圖像。其中良性腫瘤圖像有2 480幅,惡性腫瘤圖像有5 429幅。圖像采用4種不同的放大倍數(40X、100X、200X、400X)。BreakHis數據集的部分乳腺癌病理圖像樣本如圖2所示。

2.3? 數據增強

為在原有的圖像數據集的基礎上擴大圖像的數量,進而提高模型的泛化能力,往往會在已有的數據利用鏡像、旋轉、尺度變換、隨機扣取、色彩抖動等方式進行數據增強來實現對圖像的預處理。

本文利用Albumentations數據增強庫,將以下操作按照規定概率組合完成了圖像數據增強工作:將輸入數據集圖像以0.5的概率水平翻轉;以0.5的概率設置隨機轉動的角度為15°;以0.5的概率設置隨機亮度與對比度分別在-0.2到0.2與-0.1到0.1這個區間內;以0.8的概率設置隨機裁切的區間為0.9到1.1,同時設置隨機長寬比區間為0.05到1.1;對輸入圖像進行了模糊化處理以降低噪聲[8]。

2.4? 參數設置

利用EfficientNetV2-B1網絡可以讓模型的誤差率和漏檢率大幅降低,同時可提升模型泛化能力。在進行多次實驗后,成功獲得了本模型的最佳參數組合,即設置初始學習率為0.001,批量大小Batch_size為16,圖像標準化Norm_size為240,模型共迭代訓練了20輪。

2.5? 實驗結果及分析

2.5.1? 實驗結果

根據常用性能評價指標,準確率(accuracy)越高,模型的分類效果就越理想,也就越能規避惡性乳腺腫瘤細胞無法被識別分類的現象;損失越低,可說明模型魯棒性的強大。實驗結果表明:本實驗最終驗證集準確率和損失分別為0.968 4和0.084 7。訓練過程速度快,網絡收斂性良好。如圖3所示。

2.5.2? 結果分析

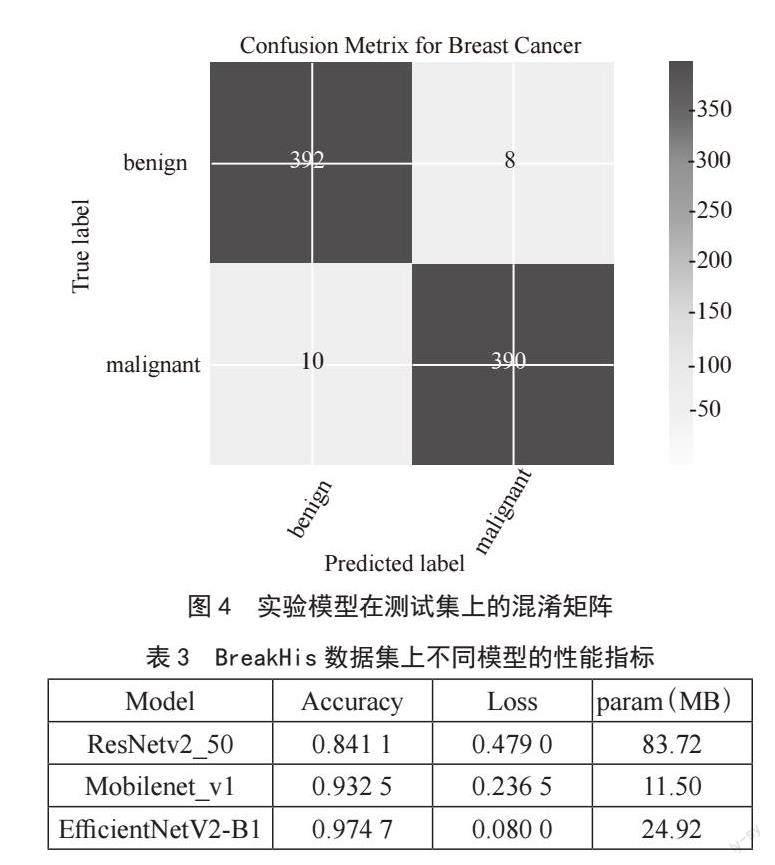

BreakHis數據集被劃分成了訓練集、驗證集和測試集。在進行數據預處理之前,訓練集、驗證集、測試集上的圖像數量分別為5 687、1 422和800。為了更直觀準確地看出模型分類效果,對測試集上的圖像進行預測,并用混淆矩陣反映預測結果情況[9]。

從圖4中可以計算出,在測試集上,對于良性和惡性乳腺癌圖像,準確率均達到97%左右,AUC達到0.978,可見本模型對于乳腺癌病理圖像分類效果之理想。

在模型訓練過程中,可以看出模型相較于輕量級神經網絡模型MobileNet[10],準確率更高,相較于其他深度學習網絡模型如ResNet不僅準確率更高,參數量更少。對比數據如表3所示。

觀察表中數據,可以明顯看出基于EfficientNetV2和遷移學習的乳腺癌病理圖像分類算法在參數量和準確率上的優越性。

3? 結? 論

借助計算機視覺技術,達到對乳腺癌病理圖像病灶的智能分類,輔助病理醫師進行乳腺癌的臨床診斷和早期篩查的未來應用的前景廣闊。深度學習已然成為數字組織病理學的首選方法。我們通過深度學習模型與遷移學習算法對乳腺癌病理圖像進行識別,并利用Nadam優化器來優化梯度下降,將圖像分為良性、惡性的二分類,得到EfficientNetV2-B1模型效果最好,其不僅網絡收斂性、訓練速度和分類精度更好,而且參數量更少。不足之處在于乳腺癌的數據量分布不均衡,今后的工作將對具體惡性乳腺癌類型進一步細分,實現對病患具體情況的具體處理。

參考文獻:

[1] 顧玉芳,李國遠.乳腺觸診成像系統在乳腺疾病早期篩查中的應用分析 [J].中國初級衛生保健,2022,36(4):77-79.

[2] TORRE L A,ISLAMI F,SIEGEL R,et al. Global Cancer in Women: Burden and Trends [J]. Cancer Epidemiology, Biomarkers &Prevention ,2017,26(4):444-457.

[3] SPANHOL F A,OLIVEIRA L S,PETITJEAN C. Breast cancer histopathological image classification using Convolutional Neural Networks [C]//2016 International Joint Conference on Neural Networks (IJCNN).Vancouver:IEEE,2016:2560-2567.

[4] KRIZHEVSKY A,STUSKEVER I,HINTON G E. ImageNet classification with deep convolutional neural networks [J].Communications of the ACM,2017,60(6):80-90.

[5] MAHBOD A,ELLINGER I,ECKER R,et al. Breast Cancer Histological Image Classification Using Fine-Tuned Deep Network Fusion [M].Campilho A,Karray F,Romeny B H. Image Analysis and Recognition. [S.I.]:Springer,2018.

[6] TAN M X,LE Q V. EfficientNetV2: Smaller Models and Faster Training [J/OL].arXiv:2104.00298 [cs.CV].[2022-11-28]. https://arxiv.org/abs/2104.00298v1.

[7] TAN M X,LE Q V. EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks [J/OL].arXiv:1905.11946 [cs.LG].[2022-11-28].https://arxiv.org/abs/1905.11946v5.

[8] DOZAT T. Incorporating Nesterov Momentum into Adam [EB/OL].[2022-11-28].http://cs229.stanford.edu/proj2015/054_report.pdf.

[9] SCH?LKOPF B,PLATT J,HOFMANN T. Analysis of Representations for Domain Adaptation [M]//SCH?LKOPF B,PLATT J,HOFMANN T. Advances in Neural Information Processing Systems 19: Proceedings of the 2006 Conference.Cambridge:MIT Press,2007.137-144.

[10] BUSLAEV A,PARINOV A,KHVEDCHENYA E,et al. Albumentations:Fast and Flexible Image Augmentations [J/OL].arXiv:1809.06839 [cs.CV].[2022-11-28].https://arxiv.org/abs/1809.06839.

作者簡介:楊傳德(2003—),男,漢族,山東臨沂人,本科

在讀,研究方向:圖像處理、深度學習;李格璇(2003—),女,漢族,山東德州人,本科在讀,研究方向:機器學習;李海軍(1974—),男,漢族,山東聊城人,副教授,碩士,研究方向:計算機視覺。