生成式人工智能時代的使用者倫理研究

[摘 " 要] 在既有生成式人工智能倫理治理討論中,使用者層面的倫理長久以來遭到忽視。交互性與生成性作為生成式人工智能的重要屬性為使用者打開了一條呈現自我的有效路徑,生成式人工智能時代中使用者與開發者的融合早已超過生產者與消費者在經濟活動中的融合,走向了人類社會形態的重構與人類未來的重塑。因此,使用者倫理的出場與前置應被視為數字素養的未來發展方向。本文將個人、社會兩個層面與積極倫理、消極倫理兩個維度相結合所構建的使用者倫理矩陣,為使用者在面對、應用生成式人工智能時所應遵守的行為道德準則和規范提供了基本框架。為了更好地實施這一框架,需要技術使用者、技術設計(開發)者、技術監管者三方共同協力,推動人與技術的關系走向緊密與向善,為人類的福祉與未來保駕護航。

[關鍵詞]生成式人工智能 " 使用者倫理 " 技術道德化 " 數字素養

[中圖分類號] "B82-057;TP18;N4 [文獻標識碼] A [ DOI ] 10.19293/j.cnki.1673-8357.2024.02.003

近年來,以GPT-4、Sora等為代表的生成式人工智能作為一種科技創新,在推動新質生產力發展的同時,其隱含的不確定性后果和潛在倫理風險也越來越被社會所關注。交互性與生成性作為生成式人工智能的重要屬性為使用者打開了一條呈現自我的有效路徑,并與設計者共同推進技術的發展。特別是隨著生成式人工智能技術的易用性不斷提升,普通使用者的地位也日益凸顯,并成為推動技術革新和應用普及的關鍵力量。他們不僅是技術的受益者,更是技術的塑造者和傳播者。然而,面對日新月異的生成式人工智能,使用者自身應當建立并遵守何種倫理規則以應對技術的挑戰卻鮮有討論。

根據《生成式人工智能服務管理暫行辦法》,生成式人工智能技術指的是“具有文本、圖片、音頻、視頻等內容生成能力的模型及相關技術”[1]。目前,在生成式人工智能倫理治理的討論中,企業和國家層面的倫理議題受到了廣泛關注。這些研究多集中于企業內部的倫理審查機制建設[2],包括人工智能領域的立法以及政策性文件、行業技術標準、行業協會自律公約、行業協會發布的倡議書等[3]。對比之下,目前學界對于使用者層面的倫理討論卻相對較少,這反映出生成式人工智能時代背景下的使用者倫理在一定程度上并未受到社會的關注與探討。縱觀人工智能發展史,使用者在生成式人工智能時代的重要性已然不可同以往等量齊觀,這既是令人欣慰的技術路徑改變,同時也帶來了使用者治理的難題。

正如習近平總書記所指出:“要加強人工智能同保障和改善民生的結合,推動人工智能在人們日常工作、學習、生活中的深度運用,創造更加智能的工作方式和生活方式。”[4]隨著未來生成式人工智能的普及,使用者作為技術的最終目的與指向,亟須重新審視自身,推動使用者倫理的出場與構建,以期與技術發展相協同,共同守護人類的福祉與未來。

1使用者倫理出場的技術圖譜:Web3.0背景下的“產消者”

1.1 “產消者”的新樣態

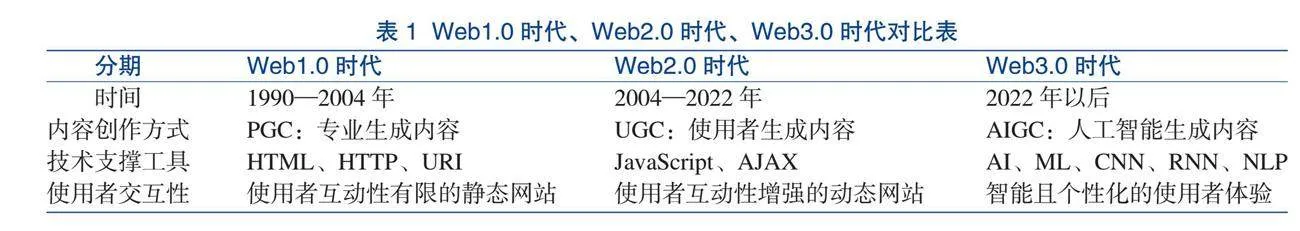

針對科學技術的發展,阿爾文·托夫勒(Alvin Toffler)從經濟活動的視角提出,“第一次浪潮社會的產消合一者在以高新科技為基礎的第三次浪潮時代又將重新成為經濟活動的中心”[5]。產消者是指那些參與生產活動的消費者,他們既是消費者又是生產者。產消者不以交換目的而進行生產,而是出于自己的興趣、愛好、需求而無償地生產產品或者服務。同時隨著消費者對生產過程的介入越多,其在生產活動中的必要性也就越顯著,從Web1.0時代到Web3.0時代的演變歷程(見表1)來看,也恰好印證了這一判斷。

Web1.0時代始于20世紀90年代,使用者主要通過互聯網網頁(瀏覽器)來獲取信息,但彼時的網頁由HTML代碼編寫,網頁內容是固定的,不會因為使用者的交互而進行動態變化。同時,網頁內容是由網站開發人員以及專業的內容創作者提供的,即專業生成內容(Professional Generated Content,PGC),普通使用者在這一階段只能作為讀者閱讀信息,而無法創造內容。在這一階段,生產者和使用者(消費者)是壁壘分明的,且相對生產者而言,使用者的話語權和地位都較為低微。長此以往,Web1.0時代在“作者少、讀者多”的情況下,仍然采取中心化的數據存儲方式,導致使用者所能享受到的資源十分匱乏,因此Web1.0時代很快被Web2.0時代所取代。

2004—2022年大致處于Web2.0時代,使用者不再僅僅是讀者,他們可以通過各類動態網站參與在線編寫和內容修改而成為創作者,即使用者生成內容(User-Generated Content,UGC)。在這一時期,UGC的創作途徑為人們通過各類社交平臺分享自己創作的內容。通過去中心化的數據共享和協作,不同的組織或個人之間進行共享和協作使群體的內容創造力不斷提升。不過在這一階段,UGC的創作主力仍然是擁有專門技能的意見領袖,普通使用者的潛力仍待發掘。

2022年之后進入Web3.0時代,通過運用生成式人工智能,使用者可以與機器協作,共同生成內容,即人工智能生成內容(AI-Generated Content,AIGC)。不同于前兩個階段,生成式人工智能的顛覆性在于引發了生產方式的變革,而非僅僅局限于托夫勒所指的商品活動過程。

1.2生成式人工智能視角的“產消者”

在生成式人工智能中,使用者與設計者的融合早已超出生產者與消費者在經濟活動中的融合,走向了人類社會形態的重構與人類未來的重塑。

一方面,生成式人工智能開始替代人類非物質形式的勞動。自從第二次工業革命引發的工業化、機械化勞動大規模地取代了人類的體力和物質勞動以后,生成式人工智能開始沖擊人類對于腦力和非物質勞動的“獨占”地位。目前,AIGC已在各類內容創作領域布局,如文本生成有ChatGPT,圖像生成有Stable Diffusion、Midjourney,視頻生成有Sora等。通過分布式的數據存儲和分享,以及在先進算法和強大算力的加持下,未來人類的生產力和創造力或將難以離開生成式人工智能的支撐。與此同時,這也引發了人類對于自身地位的懷疑,或許未來從事非物質勞動的主體不再僅僅是人,機器也不再是被動的工具,人機共生已是不可阻擋的趨勢。

另一方面,在人機共生的進程中,使用者已然成為中樞。不同于Web1.0和Web2.0時代,AIGC背景下的所有使用者從廣義上而言已參與到生產行為中。“整個世界,我們每一個人,都在為人工智能做貢獻。每當我們上網,使用我們的智能手機、信用卡或社交媒體,通過自動收費站,播放流媒體電影、看電視,都是在為人工智能做貢獻。” [6]目前,生成式人工智能的訓練數據來自互聯網的文本、音視頻和聊天記錄等,同時使用者在使用生成式人工智能所產生的數據和信息又“反哺”為訓練數據,幫助大模型更新迭代。在這一過程中,用戶的消費行為兼具了生產性質。在托夫勒那里,“產消者”仍需經過一道商品交換,且消費者并沒有真正參與到勞動工具的制造中,但在Web3.0時代,使用者不僅直接參與到了勞動工具的制造中,他們的消費資料還源源不斷轉換為生產資料,進而推動生產力的發展。因此,生成式人工智能的消費者超越了托夫勒所處的時代,并引發了本體論意義上的變革。

綜上,生成式人工智能推動了勞動形式、生產關系的轉變,打破了傳統的生產者和消費者的平衡,逐漸呈現出了使用者成為AIGC時代重要力量的趨勢。從PGC時代的開發者(生產者),到UGC時代的部分使用者(擁有專門技能的意見領袖),最后到AIGC時代的全體使用者(產消者),這既是人機共生所帶來的生產力解放,也是潛在的人類生存危機。

1.3技術發展亟須使用者倫理的出場

從Web1.0到Web3.0時代,使用者的數量在不斷增加,而這種數量上的無限擴大也將導致秩序的混亂。得益于人工智能使用成本的降低,早期Web1.0只能搭載在電腦終端上,而該時期的電腦售價昂貴,只有部分技術精英才能夠承擔,而到Web3.0時代,生成式人工智能已經可以在手機上運行,并且無須使用者掌握編程語言,只需自然語言即可使用。

根據第53次《中國互聯網絡發展狀況統計報告》,截至 2023年12月,我國手機網民規模達 10.92億人[7]。這也從另一方面啟示我們,面對數量龐大且素質良莠不齊的使用者群體,建立并普及使用者倫理應當是必須且急迫的社會任務。

2技術倫理的新面向:使用者倫理作為“將技術道德化”的補充

將技術道德化(Moralizing Technology),即將道德理念嵌入到技術設計中,從而使技術物能引導和規范人的行為 [8]。在生成式人工智能的設計中,道德物化已有所體現。例如,近年來所提出的“為社會負責任的人工智能”(Socially Responsible Artificial Intelligence)“為社會負責任的人工智能算法”(Socially Responsible Artificial Intelligence Algorithms,SARs)等均明確將社會責任與人工智能的發展置于一個共同的框架之中[9]。此外,各國所推出的相關倡議與框架,如中國發布的《全球人工智能治理倡議》,美國發布的《負責任的人工智能戰略和實施路徑》等,也都提及在算法設計、技術開發、產品研發與應用過程中,應避免歧視、偏見等問題。雖然在設計中嵌入道德是可行的,但仍不足以應對嚴峻的人工智能治理困境,“將技術道德化”在某些情境下仍然會有“失靈”的潛在風險。

2.1技術調節的反調節與再調節

技術具有多穩態性,技術設計者與使用者二者之間的意向性并非是連貫的或一致的,甚至可能是對抗性的。例如,在設計ChatGPT、Bing Chat等聊天機器人時,設計者出于安全性能的考量會拒絕為使用者生成諸如販毒、偷竊等有害的教學內容,但使用者通過各類“越獄”技巧即可繞過ChatGPT的安全屏障而獲得答案,這類行為屬于技術的反調節。就目前的情況而言,在社交媒體、論壇,一些含有不良傾向的“越獄”技巧、經驗仍在被用戶分享和轉載,且少有監管,因此,這種反調節的倫理風險需要引起高度重視。

與此同時,技術調節的再調節,即不能預先假定技術設計者都是誠實而完美的,設計者的設計行為必須得到再調節。如廣州地鐵女子裸照事件,一名網紅在地鐵拍攝的正常照片被惡意“一鍵脫衣”成“裸照”,虛假照片的迅速流傳嚴重損害了當事人的名譽權和肖像權。但與技術設計者初衷相背離的是,這類軟件設計之初是為了幫助女性在網絡上虛擬試衣或智能挑衣 [10]。由此可見,反調節與再調節都超出了技術設計者的可控范圍,二者均與使用者的意圖、行為息息相關。

2.2“將技術道德化”中的使用者問題

就將技術道德化而言,從《將技術道德化》一書的副標題“理解與設計物的道德”就可以看出,設計者被賦予了高度關注,但這并非僅僅指通過設計將道德予以技術化,進而將技術的道德問題置于設計端,而是力圖通過對物的道德解碼來開啟對技術道德構成問題的探討。就這種構成而言,設計者與使用者的意向性在將技術道德化的理論中均被關注。然而,鑒于設計者在技術環節中的重要性,技術設計者的倫理被高度重視。特別是,隨著技術日趨自主與智能化的趨勢,技術設計者的倫理素養、價值取向等逐漸被視為技術倫理問題的核心。

就技術設計者的現狀來看,目前主流的生成式人工智能多由歐美發達國家的白人男性工程師開發,這些技術設計者的價值偏好也被映射到了生成式人工智能內容生成的各個環節。例如,ChatGPT所用的語料就主要來自維基百科(Wikipedia)、Common Crawl、Web Text等語料庫,這些語料庫語種類型多為英語,這也許會導致非英語國家的使用者在使用生成式人工智能時不免受到來自西方價值觀念和文化思想的沖擊,同樣非白人群體、女性群體也因訓練數據的局限性而備受人工智能的偏見。因此,事實證明技術設計者很難保證完全的價值中立,如果僅以技術設計者的“法則”來發展技術,使用者被剝奪參與技術民主決策的權利,那么技術就會成為技術專家專制的“利維坦”。大至國家安全、意識形態,小至弱勢群體的利益,都應由多方群體協商參與,而非僅由技術設計者獨攬決策大權。

一旦任由技術設計者成為類似的“統治階級”,技術治理可能異化為技術統治,而避免這種命運就需要落實再治理的制度設計[11]。易言之,采取將技術道德化的方式雖能在一定程度上用技術引導使用者做出道德行為,但技術調節仍然會面臨諸如反調節與再調節、技術統治論等問題,這些問題超出了技術設計者的客觀能力范圍,且與使用者層面息息相關。究其原因,技術本質上仍然有社會屬性,它指向的另一端是使用者,因此,作為實際倫理受益者和風險受害者的使用者問題也亟待解決。

2.3“將技術道德化”與使用者倫理的出場

使用者倫理的出場作為“將技術道德化”的補充,意味著更多元的技術倫理,重視使用者與技術的關系,能推動多方利益群體的協同,為將技術道德化的內在主義進路進行補充,進而推動生成式人工智能更好地走向善與發展之路。

生成式人工智能作為一種尚處于研發升級階段的新興技術,與之相關的倫理分析往往面臨“科林格里奇困境”問題,即過早且過嚴的控制容易導致技術難以獲得爆發與突破;過晚控制則易導致技術發展失控,再治理起來將耗費更多的時間、金錢、人力。為此,有學者指出,為破解這一難題,AIGC的治理應建立“從決策層、技術層到應用層,從標準規范、管理制度到工具支撐,自上而下貫穿AIGC發展底層數據治理的完整生態體系。在AIGC運行的各個階段以及基于數據合規治理框架規制的各個環節之間需要對規制目標和宗旨取得共識,以確保合規高效、科學動態地完成治理目標”[12]。而就現狀來看,將技術道德化已從決策層、技術層引導使用者如何應然地使用生成式人工智能,但具體到使用者如何實然地使用層面則進一步呼喚使用者倫理的出場。

實證研究表明,公正、責任、隱私與透明度是使用者在實踐中難以察覺的倫理問題,并且不同身份的使用者存在個體利益和社會影響感知上的明顯差異 [13]。這意味著,使用者視角的倫理層次存在著被遮蔽的現象,應在使用者的實然層面有針對性地建構相應的、可操作的倫理框架。而就將技術道德化而言,其自身作為一種前瞻性的技術倫理分析,仍然會面臨對技術未來的猜測同真實使用行為不符的情況。易言之,這種方法忽視了生活經驗中的基本規范性問題。為彌補這一缺憾,以湯姆·波爾森(Tom Brsen)為代表的技術人類學派提出構筑以專家、使用者、人工物三方互動的人類學模型,“技術哲學更多的是從工程師、專家的角度思考問題,而奧爾堡學派的技術人類學方式則更傾向于對用戶、顧客等技術的使用者進行研究” [14]。就理論方法而言,技術人類學強調,“微觀層面個體與實體之間的具體互動;制度層面應有成文的規范和具體化的實踐;社會層面強調支撐微觀層面和制度層面的意識形態和政治進程”[15]。因此,使用者倫理作為將技術道德化的補充,將從一種技術人類學的視角為使用者提供“實然”的倫理框架。

3基于數字素養新發展視角的使用者倫理:從唯技能論到全民倫理啟蒙

隨著人工智能的浪潮逐漸蔓延至更多人群,傳統的數字素養(Digital Literacy)概念已經不足以應對生成式人工智能時代的挑戰。在此基礎之上,拓寬數字素養的內涵與邊界,使數字素養能為全體使用者所共享是確保全社會享有數字福祉、規避數字風險的必由之路。

3.1技能培養視角下的數字素養

理查德·蘭納姆(Richard Lanham)于1995年提出數字素養的概念,他認為“素養”在數字時代的涵義應當從理解文本拓展到圖像、聲音、視頻等多媒體信息形態[16]。

在20世紀與21世紀之交,數字素養主要指使用者對數字技術的學習能力與技術技能。這種觀念的形成是因為自20世紀70年代計算機應用程序誕生以來,早期使用者必須通過專門、系統的學習才能使用與特定任務或工作相關的計算機系統。因此,數字素養一詞的出現正是用來評估與計算機相關的基本概念和技能的。隨著計算機技能在人們當代社會生活及工作中的重要性不斷增強,數字素養已逐漸進入幼兒教育、中小學教育領域。在K-12基礎教育階段,數字素養的教育更偏向于學習人工智能的知識和技能,如計算機科學基礎、數據挖掘、機器編程等,從而為學生未來的工作需求打下基礎。

值得注意的是,以色列學者約拉姆·埃謝特-阿爾卡萊(Yoram Eshet-Alkalai)在2004年依據功能將數字素養劃分為圖像素養(視覺識讀)、創新素養(創造性生產)、分支素養(新思維)、信息素養(辨別真偽)及“社會—情感”素養(共享與情感交流)五個層次[17]。

3.2對唯技能論的反思

無疑,上述這種以掌握具體技能操作為目標的數字素養,過度強調實用性和現實性的功能主義導向或將難以應對生成式人工智能對人類社會造成的具有顛覆性質的潛在倫理風險。當下,這種唯技能論的數字素養教育思潮的弊端也逐漸顯現出來。實證研究發現,學生很少關注倫理問題,如人工智能和法律責任的偏見(8%)、人工智能和知識產權問題(9%),因為這對于他們的就業并無直接益處[18]。因此,數字素養的教育不僅應該關注提高學生的人工智能能力和興趣,還應該幫助學生認識到作為使用者應如何去正確應對人工智能帶來的社會影響和倫理問題。

基于此,學界對這類定義進行了反思和批判,“數字素養”的外延也逐漸擴大。數字素養教育的核心內容應該集中在數字技術素養、針對動態文本的思辨能力、創造性生產與自我表達能力、互動交往能力以及數字媒介倫理[19]。同樣,在各國及各大國際組織的官方文件中,倫理也作為重要因素被納入數字素養框架。例如,《歐洲終身學習核心素養框架》(European Commission:Key Competences for Lifelong Learning)明確要求使用者自身需要以批判性的態度看待從數字渠道所獲信息及數據的有效性、可靠性和影響,并且了解有關數字技術使用的法律和倫理原則;同時要以符合倫理的、安全的、負責任的方式來使用數字工具[20]。我國的《提升全民數字素養與技能行動綱要》則將數字素養明確定義為,數字社會公民學習工作生活應具備的數字獲取、制作、使用、評價、交互、分享、創新、安全保障、倫理道德等一系列素質與能力的集合,并提出推動全民數字道德倫理水平大幅提升的發展目標[21]。

3.3數字素養的新意涵:全民倫理啟蒙

縱觀近幾十年數字素養概念與戰略的發展,其自身已突破唯技能論的桎梏,走向了倫理層次的啟蒙。因此,不能把數字素養看作簡單的數字獲取與使用等技術性技能,還要看到與之相關聯的思維和行為模式。換言之,公眾應具備的數字素養與技能,不僅指公眾具備與信息通信等數字技術相關的知識和技能,還包括他們在數字社會中的價值觀、倫理、行為和思維方式等方面的素養。而從使用者的角度來看,包含倫理啟蒙的數字素養應當惠及全體公民,不應僅局限于K-12教育階段的學生。

在使用者群體中,我們尤其要關心“銀發一族”對于人工智能的接受度和學習能力。諸如其文化程度、經濟能力的不足,以及網絡安全隱患催生的“數字恐懼”、從現實世界到虛擬空間的過渡所引發的“數字排斥”等問題,導致部分老年群體不愿學、很難學習人工智能的相關知識[22],這也使得老年群體成為不法分子利用人工智能犯罪的主要目標。在技術的裹挾下,這類使用者如果不具備基礎的人工智能素養,不僅無法享受到生成式人工智能所帶來的福利,反而很容易被不法分子利用人工智能加害。這類情況也啟示公眾,在已有的數字素養框架中,總是被首先強調的那些數字技術與技能在現實生活中并不一定真正能為使用者所有,因此將使用者倫理前置、倡導倫理先行或許是更適宜數字素養未來發展的新方向。

4生成式人工智能時代的使用者倫理框架

4.1 使用者倫理的涵義及其矩陣框架

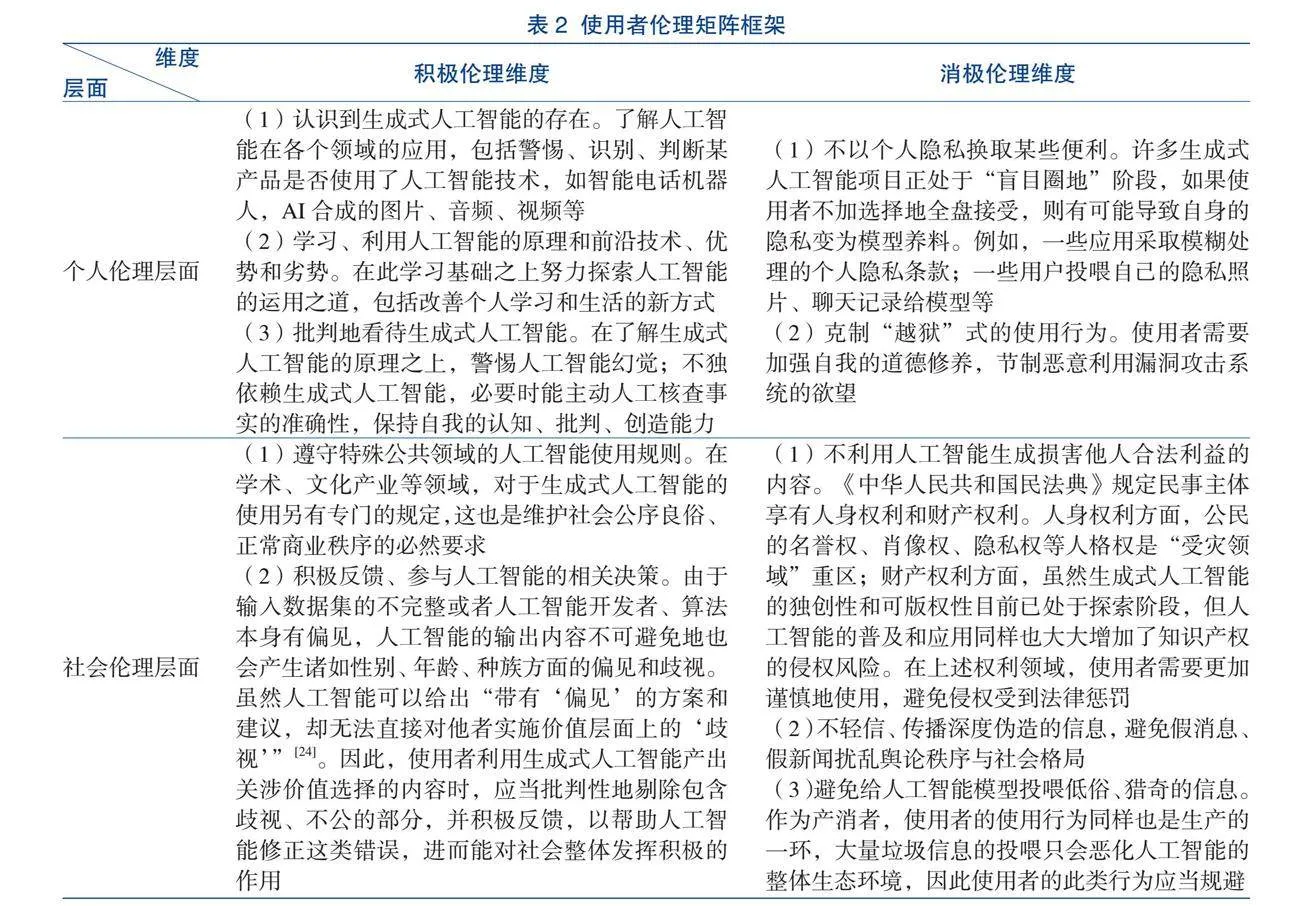

廣而言之,使用者倫理即是在生成式人工智能時代,使用者在面對、應用這項技術所應該遵守的行為道德準則與規范的總稱。使用者倫理取向可分為積極倫理與消極倫理兩個維度。所謂積極倫理,是指使用者以積極的態度來釋放技術給人帶來的正面價值,如促進人類解放與人類的全面自由發展等[23]。消極倫理,則是指強調使用者的道德義務,節制、禁止某些行為。同樣,使用者倫理還有個人倫理層與社會倫理層兩種層面。將它們與積極倫理以及消極倫理兩個維度相結合,則可得到一個基本的使用者倫理矩陣框架(見表2)。

通過該矩陣框架,可初步梳理出使用者倫理的詳細內涵并用其指導使用者正確面對、使用生成式人工智能。

4.2 使用者倫理框架的實施與踐行

使用者倫理框架雖直接關涉使用者,但其實施與踐行仍然依賴多方共同努力。

首先,就技術使用者自身而言,提高自我的道德意識,對于生成式人工智能的批判認知、使用能力已是倫理的應有之義。進一步而言,如前文所述,產消者所帶來的本體論意義上的變革也意味著使用者應當更積極地介入到“生產”環節中。在國內首個大語言模型治理開源中文數據集100 PoisonMpts中,環境社會學專家范葉超、著名社會學家李銀河、心理學家李松蔚、人權法專家劉小楠等專家作為標注工程師,各提出 100 個包含誘導偏見、歧視回答的刁鉆問題以幫助人工智能模型完成從“投毒”到“解毒”的攻防[25]。這類專家型使用者在標注數據的過程中,相較于純技術架構開發者,能更好地識別出隱蔽的偏見歧視、潛在有害內容。由此可見,一方面生成式人工智能技術的設計者應當更多地吸納不同學科、領域的專家型使用者,通過博采眾長,技術設計者可以更好地理解不同行業的需求和挑戰,從而更有針對性地優化技術,使其更好地服務于各類群體。另一方面,使用者自身也可借鑒消費者協會、微博社區志愿者等制度建設自律組織,推動構建共治、共享的智能空間。

其次,盡管技術設計者會面臨技術的反調節與再調節問題,但就目前來看,將倫理道德嵌入生成式人工智能設計的程度仍然是遠遠不夠的。布魯諾·拉圖爾(Bruno Latour)將技術物對個體行為的影響作用概括為“腳本(Script)”,但在技術實踐的實際過程中,使用者并不一定必然遵循設計者的“腳本”,反而會“改寫”。困難的是,在生成式人工智能時代,使用者的“改寫”現象更加頻繁,這反過來促使技術設計者在編寫“腳本”時,應盡可能詳細地考慮到使用者可能的意圖,并以說明、引導的方式幫助使用者正確使用人工智能。諸如強制用戶閱讀用戶須知、隱私保護條款,以醒目方式警告使用者不當使用的嚴重后果及法律責任,強制標注某段內容是人工智能合成等。當然,隨著使用者的地位日漸提升,未來設計者應當加強與使用者的合作,包括但不限于吸收各學科專家型學者優化數據集、重視使用者的反饋等。

最后,作為技術倫理治理的兜底,技術的監管者也應對倫理秩序予以最基本的保護。就目前來看,我國在這方面已取得了一定的成績。《中華人民共和國民法典》將數據、網絡虛擬財產納入法律保護范圍;對肖像權、著作權、名譽權等的規定,同樣適用于人工智能領域,如明令禁止“深度偽造”侵害他人肖像、聲音等。《中華人民共和國民法典》《中華人民共和國網絡安全法》《中華人民共和國數據安全法》《中華人民共和國個人信息保護法》等法律法規從根本上明確了相關技術服務提供者、使用者的權利和義務,為其提供了基本的行動指南,并且在《互聯網信息服務深度合成管理規定》《生成式人工智能服務管理暫行辦法》等文件中有更加詳細的規定。而根據《提升全民數字素養與技能行動綱要》對提升全民數字道德倫理水平的要求,未來我國可在全民普及生成式人工智能知識、加強倫理宣傳,在對弱勢群體傾斜、關注等方面發力,以提高使用者的整體數字素養水平。

4.3作為生成式人工智能發展必要條件的使用者倫理

與發展勢頭如火如荼的生成式人工智能相對的是,人類社會應對人工智能風險的滯后性。直到2024年,歐洲議會批準的《人工智能法案》(Artificial Intelligence Art)才成為全球首部全面的人工智能監管法規。總體而言,相關立法和政策的推出與人工智能的發展速度總是不匹配的;人工智能領域的人才需求與供給之間存在不平衡,相關教育和培訓不夠充分;普通公眾對人工智能技術的認知和理解程度有限,社會對人工智能倫理問題的認識和討論需要提上日程。

以上種種都在提示公眾,必須注重倫理在技術發展中的重要意義。然而,作為基數最為龐大的使用者,他們應當承擔何種倫理責任卻仍不明晰,這顯然并不符合生成式人工智能的發展趨勢。因此,從生成式人工智能的技術特性來看,使用者倫理是其發展的必要條件,但更需認清的是,建設使用者倫理是一個長期且復雜的過程,需要個人、企業、社會、政府等多方共同協力。在現階段,面對不同水平、能力的使用者群體,使用者倫理的踐行應當從個人層面到社會層面循序漸進地推進。

參考文獻

中央網絡安全和信息化委員會.生成式人工智能服務管理暫行辦法 [EB/OL].(2023-07-13)[2024-03-24]. https://www.cac.gov.cn/2023-07/13/c_1690898327029107.htm.

章誠豪,張勇.生成式AI的源頭治理:數據深度運用的風險隱憂與刑事規制[J].湖北社會科學,2023(11):127-135.

曾雄,梁正,張輝.人工智能軟法治理的優化進路:由軟法先行到軟法與硬法協同[EB/OL].(2024-01-23)[2024-02-22]. http://kns.cnki.net/kcms/detail/11.5181.TP.20240122.1129.014.html.

新華社.習近平主持中共中央政治局第九次集體學習并講話[EB/OL].(2018-10-13)[2024-03-24]. https://www.gov.cn/xinwen/2018-10/31/content_5336251.htm?eqid=8e9a43b100048e9700000003646b28f8.

阿爾文·托夫勒. 第三次浪潮[M]. 黃明堅,譯.北京:中信出版社,2018.

帕梅拉·麥考黛克.人工智能往事:精英、文化與思維[M].虞晶怡,楊麗鳳,譯.上海:格致出版社,2023.

中國互聯網絡信息中心.第53次《中國互聯網絡發展狀況統計報告》[R/OL].(2024-03-21)[2024-03-24]. https://www.cnnic.net.cn/n4/2024/0321/c208-10962.html.

彼得·保羅 ·維貝克.將技術道德化——理解與設計物的道德[M]. 閆宏秀,楊慶峰,譯. 上海:上海交通大學出版社,2016.

閆宏秀.負責任人工智能的信任模塑:從理念到實踐[J].云南社會科學,2023(4):40-49.

董浩.生成式人工智能時代人機對話的傳播倫理風險及其應對[J]. 閱江學刊,2024,16 (1):104-114.

劉永謀,李尉博.有限技術治理的理論建構與時代意蘊[J].自然辯證法研究,2024,40(2):3-10.

張春春,孫瑞英.如何走出AIGC的“科林格里奇困境”:全流程動態數據合規治理[J].圖書情報知識,2024(2):39-49.

洪杰文,常靜宜.用戶關切視角下的“生成式AI”倫理框架建構[J].新聞與寫作,2023(12):44-55.

王皓.奧爾堡學派的技術-人類學探究[J].青海民族大學學報(社會科學版),2019,45(4):57-64.

王中貝,周榮庭. 新興技術倫理分析路徑研究 [J]. 自然辯證法研究,2022,38(3):29-35.

Lanham R A.Digital literacy[J].Scientific American,1995,273(3):160-161.

Eshet-Alkalai Y.Digital Literacy:A Conceptual Framework for Survival Skills in the Digital Era[J]. Journal of Educational Multimedia and Hypermedia,2004,13(1):93-106.

Gong X Y,Tang Y,Liu X Y,et al. K-9 Artificial Intelligence Education in Qingdao:Issues,Challenges and Suggestions[EB/OL].(2020-11-04)[2024-02-22]. https://ieeexplore.ieee.org/document/9238087.

李德剛.數字素養:新數字鴻溝背景下的媒介素養教育新走向[J].思想理論教育,2012(18):9-13.

鐘周.勝任數字變革:歐盟數字素養框架體系研究[J].世界教育信息,2023,36(1):46-57.

中央網絡安全和信息化委員會辦公室 . 提升全民數字素養與技能行動綱要 [EB/OL].(2021-11-05)[2024-03-24]. http://www.cac.gov.cn/2021-11/05/c_1637708867754305.htm.

黃晨熹.老年數字鴻溝的現狀、挑戰及對策[J].人民論壇,2020(29):126-128.

成素梅.智能革命與個人的全面發展[J].馬克思主義與現實,2020(4):196-202.

孟令宇.從算法偏見到算法歧視:算法歧視的責任問題探究[J].東北大學學報(社會科學版),2022,24(1):1-9.

Openbayes. 100PoisonMpts:中文大模型治理數據集[EB/OL].(2024-02-23)[2024-03-24]. https://openbayes.com/console/hyperai-tutorials/datasets/493fA4LmWwA/1/overview.

(編輯 "顏 " "燕 " "和樹美)