生成式人工智能場景下虛假信息風(fēng)險特殊性透視及應(yīng)對

摘 要:生成式人工智能改變了傳統(tǒng)的信息生產(chǎn)機制而有廣闊的應(yīng)用場景,但其生成虛假信息速度快、逼真度高、無中生有的特征不僅放大了傳統(tǒng)的虛假信息風(fēng)險隱患,還使得信息信任風(fēng)險成為虛假信息的重要風(fēng)險類型,也使得社交媒體平臺虛假信息治理防線有被全面突破的風(fēng)險。對此,應(yīng)基于生成式人工智能對虛假信息治理體系的挑戰(zhàn),從規(guī)范依據(jù)、虛假信息分類分級和實施部署方面著手推進虛假信息分級治理;應(yīng)從應(yīng)用準(zhǔn)入、算法治理和訓(xùn)練數(shù)據(jù)質(zhì)量管理方面強化虛假信息的源頭治理;應(yīng)從監(jiān)管協(xié)同、義務(wù)細化和公私協(xié)同方面增強虛假信息的協(xié)同治理。

關(guān)鍵詞:生成式人工智能;虛假信息;分類分級;源頭治理;協(xié)同治理

中圖分類號:D035 文獻標(biāo)識碼:A 文章編號:1672-335X(2024)02-0112-10

DOI: 10.16497/j.cnki.1672-335X.202402010

2022年12月1日,美國OpenAI公司推出的ChatGPT以其在自然語言理解、文本生成、代碼編寫及知識問答等方面的強大功效讓社會見證了生成式人工智能的廣泛應(yīng)用場景和市場前景。我國很多企業(yè)也紛紛投入生成式人工智能的研發(fā)并推出了類似產(chǎn)品,如百度“文心一言”、阿里“通義千問”、360“智腦”、中國電科“小可”等。但生成式人工智能在應(yīng)用過程可能的負面影響也被揭露和關(guān)注,對此,既有研究探討該技術(shù)在營銷領(lǐng)域[1]、旅游領(lǐng)域[2]、教育領(lǐng)域[3][4]、科研領(lǐng)域[5]的應(yīng)用可能引發(fā)的風(fēng)險及應(yīng)對,從不同視角揭示其應(yīng)用風(fēng)險。通過文獻梳理發(fā)現(xiàn),既有研究均將虛假信息作為該技術(shù)應(yīng)用產(chǎn)生負面影響的原因之一,這充分說明在開展生成式人工智能場景下虛假信息治理理論研究的必要性。而觀察生成式人工智能技術(shù)的應(yīng)用,發(fā)現(xiàn)該技術(shù)不僅有憑空編造虛假信息的特征,而且有生成速度快、生成內(nèi)容逼真度高的特點,可以想見該技術(shù)必然會使虛假信息的風(fēng)險產(chǎn)生某種形塑進而對虛假信息治理產(chǎn)生沖擊,[6]因而從實踐需要講也有對其展開研究的必要。既有虛假信息的治理實踐和研究,主要停留在生成式人工智能未廣泛應(yīng)用前的社交平臺虛假信息的治理,[7]尚且沒有結(jié)合生成式人工智能技術(shù)對虛假信息風(fēng)險的特殊性和治理的挑戰(zhàn)來開展,因而難免缺乏針對性。因此,本文擬對生成式人工智能技術(shù)場景下虛假信息風(fēng)險特殊性進行挖掘,進而分析既有虛假信息治理體系在面對技術(shù)挑戰(zhàn)時的困局并探索紓困之策。

一、生成式人工智能技術(shù)下虛假信息風(fēng)險特殊性透視

生成式人工智能技術(shù)在生成虛假信息方面有速度快、體量大和逼真度高的特征,[8]比人工生產(chǎn)虛假信息效率高出很多量級,甚至在圖片、視頻偽造等領(lǐng)域比人類更加高明。因此,生成式人工智能技術(shù)會對傳統(tǒng)的虛假信息風(fēng)險發(fā)生影響,甚至還會產(chǎn)生新的風(fēng)險挑戰(zhàn)。為對這些風(fēng)險挑戰(zhàn)進行揭示,本文通過文獻調(diào)研法和案例收集法對風(fēng)險樣態(tài)進行總結(jié),以便揭示在生成式人工智能下虛假信息風(fēng)險的特殊性。

(一)放大已有虛假信息的風(fēng)險隱患

虛假信息因存在領(lǐng)域不同會在個人權(quán)益、社會秩序以及國家安全等不同層面產(chǎn)生風(fēng)險隱患,而生成式人工智能技術(shù)會讓虛假信息的破壞性得以放大而難以控制。在個人權(quán)益層面,編造謠言對個體進行誹謗進而侵犯個體名譽權(quán),這類虛假信息的風(fēng)險在生成式人工智能廣泛應(yīng)用前就已經(jīng)存在,而生成式人工技術(shù)場景下造謠成本的降低和造謠水平的增強,使得謠言破除難度更高且風(fēng)險隱患也更高,這放大了已有虛假信息的風(fēng)險隱患。在社會秩序?qū)用妫墒饺斯ぶ悄芗夹g(shù)使得虛假社會新聞制作成本更低、速度更快和欺騙性更強,進而使社會秩序維護面臨更高的挑戰(zhàn)。例如,杭州某小區(qū)居民用ChatGPT制作“明日杭州市取消依照尾號限行”的虛假政府通告并進行分享導(dǎo)致虛假信息被廣泛傳播,嚴重擾亂了社會秩序。[9]而民眾信以為真的原因很大程度是因為ChatGPT編寫的虛假新聞有很強的邏輯性和連貫性。在國家安全方面,生成式人工智能編寫虛假信息能力給政治穩(wěn)定、國防安全帶來的隱患也不容忽視。事實上,生成式人工智能被用于政治領(lǐng)域的案例已經(jīng)出現(xiàn)。例如,美國芝加哥市長選舉中就曾出現(xiàn)利用人工智能軟件偽造候選人談話音頻進而讓選民對候選人政治立場產(chǎn)生誤解的破壞選舉事件。[10]而在國防安全方面,生成式人工智能技術(shù)可能被敵對國家用來對我國進行虛假信息攻擊。這種虛假信息攻擊主要有兩種情形:一種情形是通過編造虛假信息來影響我國民眾的認知進而營造有利于敵人的輿論。此種攻擊手法美國對中東地區(qū)國家施展過,極大地增強了美國在當(dāng)?shù)氐妮浾搩?yōu)勢。[11]第二種情形是偽造虛假情報信息干擾我國決策機構(gòu)和國民對國安情勢判斷,進而危害我國國家安全。[12]盡管上述風(fēng)險并不是因生成式人工智能而產(chǎn)生,但運用該技術(shù)會增加侵害手段的危害性,也會相應(yīng)提升該種類風(fēng)險的治理難度。

(二)增加信息信任損害為重要風(fēng)險類型

生成式人工智能智能具有類人性、看似真實性等特征,這使其可能錯被作為獲取真實信息的工具,進而產(chǎn)生信息信任損害的風(fēng)險。事實上,生成式人工智能下虛假信息引發(fā)的信息信任損害風(fēng)險已經(jīng)得到一定程度的顯現(xiàn),體現(xiàn)在個人信息信任和知識信息信任兩個方面。在個人信息信任方面,已出現(xiàn)AI編造他人過往經(jīng)歷信息的現(xiàn)象。例如,澳大利亞某地市長布賴恩·胡德被ChatGPT編造其在1999年、2005年曾向外國官員行賄被判處刑罰的過往經(jīng)歷信息。[13]無獨有偶,美國喬治華盛頓大學(xué)法學(xué)教授喬納森·特利被編造有性侵女學(xué)生并被處罰的過往經(jīng)歷且曾因此事被《華盛頓郵報》公開報道。而事實上《華盛頓郵報》從未報道過該新聞,而特利也從未因性侵女性受過指控。[14]這說明生成式人工智能有編造個人過往經(jīng)歷的信息能力,如果將其作為獲取他人經(jīng)歷信息的工具,必然引發(fā)個人信息信任的風(fēng)險。在知識信息信任方面,類似ChatGPT的生成式人工智能能以聊天的方式向詢問者快速提供合乎邏輯和可信的答案,在回答簡單的知識常識等方面具有很好的客觀性和真實性,因此很容易被作為無所不知的超級人工智能而被賦予知識基礎(chǔ)設(shè)施的地位進而成為獲取知識的重要渠道。而生成式人工智能對問題的回答是基于對訓(xùn)練數(shù)據(jù)的深度學(xué)習(xí)。如果學(xué)習(xí)的數(shù)據(jù)質(zhì)量存在問題,其輸出文本真實性難以保證。在特定高深的學(xué)術(shù)領(lǐng)域,其沒有受到相關(guān)數(shù)據(jù)的訓(xùn)練,其對問題的回答存在事實性錯誤、概念誤用甚至捏造信息等問題。生成式人工智能還會編造虛假的信息源,如果被其欺騙而怠于查證則無疑有害教育、科研的發(fā)展,[15]進而產(chǎn)生知識信任的問題。

(三)突破社交平臺內(nèi)容治理防線的風(fēng)險

生成式人工智能連續(xù)對話、信息批量制造以及出色的偽裝能力會使得社交平臺面對治理海量高度逼真的虛假信息的挑戰(zhàn)。社交媒體平臺如微信、微博、抖音、知乎等已經(jīng)是人們?nèi)粘=煌闹匾绞剑蔀榘l(fā)布信息、獲取信息與分享知識的重要場域,也是網(wǎng)絡(luò)虛假信息泛濫的重災(zāi)區(qū)。社交媒體平臺打破了傳統(tǒng)媒體對信息發(fā)布的壟斷,任何用戶都可以是信息源,但也因用戶發(fā)布信息往往不會經(jīng)過真實性審核而面臨如何有效治理虛假信息的困擾。[16]生成式人工智能技術(shù)在信息生產(chǎn)力方面的突破性進展,會進一步加劇社交平臺虛假信息治理的難度。在治理對象識別方面,生成式人工智能生成虛假信息的高效率和欺騙性使得社交平臺識別虛假信息的工作量和工作難度極大提高,進而增加社交平臺識別虛假信息的成本。在虛假信息傳播的技術(shù)反制方面,生成式人工智能的連續(xù)對話能力使其被作為社交機器人使用時更加難以識別,從而提高打擊社交機器人的難度。傳統(tǒng)的社交機器人只是簡單復(fù)制與粘貼原帖來傳播虛假信息而不能進行持續(xù)對話,相對容易被社交平臺識別與禁止,而生成人工智能如ChatGPT卻沒有原有社交機器人的不足。因此,社交平臺虛假信息的治理將會面臨不同以往的全新挑戰(zhàn),甚至面臨現(xiàn)有治理體系被全面突破的風(fēng)險。在這種背景下,無論是監(jiān)管機構(gòu)還是社交媒體平臺,都必須及時更新社交平臺虛假信息的應(yīng)對策略,才能更好地應(yīng)對生成式人工智能技術(shù)給社交平臺虛假信息治理帶來的挑戰(zhàn)。

二、既有生成式人工智能下虛假信息治理模式的困局及改進方向

網(wǎng)絡(luò)虛假信息問題自互聯(lián)網(wǎng)誕生之日就已經(jīng)產(chǎn)生,但生成式人工智能廣泛應(yīng)用之前的虛假信息隱患遠沒有現(xiàn)在這么嚴重。雖然目前網(wǎng)絡(luò)虛假信息的宏觀框架和治理措施及安排,在一定程度上能對生成式人工智能技術(shù)引發(fā)的虛假信息問題進行應(yīng)對,但從治理現(xiàn)狀考察,既有治理體系面臨治理對象范圍擴大、源頭治理力度不足、治理主體協(xié)同性不強的困局。

(一)生成式人工智能下虛假信息的治理現(xiàn)狀

從虛假信息生成到發(fā)揮負面作用來看,依次會經(jīng)歷生成式人工智能編寫虛假信息、社交平臺傳播、受眾接受錯誤信息的過程。因此,虛假信息的治理包括信息生產(chǎn)、信息傳播以及信息影響三個環(huán)節(jié),涉及生成服務(wù)提供者、社交媒體平臺以及網(wǎng)絡(luò)用戶等多方主體。與之相對應(yīng),網(wǎng)絡(luò)虛假信息的治理也形成了覆蓋多環(huán)節(jié)、多主體的治理格局。通過梳理有關(guān)法律、行政法規(guī)、部門規(guī)章以及地方性法規(guī)、網(wǎng)絡(luò)平臺的管理規(guī)約、用戶協(xié)議等有普遍約束力或者局部約束力的文件,可將當(dāng)前網(wǎng)絡(luò)虛假信息的治理主體、治理環(huán)節(jié)及治理措施概括為圖1。

總的來說,現(xiàn)有的以《網(wǎng)絡(luò)信息內(nèi)容生態(tài)治理規(guī)定》為基礎(chǔ)構(gòu)建的網(wǎng)絡(luò)虛假信息治理體系在宏觀治理框架方面已經(jīng)相對完善,也基本覆蓋到相關(guān)主體和信息生產(chǎn)、信息傳播以及信息影響等環(huán)節(jié)。然而在治理規(guī)范的針對性層面,如《互聯(lián)網(wǎng)深度合成服務(wù)管理辦法》(以下簡稱“《辦法》”)〖ZW(1B〗2022年11月11日,《互聯(lián)網(wǎng)信息服務(wù)深度合成管理規(guī)定》由國家網(wǎng)信辦、工信部、公安部聯(lián)合發(fā)布,自2023年1月10日起施行。)直接指向人工智能深度合成虛假信息源頭生產(chǎn)的治理規(guī)范還比較少,《辦法》在第二章第六條只做了籠統(tǒng)的規(guī)定:“任何組織和個人不得利用深度合成服務(wù)制作、復(fù)制、發(fā)布、傳播法律、行政法規(guī)禁止的信息,不得利用深度合成服務(wù)從事危害國家安全和利益、損害國家形象、侵害社會公共利益、擾亂經(jīng)濟和社會秩序、侵犯他人合法權(quán)益等法律、行政法規(guī)禁止的活動。深度合成服務(wù)提供者和使用者不得利用深度合成服務(wù)制作、復(fù)制、發(fā)布、傳播虛假新聞信息。轉(zhuǎn)載基于深度合成服務(wù)制作發(fā)布的新聞信息的,應(yīng)當(dāng)依法轉(zhuǎn)載互聯(lián)網(wǎng)新聞信息稿源單位發(fā)布的新聞信息”。《辦法》沒有對深度合成服務(wù)中的基礎(chǔ)數(shù)據(jù)來源、數(shù)據(jù)質(zhì)量、數(shù)據(jù)合成算法進行規(guī)范。而其他規(guī)范在應(yīng)對生成式人工智能下虛假信息治理方面還缺乏針對性。在治理對象的覆蓋范圍上,現(xiàn)行治理規(guī)范只規(guī)制屬于違法信息、不良信息和虛假新聞的虛假信息,而沒有覆蓋到人工智能生成的純粹事實虛假信息,如虛假健康信息、虛假學(xué)術(shù)信息等。因此,在既有虛假信息治理體系中,生成式人工智能引發(fā)的虛假信息問題難以得到有效治理,還需要進一步解決。

(二)面向生成式人工智能的虛假信息治理困境

生成式人工智能技術(shù)對虛假信息生產(chǎn)效率、虛假性識別難度的提高以及其作為知識基礎(chǔ)設(shè)施表面的虛假權(quán)威性,不僅放大了傳統(tǒng)虛假信息的風(fēng)險隱患,而且引發(fā)新的信息信任風(fēng)險和平臺虛假信息治理防線被突破的風(fēng)險。然而生成式人工智能技術(shù)的積極價值也要保護,因此,在生成式人工智能時代下,虛假信息的治理目標(biāo)在于實現(xiàn)人工智能科技創(chuàng)新與虛假信息隱患的平衡,盡全力將虛假信息隱患控制在合理范圍。而從虛假治理規(guī)劃的角度講,應(yīng)做好事前人工智能虛假信息的源頭生成控制、事中虛假信息傳播的阻斷和事后虛假信息影響的消除等工作,而根據(jù)生成式人工智能的技術(shù)特性和事后修復(fù)虛假信息損害成本的考量,虛假信息治理的重點應(yīng)放在事前虛假信息生成的監(jiān)管和事中傳播環(huán)節(jié)虛假信息的阻斷,當(dāng)然事后修復(fù)影響的責(zé)任追究和辟謠工作也要進行相應(yīng)強化。因此,實現(xiàn)生成人工智能下虛假信息的治理,需要根據(jù)生成人工智能下虛假信息風(fēng)險隱患的特殊性,從治理薄弱點出發(fā),構(gòu)建與生成式人工智能場景下虛假信息風(fēng)險水平相匹配的治理體系。

但是,既有網(wǎng)絡(luò)虛假信息治理體系在面對ChatGPT等生成式人工智能技術(shù)方?jīng)_擊下面臨困局,主要體現(xiàn)在治理對象、治理規(guī)劃以及治理主體三個方面。在治理對象層面上,生成式人工智能使得虛假信息治理的范圍擴張,而既有治理體系沒有涵蓋可能引發(fā)風(fēng)險隱患的全部虛假信息。根據(jù)《網(wǎng)絡(luò)信息內(nèi)容生態(tài)治理規(guī)定》《互聯(lián)網(wǎng)深度生成服務(wù)管理辦法》《互聯(lián)網(wǎng)信息服務(wù)算法推薦管理規(guī)定》《網(wǎng)絡(luò)音視頻信息服務(wù)管理規(guī)定》等規(guī)范,既有治理體系范圍內(nèi)的虛假信息僅包括違法信息、不良信息、虛假新聞,而沒涵蓋虛假健康信息、虛假學(xué)術(shù)信息以及偏見和歧視信息等事實虛假信息。以往事實虛假信息多由不法分子為了特定目的而刻意偽造,例如編造用鐵鍋炒菜能補充鐵元素等虛假信息來銷售鐵鍋等,而不會無目的地去偽造單純事實虛假信息,而生成式人工智能由于自身智能缺陷卻會不基于功利目的地去生產(chǎn)這些純粹虛假和違反常識的信息,因此生成式人工智能場景下需要治理的虛假信息范圍更為寬泛,如果采用同樣的治理標(biāo)準(zhǔn),則會產(chǎn)生不合理地增加企業(yè)合規(guī)成本、阻礙技術(shù)創(chuàng)新以及侵犯個體信息發(fā)布自由等問題,因此,應(yīng)該綜合考慮信息類型、信息領(lǐng)域以及風(fēng)險程度進行分類分級治理。在治理規(guī)劃層面上,生成式人工智能使得源頭信息生產(chǎn)環(huán)節(jié)成為治理重點,既有治理體系在源頭治理方面力度不足,具體體現(xiàn)在生成式人工智能的監(jiān)管缺位。[17]以ChatGPT為代表的生成式人工智能之所以會產(chǎn)生虛假信息,除了人為操縱之外,還與其內(nèi)在算法缺陷以及訓(xùn)練數(shù)據(jù)質(zhì)量不高、語料庫不能及時更新等有關(guān)。生成式人工智能的治理除了要對傳播環(huán)節(jié)進行治理之外,還要回到生成人工智能規(guī)范本身,促使人工智能企業(yè)優(yōu)化算法以及提高訓(xùn)練數(shù)據(jù)的質(zhì)量來盡力減少不必要的錯誤。即便如此,也不可能將全部的錯誤問題解決,還需要人工智能服務(wù)提供者在可能的范圍之內(nèi)配合傳播環(huán)節(jié)虛假信息的治理,如添加數(shù)字水印等。整體來說,既有對人工智能企業(yè)算法治理、訓(xùn)練數(shù)據(jù)質(zhì)量管理以及配合后續(xù)治理的規(guī)范并非絕對欠缺,但都缺乏直接相關(guān)性。如,2022年3月1日施行的《互聯(lián)網(wǎng)信息服務(wù)算法推薦管理規(guī)定》,盡管對生成合成類的算法推薦技術(shù)進行了規(guī)范,但是并沒有直接從源頭對算法訓(xùn)練數(shù)據(jù)、算法缺陷等進行規(guī)制;《互聯(lián)網(wǎng)深度生成服務(wù)管理辦法》中規(guī)定:深度合成服務(wù)提供者和技術(shù)支持者應(yīng)當(dāng)加強訓(xùn)練數(shù)據(jù)管理,采取必要措施保障訓(xùn)練數(shù)據(jù)安全;訓(xùn)練數(shù)據(jù)包含個人信息的,應(yīng)當(dāng)遵守個人信息保護的有關(guān)規(guī)定。但是此處并沒有直接涉及訓(xùn)練數(shù)據(jù)的質(zhì)量、可信度等方面的問題。當(dāng)然,2023年8月公布的《生成式人工智能服務(wù)管理暫行辦法》主要規(guī)定了生成式人工智能服務(wù)提供者的責(zé)任,但是后續(xù)治理的措施并不完備,傳播平臺責(zé)任者、服務(wù)使用者相關(guān)的責(zé)任并不明確,而且缺乏相應(yīng)的懲罰措施。在治理主體的協(xié)同性方面,現(xiàn)有治理模式?jīng)]有構(gòu)建起責(zé)任明確、協(xié)作有效的生成式人工智能場景下的虛假信息治理機制。生成人工智能場景下的虛假信息從產(chǎn)生到傳播會涉及多方主體,而不同主體應(yīng)該負有相應(yīng)責(zé)任,但由于缺乏明確的責(zé)任劃定和協(xié)同義務(wù)過于寬泛,因而治理主體在治理職責(zé)的履行效果上很難保證。比如,法律只是抽象地規(guī)定監(jiān)管機關(guān)有監(jiān)管職責(zé),網(wǎng)絡(luò)服務(wù)提供者有防止生成、傳播虛假信息的義務(wù),而如何具體履行防范義務(wù)以及采取何種措施沒有細化規(guī)定。又如,應(yīng)對生成式人工智能給虛假信息治理的沖擊,有關(guān)主體(如網(wǎng)信、電信、公安等部門)之間需要進行必要的信息溝通、事務(wù)協(xié)調(diào)以及聯(lián)合行動,但目前尚缺乏相應(yīng)的協(xié)調(diào)機制。因此,在虛假信息的治理上難免相互推諉,甚至即便部分主體(如公安機關(guān)、國家安全機關(guān)等部門)有心治理,但由于缺乏相應(yīng)的協(xié)調(diào)機制其努力也因其他方面的掣肘而不能取得實效。此時,應(yīng)該反思既有的虛假信息治理體系,根據(jù)人工智能對虛假信息治理的挑戰(zhàn)來采取應(yīng)對措施,實現(xiàn)多元主體的治理協(xié)同。

(三)生成式人工智能技術(shù)下虛假信息治理的改進方向

面對生成式人工智能技術(shù)帶來虛假信息治理難題,既有虛假信息治理體系對生成人工智能場景下的虛假信息生產(chǎn)能力和風(fēng)險隱患的特殊性缺乏有效的回應(yīng),因而需要進一步優(yōu)化。以往虛假信息帶來的問題主要還是謠言誹謗、虛假新聞以及虛假信息攻擊,而且數(shù)量還停留在相對可控的范圍,只要強化對傳播各環(huán)節(jié)的把控,就能將虛假信息的影響控制在合理范圍之內(nèi)。既有治理體系之所以面對生成式人工智能會陷入困局,其原因在于現(xiàn)有治理對生成人工智能技術(shù)生成虛假信息的特性回應(yīng)能力不足。詳言之,正因為生成式人工智能無中生有、生成速度快的特性才使得需要治理的虛假信息類型增加、數(shù)量膨脹,進而才引發(fā)治理對象擴張的問題,也因其生成信息效率的革命性提高才使得信息生產(chǎn)環(huán)節(jié)的人工智能監(jiān)管成為治理的中心,才使得不同治理主體的協(xié)同性需要調(diào)整,以此來適應(yīng)治理需要。因此,既有治理體系的改進思路也應(yīng)以生成式人工智能的技術(shù)特性和影響為基礎(chǔ)來展開。詳言之,首先,應(yīng)重視違法信息、不良信息以及虛假新聞之外的虛假信息的治理,以遏制因治理疏漏而引發(fā)的信息信任等風(fēng)險的現(xiàn)實化。其次,應(yīng)增強生成式人工智能本身的治理,生成式人工智能產(chǎn)生虛假信息受其算法、訓(xùn)練數(shù)據(jù)、人工標(biāo)注等因素的影響,如果只是簡單去規(guī)定人工智能企業(yè)防止虛假信息生成的義務(wù)而不將治理的觸角伸進人工智能治理,那么虛假信息的治理就只是隔靴搔癢。最后,應(yīng)根據(jù)生成式人工智能下虛假信息生成速度快、體量大、逼真程度高的特征對虛假信息不同治理環(huán)節(jié)的治理主體、治理規(guī)范、治理措施提出新要求,對整個虛假信息的治理體系進行全過程、全鏈條優(yōu)化。

三、生成式人工智能場景下虛假信息的治理對策

生成式人工智能技術(shù)的進展使得虛假信息風(fēng)險發(fā)生了深刻變化,不僅傳統(tǒng)虛假信息風(fēng)險被放大,信息信任風(fēng)險成為重要風(fēng)險類型,還加劇了社交平臺虛假信息治理防線被突破的風(fēng)險,因此對這些風(fēng)險進行應(yīng)對已經(jīng)成為生成式人工智能場景下不可回避的問題。為有效應(yīng)對這些風(fēng)險隱患,可從虛假信息的分類分級治理、虛假信息的生產(chǎn)源頭治理以及治理主體的協(xié)同治理方面著手推進生成式人工智能場景下虛假信息的治理,進而疏解既有虛假信息治理體系在面對生成式人工智能沖擊而遭遇的困局。

(一)推進虛假信息的分級治理

面對生成式人工智能技術(shù)引發(fā)虛假信息治理對象范圍的擴充以及數(shù)量的急劇增加,務(wù)實的做法是對虛假信息進行分類分級治理,根據(jù)虛假信息損害法益的重要性和可能產(chǎn)生的危險性賦予治理主體差異化的治理責(zé)任,進而實現(xiàn)治理效果與治理成本的平衡。為實現(xiàn)分級治理,應(yīng)從規(guī)范依據(jù)、分類分級指引、部署推進策略等方面來推進分級治理。

第一,應(yīng)由監(jiān)管機關(guān)明確規(guī)定虛假信息分類分級治理的要求,使得分級分類治理有法可依。分類分級治理的理念在數(shù)據(jù)治理[18]、個人信息保護[19]方面已得到貫徹并取得階段性進展,而虛假信息分類分級還沒有明確的規(guī)范依據(jù),但《網(wǎng)絡(luò)信息內(nèi)容生態(tài)治理規(guī)定》將信息區(qū)分為違法信息、不良信息并規(guī)定差異化義務(wù)的做法已經(jīng)體現(xiàn)了虛假信息內(nèi)容分級治理的理念。為了使分類分級有明確的法律依據(jù),同時考慮到分級治理制度還處于初創(chuàng)期,因此可由中央網(wǎng)信辦在有關(guān)虛假治理規(guī)范中先做出原則性規(guī)定,以便給后續(xù)推行留下制度空間,但其中要包括內(nèi)容分級原則性標(biāo)準(zhǔn)和差異化設(shè)置治理主體義務(wù)和法律責(zé)任等內(nèi)容,以構(gòu)建起分級治理的基本法律框架。

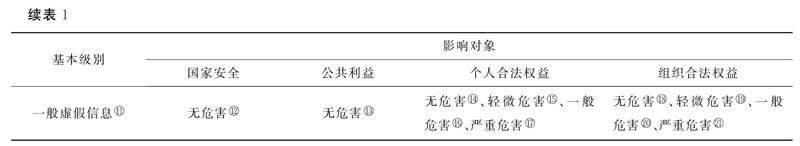

第二,應(yīng)重視制定具有可操作性的虛假信息內(nèi)容分類分級規(guī)范指引。科學(xué)且有可操作性的信息內(nèi)容分類分級指引是落實虛假信息分類分級治理的先決條件和重要依托。[20]為確保該指引具有可操作性,在制定參與主體方面,應(yīng)參考《網(wǎng)絡(luò)數(shù)據(jù)分類分級指引》的制定過程,吸納有關(guān)領(lǐng)域的監(jiān)管機關(guān)、人工智能產(chǎn)業(yè)協(xié)會、社交平臺企業(yè)行業(yè)協(xié)會以及不同行業(yè)的研究機構(gòu)和專業(yè)人士共同參與,以吸取各方面智慧和經(jīng)驗來提高可執(zhí)行性。在虛假信息內(nèi)容分級指引參考標(biāo)準(zhǔn)上,可參考《網(wǎng)絡(luò)安全標(biāo)準(zhǔn)實踐指南》〖ZW(2B〗關(guān)于發(fā)布《網(wǎng)絡(luò)安全標(biāo)準(zhǔn)實踐指南——網(wǎng)絡(luò)數(shù)據(jù)安全風(fēng)險評估實施指引》的通知,https://www.tc260.org.cn/upload/2021-12-31/1640948142376022576.pdf。)的規(guī)定,綜合考慮虛假信息的危害程度、影響對象、影響程度因素來確定虛假信息的風(fēng)險等級。根據(jù)虛假信息對國家安全、公共利益或者個人、組織合法權(quán)益造成的危害程度,將其從低到高分成一般、重大、危險三個級別,根據(jù)所損害法益的類型影響對象可區(qū)分為國家安全、公共利益、組織利益以及個人利益四種,而影響程度可分嚴重、一般、輕微和無影響四個等級(參見表1)。考慮到國家安全、公共利益的重要性,即便對其僅有輕微影響也可以定為更高等級,而僅對個人、組織權(quán)益產(chǎn)生影響的虛假信息即便有嚴重影響也可能被定為相對較低的等級。如,捏造某人殺人的謠言,相比造謠明天將施行交通管制的情形,后者涉及了不特定多數(shù)人的公共利益,盡管對公共利益有輕微影響,可以將后者定位更高級,因為這種謠言需要及時糾正,涉及的群體比較大,而前者針對的是個體,即使產(chǎn)生嚴重后果,也不產(chǎn)生更大危害,所以定為較低級別。

第三,應(yīng)遵循“先試點后推行”虛假信息分級治理推進思路。監(jiān)管機關(guān)和符合條件的企業(yè)可先行開展分級治理試點,對分類分級規(guī)范指引、差異化義務(wù)設(shè)置和分類監(jiān)管措施的實施效果進行檢驗,并為后續(xù)改進提供參考經(jīng)驗。為確保試點效果,首先要制訂詳細的試點規(guī)劃,對測試周期、測試指標(biāo)、測試結(jié)果評價、治理成本、保障機制、監(jiān)督機制、網(wǎng)絡(luò)用戶權(quán)益保護等方面做出全面規(guī)定。其次,試點期間對參與試點的生成式人工智能企業(yè)、社交平臺企業(yè)等主體給予特定的監(jiān)管優(yōu)待和財政補貼,調(diào)動企業(yè)參與試點的積極性。最后,要做好試點經(jīng)驗總結(jié)工作,對試點過程中的積極成果及時進行總結(jié),將其作為分類分級規(guī)范指引、義務(wù)規(guī)范設(shè)置和監(jiān)管措施調(diào)整的依據(jù)。

(二)強化虛假信息的源頭治理

生成式人工智能對整個虛假信息治理鏈條的直接沖擊體現(xiàn)在信息生產(chǎn)環(huán)節(jié),因此,虛假信息治理應(yīng)強化源頭治理才能實現(xiàn)治理效能最大化。而人工智能產(chǎn)生錯誤信息除受人操縱外,還受其模型算法的局限性、預(yù)訓(xùn)練數(shù)據(jù)質(zhì)量以及人工標(biāo)注質(zhì)量的影響。[21]因此,從根本上遏制虛假信息,除了規(guī)范網(wǎng)絡(luò)用戶使用網(wǎng)絡(luò)行為、運用民法、刑法在事后打擊濫用人工智能行為外,還要強化人工智能本身的治理來控制人工智能本身的虛假信息生成和提供。

第一,應(yīng)對生成式人工智能應(yīng)用領(lǐng)域設(shè)置準(zhǔn)入負面清單,暫時禁止其進入如科研、教學(xué)、醫(yī)療等可能引發(fā)高風(fēng)險的領(lǐng)域。暫時禁止生成式人工智能進入科研、教學(xué)、醫(yī)療等領(lǐng)域,可以避免其帶來的不確定性風(fēng)險,如避免學(xué)生學(xué)術(shù)誠信的擔(dān)憂、深度虛假信息生成,也可以避免醫(yī)學(xué)領(lǐng)域過度依賴人工智能可能造成不良預(yù)測事件、個人醫(yī)療信息泄露等。[22]與此同時,禁止生成式人工智能在這些領(lǐng)域的應(yīng)用也會阻礙新技術(shù)的發(fā)展,不利于我國生成式人工智能技術(shù)的發(fā)展,阻礙科技創(chuàng)新。因此,相比于意大利禁止生成式人工智能ChatGPT應(yīng)用的政策而言,意大利宣布禁用ChatGPT,限制OpenAI處理本國用戶信息,https://www.thepaper.cn/newsDetail_forward_22539065。)我國應(yīng)該保持政策的彈性,在目前生成式人工智能風(fēng)險不明的情況下,對其設(shè)置準(zhǔn)入負面清單,暫時禁止其進入某些領(lǐng)域,待到技術(shù)成熟時再全面放開。同時,我國要加大生成式人工智能的研發(fā),不能因此錯失生成式人工智能的發(fā)展機遇。從目前來看,生成式人工智能的代表ChatGPT在智能回答上已經(jīng)表現(xiàn)出類人性特征,但因其算法、訓(xùn)練數(shù)據(jù)及人工標(biāo)注的原因,其不可能成為知識基礎(chǔ)設(shè)施,而只是對已有信息進行加工和合成。盡管將其應(yīng)用在科研領(lǐng)域及教育等領(lǐng)域可能會產(chǎn)生很多難以控制的隱患,如影響認知塑造、科研誠信進而沖擊人類的知識根基。但如果將其應(yīng)用在電商領(lǐng)域以及政務(wù)問答等有相對固定模板的領(lǐng)域,則能起到提高生產(chǎn)力的功效,因此應(yīng)對其應(yīng)用領(lǐng)域進行限制。

第二,積極利用好算法備案審查制度抓手,通過細化和完善備案審查制度來督促生成式人工智能企業(yè)優(yōu)化算法模型并對明顯虛假的信息進行過濾。算法備案是國家機關(guān)實施算法治理、推進數(shù)字治理現(xiàn)代化的重要抓手。[23]實現(xiàn)虛假信息治理首先要修改算法備案的適用范圍,目前算法備案僅對具有輿論屬性與社會動員能力的算法適用,目前新出臺的《生成式人工智能服務(wù)管理暫行辦法》也沒有規(guī)定其他類型的生成式人工智能算法需要備案。因此,首先,將高風(fēng)險的生成式人工智能類算法納入其中,算法分級從算法可能引發(fā)的風(fēng)險入手,將個人權(quán)益、公共利益與國家安全納入考慮范圍,可以劃分為高風(fēng)險、中風(fēng)險和低風(fēng)險算法。參見陳兵,董思琰.分類分級治理算法的基本內(nèi)涵及實踐進路[J].西安財經(jīng)大學(xué)學(xué)報,2023,(6):70-79.)不管算法是否具有輿論屬性與社會動員能力;其次,細化和擴充備案內(nèi)容,將是否采取措施對虛假信息進行過濾或者反制以及其實際阻止效果作為審查內(nèi)容;再次,強化算法備案后的審查力度,并將通過備案審查作為算法投入使用的前置條件,避免備案流于形式。[24]最后,將提交備案審查的材料如虛假信息控制報告、治理承諾書等,將其作為后續(xù)追責(zé)的依據(jù),如果已經(jīng)備案的算法模型在后續(xù)使用中出現(xiàn)的風(fēng)險影響范圍、反制措施效果與備案內(nèi)容描述有明顯差距,應(yīng)及時撤銷備案并啟動備案造假的追責(zé)程序,進而強化備案審查的效果。

第三,應(yīng)積極推動監(jiān)管機關(guān)和人工智能產(chǎn)業(yè)協(xié)會在充分協(xié)商基礎(chǔ)上制定可供執(zhí)行的訓(xùn)練數(shù)據(jù)質(zhì)量管理規(guī)范,引導(dǎo)人工智能企業(yè)提高訓(xùn)練數(shù)據(jù)的質(zhì)量,將因訓(xùn)練數(shù)據(jù)原因?qū)е碌奶摷傩畔㈠e誤控制在合理范圍。在訓(xùn)練數(shù)據(jù)庫的選擇上,應(yīng)要求人工智能企業(yè)對該數(shù)據(jù)庫中可能隱含的虛假信息的比例和對模型訓(xùn)練的影響進行整體性評估,如果該數(shù)據(jù)庫虛假信息數(shù)據(jù)占比過高且會導(dǎo)致虛假信息輸出風(fēng)險極高,就應(yīng)要求將其排除在訓(xùn)練數(shù)據(jù)之外。在選定可用于訓(xùn)練的數(shù)據(jù)庫之外,應(yīng)要求企業(yè)采取人工或者技術(shù)手段對數(shù)據(jù)庫的虛假信息盡最大可能進行清洗,究竟應(yīng)達到何種法律強制標(biāo)準(zhǔn)應(yīng)由監(jiān)管機關(guān)和產(chǎn)業(yè)協(xié)會進行協(xié)商,以保證標(biāo)準(zhǔn)的可行性。監(jiān)管機關(guān)在制定法律強制性之前應(yīng)該積極與產(chǎn)業(yè)協(xié)會開展聽證會,聽取專家學(xué)者、產(chǎn)業(yè)公司代表的意見。此外,產(chǎn)業(yè)協(xié)會應(yīng)積極制定行業(yè)標(biāo)準(zhǔn),在行業(yè)標(biāo)準(zhǔn)的基礎(chǔ)上建立強制性國家標(biāo)準(zhǔn),并以國務(wù)院部門規(guī)章的形式發(fā)布。

(三)增強虛假信息的協(xié)同治理

生成式人工智能場景下虛假信息生產(chǎn)的影響會傳導(dǎo)到整個虛假信息治理鏈條,因此需要增強不同治理主體之間的協(xié)同性來強化治理效能。

第一,應(yīng)設(shè)置監(jiān)管機關(guān)“義務(wù)型”責(zé)任清單,注重監(jiān)管機關(guān)的力量整合,強化監(jiān)管機關(guān)的協(xié)同性,使監(jiān)管力量得到充分釋放,從而營造虛假信息治理的良好外部環(huán)境。監(jiān)管者負有營造遏制虛假信息生態(tài)環(huán)境的重要責(zé)任,必須要通過壓實責(zé)任和強化協(xié)同來營造遏制虛假信息的良好外部環(huán)境。首先,應(yīng)制定監(jiān)管“義務(wù)型”責(zé)任清單,倒逼監(jiān)管機關(guān)履行職責(zé)。責(zé)任的最初內(nèi)涵是做好分內(nèi)之事,[25]因此可通過責(zé)任清單來明確監(jiān)管機關(guān)的職責(zé)。同時責(zé)任清單要根據(jù)實際情況來進行科學(xué)制定,避免難以落地。責(zé)任清單應(yīng)該主要包括生成式類算法機制機理風(fēng)險性評估、虛假信息檢測定期報告、虛假信息處理結(jié)果公告等。責(zé)任清單應(yīng)貫徹到監(jiān)管內(nèi)容從產(chǎn)生、傳播、影響及處理等整個環(huán)節(jié)。其次,應(yīng)由對互聯(lián)網(wǎng)虛假信息治理負有主體責(zé)任的網(wǎng)信部門牽頭有關(guān)監(jiān)管部門來搭建虛假信息治理協(xié)同平臺、制定協(xié)調(diào)行動細則和銜接程序,最好借助已有的電子政務(wù)平臺來提高協(xié)作效率。

第二,應(yīng)積極應(yīng)用行業(yè)規(guī)約、平臺管理規(guī)約、用戶服務(wù)協(xié)議等軟法工具來實現(xiàn)治理義務(wù)的細化,使得人工智能企業(yè)、社交媒體平臺、網(wǎng)絡(luò)用戶有更加可具操作性的行動指南。首先,可應(yīng)用行業(yè)規(guī)約工具來將抽象的法律義務(wù)細化,將法律義務(wù)轉(zhuǎn)化為對人工智能企業(yè)、社交平臺企業(yè)內(nèi)控制度、治理措施、治理標(biāo)準(zhǔn)等方面的具體要求,為企業(yè)在實際運營過程中落實責(zé)任提供指引。其次,社交媒體平臺應(yīng)在其平臺管理規(guī)約落實治理虛假信息的義務(wù),詳細規(guī)定平臺對虛假信息的定義、虛假信息的舉報、投訴及處理機制、分級管理措施、違規(guī)行為的平臺懲戒(如凍結(jié)、注銷賬號等措施)等,將平臺的法律義務(wù)轉(zhuǎn)化為具體的治理行動。最后,應(yīng)發(fā)揮用戶協(xié)議對用戶的自律約束,將不得利用生成式人工智能生成虛假信息、不得發(fā)布和傳播未經(jīng)查證的人工智能生成信息納入用戶協(xié)議規(guī)定,并規(guī)定違反有關(guān)規(guī)定可能產(chǎn)生的平臺懲戒以及法律責(zé)任。為確保用戶了解有關(guān)協(xié)議,可采用各種舉措,如醒目提示、協(xié)議內(nèi)容考試等手段方法進行提醒。

第三,應(yīng)建立由監(jiān)管機關(guān)、人工智能產(chǎn)業(yè)協(xié)會、網(wǎng)絡(luò)平臺行業(yè)協(xié)會、重點企業(yè)代表、有關(guān)專家和其他人士組成的虛假信息治理協(xié)調(diào)機制。虛假信息治理的協(xié)同性除了要細化各自職責(zé)外,還需要彼此之間信息互通、工作協(xié)調(diào)、資源共享和良性互動。通過設(shè)置協(xié)調(diào)機制可以及時了解各個主體在虛假信息治理方面的進展、遇到的實際困難以及需要何種配合,進而形成治理主體之間對虛假信息治理的合力,提高對生成式人工智能虛假信息的治理效能。例如,對于虛假信息的重要措施之一就是對人工智能生成信息進行標(biāo)注,而為了不影響用戶使用,人工智能企業(yè)添加的標(biāo)識可能需要利用技術(shù)才能加以識別,對此社交平臺企業(yè)可通過和人工智能企業(yè)合作來獲取標(biāo)識的技術(shù)原理,以提高對生成消息的識別效率。

四、結(jié)語

生成式人工智能改變了傳統(tǒng)的信息生產(chǎn)機制而有廣闊的應(yīng)用場景,但其生成虛假信息速度快、逼真度高、無中生有的特征,使得虛假信息風(fēng)險樣態(tài)發(fā)生了改變,不僅放大了傳統(tǒng)的風(fēng)險隱患,還使得信息信任風(fēng)險成為虛假信息的重要風(fēng)險類型,也使得社交媒體平臺虛假信息治理防線有被全面突破的風(fēng)險。盡管如同ChatGPT那般強大的生成式人工智能在我國還沒有得到普遍應(yīng)用,但其引發(fā)的虛假信息風(fēng)險已經(jīng)顯現(xiàn),而且隨著生成式人工智能技術(shù)的快速發(fā)展將很快成為我國必須面對之問題。對此,既有虛假信息治理體系面臨虛假信息數(shù)量類型、數(shù)量的擴張、信息生成環(huán)節(jié)治理壓力增加、治理主體協(xié)同性不強等挑戰(zhàn),因此本文從虛假信息分級治理、源頭治理、協(xié)同治理方面為應(yīng)對上述挑戰(zhàn)提供了治理對策。但本文提供的對策能否在實踐中發(fā)揮預(yù)期效果還有待在治理實踐中根據(jù)具體情況進行細化和進一步修正,比如企業(yè)如何通過內(nèi)控制度來具體落實分級治理的要求還需要細化研究。除此之外,治理體系方面的改進只是虛假信息治理效能提升的重要部分而不是全部,因此,虛假信息的治理還需要推進相關(guān)反制技術(shù)研究的提升。

參考文獻:

[1] Paul, Justin, Akiko Ueno, et al. ChatGPT and consumers:benefits, pitfalls and future research agenda[J].International Journal of Consumer Studies,2023,47(4):1213-1225.

[2] Mich, L., Garigliano, R. ChatGPT for e-Tourism: a technological perspective[J]. Inf Technol Tourism, 2023, (25):1-12.

[3] Farrokhnia, Mohammadreza. A SWOT analysis of ChatGPT:implications for educational practice and research[J].Innovations in Education and Teaching International,2023,(5): 1-15.

[4] 馮雨奐.ChatGPT在教育領(lǐng)域的應(yīng)用價值、潛在倫理風(fēng)險與治理路徑[J].思想理論教育,2023,(4):26-32.

[5] 游俊哲.ChatGPT類生成式人工智能在科研場景中的應(yīng)用風(fēng)險與控制措施[J].情報理論與實踐,2023,46(6):24-32.

[6] 劉霞.生成式AI或致虛假信息野蠻生長[N].科技日報,2023-06-13(04).

[7] Marsden C,Meyer T,Brown I. Platform values and democratic elections :how can the law regulate digital disinformation?[J]. Computer Law & Security Review,2020,36:105373 .

[8] 舒洪水,彭鵬.ChatGPT場景下虛假信息的法律風(fēng)險與對策[J].新疆師范大學(xué)學(xué)報(哲學(xué)社會科學(xué)版),2023,44(5):124-129.

[9] 罕山.ChatGPT寫假新聞,謠言該如何止于“智”者?[EB].https://k.sina.com.cn/article_5328858693_13d9fee4502001mky0.html, 2023-02-18/2023-04-25.

[10] 任文科.ChatGPT有可能攪亂美國大選[EB].https://mp.weixin.qq.com/s/4A8ajTIsmuCw6fKmEsr8Ug,2023-04-24/2023-04-26.

[11] 李志偉.美國實施“隱秘影響行動”炮制虛假信息[N].人民日報,2023-01-17(17).

[12] 吉磊,李大琨.ChatGPT技術(shù)潛在的政治安全風(fēng)險[N].中國社會科學(xué)報,2023-03-29(08).

[13] 胡耕碩.被AI造謠找誰算賬?澳洲一市長擬起訴ChatGPT誹謗[EB].https://m.mp.oeeee.com/a/BAAFRD00002023041478 4192.html,2023-04-14/2023-04-24.

[14] 騰訊網(wǎng).又涉嫌造謠!ChatGPT編造法學(xué)教授性騷擾[EB].https://new.qq.com/rain/a/20230408A007TI00.html,2023-04-08/2023-04-25.

[15]? Cotton, Debby R E, Peter A. Cotton, & J. Reuben Shipway. Chatting and cheating:ensuring academic integrity in the era of ChatGPT[J].Innovations in Education and Teaching International,2023: 1-12.

[16] 陳小燕,任書麗.社交媒體虛假信息的治理:基于平臺社會的視角[J].新聞傳播,2022,(20):15-17.

[17] 畢文軒.生成式人工智能的風(fēng)險規(guī)制困境及其化解:以ChatGPT的規(guī)制為視角[J].比較法研究,2023,(3):155-172.

[18] 王玎.論數(shù)據(jù)處理者的數(shù)據(jù)安全保護義務(wù)[J].當(dāng)代法學(xué),2023,37(2):40-49.

[19] 童云峰.證立與提倡:讀者個人信息的民法分類分級保護[J].現(xiàn)代情報,2021,41(12):97-106.

[20] 唐要家,唐春暉.網(wǎng)絡(luò)信息內(nèi)容治理的平臺責(zé)任配置研究[J].財經(jīng)問題研究,2023,(6):59-72.

[21] 莫祖英,盤大清,劉歡,等.信息質(zhì)量視角下AIGC虛假信息問題及根源分析[J].圖書情報知識,2023,40(4):32-40.

[22] 李川,楊勝剛.法益重塑與模式更新:場景化視域下個人信息刑法保護的動態(tài)轉(zhuǎn)向[J].廣西大學(xué)學(xué)報(哲學(xué)社會科學(xué)版),2023,(6):105-117.

[23] 張吉豫.論算法備案制度[J].東方法學(xué),2023,(2):86-98.

[24] 劉艷紅.生成式人工智能的三大安全風(fēng)險及法律規(guī)制——以ChatGPT為例[J].東方法學(xué),2023,(4):29-43.

[25] 劉啟川.“依清單行政”之辨正[J].法學(xué),2022,(12):52-64.

A Perspective on the Particularity of False Information Risks and Solutions under the Scenario of Generative Artificial Intelligence

Liu Chaomin

(Law School, Ocean University of China, Qingdao 266100, China)

Abstract: Generative artificial intelligence has changed the traditional information production mechanism and has a wide range of applications. However, its characteristics such as fast generation of false information, high fidelity and sheer fabrication of false information not only increase the traditional hidden dangers of false information, but also make information trust risk? an important risk type of false information. It also puts the defensive line of social media platforms false information governance at risk of being completely broken through. Therefore, based on the challenge of generative artificial intelligence to the false information governance system, we should promote the hierarchical governance of false information from the aspects of normative basis, classification and deployment of false information. We should strengthen the control of false information source from the aspects of application access, algorithm governance and training data quality management. We should enhance the collaborative governance of false information from the aspects of regulatory coordination, obligation specification and public-private collaboration.

Key words: generative artificial intelligence; false information; classification; source governance; collaborative governance

責(zé)任編輯:高 雪

收稿日期:2023-04-19

作者簡介:劉超民(1993- ),男,河北樂亭人,中國海洋大學(xué)法學(xué)院博士研究生,專業(yè)方向為網(wǎng)絡(luò)空間法。

①2022年ll月11日,《互聯(lián)網(wǎng)信息服務(wù)深度合成管理規(guī)定》由國家網(wǎng)信辦、工信部、公安部聯(lián)合發(fā)布,白2023年1月10日起施行。

②關(guān)于發(fā)布《網(wǎng)絡(luò)安全標(biāo)準(zhǔn)實踐指南——網(wǎng)絡(luò)數(shù)據(jù)安全風(fēng)險評估實施指引》的通知,https://www.tc260.org.cniupload/2021-12-31/1640948142376022576. pdf.

③危險虛假信息,是指關(guān)系國家安全、國民經(jīng)濟命脈、重要民生、重大公共利益等的虛假信息。這里只有涉及國家安全和公共利益的虛假信息才能被歸屬為危險虛假信息這種最高級別。而且涉及國家安全的虛假信息構(gòu)成一般危害或者嚴重危害,才能歸屬于危險虛假信息,而涉及公共利益的虛假信息只有構(gòu)成嚴重危害才能歸屬于危險虛假信息。這里是為了突出強淵國家安全的重要性。

④國家安全一般危害的參考:①對政治、國土、軍事、經(jīng)濟、文化、社會、科技、網(wǎng)絡(luò)、生態(tài)、資源、核安全等構(gòu)成威脅,影響海外利益、生物、太空、極地、深海、人T智能等重點領(lǐng)域安全;②對本地區(qū)、本部門以及相關(guān)行業(yè)、領(lǐng)域生產(chǎn)、運行和經(jīng)濟利益等造成影響;③引發(fā)的級聯(lián)效應(yīng)明顯,影響范圍涉及多個行業(yè)、區(qū)域或者行業(yè)內(nèi)多個企業(yè),或者影響持續(xù)時間長,對行業(yè)發(fā)展、技術(shù)進步和產(chǎn)業(yè)生態(tài)等造成嚴重影響。

⑤國家安全嚴重危害參考:①對政治、國土、軍事、經(jīng)濟、文化、社會、科技、網(wǎng)絡(luò)、生態(tài)、資源、核安全等構(gòu)成嚴重威脅,嚴重影響海外利益、生物、太空、極地、深海、人T智能等重點領(lǐng)域安全;②對本地區(qū)、本部門以及相關(guān)行業(yè)、領(lǐng)域的重要骨干企業(yè)、關(guān)鍵信息基礎(chǔ)設(shè)施、重要資源等造成嚴重影響;③導(dǎo)致對本地區(qū)、本部門以及相關(guān)行業(yè)、領(lǐng)域大范圍停工停產(chǎn)、大面積網(wǎng)絡(luò)與服務(wù)癱瘓、大量業(yè)務(wù)處理能力喪失。

⑥公共利益嚴重危害參考:波及一個或多個省市的大部分地區(qū),引起社會動蕩,對經(jīng)濟建設(shè)有極其惡劣的負面影響。

⑦重大虛假信息,是指可能危害國家安全、公共利益的虛假信息。重大虛假信息一般不涉及個人合法權(quán)益信息和企業(yè)(組織)合法權(quán)益,但達到一定規(guī)模的有關(guān)個人的虛假信息或者基于海量個人信息加工衍生形成的虛假信息,如其非法利用可能危害國家安全、公共利益,也應(yīng)歸屬于重大虛假信息。如果虛假信息對國家安全的影響是輕微的,就歸屬于重大虛假信息,而對公共利益產(chǎn)生一般危害或者輕微危害影響,也歸屬于重大虛假信息。

⑧國家安全輕微危害參考:①對本地區(qū)、本部門以及相關(guān)行業(yè)、領(lǐng)域生產(chǎn)、運行和經(jīng)濟利益等造成輕微影響;②影響持續(xù)時間短,對行業(yè)發(fā)展、技術(shù)進步和產(chǎn)業(yè)生態(tài)等造成一般影響。

⑨公共利益一般危害參考:波及一個或多個地市的大部分地區(qū)引起社會恐慌,對經(jīng)濟建設(shè)有重大的負面影響。

⑩公共利益輕微危害參考:波及一個地市或地市以下的部分地區(qū),擾亂社會秩序,對經(jīng)濟建設(shè)有一定的負面影響。

⑩一般虛假信息,指的是可能對個人、組織合法權(quán)益造成危害,但不會危害國家安全、公共利益的虛假信息。

(12)國家安全無危害參考:對國家安全不造成影響。

⑩公共利益無危害參考:對公共利益不造成影響。

(14)個人合法權(quán)益無危害參考:對個人信息合法權(quán)益不造成影響,或僅造成微弱影響但可忽略不計。

(15)個人合法權(quán)益輕微危害參考:個人信息主體可能會遭受閑擾,但尚可以克服。如付出額外成本、無法使用應(yīng)提供的服務(wù)、造成誤解、產(chǎn)生害怕和緊張的情緒、導(dǎo)致較小的生理疾病等。

(16)個人合法權(quán)益一般危害參考:個人信息主體可能遭受較大影響,個人信息主體克服難度高,消除影響代價較大。如遭受詐騙、資金被盜用、被銀行列入黑名單、信用評分受損、名譽受損、造成歧視、被解雇、被法院傳喚、健康狀況惡化等。

(17)個人合法權(quán)益嚴重危害參考:個人信息主體可能會遭受重大的、不可消除的、可能無法克服的影響,容易導(dǎo)致白然人的人格尊嚴受到侵害或者人身、財產(chǎn)安全受到危害。如遭受無法承擔(dān)的債務(wù)、失去T作能力、導(dǎo)致長期的心理或生理疾病、導(dǎo)致死亡等。

⑩組織合法權(quán)益無危害參考:對組織合法權(quán)益不造成影響,或僅造成微弱影響但不會影響國家安全、公共利益、市場秩序或各項業(yè)務(wù)的正常開展。

⑩組織合法權(quán)益輕微危害參考:可能導(dǎo)致個別訴訟事件,或在某一時間造成部分業(yè)務(wù)中斷,使組織的經(jīng)濟利益、聲譽、技術(shù)等輕微受損。

(20)組織合法權(quán)益一般危害參考:可能導(dǎo)致組織遭到監(jiān)管部門處罰(包括一段時間內(nèi)暫停經(jīng)營資格或業(yè)務(wù)等),或者影響部分業(yè)務(wù)無法正常開展的情況,造成較大經(jīng)濟或技術(shù)損失,破壞機構(gòu)聲譽。

(21)組織合法權(quán)益嚴重危害參考:可能導(dǎo)致組織遭到監(jiān)管部門嚴重處罰(包括取消經(jīng)營資格、長期暫停相關(guān)業(yè)務(wù)等),或者影響重要/關(guān)鍵業(yè)務(wù)無法正常開展的情況,造成重大經(jīng)濟或技術(shù)損失,嚴重破壞機構(gòu)聲譽,企業(yè)面臨破產(chǎn)。

(22)意大利宣布禁用ChatGPT.限制()penAI處理本國用戶信息,https://www.thepaper.cn/newsDetail- forward一22539065。