巡檢機器人系統的軟硬件協同設計

畢逢東 周淦 張晨光 姬少英 彭良瑞 閆睿劼

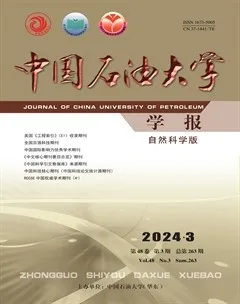

摘要:針對移動定位和目標感知兩大問題,研究軟件與硬件協同的巡檢機器人系統設計方案。在移動定位方面,設計一種結合激光雷達、單目攝像頭、慣性測量單元、GPS等多種傳感器的即時定位與地圖構建的技術方案,并采用在巡檢環境中設置二維碼路標輔助視覺定位的方法;在目標感知方面,以表計信息提取任務為例,設計一種基于深度學習的表計檢測、定位與文本識別方法。結果表明,通過引入基于5G移動通信及Wi-Fi的網絡通信功能實現了具有網絡管理平臺的巡檢機器人系統,系統達到實際應用要求,有效提升了巡檢的自動化和智能化水平。

關鍵詞:巡檢機器人; 移動定位; 目標感知; 深度學習; 文本識別

中圖分類號:TP 242 ??文獻標志碼:A

文章編號:1673-5005(2024)03-0180-08 ??doi:10.3969/j.issn.1673-5005.2024.03.020

Hardware-software co-design of inspection robot system

BI Fengdong1, ZHOU Gan2, ZHANG Chenguang2, JI Shaoying2, PENG Liangrui3,4, YAN Ruijie3,4

(1.PetroChina Natural Gas Marketing Company, Beijing 100101, China;2.Beijing Elitenect Technologies Company, Beijing 100085, China;3.Department of Electronic Engineering, Tsinghua University, Beijing 100084, China;4.Beijing National Research Center for Information Science and Technology, Beijing 100084, China)

Abstract: Aiming to two major problems of mobile positioning and object perception, the hardware-software co-design schemes of inspection robot system were explored. For the mobile positioning, a simultaneous localization and mapping strategy by combining LiDAR, monocular camera, inertial measurement unit, GPS and other sensors was designed, and an improved visual positioning scheme was introduced by using the ArUco marker road sign detection. For the object perception, taking the task of meter information extraction as an example, the deep learning based meter detection, localization and text recognition methods were adopted. The results show that, by incorporating the 5G mobile communication and Wi-Fi network communication functions, an intelligent inspection robot system with network management platform is implemented. The developed inspection robot system has met the requirements in practical applications, which effectively enhances the automation and intelligence level of inspection.

Keywords: inspection robot; mobile positioning; object perception; deep learning; text recognition

由于石油化工領域的生產場所和設備裝置存在可燃氣體和有毒氣體泄漏風險,通常以人工巡檢的方式對設備運行狀態進行監測[1],需要較多人力投入,也對人身安全帶來潛在威脅。近年來,隨著石油化工行業安全環保要求的不斷提高,并且人工成本日益增加,實現生產場所的智能化[2]、無人化管理成為趨勢。在石油化工行業中,一些機械式機器人已得到應用[3-5]。通過研發并使用地面智能巡檢機器人替代人工,可以有效提升工作效率,消除安全隱患[6]。地面智能巡檢機器人與固定攝像頭監控相比,具有靈活自主的特點。由于實際廠站環境復雜多樣,巡檢任務要求各異,研制巡檢機器人面臨兩大技術難題:移動定位與目標感知。在移動定位方面,傳統的即時定位與成圖SLAM (simultaneous localization and mapping) 技術所使用的傳感器主要包括激光雷達和攝像頭[7]。為克服特定傳感器本身的局限性,需要設計基于多傳感器融合的移動定位技術方案。在目標感知方面,對于常規的抄表作業等巡檢任務,巡檢機器人不僅需要具備目標檢測、定位與分析功能,還需要進行異常告警處理。筆者對巡檢機器人系統進行軟硬件協同設計,以目標感知中的表計信息提取任務為例,針對傳統方法[8]易受環境變化影響問題,設計一種基于深度學習的表計檢測、定位與文本識別方法,可支持機械式表計和電子式表計的示數讀取。

1 移動定位方法

1.1 基于多傳感器的移動定位

在巡檢機器人硬件配置方面,采用多種可提供位置或者運動相關信息的傳感器模塊,包括感知機器人線加速度、角速度和三軸姿態角的慣性測量單元IMU、提供機器人周圍空間深度信息的激光雷達LiDAR、用于檢測機器人周圍環境特征點的單目攝像頭、紅外熱成像傳感器[9]以及北斗衛星定位GPS等傳感器。多傳感器融合的移動定位方法流程如圖1所示,主要包括慣性測量單元、視覺定位組件、激光雷達定位組件和因子圖等。

慣性測量單元IMU對檢測到的車體線加速度和角速度進行預積分[10],預積分模塊實時輸出的位移信息分別輸入到激光雷達定位模塊與單目視覺定位模塊。IMU位姿變換信息可以用于消除因車體運動產生的點云數據幀內畸變現象,并且可以用于輔助視覺定位模塊恢復車體運動位移尺度信息以及圖像特征點的深度信息。由于單目攝像頭不能獲取三維空間中特征點與車體之間的距離,估算出來的位移可能與車體真實位移存在多種比例關系。因此可以使用IMU預積分的位移信息來恢復單目視覺定位數據與真實世界之間的比例以及圖像特征點在三維空間中的位置。

視覺定位組件分為4部分,包括視覺特征提取、深度關聯、視覺里程計和視覺回環模塊。其中深度關聯模塊的作用是獲取二維視覺特征點在三維空間下的深度信息,具體方法是將激光雷達坐標系下的點云數據變換到以相機為中心的極坐標系下,同時歸一化后的視覺特征點也映射到該極坐標系下,通過在極坐標系下搜索距離視覺特征點最近的3個激光雷達數據點構成平面,視覺特征點和相機光心構成的直線與鄰近的3個激光雷達數據點構成的平面相交,交點即為視覺特征點對應的三維空間映射點。根據視覺特征點對應的三維空間映射點與歸一化的視覺特征點之間的比例關系,可以得到視覺特征點的深度信息。視覺里程計模塊中,選取視覺關鍵幀,利用關鍵幀中的特征點、關鍵幀對應的相機位姿與IMU預積分的位移信息計算對應幀的重投影誤差,

通過非線性優化求解得到車體的位姿信息,包括三維空間位置信息和旋轉角度。視覺回環模塊通過視覺詞袋模型計算當前關鍵幀與歷史關鍵幀的相似度,檢測車體是否回到了以前到達過的位置。

激光雷達定位組件分為4部分,包括去畸變、點云特征提取、激光雷達里程計和激光雷達回環模塊。其中點云特征提取模塊通過計算數據點的曲率,將其分為角特征點和面特征點。利用視覺定位模塊提供的位姿初值,激光雷達里程計模塊中將當前時刻激光雷達特征點與上一時刻的激光雷達特征點進行匹配對齊,當兩幀數據特征點之間距離小于閾值時,更新當前車體位姿,輸出激光雷達里程計信息,包括車體三維空間位置信息和旋轉角度信息。激光雷達回環模塊通過計算當前幀點云與歷史關鍵幀點云的匹配程度,進行回環檢測。

基于單一傳感器定位得到的里程計信息存在累積誤差,需要利用概率圖模型方法進行整體優化。因子圖[11] (factor graph)是一種用于SLAM的概率圖模型。將激光雷達里程計信息、激光雷達回環信息、用于輔助視覺定位二維碼路標信息及北斗衛星定位(GPS)信息等輸入到因子圖中,因子圖使用ISAM2[12](incremental smoothing and mapping,增量平滑與建圖)算法修正定位累積誤差,更新車體位姿和地圖信息。最后,修正后的車體位姿反饋到IMU預積分模塊,更新IMU的偏置(bias),用于下一時刻的預積分。

1.2 基于二維碼路標檢測的單目視覺定位

為提高定位精度采用在巡檢環境中部署ArUco二維碼路標用于輔助視覺定位。所采用的ArUco二維碼路標實際尺寸為10 cm×10 cm。其中5 cm×5 cm的點陣塊對應唯一的路標編號,四周有一圈黑色點陣塊,有助于改進二維碼的可辨識度。利用單目攝像頭獲取圖像,提取二維碼路標角點,采用相機校準中常用的PNP (perspective-N-point)算法可求解得到單目攝像頭的位姿信息,輸入到因子圖中,用于輔助定位。

2 表計信息提取方法

以巡檢中的抄表作業為例,說明目標感知技術方案設計過程。巡檢環境中的設備一般既有機械式表計也有電子式表計,電子式表計數據可以聯網回傳。巡檢機器人在替代人工抄表作業時,通過自主導航到達表計位置附近,利用云臺上搭載的用于視覺目標感知的攝像頭獲取圖像。在圖像中首先進行目標檢測及圖像預處理,然后利用語義分割算法提取指針和刻度線,再結合文本檢測與識別結果得到表計示數,如圖2所示。

2.1 表計檢測與表盤圖像語義分割

對于表計檢測,可采用基于深度學習的目標檢測方法,采用YOLO[13]系列算法中的YOLOv5作為表計檢測網絡。對檢測到的指針式表盤區域進行圖像預處理,包括均值濾波、顏色校正以及基于自適應直方圖均衡的圖像增強,消除圖像中的噪聲干擾以及光照變化的影響。

基于深度學習的指針提取,一般利用U-Net、Deeplab等圖像分割算法,通過先驗信息獲取表計讀數[14]。本文中采用基于U-Net的指針提取方法。

對于常見的指針式表計,刻度線通常處于數字區域與回轉中心組成的扇形區域外部的附近扇環形區域中,且每個刻度數字均對應一條主刻度線。將該扇環區域的坐標由以回轉中心為原點的笛卡爾坐標系轉換到極坐標系,然后使用卷積神經網絡 (convolutional neural network, CNN)模型對刻度線進行定位。通過分析表盤上的刻度線樣式,設計如圖3所示的10層卷積神經網絡用于定位主刻度線。

該網絡主要由卷積核長寬尺寸為3×3像素的卷積層組成,卷積層的特征圖進行實例歸一化(instance normalization, IN)后,送入ReLU激活函數。網絡輸入層通道數為16,之后每兩個卷積層進行一次最大池化,通道數增加一倍,最后一次池化后,增加了一層256通道的卷積層。輸出層采用卷積核長寬尺寸為1×1像素的8通道卷積層進行降維輸出。

提取主刻度線后,依據表計的回轉中心可以確定主刻度線對應刻度示數的角度,通過利用指針附近刻度示數及對應角度,可計算出指針表示數值。通過利用文本識別獲得的物理單位信息還可確定表計讀數的物理意義。

2.2 表計文本識別

采用深度學習模型對表計圖像中的文本進行檢測與識別。文本檢測采用基于分割的DBNet網絡[15]。文本識別常用模型包括基于CNN-LSTM-CTC的結構[16]和基于注意力機制的編碼器與解碼器結構。通過分析表計文本的特點,設計了一種基于注意力機制的編碼器與解碼器結構的文本識別模型,如圖4所示。

輸入圖像后,首先對圖像進行大小歸一化,例如圖像歸一化寬度為512像素、高度為64像素。歸一化圖像送入卷積神經網絡ResNet,得到特征圖,特征圖送入編碼器得到隱含表示v。在解碼器中,利用當前解碼時間步(time step)t對應字符的嵌入表征與編碼器輸出的隱含表示計算注意力系數α(t),其中,字符嵌入表征在訓練階段采用文本真值進行計算,在推理階段采用解碼器預測文本進行計算。利用注意力系數對編碼器輸出的隱含表示進行加權求和,得到上下文向量Ct。將上下文向量Ct送入解碼器進行自回歸解碼,得到輸出的預測文本。編碼器與解碼器均采用長短時記憶(long short-term memory, LSTM)網絡[17-18],網絡結構為兩層雙向網絡,每層單向LSTM單元個數為256。

3 系統架構

基于移動定位和目標感知方法,設計的輪式智能巡檢機器人系統架構主要包含智能巡檢機器人終端、邊緣計算節點、管理平臺3部分,如圖5所示。智能巡檢機器人進行巡檢工作時基于自身構建的地圖進行自主導航定位,在巡檢區域內進行巡檢作業。巡檢過程中涉及實時處理的智能識別任務通過機器人自身邊緣計算模塊實現,部分計算量較大的智能識別功能由邊緣計算節點實現。巡檢過程中的相關數據如視頻流、傳感器狀態、巡檢情況可通過現場無線網絡如5G或Wi-Fi回傳至機器人管理平臺。值班人員可通過網絡訪問機器人管理平臺進行場站監控和管理。巡檢機器人具有離線檢測和聯網續傳功能,出現網絡故障等異常情況時將報警并切換到人工操作。

巡檢機器人軟件方面使用Linux操作系統,軟件開發基于ROS(robot operating system)。系統主要包括硬件層、算法層以及應用層。硬件層中硬件驅動包括各個外設如激光雷達、慣性測量單元、GPS等模塊的相關驅動。機器人通過驅動獲取傳感器數據后進行數據時間對齊處理,保證數據的時間一致性。算法層主要包含移動定位與目標感知算法,也包含路徑規劃、避障、運動控制等輔助算法。應用層實現機器人的業務邏輯,如自主導航定位、執行巡檢任務、智能分析設備狀態、數據匯總與上報、告警管理等。

4 試驗結果

4.1 定位試驗結果

為了驗證機器人在地圖上的定位精度,在如圖6(a)所示室內地圖上選取了10個測量點,測量機器人沿不同方向到達測試位置后的位姿。圖中黃色圓點為測量點,紅色圓點為二維碼路標。

每個測量點測30次,計算位姿平均值與標準差如表1所示。其中機器人本體的三維空間位置為x、 y和z,姿態為三維空間旋轉角,包括橫滾角αroll、俯仰角αpitch、偏航角αyaw。試驗數據表明,室內定位誤差約為2 cm,角度誤差約為1°。

為便于分析不同傳感器定位效果,手動控制機器人在環境中行走,創建環境地圖。提取建圖過程中計算出的機器人軌跡進行分析。

圖6(b)為融合激光雷達點云與未融合激光雷達點云的視覺里程計軌跡對比,其中“cam_with_lidar(有激光雷達)”是融合了激光雷達點云數據,視覺特征點與激光雷達點云進行過深度關聯的機器人視覺里程計軌跡,“cam_no_lidar(無激光雷達)”是未融合激光雷達的機器人視覺里程計軌跡。可以看出,未融合激光雷達點云深度信息的視覺里程計誤差較大,而融合激光雷達點云深度的視覺里程計在機器人回到原點附近時,可基本實現閉環,誤差較小。

巡檢機器人的多傳感器融合定位軌跡如圖6(c)所示,“lidar_with_cam(有視覺定位)”是融合視覺里程計之后的激光雷達里程計軌跡,“lidar_no_cam(無視覺定位)”是未融合視覺里程計的激光雷達里程計軌跡,“pose_after_loop(閉環軌跡)”是經過因子圖優化后的閉環軌跡,它更加接近真值。主圖是整個軌跡,子圖是整個軌跡的局部放大,可以看出,融合視覺里程計之后的激光雷達里程計軌跡更加平滑,經過因子圖優化后的閉環軌跡進一步消除了噪聲。

4.2 表計信息提取試驗結果

表計信息提取算法開發軟件環境所用計算機操作系統為Ubuntu 20.04,深度學習工具軟件為PyTorch,使用4塊Nvidia TITAN X顯卡進行模型訓練所需的并行計算。

為完成表計檢測、表計示數分析和表計上的中英文文本識別任務,需要采集真實數據。數據來源包括在多個天然氣場站和化工廠等場所采集的溫度表、壓力表、壓差表等常見指針式表計及電子式表計。表計目標檢測使用的數據集圖像總計10366張,其中訓練集9366張,驗證集1000張,測試集1000張;指針檢測數據集圖像共有3572張,其中訓練集3372張,驗證集100張,測試集100張。

對于表計上的中英文文本識別任務,還采用了公開數據集和合成數據補充訓練集樣本。所采用兩個常用的公開數據集為ICDAR MLT 2019數據集和RCTW數據集。具體數據集信息如表2所示。

在表計檢測任務上,對比YOLOv5模型、YOLOv3和Faster-RCNN,YOLOv5模型的檢測準確率最優達到98.8%,YOLOv3與Faster-RCNN檢測準確率分別為97.7%和98.0%。在不同光照、視角和背景條件下,采用YOLOv5模型的表計檢測結果如圖7(a)所示。對于圖片模糊、背光等情形,容易出現漏檢。

在指針提取任務上,采用U-Net網絡的試驗結果如圖7(b)所示。該方法能夠準確定位指針,在出現雙指針或者紅色警示條、表盤被遮擋等情況下,也能較好地完成指針提取。

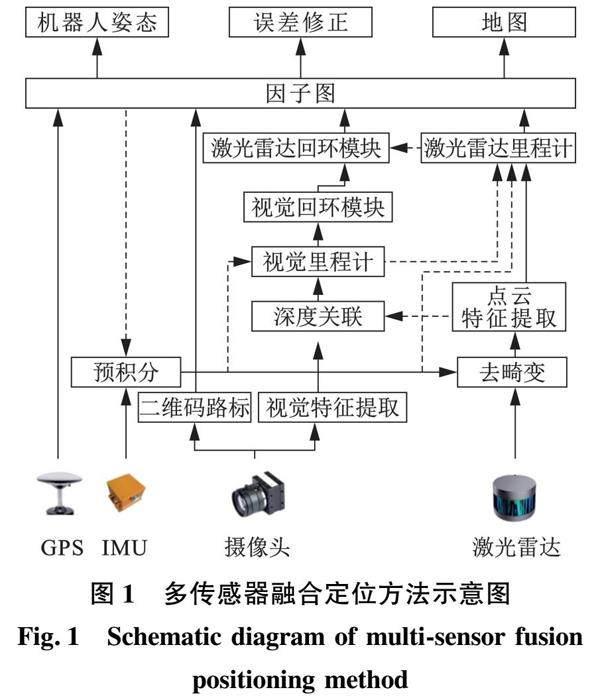

在文本識別任務上,首先采用合成樣本和公開數據集樣本進行模型預訓練,然后加入部分真實樣本進行模型參數細調訓練,對真實樣本采用多種數據增強方法,包括旋轉、剪裁、添加噪聲等。訓練完成后模型在測試集上平均字符識別率為94%。識別每張圖像的平均時間為0.02 s。

圖8列出了機械式表計文本識別結果示例,紅色字體表示識別結果有誤。對于圖8(a)和(b)中字跡較為清晰的圖像,識別正確率較高。對于文字帶邊框的情形,如圖8(b)中的“1.6”, 識別結果有誤,后續可在訓練集中添加類似的帶邊框的數字樣本加以改進。對于圖8(c)中比較模糊的圖像,識別性能也有所下降。

在完成指針提取和文本識別后,采用CNN模型對刻度線進行定位,如圖7(c)所示。通過進一步與文本識別結果進行匹配,能夠確定每個主刻度線對應的示數,從而根據指針角度確定表計最終示數。若示數超出預設閾值,則進行告警處理。

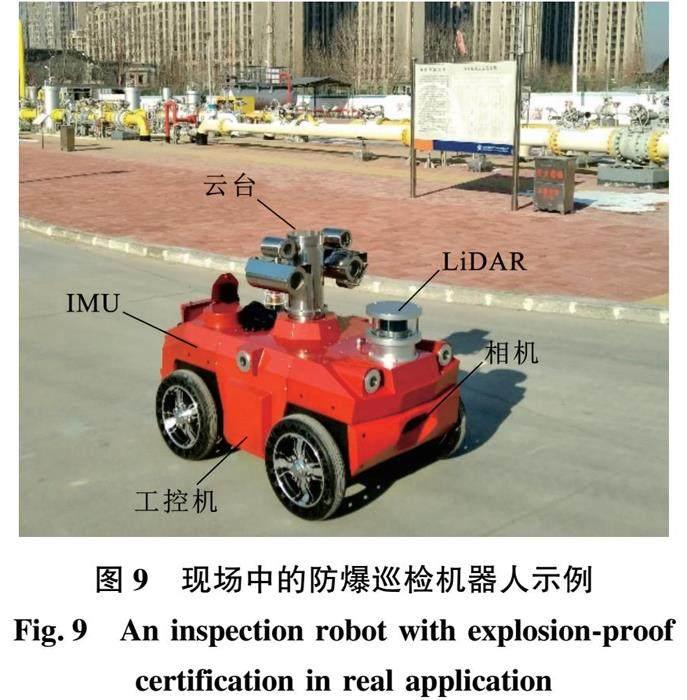

4.3 實際系統部署與測試

輪式巡檢機器人系統配置如圖9所示。系統采用四輪差動轉向底盤。主機采用 Intel i7雙核1.7 GHz CPU,16GB 內存,32 GB eMMC 閃存和256G SSD硬盤,并采用Nvidia GeForce GTX 1060顯卡或NVIDIA Jetson AGX Xavier等模塊用于并行計算。云臺配備可見光攝像頭(圖像分辨率為1920×1080)和熱成像攝像頭,可見光攝像頭用于視覺目標檢測與識別,熱成像攝像頭用于測溫。慣性測量單元(IMU)采用三馳(SC-AHRS-100D4)型號,激光雷達采用速騰聚創150 m16線型號。用于視覺定位的單目攝像頭采用海康MV-CA020-10GC型號的 200萬像素4 mm鏡頭。巡檢機器人可選配氣體檢測傳感器(氧氣、硫化氫、氨氣、一氧化碳等)。移動通信模塊采用四信5G工業路由器。巡檢機器人具有自動充電功能,可在巡檢環境中部署充電樁。另外巡檢機器人具有防爆功能(防爆等級:Ex d e mb IIB T4 Gb)。

采用本文技術方案的巡檢機器人系統已經在多個天然氣場站、化工廠以及油田進行現場運行,執行抄表、氣體泄露檢測等多種任務,如圖9所示。

巡檢機器人對某場站調壓計量撬上多個壓力表進行信息提取的實測結果如表3所示。“壓力實際值”為值班人員核驗得到的現場表計真實示數,“壓力讀表值”為機器人自動提取的表計讀數,將二者之差的絕對值除以量程,得到誤差。表3中相對誤差的平均值約為1%。

5 結 論

(1)為巡檢機器人的移動定位和目標感知提供了軟硬件協同的技術解決方案;采用包括激光雷達、單目攝像頭、慣性測量單元等傳感器實現移動定位,并引入二維碼路標輔助視覺定位進一步消除定位累積誤差,通過引入基于深度學習的表計信息提取等方法,實現目標感知與分析,新技術方案經測試達到實際使用要求。

(2)所研發的巡檢機器人可有效替代人工進行智能巡檢,設計一種基于深度學習的表計檢測、定位與文本識別方法,可支持機械式表計和電子式表計的示數讀取;通過引入5G移動通信及Wi-Fi的網絡通信功能,實現了具有網絡管理平臺的輪式巡檢機器人系統;系統通過多種傳感器獲取信息,可以完成室內及室外自主導航、設備巡檢等多種任務,并可根據需要搭載氣體泄露檢測儀等裝置,對異常進行告警處理。

參考文獻:

[1] STEELE J P, HAN Q, KARKI H, et al. Development of an oil and gas refinery inspection robot[R]. V04AT04A016,2014.

[2] 何玉榮,宋志超,張燕明,等.機器學習在水力壓裂作業中的應用綜述[J].中國石油大學學報(自然科學版),2021,45(6):127-135.

HE Yurong, SONG Zhichao, ZHANG Yanming, et al. Review on application of machine learning in hydraulic fracturing [J]. Journal of China University of Petroleum (Edition of Natural Science), 2021,45(6):127-135.

[3] 趙軍友,張亞寧,畢曉東,等.噴砂除銹爬壁機器人磁吸附結構優化設計及整機性能試驗[J].中國石油大學學報(自然科學版),2020,44(4):94-99.

ZHAO Junyou, ZHANG Yaning, BI Xiaodong, et al. Optimum design of magnetic adsorption structure and machine performance test for sand blasting and rust-removing wall-climbing robot[J]. Journal of China University of Petroleum(Edition of Natural Science), 2020,44(4):94-99.

[4] 鄭杰,尚祖躍,竇益華,等.模塊化同步自主變徑輸氣管道機器人的研究設計[J].石油機械,2023,51(11):154-162.

ZHENG Jie, SHANG Zuyue, DOU Yihua, et al. R&D for modular synchronous autonomous variable diameter gas pipeline robot [J].China Petroleum Machinery,2023,51(11):154-162.

[5] 丁建新,李雪松,宋先知,等.水平井鉆井提速-減阻-清屑多目標協同優化方法[J].石油機械,2023,51(11):1-10.

DING Jianxin, LI Xuesong, SONG Xianzhi, et al. Multi-objective collaborative optimization method for ROP improvement,drag reduction and hole cleaning in horizontal well drilling[J].China Petroleum Machinery,2023,51(11):1-10.

[6] 劉標.防爆巡檢機器人在天然氣分輸站的應用[J].化工管理,2021,28(21):196-198.

LIU Biao. Application of explosion proof inspection robot in natural gas distribution station[J]. Chemical Enterprise Management, 2021,28(21):196-198.

[7] CADENA C, CARLONE L, CARRILLO H, et al. Past, present, and future of simultaneous localization and mapping: toward the robust-perception age[J]. IEEE Transactions on Robotics, 2016,32(6):1309-1332.

[8] 康磊,鄭豪威.基于機器視覺的指針式儀表自動識別算法研究[J].石油工業技術監督,2022,38(3):20-23.

KANG Lei, ZHENG Haowei. Research on automatic recognition algorithm of pointer instrument based on machine vision[J]. Technology Supervision in Petroleum Industry, 2022,38(3):20-23.

[9] 劉慧舟,胡瑾秋,張來斌,等.基于紅外熱成像與CNN的壓裂裝備故障精準識別及預警[J].中國石油大學學報(自然科學版),2021,45(1):158-166.

LIU Huizhou, HU Jinqiu, ZHANG Laibin, et al. Accurate identification and early-warning of faults of fracturing equipments based on infrared thermal imaging and convolutional neural network [J]. Journal of China University of Petroleum (Edition of Natural Science), 2021,45(1):158-166.

[10] QIN T, LI P, SHEN S. VINS-Mono: a robust and versatile monocular visual-inertial state estimator[J]. IEEE Transactions on Robotics, 2018,34(4):1004-1020.

[11] SHAN T, ENGLOT B, MEYERS D, et al. LIO-SAM: tightly-coupled lidar inertial odometry via smoothing and mapping:IEEE/RSJ International Conference on Intelligent Robots and Systems[C]. Vilamoura-Algarve, Portugal: IEEE, 2020:5135-5142.

[12] KAESS M, JOHANNSSON H, ROBERTS R, et al. iSAM2: incremental smoothing and mapping using the Bayes tree[J]. The International Journal of Robotics Research, 2012,31(2):216-235.

[13] REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition[C]. ?Las Vegas: NV, ?2016:779-788.

[14] ZHOU D, YANG Y, ZHU J, et al. Intelligent reading recognition method of a pointer meter based on deep learning in a real environment[J]. Measurement Science and Technology, 2022,33(5):055021.

[15] LIAO M, WAN Z, YAO C, et al. Real-time scene text detection with differentiable binarization[J]. AAAI Conference on Artificial Intelligence, 2020,34(7):11474-11481.

[16] GRAVES A, FERNNDEZ S, GOMEZ F, et al. Connectionist temporal classification: labelling unsegmented sequence data with recurrent neural networks: International Conference on Machine Learning[C]. ?Pittsburgh, Pennsylvania: ACM, 2006:369-376.

[17] 王金龍,李凡鵬,胡鵬基,等.基于深度學習的水下井口彎曲應力預測方法[J].石油機械,2023,51(8):64-72.

WANG Jinlong, LI Fanpeng, HU Pengji, et al. A method for predicting bending stress of subsea wellhead based on deep learning[J].China Petroleum Machinery,2023,51(8):64-72.

(編輯 沈玉英)

基金項目:國家自然科學基金項目(U1636124)

第一作者:畢逢東(1971-),男,高級工程師,碩士,研究方向為城鎮燃氣智能化管理等。E-mail: bifengdong@petrochina.com.cn。

通信作者:彭良瑞(1972-),女,副研究員,博士,博士生導師,研究方向為智能圖文信息處理等。E-mail: penglr@tsinghua.edu.cn。

引用格式:畢逢東,周淦,張晨光,等.巡檢機器人系統的軟硬件協同設計[J].中國石油大學學報(自然科學版),2024,48(3):180-187.

BI Fengdong, ZHOU Gan, ZHANG Chenguang, et al. Hardware-software co-design of inspection robot system[J]. Journal of China University of Petroleum (Edition of Natural Science),2024,48(3):180-187.