基于多尺度指導的遙感影像建筑物提取網絡

摘 要:從遙感影像中提取建筑物是計算機視覺領域的一項基本任務。近年來,基于深度學習的方法已成為遙感影像中自動提取建筑物的主流方法。由于建筑物結構復雜、尺度多樣等特點,從遙感影像中準確高效地提取建筑物仍然是一個挑戰。針對建筑物尺度多樣導致在提取過程中無法同時兼顧小型和大型建筑物的問題,提出一種基于多尺度指導的遙感影像建筑物提取網絡。通過4 條路徑分別提取小尺度、大尺度以及其他尺度特征,通過基于交互的尺度指導模塊和可選擇核(Selective Kernel,SK) 卷積模塊分別對特征進行指導和優化特征,融合不同路徑提取的特征預測建筑物信息。分別在WHU數據集和inria 數據集上評估提出網絡的有效性, 對比實驗結果表明, 所提出的網絡在WHU 數據集上的交并比(Intersection over Union,IoU) 較網絡SegNet、ENet、MMB-Net、Refine-UNet、MAP-Net 分別提高2. 37% 、1. 48% 、1. 05% 、0. 83% 、0. 59% ,在inria 數據集上IoU 較其他網絡分別提高3. 65% 、4. 93% 、2. 42% 、1. 82% 、1. 21% 。結果顯示,所提出的網絡是一種有效、提取結果完整性更高、魯棒性更強的目標提取網絡。

關鍵詞:深度學習;遙感影像;建筑物提取;多尺度指導

中圖分類號:TP751 文獻標志碼:A 開放科學(資源服務)標識碼(OSID):

文章編號:1003-3106(2024)07-1694-08

0 引言

建筑物是城市遙感影像中人工物體的主要內容,與人類活動息息相關。有效地提取建筑物對城市規劃、發展、建設以及地理數據庫更新等發揮著重要作用。隨著遙感技術的發展,遙感影像分辨率越來越高,獲得的目標更加清晰,相關研究也不斷增加。

近年來,針對遙感影像建筑物提取,人們提出大量的方法,主要分為2 類:一類為基于傳統的方法,如基于紋理和基于閾值的方法[1-4],通常需要手動處理和選擇特征。但這種方法提取效果較差,而且非常低效,需要耗費過多人力和物力。另一類為基于深度學習的方法。隨著卷積神經網絡(Convolutional Neural Network,CNN)[5-7]到全卷積神經網絡(Fully Convolutional Network,FCN)[8-10]的演變,基于深度學習的語義分割方法開始被提出并收獲了較好的結果。隨后,其變體也由于具有良好的性能而受到廣泛認可,如編碼器- 解碼器結構[11-12]。為了充分發揮深度學習的優勢,Qiu 等[13]利用空洞空間卷積池化金字塔(Atrous SpatialPyramid Pooling,ASPP)和改進的深度可分離卷積提取建筑物的多尺度特征;Zhu 等[14]采用多條路徑分別提取不同分辨率的特征以提取建筑物的多尺度信息。楊棟杰等[15]利用通道注意力和多尺度特征融合注意力提高建筑物提取的性能。盡管這些方法提高了建筑物提取的精度,但是對于建筑物的多尺度信息提取不夠充分,同時會引入大量冗余信息。

因此設計了一個基于多尺度指導的建筑物提取網絡,通過路徑間相互指導分別提取小尺度、大尺度以及其他尺度的建筑物信息。同時,利用可選擇核(Selective Kernel,SK)卷積模塊優化提取特定尺度下的多尺度信息,有效提高了建筑物提取的精度和效率,使遙感影像下建筑物提取結果更加可靠和高效。

1 方法

1. 1 多尺度指導建筑物提取網絡

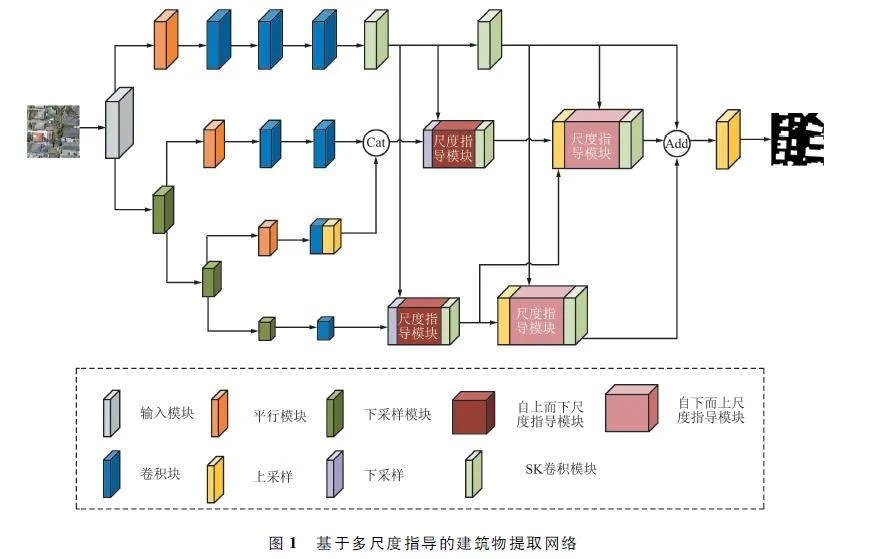

針對高分辨率遙感影像建筑物提取提出一種多尺度指導方法,如圖1 所示,該網絡包含4 條路徑L1 、L2 、L3 、L4 ,分別提取小尺度、大尺度和其他尺度的建筑物信息。通過多條路徑不僅可以保留建筑物的細節特征,還提取了建筑物的語義特征,同時具有較大的感受野。然后將多條路徑提取的建筑物特征進行融合,通過上采樣恢復到輸入分辨率大小,獲得最終的預測圖。

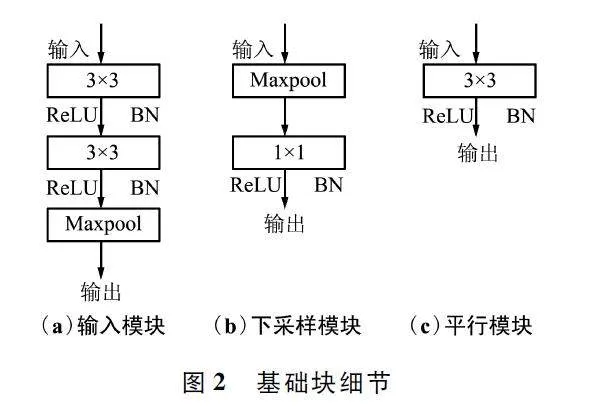

通過輸入I,分辨率大小為256 pixel×256 pixel×3 的通道,得到每條路徑上的特征圖F1 、F2 、F3 、F4 ,分別為128 pixel×128 pixel×64 通道、64 pixel×64 pixel×128 通道、32 pixel × 32 pixel × 256 通道、16 pixel ×16 pixel×512 通道。對于同一條路徑上的特征圖,分辨率大小和通道數保持一致。分辨率較大的特征圖具有更多的細節特征,但是感受野較小;分辨率較小的特征圖感受野更廣闊,但是丟失較多的細節特征。鑒于此,將L1 路徑用于提取小尺度建筑物,L4路徑用于提取大尺度建筑物,L2 、L3 兩條路徑共同提取其他尺度建筑物。在特征提取階段,通過輸入模塊將I 轉化為大小128 pixel×128 pixel×64 通道的特征圖,用于減少訓練的參數。利用卷積塊提取特征,每個卷積塊包括4 個卷積核3×3 卷積層。在分路徑階段,使用平行模塊保留原始路徑信息,下采樣模塊生成新路徑信息。基礎塊細節如圖2 所示,其中輸入模塊包括2 個3×3 卷積層和一個最大池化層,經過第一個卷積層,將大小為256 pixel×256 pixel×3通道的輸入通道數調整為64,第二層卷積輸出大小保持不變,最后經過最大池化層,特征圖大小變為128 pixel×128 pixel×64 通道;下采樣模塊包括一個最大池化層和一個1 ×1 卷積層,經過最大池化層,特征圖大小變為原來的一半,然后通過1×1 卷積將通道數調整為輸入的2 倍;平行模塊由一個3×3 卷積層構成,通過此模塊生成的特征圖與輸入特征圖的大小和通道數一致;其中每個模塊中的卷積層后均包含一個ReLU 激活函數和BN 層。

特征提取后,將L2 、L3 路徑提取的特征圖進行融合得到路徑L23 ,融合過程如下:

L23 = BR((Conv1 ×1(Cat(L2 ,Up(L3 ))))), (1)

式中:Up 表示2 倍上采樣,Cat 表示通道維度上的拼接函數,Conv1×1 表示1×1 的卷積層,BR 表示BN 層和ReLU 層。然后通過指導模塊,L1 路徑指導L4 路徑特征圖的生成;L1 路徑和L4 路徑共同指導L23 路徑特征圖的生成。使得L1 、L23 、L4 能夠分別捕獲到小尺度建筑物信息、其他尺度建筑物信息、大尺度建筑物信息。

由于不同路徑間特征圖分辨率不同,因此指導模塊包括2 個過程:自上而下指導和自下而上指導。自上而下指導過程表示將指導特征圖分辨率下采樣到被指導特征圖分辨率大小進行指導,由圖1 中自上而下指導模塊表示;自下而上指導過程表示將被指導特征圖上采樣到指導特征圖分辨率大小然后被指導,由圖1 中自下而上指導模塊表示。前者用于增強被指導特征圖對應尺度的特征信息,后者為被指導特征彌補細節信息,同時將對應路徑的特征圖恢復到被指導特征圖分辨率大小。指導過程如下:

L ^4 = Guide(Down(L1 ),L4 ), (2)

L~4 = Guide(L1 ,Up(L4 )), (3)

式中:Guide 表示指導模塊,具體結構在1. 2 節介紹;Down 表示下采樣,Up 表示上采樣。式(2)表示自上而下指導過程,式(3)表示自下而上指導過程。

自上而下過程指導完成后,使用SK 卷積模塊優化指導后的特征圖,然后進行自下而上指導過程,同樣指導結束后利用SK 卷積模塊優化特征圖,SK卷積模塊的細節在1. 3 節展示。優化完成后,利用Add 函數直接將3 個提取不同尺度的特征圖融合,最后通過上采樣和Sigmoid 操作得到最終預測圖,大小為256 pixel×256 pixel×1 通道。

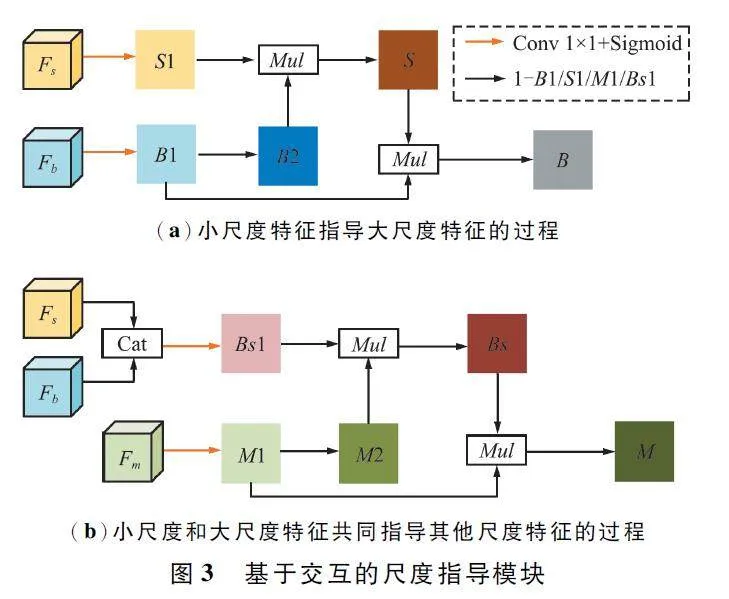

1. 2 基于交互的尺度指導模塊

文獻[16]提出的尺度指導模塊,獨立提取了不同尺度的信息。然而,該模塊在指導過程中忽視了不同尺度物體存在重疊性,導致被指導特征對應尺度信息部分被抑制,進而無法有效提取對應尺度建筑物信息。如小尺度特征圖中包含大尺度特征的部分信息,在指導大尺度特征圖生成過程中,會抑制大尺度特征圖中的這些特征,因此指導結果不理想。針對該問題,本文提出了一個基于交互的尺度指導模塊。該模塊在尺度指導模塊的基礎上,充分利用指導特征與被指導特征的交互信息。在小尺度特征指導大尺度特征時,利用大尺度特征抑制小尺度特征中提取的少量大型建筑物區域,增強小型建筑物區域;將增強后的小尺度特征進一步指導大尺度特征,得到指導后的特征尺度針對性更強,包含對應尺度的建筑物信息更全面。具體結構如圖3 所示。

圖3(a)中輸入為小尺度特征Fs 和大尺度特征Fb,通過一個1 ×1 卷積層和Sigmoid 激活函數得到二值圖S1、B1,通過式(4)得到B。首先,將B1 進行1-B1 操作,使作為權重圖的B2 對于大尺度特征具有更小的激活值;其次將B2 與S1 逐元素相乘,得到的權重圖S 對大尺度特征信息給予更低的關注,而對小尺度特征信息具有更高的關注;最后,將優化的權重圖S 與B1 逐元素相乘,分別增強和抑制B1中小型建筑物特征信息和大型建筑物特征信息,生成對大尺度特征信息關注更多的權重圖B。其中Mul 函數表示直接相乘。

在特征提取過程中,淺層特征由于具有更多的細節信息,適用于提取小尺度特征信息;深層特征由于具有更大的感受野,可以提取大尺度建筑物信息;而對于其他尺度建筑物信息,使用中間2 層提取。因此,在指導其他尺度特征生成時,利用大尺度特征和小尺度特征共同指導,故圖3(b)中輸入為3 個特征圖,分別為小尺度特征Fs、大尺度特征Fb 和其他尺度特征Fm 。首先將小尺度特征圖和大尺度特征圖拼接到一起,通過1 ×1 卷積和Sigmoid 激活函數得到權重圖Bs1,其他過程和圖3(a)中相似,具體實現如下:

B = Mul(B1,1 - Mul(S1,1 - B1)), (4)

M = Mul(M1,1 - Mul(Bs1,1 - M1))。(5)

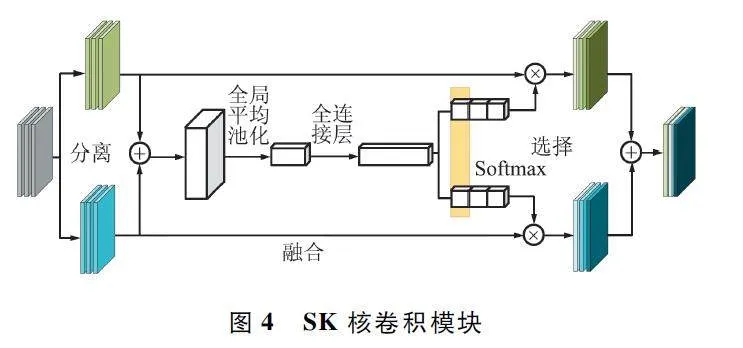

1. 3 SK 卷積模塊

在本文網絡中引入SK 卷積模塊,用于優化各條路徑提取的建筑物特征。該模塊最初在文獻[17]中提出,不僅可以自主選擇感受野,同時可以提取多尺度特征。具體結構如圖4 所示,包括分離、融合和選擇3 個步驟。首先通過空洞率分別為1、2的2 個3×3 卷積將特征圖分離;然后將分離后的特征直接相加融合,經過全局平均池化和全連接層后通道數變為輸入通道數的2 倍;接著利用Softmax 函數,如圖4 中黃色部分,將相同通道計算對應的權重,得到2 個相同通道互補的權重向量;最后將互補的權重向量分別作用于分離過程生成的2 個特征圖,相加得到最終的特征圖。

本文網絡通過SK 卷積模塊優化特征信息,經過尺度指導模塊后,各條路徑提取的特征圖具有不同的尺度。不同路徑的特征圖通過SK 卷積模塊自主選擇感受野,同時也提取了相應路徑下的多尺度信息。文中在每一個指導模塊之后均使用SK 卷積模塊進行優化,因此,每條路徑包括2 個SK 卷積模塊。

2 實驗

2. 1 實驗數據

為了驗證本文模型的有效性,選取WHU 數據集[18]和inria 數據集[19]進行訓練和測試。WHU 數據集來自武漢大學GPCV 團隊,采用航空數據集作為實驗數據;inria 數據集包括5 個不同區域的數據,不同區域之間建筑物特點各異,可以有效評估模型的泛化能力。

在訓練階段,由于資源設備有限,將訓練數據分割為256 pixel×256 pixel 大小,然后將分割后數據中沒有建筑物的影像和標簽去除,得到最終訓練數據。

2. 2 評價指標

針對模型預測的結果,采用精確率(Precision)、召回率(Recall)、F1 分數(F1)、交并比(Intersectionover Union,IoU)作為評價指標。計算如下:

Precision = TP/TP + FP, (6)

Recall = TP/TP + FN, (7)

F1 = 2 × Precision × Recall/Precision + Recall , (8)

IoU = TP/TP + FP + FN, (9)

式中:TP 表示預測結果和標簽均為建筑物;FP 表示預測結果為非建筑物,標簽為建筑物;TN 表示預測結果和標簽為非建筑物;FN 表示預測結果為建筑物,標簽為非建筑物。

遙感影像下建筑物提取屬于二分類問題,提取類別為建筑物和非建筑物2 類。針對模型,實驗以PyTorch 為框架,在NVIDIA GeForce RTX 3060 設備上構建模型。訓練過程中,超參數迭代次數設置為200,初始學習率為0. 000 1,Batch Size 為4,驗證集上Batch Size 為2,采用多步長Multi-StepLR 動態調整網絡更新學習率,通過Adam 優化器迭代優化損失函數。采用文獻[20]中的損失函數評價預測結果和真實值之間的差異,具體如式(10)所示:

L(predict,label) = α1 BCE(predict,label)+α2 Dice(predict,label), (10)

式中:α1 、α2 為超參數,分別取值0. 8、0. 2。

2. 3 實驗結果

在WHU 數據集和inria 數據集上將模型和多個語義分割網絡進行對比實驗,其中包括語義分割模型SegNet、ENet[21]以及近2 年建筑物提取領域提出的模型MMB-Net[22]、Refine-UNet 和MAP-Net。

2. 3. 1 WHU 數據集實驗結果

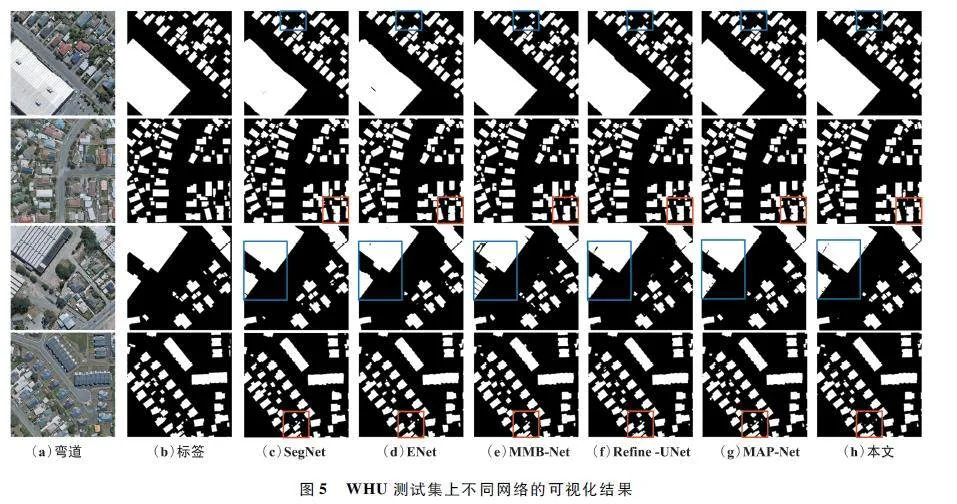

使用在WHU 訓練集上訓練好的模型對測試集進行預測,輸入大小為512 pixel×512 pixel×3 通道,輸出為建筑物提取預測圖。實驗中所有的網絡均在相同的設備以及超參數下進行,部分預測結果如圖5 所示。

本文提出的基于多尺度指導的建筑物提取網絡模型采用多路徑結構,利用改進的指導模塊,減少路徑提取特征圖的冗余信息,指引每條路徑提取相應尺度的建筑物信息。然后通過SK 卷積模塊優化對應尺度的特征,使提取的特征不僅可以自由選擇感受野,也擁有豐富的多尺度信息。通過圖5 可以發現,第一行中藍色框部分顯示本文提出的模型提取的小型建筑物邊界更光滑,與標簽匹配度更高;第三行中藍色框部分表明本文模型提取的大型建筑物較MMB-Net、Refine-UNet 完整性更高,提取的邊界較模型SegNet、ENet 與MAP-Net 更完整;第二行和第四行中紅色框表明對于影像中形狀變化較大的建筑物,本文模型提取結果邊界更完善。綜合表明,在WHU 建筑物數據集上效果優于其他模型,提出的方法具有更多的細節信息,連續性較好,而且小型建筑物遺漏更少。該模型可以有效提取遙感影像下的建筑物,建筑物提取精度定性分析如表1 所示。

由表1 可以看出,本文網絡提取結果在F1 上比其他5 個網絡分別提高1. 31% 、0. 82% 、0. 58% 、0. 46% 、0. 32% ,IoU 分別提高2. 37% 、1. 48% 、1. 05% 、0. 83% 、0. 59% ,與可視化結果一致,本文網絡綜合性能較其他對比網絡更優。

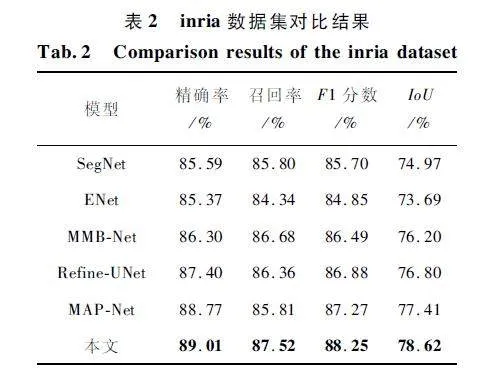

2. 3. 2 inria 數據集實驗結果

使用在inria 數據集上訓練好的模型對測試集進行預測,輸入大小為512 pixel×512 pixel×3 通道,輸出為建筑物預測圖。可視化結果如圖6 所示。其中包括5 個區域austin、chicago、kitsap、tyrol 和vienna 的影像,分別對應每一行。5 個區域的建筑物特點各異,austin 和chicago 區域建筑物分布均勻,chicago 區域建筑物呈列排布,tyrol 區域建筑物大小變化較大分布無規律,vienna 區域建筑物形狀變化較大。圖中第一行、第三行和第四行紅色框部分表明,對于規則的建筑物,本文網絡提取的建筑物輪廓更清楚和光滑;而第五行紅色框中對于復雜的建筑物,本文網絡預測結果更接近標簽形狀。

綜合表明,對比網絡提取結果完整性較差,本文網絡提取結果更準確。在inria 數據集上,所提網絡與其他對比網絡的定量實驗結果如表2 所示。

由表2 可以看出,本文提出的網絡在4 個評價指標上均優于對比網絡。對比結果顯示本文網絡的F1 比其他5 個網絡分別提高2. 55% 、3. 4% 、1. 76% 、1. 37% 、0. 98% ,IoU 分別提高3. 65% 、4. 93% 、2. 42% 、1. 82% 、1. 21% 。結果顯示,本文提出的方法和其他5 種網絡相比性能更佳,魯棒性更強。

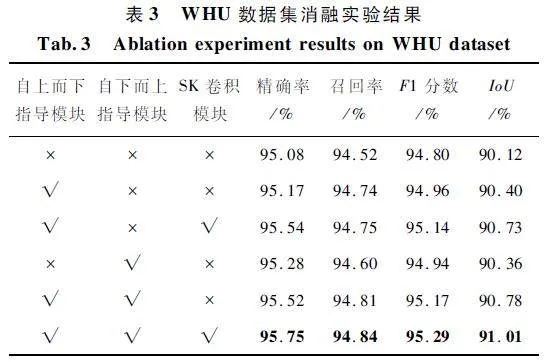

2. 3. 3 消融實驗結果

自上而下指導模塊和自下而上指導模塊分別通過分辨率向下兼容和向上兼容指導特定尺度特征生成;SK 卷積模塊通過優化指導后特征,從而提升網絡特征提取能力。本節通過在WHU 數據集上進行消融實驗驗證上述3 個模塊對模型性能影響,結果如表3 所示。

①自上而下指導模塊。該模塊通過指導特征圖下采樣對被指導特征圖進行指導,增強相關尺度特征信息,抑制不相關尺度特征信息。采用相同的訓練集、驗證集、測試集和訓練參數驗證該模塊性能。在WHU 數據集上的驗證結果如表3 第二行所示,與第一行相比,精確率和召回率均有提升,IoU 提高0. 28% 。結果表明,自上而下指導模塊有助于建筑物的分割,對于建筑物誤檢更少。

②自下而上指導模塊。該模塊通過被指導特征圖上采樣后被指導特征圖指導,可以彌補被指導特征圖下采樣后丟失的細節信息。驗證結果如表3 第四行和第五行所示,通過比較第一行和第四行,IoU提高0. 24% ,精確率和召回率均有提升,而精確率提升幅度更大。第二行和第五行相比,IoU 提升0. 38% ,精確率同樣提升空間更大。實驗結果表明,自下而上指導模塊恢復更多的空間細節,提高了建筑物分割的完整性。

③SK 卷積模塊。SK 卷積模塊為不同的卷積核分配相應的權重,達到控制感受野和優化特征的目的。表3 的第三行和第六行驗證該模塊的有效性,通過比較第二行和第三行,IoU 提升0. 33% ,比較第五行和第六行,IoU 提升0. 23% 。綜合表明,SK 卷積模塊進一步優化了指導后的特征圖,從而提升建筑物檢測表現。

通過以上消融實驗可以發現,本文提出的自上而下指導模塊、自下而上指導模塊以及SK 卷積模塊對于網絡表達能力和提取性能都至關重要。通過2 個不同過程的指導以及指導后的優化,能有效提升建筑物提取能力。

3 結束語

針對高分辨率遙感影像建筑物提取中大型建筑物完整性較低、小型建筑物容易丟失等問題,本文提出了基于多尺度指導的建筑物提取網絡。網絡包括4 條路徑,分別用于提取不同尺度的建筑物信息,通過指導模塊和SK 卷積模塊生成3 類特征圖。淺層路徑用于提取小尺度特征,深層路徑用于提取大尺度特征,中間2 條路徑提取其他尺度特征。通過融合以及上采樣多條路徑生成的特征圖得到最終預測圖,不僅在分割大型建筑物時具有更高的完整性,同時建筑物漏檢誤檢更少。通過對比實驗,在WHU數據集和inria 數據集上,本文提出的網絡均優于其他5 種網絡,表明此網絡性能更好,泛化能力更強;進行的消融實驗表明各模塊對于網絡性能的提升至關重要,共同促進網絡提取建筑物能力。但是本文網絡還需進一步改進,提升分割建筑物邊界的能力,后續將朝著此方向努力。

參考文獻

[1] COTE M,SAEEDI P. Automatic Rooftop Extraction inNadir Aerial Imagery of Suburban Regions Using Cornersand Variational Level Set Evolution[J]. IEEE Transactionson Geoscience and Remote Sensing,2013,51(1):313-328.

[2] LI E,FEMIANI J,XU S B,et al. Robust RooftopExtraction from Visible Band Images Using Higher OrderCRF[J]. IEEE Transactions on Geoscience and RemoteSensing,2015,53(8):4483-4495.

[3] ZHONG S,HUANG J,XIE W. A New Method of BuildingDetection from a Single Aerial Photograph[C]∥2008 9thInternational Conference on Signal Processing. Beijing:IEEE,2008:1219-1222.

[4] 李治,隋正偉,傅俏燕,等. 基于形態學序列和多源先驗信息的城市建筑物高分遙感提取[J]. 遙感學報,2023,27(4):998-1008.

[5] HE K M,ZHANG X Y,REN S Q,et al. Deep ResidualLearning for Image Recognition[C]∥Proceedings of theIEEE Conference on Computer Vision and Pattern Recognition. Las Vegas:IEEE,2016:770-778.

[6] KRIZHEVSKY A,SUTSKEVER I,HINTON G E. ImageNetClassification with Deep Convolutional Neural Networks[J]. Communications of the ACM,2017,60(6):84-90.

[7] SZEGEDY C,LIU W,JIA Y Q,et al. Going Deeper withConvolutions[C]∥ 2015 IEEE Conference on ComputerVision and Pattern Recognition. Boston:IEEE,2015:1-9.

[8] CHEN L C,PAPANDREOU G,SCHROFF F,et al.Rethinking Atrous Convolution for Semantic Image Segmentation[EB/ OL]. (2017-12-05)[2023-06-11]. https:∥arxiv. org/ abs/ 1706. 05587.

[9] LONG J,SHELHAMER E,DARRELL T. Fully Convolutional Networks for Semantic Segmentation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Boston:IEEE,2015:3431-3440.

[10] RONNEBERGER O,FISCHER P,BROX T. UNet:Convolutional Network for Biomedical Image Segmentation[C]∥Medical Image Computing and Computerassisted InterventionMICCAI 2015. Munich:Springer,2015:234-241.

[11] BADRINARAYANAN V,KENDALL A,CIPOLLA R. SegNet:A Deep Convolutional EncoderDecoder Architecture forImage Segmentation [J]. IEEE Transactions on PatternAnalysis and Machine Intelligence,2017,39(12):2481-2495.

[12] CHEN L C,ZHU Y K,PAPANDREOU G,et al. EncoderDecoder with Atrous Separable Convolution for SemanticImage Segmentation [C]∥ Proceedings of the EuropeanConference on Computer Vision (ECCV). Munich:Springer,2018:833-851.

[13] QIU W Y,GU L J,GAO F,et al. Building Extraction fromVery Highresolution Remote Sensing Images Using RefineUNet[J]. IEEE Geoscience and Remote Sensing Letters,2023,20:6002905.

[14] ZHU Q,LIAO C,HU H,et al. MAPNet:MultipleAttending Path Neural Network for Building Footprint Extraction from Remote Sensed Imagery [J ]. IEEETransactions on Geoscience and Remote Sensing,2021,59(7):6169-6181.

[15] 楊棟杰,高賢君,冉樹浩,等. 基于多重多尺度融合注意力網絡的建筑物提取[J]. 浙江大學學報(工學版),2022,56(10):1924-1934.

[16] HANG R L,YANG P,ZHOU F,et al. MultiscaleProgressive Segmentation Network for Highresolution Remote Sensing Imagery [J ]. IEEE Transactions onGeoscience and Remote Sensing,2022,60:5412012.

[17] LI X,WANG W H,HU X L,et al. Selective KernelNetworks[C]∥Proceedings of the IEEE / CVF Conferenceon Computer Vision and Pattern Recognition. Long Beach:IEEE,2019:510-519.

[18] JI S P,WEI S Q,LU M. Fully Convolutional Networks forMultisource Building Extraction from an Open Aerial andSatellite Imagery Data Set[J]. IEEE Transactions on Geoscience and Remote Sensing,2019,57(1):574-586.

[19] MAGGIORI E,TARABALKA Y,CHARPIAT G,et al. CanSemantic Labeling Methods Generalize to Any City?TheInria Aerial Image Labeling Benchmark[C]∥2017 IEEEInternational Geoscience and Remote Sensing Symposium(IGARSS). Fort Worth:IEEE,2017:3226-3229.

[20] JADON S. A Survey of Loss Functions for Semantic Segmentation[C]∥2020 IEEE Conference on ComputationalIntelligence in Bioinformatics and Computational Biology(CIBCB). Via del Mar:IEEE,2020:1-7.

[21] PASZKE A,CHAURASIA A,KIM S,et al. ENet:A DeepNeural Network Architecture for Realtime Semantic Segmentation[EB / OL]. (2016 - 06 - 07)[2023 - 06 - 11].https:∥arxiv. org / abs/ 1606. 02147.

[22] ZHANG H,ZHENG X C,ZHENG N S,et al. A Multiscaleand Multipath Network with Boundary Enhancement forBuilding Footprint Extraction from Remotely SensedImagery[J]. IEEE Journal of Selected Topics in AppliedEarth Observations and Remote Sensing,2022,15:8856-8869.

作者簡介

宋寶貴 男,(2000—),碩士研究生。主要研究方向:深度學習、遙感影像建筑物提取。

石衛超 男,(1999—),碩士研究生。主要研究方向:深度學習、遙感影像變化檢測。

余 快 女,(1999—),碩士研究生。主要研究方向:深度學習、遙感影像建筑物提取。

基金項目:國家自然科學基金青年項目(41901341)