基于YOLOv8-HAT的貨車視野盲區檢測算法

摘要 由于貨車體積大、駕駛艙高、后視鏡范圍有限,駕駛員在轉彎和倒車時難以全面了解車身周圍環境,盲區事故風險較大。新一代貨車視野盲區檢測技術要求檢測精確率高、部署方便、誤報率和漏報率低。針對上述需求,文章提出了一種基于YOLOv8-HAT的貨車盲區檢測算法。YOLOv8-HAT算法采用HAttention注意力機制,能夠充分挖掘并利用盲區圖像中的信息潛力,同時采用GIoU損失函數,能夠更好地反映預測框和真實框的重合度,從而提升YOLOv8的檢測精度。實驗結果表明,相較于YOLOv8,在自制數據集上,文章算法的精確率提高了6.6%,mAP增加了3%,召回率提高了6%,FPS可達120以上,能夠實現貨車視野盲區的實時檢測,保障貨運安全。

關鍵詞 貨車視野盲區;目標檢測;YOLOv8;HAttention;GIoU

中圖分類號 U492 文獻標識碼 A 文章編號 2096-8949(2024)20-0025-04

0 引言

載重貨車因其具備大容量運輸、高度靈活性和高效的作業性能,在國內公路運輸領域扮演著至關重要的角色[1],數據顯示,我國70%以上的貨物運輸任務由載重貨車完成。然而,鑒于載重貨車體積龐大、視線遮擋區域廣,以及交通道路環境復雜、駕駛員素質參差不齊等主客觀因素,一旦發生交通事故,極易造成嚴重的人員傷亡。因此,對視覺盲區內的障礙物進行有效檢測,對于防范因盲區障礙物引發的交通事故,以及確保道路交通安全具有極高的現實意義和緊迫性。

目前,基于計算機視覺的目標檢測方法已成為實現盲區檢測的主流方案,該方法分為兩類:一種是基于候選區域生成的一階段檢測法,這類方法直接從輸入圖像預測候選框后再進行分類,具有快速、實時響應的優點,但可能在精確度上較二階段檢測法低;另一種是基于回歸檢測的二階段檢測法,這種方法首先生成候選區域,然后對這些區域進一步細化分類和定位,二階段法往往都能達到較高的準確率,但其檢測速度慢、模型大,不適合貨車視野盲區的檢測任務[2]。該文以YOLOv8為基礎,構建了基于YOLOv8-HAT的貨車盲區檢測算法,能夠更好地適應貨車視野盲區的檢測任務,達到更好的檢測效果。

1 YOLOv8概述

目前,YOLOv8是YOLO系列中較為先進的版本,在2023年1月由Ultralytics發布。在YOLOv5的基礎上,YOLOv8引入了全新的結構,其結構更加簡潔明了,進一步實現了模型的輕量化,使得模型的訓練和推理速度更快,同時也保證了模型的性能,使得模型更加穩定和可靠。YOLOv8的優化體現在使用了C2f模塊替換C3模塊、去除PAN結構中上采樣后的卷積運算、使用二進制交叉熵損失進行分類任務、使用DFL和CIoU進行預測框邊界的回歸任務等[3]。YOLOv8的網絡結構主要由Backbone、Neck、Head等三大部分組成,其中Backbone(主干網絡)是模型的基礎,采用了類似于CSPDarknet的結構,負責從輸入圖像中提取特征,這些特征是后續網絡層進行目標檢測的基礎。YOLOv8的Neck(頸部網絡)位于主干網絡和頭部網絡之間,它的作用是進行特征融合和增強。YOLOv8的Head(頭部網絡)是目標檢測模型的決策部分,負責目標檢測。

2 算法原理

2.1 總體結構

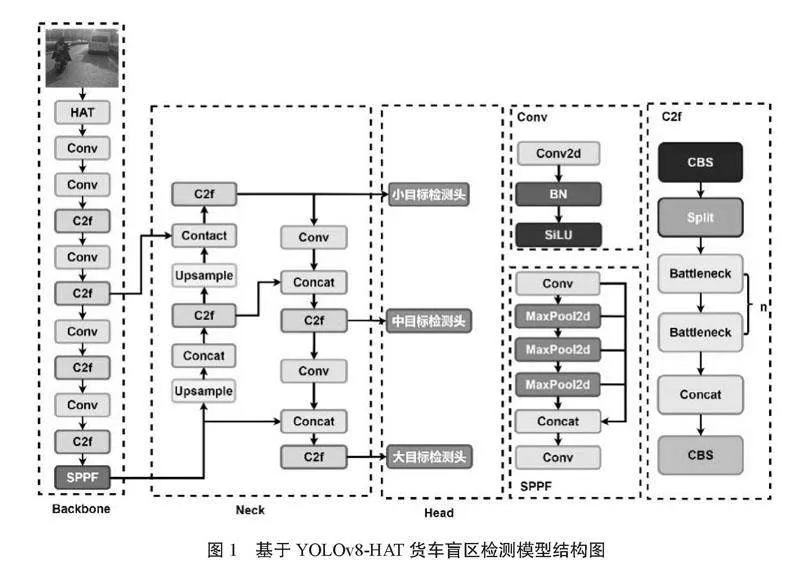

針對原YOLOv8算法對復雜場景圖像特征提取不足、對密集人群檢測準確率較低的問題,該文在YOLOv8算法的基礎上,引入了HAttention注意力機制,同時利用GIoU替換原損失函數,可以更準確地提取貨車視野盲區圖像中危險物的特征,提高檢測的準確率。圖1為優化后的模型結構圖:

2.2 HAttention注意力機制

為了增強模型對輸入圖像中重要區域的關注程度,幫助模型更有效地學習和利用貨車視野盲區圖像的局部和全局特征,該文在原有YOLOv8基礎上進行了創新優化,引入了混合注意力HAttention(HAT)機制[4]。HAT專門用于圖像超分辨率任務,其目標是從低分辨率輸入圖像中重建出高分辨率圖像。HAT機制結合了通道注意力機制和基于窗口自注意力機制的優點,這兩種機制能夠在全局統計信息捕獲及局部細節擬合能力上形成互補效應。這一設計的目的在于充分挖掘并利用低分辨率盲區圖像中的信息潛力,從而實現從低分辨圖像向高分辨圖像的有效重建,并激活更多有助于提高檢測精度的貨車視野盲區中行人和車輛的關鍵像素。通過這樣的改良,使得在貨車視野盲區檢測場景中對行人和車輛的識別與定位效果顯著提升。圖2為HAT的結構圖:

2.3 優化損失函數

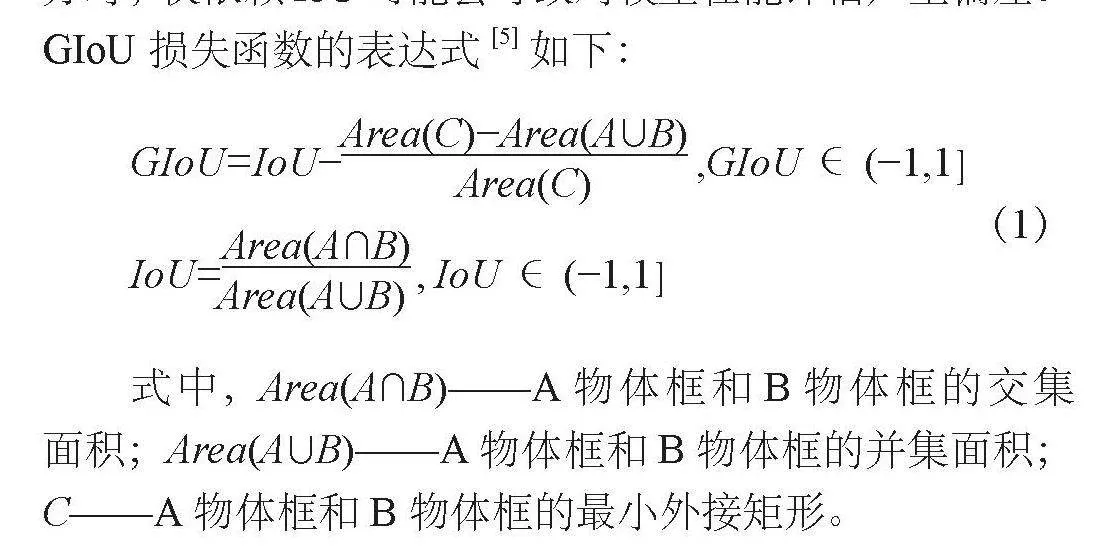

將YOLOv8中的損失函數CIoU替換為廣義的交并比(GIoU),GIoU對貨車視野盲區圖像中重疊區域和非重疊區域都進行了關注,能夠更好地反映盲區物體預測框和真實框的重合度,從而提升YOLOv8的檢測精度[5]。由于CIoU在縱橫交并比描述的相對值方面存在一定的模糊,且沒有考慮難易樣本的平衡問題,因此該文考慮采用GIoU損失函數替換原CIoU損失函數。GIoU是作為傳統IoU指標的改進和擴展形式,在目標檢測任務中提供了一種更為精確和全面的評價方法。傳統的IoU雖然在一定程度上能夠反映預測框與真實框的重疊情況,但在某些特殊場景下,如預測框與真實框并未完全包含對方時,僅依賴IoU可能會導致對模型性能評估產生偏差。GIoU損失函數的表達式[5]如下:

GIoU=IoU?Area(C)?Area(A∩B) Area(C) ,GIoU∈(?1,1](1)

IoU=Area(A∩B) Area(A∩B) ,IoU∈(?1,1]

式中,Area(A∩B)——A物體框和B物體框的交集面積;Area(A∩B)——A物體框和B物體框的并集面積;C——A物體框和B物體框的最小外接矩形。

3 實驗結果與分析

3.1 數據集準備

該實驗訓練采用了自制數據集,包含百度Aistudio上的開源數據集和UA-DETRAC車輛檢測數據集中的部分圖像。其中,百度Aistudio上的開源數據集有2 014張,該數據集選用自主搜集的部署在車輛中的攝像頭所采集的視頻而截取的圖片,符合真實駕駛情況。此外,由于該數據集中車輛類別較少,因此加上UA-DETRAC車輛檢測數據集中車輛的2 000張數據集,共有4 014張行人+車輛+自行車的數據集,先對數據集進行標注,然后進行實驗。

3.2 實驗環境

該實驗采用Windows 11 64位操作系統,硬件為第12代Intel Core i5-12500 HCPU、NVIDIA GeForce GPU、16GB(3 200 MHz)內存,實驗環境采用Python3.9.7和Pytorch1.12.1+cu116版本。在實驗中,設置初始學習率為0.01,最終學習率為0.02,Batch size為2,訓練100次,輸入圖片尺寸為640 px×640 px,最后10個epochs關閉Mosaic數據增強。

3.3 評價指標

該文采取精確率(Precision, P)、召回率(Recall, R)、平均精度(averageprecision, AP)、平均精度均值(mAP),以及每秒幀率(framespersecond, FPS)作為評價指標進行模型整體性能的評價,計算公式如式(2)所示:

Precision= TP TP+FP (2)

Recall= TP TP+FN

式中,TP——正類被預測為正類的樣本數;FP——負類被預測為正類的樣本數;FN——正類被預測為負類的樣本數。

mAP=Σ M m=1AP M (3)

式中,AP——(Precision-Recall, PR)曲線所圍成區域的面積;M——數據集中的類別數目。

TPS=N(P) T(P) (4)

式中,N(P)——處理圖像的總數;T(P)——處理圖像的時間(s)。

3.4 實驗結果與分析

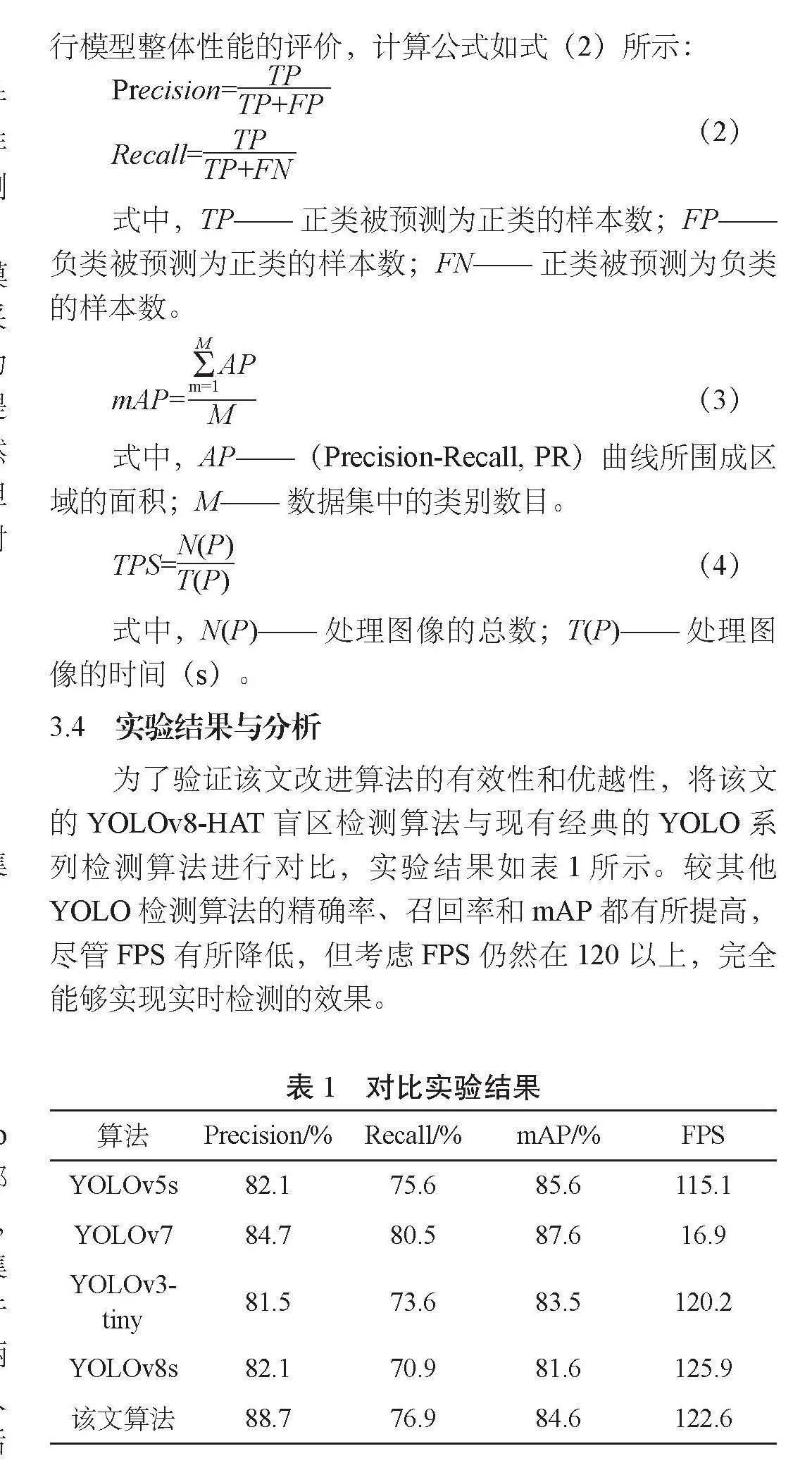

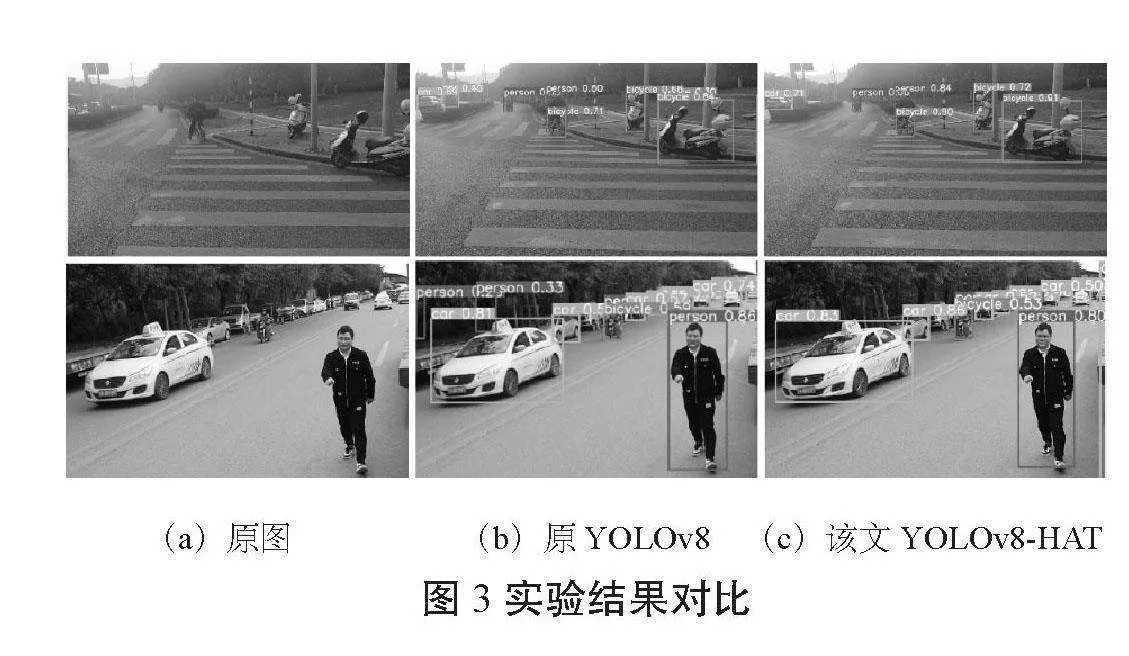

為了驗證該文改進算法的有效性和優越性,將該文的YOLOv8-HAT盲區檢測算法與現有經典的YOLO系列檢測算法進行對比,實驗結果如表1所示。較其他YOLO檢測算法的精確率、召回率和mAP都有所提高,盡管FPS有所降低,但考慮FPS仍然在120以上,完全能夠實現實時檢測的效果。

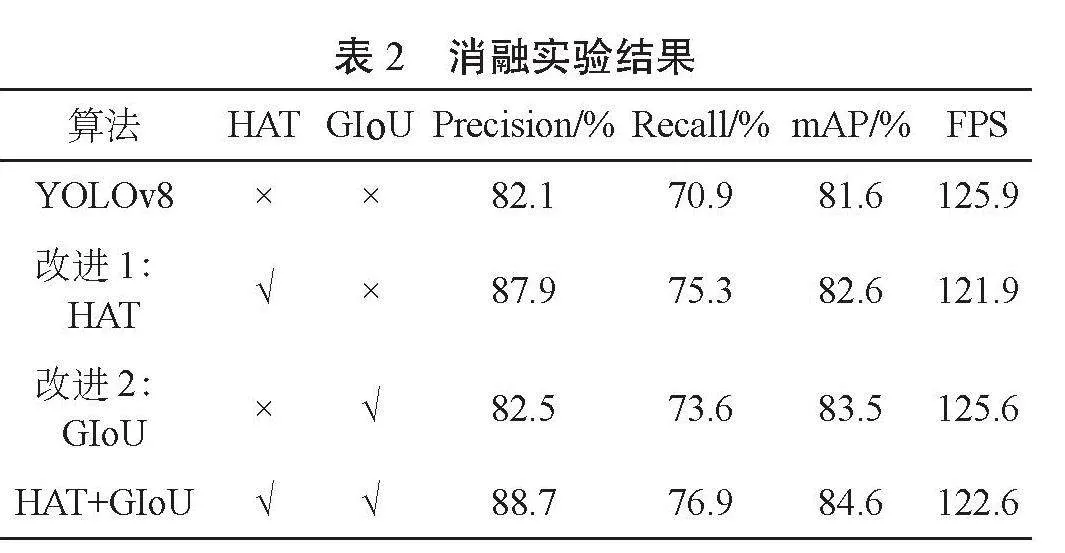

為了分析該文YOLOv8-HAT盲區檢測算法與改進后的模型中不同的改進點對于模型性能的影響。在相同的驗證集和相同的實驗環境下進行一系列的消融實驗,實驗結果如表2所示:

從實驗結果可以看出,相較于YOLOv8模型,在添加HAT注意力機制后,精確率提高了5.8%,mAP增加了5.6%;使用GIoU損失函數后,精確率提高了0.4%,召回率提高了3.3%,mAP提高了1.9%;在融合了兩種改進模型后,精確率提高了6.6%,mAP增加了3%,而FPS僅降低了3.3。利用原YOLOv8和YOLOv8-HAT對選取的圖片進行檢測,檢測結果如圖3所示,可見原YOLOv8檢測會出現如圖所示的漏識別、誤識別和重識別,而該文提出的算法置信度更高,漏檢率和誤檢率下降。

4 結束語

該文深入研究并提出了基于YOLOv8-HAT算法的貨車視野盲區檢測算法,在原模型的基礎上采用了HAT注意力機制和GIoU損失函數,顯著提升了算法的檢測性能,為解決貨車盲區問題提供了有效的技術支持。在未來,計劃將該算法應用于實際場景中,以驗證其在實際貨運駕駛環境中的性能和效果,通過持續的技術創新和應用拓展,貨車盲區檢測技術將為實現道路安全和智能交通的可持續發展作出貢獻。

參考文獻

[1]陳飛,遲福源,高曉楓,等.蘇州市高速公路貨運交通量時空分布特征[J].交通科技與管理,2023(15):30-32.

[2]羅會蘭,陳鴻坤.基于深度學習的目標檢測研究綜述[J].電子學報,2020(6):1230-1239.

[3]范佳琦,李鑫,霍天嬌,等.基于單階段算法的智能汽車跨域檢測研究[J].中國公路學報,2022(3):249-262.

[4]Chen X, Wang X, Zhou J, et al. Activating more pixels in image super-resolution transformer[C]. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.2023:22367-22377.

[5]REZATOFIGHI H, TSOI N, GWAK J, et al. Generalized intersection over union: A metric and a loss for bounding box regression[C]. Proceedings of the 2019 IEEE Conference on Computer Vision and Pattern Recognition(CVPR), 2019:658-66.

收稿日期:2024-05-10

作者簡介:周重位(2002—),男,本科,研究方向:交通設備與控制工程。

基金項目:重慶交通大學大學生創新訓練計劃國家級項目“一種云(端)邊一體的智能貨運車隊安全管理系統”(202310618022)。