基于多任務學習的建筑毀傷評估方法

摘 要:建筑毀傷評估在災害救援過程中對制定救援策略、優化資源調度等方面具有重要作用。現階段,基于語義分割的毀傷評估方法難以提取毀傷建筑細粒度語義信息,對此提出一種基于多任務學習的建筑毀傷評估方法,將毀傷評估分為粗粒度的建筑區域提取與細粒度的毀傷分割兩個子任務,通過共用編解碼器,與上下文信息融合模塊實現建筑區域的粗粒度提取和建筑毀傷的細粒度分割,將兩個結果使用Hadamard積融合,得到最終評估結果。實驗結果表明,所提的基于多任務學習的建筑毀傷評估方法有較好的性能。

關鍵詞: 建筑毀傷評估; 深度學習; 多任務學習

中圖分類號: TP 391.41 文獻標志碼: A""" DOI:10.12305/j.issn.1001-506X.2024.10.15

Multi-task learning based building damage assessment method

WANG Yibo1, ZHANG Lefei3, LI Xinde1,2,4,*

(1. School of Automation, Southeast University, Nanjing 210096, China; 2. Nanjing Center for Applied

Mathematics, Nanjing 211135, China; 3. Armed Police Force Research Institute, Beijing 10001 China;

4. Shenzhen Research Institute, Southeast University, Shenzhen 518063, China)

Abstract: Building damage assessment plays an important role in the disaster relief process, influencing the formulation of rescue strategies and optimization of resource allocation. Currently, damage assessment methods based on semantic segmentation face challenges in extracting fine-grained semantic information for damaged buildings. Thus, a multi-task learning based approach for building damage assessment is proposed, dividing the damage assessment into two subtasks as coarse-grained building area extraction and fine-grained damage segmentation. The proposed method utilizes a shared encoder-decoder and context fusion module to achieve coarse-grained extraction of building areas and fine-grained segmentation of building damage. The results of these two tasks are fused using the Hadamard product to obtain the final assessment. Experimental results demonstrate that the proposed multi-task learning based building damage assessment method performs well.

Keywords: building damage assessment; deep learning; multi-task learning

0 引 言

隨著計算機技術的發展,自主化、智能化的建筑毀傷評估在多個領域有越來越廣闊的應用前景。例如,在自然災害后通常需要對災害發生區域進行救援資源調度,通過無人機群體協作技術[12]或是使用遙感衛星獲取受災區域全局拼接圖像[3],依靠智能化毀傷評估掌握全局的建筑毀傷信息,使用系統建模分析尋求最優調度方案,可提高救援資源利用率并縮短救援時間[4]。

建筑毀傷評估的發展經歷了人工判別、貝葉斯網絡[5]判別和基于圖像的毀傷評估3個階段。人工判別起源于空中偵察出現但計算機技術未發展成熟的時期,該方法易于實施,但受限于判別人員專業水平與效率。基于貝葉斯網絡的毀傷評估以多源信息融合[6]為基礎,通過融合電信號、聲音、圖像等多種傳感器信息并進行貝葉斯推理以完成毀傷評估。得益于無人機群與衛星遙感圖像的迅速發展,基于圖像的毀傷評估有較易獲取信息和表征能力強的優勢。因此,基于圖像的建筑毀傷評估成為目前主要的建筑毀傷評估方法。

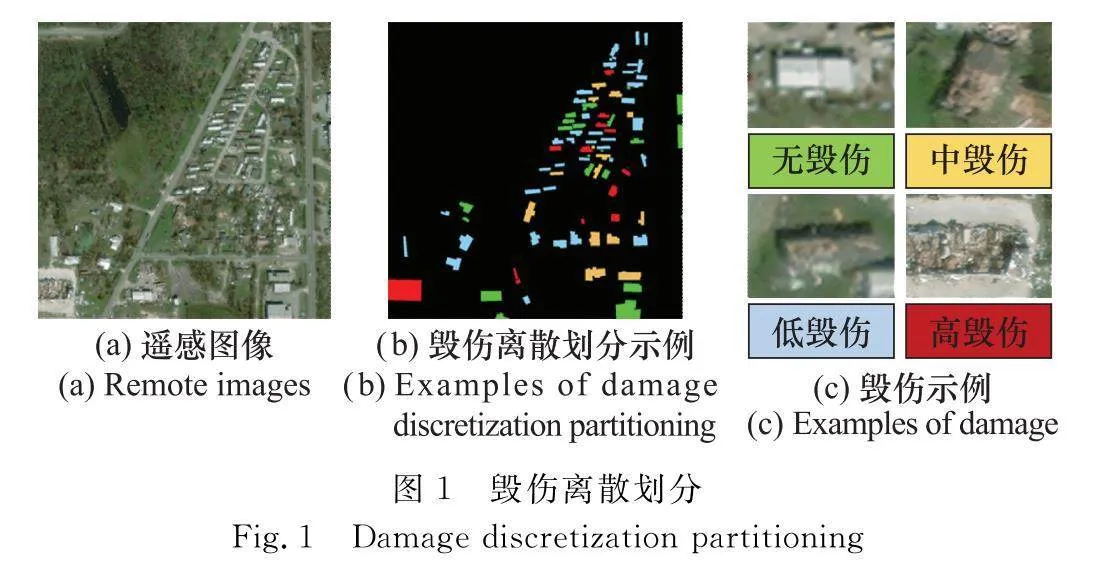

基于圖像的建筑毀傷評估方法包括像素級和特征級兩種評估方法。像素級評估包括圖像差分[7]、圖像比值、變化向量分析(change vector analysis, CVA)[89]、圖像變化檢測[10]等。該方法的輸入為建筑毀傷前后圖像,通過濾波算法計算輸入圖像對應隱空間圖像。將隱空間圖像的熵、均值、對比度、方差等組成兩組特征向量,使用向量對比方法(余弦相似度、皮爾遜系數等)對比前后特征向量差異度,或是通過構建指標集[11]的形式,完成毀傷估計。特征級毀傷評估方法以深度學習為基礎,依靠卷積神經網絡對圖像深層語義信息提取能力較強的優勢,搭配特殊任務頭(例如語義分割[1213]任務頭)實現建筑毀傷評估。像素級毀傷評估易受限于配準[1415]精度,在配準精度較低時,毀傷前后圖像產生錯位,進而導致像素級評估精度較低。基于深度學習的特征級毀傷評估方案不受制于配準精度,圖像經過多次下采樣后,特征圖不再表征單個像素信息,而是表征一片區域的語義信息,降低了對毀傷前后圖像配準精度的要求。有學者通過將毀傷程度進行離散劃分[1618],定義不同建筑物毀傷等級,依據建筑物自身毀傷程度進行毀傷分類,是深度學習在毀傷評估中的重要應用。

1 建筑毀傷離散劃分與毀傷評估方法比較

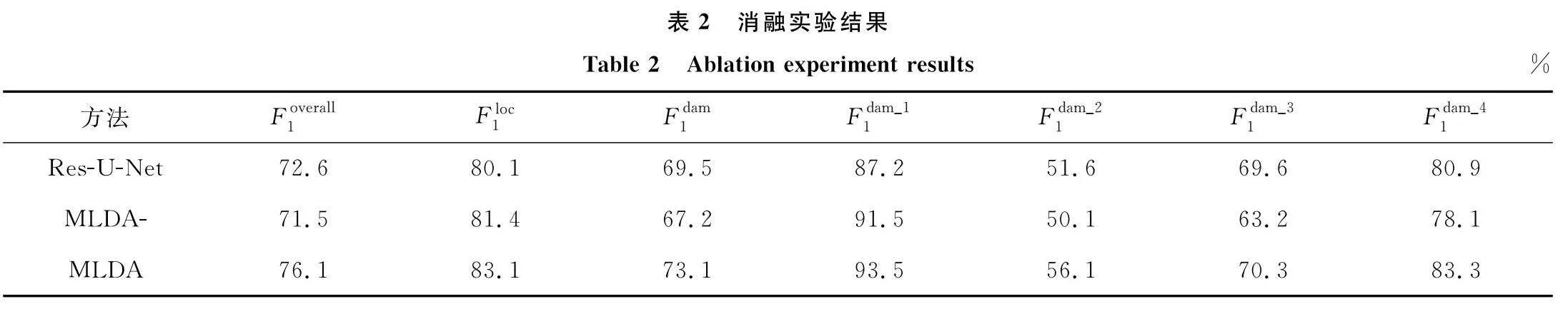

在毀傷離散劃分被提出后,建筑毀傷評估轉變為依據毀傷情況對建筑進行毀傷等級分類。該方法為毀傷評估提供了更加清晰的評判準則,結合遙感圖像大視野的優勢,以語義分割的形式對遙感圖像中建筑進行毀傷等級劃分,可以迅速完成大面積區域的毀傷評估。因此,毀傷評估逐漸轉為對毀傷建筑圖像進行語義分割,如圖1所示。圖2(a)為基于語義分割的毀傷評估,通過端到端的語義分割模型將圖像中的建筑物分割為不同的毀傷等級。目前,基于語義分割的毀傷評估的最大難點在于建筑與毀傷特征多樣性的交融。建筑物自身具有多樣性,而毀傷作用于建筑上并非單一的疊加,而是從結構、顏色和完整度等多個方面對建筑物產生影響。例如,倒塌作用于房屋與燃燒作用于房屋會產生

不同的毀傷特征。建筑與毀傷多樣性的交融導致模型需要學習大量特征以完成評估。針對該問題,基于深度學習的變化檢測[1920]使用建筑發生變化前后的圖像作為輸入,通過上下文信息推理變化信息,降低模型學習過程的難度。毀傷評估可使用類似方法,通過對比建筑毀傷前后圖像的方式實現建筑特征與毀傷特征的分離,避免模型直接學習建筑與毀傷交融后的特征,進而降低模型學習難度。但變化檢測僅識別目標變化的有無,毀傷評估需要對目標進行不同毀傷等級分類,屬于更細粒度的任務,需要在變化檢測的基礎上額外加入后置分類器以完成毀傷評估。為避免后置分類器等額外操作,可將毀傷評估劃分為區域提取與毀傷分割兩個子任務。圖2(b)為雙階段的毀傷評估,其中包括建筑區域提取與毀傷分割兩個子任務。建筑區域提取依賴建筑自身特征,而毀傷分割依賴毀傷特征,該方法對毀傷評估進行了解耦,卻將單階段任務分為建筑區域提取[2122]與毀傷分割兩階段完成,是一種非端到端的方法,增加了訓練與推理成本。圖2(c)為本文所提基于多任務學習的建筑毀傷評估方法。此后,有學者在此基礎上通過共享編碼器的方式[23],在編碼器末端引出兩個解碼器,分別完成區域提取與毀傷分割兩個子任務。多個解碼器使得模型存在冗余,并且同時訓練多個解碼器梯度較為混亂,最終影響整體精度,具有一定局限性。

本文使用多任務學習[24]的方式實現端到端毀傷評估,其結構如圖2(c)所示,通過一個編解碼器組搭配多個任務頭完成毀傷評估。將區域提取與毀傷分割兩個子任務使用相同編解碼器完成,進一步降低模型參數量。同時,本文通過上下文信息融合模塊,融合建筑物毀傷上下文信息,使用多任務頭對信息進行解耦,得到多任務學習輸出,在實現端到端的訓練的同時提高了方法的整體精度。

2 毀傷評估方法

2.1 整體框架

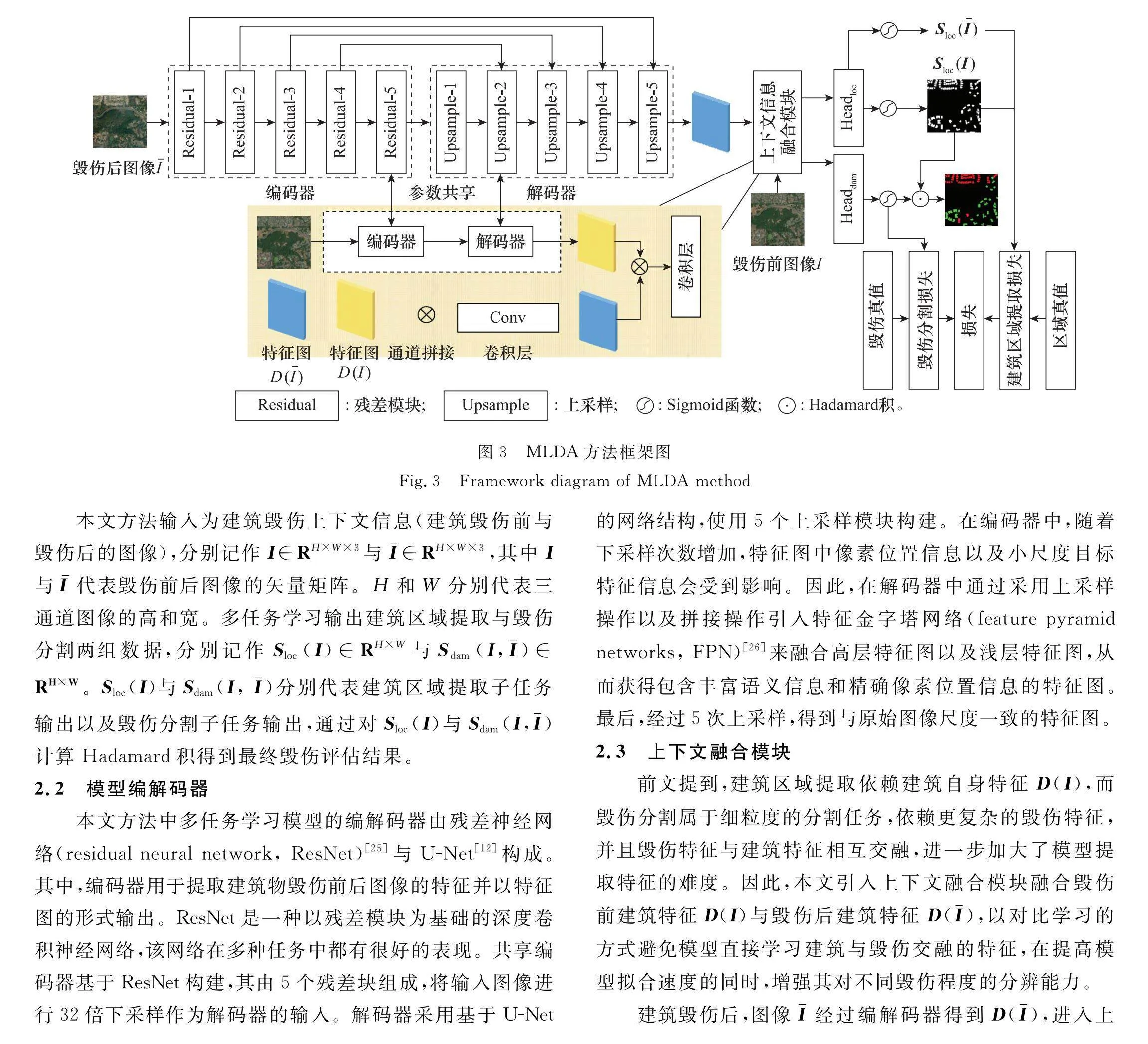

本節介紹多任務學習的毀傷評估(multi-task learning damage assessment, MLDA)方法框架。首先介紹框架整體流程,其次介紹框架中各個模塊以及作用,最后介紹訓練階段的損失函數。

本文使用基于多任務學習的方法完成建筑區域提取與毀傷分割兩個子任務。使用多任務學習一方面完成了建筑區域提取與毀傷分割的解耦,建筑區域提取依賴建筑自身特征,而毀傷分割依賴的是毀傷前后建筑的對比特征。另一方面,相較于不依賴多任務學習的情況,使用兩個模型分別完成建筑區域提取與毀傷分割可得到與多任務學習相同的輸出,但兩個獨立模型無法實現端到端的訓練與推理,同時增加了模型總參數量。建筑區域提取與毀傷分割兩個子任務具有一定相似性,本文通過共享編解碼器方式設計多任務學習方法,在縮減網絡規模的同時降低了推理時間。基于多任務學習的方法是一種端到端的方法,訓練過程與推理過程更加便捷。本文中多任務學習方法的深度學習模型由共享編碼器、共享解碼器、任務頭3部分組成,如圖3所示。

本文方法輸入為建筑毀傷上下文信息(建筑毀傷前與毀傷后的圖像),分別記作I∈RH×W×3與I-∈RH×W×3,其中I與I-代表毀傷前后圖像的矢量矩陣。

H和W分別代表三通道圖像的高和寬。多任務學習輸出建筑區域提取與毀傷分割兩組數據,分別記作Sloc(I)∈RH×W與Sdam(I,I-)∈RH×W。Sloc(I)與Sdam(I, I-)分別代表建筑區域提取子任務輸出以及毀傷分割子任務

輸出,通過對Sloc(I)與Sdam(I,I-)計算Hadamard積得到最終毀傷評估結果。

2.2 模型編解碼器

本文方法中多任務學習模型的編解碼器由殘差神經網絡(residual neural network, ResNet)[25]與U-Net[12]構成。其中,編碼器用于提取建筑物毀傷前后圖像的特征并以特征圖的形式輸出。ResNet是一種以殘差模塊為基礎的深度卷積神經網絡,該網絡在多種任務中都有很好的表現。共享編碼器基于ResNet構建,其由5個殘差塊組成,將輸入圖像進行32倍下采樣作為解碼器的輸入。解碼器采用基于U-Net的網絡結構,使用5個上采樣模塊構建。在編碼器中,隨著下采樣次數增加,特征圖中像素位置信息以及小尺度目標特征信息會受到影響。因此,在解碼器中通過采用上采樣操作以及拼接操作引入特征金字塔網絡(feature pyramid networks, FPN)[26]來融合高層特征圖以及淺層特征圖,從而獲得包含豐富語義信息和精確像素位置信息的特征圖。最后,經過5次上采樣,得到與原始圖像尺度一致的特征圖。

2.3 上下文融合模塊

前文提到,建筑區域提取依賴建筑自身特征D(I),而毀傷分割屬于細粒度的分割任務,依賴更復雜的毀傷特征,并且毀傷特征與建筑特征相互交融,進一步加大了模型提取特征的難度。因此,本文引入上下文融合模塊融合毀傷前建筑特征D(I)與毀傷后建筑特征D(I-),以對比學習的方式避免模型直接學習建筑與毀傷交融的特征,在提高模型擬合速度的同時,增強其對不同毀傷程度的分辨能力。

建筑毀傷后,圖像I-經過編解碼器得到D(I-),進入上下文融合模塊,該模塊融合建筑毀傷上下文信息得到融合后的特征圖。首先,使用一組編解碼器得到毀傷前圖像的特征圖D(I),該組編解碼器與前文提到的模型編解碼器共享參數,在減少模型總參數量的同時也降低了模型學習難度。得到建筑毀傷前與毀傷后的特征圖D(I-)與D(I)。相較于特征圖相加的融合方法,通道拼接能夠保留最原始的特征并進行融合,并且通過后續的卷積操作也能實現類似相加的效果。特征圖相乘的融合方法有利于增強類似特征,會導致部分毀傷特征削弱。因此,使用通道拼接結合卷積的形式實現D(I-)與D(I)的特征融合。

2.4 任務頭

本文將建筑毀傷評估分解為建筑區域提取和毀傷分割兩個子任務,分別為兩個任務設計獨立的任務頭。其中,建筑區域提取屬于粗粒度的二分類分割任務,需要將建筑分割為前景,而其他區域為后景。因此,使用D(I)與D(I-)作為輸入,分別經過兩個1×1卷積,將通道數降至1,再經過Sigmoid激活函數并以0.3為閾值進行二值化,即可得到建筑物區域提取輸出Sloc(I)與Sloc(I-)。

毀傷分割任務頭使用上下文信息融合特征圖為輸入,使用1×1卷積調整通道數,多種毀傷等級導致毀傷分割屬于多分類任務。因此,經過Sigmoid后取最大值索引獲得毀傷分割輸出Sdam(I, I-)。在獲得Sloc(I)與Sdam(I, I-)后,對兩者計算Hadamard積,得到毀傷評估結果。

2.5 損失函數

第2.1節介紹基于MLDA方法的整體框架,本節介紹方法在訓練過程中的損失函數。本文方法的損失函數由建筑區域提取損失和毀傷分割損失組成,具體如下所示:

loss=λ1lossloc+λ2lossdam(1)

其中,建筑區域提取損失(lossloc)與毀傷分割損失(lossdam)分別決定模型對兩個子任務的學習權重,通過加權系數λ1與λ2保證兩個損失值的權衡。

lossloc=Dice(ylocp,yloct)+Dice(y-locp,y-loct)(2)

Dice Loss[27]最早被應用于醫學影像分割中,其源于Dice系數是一種用于評估兩個輸入相似性的函數,數值越大,代表相似性越好,其最大優勢在于可以弱化樣本數量差異導致的各類別之間的失衡。本文實驗部分所使用的數據集中正樣本與負樣本之間存在明顯的數量差異,因此選擇Dice Loss作為分割損失。其中,建筑區域提取損失使用Dice Loss計算,如式(2)所示,式中ylocp與y-locp分別代表建筑區域提取的預測值,即Sloc(I)與Sloc(I-),yloct與y-loct代表前者對應真值。

lossdam=∑iωiDice(ypi,yti)(3)

Dice(X,Y)=1-2|X∩Y||X|+|Y|(4)

毀傷分割損失則是在通道維度計算Dice Loss并求加權和,如式(3)所示。式中ypi與yti分別代表第i類別的預測值與真值,ωi代表不同類別的權重。式(4)為Dice損失計算公式,其中X與Y分別代表預測值與真值。

3 實驗與結果

3.1 實驗設置

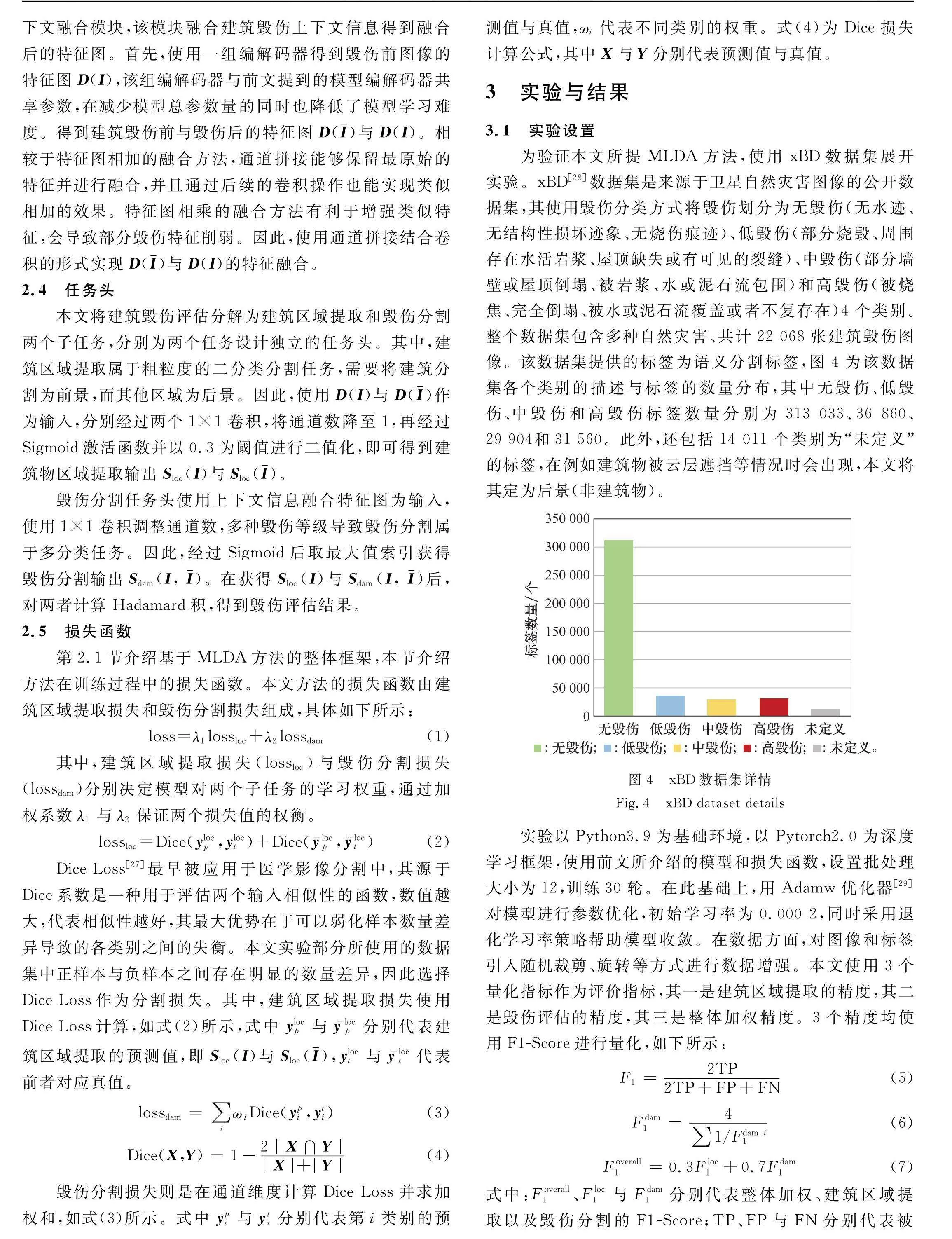

為驗證本文所提MLDA方法,使用xBD數據集展開實驗。xBD[28]數據集是來源于衛星自然災害圖像的公開數據集,其使用毀傷分類方式將毀傷劃分為無毀傷

(無水跡、無結構性損壞跡象、無燒傷痕跡)、低毀傷(部分燒毀、周圍存在水活巖漿、屋頂缺失或有可見的裂縫)、中毀傷(部分墻壁或屋頂倒塌、被巖漿、水或泥石流包圍)和高毀傷(被燒焦、完全倒塌、被水或泥石流覆蓋或者不復存在)4個類別。整個數據集包含多種自然災害、共計22 068張建筑毀傷圖像。該數據集提供的標簽為語義分割標簽,圖4為該數據集各個類別的描述與標簽的數量分布,其中無毀傷、低毀傷、中毀傷和高毀傷標簽數量分別為313 033、36 860、29 904和31 560。此外,還包括14 011個類別為“未定義”的標簽,在例如建筑物被云層遮擋等情況時會出現,本文將其定為后景(非建筑物)。

實驗以Python3.9為基礎環境,以Pytorch2.0為深度學習框架,使用前文所介紹的模型和損失函數,設置批處理大小為12,訓練30輪。在此基礎上,用Adamw優化器[29]對模型進行參數優化,初始學習率為0.000 2,同時采用退化學習率策略幫助模型收斂。在數據方面,對圖像和標簽引入隨機裁剪、旋轉等方式進行數據增強。本文使用3個量化指標作為評價指標,其一是建筑區域提取的精度,其二是毀傷評估的精度,其三是整體加權精度。3個精度均使用F1-Score進行量化,如下所示:

F1=2TP2TP+FP+FN(5)

Fdam1=4∑1/Fdam_i1(6)

Foverall1=0.3Floc1+0.7Fdam1(7)

式中:Foverall1、Floc1與Fdam1分別代表整體加權、建筑區域提取以及毀傷分割的F1-Score;TP、FP與FN分別代表被

模型預測為正類的正樣本的像素數量、被預測為正類的負樣本的像素數量,以及被預測為負類的正樣本的像素數量。

3.2 對比實驗

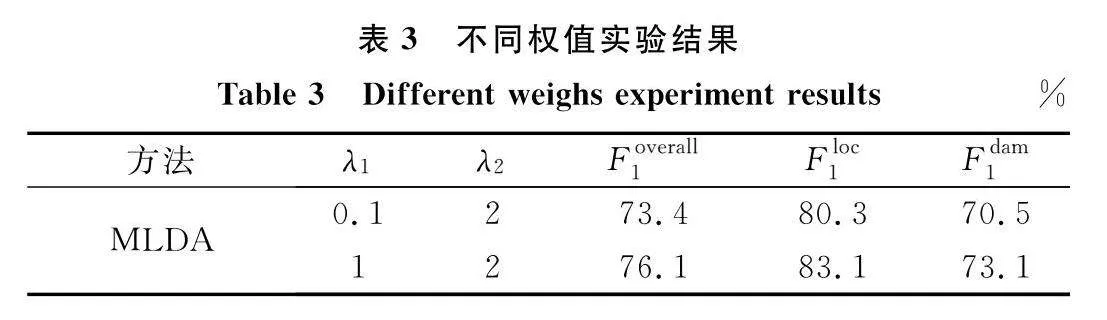

表1為針對本文方法展開的對比實驗結果,

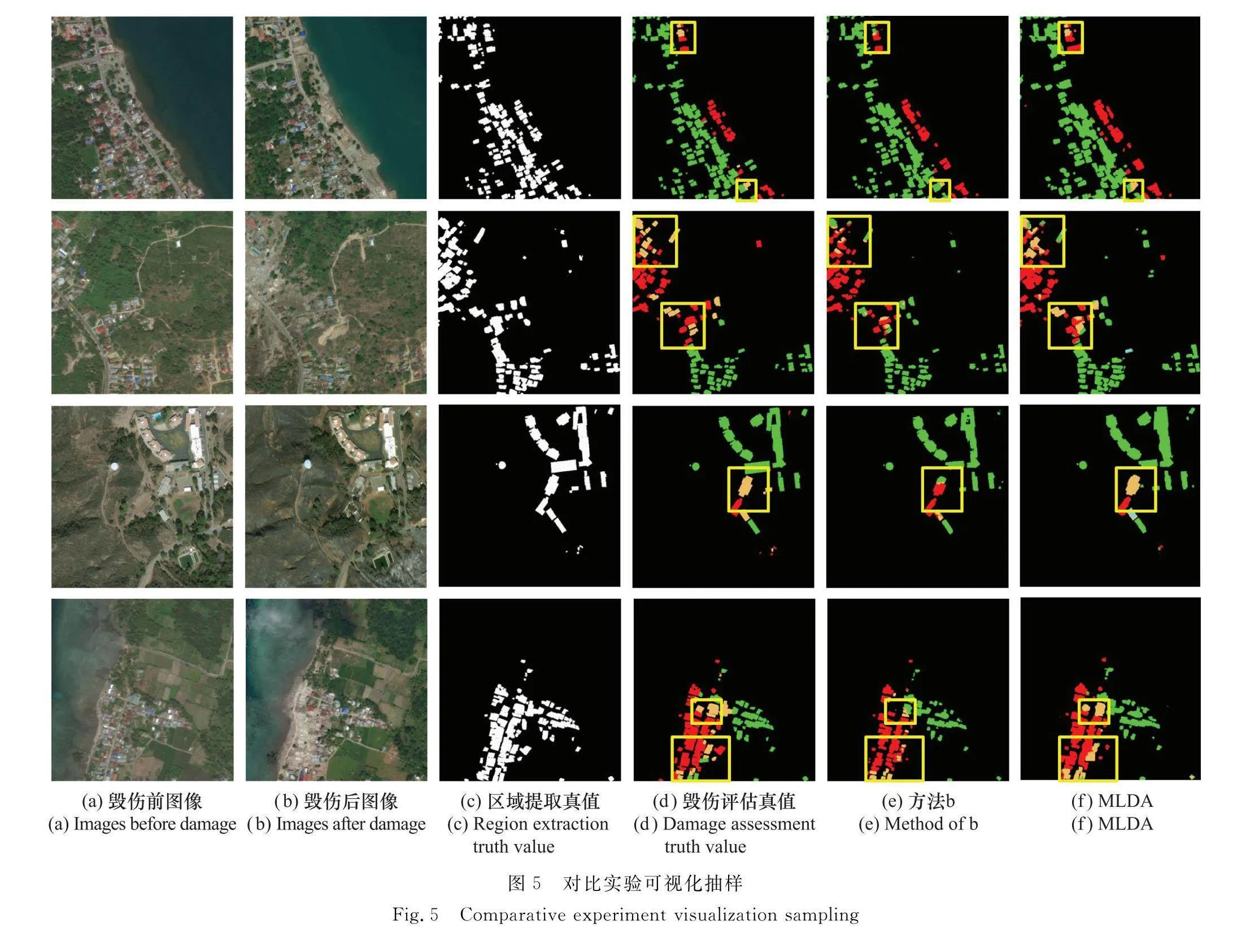

實驗顯示本文所提出的MLDA方法在毀傷評估中有一定的提升。在各個對比實驗中,以xBD-Baseline方法[30]為參考基準。該方法在ResNet50基礎上額外引入旁路模型作為融合,以64為批處理大小,設置初始學習率為0.001,進行100輪訓練。由于沒有平衡各個類別之間的數量而導致準確率較差,其Foverall1為26.5%。方法a[31]使用雙路的ResNet50作為編碼器,將特征拼接后使用額外的后置分割處理器進行毀傷分割,設置批處理大小為8,初始學習率為0.01進行訓練,最終Foverall1為74.1%。方法b[23]通過共享編碼器的方法,額外為兩個子任務設計獨立的解碼器,并且加入更多級聯操作,設置批處理大小為16,初始學習率為0.03,結合數據增強進行訓練,獲得74.5%的Foverall1。本文所提MLDA方法最終Foverall1為76.1%,優于前兩者。同時,本文方法僅使用ResNet50搭配U-Net完成,通過融合建筑毀傷上下文信息進行毀傷評估,不依賴其他額外模塊。圖5為MLDA方法(使用ResNet50)與方法b的實驗結果抽樣。圖5(a)和圖5(b)分別為毀傷前后的圖像,即輸入圖像,圖5(c)和圖5(d)分別為建筑區域提取子任務真值與毀傷評估真值,圖5(e)和圖5(f)分別為方法b與本文MLDA方法的毀傷評估預測值,其中黃色框為MLDA方法在毀傷評估中相較于方法b的提升。

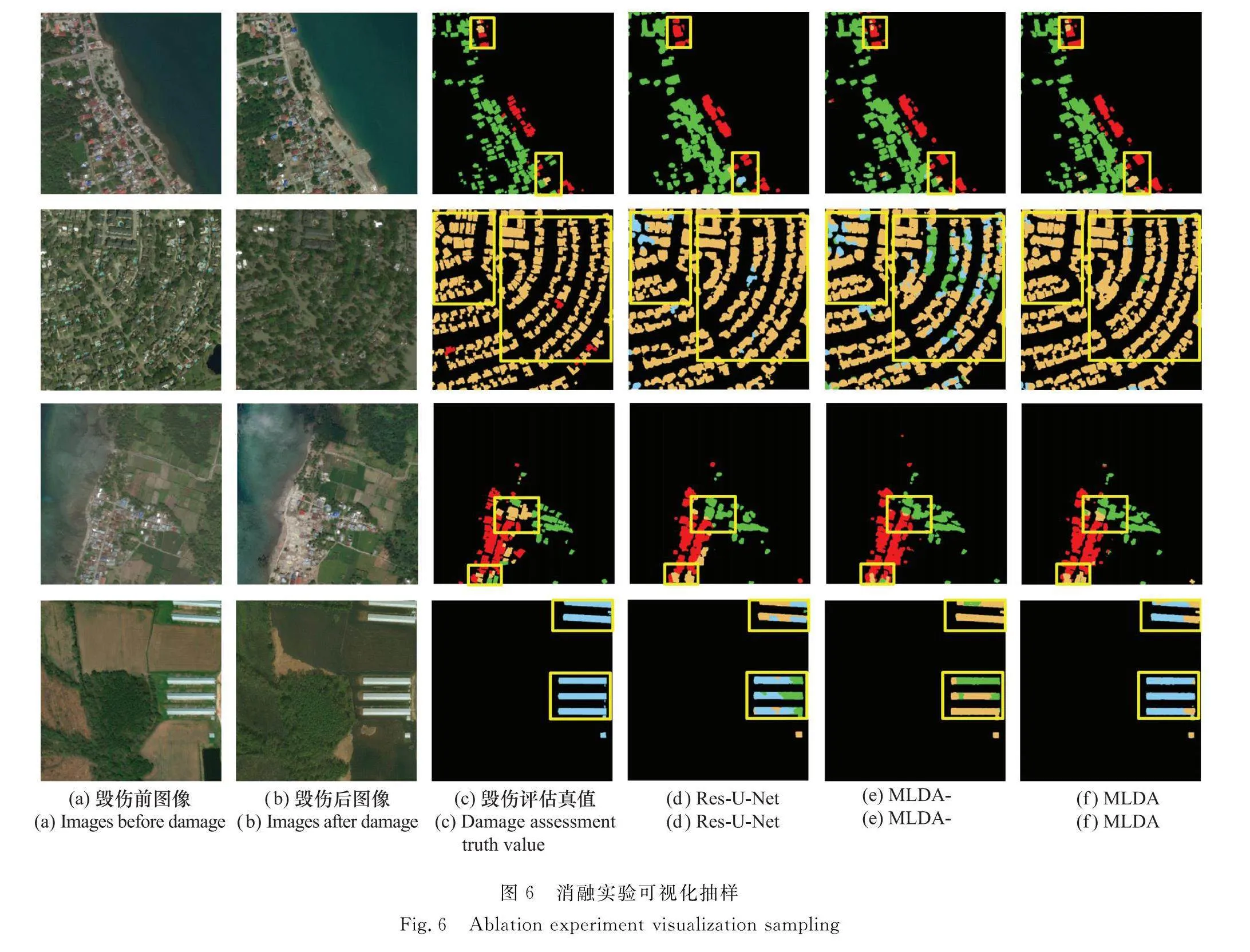

3.3 消融實驗

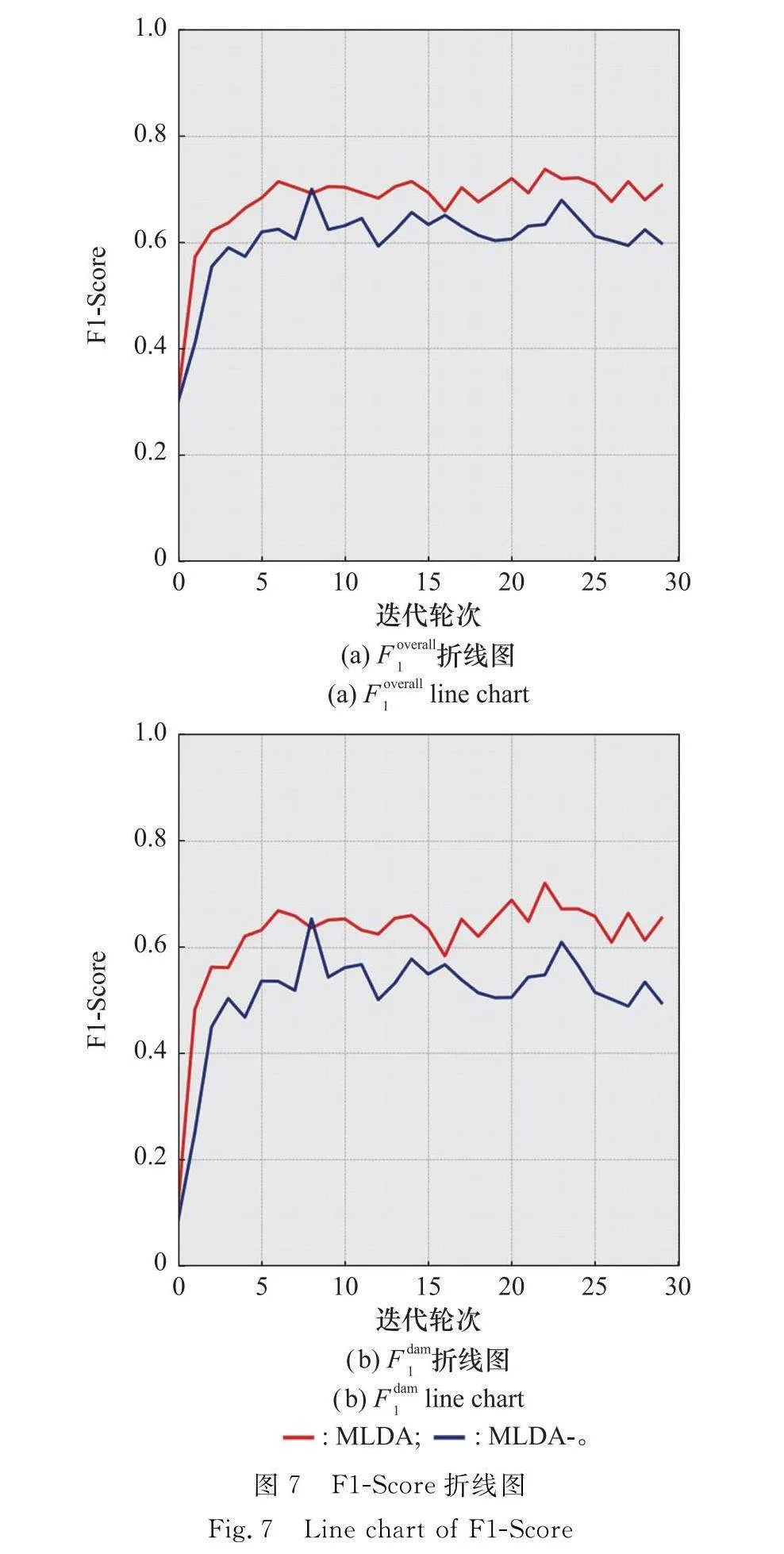

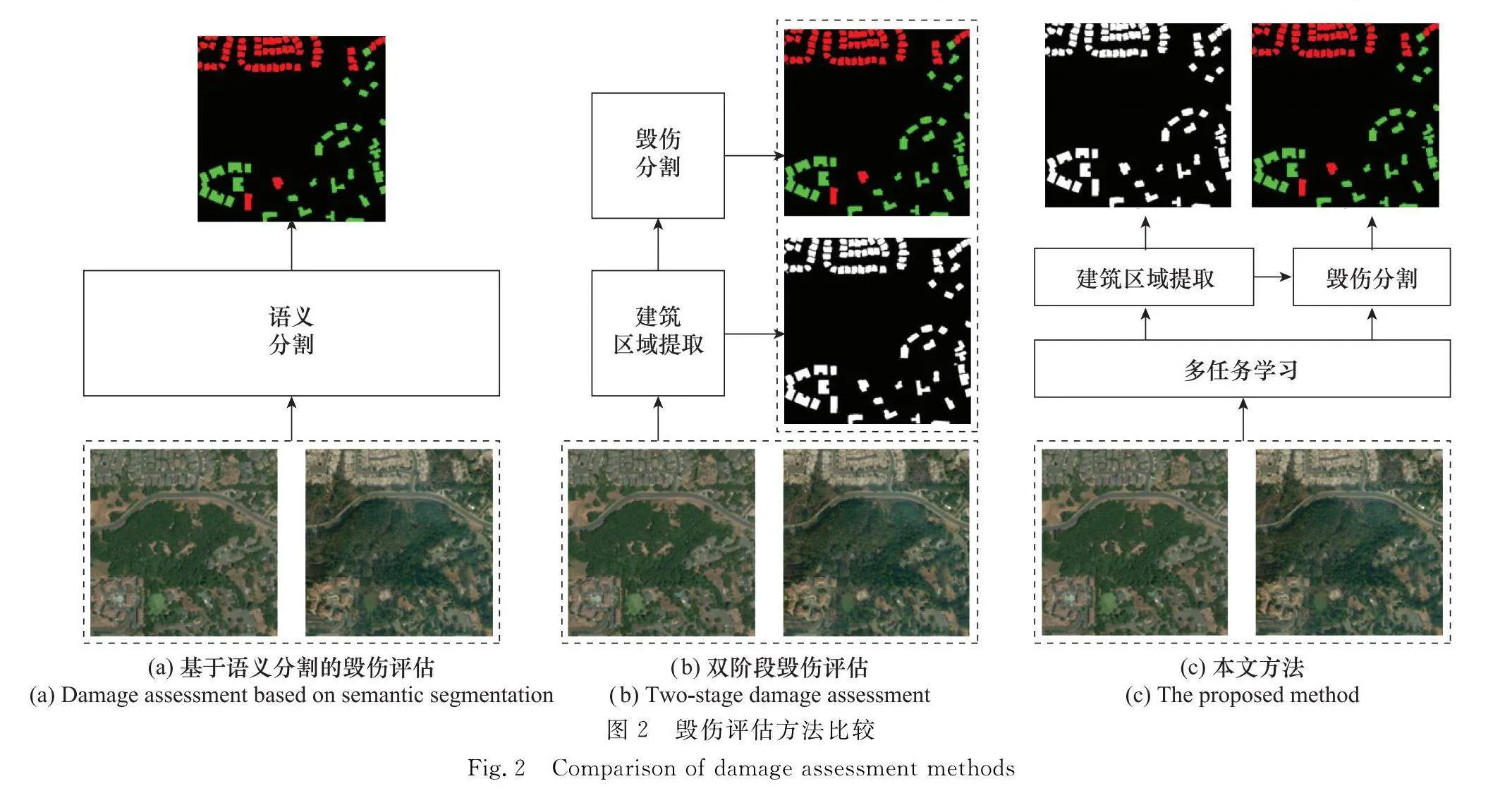

本文針對MLDA進行了消融實驗,具體如表2與圖6所示。表2中,Res-U-Net方法是以ResNet50為主干網,結合U-Net模型并且不依賴多任務學習進行的實驗。其輸入為在通道維度拼接的建筑毀傷前后圖像,并且針對ResNet50修改其第一層卷積層輸入維度為6,最終Foverall1為72.6%,低于MLDA方法。其中,建筑區域提取、無毀傷、低毀傷F1-Score較低,這表明多任務學習對建筑區域提取與毀傷分割有一定的解耦能力。表2中,MLDA-方法是在未使用上下文信息融合模塊的條件下進行的實驗,相較于MLDA取消了毀傷上下文信息融合,在使用ResNet50作為主干網的情況下得到的Foverall1為71.5%,低于其他兩種方法。其中,MLDA-方法區域提取子任務Floc1與毀傷評估Fdam1分別為81.4%與67.2%。相較于Res-U-Net方法,MLDA-方法的Floc1更高,再次表明多任務學習對建筑區域提取與毀傷分割有一定的解耦能力。與MLDA方法相比,MLDA-方法毀傷分割子任務的準確率較低,表明上下文融合模塊提高了模型學習毀傷特征的能力,以對比學習的方式避免了模型直接學習復雜的毀傷特征。圖7為MLDA方法與MLDA-方法迭代不同輪次的Foverall1與Fdam1。圖7中,紅色折線和藍色折線分別代表MLDA方法與MLDA-方法,MLDA方法在訓練迭代輪次初期即得到較高的準確率,上下文融合模塊在降低毀傷特征學習難度的同時也提高了模型學習速度,加快了模型收斂速度。

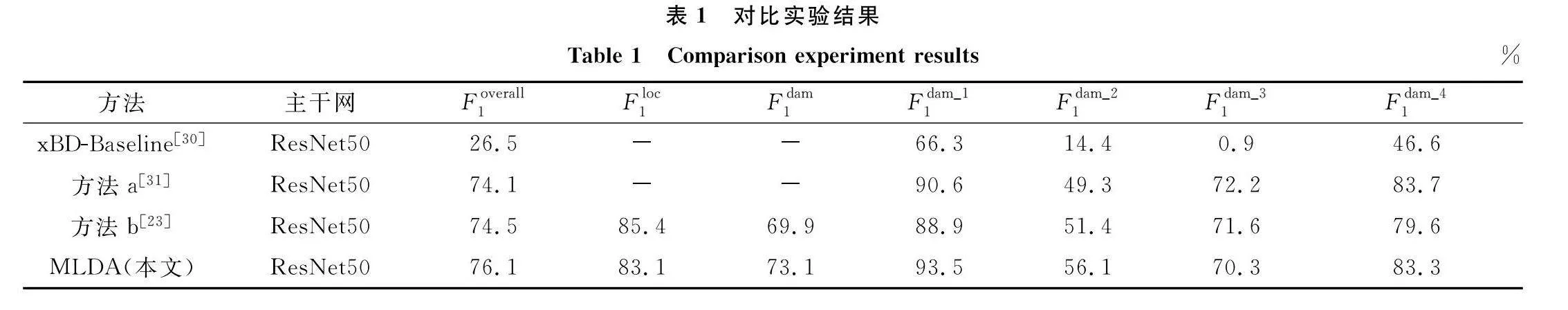

本文針對多任務學習的損失權重進行了實驗,相比于雙階段的毀傷評估,基于MLDA通過對損失函數的加權實現對兩個任務的權衡。式(1)為本文的總損失函數,其中λ1與λ2分別代表建筑區域提取與毀傷分割損失值的權值。通過加權系數保證兩個損失的數量級保持相當,lossloc包含毀傷前與毀傷后的區域提取損失,因此選擇λ1∶λ2=1∶2進行訓練,同時使用λ1∶λ2=0.1∶2驗證不同加權值對結果的影響。

表3為不同權值的實驗結果,在建筑區域提取與毀傷分割損失權值λ1∶λ2=0.1∶2時,由于損失的失衡導致建筑區域提取子任務Floc1較低,并最終導致多任務學習整體準確率下降。

4 結 論

本文提出一種MLDA方法,通過共用編解碼器搭配多個獨立任務頭的方式完成建筑物區域提取與毀傷分割兩個子任務。再使用Hadamard積融合兩個子任務輸出,得到最終毀傷評估結果。引入上下文融合模塊,融合毀傷建筑上下文信息,降低模型學習難度。本文在xBD數據集上展開實驗,實驗結果證明,本文方法在建筑毀傷評估任務中精度有所提升。

本文使用基于遙感圖像的建筑毀傷數據集驗證所提方法的有效性,但遙感圖像質量低,影響最終評估精度。無人機航拍圖像具有易獲取和質量高的優勢,使用無人機航拍圖像替代遙感圖像,本文方法會有更好的性能和應用。

參考文獻

[1] ZHENG S Q, LI X D, ZHU L L. Optimal time-efficient UAV area coverage path planning based on raster map[C]∥Proc.of the International Conference on Advanced Robotics and Mechatronics, 2023: 727732.

[2] 王建峰, 賈高偉, 郭正, 等. 多無人機協同任務規劃方法研究綜述[J/OL]. 系統工程與電子技術: 118[20240923]. http:∥kns.cnki.net/kcms/detail/11.2422.TN.20230419.1331.010.html.

WANG J F, JIA G W, GUO Z, et al. Research status and development of multi-UAV system mission planning[J/OL]. Systems Engineering and Electronics: 118[20240923]. http:∥kns.cnki.net/kcms/detail/11.2422.TN.20230419.1331.010.html.

[3] TCHINDA N E, PANOFF K M, KWADJO T D, et al. Semi-supervised image stitching from unstructured camera arrays[J]. Sensors, 2023, 23(23): 94819501.

[4] 楊丹寧. 基于受災點應急需求分析的地震初期應急物資分配問題研究[D]. 北京: 北京交通大學, 2023.

YANG D N. A study on the distribution of emergency supplies at the early stage of earthquake based on the analysis of emergency needs at the affected sites[D]. Beijing: Beijing Jiao Tong University, 2023.

[5] 李陽, 張玉梅, 趙彥東, 等. 基于云貝葉斯網絡的毀傷效果評估方法[J]. 火力與指揮控制, 2020, 45(3): 144149.

LI Y, ZHANG Y M, ZHAO Y D, et al. Method of battle da-mage assessment based on cloudy Bayesian network[J]. Fire Control amp; Command Control, 2020, 45(3): 144149.

[6] LI X D, FIR D K, JEAN D. Multi-source information fusion: progress and future[J]. Chinese Journal of Aeronautics, 2024, 37(7): 2458.

[7] 王廣學, 黃曉濤, 周智敏. 基于圖像分割的VHF SAR葉簇隱蔽目標差值變化檢測[J]. 電子學報, 2020, 38(9): 19691974.

WANG G X, HUANG X T, ZHOU Z M. VHF SAR difference change detection of target in foliage based on image segmentation[J]. Acta Electronica Sinica, 2020, 38(9): 19691974.

[8] CHEN J, CHEN X H, CUI X H, et al. Change vector analysis in posterior probability space: a new method for land cover change detection[J]. IEEE Geoscience and Remote Sensing Letters, 2010, 8(2): 317321.

[9] MARIUS P, ANDREAS D, TOBIAS U, et al. Automated extraction of annual erosion rates for arctic permafrost coasts using sentinel- deep learning, and change vector analysis[J]. Remote Sensing, 202 14(15): 36563681.

[10] 苗添, 曾虹程, 王賀, 等. 基于迭代閾值分割的星載SAR洪水區域快速提取[J]. 系統工程與電子技術, 202 44(9): 27602768.

MIAO T, ZENG H C, WANG H, et al. A fast extraction method of flood areas based on iterative threshold segmentation using spaceborne SAR data[J]. Systems Engineering and Electronics, 202 44(9): 27602768.

[11] 楊青青, 樊桂花. 基于改進模糊綜合評判法的建筑物毀傷效果評估[J]. 系統工程與電子技術, 2018, 40(9): 20262031.

YANG Q Q, FAN G H. Battle damage assessment of building based on improved fuzzy comprehensive evaluation method[J]. Systems Engineering and Electronics, 2018, 40(9): 20262031.

[12] RONNEBERGER O, FISCHER P, BROX T. U-net: convolutional networks for biomedical image segmentation[C]∥Proc.of the Medical Image Computing and Computer-assisted Intervention, 2015: 234241.

[13] XIE E Z, WANG W H, YU Z D, et al. SegFormer: simple and efficient design for semantic segmentation with transfor-mers[J]. Advances in Neural Information Processing Systems, 202 34: 1207712090.

[14] ZHONG A Q, FU Q, HUANG D F, et al. A topology based automatic registration method for infrared and polarized coupled imaging[J]. Applied Sciences, 202 12(24): 1259612607.

[15] DENG X, LIU E P, LI S X, et al. Interpretable multi-model image registration network based on disentangled convolutional sparse coding[J]. IEEE Trans.on Image Processing, 2023, 32: 10781091.

[16] 徐藝博, 于清華, 王炎娟, 等. 基于多源信息融合的巡飛彈對地目標識別與毀傷評估[J]. 系統仿真學報, 2024, 36(2): 511521.

XU Y B, YU Q H, WANG Y J, et al. Ground target recognition and damage assessment of patrol missiles based on multi-source information fusion[J]. Journal of System Simulation, 2024, 36(2): 511521.

[17] 李琳, 孫世巖, 曾雅琴, 等. 基于改進CRITIC-Bayes網絡的激光武器毀傷效果評估方法[J]. 兵器裝備工程學報, 2023, 44(7): 109115.

LI L, SUN S Y, ZENG Y Q, et al. Evaluation methods of laser weapon damage effect based on improved CRITIC-Bayes network[J]. Journal of Ordnance Equipment Engineering, 2023, 44(7): 109115.

[18] NIA K R, MORI G. Building damage assessment using deep learning and ground-level image data[C]∥Proc.of the 14th Conference on Computer and Robot, 2017: 95102.

[19] 麻連偉, 寧衛遠, 焦利偉, 等. 基于U-Net卷積神經網絡的遙感影像變化檢測方法研究[J]. 能源與環保, 202 44(11): 102106.

MA L W, NING W Y, JIAO L W, et al. Research on remote sensing image change detection method based on U-Net convolutional neural network[J]. China Energy and Environmental Protection, 202 44(11): 102106.

[20] FAN Z P, WANG S Q, PU X T, et al. Fusion-former: fusion features across transformer and convolution for building change detection[J]. Electronics, 2023, 12(23): 48234836.

[21] WANG X D, TIAN M L, ZHANG Z J, et al. SDSNet: building extraction in high-resolution remote sensing images using a deep convolutional network with cross-layer feature information interaction filtering[J]. Remote Sensing, 2023, 16(1): 169191.

[22] 王凌霄, 賈婧. 基于改進DeepLabv3plus算法的遙感圖像海島建筑提取方法[J]. 熱帶地理, 202 41(4): 834844.

WANG L X, JIA J. Extraction method of island buildings in remote sensing images based on improved DeepLabv3plus algorithm[J]. Tropical Geography, 202 41(4): 834844.

[23] ZHENG Z, ZHONG Y F, WANG J J, et al. Building damage assessment for rapid disaster response with a deep object-based semantic change detection framework: from natural disasters to man-made disasters[J]. Remote Sensing of Environment, 202 265: 112636112653.

[24] SHENG W J, LI X D. Multi-task learning for gait-based identity recognition and emotion recognition using attention enhanced temporal graph convolutional network[J]. Pattern Recognition, 202 114: 107868107880.

[25] HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]∥Proc.of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 770778.

[26] LIN T Y, DOLLAR P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]∥Proc.of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 21172125.

[27] MILLETARI F, NAVAB N, AHMADI S. V-net: fully convolutional neural networks for volumetric medical image segmentation[C]∥Proc.of the 4th Conference on 3D Vision, 2016: 565571.

[28] GUPTA R, GOODMAN B, PATEL N, et al. Creating xBD: a dataset for assessing building damage from satellite imagery[C]∥Proc.of the IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops, 2019: 1017.

[29] LOSHCHILOV I, HUTTER F. Decoupled weight decay regularization[C]∥Proc.of the International Conference on Learning Representations, 2018.

[30] GUPTA R, HOSFELT R, SAJEEV S, et al. xBD: a dataset for assessing building damage from satellite imagery[EB/OL]. [20240130]. https:∥arXiv preprint arXiv:1911.09296, 2019.

[31] WEBER E, KANE H. Building disaster damage assessment in sate-llite imagery with multi-temporal fusion[EB/OL]. [20240130]. https:∥arXiv preprint arXiv:2004.05525, 2020.

作者簡介

王一博(1999—),男,碩士研究生,主要研究方向為深度學習、圖像處理。

張樂飛(1980—),男,高級工程師,博士,主要研究方向為無人系統總體技術、無線電通信技術、數據鏈系統體系設計。

李新德(1975—),男,教授,博士,主要研究方向為人工智能、智能機器人、機器視覺感知。