CamShift在加油錐套識別跟蹤中的應用

支健輝,孔星煒,董新民,方園,王旭峰,尹寧寧

(1.空軍工程大學航空航天工程學院,陜西西安710038;2.西安建筑科技大學冶金工程學院,陜西西安710055)

0 引言

近年來,無人機在未來戰爭中的作用受到越來越多專家、學者的關注[1]。在保持其小型化、機動速度快、維護費用低、生存能力強等優點的基礎上,無人機自主空中加油技術可顯著延長其留空時間,從而極大地提高有效完成各種作戰/非作戰任務的能力。因此,自主空中加油技術的相關研究成為國內外軍事領域研究熱點之一[2-3]。

無人機自主空中加油方式分為硬管式和軟管式兩種。較之硬管式空中加油,軟管式裝備質量輕、改裝簡易、操作相對簡單,因此,開展軟管式自主空中加油研究在軍事領域中具有重大意義[4]。對加油錐套的精確識別和跟蹤技術是軟管式自主空中加油的關鍵技術之一,為實現受油機插頭與加油機錐套的成功對接提供了有力保障[5]。以往的相對導航系統過多地依賴于GPS和慣性導航元件,在空中加油的近距階段,GPS信號容易因機體的遮擋而失真。隨著先進光學傳感器的迅猛發展,通過機器視覺測量解算錐套空間位置已成為該領域的研究熱點[6]。因此,研究高精度加油錐套識別跟蹤技術對于無人機自主空中加油具有重要意義。

均值漂移(MeanShift)算法是一種較為典型的無參目標跟蹤算法,能夠實時跟蹤非剛性目標,對目標的變形、旋轉等有較好的適用性,可以有效提高搜索效率;但其核函數窗寬固定不變,導致跟蹤準確性降低,尺度定位失準,甚至丟失目標[7]。CamShift算法是在MeanShift算法的基礎上改進而來,其搜索窗口大小可以自適應地進行調整,即根據遠離或者靠近受油機時加油錐套的尺寸而自動調整搜索窗的窗寬[8]。

本文著眼于加油錐套的識別跟蹤問題,充分考慮了CamShift跟蹤算法的優缺點,提出一種基于CamShift的加油錐套識別跟蹤算法。通過VC與OpenCV相結合,編寫了位置解算程序,并進行了算法的試驗驗證。

1 錐套識別定位

1.1 特征提取

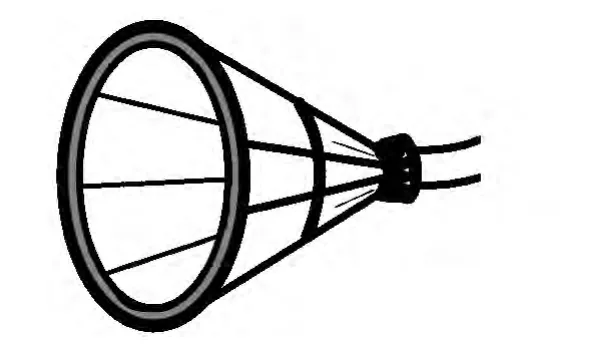

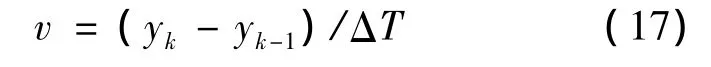

特征提取[9]是運動目標跟蹤的一個重要環節。一般選擇一個有區分度的目標特征作為特征提取的標準,如目標的邊緣、輪廓或其顏色直方圖等;在對復雜目標進行跟蹤時,可以聯合多種特征進行目標跟蹤。本文設計了如圖1所示的一種錐套等比例物理模型,錐套端面為紅色雙環結構,選取顏色和外形兩種特征對錐套進行識別。

圖1 加油錐套模型Fig.1 Drogue model

將錐套圖像從RGB空間轉換到HSV空間進行目標識別。將一般數碼相機采集到的圖像(即RGB空間圖像)轉換為HSV空間圖像需作如下變換[10]:

1.2 圖像分割

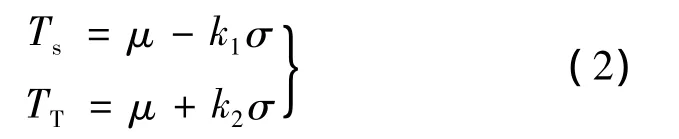

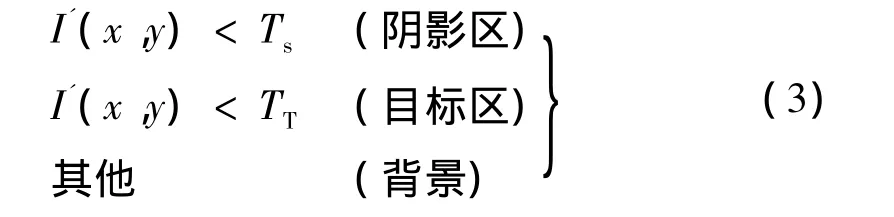

在式(1)基礎上,對圖像中的目標和背景進行分割。考慮天空中陽光和云層干擾的問題,采用自適應閾值分割提升算法的魯棒性,分割公式為:

式中:Ts為陰影區域閾值;TT為目標區域分割閾值;μ為圖像灰度均值;σ為圖像灰度方差;k1和k2為調整因子。則有自適應閾值化規則[11]為:

式中:I(x,y)為圖像像素值。

1.3 錐套定位

經過圖像分割后,對加油錐套的紅色雙環特征區域的邊緣進行最小二乘橢圓擬合[12],得到的雙環中心應該重合,擬合得到的兩條橢圓曲線中心距離應很小。考慮測量和擬合誤差,可設為一個較小值,如5個像素,即初次檢測時雙環中心距離小于5像素。若雙環運動快,圖像出現運動模糊,則適當放寬。相對移動速度比較快時,可設雙環中心距離小于20像素。

對加油錐套的紅色雙環特征區域的邊緣進行最小二乘橢圓擬合得到的內、外橢圓長軸之比要求在一定范圍之內,當內、外橢圓長軸之比為在0.6~0.8范圍之內時,即可認為檢測到的雙環為加油錐套的紅色雙環特征區域;反之,則認為不是。

2 加油錐套CamShift跟蹤算法

2.1 MeanShift算法

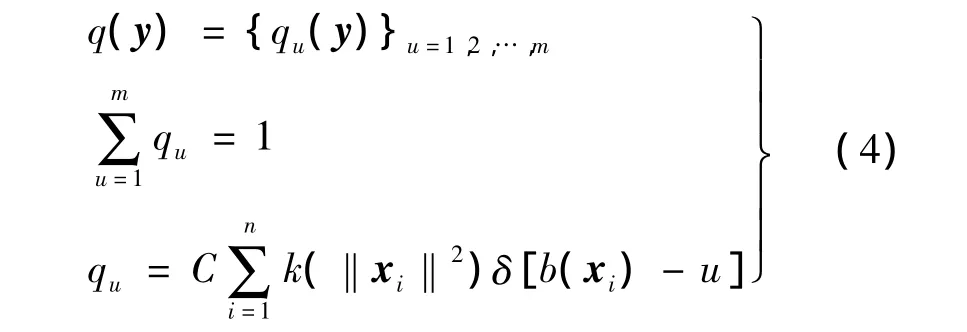

為了描述所跟蹤的目標,定義目標模型和候選目標的概率密度函數為[13]:

目標模型:

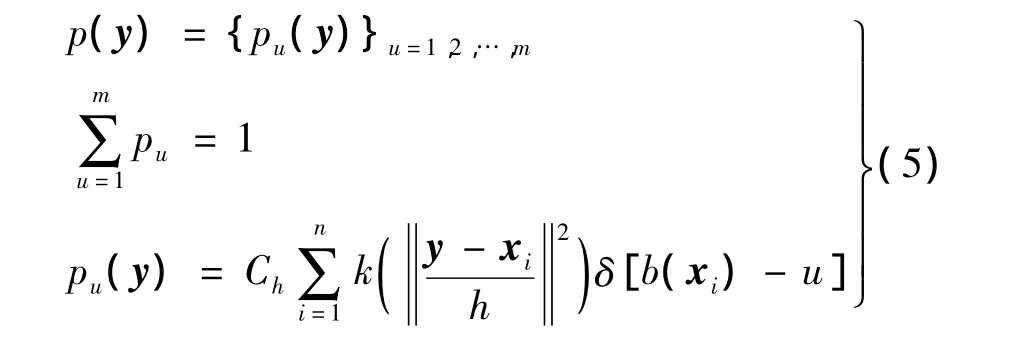

候選目標:

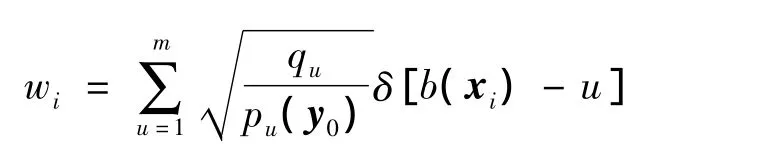

式中:qu,pu(y)分別為錐套目標模型和候選目標的第u級特征概率密度;C,Ch為歸一化常數;k(˙)為剖面核函數;δ(˙)為克羅內克δ函數;b為顏色直方圖中的索引值;xi為歸一化后目標窗口區域的像素坐標;y為“候選目標”的中心;h為核半徑。

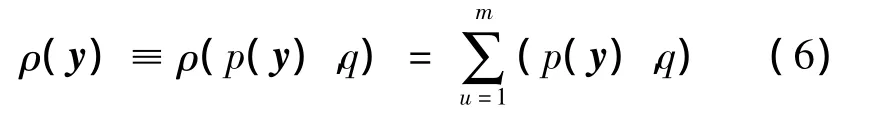

至此,錐套跟蹤的問題轉化為匹配這兩個概率密度函數的相似性度量問題。使用巴氏系數表征相似性,定義為:

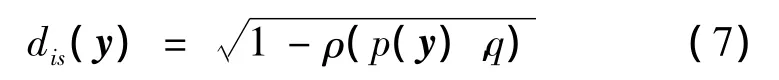

式中:ρ(y)表示上一幀中目標模型概率密度函數和當前幀中以y為中心的候選目標概率密度函數的相似性。以目標模型和候選目標之間的距離作為相似性測度函數的相似性判據,定義如下:

找到當前幀中目標的位置,即求解式(7)中距離的極小值。dis(y)最小化等價于巴氏系數ρ(y)的最大化。在當前幀中搜索目標新位置從前一幀目標的位置y0開始。因此需首先計算候選目標在當前幀中 y0位置處的概率密度函數{pu(y0)}u=1,2,…,m。

對ρ(y)在pu(y0)處進行泰勒級數展開,則ρ(y)可以近似為:

高空中大氣紊流、加油機尾渦以及下洗氣流對加油錐套影響較弱,目標位置變化范圍較小,因此,候選目標{qu(y0)}u=1,2,…,m與目標模型 p(y0)之間幾乎沒有突變現象,上式的線性關系是可以近似滿足的,且通常情況下,相鄰兩幀中目標會有部分重疊,則在連續的相鄰兩幀圖像中,這種假設條件也是滿足的。將式(5)代入式(8)可得:

其中:

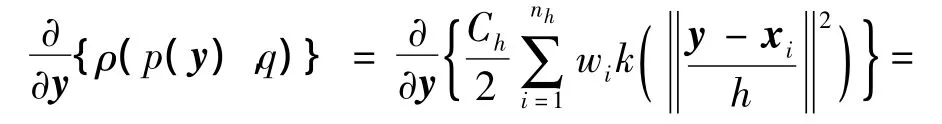

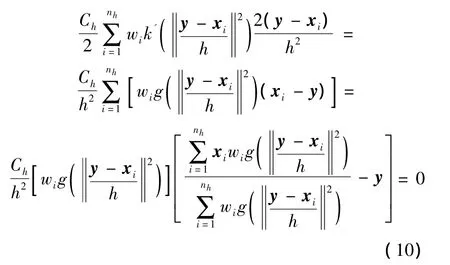

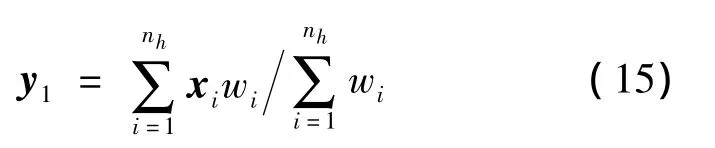

為了最小化式(7),由于式(9)右邊第一項與y無關,故第二項必須最大化。第二項代表核密度估計,核密度的剖面函數為k(‖˙‖2),樣本數據的權重為 wi。對第二項求偏導數,并令其等于零,可得:

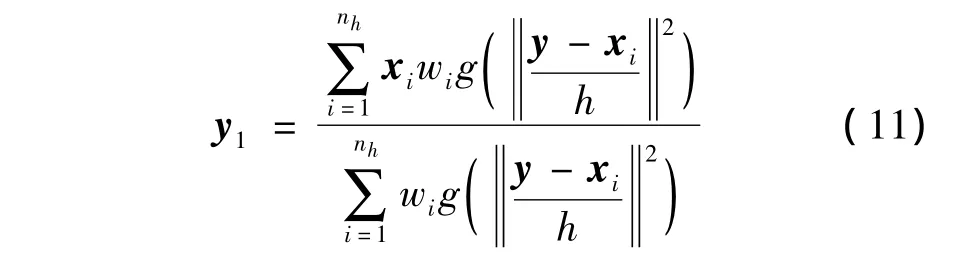

從而得到p(y)最大化的迭代搜索公式:

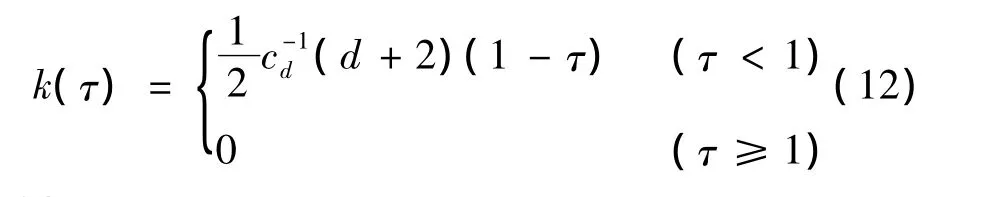

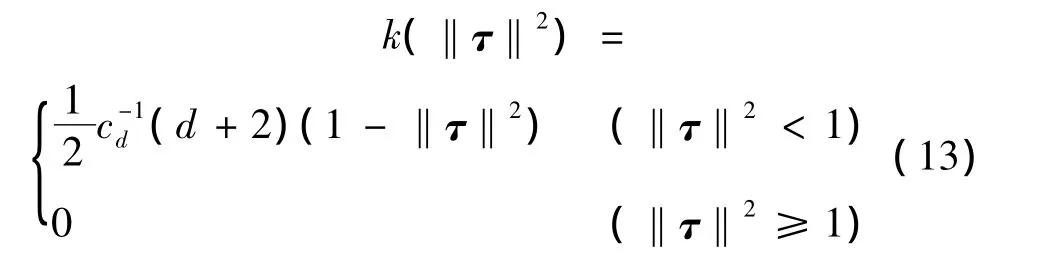

取核函數為Epanechnikov函數:

其剖面函數如下:

式中:cd為單位d維球體的體積;d為向量τ的維數。當τ為二維向量時,Epanechnikov核函數的剖面函數如下所示:

由于其核函數的剖面函數的導數g(˙)為常數,則式(11)簡化為:

反復迭代式(11),使“候選目標”沿著使ρ(y)增大的梯度方向不斷移動,直至ρ(y)達到最大,從而實現基于均值濾波的錐套跟蹤。

2.2 跟蹤窗自適應調整規則

CamShift算法是在MeanShift算法的基礎上改進而來,但其在進行目標跟蹤過程中一般只針對均值漂移向量的方向對目標位置進行跟蹤定位,并不關注目標的實際運動情況,即沒有利用目標在空間中的運動方向和運動速度信息。如果出現目標被遮擋或丟失的情況,僅憑顏色信息難以對目標繼續精確定位,因此需要在均值漂移算法中加入目標運動信息,保證跟蹤效果的穩定性和魯棒性。

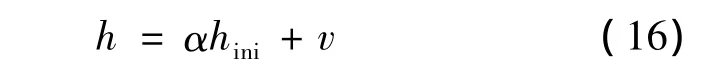

針對上述問題,為了防止目標丟失,本文采用窗寬h自適應調節規則[14]:

式中:α為調節常數;hini為初始搜索窗口寬度;v為目標在像平面的運動速度,即:

式中:ΔT為幀率的倒數;k為當前圖像幀數,取值范圍為(2,n),其中n為跟蹤軟件結束時的圖像幀數。

目標丟失的另一個主要原因是被其他障礙遮擋,而巴氏系數表征了當前窗口區域直方圖與目標直方圖的相似度,當目標發生遮擋時,當前窗口區域的巴氏系數將急劇減小。因此,可將目標是否發生遮擋的判據設置為巴氏系數。設定閾值Th,對于圖像中的目標區域,有:

根據上述判據,跟蹤算法在發現目標發生部分遮擋后即可采取相應的位置估計算法,使跟蹤算法在目標發生遮擋后依然可估計目標位置,進行跟蹤,直至目標不再被遮擋。

3 試驗及結果分析

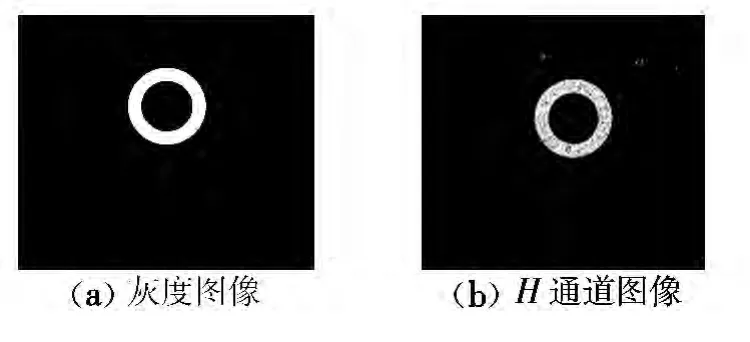

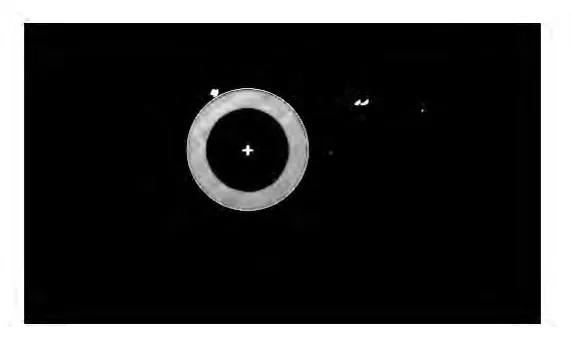

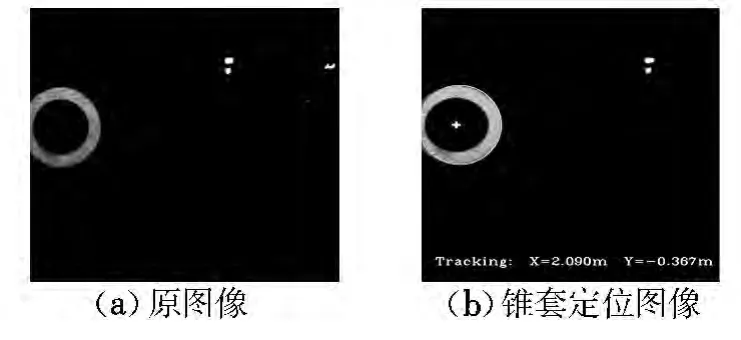

為了驗證本文算法的有效性和準確性,將VC與OpenCV相結合,編寫了錐套識別跟蹤軟件[15]。首先,進行設備的選擇以及幀率、視頻輸出和相關屬性項的設置,然后進行試驗驗證。加油錐套的灰度圖像以及H通道圖像如圖2所示,錐套捕捉定位圖像如圖3所示。

圖2 加油錐套圖像Fig.2 Drogue image

圖3 加油錐套定位Fig.3 Drogue location

由圖3可知,本文算法得到的目標圖像雜光點少,目標中心提取精度高,即使錐套快速運動也無拖影現象,具有良好的實時性。

圖4為存在部分遮擋情況下錐套跟蹤圖像。可以看出,即使在存在部分遮擋的情況下,本文所采用的算法仍然能夠精確地提取加油錐套中心點坐標,且達到毫米級定位精度,具有較高的準確性和魯棒性。

圖4 發生遮擋時的錐套跟蹤Fig.4 Drogue tracking in partial occlusion

4 結束語

本文提出了一種基于HSV色彩空間的Cam-Shift加油錐套識別跟蹤方法。由VC結合OpenCV編寫了位置解算軟件,算法求解精度高,可達到毫米級,且在目標快速運動或部分遮擋的情況下,仍能較好地解算目標位置。試驗結果充分說明了本文算法的實時性、準確性和魯棒性,能夠滿足空中加油中導航任務的需求。

[1] 馮琦,周德云.軍用無人機發展趨勢[J].電光與控制,2003,10(1):9-13.

[2] Nalepka J P,Hinchman J L.Automated aerial refueling:extending the effectiveness of unmanned air vehicles[R].AIAA-2005-6005,2005.

[3] 董新民,徐躍鑒,陳博.自動空中加油技術研究進展與關鍵問題[J].空軍工程大學學報:自然科學版,2008,9(6):1-5.

[4] 慕春棣,李波睿.基于視覺的自動空中加油技術[J].清華大學學報:自然科學版,2012,52(5):670-676,681.

[5] Chen C I,Stettner R.Drogue tracking using 3D flash lidar for autonomous aerial refueling[C]//SPIE Defense,Security,and Sensing.International Society for Optics and Photonics,2011:80370Q-80370Q-11.

[6] Campa G,Fravolini M L,Ficola A,et al.Autonomous aerial refueling for UAVs using a combined GPS-machine vision guidance[C]//AIAA Guidance,Navigation,and Control Conference and Exhibit.Providence,RI,2004:1-11.

[7] Tu Jilin,Hai Tao,Huang Thomas.Online updating appearance generative mixture model for meanshift tracking[J].Machine Vision and Applications,2009,20(3):163-173.

[8] 鄔大鵬,程衛平,于盛林.基于幀間差分和運動估計的Camshift目標跟蹤算法[J].光電工程,2010,37(1):55-60.

[9] 岡薩雷斯,溫茨同.數字圖像處理[M].李叔梁,譯.北京:北京科學出版社,1981.

[10] Zulkifley M A,Mustafa M M,Hussain A.On improving CAMSHIFT performance through colour constancy approach[C]//Computer& Information Science(ICCIS),2012 International Conference on.Kuala Lumpeu:IEEE,2012:375-378.

[11]倪維平,嚴衛東,吳俊政,等.MSTAR圖像2D Gabor濾波增強與自適應閾值分割[J].光電工程,2013,40(3):87-93.

[12] 韓九強,胡懷中,張新曼,等.機器視覺技術及應用[M].北京:高等教育出版社,2009:170-171.

[13] Tian C,Ge G,Ye S,et al.Researches of scale adaptive Mean Shift target tracking algorithm[C]//Intelligent Control and Automation(WCICA),2010 8th World Congress on.Jinan:IEEE,2010:700-703.

[14]云霄,肖剛.基于Camshift的多特征自適應融合船舶跟蹤算法[J].光電工程,2011,38(5):52-58.

[15] Bradski G,Kaehler A.學習 Opencv[M].于仕琪,劉瑞禎,譯.北京:清華大學出版社,2009:371-376.