基于關聯數據的知識發(fā)現技術述評

崔家旺 李春旺

摘 要:文章通過對CLOD、KIELD等關聯數據相關會議、谷歌學術、IEEE和Springer等數據庫基于關聯數據的知識發(fā)現技術文獻的調研與整理,分析和總結了基于關聯數據的知識發(fā)現技術發(fā)展現狀和發(fā)展趨勢。研究認為:根據對關聯數據的挖掘層次的不同,將檢索結果分為間接挖掘、直接挖掘和鏈接挖掘三類;總體而言,基于關聯數據的知識發(fā)現研究仍處于探索階段,相關研究較少且缺乏統(tǒng)一框架;基于關聯數據的知識發(fā)現統(tǒng)一框架的構建以及針對關聯數據知識發(fā)現技術的完善將是未來研究的重點。

關鍵詞:關聯數據;知識發(fā)現;述評

中圖分類號: G302 文獻標識碼: A DOI:10.11968/tsyqb.1003-6938.2016103

Abstract This paper discusses the current status and future directions of the related studies of knowledge discovery technology based on linked data。By Using IEEE,Springer,Google Scholar and other scholarly search engines and collects papers about this subject from related conferences,such as COLD and KIELD,this paper makes a comprehensive study in this subject of research and classifies related papers according to the different knowledge discovery methods. In general,knowledge discovery based on linked data is still in the exploratory stage. There still exists some problems in the knowledge discovery based on linked data, such as the quality problem of linked data;and there is no unified framework for those methods. Getting more convenient knowledge discovery methods based on linked data and building a unified framework for them will be the focus of future research.

Key words linked data; knowledge discovery; review

海量數據與知識貧乏導致了數據挖掘和知識發(fā)現研究的出現。知識發(fā)現(Knowledge Discovery)源于人工智能和機器學習,是機器學習、 人工智能、數據庫和知識庫等眾多學科相互融合而形成的一門適應性強的新興交叉學科。知識是數據元素間的關系或模式,知識發(fā)現就是從大量數據中,特別是從異構的數據平臺中提取出隱含的、未知的、潛在有用的并能被人們理解的規(guī)則與模式,并檢查趨勢、發(fā)掘出事實的高級處理過程[1]。當前有關知識發(fā)現研究主要集中在:粗糙集理論;概念格和形式概念分析;基于分類、關聯規(guī)則、領域知識和圖模型等領域[2]。

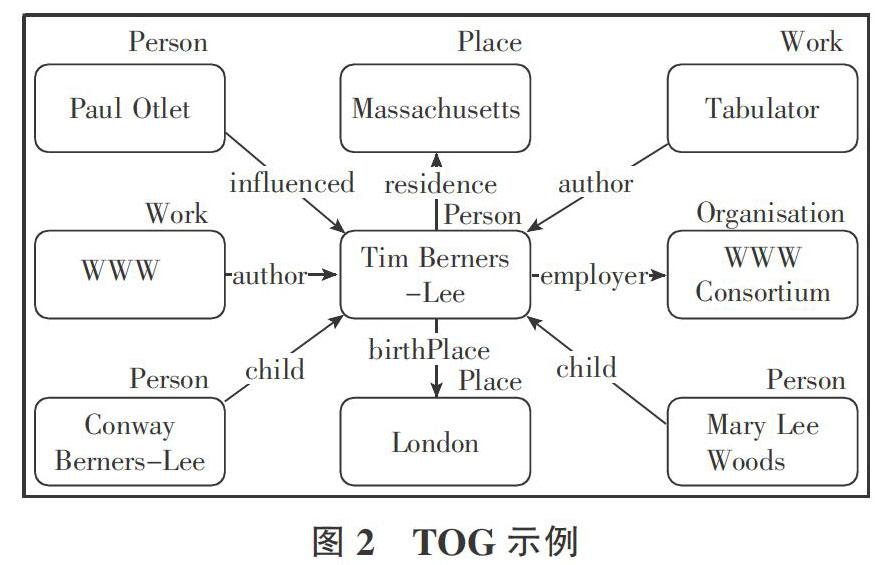

關聯數據的發(fā)布與應用為知識發(fā)現提供了一個新契機,特別是關聯數據預先建立了大量權威、準確的關聯關系,每個數據對象包括多種屬性和特征,從而為實現跨學科領域、跨數據源的精準知識發(fā)現提供有效支撐,使得基于關聯數據的知識發(fā)現成為研究熱點。……