基于宮頸上皮與血管特征的陰道鏡圖像深度學(xué)習(xí)模型探索

李燕云王永明周 奇李亦學(xué)王 振王 玨孟 妍蔡青青隋 龍華克勤

(1復(fù)旦大學(xué)附屬婦產(chǎn)科醫(yī)院宮頸科,4組織部,5女性生殖內(nèi)分泌相關(guān)疾病重點(diǎn)實(shí)驗(yàn)室,6婦科 上海 200011;2上海長(zhǎng)江科技發(fā)展有限公司智能醫(yī)療業(yè)務(wù)中心 上海 200233;3中國(guó)科學(xué)院上海生命科學(xué)研究院 上海 200031)

宮頸癌是最常見的婦科惡性腫瘤[1],有明確的癌前病變過程,即人乳頭瘤病毒(human papillomavirus,HPV)感染后出現(xiàn)低度鱗狀上皮內(nèi)病變(low-grade squamous intraepithelial lesion,LSIL)、高度鱗狀上皮內(nèi)病變(high-grade squamous intraepithelial lesion,HSIL),最終進(jìn)展為浸潤(rùn)癌(invasive carcinoma)。盡管全球范圍內(nèi)宮頸癌篩查已開展數(shù)十年,總體效果卻遠(yuǎn)未令人滿意[1-2]。作為宮頸癌早期診斷三階梯“細(xì)胞學(xué)/HPV初篩→陰道鏡→組織學(xué)確診”中的主要瓶頸,陰道鏡的診斷效率及同質(zhì)化程度一直是國(guó)內(nèi)外宮頸癌防治中的關(guān)鍵點(diǎn)和難點(diǎn)。為了規(guī)范其圖像評(píng)價(jià)標(biāo)準(zhǔn),國(guó)際宮頸病理與陰道鏡聯(lián)盟(International Federation of Cervical Pathology and Colposcopy,IFCPC)于2011年提出了目前全球最全面的陰道鏡圖像描述體系[3],之后2018年美國(guó)陰道鏡與病理協(xié)會(huì)(American Society for Colposcopy and Cervical Pathology,ASCCP)也對(duì)其進(jìn)行了引用[4]。該術(shù)語(yǔ)體系對(duì)宮頸上皮和血管的邊界、輪廓、形態(tài)等重要解剖部位或組織的圖像特征進(jìn)行了極為詳盡的定義及科學(xué)化歸類,涵蓋了醋酸白上皮、鑲嵌、點(diǎn)狀血管、異形血管等幾十種征象的標(biāo)準(zhǔn)化解析[5-8]。然而,作為相對(duì)復(fù)雜的描述性分類,其臨床普及尚有難度。尤其在國(guó)內(nèi),高水平的專業(yè)陰道鏡醫(yī)生極為短缺,基層醫(yī)師水平和能力不足,陰道鏡診斷效能遠(yuǎn)不能滿足大量的臨床需求。

近年,深度學(xué)習(xí)憑借其強(qiáng)大的特征提取能力在提高醫(yī)學(xué)圖像的診斷效率及標(biāo)準(zhǔn)化方面展示出了極佳的應(yīng)用前景[9]。然而,由于較平面圖像更為復(fù)雜、部位多變、需較強(qiáng)專業(yè)背景支撐的跨學(xué)科合作等原因,對(duì)于陰道鏡圖像的智能化判別這一細(xì)分領(lǐng)域,研究成果卻相對(duì)較少[10-14]。2015—2018年,有學(xué)者曾基于傳統(tǒng)機(jī)器學(xué)習(xí)算法,通過從醋酸或碘試驗(yàn)圖像中提取的顏色和紋理等特征信息來(lái)提高識(shí)別精度[15-17]。近年又有學(xué)者嘗試?yán)镁矸e神經(jīng)網(wǎng)絡(luò)訓(xùn)練分類器對(duì)宮頸病變進(jìn)行二分類(LSIL和HSIL)或三分類(HSIL、原位癌、浸潤(rùn)癌)的視覺判別,并取得了一定進(jìn)展[10-14];基于宮頸照相機(jī)攝圖、宮頸醋酸前后比值圖等,深度學(xué)習(xí)輔助HSIL識(shí)別亦獲得尚可的結(jié)果[18-19]。然而在推動(dòng)實(shí)際臨床應(yīng)用方面,上述成果卻遠(yuǎn)未取得實(shí)質(zhì)性進(jìn)展。病變的定性可依靠最終組織病理來(lái)彌補(bǔ),而陰道鏡定位指導(dǎo)活檢或治療則更為重要且無(wú)法取代。此外,上述研究目標(biāo)多為整張圖像的病變分類,無(wú)法具體定位病灶區(qū)域,且相關(guān)報(bào)道極少。曾有個(gè)別學(xué)者嘗試采用分類激活圖譜(class activation mapping,CAM)熱力圖等對(duì)宮頸病灶區(qū)進(jìn)行定位識(shí)別,但判別效果較差[20]。此外,標(biāo)注特征量少(1~3個(gè)特征)導(dǎo)致的信息較為單一,缺乏專業(yè)知識(shí)背景對(duì)圖像特征的規(guī)范化解讀,實(shí)驗(yàn)數(shù)據(jù)量有限(HSIL例數(shù)均<500例),難以與臨床實(shí)際情況相符,亦是目前多數(shù)研究的短板[10-14]。

本研究借助國(guó)際陰道鏡術(shù)語(yǔ)背景,將不易掌握的復(fù)雜描述性分類術(shù)語(yǔ)轉(zhuǎn)化為實(shí)際且便捷的操作體系,彌補(bǔ)了既往研究中標(biāo)注特征量少、信息單一、實(shí)驗(yàn)數(shù)據(jù)量有限等短板。同時(shí)以臨床意義為導(dǎo)向,基于國(guó)內(nèi)最大陰道鏡中心的大樣本數(shù)據(jù),對(duì)陰道鏡圖像進(jìn)行標(biāo)準(zhǔn)化精細(xì)標(biāo)注,并采用經(jīng)二次遷移學(xué)習(xí)的特征提取器構(gòu)建深度學(xué)習(xí)目標(biāo)檢測(cè)模型,探索智能輔助陰道鏡在宮頸病變區(qū)域定位及識(shí)別中的可行性,研究成果不僅適用于臨床篩查,亦可指導(dǎo)活檢及后續(xù)定位治療。

資料和方法

數(shù)據(jù)采集回顧性收集2018年3月至2019年7月復(fù)旦大學(xué)附屬婦產(chǎn)科醫(yī)院宮頸疾病診治中心9臺(tái)陰道鏡儀器記錄的陰道鏡數(shù)據(jù),每位患者包含3~10張不等的陰道鏡圖像以及基本信息文件。陰道鏡檢查儀器包括:3臺(tái)美國(guó)WALLACH公司生產(chǎn)的光電一體數(shù)碼電子陰道鏡(PENTASCOPE)、3臺(tái)德國(guó)Leisegang公司生產(chǎn)的光電一體數(shù)碼電子陰道鏡(BG/LED Y/C)、2臺(tái)深圳EDAN公司生產(chǎn)的電子數(shù)碼陰道鏡(C6 HD)以及1臺(tái)江蘇TRME同人醫(yī)療公司生產(chǎn)的電子數(shù)碼陰道鏡(TR6000G),光電一體數(shù)碼電子陰道鏡均采用Canon EOS600D相機(jī)進(jìn)行拍攝。陰道鏡檢查原因包括:子宮頸細(xì)胞學(xué)檢查陽(yáng)性、高危型HPV檢測(cè)陽(yáng)性、細(xì)胞學(xué)檢查和高危型HPV檢測(cè)均陰性但臨床癥狀明顯,以及其他原因如可疑罹患宮頸(或陰道、外陰)病變等。陰道鏡檢查采用常規(guī)3%醋酸試驗(yàn)及5%盧戈(Lugol’s)液碘染色程序,對(duì)陰道鏡圖像異常區(qū)域行多點(diǎn)活檢,陰道鏡圖像未見異常者行常規(guī)時(shí)鐘3、6、9、12點(diǎn)宮頸活檢及子宮頸管搔刮術(shù)。將活檢組織送病理科檢查,由本院專業(yè)婦產(chǎn)科病理醫(yī)師閱片后作出診斷。根據(jù)2012年版下生殖道和肛門鱗狀上皮病變術(shù)語(yǔ)(The Lower Anogenital Squamous Terminology,LAST),病理診斷結(jié)果分為:子宮頸正常或炎癥、LSIL、HSIL和癌變(包括微浸潤(rùn)癌和浸潤(rùn)癌)[21]。

同時(shí),基于患者基本信息文件中的姓名及檢查日期,通過與同一時(shí)段內(nèi)組織學(xué)病理報(bào)告數(shù)據(jù)中的患者和送檢日期進(jìn)行匹配以獲取患者的病理診斷結(jié)果。剔除無(wú)病理診斷結(jié)果以及數(shù)據(jù)不完整者,共納入最終病理診斷為宮頸LSIL者5 708例、宮頸HSIL者2 206例以及宮頸癌者514例,共計(jì)8 428例患者以及28 975張陰道鏡圖像數(shù)據(jù)。該回顧性研究符合人體試驗(yàn)倫理標(biāo)準(zhǔn),并已獲得復(fù)旦大學(xué)附屬婦產(chǎn)科醫(yī)院倫理委員會(huì)批準(zhǔn)(倫理號(hào):2020-28)。

數(shù)據(jù)標(biāo)注

標(biāo)注規(guī)范 依照2011年國(guó)際宮頸病理與陰道鏡聯(lián)盟IFCPC[3]及2018年美國(guó)陰道鏡與病理協(xié)會(huì)ASCCP陰道鏡標(biāo)準(zhǔn)化術(shù)語(yǔ)體系[4],宮頸病變異常征象包括:薄醋酸白上皮、細(xì)鑲嵌及細(xì)點(diǎn)狀血管,歸為1級(jí)(LSIL)征象;厚醋酸白上皮、粗鑲嵌、粗點(diǎn)狀血管、邊界銳利、內(nèi)部邊界、隆起,歸為2級(jí)(HSIL)征象;白斑、侵蝕性病變及碘染不著色,歸為非特異性征象;異形血管、脆性血管、外生型病變、壞疽、潰瘍等,歸為可疑浸潤(rùn)癌征象;濕疣、息肉、明顯子宮頸觸血等其他征象,歸為雜類。本實(shí)驗(yàn)基于上述體系,對(duì)各類上皮與血管征象制定了20類標(biāo)注標(biāo)簽,對(duì)陰道鏡圖像的病變區(qū)域和級(jí)別進(jìn)行像素級(jí)語(yǔ)義標(biāo)注。包括:(1)薄的醋酸白上皮(含不規(guī)則地圖樣邊界);(2)細(xì)鑲嵌;(3)細(xì)點(diǎn)狀血管;(4)致密醋酸白上皮(含袖口狀腺開口隱窩);(5)粗鑲嵌;(6)粗點(diǎn)狀血管;(7)邊界銳利;(8)內(nèi)部邊界;(9)隆起;(10)異形血管(含非典型血管);(11)脆性血管;(12)表面輪廓不規(guī)則;(13)外生型病變;(14)壞疽;(15)潰瘍;(16)宮頸有腫塊或腫瘤形成。其中,1、4、7、8、9、12、13、14、15和16為上皮特征標(biāo)簽,2、3、5、6、10和11為血管特征標(biāo)簽。0為無(wú)效,檢查不充分或模糊圖像;(17)碘染陰性;(18)陰道圖像;(19)外陰圖像,該四類標(biāo)簽定義為噪聲圖像不納入模型訓(xùn)練樣本。

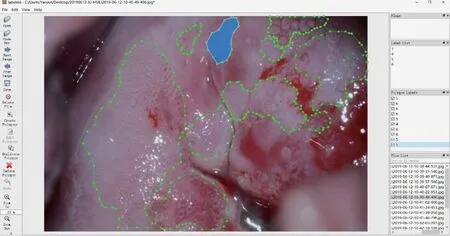

標(biāo)注過程采用開源標(biāo)注工具Labelme。候選醫(yī)師首先通過規(guī)范培訓(xùn)并在指定測(cè)試圖像上的標(biāo)注準(zhǔn)確度不低于65%才可參與數(shù)據(jù)的標(biāo)注工作。依據(jù)以上標(biāo)準(zhǔn)最終選出了50位熟練掌握2011版IFCPC國(guó)際陰道鏡術(shù)語(yǔ)且具有5年以上陰道鏡工作經(jīng)驗(yàn)的陰道鏡專科醫(yī)師。為了便于在標(biāo)注過程中相互審核,每2名醫(yī)師為一小組,按照上述標(biāo)準(zhǔn)規(guī)范對(duì)圖像進(jìn)行第一輪標(biāo)注,標(biāo)注速度為每人30~50張/天。另由10名具有10年以上陰道鏡工作經(jīng)驗(yàn)的陰道鏡醫(yī)師進(jìn)行第二輪專家復(fù)審,每5名標(biāo)注醫(yī)師配備1名專家。審核專家應(yīng)對(duì)不同標(biāo)簽的認(rèn)定標(biāo)準(zhǔn)達(dá)成一致,審核中發(fā)現(xiàn)的問題當(dāng)場(chǎng)修改。最后,由8名算法工程師對(duì)標(biāo)簽的規(guī)范性進(jìn)行第三輪復(fù)審。整個(gè)標(biāo)注過程嚴(yán)格遵循標(biāo)注流程,確保圖像標(biāo)注的準(zhǔn)確性、規(guī)范性和有效性,標(biāo)注示例見圖1。

圖1 基于Labelme軟件對(duì)20類宮頸上皮與血管征象標(biāo)簽及區(qū)域標(biāo)準(zhǔn)化標(biāo)注示例Fig 1 Example of standardized labels based on 20 types of cervical epithelial and vascular signs in Labelme

標(biāo)注后處理將20類標(biāo)簽歸并為五大類:低級(jí)別征象標(biāo)簽(1、2和3)、高級(jí)別征象標(biāo)簽(4、5、6、7、8和9)、浸潤(rùn)癌征象標(biāo)簽(10、11、12、13、14、15和16)、無(wú)法分類標(biāo)簽(17)以及無(wú)效噪聲標(biāo)簽(0、18和19)。無(wú)效標(biāo)簽噪聲數(shù)據(jù)標(biāo)簽包括質(zhì)量較差圖像以及外陰、陰道圖像。碘染圖像由于對(duì)上皮和血管的分辨率較差,則歸為無(wú)法分類標(biāo)簽。最終,基于28 975張陰道鏡圖像,共獲得標(biāo)簽57 618個(gè)。剔除無(wú)法分類及無(wú)效噪聲標(biāo)簽后,共得到三分類有效標(biāo)注圖像19 607張,包 括LSIL圖 像11 984張、HSIL圖 像6 871張和癌變圖像752張;共獲取有效標(biāo)簽39 858個(gè),包括低級(jí)別征象標(biāo)簽24 262個(gè)、高級(jí)別征象標(biāo)簽13 199個(gè)以及癌變征象標(biāo)簽2 397個(gè)。

建模任務(wù)從臨床需求看,宮頸HSIL是目前臨床治療的分界點(diǎn),國(guó)內(nèi)外均以HSIL識(shí)別準(zhǔn)確率作為陰道鏡檢查的質(zhì)控標(biāo)準(zhǔn)[4]。從病變區(qū)域特征看,LSIL病變區(qū)域特征不明顯,識(shí)別難度較大;癌變區(qū)域特征明顯,但數(shù)據(jù)量偏少;而HSIL病變區(qū)域的上皮與血管特征較LSIL顯著,且樣本量介于LSIL和癌變之間。因此,本研究將HSIL陰道鏡圖像的病變區(qū)域檢測(cè)作為主要建模任務(wù)。在上述研究的基礎(chǔ)上,進(jìn)一步對(duì)LSIL、HSIL、癌三類別病變區(qū)域檢測(cè)和類型識(shí)別進(jìn)行了研究。

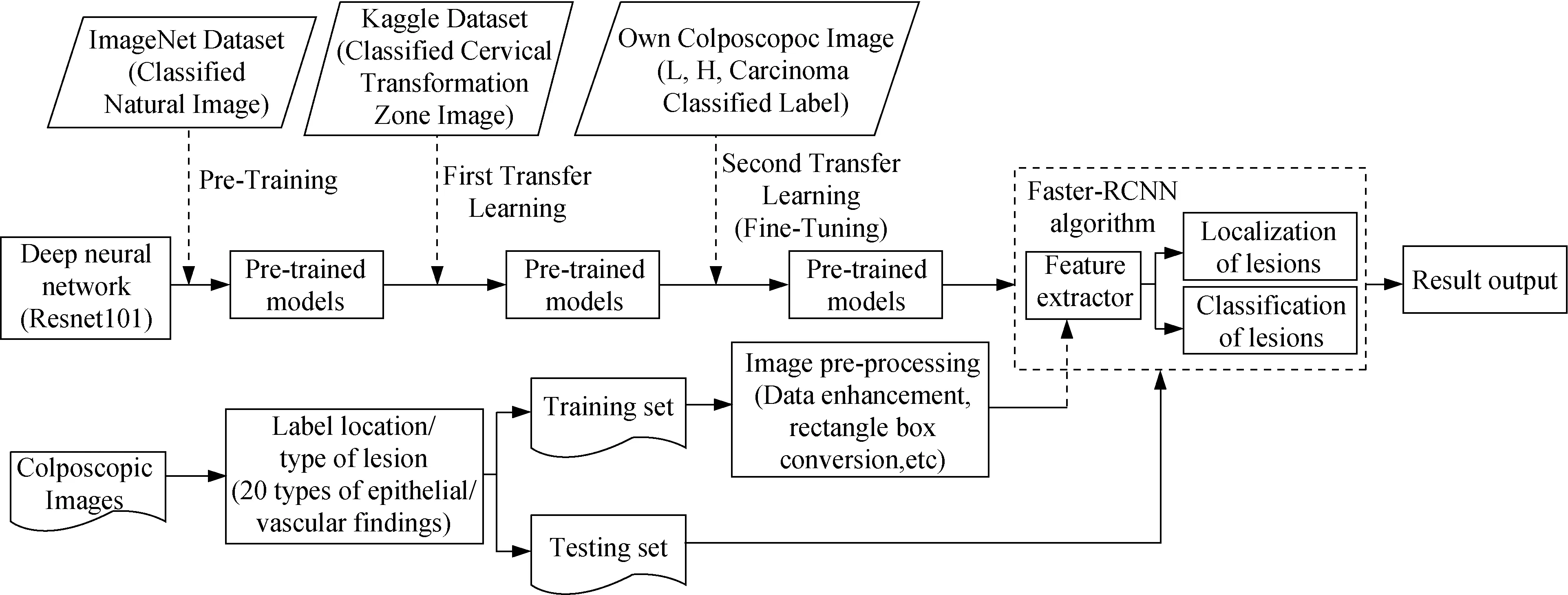

實(shí)驗(yàn)方法本實(shí)驗(yàn)的建模任務(wù)可定義為計(jì)算機(jī)視覺(computer vision,CV)領(lǐng)域的目標(biāo)識(shí)別和檢測(cè)。自2014年以來(lái),基于深度學(xué)習(xí)的目標(biāo)檢測(cè)框架分為two-stage和one-stage兩大類,前者以經(jīng)典方法Faster R-CNN[22]為代表,后者以YOLO[23]和SSD[24]為主要框架。由于Faster R-CNN具有更好的檢測(cè)精度和魯棒性,本文選擇Faster-RCNN網(wǎng)絡(luò)結(jié)構(gòu)來(lái)檢測(cè)宮頸病變區(qū)域。同時(shí),用RestNet101[25]網(wǎng)絡(luò)結(jié)構(gòu)作為提取目標(biāo)特征的主干網(wǎng)絡(luò)(backbone)。具體實(shí)驗(yàn)方法如圖2所示。

圖2 深度學(xué)習(xí)模型構(gòu)建技術(shù)路線圖Fig 2 The technical routes of deep learning models construction

圖像預(yù)處理通過剪切、模糊處理、旋轉(zhuǎn)、翻轉(zhuǎn)、亮度調(diào)節(jié)、縮小、放大、不規(guī)則變形、對(duì)比度調(diào)節(jié)等操作,進(jìn)行數(shù)據(jù)增強(qiáng),使實(shí)驗(yàn)數(shù)據(jù)多元化,模擬真實(shí)數(shù)據(jù),并解決不同標(biāo)簽類別之間的樣本數(shù)量不均衡問題。保留真實(shí)的病灶標(biāo)注,并將標(biāo)注區(qū)域轉(zhuǎn)化為矩形框,以適應(yīng)目標(biāo)檢測(cè)任務(wù)。將數(shù)據(jù)按照8∶2分為訓(xùn)練集和測(cè)試集。

基于遷移學(xué)習(xí)的特征提取器第一次遷移:基于開源自然圖像ImageNet數(shù)據(jù)集(http://www.image-net.org)訓(xùn)練的Resnet101模型,利用開源宮頸陰道鏡圖像宮頸轉(zhuǎn)化區(qū)分類數(shù)據(jù)(https://www.kaggle.com/c/intel-mobileodt-cervical-cancer-screening/data)訓(xùn)練,進(jìn)行第一次遷移學(xué)習(xí)。第二次遷移:基于上述模型,從自有陰道鏡圖像數(shù)據(jù)中挑選出單一分類(LSIL、HSIL或癌)標(biāo)簽圖像,以病變類型(LSIL、HSIL、癌)識(shí)別為目標(biāo)繼續(xù)對(duì)網(wǎng)絡(luò)最后幾層進(jìn)行微調(diào)(fine-tuning),為第二次遷移學(xué)習(xí)。

高級(jí)別病變區(qū)域檢測(cè)將上述預(yù)訓(xùn)練的

Resnet101作為特征提取器作為Faster-RCNN的主干網(wǎng)絡(luò),用于病變區(qū)域特征提取。以開源Faster-RCNN代碼進(jìn)行實(shí)驗(yàn),參數(shù)采用源代碼的默認(rèn)參數(shù)。以嫁接方式進(jìn)行精調(diào),替換上面數(shù)層卷積層,目標(biāo)輸出為病變區(qū)域及類型(參數(shù):BATCH=4,EPOCH=50,RESNET101主干網(wǎng)參數(shù)訓(xùn)練)。用隨機(jī)數(shù)生成方式,從含有有效標(biāo)簽的HSIL圖像數(shù)據(jù)中任意抽取數(shù)據(jù),進(jìn)行算法訓(xùn)練。用訓(xùn)練得到的參數(shù)對(duì)未標(biāo)注的測(cè)試集陰道鏡圖像預(yù)測(cè)病變區(qū)域,獲得算法預(yù)測(cè)結(jié)果圖,與醫(yī)生標(biāo)注的病變區(qū)域進(jìn)行比對(duì),計(jì)算出真陽(yáng)性樣本量(true positive,TP)、假陽(yáng)性樣本量(false positive,F(xiàn)P)、假陰性樣本量(false negative,F(xiàn)N)、召回率(recall,R)、精確度(precision,P)、交并比(intersection over union,IOU)、平均識(shí)別精度均值(mean average precision,mAP)及受試者操作特征曲線(receiver operator characteristic curve,ROC curve)。

三分類區(qū)域檢測(cè)與病變類型識(shí)別用隨機(jī)數(shù)生成方式,從含有有效標(biāo)簽的不同病變圖片中任意抽取數(shù)據(jù),進(jìn)行算法訓(xùn)練。用訓(xùn)練集得到的參數(shù)對(duì)測(cè)試集圖片進(jìn)行預(yù)測(cè)病變區(qū)域及病變類型,同上述方法獲得mAP@IOU=0.5值。

結(jié) 果

本實(shí)驗(yàn)采用的硬件平臺(tái)為HPE DL380 gen10服務(wù)器。其中,配置2個(gè)xeon gold 6148(2.4G 20Core)CPU,2個(gè)Nvidia v100 32G GPU顯 卡,512GB內(nèi)存。軟件環(huán)境為Ubuntu16.04操作系統(tǒng),CUDA9.0,cuDNN7.5 for CUDA9.0,Python3.7,深度學(xué)習(xí)框架PyTorch 1.0版本的Faster-RCNN(https://github.com/jwyang/faster-rcnn.pytorch.git)。

遷移學(xué)習(xí)結(jié)果第一次遷移學(xué)習(xí):1 997張訓(xùn)練;371張測(cè)試,測(cè)試集上的分類準(zhǔn)確率(分類正確圖片數(shù)/總圖片數(shù))為75%(表1)。

表1 基于ImageNet宮頸轉(zhuǎn)化區(qū)分類的第一次遷移學(xué)習(xí)數(shù)據(jù)分布Tab 1 Data distribution of the first transfer learning based on ImageNet cervical transformation zone classification(images)

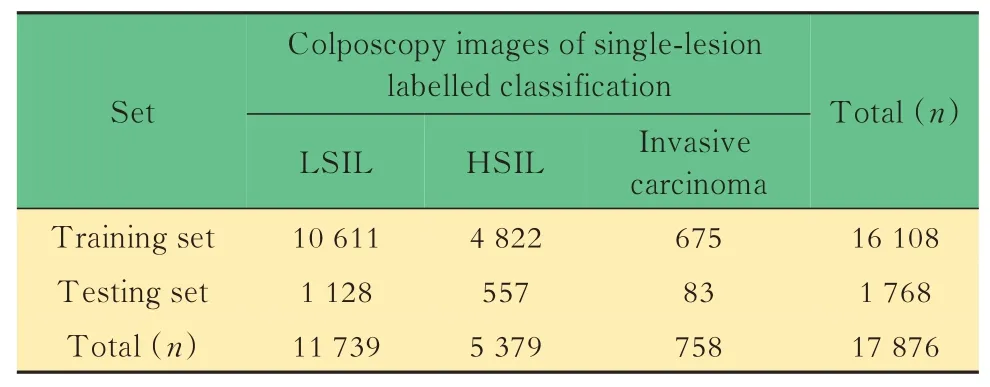

第二次遷移:從自有陰道鏡圖像訓(xùn)練集中篩選出單分類標(biāo)簽圖像,即圖片僅包含低級(jí)別、高級(jí)別或癌變?nèi)N標(biāo)簽中的單一類標(biāo)簽圖像,共計(jì)17 876張高級(jí)別圖像。其中,隨機(jī)選擇16 108張圖片作為訓(xùn)練集,1 768張圖片作為測(cè)試集,各類別標(biāo)簽數(shù)據(jù)分布如表2所示。測(cè)試集上的模型區(qū)分LSIL、HSIL、癌變的準(zhǔn)確率(分類正確圖片數(shù)/總圖片數(shù))為70%。

表2 基于自有單分類標(biāo)簽陰道鏡圖像的第二次遷移學(xué)習(xí)數(shù)據(jù)分布Tab 2 Data distribution of the second transfer learning based on colposcopy images of single-lesion labelled classification(images)

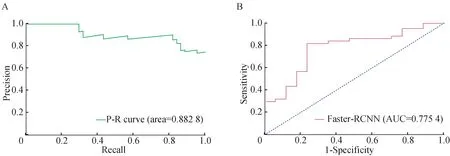

高級(jí)別病變區(qū)域檢測(cè)結(jié)果從只包含單一HSIL標(biāo)簽的陰道鏡圖像中隨機(jī)抽取出1 790張圖片作為訓(xùn)練集;61張圖片為測(cè)試集。將測(cè)試集圖片的檢測(cè)結(jié)果與醫(yī)生標(biāo)注區(qū)域進(jìn)行比對(duì),獲得真陽(yáng)性樣本量TP為44;假陽(yáng)性樣本量FP為17、假陰性樣本量FN為5。計(jì)算得到召回率(R)為89.8%,精確率(P)為72.1%,并根據(jù)高級(jí)別病變區(qū)域檢測(cè)的結(jié)果繪制R-P圖例和ROC曲線(圖3A、B)。當(dāng)交并比IOU為0.5時(shí),精度 均 值A(chǔ)P@IOU=0.5為0.82。預(yù)測(cè)模型最終輸出結(jié)果示例見圖4。

圖3 深度學(xué)習(xí)模型對(duì)61張高級(jí)別病變測(cè)試圖像識(shí)別的P-R圖例(A)和ROC曲線(B)Fig 3 P-R image recognition(A)and ROC curve(B)of 61 images for high-grade lesion recognized by deep learning model

圖4 IOU為0.5時(shí)模型在測(cè)試集上輸出結(jié)果(A)與醫(yī)師標(biāo)注區(qū)域(B)比對(duì)示例Fig 4 Example of comparison between model’s result(A)and doctor’s result(B)on the test data when IOU is 0.5

三分類區(qū)域檢測(cè)與病變類型識(shí)別結(jié)果用隨機(jī)數(shù)生成方式,任意抽取5 000張圖片作為訓(xùn)練集,其中HSIL圖片1 752張,LSIL圖片3 056張,癌圖片192張,另抽取200張圖片作為測(cè)試集。將訓(xùn)練模型對(duì)測(cè)試集圖片預(yù)測(cè)病變區(qū)域與醫(yī)生標(biāo)注區(qū)域進(jìn)行比對(duì),每個(gè)類別的平均識(shí)別精度均值mAP@IOU=0.5為0.67。

討 論

本研究借助國(guó)際陰道鏡標(biāo)準(zhǔn)化術(shù)語(yǔ)中多種宮頸上皮及血管征象特征對(duì)圖像進(jìn)行像素級(jí)語(yǔ)義標(biāo)注,采用二次遷移學(xué)習(xí)的ResNet101預(yù)訓(xùn)練網(wǎng)絡(luò)為特征提取器構(gòu)建Faster-RCNN目標(biāo)檢測(cè)模型,分別實(shí)現(xiàn)了對(duì)宮頸陰道鏡圖像HSIL單一目標(biāo)和LSIL、HSIL和癌變?nèi)惸繕?biāo)的病變區(qū)域定位及識(shí)別。證實(shí)了基于專業(yè)醫(yī)學(xué)背景和大樣本數(shù)據(jù),深度學(xué)習(xí)技術(shù)不僅可輔助陰道鏡診斷分類,且在病灶定位上亦可取得較好效果。

自20世紀(jì)60年代陰道鏡在全球廣泛應(yīng)用至今,影響其準(zhǔn)確性和可重復(fù)性的主要原因之一是缺乏統(tǒng)一規(guī)范的圖像評(píng)價(jià)標(biāo)準(zhǔn)。盡管多種陰道鏡評(píng)分系統(tǒng)曾被運(yùn)用,如Reid法、改良Reid法以及Swede法等,但其診斷效能卻一直不理想。為此,IFCPC于2011年發(fā)布了最新陰道鏡術(shù)語(yǔ)系統(tǒng),對(duì)陰道鏡下上皮和血管的邊界、輪廓、形態(tài)等重要解剖部位或組織的圖像特征進(jìn)行了全面解析和科學(xué)化歸類。本小組前期曾對(duì)IFCPC陰道鏡術(shù)語(yǔ)體系進(jìn)行了前瞻性大樣本臨床比較研究以及多項(xiàng)回顧性隊(duì)列研究,證實(shí)了其較好的臨床診斷效能,為其實(shí)際運(yùn)用奠定了重要的循證基礎(chǔ)[7-8]。本研究借助該專業(yè)陰道鏡背景優(yōu)勢(shì),對(duì)陰道鏡下上皮及血管特征進(jìn)行統(tǒng)一認(rèn)知和解讀,基于20類宮頸上皮與血管征象對(duì)圖像進(jìn)行標(biāo)準(zhǔn)化精細(xì)標(biāo)注,歸并形成分類映射,獲得高質(zhì)量標(biāo)注數(shù)據(jù),輔助計(jì)算機(jī)識(shí)別最具影響的特征群,細(xì)化訓(xùn)練目標(biāo),從而構(gòu)建更為穩(wěn)定可靠的機(jī)器學(xué)習(xí)模型。本研究將不易掌握的復(fù)雜描述性分類術(shù)語(yǔ)轉(zhuǎn)化為實(shí)際且便捷的操作體系,彌補(bǔ)了既往研究中標(biāo)注特征量少、信息單一、實(shí)驗(yàn)數(shù)據(jù)量有限等短板。

盡管國(guó)內(nèi)外開展宮頸癌智能化檢測(cè)的研究已經(jīng)有十余年,但由于較平面圖像更為復(fù)雜、部位多變、需較強(qiáng)專業(yè)背景支撐的跨學(xué)科合作等原因,對(duì)于宮頸癌前病灶陰道鏡圖像的智能化判別,研究成果相對(duì)較少。2015年Song等[15]結(jié)合臨床診斷結(jié)果和5%醋酸試驗(yàn)后的陰道鏡圖像特征等多模態(tài)數(shù)據(jù),提出了基于數(shù)據(jù)驅(qū)動(dòng)病變特征的提取方法,并針對(duì)HSIL和LSIL二分類得到了74%的識(shí)別精度。之后有學(xué)者對(duì)上述特征提取或傳統(tǒng)機(jī)器學(xué)習(xí)方法進(jìn)行了改良,提高識(shí)別精度(80.87%和81.3%)[16-17]。也有學(xué)者嘗試探索深度學(xué)習(xí)技術(shù)運(yùn)用于宮頸病變視覺判別的可行性,Xu等[10]利用卷積神經(jīng)網(wǎng)絡(luò)對(duì)1 000張陰道鏡宮頸圖像進(jìn)行訓(xùn)練,結(jié)合宮頸細(xì)胞學(xué)和HPV檢測(cè)結(jié)果,最終模型識(shí)別LSIL+的準(zhǔn)確性為88.91%。也有學(xué)者分別基于485張宮頸陰道鏡圖像(142張HSIL、257張?jiān)话?6張浸潤(rùn)癌)和330名患者(97例LSIL、213例HSIL),采用深度學(xué)習(xí)算法構(gòu)建了三分類(HSIL、原位癌、浸潤(rùn)癌)和二分類(HSIL和LSIL)模型,分別獲得了平均50%的識(shí)別精度和82.3%的準(zhǔn)確度[12-14]。近期,Zhang等[11]基于1 709例患者陰道鏡宮頸圖像,利用預(yù)訓(xùn)練DenseNet卷積神經(jīng)網(wǎng)絡(luò)對(duì)ImageNet和Kaggle數(shù)據(jù)集的各層參數(shù)進(jìn)行微調(diào),二分類診斷CIN2+準(zhǔn)確率為73.08%(AUC≈0.75)。除陰道鏡圖像之外,亦有學(xué)者對(duì)宮頸的其他圖像進(jìn)行過類似研究。2019年通過對(duì)哥斯達(dá)黎加宮頸癌篩查人群長(zhǎng)達(dá)7年的隨訪,利用固定焦距攝像機(jī)進(jìn)行數(shù)字化宮頸攝圖,以深度學(xué)習(xí)技術(shù)輔助識(shí)別CIN2+病變[18]。陸晗[19]則提出了一種用醋酸實(shí)驗(yàn)前后的宮頸比值圖像代替原圖的方法,利用VGGNet-16模型對(duì)宮頸癌前病變進(jìn)行分類識(shí)別;但均并未取得比醋酸后陰道鏡圖像明顯優(yōu)越的識(shí)別精度。上述研究均在機(jī)器輔助宮頸病變識(shí)別的方法探索上取得了一定進(jìn)展。本研究以臨床意義為導(dǎo)向,基于國(guó)內(nèi)最大陰道鏡中心的大樣本數(shù)據(jù),通過跨學(xué)科合作,綜合對(duì)比了多種目標(biāo)檢測(cè)的深度學(xué)習(xí)網(wǎng)絡(luò)架構(gòu),并在數(shù)據(jù)預(yù)處理、數(shù)據(jù)增強(qiáng)、主干網(wǎng)絡(luò)選擇與訓(xùn)練、模型超參數(shù)優(yōu)化、算法改進(jìn)等幾個(gè)方面對(duì)模型進(jìn)行優(yōu)化,構(gòu)建了HSIL單分類模型和三分類(LSIL、HSIL、癌)Faster-RCNN模型,對(duì)HSIL及以上病變的識(shí)別獲得了89.8%的召回率(即敏感度)和72.1%的精確度,該模型的診斷效能與本研究中心既往資料中,經(jīng)IFCPC術(shù)語(yǔ)培訓(xùn)的5~10年工作經(jīng)驗(yàn)的陰道鏡專科醫(yī)師水平相當(dāng)(敏感度約65%~90%)[7-8]。本研究通過選擇和輸出針對(duì)臨床實(shí)際數(shù)據(jù)和應(yīng)用場(chǎng)景的最優(yōu)模型,獲得穩(wěn)定的分類預(yù)測(cè)效果,更加貼合國(guó)內(nèi)臨床篩查需求。

本研究的另一特點(diǎn)在于對(duì)陰道鏡下病變的定位識(shí)別。既往報(bào)道的研究目標(biāo)多為圖像級(jí)的病變分類,在病變區(qū)域的定位識(shí)別方面相關(guān)報(bào)道極少。曾有個(gè)別學(xué)者嘗試CAM熱力圖等對(duì)宮頸病灶區(qū)進(jìn)行定位識(shí)別,但效果十分有限,僅能對(duì)白色腫脹且伴粗點(diǎn)狀血管的區(qū)域作出HSIL判別[20]。然而,定位指導(dǎo)活檢或指導(dǎo)治療是陰道鏡的主要功能之一,有著無(wú)法取代的臨床需求。本研究基于對(duì)28 975幅不同程度宮頸病變陰道鏡圖像的精準(zhǔn)定位標(biāo)注,結(jié)合深度學(xué)習(xí)中的目標(biāo)檢測(cè)技術(shù),分別實(shí)現(xiàn)了對(duì)宮頸陰道鏡圖像HSIL單一目標(biāo)和LSIL、HSIL和癌變?nèi)惸繕?biāo)的病變區(qū)域定位識(shí)別,當(dāng)目標(biāo)檢測(cè)交并比IOU≥0.5的情況下,兩種模型mAP分別達(dá)到0.82和0.67。結(jié)果證實(shí)了模型用于輔助陰道鏡指導(dǎo)病變區(qū)域定位的可行性,不僅適用于臨床篩查,亦可指導(dǎo)活檢及后續(xù)定位治療。

本研究模型在陰道鏡圖像的分類和病變定位上均取得了較好成績(jī)。盡管在識(shí)別精度上仍有進(jìn)一步提升的空間,但已顯示出其實(shí)際臨床應(yīng)用潛能。本研究不足之處是針對(duì)三分類區(qū)域檢測(cè)只進(jìn)行了初步的探索,在數(shù)據(jù)預(yù)處理、數(shù)據(jù)增強(qiáng)、模型調(diào)參、遷移學(xué)策略等方面還有較大發(fā)揮空間。此外,研究推廣仍然面臨瓶頸和挑戰(zhàn),如不同醫(yī)療機(jī)構(gòu)的陰道鏡設(shè)備非標(biāo)準(zhǔn)化、計(jì)算機(jī)硬件及網(wǎng)絡(luò)支撐不足等,都將影響未來(lái)智能陰道鏡的實(shí)際臨床應(yīng)用。

作者貢獻(xiàn)聲明李燕云數(shù)據(jù)采集,論文構(gòu)思、撰寫和修訂。王永明,王振,蔡青青數(shù)據(jù)統(tǒng)計(jì)。周奇,王玨,孟妍數(shù)據(jù)采集。李亦學(xué),隋龍論文構(gòu)思和指導(dǎo)。華克勤論文綜合指導(dǎo)。

利益沖突聲明所有作者均聲明不存在利益沖突。