基于注意力機制的視覺位置識別方法

戴天虹 楊曉云 宋潔綺

摘要:針對現有的視覺位置識別方法在圖像外觀變化和視角變化時準確性和魯棒性表現不佳的問題,提出了一個與注意力機制結合的視覺位置識別方法。首先,采用在大型位置數據集上預訓練的卷積神經網絡HybridNet提取特征。然后,運用上下文注意力機制對圖像不同區域分配權重值,構建基于多層卷積特征的注意力掩碼。最后,將掩碼與卷積特征結合,構建融合注意力機制的圖像特征描述符,從而提高特征的魯棒性。在兩個典型位置識別數據集上做測試實驗,結果表明結合注意力機制的方法可以有效區分圖像中與位置識別有關的區域和無關的區域,提高在外觀變化和視角變化場景中識別的準確性和魯棒性。

關鍵詞:圖像處理;位置識別;注意力機制;卷積神經網絡;深度學習

DOI:10.15938/j.jhust.2022.02.008

中圖分類號: TP391.41

文獻標志碼: A

文章編號: 1007-2683(2022)02-0063-06

Visual Place Recognition Method Based on Attention Mechanism

DAI Tian-hong,YANG Xiao-yun,SONG Jie-qi

(School of Mechanical and Electrical Engineering, Northeast Forestry University, Harbin Heilongjiang 150040, China)

Abstract:Aiming at the problem of poor accuracy and robustness of the existing visual place recognition methods when the image appearance changes and the viewing angle changes, a visual place recognition method combined with the attention mechanism is proposed. Firstly, we use the convolutional neural network HybridNet pre-trained on a large location dataset to extract features. Then, we use the context attention mechanism to assign weight values to different regions of the image to construct an attention mask based on multi-layer convolution features. Finally, we combine the mask with the convolution feature to construct the image feature descriptor fused with the attention mechanism so as to improve the robustness of the feature. Testing experiments on two typical place recognition datasets show that the method combined with the attention mechanism can effectively distinguish between the regions related to place recognition and the unrelated regions in the image, and it can improve the accuracy and robustness of recognition in scenes with changes in appearance and viewpoints.

Keywords:image processing; place recognition; attention mechanism; convolutional neural network; deep learning

0引言

視覺位置識別技術(visual place recognition,VPR)主要是指采用圖像識別技術,判斷當前圖像是否是之前曾訪問過的場景[1],目前廣泛應用于機器人同步定位與構圖(simultaneous localization and mapping, SLAM)的閉環檢測和重定位環節中,可以消除機器人系統運動過程中的累計誤差。

視覺位置識別算法主要包括對當前圖像和曾經訪問過的圖像提取特征,對提取到的特征進行編碼,計算當前圖像和曾經訪問過的圖像之間的相似度,確定是否匹配等步驟。早期的視覺位置識別技術都是對圖片提取手工特征描述符實現,比如局部特征SURF(speeded up robust features)[2]、SIFT(scale-invariant feature transform)[3]、ORB(oriented FAST and rotated BRIEF)[4],全局特征Gist[5]等,但是手工設計的特征在長時間的大型場景識別中無法做出較好的性能表現。近年來,由于深度學習技術在計算機視覺等領域得到了廣泛的應用和發展[6-11],越來越多的研究人員開始通過卷積神經網絡(convolutional neural network, CNN)提取特征來實現視覺位置識別。

文[12]采用在場景數據集上預訓練的CNN模型進行位置識別,實驗證明在光照發生變化的場景下CNN提取的特征顯著優于傳統人工設計的特征。文[13]利用CNN在外觀變化和視角變化的數據集分析不同層提取的特征在位置識別中的性能表現,實驗證明中間層和高層特征的性能表現較好。文[14]和文[15]針對位置識別任務分別設計訓練了專用的CNN。但是,直接利用CNN提取的全局特征在視角變化的數據集上性能表現不佳,因為與位置識別技術相關的視覺線索通常不會均勻地分布在整幅圖像中,圖像中與位置識別無關的線索會影響識別的準確性,比如圖像中的一些動態物體,如汽車、行人等。因此,文[16]、文[17]和文[18]提出識別圖像中的顯著區域,證明直接關注圖像中的區域特征可以有效提高視角變化時的識別魯棒性,但是這些方法都是通過生成局部區域探測器來檢測圖像中的地標性特征,容易忽略圖像中的隱藏信息。

注意力來源于認知科學,指人類視覺在學習圖像時,能快速判斷并集中于與任務有關的重點目標區域,而忽略無關區域的過程。與深度學習結合的注意力機制一般指學習訓練一個新的網絡,通過學習圖像中哪些區域對識別任務貢獻大,哪些區域與識別任務無關,對圖像中不同區域建立響應機制,從而達到有效識別的目的。

另外,通過CNN對圖像提取特征,低層次的卷積特征圖側重于圖像邊緣、輪廓等信息,而高層次的卷積特征圖含有較豐富語義信息。如果僅針對某個卷積層學習訓練注意力,則可能造成圖像信息丟失或不全。

綜上所述,本文提出利用一個多尺度卷積濾波器建立上下文注意力機制,通過提取圖像中隱藏信息,生成預測圖像各區域響應的注意力掩碼,并且針對不同卷積層提取特征的差異性,融合從多層卷積特征學習到的注意力掩碼,最后將掩碼直接與卷積特征加權,相比其他采用卷積神經網絡的方法,可以生成更具魯棒性的特征表示。

1基于注意力機制的視覺位置識別方法

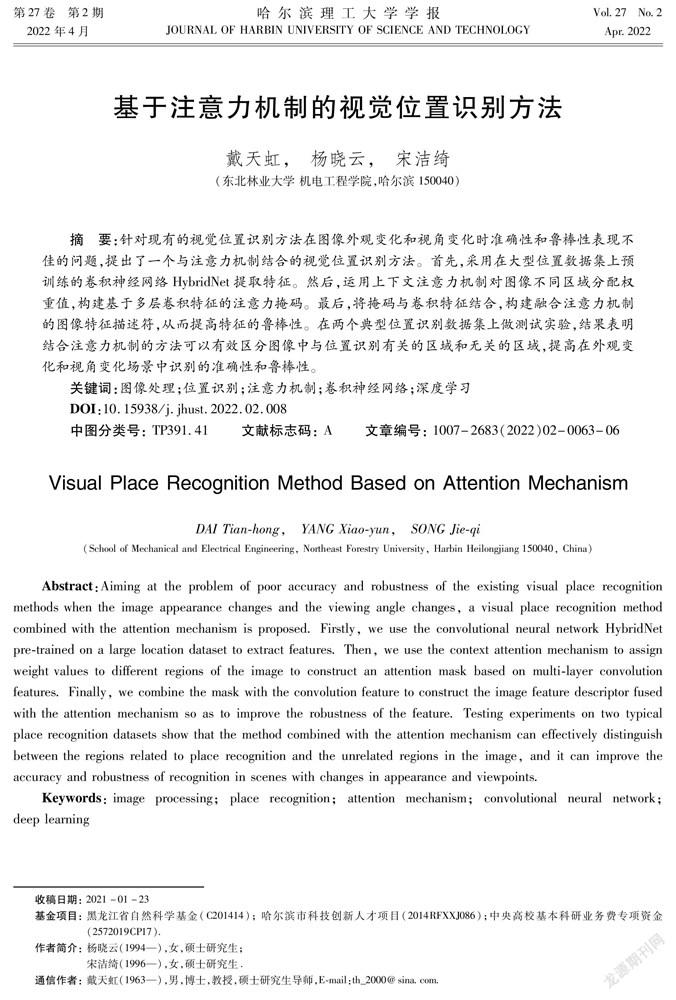

融合注意力機制的視覺位置識別方法流程如圖1所示。首先使用HybridNet[15]提取圖像卷積特征,經注意力機制處理生成圖像最終表示,最后采用余弦距離判斷查詢圖像和參考圖像之間是否發生匹配。

1.1卷積神經網絡

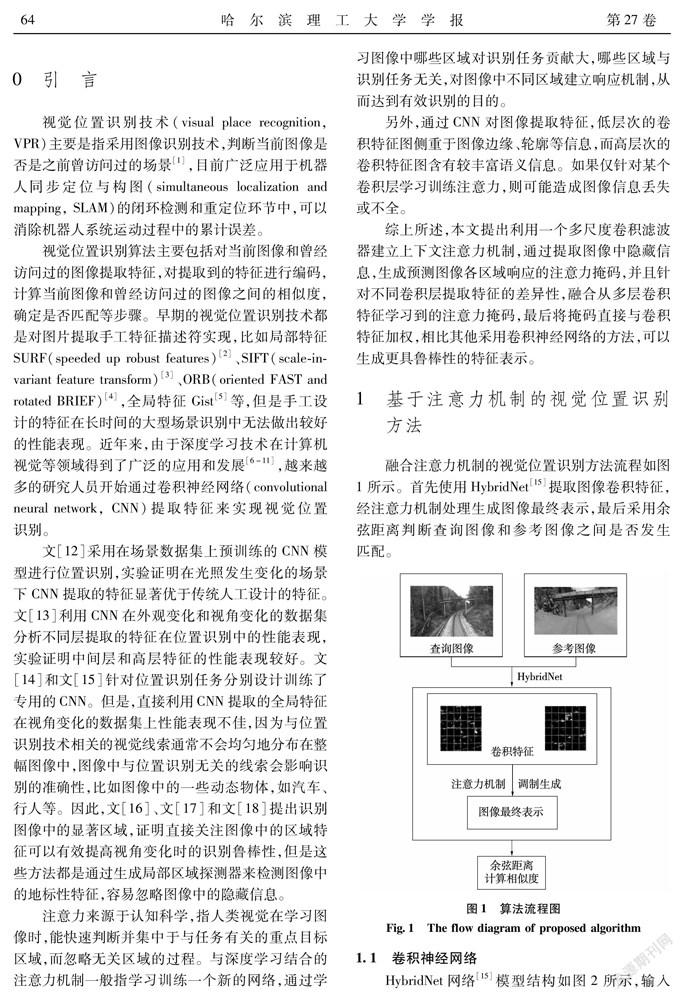

HybridNet網絡[15]模型結構如圖2所示,輸入圖像大小為227×227×3,Conv、ReLu、Norm、Pool、FC分別代表卷積層、激活層、歸一化層、最大池化層和全連接層。第一個卷積層的卷積核大小為11×11,第二個卷積層的卷積核大小為5×5,第三個到第六個卷積層的卷積核大小均為3×3。該網絡的初始化是通過AlexNet網絡[19]參數實現,然后在大型位置識別數據集SPED上訓練。

SPED數據集收集來自世界各地2543臺相機采集的總共大約250萬張圖片,分別在2014年2月和2014年8月2個不同的季節每隔半小時拍攝。相比其他用于場景訓練的數據集,涵蓋了更多的戶外場景,比如城市建筑物、郊外森林等,并且每個位置的外觀條件變化非常明顯,同一個位置的數據由一年中不同的季節和一天中不同的時間點采集。

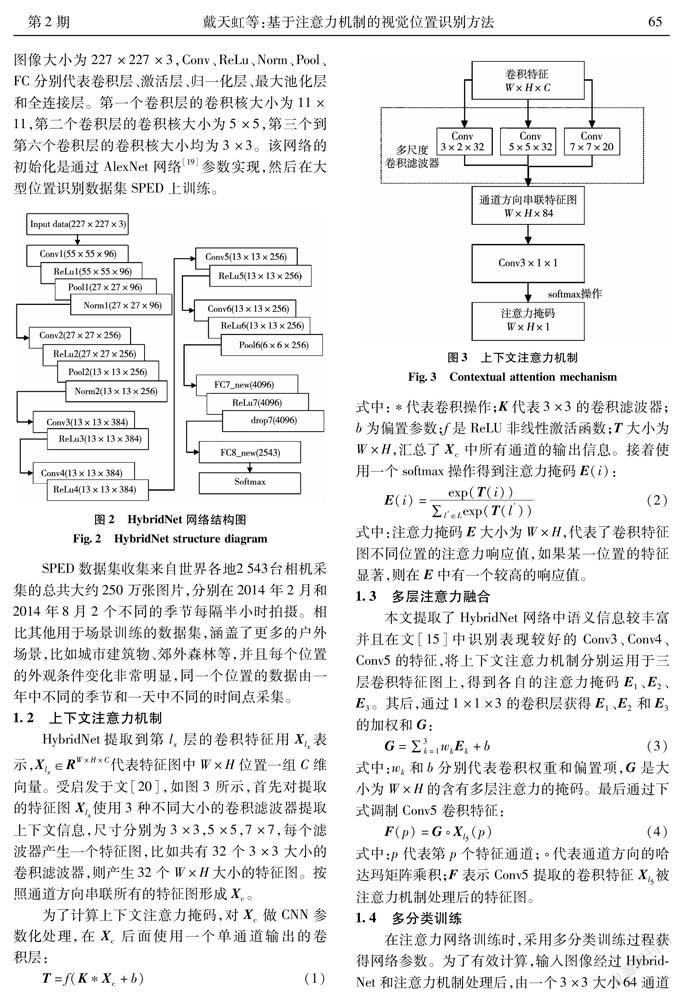

1.2上下文注意力機制

HybridNet提取到第l層的卷積特征用X表示,X∈R代表特征圖中W×H位置一組C維向量。受啟發于文[20],如圖3所示,首先對提取的特征圖Xlx使用3種不同大小的卷積濾波器提取上下文信息,尺寸分別為3×3,5×5,7×7,每個濾波器產生一個特征圖,比如共有32個3×3大小的卷積濾波器,則產生32個W×H大小的特征圖。按照通道方向串聯所有的特征圖形成X。

為了計算上下文注意力掩碼,對X做CNN參數化處理,在X后面使用一個單通道輸出的卷積層:

1.3多層注意力融合

1.4多分類訓練

1.5相似度計算

2實驗結果分析

在兩個公開的位置識別數據集上進行測試實驗。Synthesized Nordland數據集[22]包含攝像機在4個不同季節捕捉到的同一火車行駛軌跡的沿途風景圖像,本文選取了夏季和冬季,含有明顯的季節條件變化。Gardens Point數據集[13]在昆士蘭大學校園內采集,包含2個白天的子數據集分別在人行道的左邊和右邊拍攝,還有1個晚上的數據集在人行道的右邊采集,本文采用了白天左邊拍攝和晚上右邊拍攝2個子集,圖像存在明顯的視角和光照條件變化。

首先采用精確率-召回率曲線以及曲線與坐標軸圍成的面積AUC(area under the curve)評價算法性能,AUC越接近于1,則算法性能越好。精確率(precision, P)和召回率(recall, R)計算公式如下:

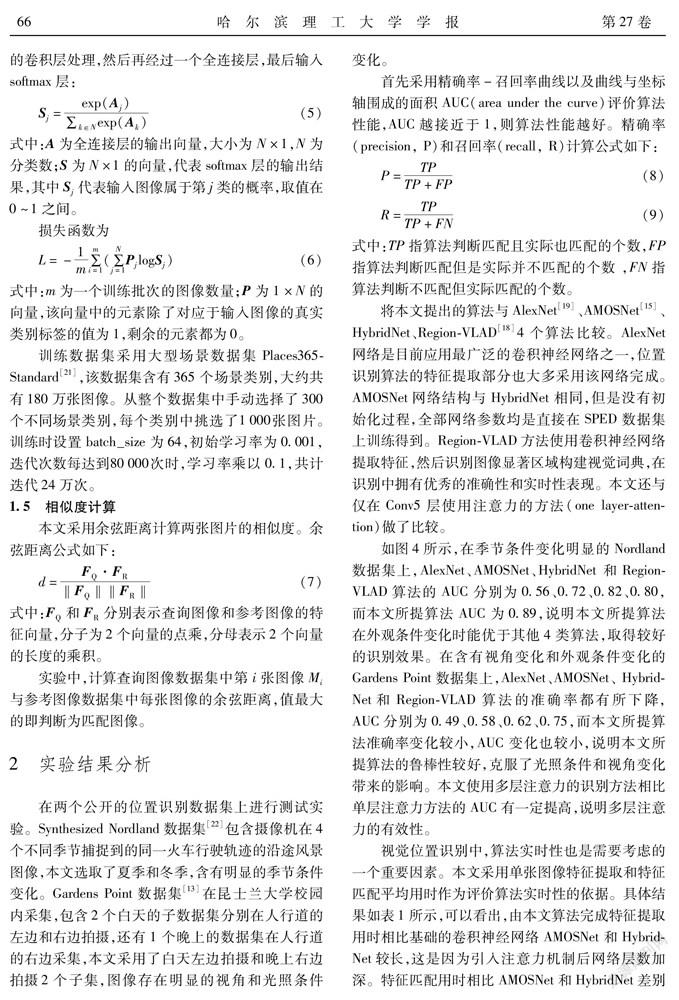

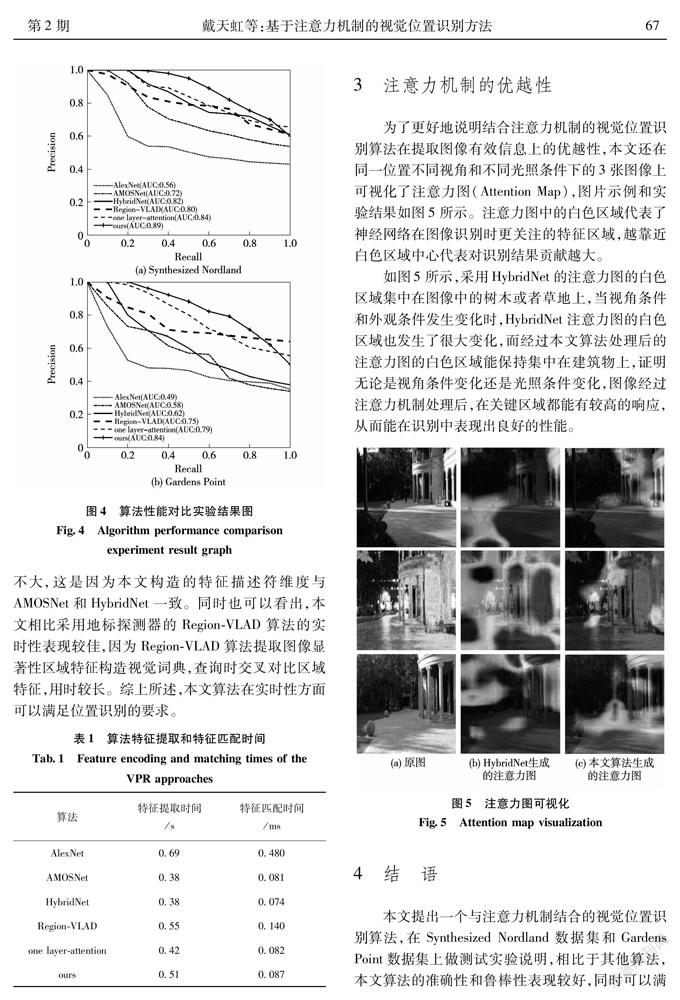

將本文提出的算法與AlexNet[19]、AMOSNet[15]、HybridNet、Region-VLAD[18]4個算法比較。AlexNet網絡是目前應用最廣泛的卷積神經網絡之一,位置識別算法的特征提取部分也大多采用該網絡完成。AMOSNet網絡結構與HybridNet相同,但是沒有初始化過程,全部網絡參數均是直接在SPED數據集上訓練得到。Region-VLAD方法使用卷積神經網絡提取特征,然后識別圖像顯著區域構建視覺詞典,在識別中擁有優秀的準確性和實時性表現。本文還與僅在Conv5層使用注意力的方法(one layer-attention)做了比較。

如圖4所示,在季節條件變化明顯的Nordland數據集上,AlexNet、AMOSNet、HybridNet 和Region-VLAD算法的AUC分別為0.56、0.72、0.82、0.80,而本文所提算法AUC為0.89,說明本文所提算法在外觀條件變化時能優于其他4類算法,取得較好的識別效果。在含有視角變化和外觀條件變化的Gardens Point數據集上,AlexNet、AMOSNet、 HybridNet和Region-VLAD算法的準確率都有所下降,AUC分別為0.49、0.58、0.62、0.75,而本文所提算法準確率變化較小,AUC變化也較小,說明本文所提算法的魯棒性較好,克服了光照條件和視角變化帶來的影響。本文使用多層注意力的識別方法相比單層注意力方法的AUC有一定提高,說明多層注意力的有效性。

視覺位置識別中,算法實時性也是需要考慮的一個重要因素。本文采用單張圖像特征提取和特征匹配平均用時作為評價算法實時性的依據。具體結果如表1所示,可以看出,由本文算法完成特征提取用時相比基礎的卷積神經網絡AMOSNet和HybridNet較長,這是因為引入注意力機制后網絡層數加深。特征匹配用時相比AMOSNet和HybridNet差別不大,這是因為本文構造的特征描述符維度與AMOSNet和HybridNet一致。同時也可以看出,本文相比采用地標探測器的Region-VLAD算法的實時性表現較佳,因為Region-VLAD算法提取圖像顯著性區域特征構造視覺詞典,查詢時交叉對比區域特征,用時較長。綜上所述,本文算法在實時性方面可以滿足位置識別的要求。

3注意力機制的優越性

為了更好地說明結合注意力機制的視覺位置識別算法在提取圖像有效信息上的優越性,本文還在同一位置不同視角和不同光照條件下的3張圖像上可視化了注意力圖(Attention Map),圖片示例和實驗結果如圖5所示。注意力圖中的白色區域代表了神經網絡在圖像識別時更關注的特征區域,越靠近白色區域中心代表對識別結果貢獻越大。

如圖5所示,采用HybridNet的注意力圖的白色區域集中在圖像中的樹木或者草地上,當視角條件和外觀條件發生變化時,HybridNet注意力圖的白色區域也發生了很大變化,而經過本文算法處理后的注意力圖的白色區域能保持集中在建筑物上,證明無論是視角條件變化還是光照條件變化,圖像經過注意力機制處理后,在關鍵區域都能有較高的響應,從而能在識別中表現出良好的性能。

4結語

本文提出一個與注意力機制結合的視覺位置識別算法,在Synthesized Nordland數據集和Gardens Point數據集上做測試實驗說明,相比于其他算法,本文算法的準確性和魯棒性表現較好,同時可以滿足實時性要求。通過Attention Map可視化,融合注意力機制的位置識別方法能對圖片中的有用區域產生較高的響應,并且當存在外觀條件和視角條件變化時,高響應區域幾乎沒有發生改變,從而能保證識別的魯棒性。

參 考 文 獻:

[1]LOWRY S, SUNDERHAUF N, NEWMAN P, et al. Visual Place Recognition: A Survey[J]. Robotics, IEEE Transactions on, 2016, 32(1): 1.

[2]BAY H, TUYTELAARS T, GOOL L V. SURF: Speeded up robust features[J]. Computer Vision-ECCV, 2006, 3951: 404.

[3]LOWE D. Distinctive Image Features from Scale-Invariant Keypoints[J]. International Journal of Computer Vision, 2004, 20: 91.

[4]RUBLEE E, RABAUD V, KONOLIGE K, et al.? ORB: An efficient alternative to SIFT or SURF[C]//Computer Vision. IEEE, 2011: 2564.

[5]OLIVA A. Building the Gist of a Scene: the Role of Global Image Features in Recognition[J]. Progress in Brain Research, 2006, 155(2): 23.

[6]BENGIO Y, COURVILLE A, VINCENT P. Representation Learning: A Review and New Perspectives[J]. IEEE Transactions on Pattern Analysis&Machine Intelligence, 2012, 35(8): 1798.

[7]RAZAVIAN A S, SULLIVAN J, CARLSSON S, et al. Visual Instance Retrieval with Deep Convolutional Networks[J]. Ite Transactions on Media Technology & Applications, 2014, 4.

[8]BABENKO A, SLESAREV A, CHIGORIN A, et al. Neural Codes for Image Retrieval[C]//European Conference on Computer Vision. Springer International Publishing, 2014: 584.

[9]WAN J, WANG D, HOI S C H, et al. Deep Learning for Content-Based Image Retrieval: A Comprehensive Study[C]//Acm International Conference on Multimedia. ACM, 2014: 157.

[10]丁博, 伊明. 基于卷積神經網絡的三維CAD模型分類[J].哈爾濱理工大學學報,2020,25(1):66.

DING Bo, YI Ming. 3D CAD model classification based on Convolutional Neural Network[J]. Journal of Harbin University of Science and Technology, 2020, 25(1): 66.

[11]于舒春,佟小雨.基于CNN特征提取的粒子濾波視頻跟蹤算法研究[J].哈爾濱理工大學學報,2020,25(4):78.

YU Shuchun, TONG Xiaoyu. Research on Particle Filter Video Tracking Algorithms Based on CNN Feature Extraction[J]. Journal of Harbin University of Science and Technology, 2020, 25(1):66.

[12]HOU Y, ZHANG H, ZHOU S. Convolutional Neural Networkbased Image Representation for Visual Loop Closure Detection[C]//IEEE International Conference on Information & Automation, 2015: 2238.

[13]SUNDERHAUF N, DAYOUB F, SHIRAZI S, et al. On the Performance of ConvNet Features for Place Recognition[C]//2015 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS).? IEEE, 2015: 4297.

[14]MERRILL N, HUANG G. Lightweight Unsupervised Deep Loop Closure[C]//Robotics: Science and Systems, 2018, 40(1): 223.

[15]CHEN Z, JACOBSON A, SUNDERHAUF N, et al. Deep Learning Features at Scale for Visual Place Recognition[C]//IEEE International Conference on? Robotics and Automation (ICRA), 2017: 3223.

[16]SUNDERHAUF N, SHIRAZI S, JACOBSON A, et al. Place Recognition with ConvNet Landmarks:? Viewpointrobust, Condition-robust, Training-free[C]//Robotics: Science and Systems, 2015.

[17]CHEN Z, MAFFRA F, SA I, et al. Only Look once, Mining Distinctive Landmarks from ConvNet for Visual Place Recognition[C]//IEEE/RSJ International Conference on Intelligent Robots & Systems. IEEE, 2017: 9.

[18]KHALIQ A, EHSAN S, CHEN Z, et al. A Holistic Visual Place Recognition Approach Using Lightweight CNNs for Significant ViewPoint and Appearance Changes[J]. IEEE Transactions on Robotics, 2019, PP(99): 1.

[19]KRIAHEVSKY A, SUTSKEVER I, HINTON G. ImageNet Classification with Deep Convolutional Neural Networks[C]//NIPS. Curran Associates Inc, 2012: 1097.

[20]WANG T T, ZHANG L H, WANG S, et al. Detect Globally, Refine Locally: A Novel Approach to Saliency Detection[C]//Conference on Computer Vision and Pattern Recognition (CVPR), 2018: 3127.

[21]ZHOU B, LAPEDRIZA A, KHOSLA A, et al. Places: A 10 Million Image Database for Scene Recognition[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2018: 1.

[22]NEUBERT P, SUNDERHAUF N, PROTZEL P. Superpixel-based Appearance Change Prediction for Long-Term Navigation Across Seasons[J]. Robotics and Autonomous Systems, 2015, 69(1): 15.

(編輯:溫澤宇)