基于特征融合的改進型PointPillar 點云目標檢測

張 勇, 石志廣, 沈 奇, 張 焱, 張 宇

(國防科技大學 電子科學學院 ATR 重點實驗室,湖南 長沙 410073)

1 引 言

近年來,隨著深度學習的發展,點云處理技術取得了重大突破[1]。點云目標檢測是點云處理的基本任務之一[2],當前可以分為基于原始點云的檢測、基于體素的檢測、基于數據降維的檢測、基于點云和體素的混合檢測4 大類。基于原始點云的檢測通過在原始點上進行數據處理、分析,從而判斷目標類別并回歸目標邊界框。此類方法的優點是充分利用點云信息,提取的點特征能夠有效表征目標,檢測效果好,但內存占用高、計算量大[3-5]。基于體素的檢測將點云在三維空間中劃分為大小一致、規則的體素,再通過提取體素特征進行目標檢測。此類方法的三維空間特征表征能力有限,相對于基于原始點云的方法計算成本更小,但三維卷積仍需耗費大量顯存和算力[6-7]。基于數據降維的檢測將點云轉換為二維圖像,利用成熟的圖像目標檢測算法進行檢測。該類方法相對于上述三類方法計算成本小、易部署,但數據降維過程中信息會丟失,檢測效果相對較差[8-10]。基于點云和體素混合的檢測同時利用點云與體素進行檢測,綜合了基于原始點云和基于體素兩種方法的優點。該類方法在充分保留三維空間結構的前提下減少了計算量,但仍保留了三維卷積,因此其計算成本仍高于基于數據降維的檢測[11-12]。

PointPillar 是從數據降維的角度提出的一種點云目標檢測網絡,具備良好的工程實用性:第一,它將三維數據轉換為二維數據來處理,減少了數據量;第二,它利用二維卷積代替三維卷積這類顯存占用率高、計算量大且難以部署的算子來提取特征,減少了計算量,提升了算法的可部署性。但該網絡的檢測精度低于同級別的其他類別的檢測方法,其主要原因有三點:第一,該網絡的檢測性能受柱體尺寸的影響,柱體尺寸越大,生成的偽圖像分辨率越小,運行速度高,但檢測效果差;柱體尺寸越小,生成的偽圖像分辨率越大,運行速度低,但檢測效果好;第二,偽圖像通過特征編碼網絡生成,生成的圖像質量直接影響檢測結果;第三,用于檢測的特征包含大量冗余信息且缺少小目標特征。

本文針對PointPillar 對小目標檢測效果差的問題,設計了一個點云目標檢測網絡。具體地,設計了一個以殘差結構為基礎模塊的主干網絡,用來提升對偽圖像的特征提取能力;設計了一個基于多層特征融合策略的檢測頭,用來提升小目標的檢測性能;設計了一個卷積注意力模塊,用于抑制特征圖中的冗余信息。最后,在KITTI 和DAIR-V2X-I數據集上驗證了提出算法的有效性。

2 PointPillar 網絡

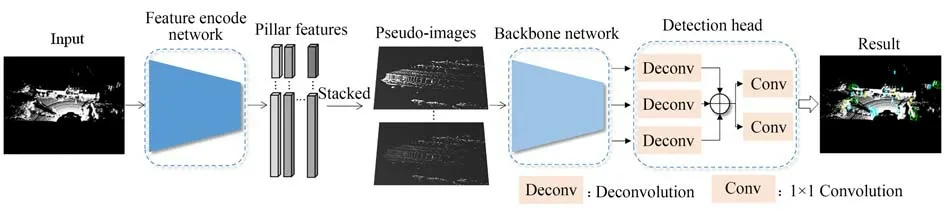

PointPillar 的思想是將點云轉換為二維偽圖像,在圖像上提取特征并完成目標分類和邊界框回歸,其網絡結構如圖1 所示,主要分為三部分:特征編碼網絡(Feature Encode Network, FEN)、主 干 網 絡(Backbone Network, BN)和 檢 測 頭(Detection Head, DH)。PointPillar 首先將點云編碼為柱體,利用FEN 提取柱特征,為減少三維數據帶來的計算量,將柱特征轉化為二維偽圖像,再利用二維卷積BN 提取圖像特征,最后經過DH 獲取檢測結果。FEN 由兩個多層感知機(Multilayer Perceptron,MLP)構成,首先將點云在[X-Y]平面劃分柱體,隨后將柱體饋入MLP 提取 柱 特 征,輸 入 為[N,4]的 柱 向 量,輸 出 為[N,64]的柱向量,為避免三維信息帶來的計算量,將柱特征在俯視圖視角下轉換為二維偽圖像。二維卷積主干網絡由16 層卷積直接堆疊構成,用于提取偽圖像特征。其輸入是尺寸為[C,H,W]的偽圖像,輸出是尺寸分別為[C,H/2,W/2],[2C,H/4,W/4],[4C,H/8,W/8]3 組不同的特征圖F1,F2,F3。檢測頭由三個反卷積和兩個1×1 卷積構成,用于在偽圖像上檢測目標。PointPillar 的 檢 測 頭 與SSD 檢 測 頭 結 構[13]類似,同樣利用了多尺度特征圖。3 個反卷積的輸入分別為F1,F2和F3,輸出均為尺寸為[2C,H/2,W/ 2]的特征圖。3 個反卷積的輸出特征經級聯后生成尺寸為[6C,H/2,W /2]的特征圖,將級聯后的特征圖輸入兩個1×1 卷積分別用于邊界框的回歸和分類,最后得到檢測結果。

圖1 PointPillar 網絡結構Fig.1 Structure of PointPillar network

PointPillar 通過將三維點云轉換為二維偽圖像,大大減少了后續需要處理的數據量;在偽圖像上利用基于圖像的目標檢測算法檢測目標,避免使用3D 卷積,使得算法輕量、高效且易部署。但它對小目標的檢測效果差,主要原因有兩點:首先,主干網絡輸出的特征圖均為高層特征,不利于小目標檢測;其次,檢測頭將主干網絡輸出的特征圖直接進行反卷積和級聯操作,導致特征圖中包含大量噪聲且語義信息和空間信息利用不充分。針對上述問題,本文提出了一種基于特征融合策略的點云目標檢測算法Pillar-FFNet。

3 Pillar-FFNet 結構

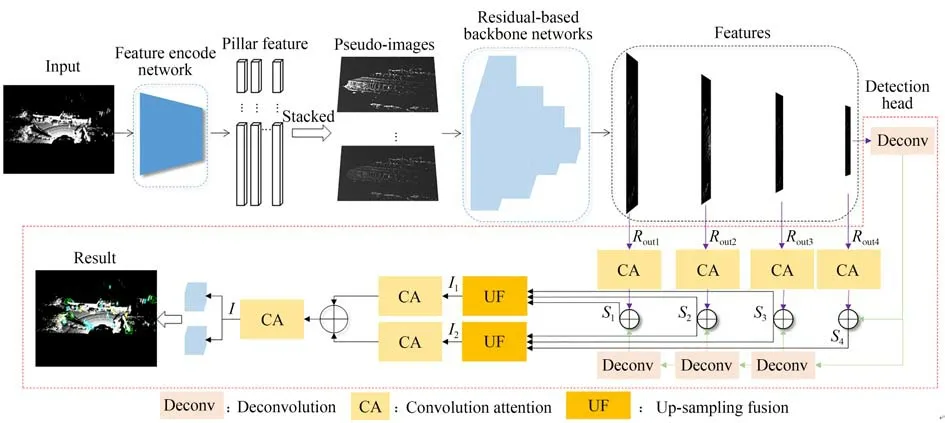

為了提高對小目標的檢測效果,本文將PointPillar 作為基礎網絡,提出了一種點云目標檢測網絡Pillar-FFNet,其結構如圖2 所示。Pillar-FFNet 由特征編碼網絡、主干網絡和檢測頭組成,特征編碼網絡與PointPillar 中的一致。設計了一個基于殘差的主干網絡,輸出四組不同尺寸的包含豐富語義信息和空間信息的特征圖;設計了一個基于多尺度特征融合策略的檢測頭,通過有效融合主干網絡輸出特征圖中的信息來提升小目標的檢測效果;設計了一個卷積注意力模塊,通過有效增強特征圖中的有效信息來提升檢測效果。Pillar-FFNet 的檢測流程為:首先,將點云饋入特征編碼網絡提取點特征,根據點特征生成偽圖像;然后,將偽圖像饋入殘差主干網絡,生成4 組不同尺度的特征圖;最后,將主干網絡生成的特征圖饋入檢測頭,完成點云目標檢測。

圖2 Pillar-FFNet 結構Fig.2 Structure of pillar-FFNet

3.1 主干網絡

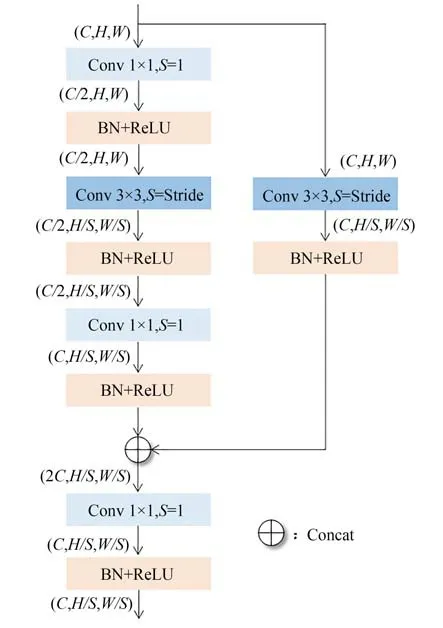

通過直接堆疊卷積來增加網絡深度會加劇反向傳播過程中梯度消失的現象,導致網絡性能退化[14]。解決這一問題的常用方法是利用殘差結構來構建深層網絡。基于此,本文將殘差結構作為基礎模塊構建了一個基于卷積殘差塊(Convolution Residual Block,CR)的主干網絡,其結構圖如圖3 所示。一個CR 塊共包含兩個分支,分別由1×1 卷積和3×3 卷積構成,每個卷積后都包含一個批量歸一化層BN 和一個激活函數ReLU。對于一個CR 塊,假設輸入特征圖為F∈RC×H×W、輸出特征圖為Fout。CR 塊的第一個分 支 由1 個3×3 卷 積 和2 個1×1 卷 積 構 成,F經過1 個1×1 卷積將數據降維為F1'∈R(C2)×H×W,F1'經 過1 個 步 長 為S的3×3 卷 積 輸 出 特 征F1''∈R(C2)×(HS)×(WS),F1''經 過1 個1×1 卷 積 將 數據增維為F1'''∈RC×(HS)×(WS);CR 塊的第二個分支由1 個 步 長 為S的3×3 卷 積 構 成,F經 過3×3 卷積輸出特征F2'∈RC×(HS)×(WS);將第一個分支的輸出F1'''和第二個分支的輸出F2'級聯得到F3∈R2C×(HS)×(WS),再將F3經過一個1×1 卷積輸出Fout∈RC×(HS)×(WS)。

圖3 CR 塊結構Fig.3 Structure of CR block

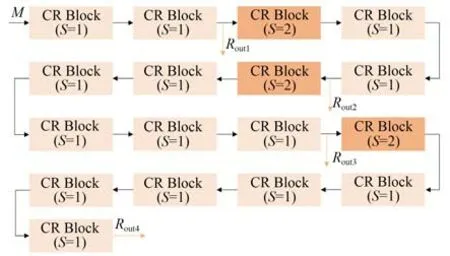

本文以CR 塊作為基礎塊設計了一個殘差主干網絡(Residual BackBone Net,RBNet)。如圖4所 示,RBNet 由14 個 步 長S為1 的CR 塊 和3 個 步長S為2 的CR 塊堆疊而成,輸出4 個不同尺寸的特征圖Rout1,Rout2,Rout3,Rout4。RBNet 的特征提取過程為:點云首先經特征編碼網絡生成偽圖像M∈R64×496×432,M為RBNet 的 輸入;M經過2 個步長為1 的CR 塊,生成特征圖Rout1∈R64×496×432;Rout1經過1 個步長為2 的CR 塊和2 個步長為1 的CR 塊,生成特征圖Rout2∈R64×248×216;Rout2經過1個步長 為2 的CR 塊和5 個步長為1 的CR 塊,生成特征圖Rout3∈R128×124×108;Rout3經過1 個步長為2 的CR 塊和5 個步長為1 的CR 塊,生 成特征圖Rout4∈R256×62×54。

圖4 RBNet 結構Fig.4 Structure of RBNet

3.2 基于多尺度特征融合策略的檢測頭

卷積神經網絡中,低層特征圖的分辨率大,空間信息豐富;高層特征圖的分辨率低,語義信息豐富[15]。為了將不同層級特征圖中的高層語義信息和低層空間信息有效融合,本文提出了一個基于多尺度特征融合策略的檢測頭,命名為MFHead。MFHead 通過有效融合不同層級的語義信息和空間信息來提升點云中小目標的檢測效果。

MFHead 結構如圖2 中紅色虛線框內的檢測頭部分所示(彩圖見期刊電子版),輸入為RBNet輸出的4 組不同尺寸的特征圖Rout1,Rout2,Rout3和Rout4,輸出為檢測框位置、目標尺寸、目標偏轉角和目標類別。首先,Rout4經過4 個反卷積生成4組特征圖,其尺寸分別為256×62×54,128×124×108,64×248×216 和64×496×432,將Rout1,Rout2,Rout3和Rout4經過卷積注意力模塊后分別與其進行級聯融合生成4 組特征圖S1,S2,S3和S4,將S1,S2,S3進行 級 聯 融 合 生 成 特征圖I1,將S2,S3,S4進行 級 聯 融 合 生 成 特征圖I2。然 后將I1,I2分別經過卷積注意力模塊后進行級聯融合生成最終的特征圖I,將I饋入兩個1×1 卷積分別進行目標分類和邊界框回歸。

3.3 卷積注意力模塊

卷積神經網絡提取的特征圖中包含豐富的細節信息,但特征圖中信息的重要性不一樣,某些信息對目標的檢測識別更重要。因此,為了能充分利用網絡中與任務相關的有效信息,抑制網絡中與任務無關的冗余信息,本文設計了一個卷積注意力模塊(CAMA),其結構如圖5 所示。首先將特征圖F∈RC×H×W按通道拆分為兩組特征圖F1∈R(C2)×H×W,F2∈R(C2)×H×W,然后將F1饋入平均池池化層得到F1'∈R(C2)×1×1,F1'經過一個1×1 卷積和sigmoid 函數,輸出每個特征圖的權 重值β,將F1與β相乘得到F1'',將F1''與F1相加得到F1out;再將F2饋入最大池化層得到F2'∈R(C2)×1×1,F2'經過一個1×1 卷積和sigmoid函數,輸出每個特征圖的權重值α,將F2與α相乘得 到F2'',將F2''與F2相 加 得 到F2out;最 后,將和F2out相加后饋入1×1卷積得到被賦予權重的特征圖Fout。本文的卷積注意力模塊可以表示為:

圖5 CAMA 模塊Fig. 5 CAMA module

式中:S( ·)表示sigmoid 函數,f1( ·)表示1×1 卷積,Avgpool( ·)表示平均池化,Maxpool( ·)表示最大池化。

3.4 損失函數

本文沿用文獻[7]中的損失函數。損失函數分為回歸損失和分類損失。回歸損失采用Smooth L1 函數,分類損失采用Focal Loss。假設目標的三維先驗框為(x,y,z,w,l,h,θ),真實邊界框表示為(xgt,ygt,zgt,wgt,lgt,hgt,θgt),預測邊界框表示為(x',y',z',w',l',h',θ'),則邊界框回歸損失函數Lloc表示為:

式中d=x,y,z為中心坐標,w,l,h分別為寬,長,高,θ為目標偏轉角。

對于偏轉角回歸,使用Ldir進一步在離散方向學習邊界框回歸方向,由于sin 函數特性無法區分θ為0°和180°,因此利用softmax 函數對角度進行分類。softmax 的輸出值大于0 時,角度為正,反之為負。

分類損失函數Lcls表示為:

其 中:pa是 anchor 的 類 別 概 率,設 置α=0.25,γ=2。

總損失函數L表示為:

式 中:Npos表示正錨框的數量,βloc=2,βcls=2,βdir=2。

4 實 驗

本文的實驗環境為:Intel? Core? i9-9820X CPU @ 3.30GHz×20 CPU NVIDIA GeForce RTX 2080 GPU,64 G 內存,Ubuntu18.04 系統。采用Python 語言在Pytorch,OpenPCDet 點云目標檢測框架下進行實驗驗證。

4.1 數據集

本文在公開數據集KITTI[16]和DAIR-V2X-I[17]上進行實驗驗證。KITTI 含有帶標簽的訓練樣本為7 481 幀。將7 481 幀樣本劃分為訓練集和驗證集,訓練集包含3 712 幀樣本,驗證集包含3 769 幀樣本,對汽車(Car)、行人(Pedestrian)和騎行者(Cyclist)三類目標進行檢測。DAIR-V2X-I包含10 084 幀樣本,其中公開的帶標簽樣本共7 058 幀。將7 058 幀樣本劃分為訓練集和驗證集,訓練集包含5 042 幀樣本,驗證集包含2 016幀樣本,對汽車,行人和騎行者三類目標進行檢測。

4.2 實驗設置

本文按照OpenPCDet 的設定來設置網絡的學習策略和超參數,按照文獻[8]中的設定來設置數據集中點云的柱體尺寸、每個柱體中的最大點數、點云數據范圍內所含最大柱體數、錨框尺寸、正 負 樣 本 交 并 比(Intersection Over Union,IoU)匹配閾值。由于KITTI 和DAIR-V2X-I 數據集中的有效范圍不一樣,因此設置的點云范圍不同。 KITTI 數據集的點云范圍設置為x∈[0,69.12],y∈[-39.68,39.68],z∈[-3,1];DAIR-V2X-I 數據集的點云范圍設置為x∈[0,99.84],y∈[-39.68,39.68],z∈[-3,1]。

4.3 評價指標

本文采用精確率-召回率(Precision-Recall,PR)曲線、平均精度(Average Precision,AP)和每秒幀數(Frame Per Second,FPS)來衡量算法的性能。

PR 曲線是一種評價模型性能的指標,以召回率(R)為橫坐標,精確率(P)為縱坐標。其定義如下:

式中:TP表示預測為正且實際為正的樣本數量,FN表示預測為負但實際為正的樣本數量,FP表示預測為正但實際為負的樣本數量。AP 是一種評價目標檢測模型檢測效果的指標,這里采用文獻[16]中AP 的定義。對于汽車,設置當IoU ≥0.7 時檢測正確;對于行人和騎行者,設置當IoU ≥0.5 時檢測正確。按照KITTI 設定,根據目標大小、遮擋和截斷情況將3 類目標的檢測難度分為簡單(easy)、中等(middle)和困難(hard)3種。本文在這3 種不同檢測難度下評估算法性能。FPS 是一種用來衡量模型推理效率的指標,表示1 秒內處理樣本的數量。在batch size 為1 時統計驗證集上的指標。一般地,PR 曲線包含的面積越大,模型性能越好;AP 值越大,模型性能越好;FPS 越大,模型推理速度越快。

4.4 實驗結果及分析

本文對KITTI 和DAIR-V2X-I 數據集中的汽車、行人和騎行者進行三維檢測,為公平比較,本文所用算法采用同樣的損失函數、相同的超參數在臺式工作站上進行訓練。

4.4.1 定量分析

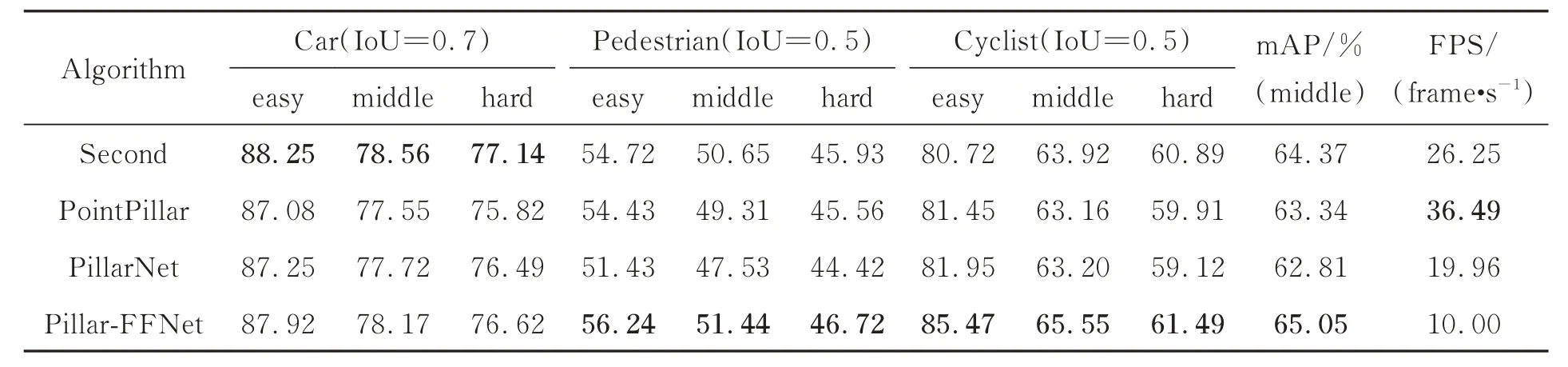

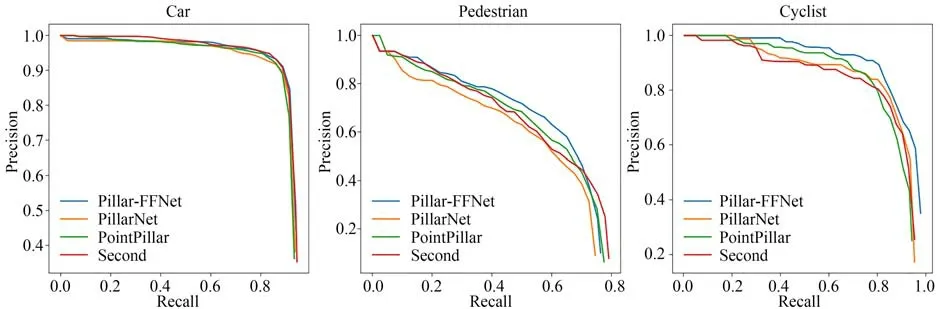

在三維目標檢測上采用AP,PR 曲線和FPS進行定量分析,將Pillar-FFNet 與3 種主流點云目標檢測算法對比,實驗結果如表1、表2 和圖6所示,加粗字體表示最佳指標。表1 和表2 分別為KITTI 驗證集和DAIR-V2X-I 驗證集上4 種算法的三維檢測AP 值和FPS;圖6 為4 種算法在KITTI 驗證集簡單檢測難度下的PR 曲線。由表1 和 表2 可 知:Pillar-FFNet 對 三 類 目 標 的 總 體 檢測和小目標的效果均優于其他3 種算法,但推理速度低于其他算法。在KITTI 驗證集上,與PointPillar 相 比,FPS 降 低 了26.49 frame/s,汽車、行人和騎行者的AP 在easy 檢測難度下分別提高了0.84%,1.81%,4.02%,在middle 檢測難度下分別提高了0.62%,2.13%,2.39%,在hard檢測難度下分別提高了0.8%,1.16%,1.58%;在DAIR-V2X-I 驗證集上,與PointPillar 相比,FPS 降低了6.95 frame/s,汽車,行人和騎行者的AP 在easy 檢測難度下分別提高了0.33%,2.09%,4.71%,在middle 檢測難度下分別提高了0.17%,0.17%,1.84%,在hard 檢測難度下分別提高了0.17%,0.17%,1.82%。由圖6 可知,Pillar-FFNet 在行人和騎行者類別上的PR 曲線明顯優于其他3 個算法,在汽車類別上的PR 曲線與其他算法性能相當。

表1 KITTI 驗證集上的三維檢測結果Tab.1 Result for 3D detection on KITTI validation dateset

表2 DAIR-V2X-I 驗證集上的三維檢測結果Tab.2 Result for 3D detection on the DAIR-V2X-I validation dateset

圖6 四種對比算法在KITTI 驗證集上的PR 曲線Fig.6 PR curves for four comparison algorithms on KITTI validation dataset

在點云數據中,由于點云自身的稀疏性,用于表征小目標的的點數少,因此對點云小目標的檢測更加困難。與PointPillar 相比,Pillar-FFNet可以在不影響汽車檢測的前提下有效提高行人和騎行者這類小目標檢測的性能。其主要原因有:首先,本文設計的RBNet 生成的4 個不同尺寸的特征圖中包含不同尺寸目標的信息,有利于后續檢測頭中的特征提取與檢測分類;其次,MFHead 檢測頭將低層特征中的空間信息和高層特征中的語義信息進行有效融合,使得饋入檢測頭的特征圖中含有各類目標的豐富信息;最后,CAMA 模塊通過計算特征圖中對應像素的權重,有效抑制了主干網絡輸出特征圖和融合后特征圖中的冗余信息,增強了特征圖中的有效信息。但由于本文設計的檢測頭采用多尺度特征融合策略,增加了需要處理的特征信息,且包含多個反卷積和卷積注意力模塊,計算量增加,降低了網絡推理速度。由于DAIR-V2X-I 數據集中的點云范圍更大、更加稠密,因此算法對DAIR-V2X-I 的處理效率更低。

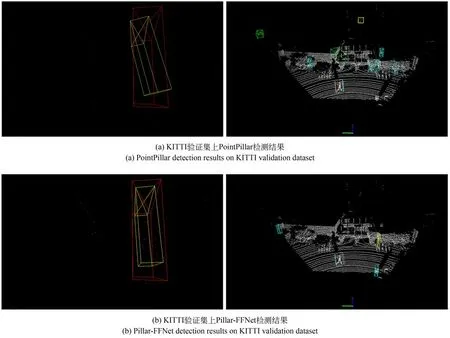

4.4.2 定性分析

這里對Pillar-FFNet 和PointPillar 的檢測結果進行了可視化分析,算法的部分檢測結果如圖7 所示。圖7 中,對應位置表示同一幀點云經過兩種不同算法的檢測結果,紅色框表示目標真實框,綠色框、藍色框和黃色框分別表示網絡預測的汽車、行人和騎行者的位置。

圖7 可視化檢測結果Fig.7 Visualisation of detection results

由圖7 可知,Pillar-FFNet 對行人和騎行者的檢測效果有顯著提升,同時不會降低汽車的檢測效果。與PointPillar 相比,Pillar-FFNet 在小目標檢測上整體更加準確,但對于遠距離的目標和較密集場景中的目標仍然存在較大的漏檢和誤檢。首先,對于遠距離目標的漏檢和誤檢問題,遠距離的目標點云數據中包含的有效點太少,導致從點中難以提取到能夠有效表征其目標特性的特征,這是產生漏檢的主要原因;遠距離的一些目標在掃描成點云后在空間結構上與汽車、行人和騎行者的部分高度相似,這是產生誤檢的主要原因。其次,密集場景中目標之間的遮擋和自身遮擋等問題嚴重,導致采集的點云數據不全面,也會導致漏檢和誤檢。最后,由于本文算法是從偽圖像中提取目標特征,點云中的目標點過于稀疏,導致其在圖像上對應的像素點太少,從而影響檢測。

4.4.3 消融實驗

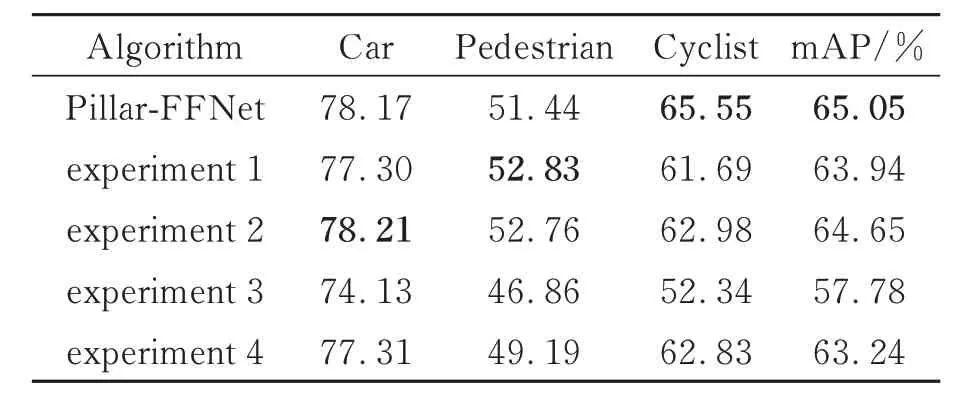

為驗證CAMA 模塊和MFHead 檢測頭對三維檢測的影響,在KITTI 上進行了消融實驗。實驗采用4.3 節的評價指標來評估算法性能,實驗結果如表3~表5 所示,其中加粗字體表示最佳指標。

表3 Pillar-FFNet 檢測頭不同融合方式對檢測的影響Tab.3 Effect of different fusion methods on detection of Pillar-FFNet detection heads

首先,設計4 組消融實驗來驗證檢測頭中不同的特征融合方式對檢測性能的影響:實驗1 將PointPillar 中的檢測頭替代Pillar-FFNet 中的MFHead;實驗2 將MFHead 中的S1和S2融合,S3和S4融 合;實 驗3 將MFHead 中 的S1,S3,S4融合,S2,S3,S4融 合;實 驗4 將MFHead 替 換 為FPN[18]結構,實驗結果如表3 所示。然后,設計4組實驗來驗證注意力對檢測性能的影響:實驗5將CAMA 模塊用SE 模塊[19]代 替;實驗6 將CAMA 模塊用CBAM 模塊[20]代替;實驗7 將CAMA模 塊 用ECA 模 塊[21]代 替;實 驗8 將CAMA 模 塊用3×3 卷積代替,實驗結果如表4 所示。最后,設計3 組實驗驗證MFHead 檢測頭和CAMA 模塊對檢測性能的影響:第一組實驗同時采用MFHead 和CAMA 模塊;第二組實驗僅采用CAMA模塊;第三組實驗僅采用MFHead 檢測頭,實驗結果如表5 所示。

表4 Pillar-FFNet 不同注意力模塊對檢測的影響Tab.4 Effect of different attention modules of Pillar-FFNet on detection

表5 本文設計的模塊對檢測的影響Tab.5 Effect of modules designed in paper on detection

根據表3~表5 可知,不同的檢測頭特征融合方式和注意力模塊下,檢測性能的差異較大。由表3 可知,MFHead 檢測頭相對于SSD 檢測頭和FPN 結構具有更好的檢測效果;由表4 可知,CAMA 模塊相對于SE,CBAM 和ECA 注意力機制能夠進一步提升三維檢測的性能。由表5 可知,同時采用CAMA 和MFHead 的模塊綜合檢測性能最好。

5 結 論

針對點云稀疏小目標檢測困難的問題,本文結合多尺度特征融合策略和卷積注意力設計了一種點云目標檢測網絡。在公開數據集上進行了實驗驗證,結果表明,與基準算法相比,本文算法在KITTI 和DAIR-V2X-I 數據集上對行人和騎行者這兩類小目標的3D 檢測精度最大分別提高了2.13%和4.71%。但由于點云自身特性的限制,點云中表征小目標的點數量少,算法提取到的小目標特征少,導致小目標準確檢測困難。因此,后續的研究重點是對點云中的小目標進行有效補全,以提升小目標檢測的準確性。