基于目標識別及跟蹤技術的母羊發情行為檢測實證研究

摘 要: 隨著畜牧養殖數字智能化監控技術的產業化應用,如何運用深度機器學習技術對畜牧養殖監控視頻數據進行發挖掘應用,從現有粗糙的低精度識別提升到更精準的高精度分析,從直觀的淺層特征深入到復雜關聯的深層特征,已成為當前畜禽環境監控系統亟待解決的關鍵技術難題。目前,母羊發情行為檢測主要是依靠人工觀察和專用的可穿戴設備,存在誤差大、容易引起母羊應激反應和成本高等問題。本文針對母羊發情所呈現的行走頻繁和食欲減退的鮮明特征,選取山東省泰安市小蘭沃村某羊場為實驗場所,依據數字畜牧監控系統錄制的實時視頻數據。首先采用Yolov5 目標檢測模型,檢測和識別發情母羊目標;然后采用DeepSORT目標跟蹤算法,獲取發情母羊在圈養食飼活動中的實時位置,通過提取目標的位置坐標數據,計算出其在目標羊圈活動的移動軌跡并計算其移動距離。最后,設計了基于行走距離檢測模型和基于食飼期間行走主軌跡痕跡檢測模型,實現發情母羊的實時精準檢測。本文工作將為集約化圈養下的小群體母羊合理分欄,精細高效養殖管理,提供了進一步的理論探索和可行性應用方案。

關鍵詞: 深度學習;畜禽養殖;母羊;發情;目標跟蹤

中圖法分類號: S126 文獻標識碼: A 文章編號: 1000-2324(2024)06-0933-10

提高公羊和母羊的配種效率是決定羊羔的數量和提升產業效率的關鍵技術之一,母羊的發情周期一般是山羊21 d 一個發情周期,綿羊16 d 一個發情周期,每次發情持續時間為30 小時,而最佳配種時間是在母羊發情的20~36 小時內完成,很容易出現發情時間判斷不準確錯過母羊的最佳配種時間,最終影響發情期受胎率從而降低繁殖率。因此,如何精準預測母羊發情時機是提高配種效率的關鍵技術。目前,針對母羊發情期行為特征已有大量研究,張國棟[1]為了及時發現發情母羊,正確掌握配種時間,提出了三種鑒定母羊發情的方法,分別為外部觀察法、陰道檢查法和試情法,該方法主要依賴于人工觀察和經驗。隨著農業傳感器技術的發展,張宏鳴[2]等將三軸加速度傳感器安裝于動物的腿部或頸部,成功識別反芻動物躺臥、行走和站立三種行為,并詳細分析識別反芻家畜發情、分娩、疾病、疼痛狀況的不同特征指標。楊曉龍[3]使用MPU6050 加速度陀螺儀安裝在奶山羊背部,成功識別了奶山羊行走、跑動、跨跳和站立四種行為,為進一步研究奶山羊發情、生病、分娩等奠定了基礎。最近,Dong Wang[4]等人使用Faster R-CNN 目標檢測算法來跟蹤監控視頻里的奶山羊,并對奶山羊的行為進行分析。YU[5]等通過從具有發情爬跨行為的視頻中捕獲圖像構建數據集,提出了一種基于Yolov3 的輕量級神經網絡,檢測公羊和母羊的交配行為,檢測精確率為99.44%。綜上所述,母羊發情行為監測主要依賴于人工觀察和專用可穿戴設備,但這些方法存在誤差大、易引起應激反應且成本高昂等問題。運用深度學習和圖像識別技術對母羊發情行為的檢測研究,能提供一種無接觸、自動化、高效的牲畜行為識別方式。

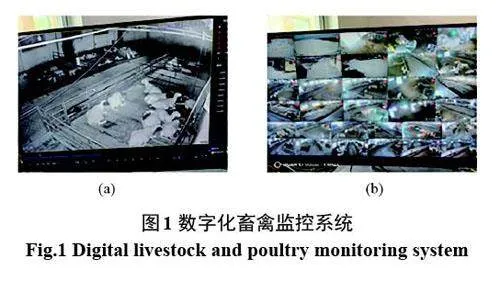

現代化畜禽養殖企業已廣泛應用智能傳感器裝備和信息傳輸技術[6-9],能夠實現指定區域至整個養殖周期(6 個月*30 d*24 h)的全場景的監測[10,11]。如圖1 所示,數字化畜禽監控系統可以對指定羊圈內的母羊發情前期、發情期、發情期后的整個過程進行實時監測和記錄。本文工作依據母羊發情時表現出的活動興奮、行走頻繁和食欲減退等顯著特征,首先,借用數字化監控設備記錄發情母羊的游走行為數據,采用基于Yolov5 模型的羊只多目標檢測技術和基于DeepSORT 算法的軌跡跟蹤技術[12-15],對羊只視頻進行目標識別和跟蹤[16,17],獲取發情母羊在圈養食飼活動中的實時位置,然后通過提取目標的位置坐標數據,計算出其在目標羊圈活動的移動軌跡并計算其移動距離,最后,設計了基于行走距離檢測模型和基于食飼期間行走軌跡檢測模型,實現發情母羊的實時精準檢測,為及時配種和提高羊的繁殖效率提供了有力支持。

1 數據獲取與預處理

1.1 試驗地點和研究對象

實驗地點選取山東省泰安市岱岳區小蘭沃村某羊場(東經:117 24′37;北緯:36 26′6)。該羊場根據羔羊、空懷母羊、受孕母羊、分娩母羊、種公羊等,采用小群體分類施策精細化方案。本試驗選取了即將進入發情期的空懷母羊為研究對象。

1.2 數據獲取與標注

試驗數據來源于羊場所配套的數字化畜禽監控系統,配備了JVS-C-BK1H3D-AM監控攝像頭,每時間段監控視頻長度為30 min,格式為mp4,幀率為25 fps ,分辨率為1 920×1 080 像素。從生產實踐得知,8 月到11 月是最常見的母羊發情時間,而9 月到10 月則是母羊發情的高峰期。由于母羊在發情期間,其行為活動明顯增加,另伴隨著食欲不振的現象。因此,采用為2023 年10~11 月的小蘭沃村羊場7-10 號羊圈即將進入發情期的七只空懷母羊的監控畫面,如圖2 所示,每天8:00~9:00、12:00~13:00 和16:00~17:00 三個時間期間進行飼料的供給。采用平均、隨機取點,剔除模糊、嚴重遮擋和離開視野等的圖像,使用Labellmg 軟件按照精準拖拽、適當留白、避免遮擋、避免重疊、合理分割、調整大小和標簽一致性的規則進行標注。最終獲得1 795 幅母羊圖像,劃分為訓練集、驗證集和測試集。其中,訓練集和驗證集圖像數量占80%,測試集數量占20%,二者比例為4∶1。

2 研究方法

2.1 基于YoloV5模型的指定小區域劃檢測

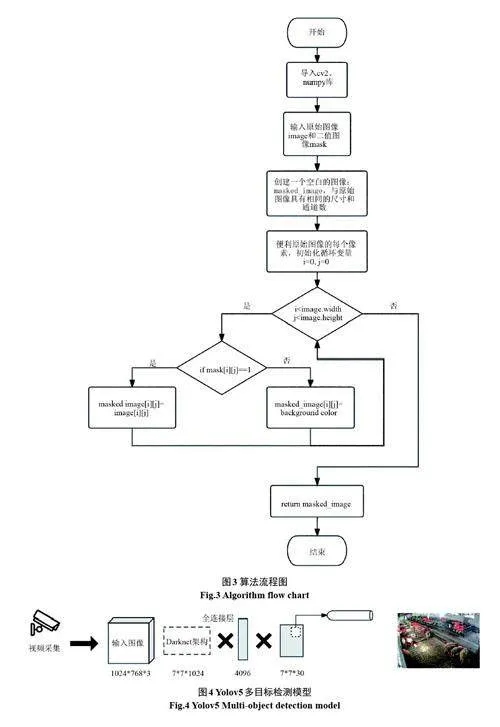

搭建Yolov5 模型可以實現羊圈中多目標羊只的實時識別與檢測,但是在實際應用中目標檢測區域以外的羊只也會被識別出來,因此本文通過二值分割法[18]在目標監測區域以外,添加蒙版以達到遮擋或隱藏非目標監測區域的目的。蒙版的原理基于二值圖像處理技術,其中像素值表示對應位置在圖像處理過程中是否應當被納入計算或顯示。通過將設計的蒙版與原始圖像進行逐像素的邏輯運算,能夠實現對圖像內容的選擇性處理與顯示。具體而言,蒙版能夠精確地選擇并處理圖像的特定區域,無論是用于遮罩、隱藏特定部分,還是進行更復雜的圖像編輯操作。在實際應用中,蒙版通常被設計為一個與原始圖像尺寸完全匹配的矩陣。這個矩陣中,被標記為檢測區域的部分被賦予非零值,而其余非目標監測區域則設置為零值。

本文選取四個邊界點來確定目標檢測區域,通過確定每個邊界點距離監控畫面頂部及左部的比例來劃定目標檢測區域的邊界。將目標區域邊界內對應位置的像素值設為1,即將原始畫面中的該位置像素保留,將目標區域邊界以外的像素設為0,即將原始畫面中的該位置像素遮擋,逐像素的加權疊加公式為式(1):

I'(x,y) = I (x,y) × M (x,y) (1)

式(1)中,假設目標圖像為I(x,y),蒙版圖像為M(x,y);I(' x,y)表示處理后的圖像在位置(x,y)處的像素值;I(x,y)表示原始目標圖像在位置(x,y)處的像素值;M(x,y)表示蒙版圖像在位置(x,y)處的像素值。具體算法流程如圖3所示。

2.2 基于YoloV5模型的發情母羊多目標檢測

如圖4 所示,為實現每只羊目標的識別和檢測,選擇Yolov5 結構搭建,用于羊目標識別和檢測深度學習模型。Yolov5 模型[19,20]增加了自適應錨框計算和自適應圖像縮放方法;在特征提取層上添加Focus 和C3 結構,以增強特征表達能力。其中,Focus 模塊對輸入圖像進行切片操作,減少了原始特征信息丟失,并提升對于模型的計算速度[21];C3 模塊借鑒了CSPNet[22]的思想,增強特征融合能力的同時降低網絡復雜度并提升運算速度;在特征融合層中,Yolov5 采用特征金字塔網絡(Feature Pyramid Networks,FPN)結合路徑聚合網絡(Pyramid Attention Network forsemantic segmentation,PAN)的結構,PAN自底向上將低層的強定位特征傳遞上去,使模型獲取更加豐富的特征信息。Yolov5 是一個非常高效的目標檢測模型,相比于其他目標檢測模型,Yolov5 擁有更加輕量級的網絡結構,這使得它在不犧牲太多準確性的情況下,可以更容易地部署到資源受限的設備上。

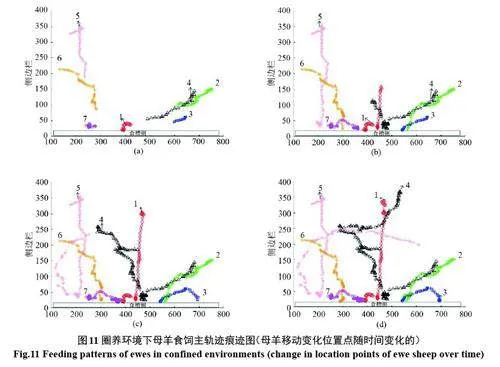

由于基于Yolo 的DeepSORT 目標跟蹤算法可選用Yolov3、Yolov4、Yolov5s 以及Yolov8s 目標檢測算法,因此本文對比了多種目標檢測算法的訓練精度。為了確保實驗的可靠性,所有模型訓練使用相同的數據集,將數據集輸入四個模型進行訓練。各模型訓練結果如表1所示。

在對比Yolov3、Yolov4、Yolov5s以及Yolov8s這四種目標檢測算法的結果中可以看出,隨著版本的更新,模型在識別精度上有了顯著的提升。Yolov3 和Yolov4 作為較早期的版本,由于技術限制和算法設計的局限性,其識別精度相較于后續版本有顯著不足。然而,在Yolov5s 與Yolov8s的對比中,盡管Yolov8s 作為Yolov5s 的后續版本,在理論上可能融入了更多的優化和改進,但在實際測試中,兩者的精確率P(%)幾乎持平。然而,Yolov5s 在召回率R(%)方面略高于Yolov8s,且在關鍵評價指標平均準確率mAP@0.5(%)上也展現出更優異的性能。Yolov8s 的設計更加注重模型的輕量化,旨在減少計算資源和內存消耗,這在一些資源受限的環境中無疑使一個巨大的優勢。然而,這種輕量化設計也在一定程度上犧牲了模型的精度。在實際應用中,這需要在精度和效率之間做出權衡。在本文的研究中,使用了GPU進行計算,以加速模型的訓練和測試過程。在平均訓練時間的對比中,Yolov5s算法比Yolov8s 算法略勝一籌,這進一步增強了其在實際應用中的競爭力。因此,基于以上分析和實驗結果,我們最終選擇了Yolov5s 算法作為羊群多目標檢測算法進行下一步的研究。這一選擇不僅考慮了模型的精度和效率,還充分考慮了實際應用的需求和限制。

2.3 基于DeepSORT算法的母羊行走軌跡跟蹤

羊圈多目標的準確檢測是母羊發情精準預測研究的重要基礎,本文采用DeepSORT算法實現羊圈中羊只多目標跟蹤。整個工作流程用如下步驟來描述:

第一步:目標檢測。通過基于Yolov5 模型的羊群多目標檢測深度學習模型,提取了羊目標的外觀特征表示,DeepSORT軌跡跟蹤算法在羊群游走連續視頻序列中[23],對每一幀圖像中檢測出羊只目標物體,提取檢測目標的位置和邊界框,將其轉換為低維特征向量。每只羊目標狀態在一個預測框中描述為式(2):

x = [u,ν,s,r, (u',ν',s') ]T(2)

式(2)中u 代表目標邊界框的水平位置,v 代表目標邊界框的垂直位置,s 代表目標面積,r 代表目標邊框邊長高比,(u',ν',s')代表水平位置、垂直位置和邊界框質心的預測值。

第二步:目標匹配。將檢測出的信息通過卡爾曼濾波器預測下一時刻目標的位置,同時通過深度學習模型提取每個檢測到的目標外觀特征;然后將這兩部分信息進行級聯匹配,匹配成功后則進行下一次的預測;若匹配失敗,則會使用匈牙利算法進行目標與軌跡之間的匹配,匹配成功后則進行卡爾曼濾波器的更新;若匹配失敗是已經獲取到預測軌跡,則更新軌跡,若未確認,并且目標在連續幀中消失時間小于閾值,則繼續跟蹤原來的軌跡;只有當目標在連續幀中消失時間超過設定閾值時,會刪除此軌跡[24]。因此,在試驗過程中,通過檢查羊目標是否在當前幀且是否與前一幀中檢測到的羊目標相同,實現目標匹配。

第三步:外觀特征更新。將當前幀中檢測到的目標物體的外觀特征與新的軌跡進行相似度匹配,更新目標軌跡的外觀特征表示,實現目標在當前幀和下一幀的匹配,即實現羊群場景中準確和實時的跟蹤多個目標。

2.4 母羊發情行為特征檢測模型

由于激素水平的變化,母羊發情行為特征主要體現在母羊發情時,變得更為活躍、行走頻繁,行動距離顯著增加,同時,由于母羊過度興奮導致食欲明顯減退。因此,依照以上母羊發情行為特征,本文給出如下兩種母羊發情行為特征檢測模型。

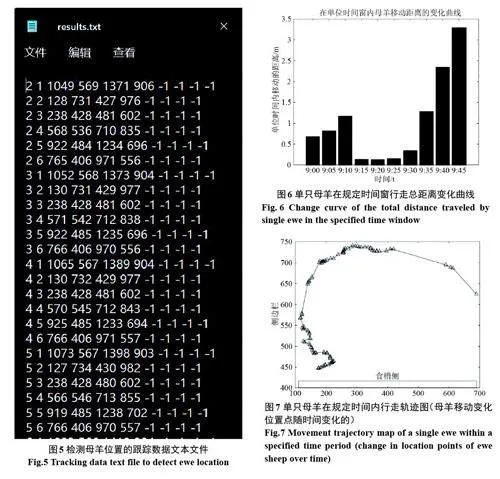

2.4.1 基于行走頻繁、行動距離顯著增加的行走距離檢測 母羊行為可細分為動態行為(如行走)和靜態行為(如趴臥、站立)。通過基于Yolov5 的多目標檢測算法和DeepSORT算法,對指定區域的每一幀圖像,計算母羊目標的位置和邊界框,確定它們在視頻數據圖像中的位置,保存結果如圖5所示。

其中,第一列對應視頻幀,第二列為檢測到的目標ID,第三列為目標框中心點橫坐標,第四列為目標框中心點縱坐標,第五和第六列分別表示檢測框的寬度和高度。采用曼哈頓距離公式,我們計算每只母羊目標在時空位置與起始源點的距離,使用IntelliJ IDEA 工具編寫了基于DeepSORT算法的程序,從而得出母羊在整個游走過程中的位移變化運動軌跡數據。用于計算羊只運動軌跡數據的總距離。數學模型描述如式(3):

Dt (x,y) = | It + 1(xt + 1,yt + 1 ) - It (xt,yt ) | (3)

式(3)中D為目標移動的距離,I 為當前目標的坐標位置,x 為目標的橫坐標,y 為目標的縱坐標,t 為單位時間或稱為幀。由此可以得出母羊的動態行為在單位時間內的移動距離,最終將數據導入至Matlab 中進行處理。如圖6 所示,單只母羊在規定(9:00~9:45),5 min 為一個時間窗,行走總距離變化曲線圖。

2.4.2 基于發情母羊食欲明顯減退的食飼期間行走軌跡檢測 試驗數羊場每天8:00~9:00、12:00~13:00 和16:00~17:00 三個時間期間進行飼料喂養。首先,選取喂養時間的視頻,然后,計算每只母羊目標在時空位置與起始源點的距離,得出母羊在整個游走過程中的位移變化運動軌跡數據。最后,獲取母羊食飼期間實時行走軌跡,分析在規定食飼期間,每只母羊食槽的距離關系,進而得出發情母羊食欲減退的定性分析。如圖7 所示,在圈養環境下,單只母羊在20 min(規定時間內)的母羊行走軌跡圖(母羊移動變化位置點隨時間變化的)。

3 試驗結果與分析

3.1 試驗平臺及參數設置

硬件平臺基于13 Gen Inter? Core ? i7-13620H 2.4 GHz,RAM 16 GB,NVIDIA GeForceRTX 4050 Laptop GPU,64 位Windows 11 操作系統。實驗設計相關數據分析和模型建立均使用python3.11+CUDA11.8+CuDNN8.9。實驗涉及相關數據分析和模型建立均在PyChramCommunity Edition 2023 軟件環境中完成。Yolov5 目標檢測模型采用隨機梯度下降(SGD),動量為0.9,批量大小為4,使用交叉熵損失,激活函數為ReLU 函數,初始學習率設為0.005,當測試精度在5 個迭代周期內無增加時,學習率進行衰減,衰減率為0.2。考慮到羊群游走視頻中的連續視頻幀是高度冗余特性,特別是存在較為相似的空間以及時間信息特征,在訓練和測試時通過利用稀疏采樣消除相鄰幀的冗余信息來加快推理速度。

3.2 試驗識別區域劃分

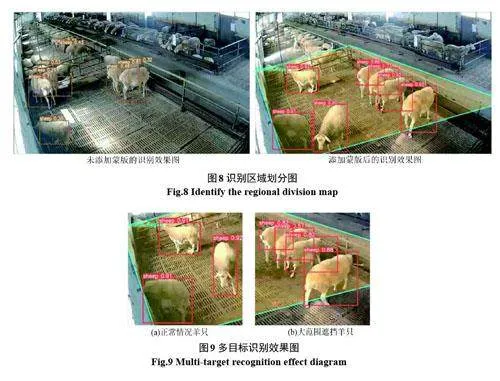

在上述算法中,輸入包括原始圖像(image)和蒙版(mask),輸出則是添加蒙版后的圖像(masked image)。apply ask 函數接受原始圖像和蒙版作為輸入,遍歷原始圖像的每個像素,并根據蒙版的像素值對原始圖像進行修改,最后返回添加蒙版后的圖像。這種逐像素的加權疊加方式可以靈活地調整蒙版的作用效果,實現對圖像的局部顯示、隱藏或改變,添加蒙版后的羊只識別效果如圖8所示。

3.3 母羊游走過程中的多目標識別分析

如圖9 所示,我們呈現了模型識別效果的展示,其中檢測框上方的數字清晰地標明了每只母羊的檢測置信度。在圖9(a)的正常場景中,每只母羊的檢測精度均保持在0.90 以上,這充分證明了我們所采用的基于Yolov5 模型的羊只多目標檢測算法的高效性和準確性。然而,隨著時間的推移,當母羊們逐漸從散亂狀態聚集起來時,遮擋現象便不可避免地出現了,如圖9(b)所示。盡管如此,即便在遮擋情況下,每只母羊的檢測精度依然能夠維持在0.80 以上。為了檢驗母羊游走過程中的羊只多目標檢測模型的穩健性,采用目標識別算法的召回率作為評價標準對模型進行評估。最終,我們認為該模型對羊只識別具有較好的穩健性與準確性。

3.4 母羊發情行為監測實證研究

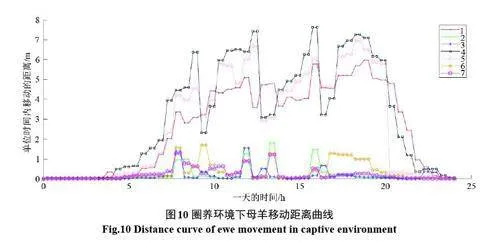

選取試驗場地標號為#7-10號的羊圈,作為發情母羊行走距離檢測實證試驗目標。監控視頻數據為2023年10月02日00:00至24:00 1 d的時間段,設置30 min為一個時間窗。如圖10所示,24 h內所發生的7只母羊的游走距離變化。

從圖10 中觀察到7 只母羊明顯的分為兩組,移動距離變化表現出顯著的差異。我們清晰觀察到編號為1、4 和5 的母羊行走頻繁,游走軌跡距離呈高表達,變化頻率明顯,經檢測其處于發情期;而編號為2、3、6 和7 的曲線呈低表達,且變化頻率相對平緩,則檢測該四只母羊尚未到發情期。

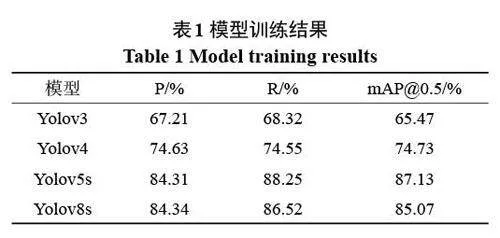

同理,繼續選取標號為#7-10 的目標羊圈,重點關注了在8:20~9:00 食飼時間段內7 只母羊的活動情況。當我們實時分析40 分鐘的視頻數據時,我們發現由于圈養環境下的羊圈空間有限,7 只母羊在這段時間內的運動細節極為瑣碎,導致生成的食飼期間行走軌跡雜亂無章,難以直接用于研究分析。為了解決這個問題,給出了如下的篩選規則:規則1:

選取當母羊處于靜止行為時(例如:趴臥、站立、進食、飲水等),在該位置停留時間超過一定閾值的位置點;規則2:在40 min 食飼期間,選取母羊移動到某一位置點的次數達到一定閾值的位置點。

通過這一步驟,我們剔除了導致軌跡圖雜亂的異常數據點。經過處理后的數據更符合我們的研究要求,于是我們利用這些數據生成了如圖11(a)、圖11(b)、圖11(c)、圖11(d)所示的母羊食飼期間行走主軌跡痕跡圖(母羊移動變化位置點隨時間變化的)。

圖11(a)展示了8:20 至8:30 這一時間段內,7 只母羊在進食前的行為主軌跡痕跡圖。從圖中可以清晰地看到,所有的7 只母羊都從初始的散列位置,移動到食槽位置,開始進食;隨著時間的推移,圖11(b)呈現了8:30 至8:40 這10 min內,7 只母羊在進食過程中的行為主軌跡痕跡圖。圖中,編號為1、4、5 的母羊在進食一段時間后,表現出離開食槽的跡象,而其他4 只母羊則繼續進食。到了8:40 至9:00 的時間段,圖11(c)和(d)進一步展示了母羊進食后的行為主軌跡痕跡圖。從圖中可以明顯看出,編號為1、4、5 的母羊已經離開了食槽,不再進食,而剩下的四只母羊則仍在進食。綜上所述,經細致觀察圖10 后,我們可以明顯看出7 只母羊被自然地劃分為兩個組,它們的行為主軌跡痕跡顯示出顯著的差異。值得我們注意的是,編號為1、4、5 的母羊在發情期間,其進食行為發生了顯著的變化:在進食開始時,這3 只母羊短暫地走進食槽旁進食,但隨后便迅速離開了食槽,不再繼續采食。與此同時,其余四只母羊則保持著正常的吃食狀態。基于這明顯的行為特征,我們可以檢測編號為1、4 和5 的母羊正處于發情期,而編號為2、3、6和7 的母羊則不處于此階段。這一現象與前面基于發情母羊行走距離檢測的結果相符合。

4 結論

目前,畜牧養殖數字智能化監控技術已成為畜牧養殖中不可缺少的配套技術,但是,迫切需要運用深度機器學習技術,從現有粗糙的低精度識別提升到更精準的高精度分析,從直觀的淺層特征深入到復雜關聯的深層特征。本文利用基于Yolov5模型的羊群多目標檢測和基于DeepSORT算法的羊群游走軌跡跟蹤技術,在羊群游走多模糊、形變較大、羊群出現遮擋,易發生相似目標干擾復雜情況下,準確對羊只目標識別和跟蹤,實時獲取它們的位置信息和移動軌跡,精準地追蹤并分析母羊的游走軌跡并計算出其移動距離。通過給出的基于行走距離檢測模型和基于食飼期間行走主軌跡痕跡檢測模型,我們能夠根據母羊的行為模式來判斷其發情狀態,深化了我們對母羊發情期間行走頻繁、食欲減退等生物學特性的認識。為集約化圈養下的精細高效養殖管理,提供了進一步的理論探索和可行性應用方案。

在試驗過程中,發現深度學習的訓練需要大量的數據作為支撐,數據集的標注過程費時費力。偽標簽學習為我們提供了一種全新的解決方案。通過利用少量的標簽數據和無標簽數據,偽標簽學習有效降低了對大規模標注數據的依賴,使得模型在有限的資源下也能展現出優異的性能。下一步的研究將注重更加細致地探索母羊發情期的聲音特征,為發情檢測提供更加全面和準確的方法;同時,計劃開發軟件接口部署到現有的畜禽數字化監控系統中,確保當系統檢測到母羊進入發情期時,能夠立即向管理人員推送通知。此外,還會融入一個直觀的人機交互模塊,使得管理人員能夠在需要時便捷地手動終止這些提示,從而更加貼合實際生產中的操作需求。展望未來,基于行走距離檢測模型和基于食飼期間行走主軌跡痕跡檢測模型有望擴展至其他類型的哺乳動物及多樣化的養殖環境,并根據實際應用場景進行必要的改進和適應性調整,以進一步提升方法的普適性和實用性。

參考文獻

[1] 張國棟. 淺談肉用羊的發情鑒定與配種方法[J]. 山

東畜牧獸醫,2020,41(06):18-19.

[2] 張宏鳴,孫 揚,趙春平,等. 反芻家畜典型行為監測

與生理狀況識別方法研究綜述[J]. 農業機械學報,

2023,54(03):1-21.

[3] 楊曉龍. 奶山羊行為監測管理系統設計[D]. 楊凌:西

北農林科技大學,2018.

[4] Dong W,Tang J L,Zhu W,et al. Dairy goat detection

based on Faster R-CNN from surveillance video[J].

Computers and Electronics in Agriculture,2018,154:

443-449.

[5] YU L, PU Y, CEN H, et al. A lightweight neural

network-based method for detecting estrus behavior

in ewes[J].Agriculture,2022,12(8):1207.

[6] 曹麗桃,程 曼,袁洪波,等. 可穿戴設備部署位置對

羊只行為識別的影響與分析[J]. 中國農機化學報,

2022,43(12):133-141.

[7] 石紅霄,高方馀,劉同海,等. 基于傳感器技術的自由

放牧羊行為識別研究進展[J]. 農業工程學報,2023,

39(17):1-18.

[8] 王 奎. 基于聲信號的放牧羊只牧食信息監測研究

[D]. 呼和浩特:內蒙古農業大學,2021.

[9] 何春明,趙斌,張麗娜. 舍飼綿羊運動狀態監測方法

的研究[J]. 黑龍江畜牧獸醫, 2023, (07): 48-52+

59+132.

[10] 姬振生. 羊只反芻行為監測系統設計與識別技術研

究[D]. 呼和浩特:內蒙古農業大學,2022.

[11] 胡必玲,郭玉堂. 基于RFID和無人機的畜牧定位系

統[J]. 計算機測量與控制,2017,25(07):239-242.

[12] 魏 斌,Masum Billah,王美麗,等. 基于深度學習的羊

臉檢測與識別方法[J]. 家畜生態學報,2022,43(03):

47-50.

[13] 張宏鳴, 周利香, 李永恒, 等. 基于改進

MobileFaceNet 的羊臉識別方法[J]. 農業機械學報,

2022,53(05):267-274.

[14] 姚 州,譚 焓,田 芳,等. 計算機視覺技術在智慧羊

場中的研究進展[J]. 中國飼料,2021,(07):7-12.

[15] 張宏鳴,汪 潤,董佩杰,等. 基于DeepSORT 算法的

肉牛多目標跟蹤方法[J]. 農業機械學報,2021,52

(04):248-256.

[16] 張 偉,沈明霞,劉龍申,等. 基于CenterNet 搭配優化

DeepSORT 算法的斷奶仔豬目標跟蹤方法研究[J].

南京農業大學學報,2021,44(05):973-981.

[17] 王 瑞,林志堅,陳平平. 基于改進DeepSort 的行人跟

蹤方法研究[J]. 無線電通信技術,2023,49(06):1117-

1124.

[18] 李建春. 牛圖像識別與分割方法研究[J]. 內蒙古科

技與經濟,2023,(20):105-107.

[19] JOCHER G.Ultralytics/yolov5:v6.1-tensorrt,tensorflow

edge tpu and openvino export and inference[EB/

OL]. 2022-02-22[2022-11-03]. https://github. com/

ultralytics/yolov5.

[20] REDMON J, FARHADI A.YOLO9000: better, faster,

stronger[C]//Proceedings of the IEEE Conference on

Computer Vision and Pattern Recognition, 2017:

7263-7271.

[21] WANG C Y,LIAO H,WU Y H, et al.CSPNet; a new

backbone that can enhance learning capability of

CNN[C]1/2020IEEE/CVF Conference on Computer

Vision and Pattern Recognition Workshops, IEEE,

2020;19854564.

[22] 劉 斌,李港慶,安澄全,等. 基于多尺度特征融合的

紅外單目測距算法[J]. 計算機應用,2022,42(03):

804-809.

[23] Bewley A, Ge Z Y, Ott L, et al. Simple online and

realtime tracking[C]//2016 IEEE International

Conference on Image Processing(ICIP). September

25-28,2016,Phoenix,AZ,USA.IEEE,2016:3464-3468.

[24] Wojke N,Bewley A,Paulus D,et al.Simple online and

realtime tracking with a deep association metric[C]//

2017 IEEE International Conference on Image

Processing (ICIP). September 17-20, 2017, Beijing,

China.IEEE,2017:3645-3649.